الدليل النهائي لتحسين محركات البحث الفنية

نشرت: 2023-02-24ضع قائمة بثلاثة أشياء قمت بها هذا العام تتعلق بتحسين محرك البحث (SEO).

هل تدور هذه التكتيكات حول البحث عن الكلمات الرئيسية والأوصاف التعريفية والروابط الخلفية؟

إذا كان الأمر كذلك ، فأنت لست وحدك. عندما يتعلق الأمر بـ SEO ، فإن هذه التقنيات هي عادةً أول ما يضيفه المسوقون إلى ترسانتهم.

بينما تعمل هذه الاستراتيجيات على تحسين رؤية موقعك في البحث العضوي ، فهي ليست الوحيدة التي يجب عليك توظيفها. هناك مجموعة أخرى من التكتيكات التي تندرج تحت مظلة تحسين محركات البحث.

يشير مُحسّنات محرّكات البحث التقني إلى عناصر ما وراء الكواليس التي تدعم محرك النمو العضوي ، مثل هندسة الموقع وتحسين الأجهزة المحمولة وسرعة الصفحة. قد لا تكون هذه الجوانب من تحسين محركات البحث هي الأكثر جاذبية ، لكنها مهمة للغاية.

تتمثل الخطوة الأولى في تحسين مُحسّنات محرّكات البحث التقني في معرفة مكانك من خلال إجراء تدقيق على الموقع. الخطوة الثانية هي وضع خطة لمعالجة المجالات التي تقصر فيها. سنغطي هذه الخطوات بالتفصيل أدناه.

نصيحة احترافية: قم بإنشاء موقع ويب مصمم للتحويل باستخدام أدوات CMS المجانية الخاصة بـ HubSpot.

ما هو الـ Technical SEO؟

يشير مُحسّنات محرّكات البحث التقني إلى أي شيء تفعله ويسهل على محركات البحث الزحف والفهرسة إلى موقعك. تعمل إستراتيجيات تحسين محركات البحث الفنية واستراتيجية المحتوى واستراتيجيات بناء الروابط جنبًا إلى جنب لمساعدة صفحاتك في الحصول على مرتبة عالية في البحث.

تحسين محركات البحث الفنية مقابل تحسين محركات البحث على الصفحة مقابل تحسين محركات البحث خارج الصفحة

يقسم العديد من الأشخاص تحسين محركات البحث (SEO) إلى ثلاث مجموعات مختلفة: تحسين محركات البحث على الصفحة ، وتحسين محركات البحث خارج الصفحة ، وتحسين محركات البحث التقني. دعنا نغطي بسرعة ما يعنيه كل منهما.

على الصفحة كبار المسئولين الاقتصاديين

يشير مُحسّنات محرّكات البحث على الصفحة إلى المحتوى الذي يخبر محركات البحث (والقراء!) عن موضوع صفحتك ، بما في ذلك النص البديل للصورة ، واستخدام الكلمات الرئيسية ، والأوصاف التعريفية ، وعلامات H1 ، وتسمية عنوان URL ، والارتباط الداخلي. لديك أكبر قدر من التحكم في مُحسّنات محرّكات البحث على الصفحة لأنه ، حسنًا ، كل شيء موجودعلىموقعك.

خارج الصفحة SEO

يخبر مُحسّنات محرّكات البحث خارج الصفحة محركات البحث مدى شعبية صفحتك وفائدتها من خلال تصويت الثقة - وعلى الأخص الروابط الخلفية أو الروابط من مواقع أخرى إلى موقعك. تعمل كمية وجودة الروابط الخلفية على تعزيز نظام ترتيب الصفحات في الصفحة. عند تساوي كل الأشياء ، ستفوق الصفحة التي تحتوي على 100 رابط ذي صلة من مواقع موثوقة صفحة بها 50 رابطًا ذي صلة من مواقع موثوقة (أو 100 رابط غير ذي صلة من مواقع موثوقة.)

تقنية تحسين محركات البحث (Technical SEO)

إن تحسين محركات البحث الفنية تحت سيطرتك أيضًا ، ولكن إتقانها أصعب قليلاً لأنه أقل بديهية.

لماذا يعتبر تحسين محركات البحث الفني مهمًا؟

قد تميل إلى تجاهل هذا المكون من مُحسّنات محرّكات البحث تمامًا ؛ ومع ذلك ، فإنه يلعب دورًا مهمًا في حركة المرور العضوية الخاصة بك. قد يكون المحتوى الخاص بك هو الأكثر شمولاً وفائدة وجيدة الكتابة ، ولكن ما لم يتمكن محرك البحث من الزحف إليه ، فلن يراه سوى عدد قليل جدًا من الأشخاص.

إنها مثل الشجرة التي تسقط في الغابة عندما لا يسمعها أحد ... هل تصدر صوتًا؟ بدون أساس تقني قوي لتحسين محركات البحث ، لن يصدر المحتوى الخاص بك أي صوت لمحركات البحث.

مصدر

مصدر

دعونا نناقش كيف يمكنك جعل المحتوى الخاص بك صدى عبر الإنترنت.

فهم تقنية تحسين محركات البحث (Technical SEO)

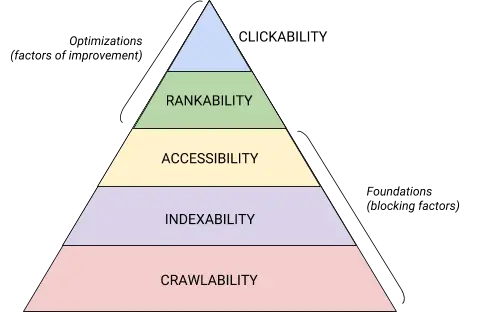

تحسين محركات البحث التقني هو وحش من الأفضل تقسيمه إلى أجزاء قابلة للهضم. إذا كنت مثلي ، فأنت تحب التعامل مع الأشياء الكبيرة في أجزاء وقوائم مرجعية. صدق أو لا تصدق ، كل شيء غطيناه حتى هذه النقطة يمكن وضعه في واحدة من خمس فئات ، كل منها تستحق قائمتها الخاصة من العناصر القابلة للتنفيذ.

يتم توضيح هذه الفئات الخمس ومكانها في التسلسل الهرمي التقني لتحسين محركات البحث بأفضل صورة من خلال هذا الرسم الجميل الذي يذكرنا بتسلسل ماسلوف الهرمي للاحتياجات ولكن تم إعادة مزجه لتحسين محرك البحث. (لاحظ أننا سنستخدم المصطلح الشائع الاستخدام "العرض" بدلاً من إمكانية الوصول.)

مصدر

مصدر

أساسيات التدقيق الفني لتحسين محركات البحث

قبل أن تبدأ بالتدقيق التقني لتحسين محركات البحث ، هناك بعض الأساسيات التي تحتاج إلى وضعها في مكانها الصحيح.

دعنا نغطي أساسيات تحسين محركات البحث الفنية هذه قبل الانتقال إلى بقية تدقيق موقع الويب الخاص بك .

تدقيق المجال المفضل لديك

مجالك هو عنوان URL الذي يكتبه الأشخاص للوصول إلى موقعك ، مثل hubspot.com . يؤثر مجال موقع الويب الخاص بك على ما إذا كان يمكن للأشخاص العثور عليك من خلال البحث ويوفر طريقة متسقة لتحديد موقعك.

عند تحديد نطاق مفضل ، فأنت تخبر محركات البحث عما إذا كنت تفضل عرض إصدار www أو بدون www لموقعك في نتائج البحث. على سبيل المثال ، يمكنك تحديدwww.yourwebsite.comعلىyourwebsite.com. يخبر هذا محركات البحث أن تعطي الأولوية لإصدار www من موقعك ويعيد توجيه جميع المستخدمين إلى عنوان URL هذا. خلاف ذلك ، ستتعامل محركات البحث مع هذين الإصدارين كمواقع منفصلة ، مما يؤدي إلى تشتت قيمة تحسين محركات البحث.

في السابق ، طلبت منك Google تحديد إصدار عنوان URL الذي تفضله. الآن ، ستحدد Google إصدارًا وتحدده لإظهار الباحثين لك. ومع ذلك ، إذا كنت تفضل تعيين الإصدار المفضل لنطاقك ، فيمكنك القيام بذلك من خلال العلامات الأساسية (التي سنغطيها قريبًا). في كلتا الحالتين ، بمجرد تعيين النطاق المفضل لديك ، تأكد من أن جميع المتغيرات ، التي تعنيwww ، و non-www ، و http ، و index.html، جميعها تعيد التوجيه بشكل دائم إلى هذا الإصدار.

تطبيق SSL

ربما سمعت بهذا المصطلح من قبل - هذا لأنه مهم جدًا. تُنشئ طبقة المقابس الآمنة أو طبقة المقابس الآمنة طبقة من الحماية بين خادم الويب (البرنامج المسؤول عن تلبية الطلب عبر الإنترنت) والمستعرض ، مما يجعل موقعك آمنًا. عندما يرسل المستخدم معلومات إلى موقع الويب الخاص بك ، مثل معلومات الدفع أو الاتصال ، فمن غير المرجح أن يتم اختراق هذه المعلومات لأن لديك SSL لحمايتها.

يتم الإشارة إلى شهادة SSL بواسطة مجال يبدأ بـ "https: //" بدلاً من "http: //" ورمز قفل في شريط URL.

تعطي محركات البحث الأولوية للمواقع الآمنة - في الواقع ، أعلنت Google في وقت مبكر من عام 2014 أن SSL سيعتبر عامل ترتيب . لهذا السبب ، تأكد من تعيين متغير SSL لصفحتك الرئيسية كنطاقك المفضل.

بعد إعداد طبقة المقابس الآمنة (SSL) ، ستحتاج إلى ترحيل أي صفحات بخلاف صفحات SSL من http إلى https. إنها مهمة صعبة ، لكنها تستحق الجهد من أجل تحسين الترتيب. فيما يلي الخطوات التي يجب عليك اتخاذها:

- أعد توجيه جميع صفحات http://yourwebsite.com إلى https://yourwebsite.com .

- قم بتحديث جميع العلامات الأساسية وعلامات hreflang وفقًا لذلك.

- قم بتحديث عناوين URL على خريطة موقعك (الموجودة على yourwebsite.com/sitemap.xml ) و robot.txt الخاص بك (الموجود على yourwebsite.com/robots.txt ).

- قم بإعداد مثيل جديد من Google Search Console و Bing Webmaster Tools لموقع https الخاص بك وتتبعه للتأكد من أن 100٪ من حركة المرور يتم ترحيلها.

تحسين سرعة الصفحة

هل تعرف كم من الوقت سينتظر زائر موقع الويب تحميل موقع الويب الخاص بك؟ ست ثوان ... وهذا هو السخاء. تظهر بعض البيانات أن معدل الارتداد يزداد بنسبة 90٪ مع زيادة وقت تحميل الصفحة من ثانية واحدة إلى خمس ثوانٍ. ليس لديك ثانية واحدة لتضيعها ، لذا يجب أن يكون تحسين وقت تحميل موقعك أولوية.

سرعة الموقع ليست مهمة فقط لتجربة المستخدم والتحويل - إنها أيضًا عامل ترتيب .

استخدم هذه النصائح لتحسين متوسط وقت تحميل الصفحة:

- قم بضغط كل ملفاتك. يقلل الضغط من حجم صورك ، بالإضافة إلى ملفات CSS و HTML و JavaScript ، لذا فإنها تأخذ مساحة أقل ويتم تحميلها بشكل أسرع.

- مراجعة الحسابات يعيد التوجيه بانتظام. تستغرق عملية إعادة التوجيه 301 بضع ثوانٍ. ضاعف ذلك في عدة صفحات أو طبقات من عمليات إعادة التوجيه ، وستؤثر بشكل خطير على سرعة موقعك.

- قلل من التعليمات البرمجية الخاصة بك. يمكن أن تؤثر التعليمات البرمجية الفوضوية سلبًا على سرعة موقعك. الشفرة الفوضوية تعني رمزًا كسولًا. إنه مثل الكتابة - ربما في المسودة الأولى ، توضح وجهة نظرك في 6 جمل. في المسودة الثانية ، تقوم بعملها في 3. كلما زادت كفاءة الشفرة ، زادت سرعة تحميل الصفحة (بشكل عام). بمجرد تنظيف الأشياء ، ستقوم بتصغير وضغط الكود الخاص بك .

- ضع في اعتبارك شبكة توزيع المحتوى (CDN). شبكات CDN هي خوادم ويب موزعة تخزن نسخًا من موقع الويب الخاص بك في مواقع جغرافية مختلفة وتقدم موقعك بناءً على موقع الباحث. نظرًا لأن المعلومات بين الخوادم لها مسافة أقصر للسفر ، يتم تحميل موقعك بشكل أسرع للطرف الطالب.

- حاول ألا تصبح البرنامج المساعد سعيدًا. غالبًا ما تحتوي المكونات الإضافية القديمة على ثغرات أمنية تجعل موقع الويب الخاص بك عرضة للمتسللين الضارين الذين يمكن أن يضروا بتصنيفات موقع الويب الخاص بك. تأكد من أنك تستخدم دائمًا أحدث إصدارات المكونات الإضافية وتقليل استخدامك إلى الأكثر أهمية. على نفس المنوال ، ضع في اعتبارك استخدام سمات مخصصة ، حيث غالبًا ما تأتي سمات مواقع الويب المعدة مسبقًا مع الكثير من التعليمات البرمجية غير الضرورية.

- استفد من المكونات الإضافية لذاكرة التخزين المؤقت. تخزن المكونات الإضافية لذاكرة التخزين المؤقت إصدارًا ثابتًا من موقعك لإرساله إلى المستخدمين العائدين ، وبالتالي تقليل وقت تحميل الموقع أثناء الزيارات المتكررة.

- استخدم التحميل غير المتزامن (غير المتزامن). البرامج النصية هي إرشادات تحتاج الخوادم إلى قراءتها قبل أن تتمكن من معالجة HTML ، أو النص الأساسي لصفحة الويب الخاصة بك ، أي الأشياء التي يرغب الزوار في رؤيتها على موقعك. عادةً ما يتم وضع النصوص البرمجية في <head> لموقع الويب (فكر في: نص Google Tag Manager الخاص بك) ، حيث يتم منحها الأولوية على المحتوى الموجود في باقي الصفحة. يعني استخدام رمز غير متزامن أن الخادم يمكنه معالجة HTML والنص في وقت واحد ، وبالتالي تقليل التأخير وزيادة وقت تحميل الصفحة.

إليك كيفية ظهور نص برمجي غير متزامن: < script async src = ” script.js “> </ script >

إذا كنت ترغب في معرفة ما هو موقع الويب الخاص بك الذي يعاني من قصور في قسم السرعة ، فيمكنك استخدام هذا المورد من Google .

بمجرد الانتهاء من وضع أساسيات تحسين محركات البحث (SEO) الخاصة بك ، فأنت على استعداد للانتقال إلى المرحلة التالية - إمكانية الزحف.

قائمة التحقق من قابلية الزحف

قابلية الزحف هي أساس إستراتيجيتك التقنية لتحسين محركات البحث. ستقوم روبوتات البحث بالزحف إلى صفحاتك لجمع معلومات حول موقعك.

إذا تم منع هذه الروبوتات بطريقة ما من الزحف ، فلن تتمكن من فهرسة صفحاتك أو ترتيبها. تتمثل الخطوة الأولى لتنفيذ مُحسّنات محرّكات البحث التقني في التأكد من إمكانية الوصول إلى جميع صفحاتك المهمة وسهولة التنقل فيها.

سنغطي أدناه بعض العناصر لإضافتها إلى قائمة التحقق الخاصة بك بالإضافة إلى بعض عناصر موقع الويب للتدقيق للتأكد من أن صفحاتك أساسية للزحف.

قائمة التحقق من قابلية الزحف

- قم بإنشاء خريطة موقع XML.

- تعظيم ميزانية الزحف الخاصة بك.

- تحسين بنية موقعك.

- قم بتعيين بنية عنوان URL.

- استخدم ملف robots.txt.

- أضف قوائم شريط التنقل.

- استخدم ترقيم الصفحات.

- تحقق من ملفات سجل SEO الخاصة بك.

1. إنشاء خريطة موقع XML.

تذكر هيكل الموقع الذي ذهبنا إليه؟ ينتمي ذلك إلى شيء يسمى ملف XML Sitemap الذي يساعد روبوتات البحث على فهم صفحات الويب الخاصة بك والزحف إليها. يمكنك التفكير في الأمر كخريطة لموقع الويب الخاص بك. سترسل خريطة موقعك إلى Google Search Console و Bing Webmaster Tools بمجرد اكتمالها. تذكر أن تحافظ على تحديث ملف Sitemap أثناء إضافة وإزالة صفحات الويب.

2. تعظيم ميزانية الزحف الخاصة بك.

تشير ميزانية الزحف إلى الصفحات والموارد التي ستزحف إليها روبوتات البحث في موقعك .

نظرًا لأن ميزانية الزحف ليست غير محدودة ، فتأكد من إعطاء الأولوية لصفحاتك الأكثر أهمية للزحف.

فيما يلي بعض النصائح لضمان زيادة ميزانية الزحف إلى الحد الأقصى:

- إزالة أو تحديد عنوان URL للصفحات المكررة.

- إصلاح أو إعادة توجيه أي روابط معطلة.

- تأكد من إمكانية الزحف إلى ملفات CSS و Javascript.

- تحقق من إحصائيات الزحف بانتظام وراقب الانخفاضات أو الزيادات المفاجئة.

- تأكد من أن أي برنامج آلي أو صفحة منعت من الزحف تم حظرها.

- حافظ على تحديث ملف Sitemap الخاص بك وقم بإرساله إلى أدوات مشرفي المواقع المناسبة.

- قلل موقعك من المحتوى غير الضروري أو القديم.

- احترس من عناوين URL التي تم إنشاؤها ديناميكيًا ، والتي يمكن أن تجعل عدد الصفحات على موقعك يرتفع.

3. تحسين بنية موقعك.

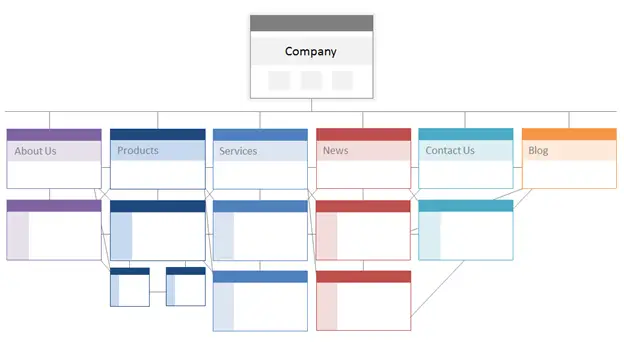

موقع الويب الخاص بك لديه صفحات متعددة. يجب تنظيم هذه الصفحات بطريقة تسمح لمحركات البحث بالعثور عليها والزحف إليها بسهولة. هذا هو المكان الذي يأتي فيه هيكل موقعك - الذي يشار إليه غالبًا باسم بنية معلومات موقع الويب الخاص بك.

بنفس الطريقة التي يعتمد بها المبنى على التصميم المعماري ، فإن بنية موقعك هي الطريقة التي تنظم بها الصفحات على موقعك.

يتم تجميع الصفحات ذات الصلة معًا ؛ على سبيل المثال ، روابط الصفحة الرئيسية للمدونة الخاصة بك إلى منشورات المدونة الفردية ، والتي يرتبط كل منها بصفحات المؤلف الخاصة بها. تساعد هذه البنية روبوتات البحث في فهم العلاقة بين صفحاتك.

يجب أن تشكل بنية موقعك أيضًا أهمية الصفحات الفردية وتشكلها. كلما كانت الصفحة (أ) أقرب إلى صفحتك الرئيسية ، زاد عدد الصفحات التي تصل إلى الصفحة (أ) ، وكلما زاد عدد الروابط التي تتمتع بهاتلكالصفحات ، زادت أهمية محركات البحث للصفحة (أ).

على سبيل المثال ، يُظهر ارتباط من صفحتك الرئيسية إلى الصفحة "أ" أهمية أكبر من ارتباط من منشور مدونة. كلما زاد عدد الروابط إلى الصفحة "أ" ، زادت "أهمية" تلك الصفحة لمحركات البحث.

من الناحية المفاهيمية ، يمكن أن تبدو بنية الموقع مثل هذا ، حيث يتم وضع الصفحاتحول ، والمنتج ، والأخبار ،وما إلى ذلك في أعلى التسلسل الهرمي لأهمية الصفحة.

مصدر

تأكد من أن أهم صفحات عملك في أعلى التسلسل الهرمي مع أكبر عدد من الروابط الداخلية (ذات الصلة!).

4. تعيين بنية عنوان URL.

تشير بنية عنوان URL إلى كيفية هيكلة عناوين URL الخاصة بك ، والتييمكنتحديدها بواسطة بنية موقعك. سأشرح الاتصال في لحظة. أولاً ، دعنا نوضح أن عناوين URL يمكن أن تحتوي على أدلة فرعية ، مثلblog.hubspot.com، و / أو المجلدات الفرعية ، مثلhubspot.com/blog، والتي تشير إلى المكان الذي يؤدي إليه عنوان URL.

كمثال ، منشور مدونة بعنوانHow to Groom Your Dogيندرج تحت نطاق فرعي أو دليل فرعي للمدونة. قد يكون عنوان URL هو www.bestdogcare.com/blog/how-to-groom-your-dog . في حين أن صفحة المنتج على نفس الموقع ستكونwww.bestdogcare.com/products/grooming-brush.

سواء كنت تستخدم نطاقات فرعية أو أدلة فرعية أو "منتجات" مقابل "متجر" في عنوان URL الخاص بك ، فهذا متروك لك تمامًا. يكمن جمال إنشاء موقع الويب الخاص بك في أنه يمكنك إنشاء القواعد. المهم هو أن تتبع هذه القواعد بنية موحدة ، مما يعني أنه لا يجب عليك التبديل بين blog.yourwebsite.com و yourwebsite.com/blogs على صفحات مختلفة. قم بإنشاء خارطة طريق ، وتطبيقها على بنية تسمية URL الخاصة بك ، والتزم بها.

إليك بعض النصائح الإضافية حول كيفية كتابة عناوين URL الخاصة بك:

- استخدم الأحرف الصغيرة.

- استخدم الشرطات للفصل بين الكلمات.

- اجعلها قصيرة ووصفية.

- تجنب استخدام الأحرف أو الكلمات غير الضرورية (بما في ذلك حروف الجر).

- تضمين كلماتك الرئيسية المستهدفة.

بمجرد أن يتم تثبيت بنية عنوان URL الخاصة بك ، سترسل قائمة بعناوين URL لصفحاتك المهمة إلى محركات البحث في شكل خريطة موقع XML . يؤدي القيام بذلك إلى منح روبوتات البحث سياقًا إضافيًا حول موقعك حتى لا يضطروا إلى اكتشافه أثناء الزحف.

5. استخدم ملف robots.txt.

عندما يقوم روبوت الويب بالزحف إلى موقعك ، فسيقوم أولاً بالتحقق من /robot.txt ، المعروف أيضًا باسم بروتوكول استبعاد الروبوت. يمكن أن يسمح هذا البروتوكول أو لا يسمح لروبوتات ويب معينة بالزحف إلى موقعك ، بما في ذلك أقسام معينة أو حتى صفحات من موقعك. إذا كنت ترغب في منع برامج الروبوت من فهرسة موقعك ، فستستخدم العلامة الوصفية noindex robots. دعونا نناقش كلا السيناريوهين.

قد ترغب في منع بعض الروبوتات من الزحف إلى موقعك تمامًا. لسوء الحظ ، هناك بعض الروبوتات ذات النوايا الخبيثة - الروبوتات التي ستكشط المحتوى الخاص بك أو ترسل بريدًا عشوائيًا إلى منتديات مجتمعك. إذا لاحظت هذا السلوك السيئ ، فستستخدم ملف robot.txt لمنعهم من دخول موقع الويب الخاص بك. في هذا السيناريو ، يمكنك التفكير في ملف robot.txt باعتباره مجال القوة لديك من الروبوتات السيئة على الإنترنت.

فيما يتعلق بالفهرسة ، تزحف روبوتات البحث إلى موقعك لجمع الأدلة والعثور على الكلمات الرئيسية حتى تتمكن من مطابقة صفحات الويب الخاصة بك مع استعلامات البحث ذات الصلة. ولكن ، كما سنناقش لاحقًا ، لديك ميزانية زحف لا تريد إنفاقها على البيانات غير الضرورية. لذلك ، قد ترغب في استبعاد الصفحات التي لا تساعد روبوتات البحث في فهم موضوع موقع الويب الخاص بك ، على سبيل المثال ، صفحةشكرًا لكمن عرض أو صفحة تسجيل دخول.

بغض النظر عن الأمر ، سيكون بروتوكول robot.txt الخاص بك فريدًا اعتمادًا على ما ترغب في تحقيقه.

6. أضف قوائم شريط التنقل.

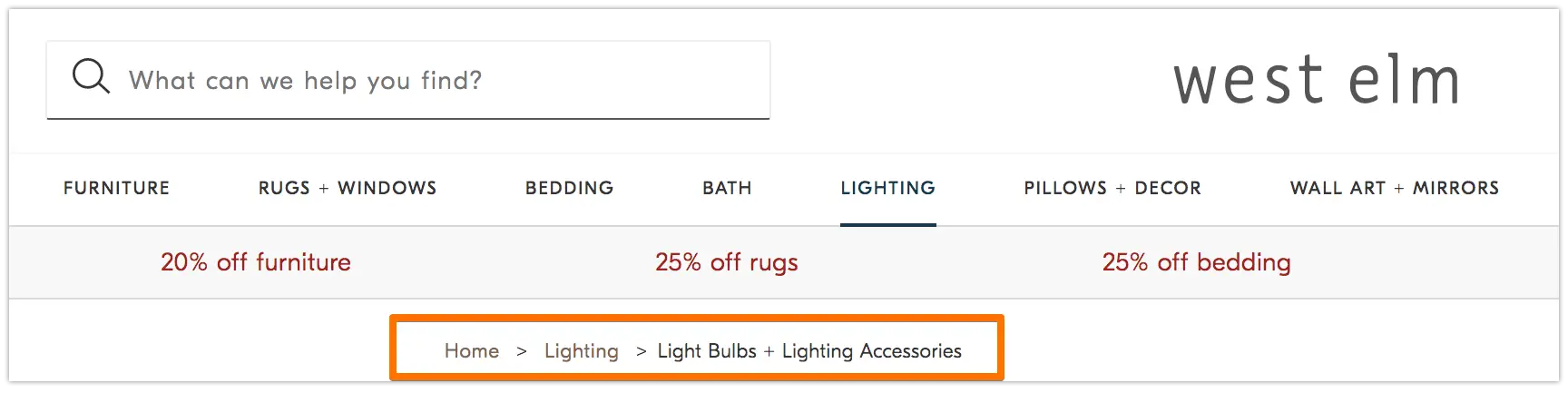

هل تتذكر الحكاية القديمةهانسيل وجريتلحيث ألقى طفلان فتات الخبز على الأرض ليجدا طريقهما إلى المنزل؟ حسنًا ، لقد كانوا في طريقهم إلى شيء ما.

فتات الخبز هي بالضبط ما تبدو عليه - مسار يوجه المستخدمين للعودة إلى بداية رحلتهم على موقع الويب الخاص بك. إنها قائمة بالصفحات تخبر المستخدمين بمدى ارتباط صفحتهم الحالية ببقية الموقع.

وهم ليسوا فقط لزوار الموقع. روبوتات البحث تستخدمها أيضًا.

مصدر

يجب أن تكون مسارات التنقل شيئين: 1) مرئية للمستخدمين حتى يتمكنوا من التنقل بسهولة في صفحات الويب الخاصة بك دون استخدام الزر"رجوع" ، و 2) لها لغة ترميزية منظمة لإعطاء سياق دقيق لبرامج الروبوت البحثية التي تزحف إلى موقعك.

ألست متأكدًا من كيفية إضافة البيانات المنظمة إلى فتات التنقل؟ استخدم هذا الدليل لقائمة Breadcrumb .

7. استخدم ترقيم الصفحات.

تذكر عندما يطلب منك المعلمون ترقيم الصفحات على ورقة البحث الخاصة بك؟ هذا يسمى ترقيم الصفحات. في عالم مُحسّنات محرّكات البحث التقني ، يلعب ترقيم الصفحات دورًا مختلفًا بعض الشيء ولكن لا يزال بإمكانك التفكير فيه كشكل من أشكال التنظيم.

يستخدم ترقيم الصفحات رمزًا لإخبار محركات البحث عندما ترتبط الصفحات ذات عناوين URL المميزة ببعضها البعض. على سبيل المثال ، قد يكون لديك سلسلة محتوى تقسمها إلى فصول أو عدة صفحات ويب. إذا كنت تريد أن تجعل من السهل على روبوتات البحث اكتشاف هذه الصفحات والزحف إليها ، فستستخدم ترقيم الصفحات.

طريقة عملها بسيطة جدا. ستنتقل إلى<head>للصفحة الأولى من السلسلة واستخدمها

rel = ”next”لإخبار روبوت البحث بالصفحة التي يجب الزحف إليها ثانيًا. بعد ذلك ، في الصفحة الثانية ، ستستخدمrel = ”prev”للإشارة إلى الصفحة السابقة وrel = ”next”للإشارة إلى الصفحة التالية ، وما إلى ذلك.

تبدو هكذا…

في الصفحة الأولى:

<link rel = “next” href = “https://www.website.com/page-two” />

في الصفحة الثانية:

<link rel = “prev” href = “https://www.website.com/page-one” />

<link rel = “next” href = “https://www.website.com/page-three” />

لاحظ أن ترقيم الصفحات مفيد لاكتشاف الزحف ، ولكنه لم يعد مدعومًا بواسطة Google لصفحات الفهرس المجمعة كما كانت من قبل.

8. تحقق من ملفات سجل SEO الخاصة بك.

يمكنك التفكير في ملفات السجل مثل إدخال دفتر اليومية. تقوم خوادم الويب (الصحفي) بتسجيل وتخزين بيانات السجل حول كل إجراء تتخذه على موقعك في ملفات السجل (المجلة). تتضمن البيانات المسجلة وقت وتاريخ الطلب والمحتوى المطلوب وعنوان IP الطالب. يمكنك أيضًا تحديد وكيل المستخدم ، وهو برنامج يمكن التعرف عليه بشكل فريد (مثل روبوت البحث ، على سبيل المثال) الذي يلبي طلب المستخدم.

ولكن ما علاقة هذا بـ SEO؟

حسنًا ، تترك روبوتات البحث أثرًا في شكل ملفات السجل عندما تزحف إلى موقعك. يمكنك تحديد ما إذا تم الزحف ومتى وما الذي تم الزحف إليه عن طريق التحقق من ملفات السجل والتصفية بواسطة وكيل المستخدم ومحرك البحث .

هذه المعلومات مفيدة لك لأنه يمكنك تحديد كيفية إنفاق ميزانية الزحف الخاصة بك والعوائق التي تواجه الفهرسة أو الوصول إلى الروبوت. للوصول إلى ملفات السجل الخاصة بك ، يمكنك إما أن تسأل مطورًا أو تستخدم محلل ملفات السجل ، مثل Screaming Frog .

فقط لأن روبوت البحث يمكنه الزحف إلى موقعك لا يعني بالضرورة أنه يمكنه فهرسة جميع صفحاتك. دعنا نلقي نظرة على الطبقة التالية من تدقيق SEO الفني الخاص بك - القابلية للفهرسة .

قائمة تدقيق الفهرسة

عندما تزحف روبوتات البحث إلى موقع الويب الخاص بك ، فإنها تبدأ في فهرسة الصفحات بناءً على موضوعها وصلتها بهذا الموضوع. بمجرد فهرستها ، تصبح صفحتك مؤهلة للترتيب في SERPs. فيما يلي بعض العوامل التي يمكن أن تساعد في فهرسة صفحاتك.

قائمة تدقيق الفهرسة

- قم بإلغاء حظر روبوتات البحث من الوصول إلى الصفحات.

- إزالة المحتوى المكرر.

- تدقيق عمليات إعادة التوجيه الخاصة بك.

- تحقق من استجابة موقعك للجوال.

- إصلاح أخطاء HTTP.

1. قم بإلغاء حظر روبوتات البحث من الوصول إلى الصفحات.

من المحتمل أن تهتم بهذه الخطوة عند معالجة قابلية الزحف ، ولكن من الجدير بالذكر هنا. تريد التأكد من إرسال الروبوتات إلى صفحاتك المفضلة وأنه يمكنهم الوصول إليها بحرية. لديك بعض الأدوات تحت تصرفك للقيام بذلك. سيعطيك أداة اختبار ملف robots.txt من Google قائمة بالصفحات غير المسموح بها ويمكنك استخدام أداة فحص Google Search Console لتحديد سبب الصفحات المحظورة.

2. إزالة المحتوى المكرر.

المحتوى المكرر يربك روبوتات البحث ويؤثر سلبًا على قابليتك للفهرسة. تذكر استخدام عناوين URL الأساسية لإنشاء صفحاتك المفضلة.

3. تدقيق عمليات إعادة التوجيه الخاصة بك.

تحقق من أن جميع عمليات إعادة التوجيه الخاصة بك قد تم إعدادها بشكل صحيح. يمكن أن تتسبب حلقات إعادة التوجيه أو عناوين URL المعطلة أو - الأسوأ من ذلك - عمليات إعادة التوجيه غير الصحيحة في حدوث مشكلات عند فهرسة موقعك. لتجنب ذلك ، قم بمراجعة جميع عمليات إعادة التوجيه بانتظام.

4. تحقق من استجابة موقعك للجوال.

إذا لم يكن موقع الويب الخاص بك مناسبًا للجوّال الآن ، فأنت متأخر كثيرًا عن المكان الذي تريد أن تكون فيه. في وقت مبكر من عام 2016 ، بدأت Google في فهرسة مواقع الجوال أولاً ، مع إعطاء الأولوية لتجربة الهاتف المحمول على سطح المكتب. اليوم ، يتم تمكين هذه الفهرسة بشكل افتراضي. لمواكبة هذا الاتجاه المهم ، يمكنك استخدام اختبار Google المتوافق مع الجوّال للتحقق من المكان الذي يحتاج موقع الويب الخاص بك إلى التحسين فيه.

5. إصلاح أخطاء HTTP.

يرمز HTTP إلى بروتوكول نقل النص التشعبي ، ولكن ربما لا تهتم بذلك. ما يهمك هو عندما يقوم HTTP بإرجاع أخطاء للمستخدمين أو لمحركات البحث ، وكيفية إصلاحها.

يمكن أن تعيق أخطاء HTTP عمل روبوتات البحث عن طريق منعها من المحتوى المهم على موقعك. لذلك ، من المهم للغاية معالجة هذه الأخطاء بسرعة وبدقة.

نظرًا لأن كل خطأ HTTP فريد ويتطلب حلاً معينًا ، فإن القسم أدناه يحتوي على شرح موجز لكل خطأ ، وستستخدم الروابط المقدمة لمعرفة المزيد حولها أو كيفية حلها.

- تُستخدم عمليات إعادة التوجيه الدائمة 301 لإرسال حركة المرور بشكل دائم من عنوان URL إلى آخر. سيسمح لك نظام إدارة المحتوى (CMS) بإعداد عمليات إعادة التوجيه هذه ، ولكن الكثير منها يمكن أن يبطئ موقعك ويؤدي إلى تدهور تجربة المستخدم لأن كل عملية إعادة توجيه إضافية تزيد من وقت تحميل الصفحة. استهدف عدم وجود سلاسل إعادة توجيه صفرية ، إن أمكن ، لأن الكثير منها سيؤدي إلى توقف محركات البحث عن الزحف إلى تلك الصفحة.

- 302 إعادة التوجيه المؤقت هي طريقة لإعادة توجيه حركة المرور مؤقتًا من عنوان URL إلى صفحة ويب مختلفة. بينما سيرسل رمز الحالة هذا المستخدمين تلقائيًا إلى صفحة الويب الجديدة ، ستظل علامة العنوان المخبأة وعنوان URL والوصف متسقة مع عنوان URL الأصلي. إذا بقيت إعادة التوجيه المؤقتة في مكانها لفترة كافية ، فسيتم التعامل معها في النهاية على أنها إعادة توجيه دائمة وستنتقل هذه العناصر إلى عنوان URL المقصود.

- 403 الرسائل المحظورة تعني أن المحتوى الذي طلبه المستخدم مقيد بناءً على أذونات الوصول أو بسبب خطأ في تهيئة الخادم.

- تخبر صفحات الخطأ 404 المستخدمين أن الصفحة التي طلبوها غير موجودة ، إما بسبب إزالتها أو أنهم كتبوا عنوان URL خاطئًا. من الجيد دائمًا إنشاء صفحات 404 مرتبطة بالعلامة التجارية وجذابة لإبقاء الزوار على موقعك (انقر فوق الرابط أعلاه لمشاهدة بعض الأمثلة الجيدة).

- 405 طريقة غير مسموح بها تعني أن خادم موقع الويب الخاص بك قد تعرف ولا يزال يحظر طريقة الوصول ، مما أدى إلى ظهور رسالة خطأ.

- 500 خطأ داخلي في الخادم هي رسالة خطأ عامة تعني أن خادم الويب لديك يواجه مشكلات في تسليم موقعك إلى الطرف الطالب.

- يرتبط الخطأ 502 Bad Gateway Error بسوء الاتصال أو الاستجابة غير الصالحة بين خوادم موقع الويب.

- تخبرك 503 Service Unavailable أنه بينما يعمل الخادم الخاص بك بشكل صحيح ، فإنه غير قادر على تلبية الطلب.

- 504 Gateway Timeout تعني أن الخادم لم يتلق استجابة في الوقت المناسب من خادم الويب الخاص بك للوصول إلى المعلومات المطلوبة.

مهما كان سبب هذه الأخطاء ، من المهم معالجتها لإرضاء كل من المستخدمين ومحركات البحث ، وللاستمرار في العودة إلى موقعك.

حتى إذا تم الزحف إلى موقعك وفهرسته ، فإن مشكلات الوصول التي تحظر المستخدمين والروبوتات ستؤثر على مُحسنات محركات البحث لديك. ومع ذلك ، نحتاج إلى الانتقال إلى المرحلة التالية من تدقيق SEO الفني الخاص بك - إمكانية العرض.

قائمة مراجعة قابلية العرض

قبل الغوص في هذا الموضوع ، من المهم ملاحظة الفرق بين إمكانية الوصول إلى تحسين محركات البحث وإمكانية الوصول إلى الويب . يتمحور الأخير حول جعل صفحات الويب الخاصة بك سهلة التصفح للمستخدمين ذوي الإعاقات أو الإعاقات ، مثل العمى أو عسر القراءة ، على سبيل المثال. تتداخل العديد من عناصر إمكانية الوصول عبر الإنترنت مع أفضل ممارسات تحسين محركات البحث. ومع ذلك ، فإن تدقيق إمكانية الوصول إلى تحسين محركات البحث (SEO) لا يأخذ في الحسبان كل ما تحتاج إلى القيام به لجعل موقعك أكثر سهولة للزوار الذين تم تعطيلهم.

سنركز على إمكانية الوصول إلى تحسين محركات البحث (SEO) ، أو العرض ، في هذا القسم ، ولكن ضع إمكانية الوصول إلى الويب في مقدمة اهتماماتك أثناء تطوير موقعك وصيانته.

قائمة مراجعة قابلية العرض

يعتمد الموقع الذي يمكن الوصول إليه على سهولة العرض. فيما يلي عناصر موقع الويب لمراجعتها لتدقيق إمكانية العرض.

أداء الخادم

كما تعلمت أعلاه ، ستؤدي مهلات وأخطاء الخادم إلى حدوث أخطاء HTTP تعيق المستخدمين والروبوتات من الوصول إلى موقعك. إذا لاحظت أن الخادم الخاص بك يواجه مشكلات ، فاستخدم الموارد المقدمة أعلاه لاستكشاف الأخطاء وإصلاحها وحلها. يمكن أن يؤدي عدم القيام بذلك في الوقت المناسب إلى قيام محركات البحث بإزالة صفحة الويب الخاصة بك من فهرسها حيث أن إظهار صفحة معطلة للمستخدم يعد تجربة سيئة.

حالة HTTP

على غرار أداء الخادم ، ستمنع أخطاء HTTP الوصول إلى صفحات الويب الخاصة بك. يمكنك استخدام زاحف الويب ، مثل Screaming Frog أو Botify أو DeepCrawl لإجراء تدقيق شامل للأخطاء في موقعك.

وقت التحميل وحجم الصفحة

إذا استغرق تحميل صفحتك وقتًا طويلاً جدًا ، فإن معدل الارتداد ليس هو المشكلة الوحيدة التي يجب أن تقلق بشأنها. يمكن أن يؤدي التأخير في وقت تحميل الصفحة إلى حدوث خطأ في الخادم يؤدي إلى حظر برامج الروبوت من صفحات الويب الخاصة بك أو جعلها تزحف إلى الإصدارات المحملة جزئيًا والتي تفتقد إلى أقسام مهمة من المحتوى. اعتمادًا على مقدار طلب الزحف الموجود لمورد معين ، ستنفق برامج الروبوت قدرًا معادلاً من الموارد لمحاولة تحميل الصفحات وعرضها وفهرستها. ومع ذلك ، يجب أن تفعل كل ما في وسعك لتقليل وقت تحميل صفحتك.

عرض جافا سكريبت

من المسلم به أن Google تواجه صعوبة في معالجة JavaScript (JS) ، وبالتالي توصي باستخدام محتوى معروض مسبقًا لتحسين إمكانية الوصول. تمتلك Google أيضًا مجموعة من الموارد لمساعدتك في فهم كيفية وصول روبوتات البحث إلى JS على موقعك وكيفية تحسين المشكلات المتعلقة بالبحث.

الصفحات اليتيمة

يجب ربط كل صفحة على موقعك بصفحة أخرىعلى الأقل- ويفضل أن تكون أكثر ، اعتمادًا على مدى أهمية الصفحة. عندما لا تحتوي الصفحة على روابط داخلية ، فإنها تسمى الصفحة اليتيمة. مثل مقالة بدون مقدمة ، تفتقر هذه الصفحات إلى السياق الذي تحتاجه الروبوتات لفهم كيفية فهرستها.

عمق الصفحة

يشير عمق الصفحة إلى عدد الطبقات الموجودة أسفل الصفحة في بنية موقعك ، أي عدد النقرات بعيدًا عن صفحتك الرئيسية. من الأفضل الحفاظ على بنية موقعك ضحلة قدر الإمكان مع الحفاظ على تسلسل هرمي بديهي. في بعض الأحيان يكون الموقع متعدد الطبقات أمرًا لا مفر منه ؛ في هذه الحالة ، سترغب في إعطاء الأولوية للموقع المنظم جيدًا على السطحية.

بغض النظر عن عدد الطبقات في بنية موقعك ، احتفظ بالصفحات المهمة - مثل منتجك وصفحات الاتصال - بما لا يزيد عن ثلاث نقرات عميقة. الهيكل الذي يدفن صفحة المنتج الخاصة بك في عمق موقعك بحيث يحتاج المستخدمون والروبوتات إلى لعب دور المحقق للعثور عليهم ، يصعب الوصول إليها ويقدم تجربة سيئة

على سبيل المثال ، يعد عنوان URL لموقع الويب مثل هذا الذي يوجه جمهورك المستهدف إلى صفحة منتجك مثالاً على بنية موقع سيئة التخطيط: www.yourwebsite.com/products-features/features-by-industry/airlines-case-studies/airlines -منتجات.

سلاسل إعادة التوجيه

عندما تقرر إعادة توجيه حركة المرور من صفحة إلى أخرى ، فأنت تدفع ثمنًا. هذا السعر هو الزحف الكفاءة. يمكن أن تؤدي عمليات إعادة التوجيه إلى إبطاء الزحف وتقليل وقت تحميل الصفحة وتجعل الوصول إلى موقعك غير ممكن إذا لم يتم إعداد عمليات إعادة التوجيه هذه بشكل صحيح. لكل هذه الأسباب ، حاول تقليل عمليات إعادة التوجيه إلى الحد الأدنى.

بمجرد معالجة مشكلات الوصول ، يمكنك الانتقال إلى كيفية ترتيب صفحاتك في SERPs.

قائمة مرجعية للترتيب

ننتقل الآن إلى العناصر الأكثر موضوعية التي ربما تكون على دراية بها بالفعل - كيفية تحسين الترتيب من وجهة نظر تقنية تحسين محركات البحث. يتضمن الحصول على ترتيب لصفحاتك بعض العناصر الموجودة على الصفحة وخارج الصفحة التي ذكرناها من قبل ولكن من منظور تقني.

تذكر أن كل هذه العناصر تعمل معًا لإنشاء موقع صديق لكبار المسئولين الاقتصاديين. لذلك ، سنكون مقصرين في استبعاد جميع العوامل المساهمة. دعونا نتعمق فيه.

الربط الداخلي والخارجي

تساعد الروابط روبوتات البحث في فهم مكان تناسب الصفحة في المخطط الكبير لاستعلام ما وتعطي سياقًا لكيفية ترتيب تلك الصفحة. توجه الروابط روبوتات البحث (والمستخدمين) إلى المحتوى ذي الصلة وأهمية صفحة النقل. بشكل عام ، يؤدي الربط إلى تحسين الزحف والفهرسة وقدرتك على الترتيب.

جودة الوصلة الخلفية

الروابط الخلفية - روابط من مواقع أخرى تعود إلى موقعك - توفر تصويتًا بالثقة لموقعك. يخبرون روبوتات البحث أن موقع الويب الخارجي أ يعتقد أن صفحتك عالية الجودة وتستحق الزحف. مع إضافة هذه الأصوات ، تلاحظ روبوتات البحث وتعامل موقعك على أنه أكثر مصداقية. يبدو وكأنه صفقة كبيرة ، أليس كذلك؟ ومع ذلك ، كما هو الحال مع معظم الأشياء العظيمة ، هناك تحذير. جودة هذه الروابط الخلفية مهمة كثيرًا.

يمكن أن تضر الروابط من المواقع منخفضة الجودة بالفعل بترتيبك. هناك العديد من الطرق للحصول على روابط خلفية عالية الجودة لموقعك ، مثل التواصل مع المنشورات ذات الصلة ، والمطالبة بالإشارات غير المرتبطة ، وتوفير المنشورات ذات الصلة ، والمطالبة بالإشارات غير المرتبطة ، وتوفير محتوى مفيد تريد المواقع الأخرى الارتباط به.

مجموعات المحتوى

نحن في HubSpot لم نخجل من حبنا لمجموعات المحتوى أو كيف تساهم في النمو العضوي . تقوم مجموعات المحتوى بربط المحتوى ذي الصلة بحيث يمكن لروبوتات البحث العثور بسهولة على جميع الصفحات التي تمتلكها في موضوع معين والزحف إليها وفهرستها. إنها تعمل كأداة للترويج الذاتي لتُظهر لمحركات البحث مدى معرفتك بموضوع ما ، لذلك من المرجح أن يصنفوا موقعك على أنه مرجع لأي استعلام بحث ذي صلة.

تعد قابلية التصنيف الخاصة بك هو المحدد الرئيسي في نمو حركة المرور العضوية لأن الدراسات تظهر أن الباحثين أكثر عرضة للنقر على نتائج البحث الثلاثة الأولى على SERPs. ولكن كيف تتأكد من أننتيجتكهي النتيجة التي يتم النقر عليها؟

دعنا نختصر هذا بالجزء الأخير في هرم المرور العضوي: إمكانية النقر.

انقر فوق قائمة التحقق

في حين أن نسبة النقر إلى الظهور (CTR) لها كل ما يتعلق بسلوك الباحث ، إلا أن هناك أشياءيمكنكالقيام بها لتحسين إمكانية النقر على SERPs. بينما تؤثر الأوصاف التعريفية وعناوين الصفحات مع الكلمات الرئيسية على نسبة النقر إلى الظهور ، فإننا سنركز على العناصر الفنية لأن هذا هو سبب وجودك هنا.

انقر فوق قائمة التحقق

- استخدم البيانات المنظمة.

- فوز ميزات SERP.

- تحسين المقتطفات المميزة.

- ضع في اعتبارك Google Discover.

يسير الترتيب ونسبة النقر إلى الظهور جنبًا إلى جنب لأن الباحثين ، لنكن صادقين ، يريدون إجابات فورية. كلما برزت نتيجتك في SERP ، زادت احتمالية حصولك على النقرة. لنستعرض بعض الطرق لتحسين إمكانية النقر.

1. استخدم البيانات المنظمة.

تستخدم البيانات المنظمة مفردات محددة تسمى المخطط لتصنيف العناصر وتسميتها على صفحة الويب الخاصة بك لروبوتات البحث. يوضح المخطط بوضوح ماهية كل عنصر ، ومدى ارتباطه بموقعك ، وكيفية تفسيره. في الأساس ، تخبر البيانات المنظمة برامج الروبوت ، "هذا فيديو" ، أو "هذا منتج" ، أو "هذه وصفة" ، مما لا يترك مجالًا للتفسير .

To be clear, using structured data is not a “clickability factor” (if there even is such a thing), but it does help organize your content in a way that makes it easy for search bots to understand, index, and potentially rank your pages.

2. Win SERP features.

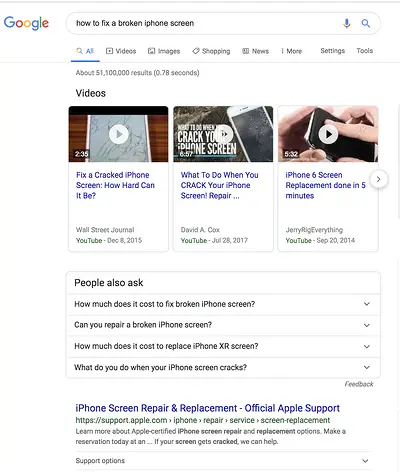

SERP features , otherwise known as rich results, are a double-edged sword. If you win themandget the click-through, you're golden. If not, your organic results are pushed down the page beneath sponsored ads, text answer boxes, video carousels, and the like.

Rich results are those elements that don't follow the page title, URL, meta description format of other search results. For example, the image below shows two SERP features — a video carousel and “People Also Ask” box — above the first organic result.

While you can still get clicks from appearing in the top organic results, your chances are greatly improved with rich results.

How do you increase your chances of earning rich results? Write useful content and use structured data. The easier it is for search bots to understand the elements of your site, the better your chances of getting a rich result.

Structured data is useful for getting these ( and other search gallery elements ) from your site to the top of the SERPs, thereby, increasing the probability of a click-through:

- Articles

- Videos

- المراجعات

- Events

- How-Tos

- FAQs (“People Also Ask” boxes)

- Images

- Local Business Listings

- Products

- Sitelinks

3. Optimize for Featured Snippets.

One unicorn SERP feature that has nothing to do with schema markup is Featured Snippets, those boxes above the search results that provide concise answers to search queries.

Featured Snippets are intended to get searchers the answers to their queries as quickly as possible. According to Google , providing the best answer to the searcher's query is the only way to win a snippet. However, HubSpot's research revealed a few additional ways to optimize your content for featured snippets .

4. Consider Google Discover.

Google Discover is a relatively new algorithmic listing of content by category specifically for mobile users. It's no secret that Google has been doubling down on the mobile experience; with over 50% of searches coming from mobile , it's no surprise either. The tool allows users to build a library of content by selecting categories of interest (think: gardening, music, or politics).

At HubSpot, we believe topic clustering can increase the likelihood of Google Discover inclusion and are actively monitoring our Google Discover traffic in Google Search Console to determine the validity of that hypothesis. We recommend that you also invest some time in researching this new feature. The payoff is a highly engaged user base that has basically hand-selected the content you've worked hard to create.

The Perfect Trio

Technical SEO, on-page SEO, and off-page SEO work together to unlock the door to organic traffic. While on-page and off-page techniques are often the first to be deployed, technical SEO plays a critical role in getting your site to the top of the search results and your content in front of your ideal audience. Use these technical tactics to round out your SEO strategy and watch the results unfold.