WordPress robots.txt

نشرت: 2019-02-26WordPress robots.txt مهم جدًا لتحسين محركات البحث. للتأكد من أن موقعك يحتل مرتبة جيدة في نتائج محرك البحث ، تحتاج إلى جعل صفحاته الأكثر أهمية ملائمة للبحث عن "الروبوتات" ("الروبوتات") الخاصة بمحركات البحث وفهرستها. سيساعد ملف robots.txt حسن التنظيم في توجيه هذه الروبوتات إلى الصفحات التي تريد فهرستها.

في هذه المقالة سوف نكشف عن مثل هذه الأسئلة:

- ما هو ملف robots.txt وسبب أهميته

- موقع WordPress robots txt

- أفضل نص للروبوتات لـ WordPress

- كيفية إنشاء ملف robots.txt

- كيفية التحقق من ملف robots.txt وإرساله إلى وحدة تحكم بحث Google.

ما هو ملف robots.txt لبرنامج WordPress ولماذا هو مهم؟

عند إنشاء موقع ويب جديد ، سترسل محركات البحث روبوتاتها لمسح جميع صفحاتها وإنشاء خريطة لها. بهذه الطريقة ، سيعرفون الصفحات التي سيتم عرضها كنتيجة عندما يبحث شخص ما عن الكلمات الرئيسية ذات الصلة. على المستوى الأساسي ، هذا بسيط للغاية (أيضًا ، تحقق من هذا المنشور المفيد - ملف htaccess الافتراضي في WordPress).

المشكلة هي أن المواقع الحديثة تحتوي على العديد من العناصر الأخرى إلى جانب الصفحات. يتيح لك WordPress تثبيت ، على سبيل المثال ، المكونات الإضافية التي غالبًا ما تحتوي على أدلة خاصة بها. ليست هناك حاجة لإظهار هذا في نتائج البحث ، لأنها لا تتطابق مع المحتوى.

ما يفعله ملف robots.txt هو توفير مجموعة من الإرشادات لروبوتات البحث. يقول لهم: "انظروا هنا وفهرس هذه الصفحات ، لكن لا تدخلوا مناطق أخرى!". يمكن أن يكون هذا الملف مفصلاً كما تريد ومن السهل جدًا إنشاؤه ، حتى لو كنت مبتدئًا.

من الناحية العملية ، ستستمر محركات البحث في فحص موقعك ، حتى إذا لم تقم بإنشاء ملف robots.txt. ومع ذلك ، فإن عدم إنشائها هو خطوة غير عقلانية للغاية. بدون هذا الملف ، تترك الروبوتات لفهرسة جميع محتويات موقعك ويقررون أنك بحاجة إلى إظهار جميع أجزاء موقعك ، حتى تلك التي ترغب في إخفائها من الوصول العام (أيضًا ، تحقق من - أفضل مكونات WordPress للتجارة الإلكترونية ).

نقطة أكثر أهمية ، بدون ملف robots.txt ، سيحصل موقع الويب الخاص بك على الكثير من الزيارات من برامج الروبوت الخاصة بموقعك. هذا سوف يؤثر سلبًا على أدائها. حتى إذا كان الحضور إلى موقعك لا يزال صغيراً ، فإن سرعة تحميل الصفحة هي شيء يجب أن يكون له الأولوية دائمًا وعلى أعلى مستوى. في النهاية ، لا يوجد سوى عدد قليل من الأشياء التي لا يحبها الناس أكثر من تحميل مواقع الويب ببطء.

موقع WordPress robots txt

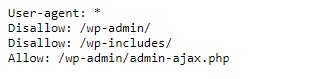

عند إنشاء موقع ويب WordPress ، يتم إنشاء ملف robots.txt تلقائيًا ووضعه في دليلك الرئيسي على الخادم. على سبيل المثال ، إذا كان موقعك موجودًا هنا - wpdevart.com ، فيمكنك العثور عليه على wpdevart.com/robots.txt ومشاهدة شيء مثل هذا:

هذا مثال على أبسط ملف robots.txt. الترجمة إلى لغة يمكن للبشر قراءتها ، الجانب الأيمن بعد وكيل المستخدم: يعلن

الروبوتات هي القواعد. تعني علامة النجمة أن القاعدة عالمية وتنطبق على جميع الروبوتات. في هذه الحالة ، يخبر الملف الروبوتات بأنه لا يمكنها فحص دلائل wp-admin و wp-include. معنى هذه القواعد هو أن هذه الأدلة تحتوي على الكثير من الملفات التي تتطلب الحماية من الوصول العام (أيضًا ، تحقق من المكون الإضافي WordPress Countdown).

بالطبع ، يمكنك إضافة المزيد من القواعد إلى ملفك. قبل القيام بذلك ، يجب أن تفهم أن هذا ملف افتراضي. عادةً ما يكون ملف robots.txt الخاص بـ WordPress موجودًا في الدليل الجذر ، والذي يُسمى غالبًا public_html أو www (أو باسم موقع الويب الخاص بك):

وتجدر الإشارة إلى أن ملف robots.txt الخاص بـ WordPress ، الذي تم إنشاؤه افتراضيًا ، لا يمكن الوصول إليه من أي دليل. إنه يعمل ، ولكن إذا كنت ترغب في إجراء تغييرات ، فأنت بحاجة إلى إنشاء ملف خاص بك وتحميله إلى الدليل الجذر.

سننظر في عدة طرق لإنشاء ملف robots.txt لبرنامج WordPress. الآن دعونا نناقش كيفية تحديد القواعد التي يجب تضمينها في الملف.

أفضل نص للروبوتات لـ WordPress

ليس من الصعب إنشاء أفضل نصوص روبوتات لموقع الويب الخاص بك على WordPress. إذن ما هي القواعد التي يجب تضمينها في ملف robots.txt. في القسم السابق ، رأينا مثالاً لملف robots.txt تم إنشاؤه بواسطة WordPress. يتضمن قاعدتين قصيرتين فقط ، لكنهما كافيان لمعظم المواقع. دعنا نلقي نظرة على ملفي robots.txt مختلفين ونرى ما يفعله كل منهما.

فيما يلي مثالنا الأول لملف WordPress robots.txt:

User-agent: * Allow: / # Disallowed Sub-Directories Disallow: / payout / Disallow: / photos / Disallow: / forums /يتم إنشاء ملف robots.txt هذا للمنتدى. محركات البحث عادة فهرسة كل موضوع المنتدى. اعتمادًا على موضوع المنتدى الخاص بك ، قد ترغب في عدم السماح بالفهرسة. على سبيل المثال ، لن تقوم Google بفهرسة مئات من مناقشات المستخدم القصيرة. يمكنك أيضًا تعيين القواعد التي تشير إلى موضوع منتدى معين لاستبعاده ، والسماح لمحركات البحث بفهرسة الباقي.

ستلاحظ أيضًا سطرًا يبدأ بـ Allow: / في أعلى الملف. يخبر هذا السطر الروبوتات أنه يمكنها فحص جميع صفحات موقعك ، باستثناء القيود المحددة أدناه. لقد لاحظت أيضًا أننا قمنا بتعيين هذه القواعد لتكون عالمية (مع علامة النجمة) ، كما كان الحال في ملف WordPress الظاهري robots.txt (أيضًا ، يمكنك التحقق من المكون الإضافي لجدول أسعار WordPress).

دعنا نتحقق من نموذج آخر لملف WordPress robots.txt:

User-agent: * Disallow: / wp-admin / Disallow: / wp-includes / User-agent: Bingbot Disallow: /في هذا الملف ، قمنا بتعيين نفس القواعد التي تنتقل افتراضيًا إلى WordPress. على الرغم من أننا نضيف أيضًا مجموعة جديدة من القواعد التي تمنع روبوتات بحث Bing من الزحف إلى موقعنا. Bingbot ، كما ترى ، هو اسم الروبوت.

يمكنك كتابة أسماء محركات البحث الأخرى لتقييد / السماح بالوصول إليها أيضًا. من الناحية العملية ، بالطبع ، يعتبر Bingbot جيدًا جدًا (حتى لو لم يكن بجودة Googlebot). ومع ذلك ، هناك العديد من الروبوتات الخبيثة.

النبأ السيئ هو أنهم لا يتبعون دائمًا التعليمات الواردة في ملف robots.txt (لا يزالون يعملون مثل الإرهابيين). يجب أن يؤخذ في الاعتبار أنه على الرغم من أن معظم الروبوتات ستستخدم الإرشادات الواردة في هذا الملف ، فلا يمكنك إجبارها على القيام بذلك.

إذا تعمقت في الموضوع ، ستجد العديد من الاقتراحات حول ما يجب السماح به وما يجب حظره على موقع WordPress الخاص بك. على الرغم من تجربتنا ، فإن القواعد الأقل غالبًا ما تكون أفضل. هنا مثال على

أفضل robots txt لموقع WordPress ، ولكن قد يكون مختلفًا بالنسبة إلى مواقع الويب المختلفة:

User-agent: * Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Disallow: *utm*= Disallow: *openstat= Allow: */uploads Sitemap: https://wpdevart.com/sitemap.xmlتقليديًا ، يحب WordPress إغلاق مجلدات wp-admin و wp-include. ومع ذلك ، لم يعد هذا هو الحل الأفضل. بالإضافة إلى ذلك ، إذا قمت بإضافة العلامات الوصفية لصورك بغرض الترويج (SEO) ، فلا فائدة من إخبار الروبوتات بعدم فهرسة محتويات هذه الأدلة.

ما يجب أن يحتوي على ملف robots.txt الخاص بك سيعتمد على احتياجات موقعك. لذلك لا تتردد في القيام بالمزيد من البحث!

كيفية إنشاء ملف robots.txt

ما الذي يمكن أن يكون أبسط من إنشاء ملف نصي (txt). كل ما عليك فعله هو فتح المحرر المفضل لديك (مثل Notepad أو TextEdit) وإدخال بضعة أسطر. ثم تقوم بحفظ الملف باستخدام برامج الروبوت وامتداد النص (robots.txt). سيستغرق الأمر بضع ثوانٍ ، لذا قد ترغب في إنشاء ملف robots.txt لـ WordPress دون استخدام مكون إضافي.

لقد حفظنا هذا الملف محليًا على الكمبيوتر. بمجرد إنشاء ملفك الخاص ، ستحتاج إلى الاتصال بموقعك عبر FTP (ربما باستخدام FileZilla).

بعد الاتصال بموقعك ، انتقل إلى دليل public_html. الآن ، كل ما عليك فعله هو تحميل ملف robots.txt من جهاز الكمبيوتر الخاص بك إلى الخادم. يمكنك القيام بذلك إما عن طريق النقر بزر الماوس الأيمن على الملف في متصفح FTP المحلي أو ببساطة عن طريق سحبه باستخدام الماوس.

يستغرق سوى بضع ثوان. كما ترى ، هذه الطريقة أسهل من استخدام البرنامج المساعد.

كيفية التحقق من ملف robots.txt من WordPress وإرساله إلى Google Search Console

بعد إنشاء ملف robots.txt الخاص بـ WordPress وتحميله ، يمكنك التحقق من وجود أخطاء في Google Search Console. Search Console عبارة عن مجموعة من أدوات Google المصممة لمساعدتك في تتبع كيفية ظهور المحتوى الخاص بك في نتائج البحث. تتحقق إحدى هذه الأدوات من ملف robots.txt ، وستجده بسهولة على صفحة مسؤول أدوات مشرفي المواقع من Google (أيضًا ، تحقق من أفضل 50 برنامج WordPress Plugins 2020).

ستجد هناك حقل المحرر حيث يمكنك إضافة الرمز لملف WordPress robots.txt الخاص بك ، ثم انقر فوق إرسال في الزاوية اليمنى السفلية. ستطلب منك وحدة تحكم بحث Google ما إذا كنت تريد استخدام الرمز الجديد أو تنزيل ملف من موقع الويب الخاص بك.

الآن ستقوم المنصة بفحص الملف الخاص بك بحثًا عن الأخطاء. إذا تم العثور على خطأ ، فسيتم عرض معلومات حول هذا لك. لقد رأيت بعض الأمثلة على ملف WordPress robots.txt ، والآن لديك المزيد من الفرص لإنشاء ملف robots.txt المثالي الخاص بك!