Schritt-für-Schritt-Anleitung zur Installation von Open-Source-LLM in Ihrer lokalen Umgebung – ohne Internet

Veröffentlicht: 2023-12-20Zusammenfassung

In der sich schnell weiterentwickelnden Welt der KI stellt die Installation eines Large Language Model (LLM) wie FALCON in einem lokalen System eine Reihe einzigartiger Herausforderungen und Chancen dar. Dieser Leitfaden soll Sie durch die entscheidenden Schritte der Einrichtung von FALCON Open-Source LLM führen und sich dabei auf die Erzielung optimaler Leistung bei gleichzeitiger Wahrung strenger Datenschutz- und Sicherheitsanforderungen konzentrieren.

Begeben Sie sich auf die Bereitstellungsreise von FALCON, einem führenden Open-Source-LLM (Large Language Model), vor Ort und sorgen Sie für Spitzenleistung und robuste Sicherheit. Dieser umfassende Leitfaden behandelt Hardwarevoraussetzungen, Softwareinstallation und Datenschulung und unterstreicht gleichzeitig die Bedeutung regelmäßiger Tests, Wartung, Skalierbarkeitsüberlegungen und Kostenanalysen. Für eine breitere Perspektive bleiben Sie über die fünf besten Open-Source-LLMs informiert und erwägen Sie, das Fachwissen von Creole Studios für eine sichere Implementierung zu nutzen, damit Sie die Leistungsfähigkeit der KI nutzen und gleichzeitig strenge Datenschutzstandards einhalten können.

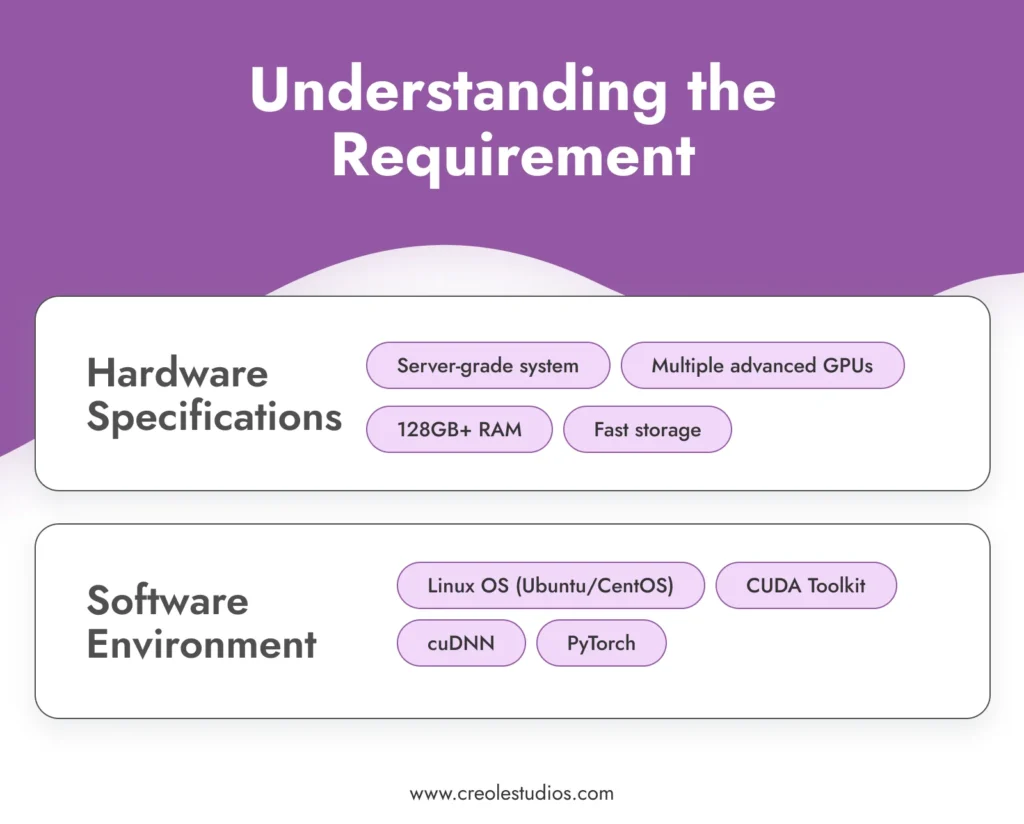

Die Anforderung verstehen

Bevor Sie mit dem Installationsprozess beginnen, ist es wichtig, die Anforderungen für den Betrieb eines anspruchsvollen Modells wie FALCON zu verstehen .

- Hardware-Spezifikationen : FALCON erfordert mit seinen gewaltigen 180 Milliarden Parametern erhebliche Rechenressourcen. Dies erfordert eine leistungsstarke Computerumgebung, die in der Regel Serversysteme umfasst, die mit mehreren fortschrittlichen GPUs (z. B. NVIDIA A100s), umfangreichem RAM (128 GB oder mehr) und Hochgeschwindigkeitsspeicherlösungen (SSDs oder NVMe) zur Verwaltung des Modells ausgestattet sind und Daten effizient verwalten. Sie können sich auf die Richtlinien von NVIDIA zum Einrichten von KI- und ML-Umgebungen beziehen.

- Softwareumgebung : Für den effektiven Betrieb von FALCON ist eine stabile und kompatible Softwareumgebung erforderlich. Ein Linux-basiertes Betriebssystem wie Ubuntu oder CentOS wird aufgrund seiner hervorragenden GPU-Unterstützung und Kompatibilität mit wichtigen Tools und Bibliotheken empfohlen. Der Software-Stack umfasst das CUDA Toolkit für GPU-Beschleunigung, cuDNN für tiefe neuronale Netze und Frameworks für maschinelles Lernen wie PyTorch.

Erwerben Sie das Modell

Der nächste Schritt ist die Anschaffung des FALCON-Modells. Dies kann Folgendes umfassen :

- Modelllizenzierung : Überprüfen Sie die neuesten Verfügbarkeits- und Lizenzoptionen für FALCON. Die Lizenzierung eines Modells wie FALCON erfordert in der Regel Verhandlungen und Vereinbarungen, um sicherzustellen, dass Sie das gesetzliche Recht haben, das Modell zu nutzen. Behalten Sie das offizielle FALCON-Repository oder verwandte Marktplätze für KI-Modelle im Auge, um Updates und Lizenzdetails zu erhalten.

- Modellübertragung : Angesichts der Luftspaltstruktur des Aufbaus ist die Übertragung des Modells in Ihre lokale Umgebung ein entscheidender Schritt. Dies kann die physische Übertragung des Modells über sichere, verschlüsselte Speichergeräte beinhalten. Bei dieser Übertragung stehen die Integrität und Sicherheit des Modells im Vordergrund.

Richten Sie die Infrastruktur ein

Der Aufbau einer robusten Infrastruktur ist für den effizienten Betrieb von FALCON LLM von entscheidender Bedeutung :

- Serverkonfiguration : Optimieren Sie Ihre Server für hochintensive KI-Arbeitslasten. Dazu gehört die Konfiguration mehrerer GPUs für die parallele Verarbeitung, die Sicherstellung einer Netzwerkverbindung mit hoher Bandbreite innerhalb des Systems und die Implementierung effektiver Kühllösungen zur Steuerung der Wärmeabgabe.

- Speicherverwaltung : Planen Sie Ihre Speicherarchitektur angesichts der Größe von FALCON und der potenziell großen Datenmengen, mit denen Sie arbeiten werden, sorgfältig. Aufgrund ihrer Geschwindigkeit werden SSDs oder NVMe-Laufwerke mit hoher Kapazität empfohlen. Stellen Sie sicher, dass Redundanz- und Backup-Systeme vorhanden sind.

- Stromversorgung und Kühlung : Diese leistungsstarken Server benötigen angemessene Stromversorgungs- und Kühlsysteme. Stellen Sie sicher, dass Ihre Infrastruktur diesen Anforderungen gerecht wird. Es ist ratsam, Hardware-Spezialisten zu konsultieren, um ein Rechenzentrum zu entwerfen, das dieser Einrichtung standhalten kann

Installieren Sie die erforderliche Software

Die Softwareinstallation ist ein entscheidender Schritt bei der Einrichtung Ihres Open-Source-LLM :

- Betriebssystem-Setup : Installieren Sie die von Ihnen gewählte Linux-Distribution. Ubuntu und CentOS sind aufgrund ihrer Stabilität und Unterstützung beliebte Optionen. Stellen Sie sicher, dass das Betriebssystem so konfiguriert ist, dass es die Hardwareressourcen optimal nutzt.

- Abhängigkeitsinstallation : Installieren Sie CUDA Toolkit für GPU-Unterstützung, cuDNN für Deep-Learning-Funktionen und PyTorch als Framework für maschinelles Lernen. Stellen Sie sicher, dass Sie Versionen verwenden, die mit dem FALCON-Modell kompatibel sind.

- Sicherheitssoftware : In einer Air-Gap-Umgebung ist die interne Sicherheit von entscheidender Bedeutung. Installieren Sie robuste Firewall- und Intrusion-Detection-Systeme. Auch wenn das System isoliert ist, kann es zu internen Bedrohungen oder versehentlichen Sicherheitsverletzungen kommen.

Modellinstallation

Die Installation des FALCON-Modells umfasst mehrere Schritte :

- Modellübertragung : Übertragen Sie die Modelldateien mithilfe verschlüsselter Speichergeräte sicher auf Ihr lokales System.

- Installationsprozess : Befolgen Sie die von FALCON bereitgestellte Installationsanleitung. Dies umfasst normalerweise das Einrichten der Umgebungsvariablen, das Laden der Modelldateien und das Konfigurieren der Modellparameter.

- Überprüfung : Überprüfen Sie nach der Installation die Integrität der Installation. Stellen Sie sicher, dass die Modelldateien intakt sind und das Modell die Erstdiagnose ordnungsgemäß durchführt.

Datensicherheit und Compliance

Die Gewährleistung der Datensicherheit in einer Air-Gap-Umgebung erfordert mehrere Schutzebenen :

- Verschlüsselung : Alle Daten, sowohl im Ruhezustand als auch bei der Übertragung innerhalb des Netzwerks, sollten verschlüsselt werden. Implementieren Sie starke Verschlüsselungsprotokolle, um Ihre Daten zu schützen.

- Compliance : Halten Sie sich an relevante Datenschutzbestimmungen und Branchenstandards. Überprüfen Sie Ihre Systeme regelmäßig auf Konformität.

- Zugriffskontrolle : Implementieren Sie strenge Zugriffskontrollrichtlinien. Nur autorisiertes Personal sollte Zugriff auf das Modell und die Daten haben.

Trainieren des Modells mit kuratierten Daten

Um FALCON an Ihre spezifischen Bedürfnisse anzupassen, ist das Training mit kuratierten Daten unerlässlich .

- Datenerfassung und -vorbereitung : Sammeln Sie für Ihren Anwendungsfall relevante Daten. Diese Daten sollten repräsentativ, vielfältig und von hoher Qualität sein. Verarbeiten und bereinigen Sie die Daten vor, um sicherzustellen, dass sie für das Training geeignet sind.

- Trainingsprozess : Konfigurieren Sie die Trainingsparameter von FALCON entsprechend Ihren Zielen. Das Trainieren eines Modells wie FALCON erfordert ein tiefes Verständnis der Prinzipien des maschinellen Lernens und der Besonderheiten der Modellarchitektur.

- Überwachung und Anpassung : Überwachen Sie den Trainingsprozess kontinuierlich auf Leistung und Genauigkeit. Seien Sie darauf vorbereitet, die Trainingsdaten oder -parameter nach Bedarf anzupassen, um die gewünschten Ergebnisse zu erzielen.

Prüfung und Wartung

Regelmäßige Tests und Wartung sind entscheidend für den langfristigen Erfolg des Modells .

- Leistungstests : Testen Sie das Modell regelmäßig auf Genauigkeit und Effizienz. Dazu gehört das Ausführen von Validierungsdatensätzen und das Überprüfen der Modellausgaben auf Konsistenz und Qualität.

- Software- und Hardwarewartung : Aktualisieren und patchen Sie die Softwareumgebung regelmäßig. Warten Sie die Hardware, um einen effizienten Betrieb sicherzustellen, einschließlich der Verwaltung der Kühlsysteme, der Überprüfung der Netzteile und des Austauschs fehlerhafter Komponenten.

- Modellaktualisierung : Bleiben Sie über Aktualisierungen des FALCON-Modells auf dem Laufenden. In einer Air-Gap-Umgebung erfordert die Aktualisierung des Modells möglicherweise die manuelle Übertragung aktualisierter Modelldateien.

Skalierbarkeit und Kosten

Berücksichtigen Sie das zukünftige Wachstum und die Kostenauswirkungen Ihrer Einrichtung .

- Skalierbarkeitsplanung : Planen Sie eine mögliche Skalierung Ihrer Infrastruktur. Dies kann das Hinzufügen weiterer GPUs, die Erweiterung des Speichers oder die Verbesserung der Netzwerkkapazitäten innerhalb der Air-Gap-Umgebung umfassen.

- Kostenanalyse : Überprüfen Sie regelmäßig die Kosten, die mit der Wartung und dem Betrieb von FALCON verbunden sind. Darin sind Hardwarekosten, Energieverbrauch und Lizenzgebühren enthalten.

Abschließende Anmerkungen: Die Bedeutung von Open-Source-LLMs und die Expertise von Creole Studios

Die lokale Installation von Open-Source-LLMs wie FALCON bietet erhebliche Vorteile, darunter beispiellosen Datenschutz, Anpassung und Kontrolle über Ihre KI-Funktionen. Es ermöglicht Unternehmen, die Leistungsfähigkeit der KI zu nutzen und gleichzeitig sicherzustellen, dass sensible Daten innerhalb der Grenzen ihres sicheren, privaten Netzwerks bleiben.

Creole Studios zeichnet sich dadurch aus, dass es Kunden bei dem komplexen Prozess der Einrichtung und Wartung von Open-Source-LLMs in lokalen, Air-Gap-Umgebungen unterstützt. Unser Fachwissen sorgt für eine reibungslose, sichere und effektive Implementierung und ermöglicht es Unternehmen, das volle Potenzial von KI auszuschöpfen und gleichzeitig die höchsten Datenschutz- und Sicherheitsstandards einzuhalten. Mit unserer Unterstützung können Unternehmen die Herausforderungen der KI-Implementierung souverän meistern und in der sich schnell entwickelnden Technologielandschaft vorne bleiben.