Hadoop HDFS und NoSQL: Eine leistungsstarke Kombination für Big Data

Veröffentlicht: 2023-01-05Hadoop ist ein Open-Source-Framework, das die verteilte Verarbeitung großer Datensätze über Computercluster hinweg mithilfe eines einfachen Programmiermodells ermöglicht. HDFS ist das Hadoop Distributed File System , das eine skalierbare und fehlertolerante Methode zum Speichern von Daten bietet. NoSQL-Datenbanken sind eine neue Klasse von Datenbanken, die eine skalierbare, flexible und leistungsstarke Alternative zu herkömmlichen relationalen Datenbanken bieten sollen.

Der Hauptunterschied zwischen Hadoop und HDFS besteht darin, dass Hadoop ein Open-Source-Framework zum Speichern, Verarbeiten und Analysieren von Daten ist, während HDFS ein Dateisystem ist, das Benutzern den Zugriff auf Hadoop-Daten ermöglicht. Folglich ist HDFS ein Hadoop-Modul .

Sowohl SQL als auch Hadoop können Daten auf verschiedene Weise verwalten. Ein Hadoop-Framework wird zum Zusammenstellen von Softwarekomponenten verwendet, während ein SQL-Framework zum Zusammenstellen von Datenbanken verwendet wird. Bei Big Data ist es wichtig, die Vor- und Nachteile der einzelnen Tools abzuwägen. Die Hadoop-Plattform speichert Daten nur einmal, während Hadoop eine viel größere Anzahl von Datensätzen speichert.

Hadoop ist keine Datenbank, sondern eine Software, die massives paralleles Computing ermöglicht. Diese Technologie ermöglicht NoSQL-Datenbanken (z. B. HBase) die Verteilung von Daten auf Tausende von Servern mit geringer Leistungseinbuße.

Hadoop speichert Daten nicht auf die gleiche Weise wie relationaler Speicher. Ein verteilter Server ist eine der Anwendungen, die ihn am häufigsten verwenden. Obwohl es sich um eine Hadoop-Datenbank handelt, gilt sie nicht als relationale Datenbank, da sie Dateien in HDFS (Distributed File System) speichert.

Was ist der Unterschied zwischen Nosql und Hdfs?

Es ist ein Dateisystem und wird auch als Dateisystem bezeichnet. Es ist bereits klar, dass diese App eine Reihe von Funktionen bietet. Wo bekommt man dieses NOSQL-Zeug her? Wir können damit große Datenmengen in Echtzeit verarbeiten, da wir keine relationalen Datenbanken oder andere Funktionen verwenden müssen.

Der in Hadoop ausgeführte HBase-Speichermanager bietet zufällige Lese- und Schreibvorgänge mit geringer Latenz. Das HBase-System verwendet eine Auto-Sharding-Funktion, bei der große Tabellen dynamisch verteilt werden. Jeder Regionsserver ist dafür verantwortlich, eine Reihe von Regionen zu bedienen, und es gibt nur einen Regionsserver, der eine Region bedienen kann (dh HMaster und HRegion sind zwei der Hauptdienste, die von HBase bereitgestellt werden. Die HRegion-Komponente der HBase-Tabelle ist für die Handhabung verantwortlich Teilmengen der Daten der Tabelle. Wenn ein Region Server gestartet wird, wird er jeder Region zugewiesen. Daher ist der Master nicht an den Lese- und Schreibvorgängen beteiligt.

Beim Umgang mit unstrukturierten und umfangreichen Daten heben sich NoSQL-Datenbanken wie MongoDB und Cassandra von traditionellen relationalen Datenbanken ab. Unternehmen mit großen Datenworkloads wie Big Data ziehen es vor, diese Tools zu verwenden, um riesige Mengen unterschiedlicher und unstrukturierter Daten schnell zu verarbeiten und zu analysieren. MongoDB speichert Daten in Sammlungen, während Hadoop Daten in einem anderen Dateisystem speichert, das als HDFS bekannt ist. Aufgrund dieses Unterschieds ist es vorteilhaft, eine unterschiedliche Architektur zu haben. Es ist auch viel schneller, Daten in MongoDB abzufragen, als einzelne Dateien zu durchsuchen. Da mongodb für Umgebungen mit hohem Volumen ausgelegt ist, eignet es sich außerdem gut für die Verarbeitung großer Datenmengen zu relativ geringen Kosten. Unternehmen, die Big-Data-Lösungen benötigen, wird empfohlen, NoSQL-Datenbanken zu verwenden. Sie haben zahlreiche Vorteile gegenüber herkömmlichen Datenbanken in Bezug auf Verarbeitungsgeschwindigkeit und Analytik und eignen sich gut für umfangreiche Datenanalyse und -verwaltung.

Ist Hadoop eine Nosql-Datenbank?

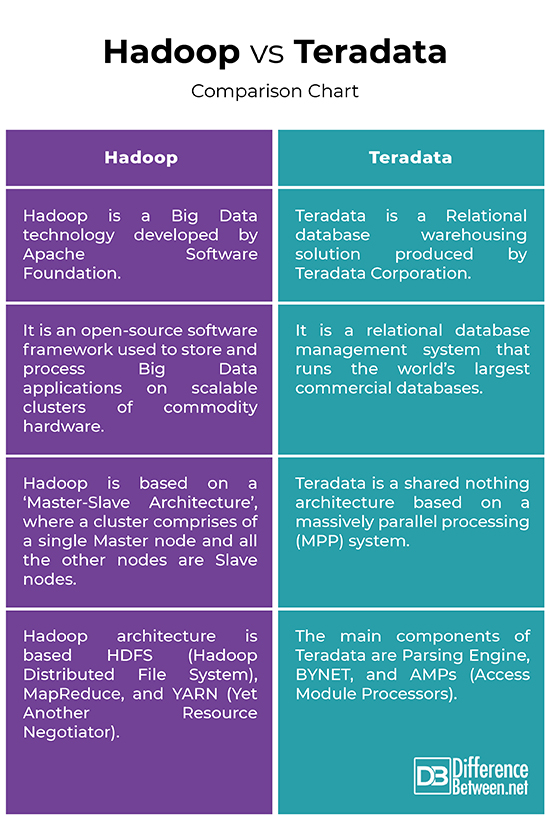

Hadoop ist kein traditionelles relationales Datenbankverwaltungssystem. Es handelt sich um ein verteiltes Dateisystem, das hilft, große Datenmengen über einen Cluster von Commodity-Servern zu speichern und zu verarbeiten. Hadoop wurde entwickelt, um von einzelnen Servern auf Tausende von Maschinen zu skalieren, die jeweils lokale Rechen- und Speicherfunktionen bieten.

Die Nutzung von Daten im supermassiven Maßstab wird durch neue Technologien revolutioniert. Die Big-Data-Infrastruktur hat zahlreiche Akteure, darunter Hadoop, NoSQL und Spark. DBAs und Infrastrukturingenieure/Entwickler arbeiten jetzt für sie, um komplexe Systeme in einer neuen Generation von DBAs und Infrastrukturingenieuren zu verwalten. Da Hadoop eher ein Software-Ökosystem als eine Datenbank ist, ermöglicht es die Berechnung riesiger Datenmengen mit einer Geschwindigkeit, die sowohl effizient als auch effektiv ist. Die Vorteile, die es für die riesigen Datenmengen bietet, die es verarbeitet, waren ein Wendepunkt für die Big-Data-Verarbeitung. Eine große Datentransaktion, die beispielsweise auf einem zentralisierten relationalen Datenbanksystem 20 Stunden dauert, kann auf einem Hadoop-Cluster in nur drei Minuten abgeschlossen werden.

Es steht mehr als eine SQL-Sprache zur Auswahl. MongoDB, eine reine Dokumentendatenbank, ist eine Art von NoSQL-Datenbank; Cassandra, eine breitspaltige Datenbank, ist eine andere; und Neo4j, eine Graphdatenbank, ist eine andere. Diese Funktion wurde von SQL-on- Hadoop erstellt. SQL-on-Hadoop ist eine neue Klasse von Analysewerkzeugen, die etablierte SQL-Abfragen mit Hadoop-Datenframeworks kombiniert. SQL-on-Hadoop ermöglicht Unternehmensentwicklern und Geschäftsanalysten die Zusammenarbeit mit Hadoop auf Commodity-Computing-Clustern, indem es die Ausführung vertrauter SQL-Abfragen ermöglicht. Die Vorteile von SQL-on-Hadoop. Die zahlreichen Vorteile von SQL-on-Hadoop, zusätzlich zu seiner Benutzerfreundlichkeit, sind die Zeit und die Ressourcen von Entwicklern und Analysten von Unternehmensdaten wert. Zu Beginn können sie mit Hadoop auf Commodity-Computing-Clustern arbeiten, was ihnen einen schnellen und einfachen Einstieg in Big-Data-Analysen ermöglicht. SQL-on-Hadoop ermöglicht es ihnen auch, vertraute SQL-Abfragen zu nutzen, was ihnen das Erlernen von Big-Data-Analysen erleichtert. Darüber hinaus bietet SQL-on-Hadoop die Map/Reduce-Funktionalität von Hadoop sowie die reichhaltigen Datenanalysefunktionen, die es bietet.

Nosql-Datenbanken auf dem Vormarsch

Infolgedessen werden NoSQL-Datenbanken aufgrund ihrer Skalierbarkeit, Lese-/Schreibleistung und Datenflexibilität immer beliebter. Es gibt mehrere gute Beispiele für NoSQL-Datenbanken auf dem Markt, darunter DynamoDB, Riak und Redis.

Hive ist eine leichte und modulare NoSQL-Datenbank mit hervorragenden Leistungskennzahlen. Es ist in der reinen Programmiersprache Dart geschrieben und aufgrund seiner Einfachheit bei Entwicklern beliebt.

Was ist der Unterschied zwischen Hadoop und Datenbank?

Während das RDBMS keine Daten speichert und verarbeitet, speichert und verarbeitet Hadoop Daten eher als verteiltes Dateisystem. Ein RDBMS hingegen ist eine strukturierte Datenbank, die Daten in Zeilen und Spalten speichert und mit SQL aktualisiert und in einer Vielzahl von Tabellen dargestellt werden kann.

Die Akzeptanz von Big-Data-Technologien und -Tools hat rasant zugenommen. Eine Open-Source-Hadoop-Distribution läuft auf einem verteilten Dateisystem und ermöglicht den Austausch und die Verarbeitung großer Datensätze. Eine RDB ist ein grundlegendes Datenbankverwaltungssystem, das in der einfachsten Form von allen Datenbankverwaltungssystemen wie Microsoft SQL Server, Oracle und MySQL verwendet wird. Obwohl es als Weiterentwicklung eingestuft wird, ähnelt ein RDBMS eher jeder anderen Standarddatenbank als einem großen Unterfangen. Es ist keine Datenbank, sondern ein verteiltes Dateisystem, das große Sammlungen von Datendateien aufnehmen und verarbeiten kann. Obwohl Systeme wie Hadoop eine bessere Leistung bieten können, gibt es einige Nachteile, die selten diskutiert werden. Sie müssen darüber nachdenken, wie Sie Ihren Hadoop-Cluster, Ihre Sicherheit, Presto oder jede andere von Ihnen verwendete Schnittstelle verwalten.

Die meisten relationalen Datenbanksysteme wie SQL Server und Oracle sind viel einfacher zu verwenden. Die meisten Unternehmen stehen vor dem großen Problem, dass sie nicht genügend qualifizierte Mitarbeiter haben, die Hadoop effektiv betreiben können, sowie erhebliche Kosten für Talente. Wenn Sie 10.000 Mitarbeiter haben, benötigen Sie viele Daten, um sie alle im Auge zu behalten. Diese Informationen können mit Presto auf verschiedene Arten gespeichert werden. Eine Datumspartition kann verwendet werden, um jeden Tag die Position einer Person zu speichern. Das RDBMS hingegen kann als Beispiel für ein Datenmodell verwendet werden. Diese Methode kann nur verwendet werden, wenn Sie bereits Zugriff auf die Daten des Vortages haben.

Was ist der Hauptunterschied zwischen relationalen Datenbanken und Big Data?

Der Hauptunterschied zwischen relationalen Datenbanken und Big Data besteht darin, dass relationale Datenbanken für die Speicherung strukturierter Daten optimiert sind, während Big Data für die Speicherung unstrukturierter und halbstrukturierter Daten optimiert ist. Eine relationale Datenbank ist nach dem relationalen Modell modelliert, während eine Big-Data-Datenbank nach dem verteilten Modell modelliert ist. Strukturierte Daten können effizient in relationalen Datenbanken gespeichert und verarbeitet werden. Die Tabelle enthält Daten und ermöglicht den Zugriff und das Abrufen in der strukturierten Abfragesprache (SQL). Big Data ist definiert als alle Daten, die unstrukturiert oder halbstrukturiert sind.

Was ist der Unterschied zwischen Hadoop und Mongodb?

Da MongoDB in C ausgeführt wird, ist es bei der Speicherverwaltung besser als jede andere Datenbank. Hadoop ist ein Java-basierter Softwaresatz, der ein Framework zum Speichern, Abrufen und Verarbeiten von Daten bereitstellt. Hadoop optimiert Speicherplatz effektiver als MongoDB.

MongoDB war eine in C erstellte NoSQL-Datenbank (Not Only SQL). Hadoop ist eine Open-Source-Softwareplattform, die hauptsächlich aus Java besteht und die Verarbeitung großer Datenmengen ermöglicht. Darüber hinaus umfasst MongoDB Atlas Volltextsuche, erweiterte Analysen und eine intuitive Abfragesprache. Hadoop ist effektiv beim Speichern und Verarbeiten einer großen Datenmenge, jedoch in kleinen Stapeln. In MongoDB ist eine Vielzahl von integrierten Echtzeit-Datenverarbeitungstools verfügbar. Aufgrund seiner Konnektoren für externe Tools wie Kafka und Spark vereinfacht MongoDB die Datenaufnahme und -verarbeitung. Die Vorteile von Hadoop und MongoDB gegenüber herkömmlichen Datenbanken im Bereich Big Data sind zahlreich. Hadoop, ein verteiltes Dateisystem, kann verwendet werden, um mit riesigen Dateien umzugehen. MongoDB ist die einzige Datenbank, die in Bezug auf die Leistung eine herkömmliche Datenbank ersetzen kann.

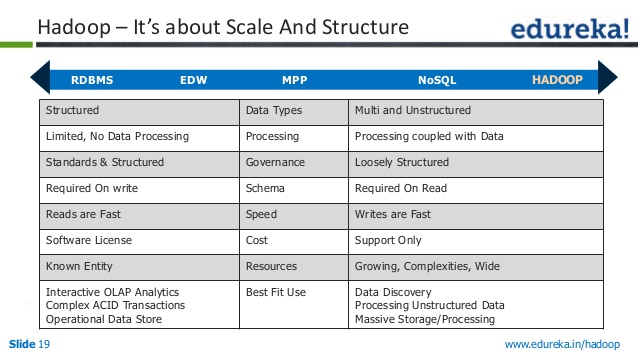

Rdbms gegen Nosql gegen Hadoop

Es gibt drei Haupttypen von Datenspeichern – RDBMS, NoSQL und Hadoop. Sie haben jeweils ihre eigenen Stärken und Schwächen, daher ist es wichtig, das richtige für Ihre Bedürfnisse auszuwählen.

RDBMS (Relational Database Management System) ist die häufigste Art von Datenspeicher. Es ist einfach zu bedienen und einfach zu skalieren. Es ist jedoch nicht so flexibel wie NoSQL oder Hadoop und kann teurer in der Wartung sein.

NoSQL (Not Only SQL) ist eine neuere Art von Datenspeicher, die immer beliebter wird. Es ist flexibler als RDBMS und lässt sich besser skalieren. Es ist jedoch nicht so einfach zu bedienen und kann teurer in der Wartung sein.

Hadoop ist eine Art Datenspeicher, der für Big Data entwickelt wurde. Es ist sehr skalierbar und kann viele Daten verarbeiten. Es ist jedoch nicht so einfach zu verwenden wie RDBMS oder NoSQL, und die Wartung kann teurer sein.

Der Ansatz eines Unternehmens zum Speichern, Verarbeiten und Analysieren von Daten kann mit der Apache Hadoop -Plattform erheblich verbessert werden. Ein Data Lake kann mehrere Arten von analytischen Workloads auf derselben Hardware und Software ausführen und Datenmengen in großem Umfang verwalten. Die Analysten können jetzt mithilfe von Tools wie Apache Impala und Apache Spark auch unterwegs effektiv mit Daten interagieren. Hadoop hat im Gegensatz zu Relational Database Management System (RDBMS) nicht die gleichen Fähigkeiten wie eine Datenbank, sondern ist eher ein verteiltes Dateisystem, das riesige Datenmengen verarbeiten kann. Die Datenmenge, die einfach und effektiv verarbeitet werden kann, wird als Datenvolumen Volumen bezeichnet. Mit anderen Worten, es ist der gesamte Datenvolumenprozess über einen bestimmten Zeitraum, der optimiert werden kann. Es hat die Fähigkeit, Daten aus einer Vielzahl von Quellen zu speichern, zu verarbeiten und für die Analyse aufzubereiten.

In geringem Umfang konnte das RDBMS nur strukturierte und halbstrukturierte Daten verwalten. Hadoop ist nicht in der Lage, Daten aus einer Vielzahl von Quellen oder strukturierten Strukturen zu verarbeiten. Reaktionszeit, Skalierbarkeit und Kosten sind einige der anderen wichtigen Faktoren, die es zu berücksichtigen gilt.

Warum Rdbms immer noch das beliebteste Datenbankverwaltungssystem ist

Das am weitesten verbreitete Datenbankverwaltungssystem der Welt ist das RDBMS. Es bietet eine Vielzahl von Funktionen und ist äußerst zuverlässig. Die relationale Datenbank eignet sich am besten zum Speichern von Daten, auf die mehrere Benutzer zugreifen müssen.

NoSQL-Datenbanken werden teilweise aufgrund ihrer Leistungsvorteile gegenüber relationalen Datenbanken immer beliebter. Sie ermöglichen es Ihnen auch, große Datenmengen zu speichern, die Sie nicht mit mehreren Benutzern teilen müssen.

Hadoop Nosql

Auf einem Commodity-Hardware-Cluster speichert Hadoop Big Data. Sie haben die Möglichkeit, jede Funktion, die nicht funktioniert oder Ihren Anforderungen entspricht, bei Bedarf zu ändern. Im Gegensatz dazu ist ein NoSQL-Datenbankverwaltungssystem eine Art Datenbankverwaltungssystem, das zum Speichern von strukturierten, halbstrukturierten und unstrukturierten Daten verwendet wird.

Ist Hdfs Eine Datenbank

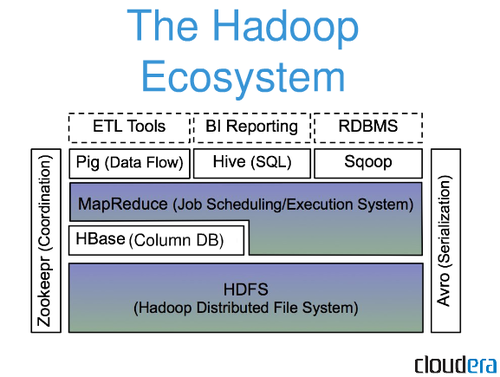

Das HDFS-Dateisystem ist ein verteiltes Dateisystem, das auf handelsüblicher Hardware ausgeführt wird. Ein einzelner Apache Hadoop-Cluster kann mit dieser Funktion so konfiguriert werden, dass er Hunderte (und sogar Tausende) von Knoten unterstützt. Apache Hadoop, zu dem auch MapReduce und YARN gehören, besteht aus mehreren Hauptkomponenten.

Den leistungsstarken Zugriff auf Daten ermöglicht das Hadoop Distributed File System (HDFS), das eine Komponente des Hadoop-Betriebssystems ist . Der primäre Namensknoten eines Clusters ist dafür verantwortlich, zu verfolgen, wo die Dateidaten des Clusters gespeichert sind. Zusätzlich zum Verwalten des Dateizugriffs verwaltet der Name-Knoten den Zugriff auf Dateien wie Lesen, Schreiben, Erstellen, Löschen usw. Yahoo hat das Hadoop Distributed File System als Teil seiner Online-Werbeplatzierungs- und Suchmaschinenanforderungen eingeführt. Das HDFS-Protokoll stellt einen Dateisystem-Namespace bereit, um Benutzerdaten zu speichern. DataNodes können während normaler Dateioperationen miteinander kommunizieren, weil sie miteinander kommunizieren. Das Hadoop Distributed File System (HDFS) ist Bestandteil vieler Open Source Data Lakes. HDFS wird von eBay, Facebook, LinkedIn und Twitter verwendet, um große Datenmengen zu analysieren. Im Falle eines Knoten- oder Hardwareausfalls ist eine Datenreplikation erforderlich, damit HDFS ordnungsgemäß funktioniert.

Beispiel einer Hadoop-Datenbank

Eine Hadoop-Datenbank ist eine Datenbank, die das Hadoop Distributed File System (HDFS) als zugrunde liegenden Speicher verwendet. Hadoop-Datenbanken werden normalerweise zum Speichern großer Datenmengen verwendet, die zu groß sind, um auf einen einzelnen Server zu passen.

Apache Hadoop ist ein Open-Source-Framework zum Speichern und Verarbeiten großer Datensätze auf verteilte Weise auf handelsüblicher Hardware und wird in einer Vielzahl von Anwendungen eingesetzt. Es ist eine Open-Source-Version des Google-Paradigmas, das in ihrem Papier MapReduce von 2004 verwendet wurde. Wir gehen in diesem Artikel auf einige der am häufigsten gestellten Fragen von Anfängern im Big-Data-Ökosystem ein. Die Apache Hadoop-Plattform konzentriert sich eher auf die verteilte Datenverarbeitung als auf Datenbankspeicherung oder relationale Speicherung. Trotz des Vorhandenseins einer als HDFS (Hadoop Distributed File System) bekannten Speicherkomponente, die Dateien speichert, die für die Verarbeitung verwendet werden, fällt HDFS unter die Kategorie einer relationalen Datenbank. Hive sowie HiveQL können verwendet werden, um den HDFS-Speicher von HDFS abzufragen, der in HDFS integriert ist.

Was ist ein Beispiel für Hadoop?

Hadoop kann von Finanzdienstleistungsunternehmen verwendet werden, um Risiken zu bewerten, Anlagemodelle zu erstellen und Handelsalgorithmen zu erstellen; Hadoop wurde auch verwendet, um bei der Erstellung und Verwaltung dieser Anwendungen zu helfen. Diese Technologie wird von Einzelhändlern verwendet, um ihnen durch die Analyse strukturierter und unstrukturierter Daten zu helfen, ihre Kunden besser zu verstehen und zu bedienen.

Die vielen Einsatzmöglichkeiten von Hadoop

Hadoop kann verwendet werden, um Daten in großen Datenanwendungen wie Big Data Analytics, Echtzeit-Datenanalyse, wissenschaftliche Forschung und Data Warehousing zu verwalten. Dadurch ist es eine vielseitige und anpassungsfähige Plattform, die sich ideal für eine Vielzahl von Anwendungen eignet.

Ist Spark eine Nosql-Datenbank?

Ein NoSQL DataFrame ist laut Dokumentation ein Datenquellenformat für den Spark DataFrame. DataPruning und Filterung (Prädikat-Pushdown) sind in dieser Datenquelle verfügbar, wodurch Spark-Abfragen mit kleineren Datenmengen ausgeführt werden können und nur die Daten geladen werden, die für den aktiven Job erforderlich sind.

Es erfordert viel taktischen Aufwand, eine Apache Spark- und NoSQL-Datenbank (Apache Cassandra und MongoDB) miteinander zu verbinden. In diesem Blog geht es darum, wie man Apache Spark-Anwendungen auf NoSQL-Backends erstellt. TCP/IP sPark ist ein beliebtes Freizeitparkziel mit einer großen Anzahl von Fahrgeschäften in seinen bekannten Abschnitten CassandraLand und MongoLand. Als unsere Spark-Anwendung Daten vom DOE nachschlug, drehte sie ihre Räder und wurde frustriert. Die Lektion hier ist, dass die Schlüsselsequenz von Cassandra beim Abrufen von Daten entscheidend ist. CassandraLand hat auch eine beliebte Achterbahn namens Partitioner. Kunden von Achterbahnfahrten werden ermutigt, ihre Fahrthistorie zu verfolgen, damit die Betreiber verfolgen können, wer sie jeden Tag gefahren ist. Mongo-Lektion 1 – MongoDB-Verbindungen korrekt verwalten Beim Aktualisieren von Daten, wie z. B. dem Status der neuen Parkmitgliedschaft des Energieministeriums, können Mongo-Indizes sehr hilfreich sein. Bei bestimmten Updates sollten MongoDB und Spark für eine ordnungsgemäße Verbindungsverwaltung und Indexierung sorgen.

Spark: Die Zukunft von Big Data

Apache Spark, ein verteiltes Verarbeitungssystem, das in Zusammenarbeit mit der Apache Software Foundation entwickelt wurde, ist ein Hadoop-basiertes Big-Data-Verarbeitungssystem. Ein Open-Source-Framework, das verwendet werden kann, um große Datensätze zu optimieren und die Lücke zwischen prozeduralen und relationalen Modellen zu schließen. Darüber hinaus unterstützt Spark MongoDB, sodass es für Echtzeitanalysen und maschinelles Lernen verwendet werden kann.