Der ultimative Leitfaden für technisches SEO

Veröffentlicht: 2023-02-24Nennen Sie drei Dinge, die Sie dieses Jahr im Zusammenhang mit der Suchmaschinenoptimierung (SEO) getan haben.

Drehen sich diese Taktiken um Keyword-Recherche, Meta-Beschreibungen und Backlinks?

Wenn ja, sind Sie nicht allein. Wenn es um SEO geht, sind diese Techniken normalerweise die ersten, die Vermarkter ihrem Arsenal hinzufügen.

Obwohl diese Strategien die Sichtbarkeit Ihrer Website in der organischen Suche verbessern, sind sie nicht die einzigen, die Sie anwenden sollten. Es gibt eine weitere Reihe von Taktiken, die unter den SEO-Schirm fallen.

Technisches SEO bezieht sich auf die Elemente hinter den Kulissen, die Ihren organischen Wachstumsmotor antreiben, wie z. B. Website-Architektur, mobile Optimierung und Seitengeschwindigkeit. Diese Aspekte von SEO sind vielleicht nicht die attraktivsten, aber sie sind unglaublich wichtig.

Der erste Schritt zur Verbesserung Ihrer technischen SEO besteht darin, zu wissen, wo Sie stehen, indem Sie ein Site-Audit durchführen. Der zweite Schritt besteht darin, einen Plan zu erstellen, um die Bereiche anzugehen, in denen Sie zu kurz kommen. Wir werden diese Schritte im Folgenden ausführlich behandeln.

Profi-Tipp: Erstellen Sie mit den kostenlosen CMS-Tools von HubSpot eine Website, die auf Conversions ausgelegt ist.

Was ist technisches SEO?

Technisches SEO bezieht sich auf alles, was Sie tun, um Ihre Website für Suchmaschinen leichter zu crawlen und zu indizieren. Technisches SEO, Inhaltsstrategie und Strategien zum Linkaufbau arbeiten alle zusammen, damit Ihre Seiten in der Suche einen hohen Rang einnehmen.

Technisches SEO vs. On-Page-SEO vs. Off-Page-SEO

Viele Menschen unterteilen die Suchmaschinenoptimierung (SEO) in drei verschiedene Bereiche: On-Page-SEO, Off-Page-SEO und technisches SEO. Lassen Sie uns schnell abdecken, was jedes bedeutet.

OnPage-SEO

On-Page-SEO bezieht sich auf den Inhalt, der Suchmaschinen (und Lesern!) Mitteilt, worum es auf Ihrer Seite geht, einschließlich Bild-Alt-Text, Keyword-Verwendung, Meta-Beschreibungen, H1-Tags, URL-Benennung und interne Verlinkung. Sie haben die größte Kontrolle über On-Page-SEO, weil sich allesaufIhrer Website befindet.

OffPage-SEO

Off-Page-SEO teilt Suchmaschinen durch Vertrauensvoten mit, wie beliebt und nützlich Ihre Seite ist – vor allem durch Backlinks oder Links von anderen Websites zu Ihrer eigenen. Quantität und Qualität der Backlinks erhöhen den PageRank einer Seite. Unter sonst gleichen Bedingungen wird eine Seite mit 100 relevanten Links von glaubwürdigen Websites eine Seite mit 50 relevanten Links von glaubwürdigen Websites (oder 100 irrelevante Links von glaubwürdigen Websites) übertreffen.

Technisches SEO

Technisches SEO liegt ebenfalls in Ihrer Kontrolle, ist jedoch etwas schwieriger zu meistern, da es weniger intuitiv ist.

Warum ist technisches SEO wichtig?

Sie könnten versucht sein, diese SEO-Komponente vollständig zu ignorieren; es spielt jedoch eine wichtige Rolle in Ihrem organischen Verkehr. Ihre Inhalte sind vielleicht die gründlichsten, nützlichsten und am besten geschriebenen, aber wenn eine Suchmaschine sie nicht crawlen kann, werden sie nur sehr wenige Menschen jemals sehen.

Es ist wie ein Baum, der in den Wald fällt, wenn niemand in der Nähe ist, um es zu hören … macht es ein Geräusch? Ohne eine starke technische SEO-Grundlage werden Ihre Inhalte für Suchmaschinen keinen Ton von sich geben.

Quelle

Quelle

Lassen Sie uns besprechen, wie Sie Ihre Inhalte im Internet zum Klingen bringen können.

Technisches SEO verstehen

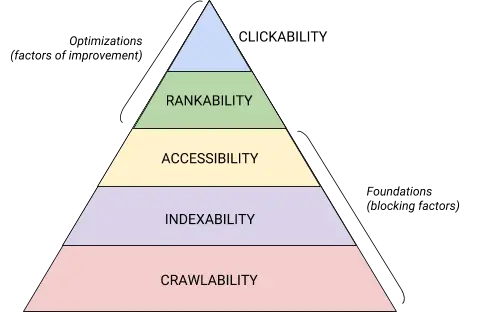

Technisches SEO ist ein Monster, das am besten in verdauliche Teile zerlegt wird. Wenn Sie wie ich sind, packen Sie große Dinge gerne in Stücken und mit Checklisten an. Ob Sie es glauben oder nicht, alles, was wir bisher behandelt haben, kann in eine von fünf Kategorien eingeordnet werden, von denen jede eine eigene Liste mit umsetzbaren Elementen verdient.

Diese fünf Kategorien und ihr Platz in der technischen SEO-Hierarchie werden am besten durch diese schöne Grafik veranschaulicht, die an Maslovs Hierarchie der Bedürfnisse erinnert, aber für die Suchmaschinenoptimierung neu gemischt wurde. (Beachten Sie, dass wir den allgemein verwendeten Begriff „Rendering“ anstelle von Barrierefreiheit verwenden werden.)

Quelle

Quelle

Grundlagen des technischen SEO-Audits

Bevor Sie mit Ihrem technischen SEO-Audit beginnen, müssen Sie einige Grundlagen schaffen.

Auditieren Sie Ihre bevorzugte Domain

Ihre Domain ist die URL, die Nutzer eingeben, um auf Ihre Website zu gelangen, z. B. hubspot.com . Ihre Website-Domain wirkt sich darauf aus, ob Menschen Sie über die Suche finden können, und bietet eine konsistente Möglichkeit, Ihre Website zu identifizieren.

Wenn Sie eine bevorzugte Domain auswählen, teilen Sie den Suchmaschinen mit, ob Sie die www- oder die nicht-www-Version Ihrer Website bevorzugen, um in den Suchergebnissen angezeigt zu werden. Sie können beispielsweisewww.ihrewebsite.comanstelle vonihrewebsite.comauswählen . Dies weist Suchmaschinen an, die www-Version Ihrer Website zu priorisieren, und leitet alle Benutzer zu dieser URL weiter. Andernfalls behandeln Suchmaschinen diese beiden Versionen als separate Websites, was zu einem verteilten SEO-Wert führt.

Zuvor hat Google Sie aufgefordert, die von Ihnen bevorzugte Version Ihrer URL anzugeben. Jetzt wird Google eine Version identifizieren und auswählen, die Suchenden für Sie angezeigt wird . Wenn Sie jedoch lieber die bevorzugte Version Ihrer Domain festlegen möchten, können Sie dies über kanonische Tags tun (auf die wir in Kürze eingehen werden). Sobald Sie Ihre bevorzugte Domain festgelegt haben, stellen Sie in jedem Fall sicher, dass alle Varianten, alsowww, non-www, http und index.html, dauerhaft auf diese Version umleiten.

Implementieren Sie SSL

Sie haben diesen Begriff vielleicht schon einmal gehört – das liegt daran, dass er ziemlich wichtig ist. SSL oder Secure Sockets Layer erstellt eine Schutzschicht zwischen dem Webserver (der Software, die für die Erfüllung einer Online-Anfrage verantwortlich ist) und einem Browser, wodurch Ihre Website sicher wird. Wenn ein Benutzer Informationen an Ihre Website sendet, z. B. Zahlungs- oder Kontaktinformationen, ist es weniger wahrscheinlich, dass diese Informationen gehackt werden, da Sie SSL verwenden, um sie zu schützen.

Ein SSL-Zertifikat wird durch eine Domain gekennzeichnet, die mit „https://“ anstelle von „http://“ beginnt, und einem Schlosssymbol in der URL-Leiste.

Suchmaschinen priorisieren sichere Websites – tatsächlich hat Google bereits 2014 angekündigt, dass SSL als Rankingfaktor betrachtet wird . Stellen Sie deshalb unbedingt die SSL-Variante Ihrer Homepage als bevorzugte Domain ein.

Nachdem Sie SSL eingerichtet haben, müssen Sie alle Nicht-SSL-Seiten von http auf https migrieren. Es ist eine große Aufgabe, aber im Namen eines verbesserten Rankings die Mühe wert. Hier sind die Schritte, die Sie ausführen müssen:

- Leiten Sie alle http://yourwebsite.com-Seiten auf https://yourwebsite.com um .

- Aktualisieren Sie alle kanonischen und hreflang-Tags entsprechend.

- Aktualisieren Sie die URLs in Ihrer Sitemap (unter yourwebsite.com/sitemap.xml ) und Ihrer robot.txt (unter yourwebsite.com/robots.txt ).

- Richten Sie eine neue Instanz von Google Search Console und Bing Webmaster Tools für Ihre https-Website ein und verfolgen Sie sie, um sicherzustellen, dass 100 % des Datenverkehrs migriert wird.

Seitengeschwindigkeit optimieren

Wissen Sie, wie lange ein Website-Besucher warten wird, bis Ihre Website geladen ist? Sechs Sekunden … und das ist großzügig. Einige Daten zeigen , dass die Absprungrate mit einer Erhöhung der Seitenladezeit von einer auf fünf Sekunden um 90 % steigt. Sie haben keine Sekunde zu verlieren, daher sollte die Verbesserung der Ladezeit Ihrer Website Priorität haben.

Die Website-Geschwindigkeit ist nicht nur für die Benutzererfahrung und Konversion wichtig, sondern auch ein Ranking-Faktor .

Verwenden Sie diese Tipps, um Ihre durchschnittliche Seitenladezeit zu verbessern:

- Komprimieren Sie alle Ihre Dateien. Die Komprimierung reduziert die Größe Ihrer Bilder sowie CSS-, HTML- und JavaScript-Dateien, sodass sie weniger Speicherplatz beanspruchen und schneller geladen werden.

- Überprüfe Weiterleitungen regelmäßig. Die Verarbeitung einer 301-Weiterleitung dauert einige Sekunden. Multiplizieren Sie das über mehrere Seiten oder Ebenen von Weiterleitungen, und Sie werden die Geschwindigkeit Ihrer Website ernsthaft beeinträchtigen.

- Kürzen Sie Ihren Code. Unordentlicher Code kann sich negativ auf die Geschwindigkeit Ihrer Website auswirken. Unordentlicher Code bedeutet Code, der faul ist. Es ist wie beim Schreiben – vielleicht bringen Sie im ersten Entwurf Ihren Standpunkt in 6 Sätzen vor. Im zweiten Entwurf schaffen Sie es in 3. Je effizienter der Code ist, desto schneller wird die Seite geladen (im Allgemeinen). Sobald Sie die Dinge aufgeräumt haben, verkleinern und komprimieren Sie Ihren Code .

- Betrachten Sie ein Content Distribution Network (CDN). CDNs sind verteilte Webserver, die Kopien Ihrer Website an verschiedenen geografischen Standorten speichern und Ihre Website basierend auf dem Standort des Suchenden bereitstellen. Da die Informationen zwischen den Servern kürzer zurückgelegt werden müssen, wird Ihre Website für die anfragende Partei schneller geladen.

- Versuchen Sie nicht, das Plugin glücklich zu machen. Veraltete Plugins weisen oft Sicherheitslücken auf, die Ihre Website anfällig für böswillige Hacker machen, die das Ranking Ihrer Website beeinträchtigen können. Stellen Sie sicher, dass Sie immer die neuesten Versionen von Plugins verwenden, und beschränken Sie Ihre Verwendung auf das Nötigste. Erwägen Sie in gleicher Weise die Verwendung von benutzerdefinierten Themen, da vorgefertigte Website-Themen oft mit viel unnötigem Code ausgestattet sind.

- Nutzen Sie Cache-Plugins. Cache-Plugins speichern eine statische Version Ihrer Website, um sie an wiederkehrende Benutzer zu senden, wodurch die Zeit zum Laden der Website bei wiederholten Besuchen verkürzt wird.

- Verwenden Sie asynchrones (asynchrones) Laden. Skripte sind Anweisungen, die Server lesen müssen, bevor sie den HTML- oder Textkörper Ihrer Webseite verarbeiten können, dh die Dinge, die Besucher auf Ihrer Website sehen möchten. Typischerweise werden Skripte im <head> einer Website platziert (denken Sie an: Ihr Google Tag Manager-Skript), wo sie gegenüber dem Inhalt auf dem Rest der Seite priorisiert werden. Die Verwendung von asynchronem Code bedeutet, dass der Server HTML und Skript gleichzeitig verarbeiten kann, wodurch die Verzögerung verringert und die Ladezeit der Seite verlängert wird.

So sieht ein asynchrones Skript aus: < script async src =" script.js "></ script >

Wenn Sie sehen möchten, wo Ihre Website in der Geschwindigkeitsabteilung zurückbleibt, können Sie diese Ressource von Google verwenden .

Sobald Sie Ihre technischen SEO-Grundlagen eingerichtet haben, können Sie mit der nächsten Stufe fortfahren – der Crawlbarkeit.

Crawling-Checkliste

Crawlability ist die Grundlage Ihrer technischen SEO-Strategie. Such-Bots durchsuchen Ihre Seiten, um Informationen über Ihre Website zu sammeln.

Wenn diese Bots irgendwie am Crawlen gehindert werden, können sie Ihre Seiten nicht indexieren oder ranken. Der erste Schritt zur Implementierung von technischem SEO besteht darin, sicherzustellen, dass alle wichtigen Seiten zugänglich und einfach zu navigieren sind.

Im Folgenden behandeln wir einige Elemente, die Sie Ihrer Checkliste hinzufügen können, sowie einige Website-Elemente, die Sie prüfen müssen, um sicherzustellen, dass Ihre Seiten optimal gecrawlt werden können.

Crawling-Checkliste

- Erstellen Sie eine XML-Sitemap.

- Maximieren Sie Ihr Crawl-Budget.

- Optimieren Sie Ihre Website-Architektur.

- Legen Sie eine URL-Struktur fest.

- Verwenden Sie robots.txt.

- Breadcrumb-Menüs hinzufügen.

- Paginierung verwenden.

- Überprüfen Sie Ihre SEO-Protokolldateien.

1. Erstellen Sie eine XML-Sitemap.

Erinnern Sie sich an die Seitenstruktur, die wir durchgegangen sind? Das gehört in eine sogenannte XML-Sitemap , die Such-Bots hilft, Ihre Webseiten zu verstehen und zu crawlen. Sie können es sich wie eine Karte für Ihre Website vorstellen. Sobald sie fertig ist , übermitteln Sie Ihre Sitemap an die Google Search Console und die Bing Webmaster Tools. Denken Sie daran, Ihre Sitemap beim Hinzufügen und Entfernen von Webseiten auf dem neuesten Stand zu halten.

2. Maximieren Sie Ihr Crawl-Budget.

Ihr Crawling-Budget bezieht sich auf die Seiten und Ressourcen auf Ihrer Website, die Such-Bots crawlen .

Da das Crawling-Budget nicht unbegrenzt ist, stellen Sie sicher, dass Sie Ihre wichtigsten Seiten für das Crawling priorisieren.

Hier sind ein paar Tipps, um sicherzustellen, dass Sie Ihr Crawl-Budget maximieren:

- Entfernen oder kanonisieren Sie doppelte Seiten.

- Korrigieren Sie defekte Links oder leiten Sie sie um.

- Stellen Sie sicher, dass Ihre CSS- und Javascript-Dateien gecrawlt werden können.

- Überprüfen Sie regelmäßig Ihre Crawling-Statistiken und achten Sie auf plötzliche Einbrüche oder Anstiege.

- Stellen Sie sicher, dass alle Bots oder Seiten, denen Sie das Crawlen verwehrt haben, blockiert werden sollen.

- Halten Sie Ihre Sitemap auf dem neuesten Stand und übermitteln Sie sie an die entsprechenden Webmaster-Tools.

- Beschneiden Sie Ihre Website von unnötigen oder veralteten Inhalten.

- Achten Sie auf dynamisch generierte URLs, die die Anzahl der Seiten Ihrer Website in die Höhe schnellen lassen können.

3. Optimieren Sie Ihre Site-Architektur.

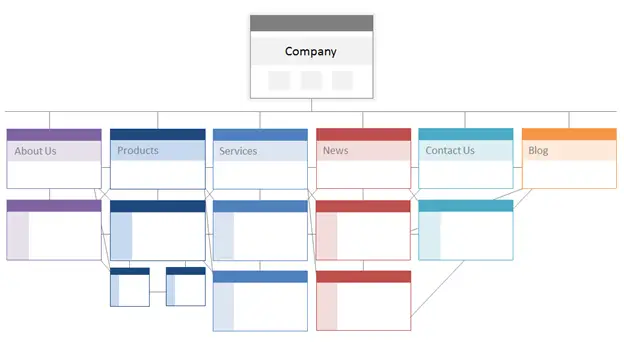

Ihre Website hat mehrere Seiten. Diese Seiten müssen so organisiert sein, dass Suchmaschinen sie leicht finden und crawlen können. Hier kommt Ihre Website-Struktur – oft als Informationsarchitektur Ihrer Website bezeichnet – ins Spiel.

Genauso wie ein Gebäude auf architektonischem Design basiert, organisiert Ihre Site-Architektur die Seiten Ihrer Site.

Verwandte Seiten werden gruppiert; Zum Beispiel verlinkt Ihre Blog-Startseite auf einzelne Blog-Posts, die jeweils auf ihre jeweiligen Autorenseiten verlinken. Diese Struktur hilft Suchbots, die Beziehung zwischen Ihren Seiten zu verstehen.

Ihre Website-Architektur sollte auch die Bedeutung einzelner Seiten formen und von ihr geformt werden. Je näher Seite A an Ihrer Homepage liegt, je mehr Seiten auf Seite A verlinken und je mehr Link EquitydieseSeiten haben, desto mehr Bedeutung messen Suchmaschinen Seite A bei.

Beispielsweise weist ein Link von Ihrer Homepage zu Seite A eine größere Bedeutung auf als ein Link von einem Blogbeitrag. Je mehr Links zu Seite A, desto „bedeutender“ wird diese Seite für Suchmaschinen.

Konzeptionell könnte eine Site-Architektur etwa so aussehen, wobei die SeitenAbout, Product, Newsusw. an der Spitze der Hierarchie der Seitenwichtigkeit positioniert sind.

Quelle

Stellen Sie sicher, dass die für Ihr Unternehmen wichtigsten Seiten mit der größten Anzahl an (relevanten!) internen Links ganz oben in der Hierarchie stehen.

4. Legen Sie eine URL-Struktur fest.

Die URL-Struktur bezieht sich darauf, wie Sie Ihre URLs strukturieren, was durch Ihre Website-Architektur bestimmtwerden kann. Den Zusammenhang erkläre ich gleich. Lassen Sie uns zunächst klarstellen, dass URLs Unterverzeichnisse wieblog.hubspot.comund/oder Unterordner wiehubspot.com/bloghaben können, die angeben, wohin die URL führt.

Beispielsweise würde ein Blog-Beitrag mit dem TitelHow to Groom Your Dogunter eine Blog-Subdomain oder ein Unterverzeichnis fallen. Die URL könnte www.bestdogcare.com/blog/how-to-groom-your-dog lauten . Während eine Produktseite auf derselben Websitewww.bestdogcare.com/products/grooming-brushwäre .

Ob Sie Subdomains oder Unterverzeichnisse oder „Produkte“ versus „Shop“ in Ihrer URL verwenden, bleibt ganz Ihnen überlassen. Das Schöne an der Erstellung Ihrer eigenen Website ist, dass Sie die Regeln erstellen können. Wichtig ist, dass diese Regeln einer einheitlichen Struktur folgen, was bedeutet, dass Sie nicht zwischen blog.ihrewebsite.com und ihrewebsite.com/blogs auf verschiedenen Seiten wechseln sollten. Erstellen Sie eine Roadmap, wenden Sie sie auf Ihre URL-Namensstruktur an und halten Sie sich daran.

Hier sind ein paar weitere Tipps zum Schreiben Ihrer URLs:

- Verwenden Sie Kleinbuchstaben.

- Verwenden Sie Bindestriche, um Wörter zu trennen.

- Machen Sie sie kurz und beschreibend.

- Vermeiden Sie unnötige Zeichen oder Wörter (einschließlich Präpositionen).

- Fügen Sie Ihre Ziel-Keywords hinzu.

Sobald Sie Ihre URL-Struktur aufgebaut haben, übermitteln Sie eine Liste der URLs Ihrer wichtigen Seiten an Suchmaschinen in Form einer XML-Sitemap . Dadurch erhalten Such-Bots zusätzlichen Kontext zu Ihrer Website, sodass sie dies nicht beim Crawlen herausfinden müssen.

5. Verwenden Sie robots.txt.

Wenn ein Web-Roboter Ihre Website durchsucht, überprüft er zuerst die Datei /robot.txt, die auch als Robot Exclusion Protocol bekannt ist. Dieses Protokoll kann bestimmten Web-Robotern erlauben oder verbieten, Ihre Website zu crawlen, einschließlich bestimmter Abschnitte oder sogar Seiten Ihrer Website. Wenn Sie verhindern möchten, dass Bots Ihre Website indexieren, verwenden Sie ein noindex-Robots-Meta-Tag. Lassen Sie uns diese beiden Szenarien diskutieren.

Möglicherweise möchten Sie bestimmte Bots vollständig daran hindern, Ihre Website zu crawlen. Leider gibt es da draußen einige Bots mit böswilliger Absicht – Bots, die Ihre Inhalte kratzen oder Ihre Community-Foren spammen. Wenn Sie dieses schlechte Verhalten bemerken, verwenden Sie Ihre robot.txt, um zu verhindern, dass sie auf Ihre Website gelangen. In diesem Szenario können Sie sich robot.txt als Ihr Kraftfeld von bösartigen Bots im Internet vorstellen.

In Bezug auf die Indexierung crawlen Suchbots Ihre Website, um Hinweise zu sammeln und Schlüsselwörter zu finden, damit sie Ihre Webseiten mit relevanten Suchanfragen abgleichen können. Aber wie wir später besprechen werden, haben Sie ein Crawl-Budget, das Sie nicht für unnötige Daten ausgeben möchten. Daher möchten Sie möglicherweise Seiten ausschließen, die Suchbots nicht dabei helfen, zu verstehen, worum es auf Ihrer Website geht, z. B. eineDankeschön-Seite von einem Angebot oder eine Anmeldeseite.

Egal was passiert, Ihr robot.txt-Protokoll wird einzigartig sein, je nachdem, was Sie erreichen möchten.

6. Fügen Sie Breadcrumb-Menüs hinzu.

Erinnerst du dich an die alte FabelHänsel und Gretel,wo zwei Kinder Brotkrümel auf den Boden fallen ließen, um den Weg nach Hause zu finden? Nun, sie hatten etwas vor.

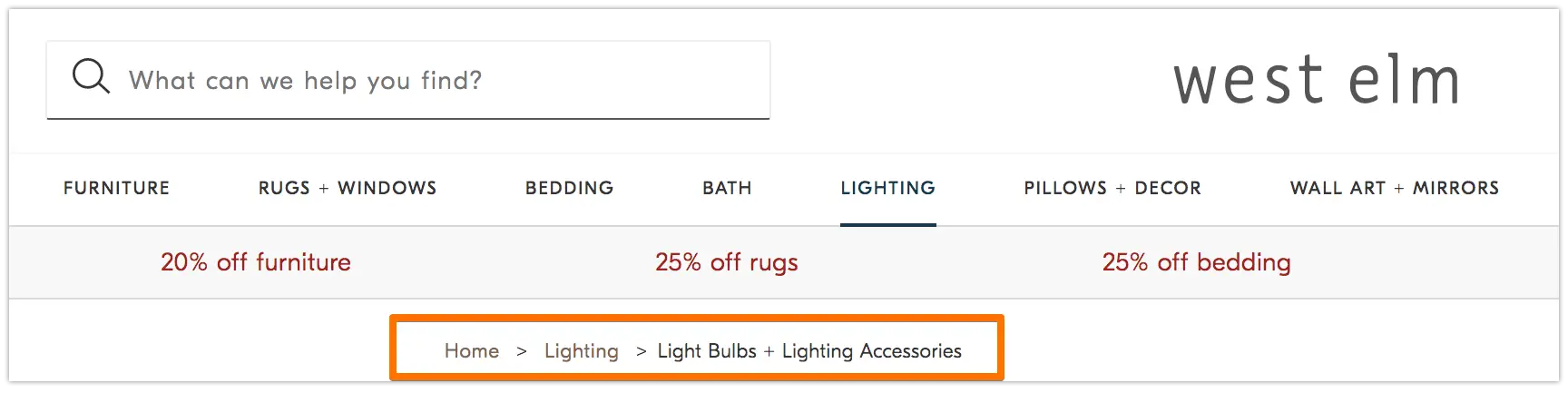

Breadcrumbs sind genau das, wonach sie sich anhören – ein Pfad, der die Benutzer zurück zum Anfang ihrer Reise auf Ihrer Website führt. Es ist ein Seitenmenü, das den Benutzern mitteilt, wie ihre aktuelle Seite mit dem Rest der Website zusammenhängt.

Und sie sind nicht nur für Website-Besucher; Suchbots verwenden sie auch.

Quelle

Breadcrumbs sollten zweierlei sein: 1) für Benutzer sichtbar, damit sie problemlos durch Ihre Webseiten navigieren können, ohne die Schaltfläche„Zurück“zu verwenden , und 2) über eine strukturierte Auszeichnungssprache verfügen, um Suchbots, die Ihre Website durchsuchen, einen genauen Kontext zu geben.

Sie sind sich nicht sicher, wie Sie strukturierte Daten zu Ihren Breadcrumbs hinzufügen können? Verwenden Sie diese Anleitung für BreadcrumbList .

7. Verwenden Sie die Paginierung.

Erinnern Sie sich, als Lehrer von Ihnen verlangten, die Seiten Ihrer Forschungsarbeit zu nummerieren? Das nennt man Paginierung. In der Welt der technischen SEO spielt die Paginierung eine etwas andere Rolle, aber Sie können sie sich immer noch als Organisationsform vorstellen.

Die Paginierung verwendet Code, um Suchmaschinen mitzuteilen, wenn Seiten mit unterschiedlichen URLs miteinander verwandt sind. Beispielsweise haben Sie möglicherweise eine Inhaltsserie, die Sie in Kapitel oder mehrere Webseiten aufteilen. Wenn Sie es Such-Bots erleichtern möchten, diese Seiten zu entdecken und zu durchsuchen, verwenden Sie die Paginierung.

Die Funktionsweise ist ziemlich einfach. Sie gehen zum<head>von Seite eins der Serie und verwenden

rel="next", um dem Suchbot mitzuteilen, welche Seite als zweite gecrawlt werden soll. Dann verwenden Sie auf Seite zweirel=“prev“,um die vorherige Seite anzugeben, undrel=“next“,um die nachfolgende Seite anzugeben, und so weiter.

Es sieht aus wie das…

Auf Seite eins:

<link rel="next" href="https://www.website.com/page-two" />

Auf Seite zwei:

<link rel="prev" href="https://www.website.com/page-one" />

<link rel=“next“ href=“https://www.website.com/page-three“ />

Beachten Sie, dass die Paginierung für die Crawl-Erkennung nützlich ist, aber von Google nicht mehr unterstützt wird, um Seiten in Stapeln zu indizieren, wie es früher der Fall war.

8. Überprüfen Sie Ihre SEO-Protokolldateien.

Sie können sich Protokolldateien wie einen Journaleintrag vorstellen. Webserver (der Journaler) erfassen und speichern Protokolldaten über jede Aktion, die sie auf Ihrer Website ausführen, in Protokolldateien (dem Journal). Zu den erfassten Daten gehören Uhrzeit und Datum der Anfrage, der angeforderte Inhalt und die anfragende IP-Adresse. Sie können auch den Benutzeragenten identifizieren, bei dem es sich um eine eindeutig identifizierbare Software (wie beispielsweise einen Suchbot) handelt, die die Anfrage für einen Benutzer erfüllt.

Aber was hat das mit SEO zu tun?

Nun, Suchbots hinterlassen eine Spur in Form von Protokolldateien, wenn sie Ihre Website durchsuchen. Sie können feststellen, ob, wann und was gecrawlt wurde, indem Sie die Protokolldateien überprüfen und nach dem Benutzeragenten und der Suchmaschine filtern .

Diese Informationen sind für Sie nützlich, da Sie feststellen können, wie Ihr Crawl-Budget ausgegeben wird und welche Hindernisse für die Indizierung oder den Zugriff auf einen Bot auftreten. Um auf Ihre Protokolldateien zuzugreifen, können Sie entweder einen Entwickler fragen oder einen Protokolldateianalysator wie Screaming Frog verwenden .

Nur weil ein Suchbot Ihre Website crawlen kann, bedeutet das nicht unbedingt, dass er alle Ihre Seiten indexieren kann. Werfen wir einen Blick auf die nächste Ebene Ihres technischen SEO-Audits – Indexierbarkeit .

IndexierbarkeitCheckliste

Während Such-Bots Ihre Website durchsuchen, beginnen sie mit der Indizierung von Seiten basierend auf ihrem Thema und ihrer Relevanz für dieses Thema. Nach der Indexierung ist Ihre Seite berechtigt, in den SERPs zu ranken. Hier sind einige Faktoren, die dazu beitragen können, dass Ihre Seiten indexiert werden.

Indexierbarkeit Checkliste

- Entsperren Sie Such-Bots für den Zugriff auf Seiten.

- Entfernen Sie doppelte Inhalte.

- Überprüfe deine Weiterleitungen.

- Überprüfen Sie die Reaktionsfähigkeit Ihrer Website auf Mobilgeräte.

- HTTP-Fehler beheben.

1. Entsperren Sie Such-Bots für den Zugriff auf Seiten.

Sie werden sich wahrscheinlich um diesen Schritt kümmern, wenn Sie sich mit der Crawlbarkeit befassen, aber er ist hier erwähnenswert. Sie möchten sicherstellen, dass Bots an Ihre bevorzugten Seiten gesendet werden und dass sie frei darauf zugreifen können. Dazu stehen Ihnen einige Tools zur Verfügung. Der robots.txt-Tester von Google gibt Ihnen eine Liste der Seiten, die nicht zugelassen sind, und Sie können das Inspect-Tool der Google Search Console verwenden, um die Ursache blockierter Seiten zu ermitteln.

2. Entfernen Sie doppelte Inhalte.

Doppelte Inhalte verwirren Suchbots und wirken sich negativ auf Ihre Indexierbarkeit aus. Denken Sie daran, kanonische URLs zu verwenden, um Ihre bevorzugten Seiten festzulegen.

3. Prüfen Sie Ihre Weiterleitungen.

Überprüfen Sie, ob alle Ihre Weiterleitungen richtig eingerichtet sind. Weiterleitungsschleifen, fehlerhafte URLs oder – schlimmer noch – unsachgemäße Weiterleitungen können Probleme verursachen, wenn Ihre Website indiziert wird. Um dies zu vermeiden, überprüfen Sie regelmäßig alle Ihre Weiterleitungen.

4. Überprüfen Sie die Reaktionsfähigkeit Ihrer Website auf Mobilgeräte.

Wenn Ihre Website noch nicht für Mobilgeräte optimiert ist, sind Sie weit hinter dem zurück, wo Sie sein sollten. Bereits 2016 begann Google damit, zuerst mobile Websites zu indizieren , wobei das mobile Erlebnis gegenüber dem Desktop priorisiert wurde. Heute ist diese Indizierung standardmäßig aktiviert. Um mit diesem wichtigen Trend Schritt zu halten, können Sie den Handy-freundlichen Test von Google verwenden , um zu überprüfen, wo Ihre Website verbessert werden muss.

5. HTTP-Fehler beheben.

HTTP steht für HyperText Transfer Protocol, aber das interessiert Sie wahrscheinlich nicht. Was Sie interessiert, ist, wann HTTP Fehler an Ihre Benutzer oder Suchmaschinen zurückgibt und wie Sie diese beheben können.

HTTP-Fehler können die Arbeit von Such-Bots behindern, indem sie wichtige Inhalte auf Ihrer Website blockieren. Es ist daher unglaublich wichtig, diese Fehler schnell und gründlich zu beheben.

Da jeder HTTP-Fehler einzigartig ist und eine bestimmte Lösung erfordert, enthält der Abschnitt unten eine kurze Erläuterung zu jedem Fehler, und Sie verwenden die bereitgestellten Links, um mehr darüber zu erfahren oder wie Sie sie beheben können.

- Permanente 301-Weiterleitungen werden verwendet, um Datenverkehr dauerhaft von einer URL zu einer anderen zu senden. Ihr CMS ermöglicht Ihnen die Einrichtung dieser Weiterleitungen, aber zu viele davon können Ihre Website verlangsamen und Ihre Benutzererfahrung beeinträchtigen, da jede zusätzliche Weiterleitung die Ladezeit der Seite verlängert. Streben Sie nach Möglichkeit keine Weiterleitungsketten an, da zu viele dazu führen, dass Suchmaschinen das Crawlen dieser Seite aufgeben.

- 302 Temporary Redirect ist eine Möglichkeit, den Datenverkehr vorübergehend von einer URL auf eine andere Webseite umzuleiten. Während dieser Statuscode Benutzer automatisch auf die neue Webseite weiterleitet, bleiben das zwischengespeicherte Titel-Tag, die URL und die Beschreibung mit der Ursprungs-URL konsistent. Wenn die temporäre Weiterleitung jedoch lange genug bestehen bleibt, wird sie schließlich als permanente Weiterleitung behandelt und diese Elemente werden an die Ziel-URL weitergeleitet.

- 403 Forbidden Messages bedeuten, dass der von einem Benutzer angeforderte Inhalt aufgrund von Zugriffsberechtigungen oder aufgrund einer Serverfehlkonfiguration eingeschränkt ist.

- 404-Fehlerseiten teilen Benutzern mit, dass die von ihnen angeforderte Seite nicht existiert, entweder weil sie entfernt wurde oder weil sie die falsche URL eingegeben haben. Es ist immer eine gute Idee, markenkonforme und ansprechende 404-Seiten zu erstellen, um Besucher auf Ihrer Website zu halten (klicken Sie auf den obigen Link, um einige gute Beispiele zu sehen).

- 405 Method Not Allowed bedeutet, dass Ihr Website-Server die Zugriffsmethode erkannt und dennoch blockiert hat, was zu einer Fehlermeldung führt.

- 500 Internal Server Error ist eine allgemeine Fehlermeldung, die bedeutet, dass Ihr Webserver Probleme hat, Ihre Website an die anfragende Partei zu liefern.

- 502 Bad Gateway Error steht im Zusammenhang mit Fehlkommunikation oder ungültiger Antwort zwischen Website-Servern.

- 503 Service Unavailable teilt Ihnen mit, dass Ihr Server zwar ordnungsgemäß funktioniert, die Anforderung jedoch nicht erfüllen kann.

- 504 Gateway Timeout bedeutet, dass ein Server keine rechtzeitige Antwort von Ihrem Webserver erhalten hat, um auf die angeforderten Informationen zuzugreifen.

Was auch immer der Grund für diese Fehler ist, es ist wichtig, sie zu beheben, damit sowohl Benutzer als auch Suchmaschinen zufrieden sind und beide Ihre Website immer wieder besuchen.

Selbst wenn Ihre Website gecrawlt und indexiert wurde, wirken sich Zugänglichkeitsprobleme, die Benutzer und Bots blockieren, auf Ihre SEO aus. Allerdings müssen wir mit der nächsten Phase Ihres technischen SEO-Audits fortfahren – der Renderbarkeit.

Renderbarkeits-Checkliste

Bevor wir uns mit diesem Thema befassen, ist es wichtig, den Unterschied zwischen SEO-Zugänglichkeit und Web-Zugänglichkeit zu beachten . Letzteres dreht sich darum, Ihre Webseiten für Benutzer mit Behinderungen oder Beeinträchtigungen, wie beispielsweise Blindheit oder Legasthenie, leicht navigierbar zu machen. Viele Elemente der Online-Zugänglichkeit überschneiden sich mit Best Practices für SEO. Eine SEO-Zugänglichkeitsprüfung berücksichtigt jedoch nicht alles, was Sie tun müssten, um Ihre Website für Besucher mit Behinderungen zugänglicher zu machen.

Wir werden uns in diesem Abschnitt auf die SEO-Zugänglichkeit oder das Rendering konzentrieren, aber behalten Sie die Web-Zugänglichkeit im Auge, wenn Sie Ihre Website entwickeln und pflegen.

Renderbarkeits-Checkliste

Eine barrierefreie Website basiert auf einer einfachen Wiedergabe. Nachfolgend finden Sie die Website-Elemente, die Sie für Ihr Renderability-Audit überprüfen müssen.

Serverleistung

Wie Sie oben erfahren haben, verursachen Server-Timeouts und -Fehler HTTP-Fehler, die Benutzer und Bots daran hindern, auf Ihre Website zuzugreifen. Wenn Sie feststellen, dass Ihr Server Probleme hat, verwenden Sie die oben bereitgestellten Ressourcen, um sie zu beheben und zu beheben. Wenn Sie dies nicht rechtzeitig tun, kann dies dazu führen, dass Suchmaschinen Ihre Webseite aus ihrem Index entfernen, da es eine schlechte Erfahrung ist, einem Benutzer eine fehlerhafte Seite zu zeigen.

HTTP-Status

Ähnlich wie bei der Serverleistung verhindern HTTP-Fehler den Zugriff auf Ihre Webseiten. Sie können einen Webcrawler wie Screaming Frog , Botify oder DeepCrawl verwenden , um eine umfassende Fehlerprüfung Ihrer Website durchzuführen.

Ladezeit und Seitengröße

Wenn das Laden Ihrer Seite zu lange dauert, ist die Absprungrate nicht das einzige Problem, über das Sie sich Sorgen machen müssen. Eine Verzögerung der Seitenladezeit kann zu einem Serverfehler führen, der Bots von Ihren Webseiten blockiert oder sie dazu bringt, teilweise geladene Versionen zu crawlen, denen wichtige Inhaltsabschnitte fehlen. Abhängig davon, wie viel Crawling-Nachfrage für eine bestimmte Ressource besteht, werden Bots eine entsprechende Menge an Ressourcen aufwenden, um zu versuchen, Seiten zu laden, zu rendern und zu indizieren. Sie sollten jedoch alles in Ihrer Macht Stehende tun, um die Ladezeit Ihrer Seite zu verkürzen.

JavaScript-Rendering

Google tut sich zugegebenermaßen schwer mit der Verarbeitung von JavaScript (JS) und empfiehlt daher, vorgerenderte Inhalte einzusetzen , um die Barrierefreiheit zu verbessern. Google hat auch eine Vielzahl von Ressourcen, die Ihnen helfen zu verstehen, wie Such-Bots auf JS auf Ihrer Website zugreifen und wie Sie suchbezogene Probleme verbessern können.

Verwaiste Seiten

Jede Seite Ihrer Website sollte mit mindestenseiner anderen Seite verlinkt sein – vorzugsweise mehr, je nachdem, wie wichtig die Seite ist. Wenn eine Seite keine internen Links hat, wird sie als verwaiste Seite bezeichnet. Wie einem Artikel ohne Einleitung fehlt diesen Seiten der Kontext, den Bots benötigen, um zu verstehen, wie sie indiziert werden sollten.

Seitentiefe

Die Seitentiefe bezieht sich darauf, wie viele Ebenen tiefer eine Seite in Ihrer Site-Struktur vorhanden ist, dh wie viele Klicks sie von Ihrer Homepage entfernt ist. Es ist am besten, Ihre Site-Architektur so flach wie möglich zu halten und gleichzeitig eine intuitive Hierarchie beizubehalten. Manchmal ist eine vielschichtige Site unvermeidlich; In diesem Fall sollten Sie einer gut organisierten Website Vorrang vor Oberflächlichkeit einräumen.

Unabhängig davon, wie viele Ebenen in Ihrer Website-Struktur vorhanden sind, halten Sie wichtige Seiten – wie Ihre Produkt- und Kontaktseiten – nicht länger als drei Klicks tief. Eine Struktur, die Ihre Produktseite so tief in Ihrer Website vergräbt, dass Benutzer und Bots Detektiv spielen müssen, um herauszufinden, dass sie weniger zugänglich sind und ein schlechtes Erlebnis bieten

Beispielsweise ist eine Website-URL wie diese, die Ihre Zielgruppe zu Ihrer Produktseite führt, ein Beispiel für eine schlecht geplante Website-Struktur: www.ihrewebsite.com/products-features/features-by-industry/airlines-case-studies/airlines -Produkte.

Umleitungsketten

Wenn Sie sich entscheiden, den Datenverkehr von einer Seite auf eine andere umzuleiten, zahlen Sie einen Preis. Dieser Preis ist Crawl-Effizienz. Weiterleitungen können das Crawling verlangsamen, die Ladezeit von Seiten verkürzen und Ihre Website unzugänglich machen, wenn diese Weiterleitungen nicht richtig eingerichtet sind. Versuchen Sie aus all diesen Gründen, Weiterleitungen auf ein Minimum zu beschränken.

Sobald Sie Probleme mit der Barrierefreiheit angesprochen haben, können Sie sich damit befassen, wie Ihre Seiten in den SERPs ranken.

Ranking-Checkliste

Nun kommen wir zu den aktuelleren Elementen, die Ihnen wahrscheinlich bereits bekannt sind – wie man das Ranking aus technischer SEO-Sicht verbessert. Das Ranking Ihrer Seiten erfordert einige der On-Page- und Off-Page-Elemente, die wir zuvor erwähnt haben, jedoch aus technischer Sicht.

Denken Sie daran, dass all diese Elemente zusammenarbeiten, um eine SEO-freundliche Website zu erstellen. Wir würden also nachlässig sein, alle beitragenden Faktoren auszulassen. Tauchen wir ein.

Interne und externe Verlinkung

Links helfen Such-Bots zu verstehen, wo eine Seite in das große Schema einer Suchanfrage passt, und geben Kontext für das Ranking dieser Seite. Links führen Suchbots (und Benutzer) zu verwandten Inhalten und übertragen die Wichtigkeit der Seite. Insgesamt verbessert das Verlinken das Crawling, die Indexierung und Ihre Ranking-Fähigkeit.

Backlink-Qualität

Backlinks – Links von anderen Websites zurück zu Ihrer eigenen – sind ein Vertrauensbeweis für Ihre Website. Sie teilen den Suchbots mit, dass die externe Website A glaubt, dass Ihre Seite von hoher Qualität ist und es wert ist, gecrawlt zu werden. Wenn sich diese Stimmen summieren, bemerken Suchbots und behandeln Ihre Website als glaubwürdiger. Klingt nach viel Recht? Wie bei den meisten großartigen Dingen gibt es jedoch eine Einschränkung. Die Qualität dieser Backlinks ist sehr wichtig.

Links von minderwertigen Seiten können Ihren Rankings sogar schaden. Es gibt viele Möglichkeiten, qualitativ hochwertige Backlinks zu Ihrer Website zu erhalten, z. B. die Kontaktaufnahme zu relevanten Publikationen, das Beanspruchen von nicht verlinkten Erwähnungen, das Bereitstellen relevanter Publikationen, das Beanspruchen von nicht verlinkten Erwähnungen und das Bereitstellen hilfreicher Inhalte, auf die andere Websites verlinken möchten.

Content-Cluster

Wir bei HubSpot haben uns nicht gescheut, Content-Cluster zu lieben oder wie sie zum organischen Wachstum beitragen . Content-Cluster verknüpfen verwandte Inhalte, sodass Such-Bots alle Seiten, die Sie zu einem bestimmten Thema besitzen, leicht finden, crawlen und indizieren können. Sie fungieren als Instrument zur Eigenwerbung, um Suchmaschinen zu zeigen, wie viel Sie über ein Thema wissen, sodass sie Ihre Website mit größerer Wahrscheinlichkeit als Autorität für alle verwandten Suchanfragen einstufen.

Ihre Rangfähigkeit ist die Hauptdeterminante für das Wachstum des organischen Verkehrs, da Studien zeigen, dass Suchende eher auf die ersten drei Suchergebnisse in SERPs klicken. Aber wie stellen Sie sicher, dassIhrErgebnis angeklickt wird?

Lassen Sie uns dies mit dem letzten Teil der organischen Traffic-Pyramide abrunden: Klickbarkeit.

Klickbarkeits-Checkliste

Während die Klickrate (CTR) alles mit dem Suchverhalten zu tun hat, gibt es Dinge,die Sietun können, um Ihre Klickbarkeit auf den SERPs zu verbessern. Während sich Meta-Beschreibungen und Seitentitel mit Schlüsselwörtern auf die CTR auswirken, konzentrieren wir uns auf die technischen Elemente, denn deshalb sind Sie hier.

Klickbarkeits-Checkliste

- Verwenden Sie strukturierte Daten.

- Gewinnen Sie SERP-Funktionen.

- Für Featured Snippets optimieren.

- Denken Sie an Google Discover.

Ranking und Klickrate gehen Hand in Hand, denn seien wir ehrlich, Suchende wollen sofortige Antworten. Je mehr Ihr Ergebnis auf der SERP auffällt, desto wahrscheinlicher ist es, dass Sie den Klick erhalten. Sehen wir uns einige Möglichkeiten zur Verbesserung Ihrer Klickbarkeit an.

1. Verwenden Sie strukturierte Daten.

Strukturierte Daten verwenden ein bestimmtes Vokabular namens Schema, um Elemente auf Ihrer Webseite für Suchbots zu kategorisieren und zu kennzeichnen. Das Schema macht glasklar, was jedes Element ist, wie es sich auf Ihre Website bezieht und wie es zu interpretieren ist. Grundsätzlich sagen strukturierte Daten Bots: „Dies ist ein Video“, „Dies ist ein Produkt“ oder „Dies ist ein Rezept“ und lassen keinen Raum für Interpretationen .

To be clear, using structured data is not a “clickability factor” (if there even is such a thing), but it does help organize your content in a way that makes it easy for search bots to understand, index, and potentially rank your pages.

2. Win SERP features.

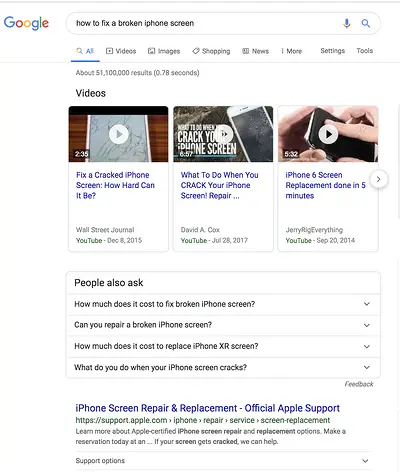

SERP features , otherwise known as rich results, are a double-edged sword. If you win themandget the click-through, you're golden. If not, your organic results are pushed down the page beneath sponsored ads, text answer boxes, video carousels, and the like.

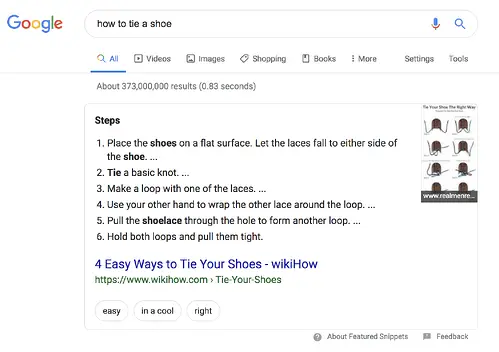

Rich results are those elements that don't follow the page title, URL, meta description format of other search results. For example, the image below shows two SERP features — a video carousel and “People Also Ask” box — above the first organic result.

While you can still get clicks from appearing in the top organic results, your chances are greatly improved with rich results.

How do you increase your chances of earning rich results? Write useful content and use structured data. The easier it is for search bots to understand the elements of your site, the better your chances of getting a rich result.

Structured data is useful for getting these ( and other search gallery elements ) from your site to the top of the SERPs, thereby, increasing the probability of a click-through:

- Articles

- Videos

- Bewertungen

- Events

- How-Tos

- FAQs (“People Also Ask” boxes)

- Images

- Local Business Listings

- Products

- Sitelinks

3. Optimize for Featured Snippets.

One unicorn SERP feature that has nothing to do with schema markup is Featured Snippets, those boxes above the search results that provide concise answers to search queries.

Featured Snippets are intended to get searchers the answers to their queries as quickly as possible. According to Google , providing the best answer to the searcher's query is the only way to win a snippet. However, HubSpot's research revealed a few additional ways to optimize your content for featured snippets .

4. Consider Google Discover.

Google Discover is a relatively new algorithmic listing of content by category specifically for mobile users. It's no secret that Google has been doubling down on the mobile experience; with over 50% of searches coming from mobile , it's no surprise either. The tool allows users to build a library of content by selecting categories of interest (think: gardening, music, or politics).

At HubSpot, we believe topic clustering can increase the likelihood of Google Discover inclusion and are actively monitoring our Google Discover traffic in Google Search Console to determine the validity of that hypothesis. We recommend that you also invest some time in researching this new feature. The payoff is a highly engaged user base that has basically hand-selected the content you've worked hard to create.

The Perfect Trio

Technical SEO, on-page SEO, and off-page SEO work together to unlock the door to organic traffic. While on-page and off-page techniques are often the first to be deployed, technical SEO plays a critical role in getting your site to the top of the search results and your content in front of your ideal audience. Use these technical tactics to round out your SEO strategy and watch the results unfold.