WordPress robots.txt

Veröffentlicht: 2019-02-26WordPress robots.txt ist sehr wichtig für SEO. Um sicherzustellen, dass Ihre Website in den Suchmaschinenergebnissen gut platziert ist, müssen Sie ihre wichtigsten Seiten für die Suche und Indizierung von „Robotern“ („Bots“) von Suchmaschinen bequem machen. Eine gut strukturierte robots.txt-Datei hilft dabei, diese Bots zu den Seiten zu leiten, die Sie indizieren möchten.

In diesem Artikel werden wir solche Fragen aufdecken:

- Was ist eine robots.txt-Datei und warum ist sie wichtig?

- WordPress-Roboter-TXT-Speicherort

- Beste Roboter-TXT für WordPress

- So erstellen Sie eine robots.txt-Datei

- So überprüfen Sie die robots.txt-Datei und senden sie an die Google Search Console.

Was ist eine robots.txt-Datei für WordPress und warum ist sie wichtig?

Wenn Sie eine neue Website erstellen, senden Suchmaschinen ihre Roboter, um alle Seiten zu scannen und eine Karte zu erstellen. Auf diese Weise wissen sie, welche Seiten als Ergebnis angezeigt werden sollen, wenn jemand nach relevanten Schlüsselwörtern sucht. Auf einer grundlegenden Ebene ist dies ganz einfach (lesen Sie auch diesen nützlichen Beitrag – WordPress-Standard-.htaccess-Datei).

Das Problem ist, dass moderne Websites neben Seiten viele andere Elemente enthalten. Mit WordPress können Sie zum Beispiel Plugins installieren, die oft ihre eigenen Verzeichnisse haben. Es ist nicht erforderlich, dies in den Suchergebnissen anzuzeigen, da sie nicht mit dem Inhalt übereinstimmen.

Was die robots.txt-Datei tut, ist eine Reihe von Richtlinien für Suchroboter bereitzustellen. Er sagt ihnen: „Schauen Sie hier und indizieren Sie diese Seiten, aber betreten Sie keine anderen Bereiche!“. Diese Datei kann so detailliert sein, wie Sie möchten, und ist sehr einfach zu erstellen, selbst wenn Sie Anfänger sind.

In der Praxis scannen die Suchmaschinen Ihre Website auch dann, wenn Sie keine robots.txt-Datei erstellen. Es nicht zu schaffen, ist jedoch ein sehr irrationaler Schritt. Ohne diese Datei überlassen Sie es den Robotern, den gesamten Inhalt Ihrer Website zu indizieren, und sie entscheiden, dass Sie alle Teile Ihrer Website anzeigen müssen, auch diejenigen, die Sie vor dem öffentlichen Zugriff verbergen möchten (überprüfen Sie auch die – Best WordPress eCommerce-Plugins). ).

Ein noch wichtigerer Punkt: Ohne eine robots.txt-Datei wird Ihre Website viele Zugriffe von Robotern Ihrer Website haben. Dies wirkt sich negativ auf seine Leistung aus. Auch wenn die Besucherzahlen Ihrer Website noch gering sind, sollte die Seitenladegeschwindigkeit immer an erster Stelle und auf höchstem Niveau stehen. Am Ende gibt es nur wenige Dinge, die Menschen nicht mehr mögen, als langsam ladende Websites.

WordPress-Roboter-TXT-Speicherort

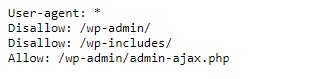

Wenn Sie eine WordPress-Website erstellen, wird automatisch eine robots.txt-Datei erstellt und in Ihrem Hauptverzeichnis auf dem Server abgelegt. Wenn sich Ihre Website beispielsweise hier befindet – wpdevart.com, finden Sie sie unter wpdevart.com/robots.txt und sehen etwa Folgendes:

Dies ist ein Beispiel für die einfachste robots.txt-Datei. Übersetzen in menschenlesbare Sprache, die rechte Seite nach dem User-Agent: erklärt

für welche Roboter die Regeln gelten. Ein Sternchen bedeutet, dass die Regel universell ist und für alle Roboter gilt. In diesem Fall teilt die Datei Robots mit, dass sie die Verzeichnisse wp-admin und wp-includes nicht scannen können. Die Bedeutung dieser Regeln ist, dass diese Verzeichnisse viele Dateien enthalten, die vor öffentlichem Zugriff geschützt werden müssen (siehe auch unser WordPress Countdown-Plugin).

Natürlich können Sie Ihrer Datei weitere Regeln hinzufügen. Bevor Sie dies tun, müssen Sie verstehen, dass dies eine virtuelle Datei ist. Normalerweise befindet sich WordPress robots.txt im Root-Verzeichnis, das oft public_html oder www (oder den Namen Ihrer Website) heißt:

Es ist zu beachten, dass die standardmäßig erstellte robots.txt-Datei für WordPress von keinem Verzeichnis aus für Sie zugänglich ist. Es funktioniert, aber wenn Sie Änderungen vornehmen möchten, müssen Sie Ihre eigene Datei erstellen und in das Stammverzeichnis hochladen.

Wir werden uns verschiedene Möglichkeiten zum Erstellen einer robots.txt-Datei für WordPress ansehen. Lassen Sie uns nun besprechen, wie Sie bestimmen, welche Regeln in die Datei aufgenommen werden sollen.

Beste Roboter-TXT für WordPress

Es ist nicht so schwierig, das beste Robots TXT für Ihre WordPress-Website zu erstellen. Welche Regeln müssen also in die robots.txt-Datei aufgenommen werden? Im vorherigen Abschnitt haben wir ein Beispiel für eine von WordPress generierte robots.txt-Datei gesehen. Es enthält nur zwei kurze Regeln, aber für die meisten Websites sind sie ausreichend. Lassen Sie uns einen Blick auf zwei verschiedene robots.txt-Dateien werfen und sehen, was jede tut.

Hier ist unser erstes Beispiel einer WordPress robots.txt-Datei:

User-agent: * Allow: / # Disallowed Sub-Directories Disallow: / payout / Disallow: / photos / Disallow: / forums /Diese robots.txt-Datei wird für das Forum erstellt. Suchmaschinen indizieren normalerweise jeden Forenthread. Je nach Thema Ihres Forums möchten Sie die Indizierung möglicherweise nicht zulassen. Beispielsweise wird Google nicht Hunderte von kurzen Benutzerdiskussionen indizieren. Sie können auch Regeln festlegen, die auf einen bestimmten Forenthread verweisen, um ihn auszuschließen, und Suchmaschinen erlauben, den Rest zu indizieren.

Sie bemerken auch eine Zeile, die mit Allow: / am Anfang der Datei beginnt. Diese Zeile teilt Robots mit, dass sie alle Seiten Ihrer Website scannen können, mit Ausnahme der unten festgelegten Einschränkungen. Sie haben auch bemerkt, dass wir diese Regeln universell (mit einem Sternchen) festgelegt haben, wie es in der virtuellen WordPress robots.txt-Datei der Fall war (Sie können auch unser WordPress-Preistabellen-Plugin überprüfen).

Schauen wir uns ein weiteres Beispiel für eine WordPress robots.txt-Datei an:

User-agent: * Disallow: / wp-admin / Disallow: / wp-includes / User-agent: Bingbot Disallow: /In dieser Datei legen wir die gleichen Regeln fest, die standardmäßig an WordPress gehen. Obwohl wir auch einen neuen Satz von Regeln hinzufügen, die Bing-Suchroboter daran hindern, unsere Website zu crawlen. Bingbot ist, wie Sie sehen können, der Name des Roboters.

Sie können auch andere Suchmaschinennamen eingeben, um deren Zugriff einzuschränken / zuzulassen. In der Praxis ist Bingbot natürlich sehr gut (wenn auch nicht so gut wie Googlebot). Es gibt jedoch viele bösartige Roboter.

Die schlechte Nachricht ist, dass sie nicht immer den Anweisungen in der robots.txt-Datei folgen (sie arbeiten immer noch wie Terroristen). Es sollte beachtet werden, dass, obwohl die meisten Roboter die Anweisungen in dieser Datei verwenden werden, Sie sie nicht dazu zwingen können.

Wenn Sie tiefer in das Thema einsteigen, finden Sie viele Vorschläge, was Sie auf Ihrer WordPress-Seite zulassen und was Sie blockieren sollten. Obwohl unserer Erfahrung nach weniger Regeln oft besser sind. Hier ist ein Beispiel für die

beste robots txt für WordPress-Website, aber für verschiedene Websites kann es anders sein:

User-agent: * Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Disallow: *utm*= Disallow: *openstat= Allow: */uploads Sitemap: https://wpdevart.com/sitemap.xmlTraditionell schließt WordPress gerne die Verzeichnisse wp-admin und wp-includes. Dies ist jedoch nicht mehr die beste Lösung. Wenn Sie außerdem Meta-Tags für Ihre Bilder zu Werbezwecken (SEO) hinzufügen, hat es keinen Sinn, Robotern zu sagen, dass sie den Inhalt dieser Verzeichnisse nicht indizieren sollen.

Was Ihre robots.txt-Datei enthalten sollte, hängt von den Anforderungen Ihrer Website ab. Fühlen Sie sich also frei, mehr zu recherchieren!

So erstellen Sie eine robots.txt

Was könnte einfacher sein, als eine Textdatei (txt) zu erstellen. Alles, was Sie tun müssen, ist, Ihren bevorzugten Editor (wie Notepad oder TextEdit) zu öffnen und ein paar Zeilen einzugeben. Dann speichern Sie die Datei mit robots und txt-Erweiterung (robots.txt). Es dauert ein paar Sekunden, daher möchten Sie vielleicht eine robots.txt für WordPress erstellen, ohne ein Plugin zu verwenden.

Diese Datei haben wir lokal auf dem Rechner gespeichert. Sobald Sie Ihre eigene Datei erstellt haben, müssen Sie sich über FTP (möglicherweise mit FileZilla) mit Ihrer Website verbinden.

Nachdem Sie sich mit Ihrer Website verbunden haben, gehen Sie zum Verzeichnis public_html. Jetzt müssen Sie nur noch die robots.txt-Datei von Ihrem Computer auf den Server hochladen. Dies können Sie entweder durch Klicken mit der rechten Maustaste auf die Datei im lokalen FTP-Navigator oder durch einfaches Ziehen mit der Maus tun.

Es dauert nur wenige Sekunden. Wie Sie sehen können, ist diese Methode einfacher als die Verwendung des Plugins.

So prüfen Sie die robots.txt von WordPress und senden sie an die Google Search Console

Nachdem Ihre WordPress robots.txt-Datei erstellt und hochgeladen wurde, können Sie in der Google Search Console nach Fehlern suchen. Die Search Console ist eine Reihe von Google-Tools, mit denen Sie verfolgen können, wie Ihre Inhalte in den Suchergebnissen angezeigt werden. Eines dieser Tools überprüft robots.txt, Sie finden es leicht auf der Admin-Seite der Google Webmaster-Tools (siehe auch Die 50 besten WordPress-Plugins 2020).

Dort finden Sie das Editor-Feld, in dem Sie den Code für Ihre WordPress robots.txt-Datei hinzufügen können, und klicken Sie unten rechts auf Senden. Die Google-Suchkonsole fragt Sie, ob Sie den neuen Code verwenden oder eine Datei von Ihrer Website herunterladen möchten.

Jetzt überprüft die Plattform Ihre Datei auf Fehler. Wenn ein Fehler gefunden wird, werden Ihnen Informationen darüber angezeigt. Sie haben einige Beispiele der WordPress robots.txt-Datei gesehen, und jetzt haben Sie noch mehr Möglichkeiten, Ihre perfekte robots.txt-Datei zu erstellen!