Guía paso a paso para instalar LLM de código abierto en su entorno local, sin Internet

Publicado: 2023-12-20Resumen

En el mundo de la IA en rápido avance, la instalación de un modelo de lenguaje grande (LLM) como FALCON dentro de un sistema local presenta un conjunto único de desafíos y oportunidades. Esta guía está diseñada para guiarlo a través de los pasos críticos de la configuración de FALCON Open-Source LLM, enfocándose en lograr un rendimiento óptimo mientras se mantiene una estricta seguridad y privacidad de los datos.

Embárquese en el viaje de implementación de FALCON, un destacado modelo de lenguaje grande (LLM) de código abierto, a nivel local, que garantiza el máximo rendimiento y una seguridad sólida. Esta guía completa cubre los requisitos previos de hardware, la instalación de software y la capacitación en datos, al tiempo que subraya la importancia de las pruebas periódicas, el mantenimiento, las consideraciones de escalabilidad y el análisis de costos. Para obtener una perspectiva más amplia, manténgase informado sobre los 5 principales LLM de código abierto y considere aprovechar la experiencia de Creole Studios para una implementación segura, lo que le permitirá aprovechar el poder de la IA mientras mantiene estrictos estándares de privacidad de datos.

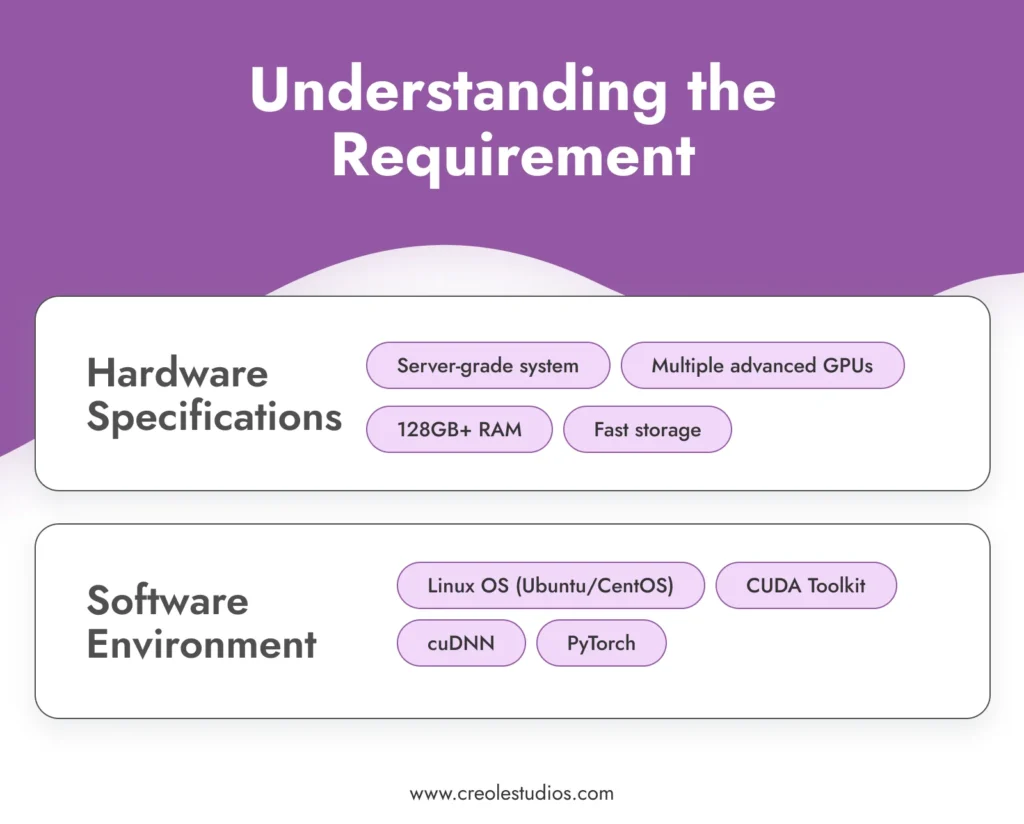

Comprender el requisito

Antes de sumergirse en el proceso de instalación, es fundamental comprender los requisitos para ejecutar un modelo sofisticado como FALCON .

- Especificaciones de hardware : FALCON, con sus enormes 180 mil millones de parámetros, exige importantes recursos computacionales. Esto requiere un entorno informático de alto rendimiento, que generalmente incluye sistemas de nivel de servidor equipados con múltiples GPU avanzadas (por ejemplo, NVIDIA A100), RAM sustancial (128 GB o más) y soluciones de almacenamiento de alta velocidad (SSD o NVMe) para administrar el modelo. y datos de manera eficiente. Puede consultar las pautas de NVIDIA para configurar entornos de IA y ML.

- Entorno de software : ejecutar FALCON de forma eficaz requiere un entorno de software estable y compatible. Se recomienda un sistema operativo basado en Linux como Ubuntu o CentOS por su excelente soporte de GPU y compatibilidad con herramientas y bibliotecas esenciales. La pila de software incluye CUDA Toolkit para aceleración de GPU, cuDNN para redes neuronales profundas y marcos de aprendizaje automático como PyTorch.

Adquirir el modelo

El siguiente paso es adquirir el modelo FALCON. Esto puede implicar :

- Licencia de modelo : consulte la disponibilidad más reciente y las opciones de licencia para FALCON. Obtener la licencia de un modelo como FALCON generalmente implica negociaciones y acuerdos, lo que garantiza que usted tenga el derecho legal a utilizar el modelo. Esté atento al repositorio oficial de FALCON o a los mercados de modelos de IA relacionados para obtener actualizaciones y detalles de licencia.

- Transferencia del modelo : Dada la naturaleza aislada de la configuración, transferir el modelo a su entorno local es un paso crítico. Esto podría implicar transferir físicamente el modelo utilizando dispositivos de almacenamiento cifrados y seguros. La integridad y seguridad del modelo durante esta transferencia son primordiales.

Configurar la infraestructura

Establecer una infraestructura sólida es fundamental para el funcionamiento eficiente de FALCON LLM :

- Configuración del servidor : optimice sus servidores para cargas de trabajo de IA de alta intensidad. Esto incluye configurar múltiples GPU para procesamiento paralelo, garantizar redes de alto ancho de banda dentro del sistema e implementar soluciones de enfriamiento efectivas para administrar la producción de calor.

- Gestión de almacenamiento : dado el tamaño de FALCON y los conjuntos de datos potencialmente grandes con los que trabajará, planifique cuidadosamente su arquitectura de almacenamiento. Se recomiendan unidades SSD o NVMe de alta capacidad por su velocidad. Asegúrese de contar con sistemas de redundancia y respaldo implementados.

- Energía y refrigeración : estos potentes servidores requerirán sistemas de refrigeración y suministro de energía adecuados. Asegúrese de que su infraestructura pueda manejar estos requisitos. Es recomendable consultar con especialistas en hardware para diseñar un centro de datos que pueda soportar esta configuración.

Instale el software requerido

La instalación del software es un paso fundamental en la configuración de su LLM de código abierto :

- Configuración del sistema operativo : instale la distribución de Linux elegida. Ubuntu y CentOS son opciones populares por su estabilidad y soporte. Asegúrese de que el sistema operativo esté configurado para utilizar de manera óptima los recursos de hardware.

- Instalación de dependencias : instale CUDA Toolkit para compatibilidad con GPU, cuDNN para capacidades de aprendizaje profundo y PyTorch como marco de aprendizaje automático. Asegúrate de estar utilizando versiones compatibles con el modelo FALCON.

- Software de seguridad : en un entorno aislado, la seguridad interna es clave. Instale firewalls robustos y sistemas de detección de intrusiones. Aunque el sistema esté aislado, pueden ocurrir amenazas internas o infracciones accidentales.

Instalación del modelo

La instalación del modelo FALCON implica varios pasos :

- Transferencia de modelo : transfiera de forma segura los archivos del modelo a su sistema local utilizando dispositivos de almacenamiento cifrados.

- Proceso de instalación : siga la guía de instalación proporcionada por FALCON. Por lo general, esto implica configurar las variables de entorno, cargar los archivos del modelo y configurar los parámetros del modelo.

- Verificación : Post-instalación, verificar la integridad de la instalación. Asegúrese de que los archivos del modelo estén intactos y que el modelo ejecute el diagnóstico inicial correctamente.

Seguridad y cumplimiento de datos

Garantizar la seguridad de los datos en un entorno aislado implica varias capas de protección :

- Cifrado : todos los datos, tanto en reposo como en tránsito dentro de la red, deben estar cifrados. Implemente protocolos de cifrado sólidos para proteger sus datos.

- Cumplimiento : cumpla con las regulaciones de protección de datos y los estándares de la industria pertinentes. Audite periódicamente sus sistemas para comprobar el cumplimiento.

- Control de acceso : Implemente políticas estrictas de control de acceso. Sólo el personal autorizado debe tener acceso al modelo y a los datos.

Entrenando el modelo con datos seleccionados

Para adaptar FALCON a sus necesidades específicas, es esencial entrenarlo con datos seleccionados .

- Recopilación y preparación de datos : recopile datos relevantes para su caso de uso. Estos datos deben ser representativos, diversos y de alta calidad. Preprocese y limpie los datos para garantizar que sean adecuados para el entrenamiento.

- Proceso de capacitación : configure los parámetros de capacitación de FALCON para alinearlos con sus objetivos. Entrenar un modelo como FALCON requiere una comprensión profunda de los principios del aprendizaje automático y los detalles de la arquitectura del modelo.

- Monitoreo y ajuste : Monitoree continuamente el proceso de capacitación para determinar su rendimiento y precisión. Esté preparado para ajustar los datos o parámetros de entrenamiento según sea necesario para lograr los resultados deseados.

Pruebas y mantenimiento

Las pruebas y el mantenimiento periódicos son fundamentales para el éxito a largo plazo del modelo .

- Pruebas de rendimiento : pruebe periódicamente la precisión y eficiencia del modelo. Esto implica ejecutar conjuntos de datos de validación y verificar la coherencia y calidad de los resultados del modelo.

- Mantenimiento de software y hardware : actualice y parchee periódicamente el entorno de software. Mantenga el hardware para garantizar que funcione de manera eficiente, incluida la administración de los sistemas de enfriamiento, la verificación de las fuentes de alimentación y el reemplazo de cualquier componente defectuoso.

- Actualización del modelo : Manténgase al tanto de las actualizaciones del modelo FALCON. En un entorno aislado, la actualización del modelo puede requerir la transferencia manual de archivos de modelo actualizados.

Escalabilidad y costo

Considere el crecimiento futuro y las implicaciones de costos de su instalación .

- Planificación de escalabilidad : planifique el posible escalamiento de su infraestructura. Esto podría incluir agregar más GPU, ampliar el almacenamiento o mejorar las capacidades de red dentro del entorno aislado.

- Análisis de costos : revise periódicamente los costos involucrados en el mantenimiento y funcionamiento de FALCON. Esto incluye costos de hardware, consumo de energía y tarifas de licencia.

Notas finales: la importancia de los LLM de código abierto y la experiencia de Creole Studios

La instalación local de LLM de código abierto como FALCON ofrece beneficios significativos, que incluyen privacidad de datos, personalización y control incomparables sobre sus capacidades de inteligencia artificial. Permite a las empresas aprovechar el poder de la IA y al mismo tiempo garantizar que los datos confidenciales permanezcan dentro de los límites de su red privada y segura.

Creole Studios se destaca en ayudar a los clientes con el complejo proceso de configurar y mantener LLM de código abierto en entornos locales aislados. Nuestra experiencia garantiza una implementación fluida, segura y eficaz, lo que permite a las empresas aprovechar todo el potencial de la IA manteniendo los más altos estándares de privacidad y seguridad de los datos. Con nuestro apoyo, las empresas pueden afrontar con confianza los desafíos de la implementación de la IA y mantenerse a la vanguardia en el panorama tecnológico en rápida evolución.