Kafka: una excelente opción para agentes de mensajes en microservicios

Publicado: 2022-11-19Kafka es una plataforma de transmisión distribuida. A menudo se utiliza para la agregación de registros, el procesamiento de secuencias en tiempo real y el abastecimiento de eventos. Recientemente, Kafka ha ganado popularidad como intermediario de mensajes para microservicios. Kafka no es una cola de mensajes tradicional como ActiveMQ o RabbitMQ. No tiene un servidor central que almacene todos los mensajes. En su lugar, utiliza un modelo de publicación-suscripción. Los mensajes se almacenan en temas y cada tema puede tener varias particiones. Kafka es altamente disponible y escalable. Puede manejar miles de millones de mensajes por día. Kafka también es muy rápido. Puede procesar mensajes en tiempo real. Kafka es una excelente opción para crear un intermediario de mensajes para microservicios. Es altamente disponible, escalable y rápido.

Kafka, que es un sistema de mensajería en tiempo real, lo hace posible. Los flujos de datos están protegidos contra interferencias y pueden ser distribuidos o tolerantes a fallas. El bus de integración de datos de Kafka es un protocolo de intercambio de datos que permite que una amplia gama de productores y consumidores compartan datos. Las capacidades de Kafka son similares a las de MongoDB y RDS, que sirven como búfer de datos al final de su aplicación.

KSQL, un lenguaje de secuencias de comandos basado en SQL, se utiliza para analizar y procesar datos de transmisión en tiempo real en Apache Kafka . KSQL incluye un marco interactivo para el procesamiento de secuencias, que está diseñado para permitirle realizar actividades de procesamiento de secuencias, como agregación de datos, filtrado, unión, sesionización, creación de ventanas, etc.

Es más que un excelente intermediario de mensajes, como lo demuestra Apache Kafka. La implementación del marco tiene una serie de características similares a las de una base de datos que lo hacen adecuado para su uso en una base de datos. Como resultado, ahora sirve como registro de eventos comerciales en lugar de depender de bases de datos relacionales.

La aplicación Kafka ahorra tiempo y energía al transmitir datos desde MongoDB de manera simple y eficiente. Se requiere MongoDB para que las empresas publiquen grandes cantidades de datos a otros suscriptores, así como para administrar múltiples flujos de datos. El servicio Kafka MongoDB Connection permite a los desarrolladores crear múltiples flujos asincrónicos con MongoDB, que es una herramienta popular en la industria.

En una base de datos, Apache Kafka sirve como modelo. Cientos de empresas lo utilizan para proporcionar garantías ACID y realizar tareas de misión crítica. Sin embargo, en la mayoría de los casos, Kafka no es tan competitivo como otras bases de datos.

¿Qué tipo de base de datos es Kafka?

Kafka es un tipo de base de datos que se utiliza para almacenar y recuperar mensajes. Es un sistema distribuido que está diseñado para ser escalable y tolerante a fallas.

Es una plataforma de procesamiento de secuencias de código abierto escrita en Scala y Java que forma parte del proyecto Kafka de Apache Software Foundation. Una corriente en informática es una colección de elementos de información que están disponibles a lo largo del tiempo. Los flujos se pueden definir como elementos en una cinta transportadora que se procesan uno a la vez. Los flujos, en su forma más básica, pueden ser una serie de eventos aparentemente no relacionados. Los conceptos de abastecimiento de eventos difieren de los conceptos de almacenamiento de datos y análisis de datos a los que están acostumbrados los desarrolladores. ¿Cómo uso Kafka como base de datos? Blue es la empresa que dice sí al trato.

Según Team Red, los programadores están cometiendo un gran error cuando cambian de bases de datos convencionales a Kafka. Según Martin Kleppmann, el mensaje del Equipo Rojo de que Kafka es para todos es condescendiente. El problema que tiene Team Red con Kafka y las transmisiones es que tienen un problema con los desarrolladores que desechan los RDMS. Cuando se presenta un registro permanente de eventos, siempre tendrá su contexto histórico, lo que facilita su auditoría. La administración de bases de datos tiene numerosas ventajas, pero también es uno de sus aspectos más difíciles. La base de datos tradicional opera de dos maneras completamente diferentes: combina lecturas y escrituras. Es fundamental que los programadores mantengan y sincronicen los datos duplicados en varias tablas.

La escala cambia el patrón a medida que avanza. Las corrientes se distinguen por una clara distinción entre las preocupaciones de los lectores y las de los escritores. No existe una relación entre la rapidez con la que Kafka escribe en un archivo y la rapidez con la que Elastic Search puede enviarle actualizaciones. Como resultado, los usuarios de Kafka procesan registros para generar varias vistas materializadas. Hacer que las vistas materializadas funcionen como un mecanismo de almacenamiento en caché conveniente requiere algunos costos iniciales. Las vistas materializadas, además de almacenar sus propios datos y escalar, son componentes importantes de la infraestructura. Para el 99 % de las empresas, los DBMS son la mejor base.

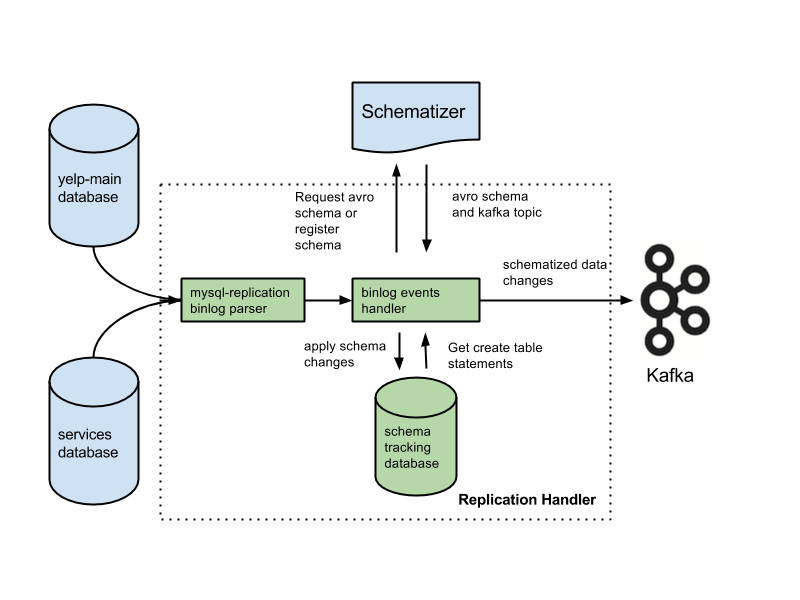

Su aplicación puede estar en esta categoría y puede tener derecho a una arquitectura novedosa basada en sus antecedentes. Muchas características críticas se perderán si reemplaza las bases de datos con registros. Las funciones incluyen restricciones de clave externa, transacciones atómicas (todo o nada) y técnicas de aislamiento de procedimientos que ayudan con los problemas de concurrencia. Arjun asume que la integridad de su aplicación se mantiene en todo momento. Las funciones básicas que la mayoría de la gente da por sentadas se convierten en responsabilidades adicionales a medida que trabaja en transmisiones. Es fundamental separar la intención de la declaración escrita. Una configuración común es usar Kafka junto con un sistema de captura de datos modificados.

Según Team Red, las características de integridad de datos de las bases de datos son fundamentales para lograr el control de datos. Las transacciones deben estar aisladas de las bases de datos convencionales para que puedan ser consideradas. Como resultado, una sola pieza de escritura puede ser costosa. Si su aplicación tiene dificultades para hacer frente al volumen de escrituras costosas, es posible que se vea obligado a migrar a una base de datos más convencional. Team Red no menciona que usar una base de datos frente a Kafka reduce sus mejores características.

Las ventajas de este diseño son significativas sobre los sistemas de mensajería tradicionales. La primera ventaja de Kafka es que puede manejar una gran cantidad de solicitudes. Además, debido a que los datos solo se escriben en el disco cuando es necesario, Kafka puede manejar grandes cantidades de datos.

SQL Server es una herramienta de base de datos que cae en la categoría de herramientas. Este dispositivo portátil es versátil y confiable, pero a veces puede ser difícil de usar. Kafka y Azure son plataformas extremadamente capaces, pero Kafka se amplía mientras que Azure se reduce.

SQL Server es una excelente herramienta para las empresas que requieren grandes cantidades de almacenamiento de datos, pero puede que no sea la mejor opción para aquellas que requieren un escalado rápido o un alto rendimiento. Para las empresas que necesitan procesar grandes cantidades de datos sin comprometer el rendimiento, Kafka es una mejor opción que SQL Server.

Kafka: un sistema de almacenamiento distribuido para telemetría de series temporales

Un sistema de almacenamiento distribuido de Kafka, que emplea un modelo basado en temas, almacena datos. Los datos se pueden almacenar en un modelo basado en temas de una base de datos Kafka en lugar de en una base de datos relacional. Se comporta de manera similar a una cola en un tema de Kafka , aunque no de la misma manera que lo hace una cola. Puede almacenar una gran cantidad de series temporales en el marco de Kafka en lugar de una base de datos de series temporales.

¿Cuál es la diferencia entre Kafka y Mongodb?

Es un servicio de registro de confirmación distribuido, particionado y replicado que se basa en un sistema distribuido. A pesar de su diseño único, es un componente importante de un sistema de mensajería. MongoDB, por otro lado, se describe como "La base de datos para ideas gigantes".

Debido a que Kafka no es compatible con las colas desde el primer momento, debe introducirlo en una versión del sistema para el consumidor. Si se requiere una base de datos relacional, otra herramienta puede ser de mayor utilidad. MongoDB es una excelente opción por una variedad de razones, incluida su facilidad de uso y flexibilidad. El soporte de usuario de Apache está disponible. Confluent tiene un Kafka (si está dispuesto a pagar) que se creó en Linkedin al mismo tiempo que el proyecto Kafka. Tener un proveedor que realice copias de seguridad automáticas y escale el clúster automáticamente es extremadamente conveniente. Si no tiene un administrador del sistema o DBA que conozca MongoDB, es una buena idea utilizar un tercero que se especialice en el alojamiento de MongoDB.

Kafka, en su forma más básica, está destinado a permitirnos poner en cola los mensajes. El motor de almacenamiento de Cassandra garantiza una escritura en tiempo constante en sus datos sin importar cuán grandes sean. MongoDB proporciona una implementación personalizada de mapa/reducción, así como soporte nativo de Hadoop para análisis, mientras que Cassandra no lo hace. No importa si lo aloja usted u otro proveedor porque el costo suele ser razonable.

Kafka vs. Sistemas de bases de datos tradicionales

Es importante tener en cuenta que existen varias diferencias entre Kafka y un sistema de base de datos tradicional.

Debido a que Kafka es una plataforma de transmisión, puede manejar una alta tasa de ingesta de datos sin requerir un procesamiento previo significativo.

Los datos son consumidos por lecturas de cola en lugar de lecturas de disco cuando se ejecuta Kafka.

El uso del almacenamiento en caché de páginas reduce la necesidad de visitas de ida y vuelta a la base de datos para Kafka.

Para enviar datos descendentes a clientes intermedios, Kafka emplea mensajes de publicación/suscripción.

¿Qué es la base de datos Kafka?

Kafka es una base de datos que a menudo se usa para almacenar datos de transmisión. Es un sistema distribuido que está diseñado para ser escalable y tolerante a fallas. Kafka se usa a menudo para crear canalizaciones de datos en tiempo real y aplicaciones de transmisión. Puede manejar alto rendimiento y baja latencia.

Un corredor de mensajes como Kafka ha ganado popularidad en los últimos años. Según los defensores, Kafka es un cambio de paradigma en la gestión de datos. Es fundamental recordar que el uso de Kafka como su almacén de datos principal no le brinda aislamiento. Todos los problemas que encuentren los sistemas de bases de datos se resolverán en el futuro. Los piratas informáticos pueden robar datos explotando fallas en arquitecturas autónomas. Si dos usuarios intentan comprar el mismo artículo al mismo tiempo, ambos tendrán éxito y nos quedaremos sin inventario para ambos. Estas arquitecturas, que utilizan funciones de viaje en el tiempo cuando se ejecutan dispositivos de luz de gas, se basan en arquitecturas basadas en eventos.

Administrar grandes volúmenes de datos es un excelente uso de Kafka. Las transacciones aún deben aislarse utilizando un DBMS tradicional. Utilice bases de datos OLTP para el control de admisión, CDC para la generación de eventos y modele copias posteriores a medida que aparecen las vistas para darle la vuelta a su base de datos.

Kafka también se puede utilizar para almacenar grandes cantidades de datos y procesarlos a diario. La capacidad de procesar big data en modo por lotes o de transmisión es una ventaja sobre otros métodos. El proceso de Kafka se puede utilizar para recuperar archivos de registro de varios servidores y almacenarlos en una base de datos o en un índice de búsqueda, por ejemplo. También está disponible una API de transmisión que se puede usar para procesar datos en tiempo real.

Kafka contra Sql

En general, Kafka y MySQL se clasifican en dos tipos: colas de mensajes y aplicaciones de bases de datos. La mayoría de los desarrolladores consideran a Kafka como una solución escalable, distribuida y de alto rendimiento, mientras que MySQL se considera la más popular debido a su simplicidad, rendimiento y facilidad de uso.

La mensajería pub-sub en Kafka es un sistema distribuido, tolerante a fallas y de alto rendimiento que puede manejar grandes volúmenes de datos. MySQL es la base de datos de código abierto más popular del mundo, diseñada para su uso en sistemas de producción de misión crítica y de carga pesada. Los desarrollos consideran que Kafka es más poderoso que MySQL debido a su alto rendimiento, arquitectura distribuida y escalabilidad; mientras que SQL, Free y Easy son las principales razones por las que los usuarios de MySQL lo prefieren. Recomiendo PostgreSQL si desea obtener experiencia práctica con los sistemas de administración de bases de datos (DBMS). En Vital Beats, usamos principalmente Postgres porque nos permite lograr el equilibrio deseado entre la gestión de datos eficaz y la copia de seguridad sin dejar de admitir la línea de comandos. Si planea alojar su base de datos localmente o en la nube, el primer punto de contacto son las bases de datos PaaS (Platform as a Service). Debido a que MongoDB escribe datos en el mismo nivel que un documento, la consistencia es difícil sin transacciones.

Los almacenes de documentos, como los que se encuentran en Amazon DynamoDB y AWS RedShift, son muy diferentes de los pares clave-valor (o almacenes de columnas) que se encuentran en MongoDB. Es más rápido y fácil consultar usando la base de datos #Nosql porque se reduce el tiempo de desarrollo. Como empleado por primera vez en la industria de bienes raíces, me gustaría seleccionar una base de datos que sea altamente productiva con el tiempo. Si ejecuta Aurora Postgres en AWS con una implementación de una sola región, es una de las mejores plataformas que recomiendo. Si usa PostgreSQL en tres entornos de nube, experimentará una mejor replicación de varias regiones. Si las configura correctamente, cualquiera de estas tres bases de datos funcionará de manera eficiente, escalable y confiable a largo plazo. Uber cambió de Postgres a MySql por una variedad de razones, incluida la necesidad de un sistema de transmisión de datos más ágil y confiable.

El director de tecnología de OPS Platform afirmó que Postgres era la opción más efectiva a largo plazo para su producto debido a su velocidad y facilidad de uso. En comparación con MySQL 7.x, las transacciones se manejan más rápidamente en MySQL 8.0. ¿Es una base de datos más segura? ¿Es posible cambiar la clave de cifrado al azar? MySQL y MongoDB son las dos bases de datos de código abierto más populares. Además de la facilidad con la que se pueden almacenar los datos, MongoDB se puede utilizar para almacenar grandes cantidades de datos entrantes a través de la red de distribución de contenido (CDN). La principal ventaja de Postgres sobre otras bases de datos relacionales de objetos es su énfasis en la extensibilidad y el cumplimiento de estándares.

Se pueden crear índices regulares de árbol B y hash, así como índices de expresión y parciales (aquellos que solo afectan una parte de la tabla). La distinción más básica entre Redis y Kafka es su uso de marcos de mensajería empresarial. Estoy buscando una tecnología que sea nativa de la nube cuando elijo una. Además del descubrimiento de servicios, NATS se puede usar para reemplazar el equilibrio de carga, los multiclústeres globales y otras operaciones. Lo único que Redis no hace es servir como un intermediario de mensajes puro (al momento de escribir). Como resultado, es más un almacén general de clave-valor en memoria. A pesar de tener una extensa biblioteca de música, mis canciones suelen durar más de dos horas.

El problema de almacenar archivos de audio en una fila de la base de datos durante varias horas es que no se pueden buscar fácilmente. Si lo prefiere, considere almacenar archivos de audio en un servicio de almacenamiento en la nube como Backblaze b2 o AWS S3. ¿Existe alguna solución que utilice MQTT Broker en IoT World? Está alojado en uno de los centros de datos. Actualmente lo estamos procesando para fines relacionados con alertas y alarmas. Nuestro objetivo principal es utilizar productos más ligeros que reduzcan la complejidad operativa y los costes de mantenimiento. Sería ideal si pudiéramos integrar Apache Kafka con estas llamadas API de terceros adicionales.

La aplicación RabbitMQ es una excelente opción tanto para reintentar como para hacer cola. Si no necesita que cada mensaje sea procesado por más de un usuario, puede usar RabbitMQ. No tiene sentido usar Kafka para entregar el sistema con confirmaciones. El administrador de estado de eventos de Kafka, al igual que un administrador de estado de eventos persistentes, le permite transformar y consultar varias fuentes de datos mediante una API de transmisión. El marco RabbitMQ es ideal para un editor o suscriptor (o consumidor) uno a uno, y creo que se puede configurar un intercambio de distribución para habilitar múltiples consumidores. El proyecto Pushnami demuestra cómo migrar datos en vivo de una base de datos a otra. Como cada frontend (Angular), backend (Node.js) y frontend (MongoDB) son nativos, el intercambio de datos fue mucho más fácil.

Para evitar la capa de traducción, omití la parte relacional a jerárquica. Es fundamental mantener un tamaño finito en los objetos de MongoDB y utilizar los índices correctos. Ya en la década de 1960, algunos de los primeros registros médicos electrónicos (EMR, por sus siglas en inglés) usaban MUMPS, una base de datos orientada a documentos. MongoDB, que almacena hasta el 40 % de todos los registros hospitalarios, se considera una sólida base de datos médica. Sin embargo, ha habido algunos métodos muy inteligentes para realizar consultas geográficas no admitidas de forma nativa, que son extremadamente lentas a largo plazo. Amazon Kinesis procesa cientos de miles de archivos de datos por segundo de cientos de miles de fuentes. RabbitMQ le facilita enviar y recibir mensajes desde cualquier aplicación. Apache ActiveMQ es rápido, admite una amplia gama de clientes de idiomas cruzados y es un lenguaje de secuencias de comandos robusto. Los datos de Hadoop se procesan mediante un motor de procesamiento rápido y de propósito general llamado Spark.

Kafka contra mongodb

Mongodb es una poderosa base de datos orientada a documentos que tiene muchas características que la convierten en una buena opción para una variedad de aplicaciones. Kafka es una plataforma de transmisión de alto rendimiento que se puede utilizar para crear canalizaciones de datos en tiempo real y aplicaciones de transmisión.

Las transferencias de MongoDB como fuente a otras fuentes de MongoDB u otras fuentes de MongoDB pueden realizarse sin problemas con la aplicación Kafka to MongoDB. Con la ayuda de MongoDB Kafka Connector, aprenderá cómo transferir datos de manera eficiente. Con esta función, puede crear una canalización de ETL completamente nueva para su organización. Confluent ofrece una variedad de conectores que actúan como fuente y sumidero, lo que permite a los usuarios transferir datos entre los dos. Los conectores Debezium MongoDB son uno de esos mecanismos de conectividad que permite a los usuarios de Kafka MongoDB conectarse a la base de datos MongoDB. Antes de poder iniciar Confluent Kafka, primero debe asegurarse de que se esté ejecutando en su sistema. Al usar funcionalidades como KStream, KSQL o cualquier otra herramienta como Spark Streaming, puede analizar datos en Kafka.

La entrada de datos en el almacén requiere scripts manuales, así como un código personalizado. La plataforma de canalización de datos sin código de Hevo le permite crear sistemas de canalización de datos simples sin codificación. La plataforma de precios transparente de Hevo le permite ver cada detalle de su inversión en ELT en tiempo real. El período de prueba dura 14 días e incluye soporte 24×7. El cifrado de extremo a extremo se realiza utilizando las certificaciones de seguridad más estrictas. Hevo se puede utilizar para transferir de forma segura sus datos de Kafka y MongoDB a 150 fuentes de datos diferentes (incluidas 40 fuentes gratuitas).

¿Qué es Kafka y Mongodb?

El conector MongoDB Kafka es un conector verificado por Confluent que mantiene los datos de los temas de Kafka como un receptor de datos en MongoDB y publica los cambios en esos temas como fuente de datos.

Los pros y los contras de usar Kafka como base de datos

¿Qué base de datos es buena para Kafka? En principio, Kafka se puede utilizar para crear una base de datos. El resultado será un examen de todos los problemas importantes que han afectado a los sistemas de gestión de bases de datos durante décadas. Un sistema de gestión de bases de datos (DBMS) es un tipo de software que organiza y consulta datos. Son necesarios para aplicaciones a gran escala y para almacenar datos a los que deben acceder varios usuarios. Un DBMS se clasifica en dos tipos: relacional y no relacional. El modelo relacional es un método estándar para representar información en un DBMS relacional. Son populares porque son fáciles de usar y se pueden usar para almacenar datos organizados en tablas. Un DBMS que no usa modelos relacionales no es tan poderoso como uno que usa otros modelos. Los datos también se almacenan en otros formatos además de las tablas para organizarlos de manera más eficiente, como flujos de datos. El modelo Kafka se usa para crear una base de datos, que se puede usar para una variedad de propósitos. El procesamiento de flujo es el corazón de Kafka, un nuevo modelo de representación de datos. Los sistemas de gestión de datos (DMS) son un componente crucial de la gestión de datos. Sin embargo, usar Kafka como base de datos puede resultar complicado en ocasiones. Algunos de los problemas más comunes que encuentran los DBMS son el rendimiento, la escalabilidad y la confiabilidad. George Fraser, director ejecutivo de Fivetran, y Arjun Narayan, director ejecutivo de Materialise, coescribieron la publicación.

Base de datos de persistencia de Kafka

Las bases de datos de persistencia de Kafka proporcionan una forma de almacenar datos en un clúster de Kafka de manera altamente disponible y escalable. De forma predeterminada, kafka utilizará una base de datos en memoria para almacenar datos, pero esto no es adecuado para implementaciones de producción. Se puede usar una base de datos de persistencia de kafka para proporcionar una opción de almacenamiento más confiable para los datos de kafka.

LinkedIn creó Apache kaffef de código abierto en 2011. Esta plataforma permite alimentar datos en tiempo real con una latencia y un rendimiento extremadamente bajos. En la mayoría de los casos, los datos se pueden importar y exportar a través de Kafka Connect desde sistemas externos. Las nuevas soluciones pueden ayudar con problemas como el rendimiento de almacenamiento ineficiente y la infrautilización de las unidades. A pesar de los desafíos de la arquitectura, el flash local es una excelente opción para los sistemas Kafka. Debido a que solo se puede acceder a cada tema en Kakfa en una unidad, habrá un aumento en la infrautilización. La sincronización también puede ser difícil, lo que genera problemas de costos y eficiencia.

Cuando falla un SSD, los datos deben reconstruirse por completo. Este procedimiento lento reduce el rendimiento del clúster. Kafka se adapta mejor al almacenamiento basado en NVMe/TCP porque allana el equilibrio entre confiabilidad y rendimiento.

Kafka es un sistema de mensajería fantástico, pero no una solución perfecta para almacenar datos

Kafka es un excelente sistema de mensajería que se puede utilizar para almacenar datos. Una de las opciones de retención de Kafka es un tiempo de retención de -1, que se refiere a una retención de por vida. Sin embargo, la confiabilidad de Kafka está muy por debajo de la de una base de datos tradicional. Es importante tener en cuenta que Kafka almacena datos en disco, suma de verificación y replicados para tolerancia a fallas, por lo que acumular más datos almacenados no lo ralentiza. Kafka se puede usar para enviar y recibir mensajes, pero no es la mejor opción para almacenar datos.

¿Qué es Kafka?

Kafka es un sistema de mensajería de publicación y suscripción rápido, escalable, duradero y tolerante a fallas. Kafka se utiliza en la producción de empresas como LinkedIn, Twitter, Netflix y Airbnb.

Kafka tiene un diseño simple y directo. Es un sistema distribuido que se ejecuta en un grupo de máquinas y se puede escalar horizontalmente. Kafka está diseñado para manejar un alto rendimiento y una baja latencia.

Kafka se utiliza para crear canalizaciones y aplicaciones de transmisión de datos en tiempo real. Se puede utilizar para procesar y agregar datos en tiempo real. Kafka también se puede utilizar para el procesamiento, registro y auditoría de eventos.

LinkedIn lanzó Kafka en 2011 para manejar fuentes de datos en tiempo real. Kafka está siendo utilizado por más del 80% de Fortune 100 en la actualidad. Una API de Kafka Streams es una biblioteca poderosa y liviana que está diseñada para permitir el procesamiento sobre la marcha. Además de las bases de datos distribuidas populares, Kafka incluye una abstracción de un registro de confirmación distribuido. A diferencia de las colas de mensajería, Kafka es un sistema distribuido altamente adaptable y tolerante a fallas con alta escalabilidad. Por ejemplo, podría usarse para administrar la coincidencia de pasajeros y conductores en Uber o proporcionar análisis en tiempo real en British Gas. Muchos microservicios se basan en Kafka. El servicio nativo en la nube, completo y completamente administrado de Confluent es superior al de Kafka. Confluent simplifica la creación de una categoría completamente nueva de aplicaciones modernas impulsadas por eventos al combinar datos históricos y en tiempo real en una fuente de verdad unificada.

Con la ayuda de Kinesis, puede manejar una amplia gama de flujos de datos, lo que la convierte en una plataforma de procesamiento de flujo potente y versátil. Es una plataforma popular debido a su velocidad, simplicidad y compatibilidad con una amplia gama de dispositivos. Debido a su confiabilidad, es una de las plataformas de transmisión más populares. Puede manejar un gran volumen de datos sin experimentar ningún problema debido a su durabilidad. Además, debido a que es una plataforma conocida que es ampliamente utilizada y respaldada, es fácil encontrar un socio o integrador que lo ayude a comenzar. Si está buscando una plataforma de transmisión que sea poderosa y confiable, Kinesis es una excelente opción.

Kafka: el sistema de mensajería que está reemplazando a las bases de datos

Los flujos de datos en tiempo real se pueden adaptar al entorno de datos cambiante mediante el uso de Kafka, un sistema de mensajería para crear canalizaciones y aplicaciones de transmisión de datos en tiempo real. Los grandes datos se procesan a través de flujos de eventos en tiempo real mediante el uso de Kafka, que está escrito en Scala y Java. Una conexión Kafka se puede extender de un punto a otro y también se puede usar para enviar datos entre fuentes. La plataforma de transmisión de eventos está destinada a proporcionar transmisión en vivo de eventos. Es injusto comparar bases de datos con soluciones de mensajería como Kafka. Debido a las características de Kafka, ya no se requieren bases de datos.

Kafka no es una base de datos

Kafka no es una base de datos, pero a menudo se usa junto con una. Es un intermediario de mensajes que se puede utilizar para enviar mensajes entre diferentes componentes de un sistema. A menudo se usa para desacoplar diferentes partes de un sistema para que puedan escalarse de forma independiente.

Es posible reemplazar Apache Kafka con una base de datos, pero no lo haga por conveniencia. El episodio de Top Gear en el que los protagonistas recibieron $ 10,000 cada uno por comprar un superdeportivo italiano usado con motor central me recordó un viejo episodio de Top Gear en el que los protagonistas recibieron $ 10,000 cada uno. En 2011, LinkedIn lanzó Kafka y este episodio se emitió el mismo año. Le permite hacer el mínimo de mensajería persistente sin invertir en una plataforma de mensajería con todas las funciones. La premisa fundamental es que existe una regla básica. Cree una tabla (o depósito, colección, índice, lo que sea) para cada evento que se registró durante el proceso de producción. Sondee la base de datos periódicamente desde una instancia de consumidor, actualizando el estado del consumidor a medida que se procesa.

Para que el modelo funcione correctamente, los productores y los consumidores deben poder trabajar simultáneamente. Considere usar el libro de Kafka como guía y almacenar registros indefinidamente en lugar de simplemente leerlos. Los grupos de consumidores separados, por otro lado, podrían implementarse duplicando registros en la inserción y luego eliminando registros después del consumo. Kafka emplea compensaciones persistentes para permitir su abanico de datos definidos por el usuario y admitir múltiples consumidores inconexos. Para discontinuar esta funcionalidad, debe desarrollar un servicio desde cero. No es difícil implementar el concepto de purga temporal, pero es necesario acoger la lógica de los carroñeros. En Kafka, existen controles detallados sobre todos los actores (consumidores, productores y administradores).

Puede procesar millones de registros por segundo en servidores básicos y en la nube sin ningún problema. Kafka está optimizado para altos niveles de rendimiento tanto en el lado del productor como del consumidor, en un sentido no funcional. Usando Kafka, es un registro distribuido de solo agregar que no tiene rival en este campo. A diferencia de los intermediarios de mensajes tradicionales que eliminan los mensajes en la etapa de consumo, Kafka no purga los mensajes una vez que se consumen. Es casi seguro que el rendimiento y la latencia de una base de datos deberán mejorarse significativamente mediante el uso de hardware especializado y un ajuste de rendimiento altamente enfocado. Prescindir de un corredor puede resultar atractivo a primera vista. Cuando utiliza una plataforma de transmisión de eventos como Kafka, capitaliza el enorme esfuerzo de ingeniería que se ha invertido en su construcción.

Para asegurarse de que cualquier solución que elija implementar hoy se pueda mantener, debe estar seguro de que se puede mantener a un alto nivel. La mayoría de las funciones en un almacén de eventos solo se pueden implementar mediante el uso de una base de datos. No existe una tienda de eventos única para todos; cualquier almacén de eventos no triviales, en la mayoría de los casos, es casi con seguridad una implementación a medida respaldada por una o más bases de datos estándar. Puede usar bases de datos en el campo de la organización de datos para una recuperación eficiente, pero debe evitar usarlas para distribuir datos (casi) en tiempo real.