La guía definitiva para el SEO técnico

Publicado: 2023-02-24Enumere tres cosas que ha hecho este año relacionadas con la optimización de motores de búsqueda (SEO).

¿Estas tácticas giran en torno a la investigación de palabras clave, las metadescripciones y los vínculos de retroceso?

Si es así, no estás solo. Cuando se trata de SEO, estas técnicas suelen ser las primeras que los especialistas en marketing agregan a su arsenal.

Si bien estas estrategias mejoran la visibilidad de su sitio en la búsqueda orgánica, no son las únicas que debería emplear. Hay otro conjunto de tácticas que se encuentran bajo el paraguas de SEO.

El SEO técnico se refiere a los elementos detrás de escena que impulsan su motor de crecimiento orgánico, como la arquitectura del sitio, la optimización móvil y la velocidad de la página. Estos aspectos del SEO pueden no ser los más atractivos, pero son increíblemente importantes.

El primer paso para mejorar su SEO técnico es saber dónde se encuentra realizando una auditoría del sitio. El segundo paso es crear un plan para abordar las áreas en las que se queda corto. Cubriremos estos pasos en profundidad a continuación.

Consejo profesional: cree un sitio web diseñado para convertir usando las herramientas CMS gratuitas de HubSpot.

¿Qué es el SEO técnico?

El SEO técnico se refiere a cualquier cosa que haga que haga que su sitio sea más fácil de rastrear e indexar para los motores de búsqueda. El SEO técnico, la estrategia de contenido y las estrategias de construcción de enlaces funcionan en conjunto para ayudar a que sus páginas obtengan una clasificación alta en la búsqueda.

SEO técnico vs. SEO on-page vs. SEO off-page

Muchas personas dividen la optimización de motores de búsqueda (SEO) en tres segmentos diferentes: SEO en la página, SEO fuera de la página y SEO técnico. Veamos rápidamente lo que significa cada uno.

SEO en la página

El SEO en la página se refiere al contenido que le dice a los motores de búsqueda (¡y a los lectores!) de qué se trata su página, incluido el texto alternativo de la imagen, el uso de palabras clave, las metadescripciones, las etiquetas H1, los nombres de URL y los enlaces internos. Tienes el mayor control sobre el SEO en la página porque, bueno, todo estáentu sitio.

SEO fuera de la página

El SEO fuera de la página le dice a los motores de búsqueda qué tan popular y útil es su página a través de votos de confianza, especialmente vínculos de retroceso o enlaces de otros sitios al suyo. La cantidad y la calidad de los backlinks aumentan el PageRank de una página. En igualdad de condiciones, una página con 100 enlaces relevantes de sitios confiables superará a una página con 50 enlaces relevantes de sitios confiables (o 100 enlaces irrelevantes de sitios confiables).

SEO técnico

El SEO técnico también está bajo tu control, pero es un poco más complicado de dominar ya que es menos intuitivo.

¿Por qué es importante el SEO técnico?

Puede sentirse tentado a ignorar por completo este componente del SEO; sin embargo, juega un papel importante en su tráfico orgánico. Su contenido puede ser el más completo, útil y bien escrito, pero a menos que un motor de búsqueda pueda rastrearlo, muy pocas personas lo verán.

Es como un árbol que cae en el bosque cuando no hay nadie cerca para oírlo… ¿hace algún sonido? Sin una sólida base técnica de SEO, su contenido no tendrá ningún sonido para los motores de búsqueda.

Fuente

Fuente

Analicemos cómo puede hacer que su contenido resuene en Internet.

Comprender el SEO técnico

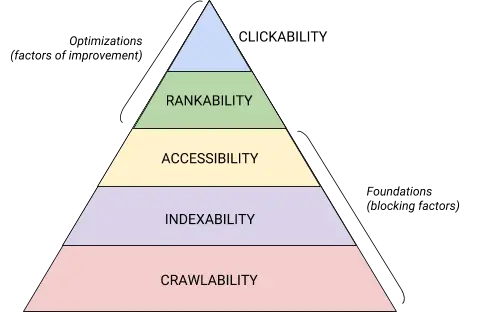

El SEO técnico es una bestia que se descompone mejor en partes digeribles. Si eres como yo, te gusta abordar las cosas grandes en partes y con listas de verificación. Lo crea o no, todo lo que hemos cubierto hasta este punto se puede colocar en una de cinco categorías, cada una de las cuales merece su propia lista de elementos procesables.

Estas cinco categorías y su lugar en la jerarquía técnica de SEO se ilustran mejor con este hermoso gráfico que recuerda a la Jerarquía de necesidades de Maslov pero remezclado para la optimización de motores de búsqueda. (Tenga en cuenta que utilizaremos el término de uso común "Representación" en lugar de Accesibilidad).

Fuente

Fuente

Fundamentos técnicos de la auditoría SEO

Antes de comenzar con su auditoría técnica de SEO, hay algunos fundamentos que debe implementar.

Abordemos estos fundamentos técnicos de SEO antes de pasar al resto de la auditoría de su sitio web.

Audita tu dominio preferido

Tu dominio es la URL que las personas escriben para llegar a tu sitio, como hubspot.com . El dominio de su sitio web afecta si las personas pueden encontrarlo a través de la búsqueda y proporciona una forma consistente de identificar su sitio.

Cuando selecciona un dominio preferido, le está diciendo a los motores de búsqueda si prefiere que se muestre la versión con www o sin www de su sitio en los resultados de búsqueda. Por ejemplo, puede seleccionarwww.yourwebsite.comsobreyourwebsite.com. Esto le dice a los motores de búsqueda que prioricen la versión www de su sitio y redirige a todos los usuarios a esa URL. De lo contrario, los motores de búsqueda tratarán estas dos versiones como sitios separados, lo que dará como resultado un valor de SEO disperso.

Anteriormente, Google te pedía que identificaras la versión de tu URL que prefieres. Ahora, Google identificará y seleccionará una versión para mostrarle a los buscadores. Sin embargo, si prefiere establecer la versión preferida de su dominio, puede hacerlo a través de etiquetas canónicas (que trataremos en breve). De cualquier manera, una vez que establezca su dominio preferido, asegúrese de que todas las variantes, es decir,www, non-www, http e index.html, redirijan permanentemente a esa versión.

Implementar SSL

Es posible que haya escuchado este término antes, eso se debe a que es muy importante. SSL, o Secure Sockets Layer , crea una capa de protección entre el servidor web (el software responsable de cumplir con una solicitud en línea) y un navegador, lo que hace que su sitio sea seguro. Cuando un usuario envía información a su sitio web, como pago o información de contacto, es menos probable que esa información sea pirateada porque tiene SSL para protegerlos.

Un certificado SSL se identifica con un dominio que comienza con "https://" en lugar de "http://" y un símbolo de candado en la barra de URL.

Los motores de búsqueda priorizan los sitios seguros; de hecho, Google anunció ya en 2014 que SSL se consideraría un factor de clasificación . Debido a esto, asegúrese de configurar la variante SSL de su página de inicio como su dominio preferido.

Después de configurar SSL, deberá migrar cualquier página que no sea SSL de http a https. Es una tarea difícil, pero vale la pena el esfuerzo en nombre de una clasificación mejorada. Estos son los pasos que debe seguir:

- Redirigir todas las páginas de http://yourwebsite.com a https://yourwebsite.com .

- Actualice todas las etiquetas canónicas y hreflang en consecuencia.

- Actualice las URL en su mapa del sitio (ubicado en yourwebsite.com/sitemap.xml ) y su robot.txt (ubicado en yourwebsite.com/robots.txt ).

- Configure una nueva instancia de Google Search Console y Bing Webmaster Tools para su sitio web https y realice un seguimiento para asegurarse de que el 100 % del tráfico migre.

Optimizar la velocidad de la página

¿Sabe cuánto tiempo esperará un visitante del sitio web para que se cargue su sitio web? Seis segundos ... y eso es ser generoso. Algunos datos muestran que la tasa de rebote aumenta en un 90% con un aumento en el tiempo de carga de la página de uno a cinco segundos. No tiene un segundo que perder, por lo que mejorar el tiempo de carga de su sitio debe ser una prioridad.

La velocidad del sitio no solo es importante para la experiencia del usuario y la conversión, también es un factor de clasificación .

Utilice estos consejos para mejorar el tiempo promedio de carga de su página:

- Comprime todos tus archivos. La compresión reduce el tamaño de sus imágenes , así como los archivos CSS, HTML y JavaScript, por lo que ocupan menos espacio y se cargan más rápido.

- Audite las redirecciones con regularidad. Una redirección 301 tarda unos segundos en procesarse. Multiplique eso en varias páginas o capas de redireccionamientos y tendrá un impacto serio en la velocidad de su sitio.

- Recorta tu código. El código desordenado puede afectar negativamente la velocidad de su sitio. Código desordenado significa código perezoso. Es como escribir: tal vez en el primer borrador, expresas tu punto en 6 oraciones. En el segundo borrador, lo haces en 3. Cuanto más eficiente sea el código, más rápido se cargará la página (en general). Una vez que limpie las cosas, minimizará y comprimirá su código .

- Considere una red de distribución de contenido (CDN). Los CDN son servidores web distribuidos que almacenan copias de su sitio web en varias ubicaciones geográficas y entregan su sitio según la ubicación del buscador. Dado que la información entre servidores tiene una distancia más corta para viajar, su sitio se carga más rápido para la parte solicitante.

- Trate de no volverse feliz con los complementos. Los complementos obsoletos a menudo tienen vulnerabilidades de seguridad que hacen que su sitio web sea susceptible a piratas informáticos maliciosos que pueden dañar las clasificaciones de su sitio web. Asegúrese de usar siempre las últimas versiones de complementos y minimice su uso a lo más esencial. De la misma manera, considere usar temas personalizados, ya que los temas de sitios web prefabricados a menudo vienen con una gran cantidad de código innecesario.

- Aprovecha los complementos de caché. Los complementos de caché almacenan una versión estática de su sitio para enviarla a los usuarios recurrentes, lo que reduce el tiempo de carga del sitio durante las visitas repetidas.

- Utilice la carga asíncrona (asincrónica). Los scripts son instrucciones que los servidores deben leer antes de que puedan procesar el HTML o el cuerpo de su página web, es decir, las cosas que los visitantes quieren ver en su sitio. Por lo general, las secuencias de comandos se colocan en el <head> de un sitio web (piense: su secuencia de comandos de Google Tag Manager), donde tienen prioridad sobre el contenido del resto de la página. El uso de código asíncrono significa que el servidor puede procesar el HTML y el script simultáneamente, lo que reduce la demora y aumenta el tiempo de carga de la página.

Así es como se ve un script asincrónico: < script async src =” script.js “></ script >

Si desea ver dónde se queda corto su sitio web en el departamento de velocidad, puede utilizar este recurso de Google .

Una vez que tenga los fundamentos técnicos de SEO en su lugar, estará listo para pasar a la siguiente etapa: rastreabilidad.

Lista de verificación de rastreabilidad

La capacidad de rastreo es la base de su estrategia técnica de SEO. Los robots de búsqueda rastrearán sus páginas para recopilar información sobre su sitio.

Si estos bots están bloqueados de alguna manera para rastrear, no pueden indexar ni clasificar sus páginas. El primer paso para implementar el SEO técnico es asegurarse de que todas sus páginas importantes sean accesibles y fáciles de navegar.

A continuación, cubriremos algunos elementos para agregar a su lista de verificación, así como algunos elementos del sitio web para auditar y garantizar que sus páginas sean óptimas para el rastreo.

Lista de verificación de rastreabilidad

- Crear un mapa del sitio XML.

- Maximice su presupuesto de rastreo.

- Optimice la arquitectura de su sitio.

- Establecer una estructura de URL.

- Utilice robots.txt.

- Agregue menús de migas de pan.

- Usa la paginación.

- Verifique sus archivos de registro de SEO.

1. Cree un mapa del sitio XML.

¿Recuerdas la estructura del sitio que repasamos? Eso pertenece a algo llamado mapa del sitio XML que ayuda a los robots de búsqueda a comprender y rastrear sus páginas web. Puede pensar en ello como un mapa para su sitio web. Enviarás tu mapa del sitio a Google Search Console y Bing Webmaster Tools una vez que esté completo. Recuerde mantener su mapa del sitio actualizado a medida que agrega y elimina páginas web.

2. Maximice su presupuesto de rastreo.

Su presupuesto de rastreo se refiere a las páginas y los recursos que rastrearán los robots de búsqueda de su sitio .

Dado que el presupuesto de rastreo no es infinito, asegúrese de priorizar las páginas más importantes para el rastreo.

Aquí hay algunos consejos para asegurarse de que está maximizando su presupuesto de rastreo:

- Elimina o canonicaliza las páginas duplicadas.

- Arregle o redirija cualquier enlace roto.

- Asegúrese de que sus archivos CSS y Javascript se puedan rastrear.

- Comprueba tus estadísticas de rastreo con regularidad y observa si hay descensos o aumentos repentinos.

- Asegúrese de que cualquier bot o página que no haya permitido rastrear esté destinado a ser bloqueado.

- Mantenga su mapa del sitio actualizado y envíelo a las herramientas para webmasters correspondientes.

- Elimina el contenido innecesario o desactualizado de tu sitio.

- Tenga cuidado con las URL generadas dinámicamente, que pueden hacer que la cantidad de páginas de su sitio se dispare.

3. Optimice la arquitectura de su sitio.

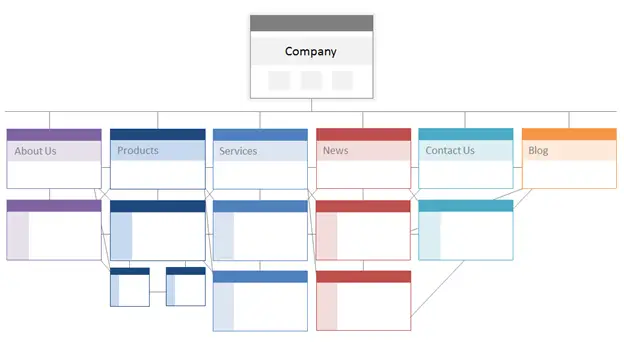

Su sitio web tiene varias páginas. Esas páginas deben organizarse de una manera que permita a los motores de búsqueda encontrarlas y rastrearlas fácilmente. Ahí es donde entra en juego la estructura de su sitio, a menudo denominada arquitectura de información de su sitio web.

De la misma manera que un edificio se basa en el diseño arquitectónico, la arquitectura de su sitio es la forma en que organiza las páginas de su sitio.

Las páginas relacionadas se agrupan; por ejemplo, la página de inicio de su blog se vincula a publicaciones de blog individuales, cada una de las cuales se vincula a sus respectivas páginas de autor. Esta estructura ayuda a los robots de búsqueda a comprender la relación entre sus páginas.

La arquitectura de su sitio también debe moldear y ser moldeada por la importancia de las páginas individuales. Cuanto más cerca esté la página A de su página de inicio, más páginas se vincularán a la página A, y cuanto más enlace tenganesaspáginas, más importancia le darán los motores de búsqueda a la página A.

Por ejemplo, un enlace desde su página de inicio a la página A demuestra más importancia que un enlace desde una publicación de blog. Cuantos más enlaces a la página A, más "significativa" se vuelve esa página para los motores de búsqueda.

Conceptualmente, la arquitectura de un sitio podría verse así, donde las páginasAcerca de, Producto, Noticias,etc. se colocan en la parte superior de la jerarquía de importancia de la página.

Fuente

Asegúrese de que las páginas más importantes para su negocio estén en la parte superior de la jerarquía con la mayor cantidad de enlaces internos (¡relevantes!).

4. Establezca una estructura de URL.

La estructura de URL se refiere a cómo estructura sus URL, lo quepodría estardeterminado por la arquitectura de su sitio. Voy a explicar la conexión en un momento. Primero, aclaremos que las URL pueden tener subdirectorios, comoblog.hubspot.com, y/o subcarpetas, comohubspot.com/blog, que indican a dónde conduce la URL.

Como ejemplo, una publicación de blog tituladaCómo arreglar a tu perrose incluiría en un subdominio o subdirectorio de blog. La URL podría ser www.bestdogcare.com/blog/how-to-groom-your-dog . Mientras que una página de producto en ese mismo sitio seríawww.bestdogcare.com/products/grooming-brush.

Ya sea que use subdominios o subdirectorios o "productos" versus "tienda" en su URL, depende totalmente de usted. La belleza de crear su propio sitio web es que puede crear las reglas. Lo importante es que esas reglas sigan una estructura unificada, lo que significa que no debe cambiar entre blog.yourwebsite.com y yourwebsite.com/blogs en diferentes páginas. Cree una hoja de ruta, aplíquela a su estructura de nombres de URL y apéguese a ella.

Aquí hay algunos consejos más sobre cómo escribir sus URL:

- Utilice caracteres en minúsculas.

- Use guiones para separar las palabras.

- Hágalos breves y descriptivos.

- Evite el uso de caracteres o palabras innecesarias (incluidas las preposiciones).

- Incluya sus palabras clave objetivo.

Una vez que haya abrochado su estructura de URL, enviará una lista de URL de sus páginas importantes a los motores de búsqueda en forma de un mapa del sitio XML . Si lo hace, le da a los robots de búsqueda un contexto adicional sobre su sitio para que no tengan que averiguarlo mientras rastrean.

5. Utilice robots.txt.

Cuando un robot web rastrea su sitio, primero verificará /robot.txt, también conocido como el Protocolo de exclusión de robots. Este protocolo puede permitir o impedir que robots web específicos rastreen su sitio, incluidas secciones específicas o incluso páginas de su sitio. Si desea evitar que los bots indexen su sitio, usará una metaetiqueta de robots noindex. Analicemos ambos escenarios.

Es posible que desee bloquear ciertos bots para que no rastreen su sitio por completo. Desafortunadamente, existen algunos bots con intenciones maliciosas, bots que rasparán su contenido o enviarán spam a los foros de su comunidad. Si nota este mal comportamiento, usará su robot.txt para evitar que ingresen a su sitio web. En este escenario, puede pensar en robot.txt como su campo de fuerza de los bots malos en Internet.

Con respecto a la indexación, los robots de búsqueda rastrean su sitio para recopilar pistas y encontrar palabras clave para que puedan relacionar sus páginas web con consultas de búsqueda relevantes. Pero, como veremos más adelante, tiene un presupuesto de rastreo que no desea gastar en datos innecesarios. Por lo tanto, es posible que desee excluir las páginas que no ayudan a los robots de búsqueda a comprender de qué se trata su sitio web, por ejemplo, una páginade agradecimientode una oferta o una página de inicio de sesión.

Pase lo que pase, su protocolo robot.txt será único dependiendo de lo que le gustaría lograr.

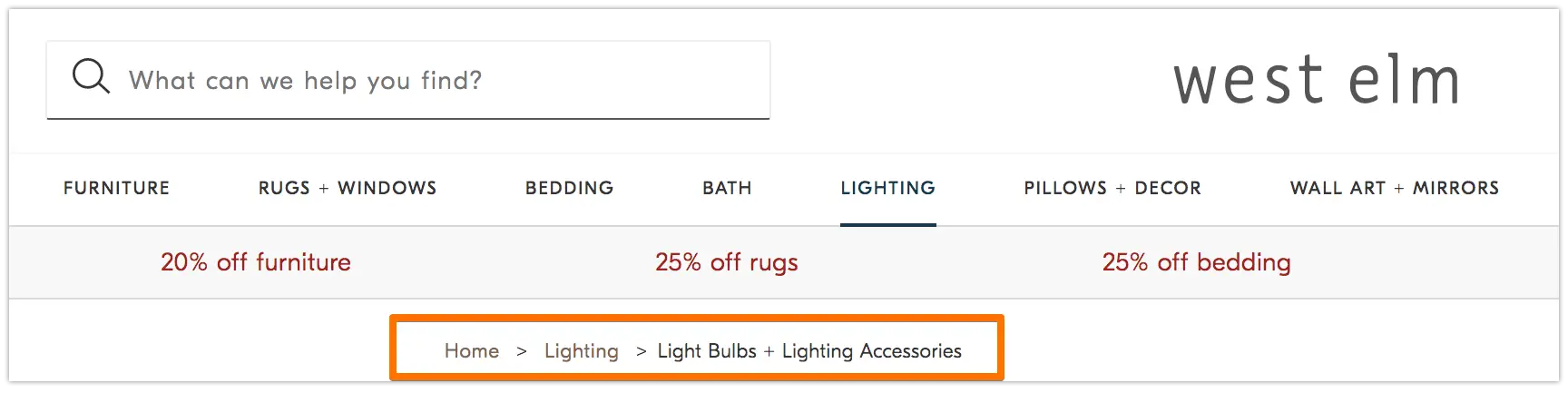

6. Agregue menús de migas de pan.

¿Recuerdas la vieja fábulaHansel y Gretelen la que dos niños tiraban migas de pan al suelo para encontrar el camino de regreso a casa? Bueno, estaban en algo.

Las migas de pan son exactamente lo que parecen: un rastro que guía a los usuarios al inicio de su viaje en su sitio web. Es un menú de páginas que les dice a los usuarios cómo se relaciona su página actual con el resto del sitio.

Y no son solo para los visitantes del sitio web; los robots de búsqueda también los usan.

Fuente

Las migas de pan deben ser dos cosas: 1) visibles para los usuarios para que puedan navegar fácilmente por sus páginas web sin usar el botónAtrás, y 2) tener un lenguaje de marcado estructurado para brindar un contexto preciso a los robots de búsqueda que rastrean su sitio.

¿No está seguro de cómo agregar datos estructurados a sus migas de pan? Utilice esta guía para BreadcrumbList .

7. Usa la paginación.

¿Recuerdas cuando los profesores te pedían que numeraras las páginas de tu trabajo de investigación? Eso se llama paginación. En el mundo del SEO técnico, la paginación tiene un papel ligeramente diferente, pero aún puedes pensar en ella como una forma de organización.

La paginación usa código para indicar a los motores de búsqueda cuándo las páginas con distintas URL están relacionadas entre sí. Por ejemplo, puede tener una serie de contenido que divide en capítulos o en varias páginas web. Si desea facilitar que los robots de búsqueda descubran y rastreen estas páginas, entonces utilizará la paginación.

La forma en que funciona es bastante simple. Irá al<head>de la página uno de la serie y usará

rel=”siguiente”para decirle al robot de búsqueda qué página rastrear en segundo lugar. Luego, en la página dos, usarárel=”prev”para indicar la página anterior yrel=”next”para indicar la página siguiente, y así sucesivamente.

Se parece a esto…

En la página uno:

<enlace rel=“siguiente” href=“https://www.website.com/page-two” />

En la página dos:

<enlace rel=“prev” href=“https://www.website.com/page-one” />

<enlace rel=“siguiente” href=“https://www.sitioweb.com/página-tres” />

Tenga en cuenta que la paginación es útil para el descubrimiento de rastreo, pero Google ya no la admite para indexar páginas por lotes como antes.

8. Verifique sus archivos de registro de SEO.

Puede pensar en los archivos de registro como una entrada de diario. Los servidores web (el diario) registran y almacenan datos de registro sobre cada acción que realizan en su sitio en archivos de registro (el diario). Los datos registrados incluyen la hora y la fecha de la solicitud, el contenido solicitado y la dirección IP solicitante. También puede identificar el agente de usuario, que es un software de identificación única (como un robot de búsqueda, por ejemplo) que cumple con la solicitud de un usuario.

Pero, ¿qué tiene esto que ver con el SEO?

Bueno, los robots de búsqueda dejan un rastro en forma de archivos de registro cuando rastrean su sitio. Puede determinar si, cuándo y qué se rastreó revisando los archivos de registro y filtrando por el agente de usuario y el motor de búsqueda .

Esta información es útil para usted porque puede determinar cómo se gasta su presupuesto de rastreo y qué barreras para la indexación o el acceso está experimentando un bot. Para acceder a sus archivos de registro, puede preguntarle a un desarrollador o usar un analizador de archivos de registro, como Screaming Frog .

El hecho de que un robot de búsqueda pueda rastrear su sitio no significa necesariamente que pueda indexar todas sus páginas. Echemos un vistazo a la siguiente capa de su auditoría técnica de SEO: la indexabilidad .

Lista de verificación de indexabilidad

A medida que los robots de búsqueda rastrean su sitio web, comienzan a indexar las páginas según su tema y su relevancia para ese tema. Una vez indexada, su página es elegible para clasificarse en los SERP. Aquí hay algunos factores que pueden ayudar a que sus páginas se indexen.

Lista de verificación de indexabilidad

- Desbloquee los robots de búsqueda para que no accedan a las páginas.

- Eliminar contenido duplicado.

- Audita tus redireccionamientos.

- Compruebe la capacidad de respuesta móvil de su sitio.

- Corrige errores de HTTP.

1. Desbloquee los robots de búsqueda para que no accedan a las páginas.

Es probable que se ocupe de este paso cuando aborde la capacidad de rastreo, pero vale la pena mencionarlo aquí. Desea asegurarse de que los bots se envíen a sus páginas preferidas y que puedan acceder a ellas libremente. Tienes algunas herramientas a tu disposición para hacer esto. El probador de robots.txt de Google le dará una lista de páginas que no están permitidas y puede usar la herramienta Inspeccionar de Google Search Console para determinar la causa de las páginas bloqueadas.

2. Eliminar contenido duplicado.

El contenido duplicado confunde a los robots de búsqueda y afecta negativamente su indexabilidad. Recuerde usar URL canónicas para establecer sus páginas preferidas.

3. Audite sus redireccionamientos.

Verifique que todos sus redireccionamientos estén configurados correctamente. Los bucles de redireccionamiento, las URL rotas o, lo que es peor, los redireccionamientos inadecuados pueden causar problemas cuando se indexa su sitio. Para evitar esto, audite todos sus redireccionamientos con regularidad.

4. Compruebe la capacidad de respuesta móvil de su sitio.

Si su sitio web no es compatible con dispositivos móviles en este momento, entonces está muy lejos de donde debe estar. Ya en 2016, Google comenzó a indexar primero los sitios móviles , priorizando la experiencia móvil sobre el escritorio. Hoy, esa indexación está habilitada de forma predeterminada. Para mantenerse al día con esta importante tendencia, puede utilizar la prueba de compatibilidad con dispositivos móviles de Google para verificar dónde necesita mejorar su sitio web.

5. Corrija los errores de HTTP.

HTTP significa Protocolo de transferencia de hipertexto, pero probablemente no le importe eso. Lo que sí le importa es cuándo HTTP devuelve errores a sus usuarios o a los motores de búsqueda, y cómo corregirlos.

Los errores de HTTP pueden impedir el trabajo de los robots de búsqueda al bloquearlos del contenido importante de su sitio. Por lo tanto, es increíblemente importante abordar estos errores de forma rápida y exhaustiva.

Dado que cada error HTTP es único y requiere una resolución específica, la siguiente sección tiene una breve explicación de cada uno, y usará los enlaces proporcionados para obtener más información o cómo resolverlos.

- Los redireccionamientos permanentes 301 se utilizan para enviar tráfico de forma permanente de una URL a otra. Su CMS le permitirá configurar estos redireccionamientos, pero demasiados pueden ralentizar su sitio y degradar su experiencia de usuario, ya que cada redireccionamiento adicional aumenta el tiempo de carga de la página. Apunta a cero cadenas de redireccionamiento, si es posible, ya que demasiadas harán que los motores de búsqueda dejen de rastrear esa página.

- La redirección temporal 302 es una forma de redirigir temporalmente el tráfico de una URL a una página web diferente. Si bien este código de estado enviará automáticamente a los usuarios a la nueva página web, la etiqueta de título, la URL y la descripción en caché seguirán siendo coherentes con la URL de origen. Sin embargo, si la redirección temporal permanece en su lugar el tiempo suficiente, eventualmente se tratará como una redirección permanente y esos elementos pasarán a la URL de destino.

- Los mensajes prohibidos 403 significan que el contenido que un usuario ha solicitado está restringido en función de los permisos de acceso o debido a una mala configuración del servidor.

- Las páginas de error 404 les dicen a los usuarios que la página que han solicitado no existe, ya sea porque se eliminó o porque escribieron la URL incorrecta. Siempre es una buena idea crear páginas 404 que estén en la marca y sean atractivas para mantener a los visitantes en su sitio (haga clic en el enlace de arriba para ver algunos buenos ejemplos).

- 405 Método no permitido significa que el servidor de su sitio web reconoció y aún bloqueó el método de acceso, lo que resultó en un mensaje de error.

- 500 Internal Server Error es un mensaje de error general que significa que su servidor web está experimentando problemas para entregar su sitio a la parte solicitante.

- 502 Bad Gateway Error está relacionado con una falta de comunicación o una respuesta no válida entre los servidores del sitio web.

- 503 Servicio no disponible le dice que si bien su servidor funciona correctamente, no puede cumplir con la solicitud.

- 504 Gateway Timeout significa que un servidor no recibió una respuesta oportuna de su servidor web para acceder a la información solicitada.

Cualquiera que sea el motivo de estos errores, es importante abordarlos para mantener contentos tanto a los usuarios como a los motores de búsqueda, y para que ambos regresen a su sitio.

Incluso si su sitio ha sido rastreado e indexado, los problemas de accesibilidad que bloquean a los usuarios y los bots afectarán su SEO. Dicho esto, debemos pasar a la siguiente etapa de su auditoría técnica de SEO: la capacidad de representación.

Lista de verificación de renderización

Antes de sumergirnos en este tema, es importante tener en cuenta la diferencia entre la accesibilidad SEO y la accesibilidad web . El último gira en torno a hacer que sus páginas web sean fáciles de navegar para usuarios con discapacidades o deficiencias, como ceguera o dislexia, por ejemplo. Muchos elementos de la accesibilidad en línea se superponen con las mejores prácticas de SEO. Sin embargo, una auditoría de accesibilidad de SEO no tiene en cuenta todo lo que debe hacer para que su sitio sea más accesible para los visitantes discapacitados.

En esta sección, nos centraremos en la accesibilidad SEO, o la representación, pero tenga en cuenta la accesibilidad web a medida que desarrolla y mantiene su sitio.

Lista de verificación de renderización

Un sitio accesible se basa en la facilidad de representación. A continuación, se encuentran los elementos del sitio web que debe revisar para su auditoría de renderización.

Rendimiento del servidor

Como aprendió anteriormente, los tiempos de espera y los errores del servidor causarán errores HTTP que dificultarán el acceso de los usuarios y bots a su sitio. Si nota que su servidor está experimentando problemas, use los recursos proporcionados anteriormente para solucionarlos y resolverlos. Si no lo hace de manera oportuna, los motores de búsqueda pueden eliminar su página web de su índice, ya que es una mala experiencia mostrar una página rota a un usuario.

Estado HTTP

Similar al rendimiento del servidor, los errores HTTP impedirán el acceso a sus páginas web. Puede usar un rastreador web, como Screaming Frog , Botify o DeepCrawl para realizar una auditoría de errores completa de su sitio.

Tiempo de carga y tamaño de página

Si tu página tarda demasiado en cargarse, la tasa de rebote no es el único problema del que debes preocuparte. Una demora en el tiempo de carga de la página puede resultar en un error del servidor que bloqueará a los bots de sus páginas web o hará que rastreen versiones parcialmente cargadas a las que les faltan secciones importantes de contenido. Dependiendo de cuánta demanda de rastreo haya para un recurso determinado, los bots gastarán una cantidad equivalente de recursos para intentar cargar, procesar e indexar páginas. Sin embargo, debe hacer todo lo que esté bajo su control para disminuir el tiempo de carga de su página.

Representación de JavaScript

Es cierto que Google tiene dificultades para procesar JavaScript (JS) y, por lo tanto, recomienda emplear contenido renderizado previamente para mejorar la accesibilidad. Google también tiene una gran cantidad de recursos para ayudarlo a comprender cómo los robots de búsqueda acceden a JS en su sitio y cómo mejorar los problemas relacionados con la búsqueda.

Páginas huérfanas

Cada página de su sitio debe estar vinculadaal menosa otra página, preferiblemente a más, según la importancia de la página. Cuando una página no tiene enlaces internos, se llama página huérfana. Como un artículo sin introducción, estas páginas carecen del contexto que los bots necesitan para comprender cómo deben indexarse.

Profundidad de página

La profundidad de la página se refiere a cuántas capas hacia abajo existe en una página en la estructura de su sitio, es decir, a cuántos clics se encuentra de su página de inicio. Lo mejor es mantener la arquitectura de su sitio lo más superficial posible y al mismo tiempo mantener una jerarquía intuitiva. A veces, un sitio de varias capas es inevitable; en ese caso, querrá priorizar un sitio bien organizado sobre la superficialidad.

Independientemente de cuántas capas haya en la estructura de su sitio, mantenga las páginas importantes, como su producto y las páginas de contacto, con una profundidad máxima de tres clics. Una estructura que entierra la página de su producto tan profundamente en su sitio que los usuarios y los bots necesitan jugar a los detectives para encontrarlos son menos accesibles y brindan una experiencia deficiente

Por ejemplo, una URL de sitio web como esta que guía a su público objetivo a la página de su producto es un ejemplo de una estructura de sitio mal planificada: www.yourwebsite.com/products-features/features-by-industry/airlines-case-studies/airlines -productos.

Cadenas de redirección

Cuando decide redirigir el tráfico de una página a otra, está pagando un precio. Ese precio es la eficiencia de rastreo. Los redireccionamientos pueden ralentizar el rastreo, reducir el tiempo de carga de la página y hacer que su sitio sea inaccesible si esos redireccionamientos no están configurados correctamente. Por todas estas razones, trate de mantener las redirecciones al mínimo.

Una vez que haya abordado los problemas de accesibilidad, puede pasar a la clasificación de sus páginas en los SERP.

Lista de verificación de clasificación

Ahora pasamos a los elementos más tópicos que probablemente ya conozca: cómo mejorar la clasificación desde un punto de vista técnico de SEO. Lograr que sus páginas se clasifiquen implica algunos de los elementos dentro y fuera de la página que mencionamos antes, pero desde una perspectiva técnica.

Recuerde que todos estos elementos trabajan juntos para crear un sitio compatible con SEO. Por lo tanto, sería negligente dejar de lado todos los factores contribuyentes. Sumerjámonos en ello.

Enlace interno y externo

Los enlaces ayudan a los robots de búsqueda a comprender dónde encaja una página en el gran esquema de una consulta y brindan contexto sobre cómo clasificar esa página. Los enlaces guían a los robots de búsqueda (y a los usuarios) al contenido relacionado y la importancia de la página de transferencia. En general, la vinculación mejora el rastreo, la indexación y su capacidad para clasificar.

Calidad del vínculo de retroceso

Los vínculos de retroceso ( vínculos de otros sitios al suyo) brindan un voto de confianza para su sitio. Le dicen a los robots de búsqueda que el sitio web externo A cree que su página es de alta calidad y vale la pena rastrearla. A medida que se acumulan estos votos, los robots de búsqueda notan y tratan su sitio como más creíble. Suena como una gran oferta, ¿verdad? Sin embargo, como con la mayoría de las grandes cosas, hay una advertencia. La calidad de esos backlinks importa mucho.

Los enlaces de sitios de baja calidad en realidad pueden dañar su clasificación. Hay muchas maneras de obtener vínculos de retroceso de calidad a su sitio, como llegar a publicaciones relevantes, reclamar menciones no vinculadas, proporcionar publicaciones relevantes, reclamar menciones no vinculadas y proporcionar contenido útil al que otros sitios deseen vincularse.

Clústeres de contenido

En HubSpot no hemos sido tímidos acerca de nuestro amor por los grupos de contenido o cómo contribuyen al crecimiento orgánico . Los grupos de contenido vinculan contenido relacionado para que los robots de búsqueda puedan encontrar, rastrear e indexar fácilmente todas las páginas que posee sobre un tema en particular. Actúan como una herramienta de autopromoción para mostrar a los motores de búsqueda cuánto sabe sobre un tema, por lo que es más probable que clasifiquen su sitio como una autoridad para cualquier consulta de búsqueda relacionada.

Su clasificación es el principal determinante en el crecimiento del tráfico orgánico porque los estudios muestran que es más probable que los buscadores hagan clic en los tres primeros resultados de búsqueda en SERP. Pero, ¿cómo te aseguras de queel tuyosea el resultado en el que se haga clic?

Completemos esto con la pieza final de la pirámide de tráfico orgánico: la posibilidad de hacer clic.

Lista de verificación de capacidad de clic

Si bien la tasa de clics (CTR) tiene mucho que ver con el comportamiento del buscador, hay cosasquepuede hacer para mejorar su capacidad de clic en los SERP. Si bien las metadescripciones y los títulos de página con palabras clave afectan el CTR, nos centraremos en los elementos técnicos porque es por eso que estás aquí.

Lista de verificación de capacidad de clic

- Usa datos estructurados.

- Gana funciones SERP.

- Optimizar para fragmentos destacados.

- Considere Google Discover.

La clasificación y la tasa de clics van de la mano porque, seamos honestos, los buscadores quieren respuestas inmediatas. Cuanto más se destaque su resultado en el SERP, más probabilidades tendrá de obtener el clic. Repasemos algunas formas de mejorar la capacidad de hacer clic.

1. Usa datos estructurados.

Los datos estructurados emplean un vocabulario específico llamado esquema para categorizar y etiquetar elementos en su página web para los robots de búsqueda. El esquema deja muy claro qué es cada elemento, cómo se relaciona con su sitio y cómo interpretarlo. Básicamente, los datos estructurados le dicen a los bots: "Esto es un video", "Esto es un producto" o "Esta es una receta", sin dejar espacio para la interpretación .

To be clear, using structured data is not a “clickability factor” (if there even is such a thing), but it does help organize your content in a way that makes it easy for search bots to understand, index, and potentially rank your pages.

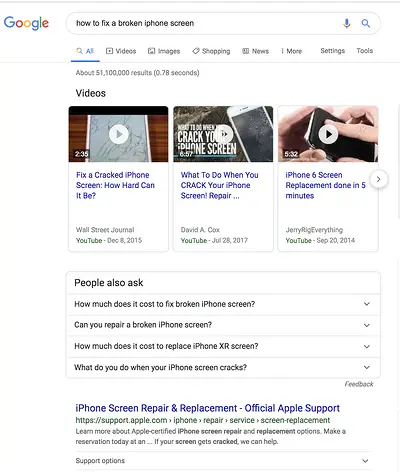

2. Win SERP features.

SERP features , otherwise known as rich results, are a double-edged sword. If you win themandget the click-through, you're golden. If not, your organic results are pushed down the page beneath sponsored ads, text answer boxes, video carousels, and the like.

Rich results are those elements that don't follow the page title, URL, meta description format of other search results. For example, the image below shows two SERP features — a video carousel and “People Also Ask” box — above the first organic result.

While you can still get clicks from appearing in the top organic results, your chances are greatly improved with rich results.

How do you increase your chances of earning rich results? Write useful content and use structured data. The easier it is for search bots to understand the elements of your site, the better your chances of getting a rich result.

Structured data is useful for getting these ( and other search gallery elements ) from your site to the top of the SERPs, thereby, increasing the probability of a click-through:

- Articles

- Videos

- Reseñas

- Events

- How-Tos

- FAQs (“People Also Ask” boxes)

- Images

- Local Business Listings

- Products

- Sitelinks

3. Optimize for Featured Snippets.

One unicorn SERP feature that has nothing to do with schema markup is Featured Snippets, those boxes above the search results that provide concise answers to search queries.

Featured Snippets are intended to get searchers the answers to their queries as quickly as possible. According to Google , providing the best answer to the searcher's query is the only way to win a snippet. However, HubSpot's research revealed a few additional ways to optimize your content for featured snippets .

4. Consider Google Discover.

Google Discover is a relatively new algorithmic listing of content by category specifically for mobile users. It's no secret that Google has been doubling down on the mobile experience; with over 50% of searches coming from mobile , it's no surprise either. The tool allows users to build a library of content by selecting categories of interest (think: gardening, music, or politics).

At HubSpot, we believe topic clustering can increase the likelihood of Google Discover inclusion and are actively monitoring our Google Discover traffic in Google Search Console to determine the validity of that hypothesis. We recommend that you also invest some time in researching this new feature. The payoff is a highly engaged user base that has basically hand-selected the content you've worked hard to create.

The Perfect Trio

Technical SEO, on-page SEO, and off-page SEO work together to unlock the door to organic traffic. While on-page and off-page techniques are often the first to be deployed, technical SEO plays a critical role in getting your site to the top of the search results and your content in front of your ideal audience. Use these technical tactics to round out your SEO strategy and watch the results unfold.