WordPress robots.txt

Publicado: 2019-02-26El archivo robots.txt de WordPress es muy importante para el SEO. Para asegurarse de que su sitio esté bien posicionado en los resultados de los motores de búsqueda, debe hacer que sus páginas más importantes sean convenientes para buscar e indexar los "robots" ("bots") de los motores de búsqueda. Un archivo robots.txt bien estructurado ayudará a dirigir estos bots a las páginas que desea indexar.

En este artículo vamos a revelar tales preguntas:

- ¿Qué es un archivo robots.txt y por qué es importante?

- Ubicación del texto de los robots de WordPress

- El mejor texto de robots para WordPress

- Cómo crear un archivo robots.txt

- Cómo comprobar el archivo robots.txt y enviarlo a la consola de búsqueda de Google.

¿Qué es un archivo robots.txt para WordPress y por qué es importante?

Cuando creas un nuevo sitio web, los motores de búsqueda enviarán sus robots para escanear y crear un mapa de todas sus páginas. De esta forma, sabrán qué páginas mostrar como resultado cuando alguien busque palabras clave relevantes. En un nivel básico, esto es bastante simple (también, consulte esta publicación útil: archivo .htaccess predeterminado de WordPress).

El problema es que los sitios web modernos contienen muchos otros elementos además de las páginas. WordPress le permite instalar, por ejemplo, complementos que a menudo tienen sus propios directorios. No hay necesidad de mostrar esto en los resultados de búsqueda, ya que no coinciden con el contenido.

Lo que hace el archivo robots.txt es proporcionar un conjunto de pautas para los robots de búsqueda. Les dice: “¡Miren aquí e indexen estas páginas, pero no entren a otras áreas!”. Este archivo puede ser tan detallado como quieras y es muy fácil de crear, incluso si eres principiante.

En la práctica, los motores de búsqueda aún escanearán su sitio, incluso si no crea un archivo robots.txt. Sin embargo, no crearlo es un paso muy irracional. Sin este archivo, deja que los robots indexen todo el contenido de su sitio y deciden que necesita mostrar todas las partes de su sitio, incluso aquellas que le gustaría ocultar del acceso público (también, verifique los mejores complementos de comercio electrónico de WordPress) ).

Un punto más importante, sin un archivo robots.txt, su sitio web tendrá muchas visitas de robots de su sitio. Esto afectará negativamente a su rendimiento. Incluso si la asistencia de su sitio aún es pequeña, la velocidad de carga de la página es algo que siempre debe tener prioridad y al más alto nivel. Al final, solo hay algunas cosas que a la gente no le gustan más que cargar sitios web lentamente.

Ubicación del texto de los robots de WordPress

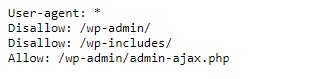

Cuando crea un sitio web de WordPress, se crea automáticamente un archivo robots.txt y se ubica en su directorio principal en el servidor. Por ejemplo, si su sitio se encuentra aquí: wpdevart.com, puede encontrarlo en wpdevart.com/robots.txt y ver algo como esto:

Este es un ejemplo del archivo robots.txt más simple. Traduciendo a un lenguaje legible por humanos, el lado derecho después del agente de usuario: declara

para qué robots son las reglas. Un asterisco significa que la regla es universal y se aplica a todos los robots. En este caso, el archivo le dice a los robots que no pueden escanear los directorios wp-admin y wp-includes. El significado de estas reglas es que estos directorios contienen una gran cantidad de archivos que requieren protección contra el acceso público (también, consulte nuestro complemento WordPress Countdown).

Por supuesto, puede agregar más reglas a su archivo. Antes de hacer esto, debe comprender que se trata de un archivo virtual. Por lo general, WordPress robots.txt se encuentra en el directorio raíz, que a menudo se llama public_html o www (o por el nombre de su sitio web):

Cabe señalar que el archivo robots.txt para WordPress, creado por defecto, no es accesible desde ningún directorio. Funciona, pero si desea realizar cambios, debe crear su propio archivo y cargarlo en el directorio raíz.

Veremos varias formas de crear un archivo robots.txt para WordPress. Ahora analicemos cómo determinar qué reglas incluir en el archivo.

El mejor texto de robots para WordPress

No es tan difícil crear el mejor archivo de texto de robots para su sitio web de WordPress. Entonces, ¿qué reglas deben incluirse en el archivo robots.txt? En la sección anterior, vimos un ejemplo de un archivo robots.txt generado por WordPress. Incluye solo dos reglas breves, pero para la mayoría de los sitios son suficientes. Echemos un vistazo a dos archivos robots.txt diferentes y veamos qué hace cada uno.

Aquí está nuestro primer ejemplo de un archivo robots.txt de WordPress:

User-agent: * Allow: / # Disallowed Sub-Directories Disallow: / payout / Disallow: / photos / Disallow: / forums /Este archivo robots.txt se crea para el foro. Los motores de búsqueda suelen indexar todos los hilos del foro. Según el tema de su foro, es posible que desee no permitir la indexación. Por ejemplo, Google no indexará cientos de discusiones breves de usuarios. También puede establecer reglas que apunten a un hilo específico del foro para excluirlo y permitir que los motores de búsqueda indexen el resto.

También observa una línea que comienza con Permitir: / en la parte superior del archivo. Esta línea le dice a los robots que pueden escanear todas las páginas de su sitio, excepto las restricciones establecidas a continuación. También notó que configuramos estas reglas para que sean universales (con un asterisco), como estaba en el archivo virtual robots.txt de WordPress (también puede consultar nuestro complemento de tabla de precios de WordPress).

Veamos otro archivo robots.txt de WordPress de muestra:

User-agent: * Disallow: / wp-admin / Disallow: / wp-includes / User-agent: Bingbot Disallow: /En este archivo establecemos las mismas reglas que van a WordPress por defecto. Aunque también estamos agregando un nuevo conjunto de reglas que impiden que los robots de búsqueda de Bing rastreen nuestro sitio. Bingbot, como puedes ver, es el nombre del robot.

Puede escribir otros nombres de motores de búsqueda para restringir/permitir su acceso también. En la práctica, por supuesto, Bingbot es muy bueno (aunque no tan bueno como Googlebot). Sin embargo, hay muchos robots maliciosos.

La mala noticia es que no siempre siguen las instrucciones del archivo robots.txt (todavía funcionan como terroristas). Debe tenerse en cuenta que, aunque la mayoría de los robots utilizarán las instrucciones proporcionadas en este archivo, no puede obligarlos a hacerlo.

Si profundiza en el tema, encontrará muchas sugerencias sobre qué permitir y qué bloquear en su sitio de WordPress. Aunque, según nuestra experiencia, menos reglas suelen ser mejores. Aquí hay un ejemplo de la

mejores robots txt para el sitio web de WordPress, pero para diferentes sitios web puede ser diferente:

User-agent: * Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Disallow: *utm*= Disallow: *openstat= Allow: */uploads Sitemap: https://wpdevart.com/sitemap.xmlTradicionalmente, a WordPress le gusta cerrar los directorios wp-admin y wp-includes. Sin embargo, esta ya no es la mejor solución. Además, si agrega etiquetas meta para sus imágenes con fines de promoción (SEO), no tiene sentido decirles a los robots que no indexen el contenido de estos directorios.

Lo que debe contener su archivo robots.txt dependerá de las necesidades de su sitio. ¡Así que siéntete libre de investigar más!

Cómo crear un archivo robots.txt

¿Qué podría ser más simple que crear un archivo de texto (txt). Todo lo que tienes que hacer es abrir tu editor favorito (como Notepad o TextEdit) e ingresar algunas líneas. Luego guarda el archivo usando robots y la extensión txt (robots.txt). Tomará unos segundos, por lo que es posible que desee crear un archivo robots.txt para WordPress sin usar un complemento.

Guardamos este archivo localmente en la computadora. Una vez que haya creado su propio archivo, debe conectarse a su sitio a través de FTP (tal vez con FileZilla).

Después de conectarse a su sitio, vaya al directorio public_html. Ahora, todo lo que necesita hacer es cargar el archivo robots.txt desde su computadora al servidor. Puede hacer esto haciendo clic con el botón derecho del mouse en el archivo en el navegador FTP local o simplemente arrastrándolo con el mouse.

Solo toma unos segundos. Como puede ver, este método es más fácil que usar el complemento.

Cómo comprobar el archivo robots.txt de WordPress y enviarlo a Google Search Console

Después de crear y cargar su archivo robots.txt de WordPress, puede verificar si hay errores en Google Search Console. Search Console es un conjunto de herramientas de Google diseñado para ayudarlo a realizar un seguimiento de cómo aparece su contenido en los resultados de búsqueda. Una de estas herramientas verifica robots.txt, lo encontrará fácilmente en la página de administración de herramientas para webmasters de Google (también, consulte Los 50 mejores complementos de WordPress 2020).

Allí encontrará el campo del editor donde puede agregar el código para su archivo robots.txt de WordPress y haga clic en Enviar en la esquina inferior derecha. La consola de búsqueda de Google le preguntará si desea utilizar el nuevo código o descargar un archivo de su sitio web.

Ahora la plataforma revisará su archivo en busca de errores. Si se encuentra un error, se le mostrará información al respecto. Viste algunos ejemplos del archivo robots.txt de WordPress, ¡y ahora tienes aún más posibilidades de crear tu archivo robots.txt perfecto!