Guide étape par étape pour installer LLM Open Source dans votre environnement local – sans Internet

Publié: 2023-12-20Résumé

Dans le monde en évolution rapide de l’IA, l’installation d’un grand modèle linguistique (LLM) tel que FALCON au sein d’un système local présente un ensemble unique de défis et d’opportunités. Ce guide est conçu pour vous guider à travers les étapes critiques de la configuration de FALCON Open-Source LLM, en se concentrant sur l'obtention de performances optimales tout en maintenant une confidentialité et une sécurité strictes des données.

Embarquez pour le déploiement local de FALCON, un grand modèle de langage open source (LLM) de premier plan, garantissant des performances optimales et une sécurité robuste. Ce guide complet couvre les prérequis matériels, l'installation des logiciels et la formation sur les données tout en soulignant l'importance des tests réguliers, de la maintenance, des considérations d'évolutivité et de l'analyse des coûts. Pour une perspective plus large, restez informé des 5 meilleurs LLM open source et envisagez de tirer parti de l'expertise de Creole Studios pour une mise en œuvre sécurisée, vous permettant d'exploiter la puissance de l'IA tout en maintenant des normes strictes de confidentialité des données.

Comprendre l'exigence

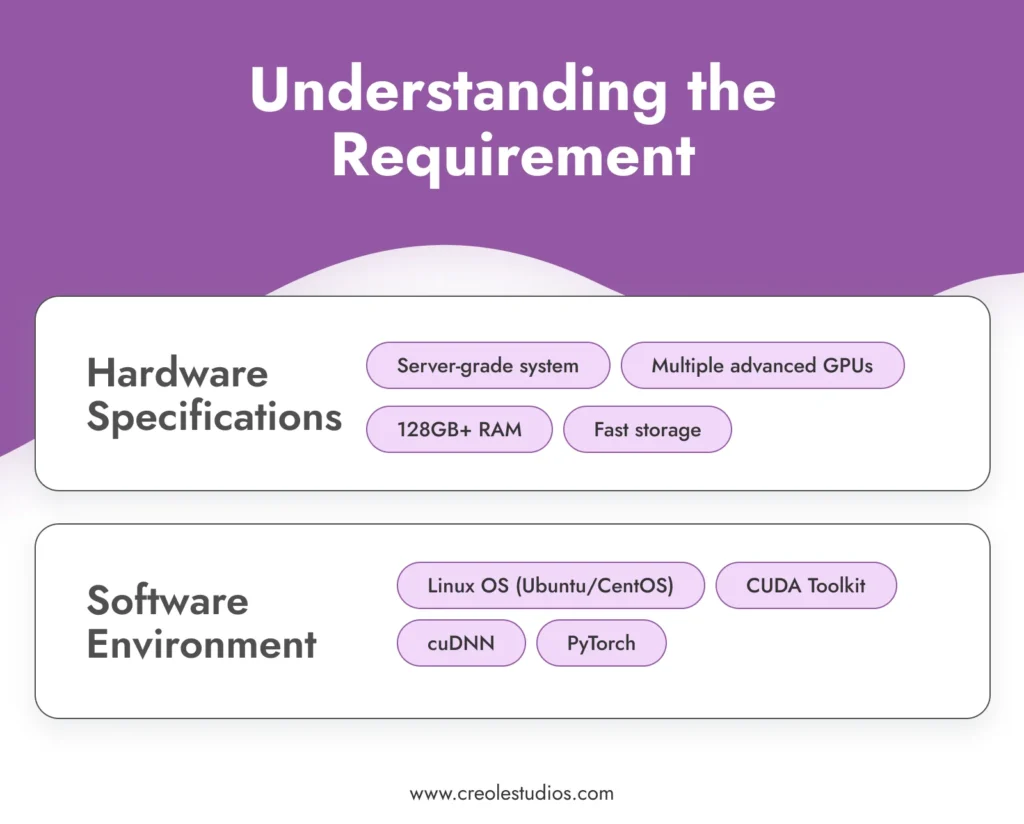

Avant de plonger dans le processus d'installation, il est crucial de comprendre les exigences requises pour faire fonctionner un modèle sophistiqué comme FALCON .

- Spécifications matérielles : FALCON, avec ses 180 milliards de paramètres, nécessite des ressources de calcul importantes. Cela nécessite un environnement informatique haute performance, impliquant généralement des systèmes de niveau serveur équipés de plusieurs GPU avancés (par exemple, NVIDIA A100), d'une RAM importante (128 Go ou plus) et de solutions de stockage à haut débit (SSD ou NVMe) pour gérer le modèle. et les données de manière efficace. Vous pouvez vous référer aux directives de NVIDIA pour la configuration des environnements IA et ML.

- Environnement logiciel : L'exécution efficace de FALCON nécessite un environnement logiciel stable et compatible. Un système d'exploitation basé sur Linux comme Ubuntu ou CentOS est recommandé pour son excellente prise en charge GPU et sa compatibilité avec les outils et bibliothèques essentiels. La pile logicielle comprend le CUDA Toolkit pour l'accélération GPU, cuDNN pour les réseaux neuronaux profonds et des frameworks d'apprentissage automatique comme PyTorch.

Acquérir le modèle

La prochaine étape consiste à acquérir le modèle FALCON. Cela peut impliquer :

- Licence de modèle : vérifiez les dernières disponibilités et options de licence pour FALCON. L'obtention d'une licence pour un modèle comme FALCON implique généralement des négociations et des accords, garantissant que vous avez le droit légal d'utiliser le modèle. Gardez un œil sur le référentiel officiel FALCON ou sur les marchés de modèles d'IA associés pour les mises à jour et les détails des licences.

- Transfert de modèle : étant donné la nature de la configuration, le transfert du modèle dans votre environnement local est une étape critique. Cela peut impliquer le transfert physique du modèle à l’aide de périphériques de stockage sécurisés et cryptés. L'intégrité et la sécurité du modèle lors de ce transfert sont primordiales.

Configurer l'infrastructure

La mise en place d'une infrastructure robuste est essentielle au fonctionnement efficace de FALCON LLM :

- Configuration du serveur : optimisez vos serveurs pour les charges de travail d'IA de haute intensité. Cela inclut la configuration de plusieurs GPU pour un traitement parallèle, la garantie d'une mise en réseau à large bande passante au sein du système et la mise en œuvre de solutions de refroidissement efficaces pour gérer la production de chaleur.

- Gestion du stockage : compte tenu de la taille de FALCON et des ensembles de données potentiellement volumineux avec lesquels vous travaillerez, planifiez soigneusement votre architecture de stockage. Les disques SSD ou NVMe haute capacité sont recommandés pour leur vitesse. Assurez-vous de disposer de systèmes de redondance et de sauvegarde.

- Alimentation et refroidissement : Ces serveurs puissants nécessiteront une alimentation électrique et des systèmes de refroidissement adéquats. Assurez-vous que votre infrastructure peut répondre à ces exigences. Il est conseillé de consulter des spécialistes du matériel pour concevoir un centre de données capable de supporter cette configuration.

Installez le logiciel requis

L'installation du logiciel est une étape critique dans la mise en place de votre LLM open source :

- Configuration du système d'exploitation : installez la distribution Linux de votre choix. Ubuntu et CentOS sont des choix populaires pour leur stabilité et leur prise en charge. Assurez-vous que le système d’exploitation est configuré pour utiliser de manière optimale les ressources matérielles.

- Installation des dépendances : installez CUDA Toolkit pour la prise en charge GPU, cuDNN pour les capacités d'apprentissage en profondeur et PyTorch comme cadre d'apprentissage automatique. Assurez-vous d'utiliser des versions compatibles avec le modèle FALCON.

- Logiciel de sécurité : dans un environnement isolé, la sécurité interne est essentielle. Installez des systèmes robustes de pare-feu et de détection d’intrusion. Même si le système est isolé, des menaces internes ou des violations accidentelles peuvent survenir.

Installation du modèle

L'installation du modèle FALCON se déroule en plusieurs étapes :

- Transfert de modèle : transférez en toute sécurité les fichiers de modèle sur votre système local à l'aide de périphériques de stockage cryptés.

- Processus d'installation : Suivez le guide d'installation fourni par FALCON. Cela implique généralement la configuration des variables d'environnement, le chargement des fichiers de modèle et la configuration des paramètres du modèle.

- Vérification : Post-installation, vérifiez l'intégrité de l'installation. Assurez-vous que les fichiers du modèle sont intacts et que le modèle exécute correctement les diagnostics initiaux.

Sécurité et conformité des données

Assurer la sécurité des données dans un environnement hermétique implique plusieurs niveaux de protection :

- Chiffrement : toutes les données, au repos et en transit au sein du réseau, doivent être cryptées. Mettez en œuvre des protocoles de cryptage forts pour protéger vos données.

- Conformité : Adhérer aux réglementations pertinentes en matière de protection des données et aux normes de l'industrie. Auditez régulièrement la conformité de vos systèmes.

- Contrôle d'accès : mettez en œuvre des politiques strictes de contrôle d'accès. Seul le personnel autorisé doit avoir accès au modèle et aux données.

Entraîner le modèle avec des données organisées

Pour adapter FALCON à vos besoins spécifiques, il est essentiel de le former avec des données organisées .

- Collecte et préparation des données : rassemblez des données pertinentes pour votre cas d'utilisation. Ces données doivent être représentatives, diversifiées et de haute qualité. Prétraitez et nettoyez les données pour vous assurer qu’elles conviennent à la formation.

- Processus de formation : configurez les paramètres de formation de FALCON pour les aligner sur vos objectifs. Former un modèle comme FALCON nécessite une compréhension approfondie des principes d'apprentissage automatique et des spécificités de l'architecture du modèle.

- Surveillance et ajustement : Surveillez en permanence le processus de formation pour en vérifier les performances et la précision. Soyez prêt à ajuster les données ou les paramètres d’entraînement si nécessaire pour obtenir les résultats souhaités.

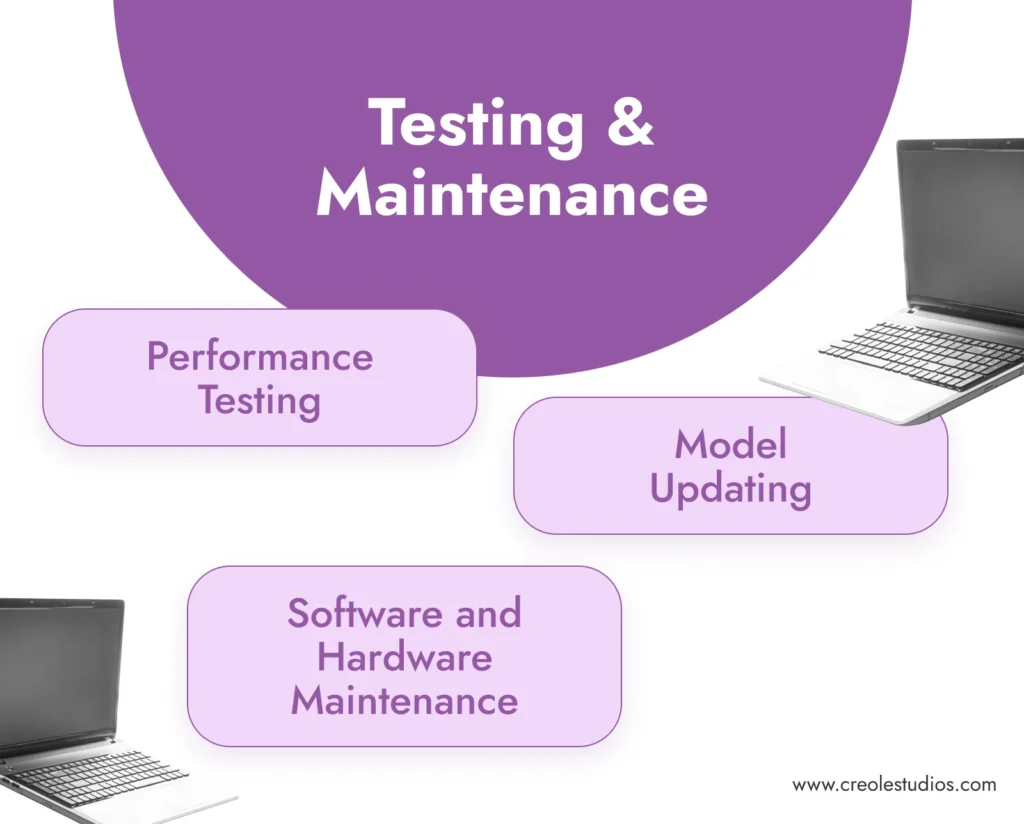

Tests et maintenance

Des tests et une maintenance réguliers sont essentiels au succès à long terme du modèle .

- Tests de performances : testez régulièrement la précision et l’efficacité du modèle. Cela implique d'exécuter des ensembles de données de validation et de vérifier la cohérence et la qualité des résultats du modèle.

- Maintenance logicielle et matérielle : Mettre à jour et corriger régulièrement l'environnement logiciel. Entretenez le matériel pour garantir son fonctionnement efficace, notamment en gérant les systèmes de refroidissement, en vérifiant les alimentations électriques et en remplaçant tout composant défaillant.

- Mise à jour du modèle : Tenez-vous au courant des mises à jour du modèle FALCON. Dans un environnement isolé, la mise à jour du modèle peut nécessiter le transfert manuel des fichiers de modèle mis à jour.

Évolutivité et coût

Tenez compte de la croissance future et des implications financières de votre configuration .

- Planification de l'évolutivité : planifiez la mise à l'échelle potentielle de votre infrastructure. Cela peut inclure l’ajout de GPU supplémentaires, l’extension du stockage ou l’amélioration des capacités du réseau dans un environnement isolé.

- Analyse des coûts : examinez régulièrement les coûts impliqués dans la maintenance et le fonctionnement de FALCON. Cela comprend les coûts du matériel, la consommation d'énergie et les frais de licence.

Notes finales : l'importance des LLM Open-SOurce et de l'expertise des studios créoles

L'installation locale de LLM open source comme FALCON offre des avantages significatifs, notamment une confidentialité des données, une personnalisation et un contrôle sans précédent sur vos capacités d'IA. Il permet aux entreprises de tirer parti de la puissance de l’IA tout en garantissant que les données sensibles restent dans les limites de leur réseau privé et sécurisé.

Creole Studios excelle dans l'assistance aux clients dans le processus complexe de mise en place et de maintenance de LLM open source dans des environnements locaux et isolés. Notre expertise garantit une mise en œuvre fluide, sécurisée et efficace, permettant aux entreprises d’exploiter tout le potentiel de l’IA tout en maintenant les normes les plus élevées en matière de confidentialité et de sécurité des données. Avec notre soutien, les entreprises peuvent relever en toute confiance les défis de la mise en œuvre de l’IA et garder une longueur d’avance dans un paysage technologique en évolution rapide.