Kafka : un excellent choix pour les courtiers en messages dans les microservices

Publié: 2022-11-19Kafka est une plateforme de streaming distribuée. Il est souvent utilisé pour l'agrégation de journaux, le traitement de flux en temps réel et la recherche d'événements. Récemment, Kafka a gagné en popularité en tant que courtier de messages pour les microservices. Kafka n'est pas une file d'attente de messages traditionnelle comme ActiveMQ ou RabbitMQ. Il n'a pas de serveur central qui stocke tous les messages. Au lieu de cela, il utilise un modèle de publication-abonnement. Les messages sont stockés dans des rubriques, et chaque rubrique peut avoir plusieurs partitions. Kafka est hautement disponible et évolutif. Il peut gérer des milliards de messages par jour. Kafka est également très rapide. Il peut traiter les messages en temps réel. Kafka est un excellent choix pour créer un courtier de messages pour les microservices. Il est hautement disponible, évolutif et rapide.

Kafka, qui est un système de messagerie en temps réel, rend cela possible. Les flux de données sont protégés contre les interférences et peuvent être distribués ou tolérants aux pannes. Le bus d'intégration de données Kafka est un protocole d'échange de données qui permet à un large éventail de producteurs et de consommateurs de partager des données. Les capacités de Kafka sont similaires à celles de MongoDB et RDS, qui servent de tampon de données à la fin de votre application.

KSQL, un langage de script basé sur SQL, est utilisé pour analyser et traiter des données de streaming en temps réel dans Apache Kafka . KSQL inclut un cadre interactif pour le traitement de flux, qui est destiné à vous permettre d'effectuer des activités de traitement de flux telles que l'agrégation de données, le filtrage, la jointure, la mise en session, le fenêtrage, etc.

C'est plus qu'un excellent courtier de messages, comme l'a démontré Apache Kafka. L'implémentation de la structure comporte un certain nombre de fonctionnalités de type base de données qui la rendent adaptée à une utilisation dans une base de données. Par conséquent, il sert désormais d'enregistrement des événements commerciaux plutôt que de s'appuyer sur des bases de données relationnelles.

L' application Kafka permet d'économiser du temps et de l'énergie en diffusant les données de MongoDB de manière simple et efficace. MongoDB est nécessaire pour que les entreprises publient de grandes quantités de données à d'autres abonnés et gèrent plusieurs flux de données. Le service Kafka MongoDB Connection permet aux développeurs de créer plusieurs flux asynchrones avec MongoDB, qui est un outil industriel populaire.

Dans une base de données, Apache Kafka sert de modèle. Des centaines d'entreprises l'utilisent pour fournir des garanties ACID et effectuer des tâches critiques. Dans la plupart des cas, cependant, Kafka n'est pas aussi compétitif que les autres bases de données.

Quel type de base de données est Kafka ?

Kafka est un type de base de données utilisé pour stocker et récupérer des messages. Il s'agit d'un système distribué conçu pour être évolutif et tolérant aux pannes.

Il s'agit d'une plate-forme de traitement de flux open source écrite en Scala et Java qui fait partie du projet Kafka de l'Apache Software Foundation. Un flux en informatique est une collection d'éléments d'information qui sont rendus disponibles au fil du temps. Les flux peuvent être définis comme des éléments d'un tapis roulant traités un par un. Les flux, dans leur forme la plus élémentaire, peuvent être une série d'événements apparemment sans rapport. Les concepts de sourçage d'événements diffèrent des concepts d'entreposage de données et d'analyse de données auxquels les développeurs sont habitués. Comment utiliser Kafka comme base de données ? Blue est l'entreprise qui dit oui à l'accord.

Selon Team Red, les programmeurs commettent une énorme erreur lorsqu'ils passent des bases de données conventionnelles à Kafka. Selon Martin Kleppmann, le message de Team Red selon lequel Kafka est pour tout le monde est condescendant. Le problème que Team Red a avec Kafka et les flux est qu'ils ont un problème avec les développeurs qui jettent les RDMS. Lorsqu'un journal permanent des événements est présenté, il aura toujours son contexte historique, ce qui le rend facile à auditer. L'administration de bases de données présente de nombreux avantages, mais c'est aussi l'un de ses aspects les plus difficiles. La base de données traditionnelle fonctionne de deux manières complètement différentes : elle confond les lectures et les écritures. Il est essentiel que les programmeurs maintiennent et synchronisent les données dupliquées sur plusieurs tables.

L'échelle change le motif au fur et à mesure. Les flux se distinguent par une distinction claire entre les préoccupations des lecteurs et des écrivains. Il n'y a aucune relation entre la vitesse à laquelle Kafka écrit dans un fichier et la vitesse à laquelle Elastic Search peut y envoyer des mises à jour. En conséquence, les utilisateurs de Kafka traitent les journaux afin de générer diverses vues matérialisées. Faire en sorte que les vues matérialisées fonctionnent comme un mécanisme de mise en cache pratique nécessite des coûts initiaux. Les vues matérialisées, en plus de stocker leurs propres données et leur mise à l'échelle, sont des composants importants de l'infrastructure. Pour 99% des entreprises, les SGBD sont la meilleure base.

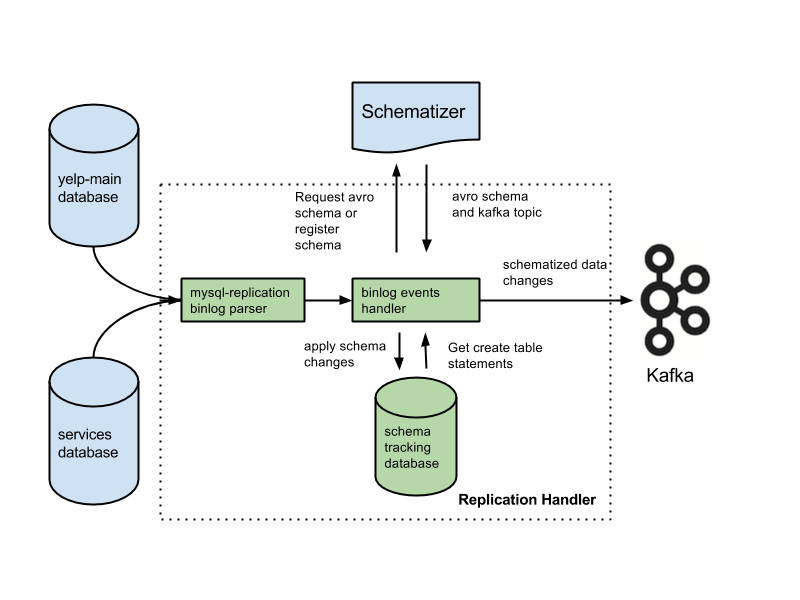

Votre application peut être dans cette catégorie, et vous pouvez avoir droit à une nouvelle architecture basée sur votre parcours. De nombreuses fonctionnalités critiques seront perdues si vous remplacez les bases de données par des journaux. Les fonctionnalités incluent des contraintes de clé étrangère, des transactions atomiques (tout ou rien) et des techniques d'isolation procédurale qui aident à résoudre les problèmes de concurrence. Arjun suppose que l'intégrité de votre application est maintenue à tout moment. Les fonctionnalités de base que la plupart des gens tiennent pour acquises deviennent des responsabilités supplémentaires lorsque vous travaillez sur des flux. Il est essentiel de séparer l'intention de la déclaration écrite. Une configuration courante consiste à utiliser Kafka avec un système de capture de données modifiées.

Selon Team Red, les fonctionnalités d'intégrité des données des bases de données sont essentielles pour assurer le contrôle des données. Les transactions doivent être isolées des bases de données conventionnelles pour être prises en compte. Par conséquent, un seul écrit peut coûter cher. Si votre application a du mal à faire face au volume d'écritures coûteuses, vous pouvez être contraint de migrer vers une base de données plus conventionnelle. Team Red omet de mentionner que l'utilisation d'une base de données devant Kafka réduit ses meilleures fonctionnalités.

Les avantages de cette conception sont importants par rapport aux systèmes de messagerie traditionnels. Le premier avantage de Kafka est qu'il peut gérer un nombre élevé de requêtes. De plus, comme les données ne sont écrites sur le disque qu'en cas de besoin, Kafka peut gérer d'énormes quantités de données.

SQL Server est un outil de base de données qui entre dans la catégorie des outils. Cet appareil portable est polyvalent et fiable, mais il peut parfois être difficile à utiliser. Kafka et Azure sont toutes deux des plates-formes extrêmement performantes, mais Kafka est mis à l'échelle tandis qu'Azure est réduit.

SQL Server est un excellent outil pour les entreprises qui ont besoin de grandes quantités de stockage de données, mais ce n'est peut-être pas le meilleur choix pour ceux qui ont besoin d'une mise à l'échelle rapide ou d'un débit élevé. Pour les entreprises qui doivent traiter de grandes quantités de données sans compromettre les performances, Kafka est un meilleur choix que SQL Server.

Kafka : un système de stockage distribué pour la télémétrie des séries chronologiques

Un système de stockage distribué Kafka, qui utilise un modèle basé sur un sujet, stocke les données. Les données peuvent être stockées dans un modèle thématique d'une base de données Kafka plutôt que dans une base de données relationnelle. Il se comporte de la même manière qu'une file d'attente dans un Kafka Topic , mais pas de la même manière qu'une file d'attente. Il peut stocker un grand nombre de séries chronologiques dans le framework Kafka plutôt que dans une base de données de séries chronologiques.

Quelle est la différence entre Kafka et Mongodb ?

Il s'agit d'un service de journal de validation distribué, partitionné et répliqué basé sur un système distribué. Malgré sa conception unique, il s'agit d'un composant important d'un système de messagerie. MongoDB, quant à lui, est décrit comme "la base de données des idées géantes".

Étant donné que Kafka ne prend pas en charge la mise en file d'attente, vous devez le pirater dans une version grand public du système. Si une base de données relationnelle est requise, un autre outil peut être plus utile. MongoDB est un excellent choix pour diverses raisons, notamment sa facilité d'utilisation et sa flexibilité. Le support utilisateur d'Apache est disponible. Confluent a un Kafka (si prêt à payer) qui a été créé chez Linkedin en même temps que le projet Kafka. Avoir un fournisseur qui effectue des sauvegardes automatiques et dimensionne automatiquement le cluster est extrêmement pratique. Si vous n'avez pas d'administrateur système ou de DBA connaissant MongoDB, c'est une bonne idée de faire appel à un tiers spécialisé dans l'hébergement MongoDB.

Kafka, dans sa forme la plus élémentaire, est destiné à nous permettre de mettre les messages en file d'attente. Le moteur de stockage de Cassandra garantit une écriture en temps constant dans vos données, quelle que soit leur taille. MongoDB fournit une implémentation de carte/réduction personnalisée ainsi qu'une prise en charge native de Hadoop pour l'analyse, contrairement à Cassandra. Peu importe qu'il soit hébergé par vous ou par un autre fournisseur, car le coût est généralement raisonnable.

Kafka contre. Systèmes de base de données traditionnels

Il est important de noter qu'il existe plusieurs différences entre Kafka et un système de base de données traditionnel.

Étant donné que Kafka est une plate-forme de diffusion en continu, elle peut gérer un taux élevé d'ingestion de données sans nécessiter de traitement préalable important.

Les données sont consommées par des lectures de fin plutôt que par des lectures de disque lors de l'exécution de Kafka.

L'utilisation de la mise en cache des pages réduit le besoin de visites aller-retour de la base de données pour Kafka.

Pour envoyer des données en aval aux clients en aval, Kafka utilise la messagerie pub/sub.

Qu'est-ce que la base de données Kafka

Kafka est une base de données souvent utilisée pour stocker des données de streaming. Il s'agit d'un système distribué conçu pour être évolutif et tolérant aux pannes. Kafka est souvent utilisé pour créer des pipelines de données en temps réel et des applications de streaming. Il peut gérer un débit élevé et une faible latence.

Un courtier de messages tel que Kafka a gagné en popularité ces dernières années. Selon les partisans, Kafka est un changement de paradigme dans la gestion des données. Il est essentiel de se rappeler que l'utilisation de Kafka comme magasin de données principal ne vous fournit pas d'isolement. Chaque problème rencontré par les systèmes de base de données sera résolu à l'avenir. Les pirates peuvent voler des données en exploitant les failles des architectures autonomes. Si deux utilisateurs tentent d'acheter le même article en même temps, ils réussiront tous les deux et nous manquerons d'inventaire pour eux deux. Ces architectures, qui utilisent des fonctionnalités de voyage dans le temps lors de l'exécution d'appareils à gaz, s'appuient sur des architectures événementielles.

La gestion de gros volumes de données est une excellente utilisation de Kafka. Les transactions doivent toujours être isolées à l'aide d'un SGBD traditionnel. Utilisez les bases de données OLTP pour le contrôle d'admission, CDC pour la génération d'événements et modélisez les copies en aval au fur et à mesure que les vues apparaissent afin de transformer votre base de données à l'envers.

Kafka peut également être utilisé pour stocker de grandes quantités de données et les traiter au quotidien. La possibilité de traiter le Big Data en mode batch ou streaming est un avantage par rapport aux autres méthodes. Le processus Kafka peut être utilisé pour récupérer des fichiers journaux de plusieurs serveurs et les stocker dans une base de données ou un index de recherche, par exemple. Une API de streaming est également disponible qui peut être utilisée pour traiter les données en temps réel.

Kafka contre Sql

En général, Kafka et MySQL sont classés en deux types : les files d'attente de messages et les applications de base de données. La plupart des développeurs considèrent Kafka comme une solution à haut débit, distribuée et évolutive, tandis que MySQL est considérée comme la plus populaire en raison de sa simplicité, de ses performances et de sa facilité d'utilisation.

La messagerie Pub-Sub sur Kafka est un système distribué, tolérant aux pannes et à haut débit qui peut gérer de gros volumes de données. MySQL est la base de données open source la plus populaire au monde, destinée à être utilisée dans les systèmes de production critiques et à forte charge. Les développements considèrent que Kafka est plus puissant que MySQL en raison de son haut débit, de son architecture distribuée et de son évolutivité ; tandis que SQL, Free et Easy sont les principales raisons pour lesquelles les utilisateurs de MySQL le préfèrent. Je recommande PostgreSQL si vous souhaitez acquérir une expérience pratique des systèmes de gestion de bases de données (SGBD). Chez Vital Beats, nous utilisons principalement Postgres car il nous permet d'atteindre l'équilibre souhaité entre la gestion efficace des données et la sauvegarde tout en prenant en charge la ligne de commande. Si vous envisagez d'héberger votre base de données sur site ou dans le cloud, le premier point de contact est les bases de données PaaS (Platform as a Service). Étant donné que MongoDB écrit des données au même niveau qu'un document, la cohérence est difficile sans transactions.

Les magasins de documents, comme ceux trouvés dans Amazon DynamoDB et AWS RedShift, sont très différents des paires clé-valeur (ou magasins de colonnes) trouvés dans MongoDB. Il est plus rapide et plus facile d'interroger en utilisant la base de données #Nosql car le temps de développement est réduit. En tant que nouvel employé dans le secteur de l'immobilier, j'aimerais sélectionner une base de données qui sera très productive au fil du temps. Si vous exécutez Aurora Postgres sur AWS avec un déploiement dans une seule région, c'est l'une des meilleures plateformes que je recommande. Si vous utilisez PostgreSQL dans trois environnements cloud, vous bénéficierez d'une meilleure réplication multirégionale. Si vous les configurez correctement, chacune de ces trois bases de données fonctionnera de manière efficace, évolutive et fiable à long terme. Uber est passé de Postgres à MySql pour diverses raisons, notamment le besoin d'un système de transmission de données plus agile et plus fiable.

Le directeur de la technologie d'OPS Platform a déclaré que Postgres était le choix le plus efficace à long terme pour son produit en raison de sa rapidité et de sa facilité d'utilisation. Par rapport à MySQL 7.x, les transactions sont traitées plus rapidement dans MySQL 8.0. Une base de données est-elle plus sécurisée ? Est-il possible de changer la clé de chiffrement au hasard ? MySQL et MongoDB sont les deux bases de données open source les plus populaires. En plus de la facilité avec laquelle les données peuvent être stockées, MongoDB peut être utilisé pour stocker de grandes quantités de données entrantes via le réseau de distribution de contenu (CDN). Le principal avantage de Postgres par rapport aux autres bases de données relationnelles objet est l'accent mis sur l'extensibilité et la conformité aux normes.

Des index B-tree et hash réguliers, ainsi que des index d'expression et partiels (ceux qui n'affectent qu'une partie de la table), peuvent être créés. La distinction la plus fondamentale entre Redis et Kafka est leur utilisation des frameworks de messagerie d'entreprise. Je recherche une technologie native du cloud lorsque j'en choisis une. En plus de la découverte de services, NATS peut être utilisé pour remplacer l'équilibrage de charge, les multiclusters globaux et d'autres opérations. La seule chose que Redis ne fait pas est de servir de pur courtier de messages (au moment de la rédaction). Par conséquent, il s'agit davantage d'un magasin général de valeurs-clés en mémoire. Malgré une vaste bibliothèque musicale, mes chansons durent souvent plus de deux heures.

Le problème avec le stockage de fichiers audio dans une ligne de base de données pendant plusieurs heures est qu'ils ne sont pas facilement consultables. Si vous préférez, envisagez de stocker des fichiers audio dans un service de stockage en nuage tel que Backblaze b2 ou AWS S3. Existe-t-il une solution qui utilise MQTT Broker sur IoT World ? Il est hébergé dans l'un des centres de données. Nous le traitons actuellement à des fins d'alerte et d'alarme. Notre objectif principal est d'utiliser des produits plus légers qui réduisent la complexité opérationnelle et les coûts de maintenance. Ce serait idéal si nous pouvions intégrer Apache Kafka avec ces appels d'API tiers supplémentaires.

L'application RabbitMQ est un excellent choix pour les nouvelles tentatives et la mise en file d'attente. Si vous n'avez pas besoin que chaque message soit traité par plusieurs utilisateurs, vous pouvez utiliser RabbitMQ. Cela n'a pas de sens d'utiliser Kafka pour livrer le système avec des confirmations. Le gestionnaire d'état d'événement Kafka, comme un gestionnaire d'état d'événement persistant, vous permet de transformer et d'interroger diverses sources de données à l'aide d'une API de flux. Le framework RabbitMQ est idéal pour un éditeur ou un abonné (ou un consommateur) individuel, et je pense qu'un échange de diffusion peut être configuré pour permettre à plusieurs consommateurs. Le projet Pushnami montre comment migrer des données en direct d'une base de données à une autre. Comme chaque frontend (Angular), backend (Node.js) et frontend (MongoDB) est natif, l'échange de données était beaucoup plus facile.

Pour éviter la couche de traduction, j'ai ignoré la partie relationnelle à hiérarchique. Il est essentiel de conserver une taille finie dans les objets MongoDB et d'utiliser des index corrects. Dès les années 1960, certains des premiers dossiers médicaux électroniques (DME) utilisaient MUMPS, une base de données orientée documents. MongoDB, qui stocke jusqu'à 40 % de tous les dossiers hospitaliers, est considérée comme une base de données médicale robuste. Cependant, il existe des méthodes très intelligentes pour effectuer des requêtes géographiques non nativement prises en charge, ce qui est extrêmement lent à long terme. Amazon Kinesis traite des centaines de milliers de fichiers de données par seconde à partir de centaines de milliers de sources. RabbitMQ vous permet d'envoyer et de recevoir facilement des messages depuis n'importe quelle application. Apache ActiveMQ est rapide, prend en charge une large gamme de clients multilingues et est un langage de script robuste. Les données Hadoop sont traitées à l'aide d'un moteur de traitement rapide et polyvalent nommé Spark.

Kafka contre Mongodb

Mongodb est une puissante base de données orientée documents qui possède de nombreuses fonctionnalités qui en font un bon choix pour une variété d'applications. Kafka est une plate-forme de streaming hautes performances qui peut être utilisée pour créer des pipelines de données en temps réel et des applications de streaming.

Les transferts de MongoDB en tant que source vers d'autres sources MongoDB ou d'autres sources MongoDB peuvent être transparents avec l'application Kafka vers MongoDB. Avec l'aide de MongoDB Kafka Connector, vous apprendrez à transférer efficacement des données. Grâce à cette fonctionnalité, vous pouvez créer un tout nouveau pipeline ETL pour votre organisation. Confluent propose une variété de connecteurs qui agissent comme source et puits, permettant aux utilisateurs de transférer des données entre les deux. Les connecteurs Debezium MongoDB sont l'un de ces mécanismes de connectivité qui permettent aux utilisateurs de Kafka MongoDB de se connecter à la base de données MongoDB. Avant de pouvoir démarrer Confluent Kafka, vous devez d'abord vous assurer qu'il est en cours d'exécution sur votre système. En utilisant des fonctionnalités telles que KStream, KSQL ou tout autre outil tel que Spark Streaming, vous pouvez analyser des données dans Kafka.

La saisie de données dans l'entrepôt nécessite des scripts manuels ainsi qu'un code personnalisé. La plate-forme de pipeline de données sans code de Hevo vous permet de créer des systèmes de pipeline de données simples sans codage. La plateforme de tarification transparente de Hevo vous permet de voir chaque détail de vos dépenses ELT en temps réel. La période d'essai dure 14 jours et comprend une assistance 24 × 7. Le chiffrement de bout en bout est effectué en utilisant les certifications de sécurité les plus strictes. Hevo peut être utilisé pour transférer en toute sécurité vos données Kafka et MongoDB vers 150 sources de données différentes (dont 40 sources gratuites).

Qu'est-ce que Kafka et Mongodb ?

Le connecteur MongoDB Kafka est un connecteur vérifié par Confluent qui conserve les données des sujets Kafka en tant que puits de données dans MongoDB et publie les modifications apportées à ces sujets en tant que source de données.

Les avantages et les inconvénients de l'utilisation de Kafka comme base de données

Quelle base de données est bonne pour Kafka ? En principe, Kafka peut être utilisé pour créer une base de données. Le résultat sera un examen de chaque problème majeur qui a tourmenté les systèmes de gestion de bases de données pendant des décennies. Un système de gestion de base de données (SGBD) est un type de logiciel qui organise et interroge les données. Ils sont nécessaires pour les applications à grande échelle et pour stocker des données auxquelles plusieurs utilisateurs doivent accéder. Un SGBD est classé en deux types : relationnel et non relationnel. Le modèle relationnel est une méthode standard de représentation des informations dans un SGBD relationnel. Ils sont populaires car ils sont simples à utiliser et peuvent être utilisés pour stocker des données organisées dans des tables. Un SGBD qui n'utilise pas de modèles relationnels n'est pas aussi puissant qu'un SGBD qui utilise d'autres modèles. Les données sont également stockées dans d'autres formats que les tableaux afin de les organiser plus efficacement, tels que des flux de données. Le modèle Kafka est utilisé pour créer une base de données, qui peut être utilisée à diverses fins. Le traitement de flux est au cœur de Kafka, un nouveau modèle de représentation de données. Les systèmes de gestion des données (DMS) sont un élément crucial de la gestion des données. Cependant, l'utilisation de Kafka comme base de données peut parfois être difficile. Certains des problèmes les plus courants rencontrés par les SGBD sont les performances, l'évolutivité et la fiabilité. George Fraser, PDG de Fivetran, et Arjun Narayan, PDG de Materialise, ont co-écrit le message.

Base de données de persistance Kafka

Les bases de données de persistance Kafka offrent un moyen de stocker des données dans un cluster kafka de manière hautement disponible et évolutive. Par défaut, kafka utilisera une base de données en mémoire pour stocker les données, mais cela ne convient pas aux déploiements de production. Une base de données de persistance kafka peut être utilisée pour fournir une option de stockage plus fiable pour les données kafka.

LinkedIn a créé le kaffef open-source Apache en 2011. Cette plate-forme permet d'alimenter des données en temps réel avec une latence et un débit extrêmement faibles. Dans la plupart des cas, les données peuvent être importées et exportées via Kafka Connect à partir de systèmes externes. De nouvelles solutions peuvent aider à résoudre des problèmes tels que des performances de stockage inefficaces et la sous-utilisation des disques. Malgré les défis de l'architecture, le flash local est un excellent choix pour les systèmes Kafka. Étant donné que chaque sujet de Kakfa n'est accessible que sur un seul lecteur, il y aura une augmentation de la sous-utilisation. La synchronisation peut également être difficile, ce qui entraîne des problèmes de coût et d'efficacité.

Lorsqu'un SSD tombe en panne, les données qu'il contient doivent être entièrement reconstruites. Cette procédure chronophage réduit les performances du cluster. Kafka est le mieux adapté au stockage basé sur NVMe/TCP car il aplanit le compromis entre fiabilité et performances.

Kafka est un système de messagerie fantastique, mais pas une solution parfaite pour stocker des données

Kafka est un excellent système de messagerie qui peut être utilisé pour stocker des données. L'une des options de rétention de Kafka est un temps de rétention de -1, qui fait référence à une rétention à vie. Cependant, la fiabilité de Kafka est bien inférieure à celle d'une base de données traditionnelle. Il est important de noter que Kafka stocke les données sur le disque, la somme de contrôle et répliquées pour la tolérance aux pannes, donc l'accumulation de plus de données stockées ne le ralentit pas. Kafka peut être utilisé pour envoyer et recevoir des messages, mais ce n'est pas le meilleur choix pour stocker des données.

Qu'est-ce que Kafka

Kafka est un système de messagerie de publication-abonnement rapide, évolutif, durable et tolérant aux pannes. Kafka est utilisé dans la production par des entreprises telles que LinkedIn, Twitter, Netflix et Airbnb.

Kafka a un design simple et direct. Il s'agit d'un système distribué qui s'exécute sur un groupe de machines et peut être mis à l'échelle horizontalement. Kafka est conçu pour gérer un débit élevé et une faible latence.

Kafka est utilisé pour créer des pipelines et des applications de données de streaming en temps réel. Il peut être utilisé pour traiter et agréger des données en temps réel. Kafka peut également être utilisé pour le traitement des événements, la journalisation et l'audit.

LinkedIn a lancé Kafka en 2011 pour gérer les flux de données en temps réel. Kafka est aujourd'hui utilisé par plus de 80% des Fortune 100. Une API Kafka Streams est une bibliothèque puissante et légère conçue pour permettre un traitement à la volée. En plus des bases de données distribuées populaires, Kafka inclut une abstraction d'un journal de validation distribué. Contrairement aux files d'attente de messagerie, Kafka est un système distribué hautement adaptable et tolérant aux pannes avec une évolutivité élevée. Par exemple, il pourrait être utilisé pour gérer l'appariement des passagers et des chauffeurs chez Uber ou fournir des analyses en temps réel chez British Gas. De nombreux microservices s'appuient sur Kafka. Le service cloud natif, complet et entièrement géré de Confluent est supérieur à celui de Kafka. Confluent simplifie la création d'une toute nouvelle catégorie d'applications modernes pilotées par les événements en combinant des données historiques et en temps réel dans une source de vérité unifiée.

Avec l'aide de Kinesis, vous pouvez gérer une large gamme de flux de données, ce qui en fait une plate-forme de traitement de flux puissante et polyvalente. C'est une plate-forme populaire en raison de sa vitesse, de sa simplicité et de sa compatibilité avec une large gamme d'appareils. En raison de sa fiabilité, c'est l'une des plateformes de streaming les plus populaires. Il peut gérer un volume élevé de données sans rencontrer de problèmes en raison de sa durabilité. De plus, comme il s'agit d'une plate-forme bien connue, largement utilisée et prise en charge, il est simple de trouver un partenaire ou un intégrateur pour vous aider à démarrer. Si vous recherchez une plateforme de streaming à la fois puissante et fiable, Kinesis est un excellent choix.

Kafka : le système de messagerie qui remplace les bases de données

Les flux de données en temps réel peuvent être adaptés à l'évolution de l'environnement de données en utilisant Kafka, un système de messagerie permettant de créer un pipeline de données et des applications de diffusion en temps réel. Le Big Data est traité via des flux d'événements en temps réel grâce à l'utilisation de Kafka, qui est écrit en Scala et Java. Une connexion Kafka peut être étendue d'un point à un autre, et elle peut également être utilisée pour envoyer des données entre des sources. La plate-forme de diffusion d'événements est destinée à fournir une diffusion en direct d'événements. Il est injuste de comparer des bases de données avec des solutions de messagerie comme Kafka. Grâce aux fonctionnalités de Kafka, les bases de données ne sont plus nécessaires.

Kafka n'est pas une base de données

Kafka n'est pas une base de données, mais il est souvent utilisé en conjonction avec une. C'est un courtier de messages qui peut être utilisé pour envoyer des messages entre différents composants d'un système. Il est souvent utilisé pour découpler différentes parties d'un système afin qu'elles puissent évoluer indépendamment.

Il est possible de remplacer Apache Kafka par une base de données, mais ne le faites pas par commodité. L'épisode de Top Gear dans lequel les protagonistes ont reçu 10 000 $ chacun pour l'achat d'une supercar italienne à moteur central d'occasion m'a rappelé un vieil épisode de Top Gear dans lequel les protagonistes ont reçu 10 000 $ chacun. En 2011, LinkedIn a publié Kafka, et cet épisode a été diffusé la même année. Il vous permet de faire le strict minimum de messagerie persistante sans investir dans une plate-forme de messagerie complète. La prémisse fondamentale est qu'il existe une règle de base. Créez une table (ou un compartiment, une collection, un index, etc.) pour chaque événement enregistré pendant le processus du producteur. Interrogez régulièrement la base de données à partir d'une instance de consommateur, en mettant à jour l'état du consommateur au fur et à mesure de son traitement.

Pour que le modèle fonctionne correctement, les producteurs et les consommateurs doivent pouvoir travailler simultanément. Envisagez d'utiliser le livre de Kafka comme guide et de stocker les enregistrements indéfiniment plutôt que de simplement les lire. Les groupes de consommateurs disjoints, en revanche, pourraient être mis en œuvre en dupliquant les enregistrements lors de l'insertion, puis en supprimant les enregistrements après consommation. Kafka utilise des décalages persistants pour permettre à ses données définies par l'utilisateur de ventiler et de prendre en charge plusieurs consommateurs disjoints. Pour interrompre cette fonctionnalité, vous devez développer un service à partir de zéro. Il n'est pas difficile de mettre en œuvre le concept de purge basée sur le temps, mais il est nécessaire d'héberger la logique des récupérateurs. Sur Kafka, il existe des contrôles fins sur tous les acteurs (consommateurs, producteurs et administrateurs).

Il peut traiter des millions d'enregistrements par seconde sur des serveurs de base et cloud sans aucun problème. Kafka est optimisé pour des niveaux de débit élevés tant du côté du producteur que du consommateur, dans un sens non fonctionnel. En utilisant Kafka, il s'agit d'un journal distribué, en ajout uniquement, sans égal dans ce domaine. Contrairement aux courtiers de messages traditionnels qui suppriment les messages au stade de la consommation, Kafka ne purge pas les messages après leur consommation. Le débit et la latence d'une base de données devront presque certainement être considérablement améliorés grâce à l'utilisation de matériel spécialisé et à un réglage des performances hautement ciblé. Se passer d'un courtier peut être attrayant à première vue. Lorsque vous utilisez une plate-forme d'événements en streaming telle que Kafka, vous capitalisez sur l'énorme effort d'ingénierie qui a été consacré à sa construction.

Pour vous assurer que la solution que vous choisissez de déployer aujourd'hui peut être maintenue, vous devez être certain qu'elle peut être maintenue à un niveau élevé. La majorité des fonctions d'un magasin d'événements ne peuvent être implémentées que par l'utilisation d'une base de données. Il n'y a pas de magasin d'événements à taille unique ; tout magasin d'événements non trivial, dans la plupart des cas, est presque certainement une implémentation sur mesure soutenue par une ou plusieurs bases de données prêtes à l'emploi. Vous pouvez utiliser des bases de données dans le domaine de l'organisation des données pour une récupération efficace, mais vous devez éviter de les utiliser pour distribuer des données en (presque) temps réel.