Le guide ultime du référencement technique

Publié: 2023-02-24Énumérez trois choses que vous avez faites cette année qui se rapportent à l'optimisation des moteurs de recherche (SEO).

Ces tactiques tournent-elles autour de la recherche de mots-clés, des méta-descriptions et des backlinks ?

Si oui, vous n'êtes pas seul. En matière de référencement, ces techniques sont généralement les premières que les spécialistes du marketing ajoutent à leur arsenal.

Bien que ces stratégies améliorent la visibilité de votre site dans la recherche organique, elles ne sont pas les seules que vous devriez utiliser. Il existe un autre ensemble de tactiques qui relèvent du SEO.

Le référencement technique fait référence aux éléments en coulisse qui alimentent votre moteur de croissance organique, tels que l'architecture du site, l'optimisation mobile et la vitesse des pages. Ces aspects du référencement ne sont peut-être pas les plus sexy, mais ils sont incroyablement importants.

La première étape pour améliorer votre référencement technique consiste à savoir où vous en êtes en effectuant un audit de site. La deuxième étape consiste à créer un plan pour aborder les domaines où vous êtes en deçà. Nous couvrirons ces étapes en profondeur ci-dessous.

Conseil de pro : créez un site Web conçu pour convertir à l'aide des outils CMS gratuits de HubSpot.

Qu'est-ce que le SEO technique ?

Le référencement technique fait référence à tout ce que vous faites pour faciliter l'exploration et l'indexation de votre site par les moteurs de recherche. Le référencement technique, la stratégie de contenu et les stratégies de création de liens fonctionnent tous en tandem pour aider vos pages à se classer très bien dans les recherches.

SEO technique vs SEO sur page vs SEO hors page

De nombreuses personnes décomposent l'optimisation des moteurs de recherche (SEO) en trois catégories différentes : le référencement sur la page, le référencement hors page et le référencement technique. Voyons rapidement ce que chacun signifie.

Référencement sur la page

Le référencement sur la page fait référence au contenu qui indique aux moteurs de recherche (et aux lecteurs !) De quoi parle votre page, y compris le texte alternatif de l'image, l'utilisation des mots clés, les méta descriptions, les balises H1, la dénomination d'URL et les liens internes. Vous avez le plus de contrôle sur le référencement sur la page car, eh bien, tout estsurvotre site.

SEO hors page

Le référencement hors page indique aux moteurs de recherche la popularité et l'utilité de votre page grâce à des votes de confiance, notamment des backlinks ou des liens d'autres sites vers le vôtre. La quantité et la qualité des backlinks augmentent le PageRank d'une page. Toutes choses étant égales par ailleurs, une page avec 100 liens pertinents provenant de sites crédibles surclassera une page avec 50 liens pertinents provenant de sites crédibles (ou 100 liens non pertinents provenant de sites crédibles).

Référencement technique

Le référencement technique est également sous votre contrôle, mais il est un peu plus difficile à maîtriser car il est moins intuitif.

Pourquoi le SEO technique est-il important ?

Vous pourriez être tenté d'ignorer complètement cette composante du SEO ; cependant, il joue un rôle important dans votre trafic organique. Votre contenu peut être le plus complet, le plus utile et le mieux écrit, mais à moins qu'un moteur de recherche ne puisse l'explorer, très peu de gens le verront.

C'est comme un arbre qui tombe dans la forêt quand personne n'est là pour l'entendre… Est-ce que ça fait du bruit ? Sans une solide base technique de référencement, votre contenu ne fera aucun bruit pour les moteurs de recherche.

Source

Source

Voyons comment vous pouvez faire résonner votre contenu sur Internet.

Comprendre le référencement technique

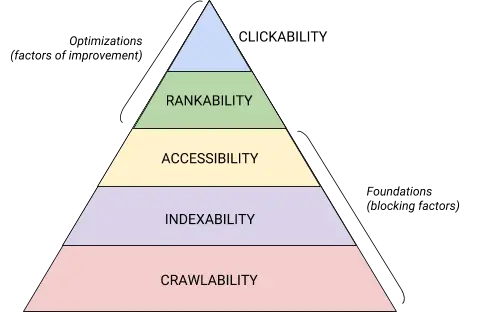

Le référencement technique est une bête qu'il vaut mieux décomposer en éléments digestes. Si vous êtes comme moi, vous aimez aborder de grandes choses en morceaux et avec des listes de contrôle. Croyez-le ou non, tout ce que nous avons couvert jusqu'à présent peut être classé dans l'une des cinq catégories, chacune méritant sa propre liste d'éléments exploitables.

Ces cinq catégories et leur place dans la hiérarchie technique du référencement sont mieux illustrées par ce magnifique graphique qui rappelle la hiérarchie des besoins de Maslov mais remixé pour l'optimisation des moteurs de recherche. (Notez que nous utiliserons le terme couramment utilisé "Rendu" à la place d'Accessibilité.)

Source

Source

Fondamentaux techniques de l'audit SEO

Avant de commencer votre audit SEO technique, il y a quelques fondamentaux que vous devez mettre en place.

Couvrons ces fondamentaux techniques du référencement avant de passer au reste de l'audit de votre site Web.

Auditez votre domaine préféré

Votre domaine est l'URL que les gens tapent pour arriver sur votre site, comme hubspot.com . Le domaine de votre site Web a un impact sur la capacité des internautes à vous trouver via la recherche et offre un moyen cohérent d'identifier votre site.

Lorsque vous sélectionnez un domaine préféré, vous indiquez aux moteurs de recherche si vous préférez que la version www ou non-www de votre site s'affiche dans les résultats de recherche. Par exemple, vous pouvez sélectionnerwww.votresiteweb.complutôt quevotresiteweb.com. Cela indique aux moteurs de recherche de donner la priorité à la version www de votre site et redirige tous les utilisateurs vers cette URL. Sinon, les moteurs de recherche traiteront ces deux versions comme des sites distincts, ce qui entraînera une valeur SEO dispersée.

Auparavant, Google vous demandait d'identifier la version de votre URL que vous préférez. Maintenant, Google identifiera et sélectionnera une version pour vous montrer les chercheurs. Cependant, si vous préférez définir la version préférée de votre domaine, vous pouvez le faire via des balises canoniques (que nous aborderons sous peu). Quoi qu'il en soit, une fois que vous avez défini votre domaine préféré, assurez-vous que toutes les variantes, c'est-à-direwww, non-www, http et index.html, redirigent toutes en permanence vers cette version.

Implémenter SSL

Vous avez peut-être déjà entendu ce terme - c'est parce qu'il est assez important. SSL, ou Secure Sockets Layer , crée une couche de protection entre le serveur Web (le logiciel chargé de répondre à une demande en ligne) et un navigateur, sécurisant ainsi votre site. Lorsqu'un utilisateur envoie des informations à votre site Web, comme des informations de paiement ou de contact, ces informations sont moins susceptibles d'être piratées car vous disposez du protocole SSL pour les protéger.

Un certificat SSL est désigné par un domaine qui commence par "https://" par opposition à "http://" et un symbole de cadenas dans la barre d'URL.

Les moteurs de recherche donnent la priorité aux sites sécurisés — en fait, Google a annoncé dès 2014 que SSL serait considéré comme un facteur de classement . Pour cette raison, assurez-vous de définir la variante SSL de votre page d'accueil comme domaine préféré.

Après avoir configuré SSL, vous devrez migrer toutes les pages non SSL de http vers https. C'est un défi de taille, mais qui en vaut la peine au nom d'un meilleur classement. Voici les étapes que vous devez suivre :

- Redirigez toutes les pages http://votresiteweb.com vers https://votresiteweb.com .

- Mettez à jour toutes les balises canoniques et hreflang en conséquence.

- Mettez à jour les URL de votre sitemap (situé sur yourwebsite.com/sitemap.xml ) et de votre robot.txt (situé sur yourwebsite.com/robots.txt ).

- Configurez une nouvelle instance de Google Search Console et Bing Webmaster Tools pour votre site Web https et suivez-la pour vous assurer que 100 % du trafic migre.

Optimiser la vitesse des pages

Savez-vous combien de temps un visiteur de site Web attendra que votre site Web se charge ? Six secondes … et c'est généreux. Certaines données montrent que le taux de rebond augmente de 90 % avec une augmentation du temps de chargement de la page de une à cinq secondes. Vous n'avez pas une seconde à perdre, l'amélioration du temps de chargement de votre site doit donc être une priorité.

La vitesse du site n'est pas seulement importante pour l'expérience utilisateur et la conversion, c'est aussi un facteur de classement .

Suivez ces conseils pour améliorer le temps de chargement moyen de vos pages :

- Compressez tous vos fichiers. La compression réduit la taille de vos images , ainsi que des fichiers CSS, HTML et JavaScript, afin qu'ils occupent moins d'espace et se chargent plus rapidement.

- Auditez régulièrement les redirections. Une redirection 301 prend quelques secondes à traiter. Multipliez cela sur plusieurs pages ou couches de redirections, et vous affecterez sérieusement la vitesse de votre site.

- Réduisez votre code. Un code désordonné peut avoir un impact négatif sur la vitesse de votre site. Un code désordonné signifie un code paresseux. C'est comme écrire - peut-être que dans le premier brouillon, vous faites valoir votre point de vue en 6 phrases. Dans le deuxième brouillon, vous le faites en 3. Plus le code est efficace, plus la page se chargera rapidement (en général). Une fois que vous aurez nettoyé les choses, vous minifierez et compresserez votre code .

- Considérez un réseau de distribution de contenu (CDN). Les CDN sont des serveurs Web distribués qui stockent des copies de votre site Web dans divers emplacements géographiques et diffusent votre site en fonction de l'emplacement du chercheur. Étant donné que les informations entre les serveurs ont une distance plus courte à parcourir, votre site se charge plus rapidement pour le demandeur.

- Essayez de ne pas aller plugin heureux. Les plugins obsolètes présentent souvent des failles de sécurité qui rendent votre site Web vulnérable aux pirates malveillants qui peuvent nuire au classement de votre site Web. Assurez-vous de toujours utiliser les dernières versions des plugins et réduisez votre utilisation à l'essentiel. Dans le même ordre d'idées, envisagez d'utiliser des thèmes personnalisés, car les thèmes de sites Web prédéfinis contiennent souvent beaucoup de code inutile.

- Profitez des plugins de cache. Les plugins de cache stockent une version statique de votre site à envoyer aux utilisateurs récurrents, réduisant ainsi le temps de chargement du site lors de visites répétées.

- Utilisez le chargement asynchrone (async). Les scripts sont des instructions que les serveurs doivent lire avant de pouvoir traiter le code HTML, ou corps, de votre page Web, c'est-à-dire ce que les visiteurs veulent voir sur votre site. En règle générale, les scripts sont placés dans le <head> d'un site Web (pensez à votre script Google Tag Manager), où ils sont prioritaires sur le contenu du reste de la page. L'utilisation de code asynchrone signifie que le serveur peut traiter simultanément le code HTML et le script, réduisant ainsi le délai et augmentant le temps de chargement de la page.

Voici à quoi ressemble un script asynchrone : < script async src = » script.js « ></ script >

Si vous voulez voir les lacunes de votre site Web en termes de vitesse, vous pouvez utiliser cette ressource de Google .

Une fois que vous avez mis en place vos bases techniques de référencement, vous êtes prêt à passer à l'étape suivante : l'exploration.

Liste de contrôle d'exploration

La crawlabilité est la base de votre stratégie SEO technique. Les robots de recherche exploreront vos pages pour recueillir des informations sur votre site.

Si ces bots sont bloqués d'une manière ou d'une autre, ils ne peuvent pas indexer ou classer vos pages. La première étape de la mise en œuvre du référencement technique consiste à s'assurer que toutes vos pages importantes sont accessibles et faciles à naviguer.

Ci-dessous, nous aborderons certains éléments à ajouter à votre liste de contrôle ainsi que certains éléments de site Web à auditer pour vous assurer que vos pages sont prêtes à être explorées.

Liste de contrôle d'exploration

- Créez un sitemap XML.

- Maximisez votre budget de crawl.

- Optimisez l'architecture de votre site.

- Définissez une structure d'URL.

- Utilisez robots.txt.

- Ajouter des menus fil d'Ariane.

- Utilisez la pagination.

- Vérifiez vos fichiers journaux SEO.

1. Créez un sitemap XML.

Vous souvenez-vous de la structure du site que nous avons parcourue ? Cela appartient à quelque chose appelé un sitemap XML qui aide les robots de recherche à comprendre et à explorer vos pages Web. Vous pouvez le considérer comme une carte pour votre site Web. Vous soumettrez votre sitemap à Google Search Console et aux outils pour les webmasters Bing une fois qu'il sera terminé. N'oubliez pas de maintenir votre sitemap à jour lorsque vous ajoutez et supprimez des pages Web.

2. Maximisez votre budget de crawl.

Votre budget d'exploration fait référence aux pages et aux ressources de votre site que les robots de recherche exploreront .

Parce que le budget de crawl n'est pas infini, assurez-vous de donner la priorité à vos pages les plus importantes pour le crawl.

Voici quelques conseils pour vous assurer que vous maximisez votre budget de crawl :

- Supprimez ou canonisez les pages en double.

- Corrigez ou redirigez les liens brisés.

- Assurez-vous que vos fichiers CSS et Javascript sont explorables.

- Vérifiez régulièrement vos statistiques de crawl et surveillez les baisses ou les augmentations soudaines.

- Assurez-vous que tout bot ou page que vous avez interdit d'explorer est censé être bloqué.

- Gardez votre sitemap à jour et soumettez-le aux outils appropriés pour les webmasters.

- Élaguez votre site du contenu inutile ou obsolète.

- Méfiez-vous des URL générées dynamiquement, qui peuvent faire monter en flèche le nombre de pages de votre site.

3. Optimisez l'architecture de votre site.

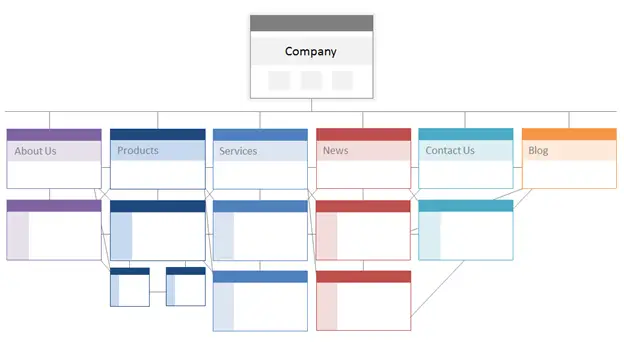

Votre site Web comporte plusieurs pages. Ces pages doivent être organisées de manière à permettre aux moteurs de recherche de les trouver et de les parcourir facilement. C'est là qu'intervient la structure de votre site, souvent appelée architecture de l'information de votre site Web.

De la même manière qu'un bâtiment est basé sur la conception architecturale, l'architecture de votre site est la façon dont vous organisez les pages de votre site.

Les pages associées sont regroupées ; par exemple, la page d'accueil de votre blog renvoie à des articles de blog individuels, chacun renvoyant à leurs pages d'auteur respectives. Cette structure aide les robots de recherche à comprendre la relation entre vos pages.

L'architecture de votre site doit également façonner et être façonnée par l'importance des pages individuelles. Plus la page A est proche de votre page d'accueil, plus il y a de liens vers la page A et pluscespages ont d'équité en matière de liens, plus les moteurs de recherche accorderont d'importance à la page A.

Par exemple, un lien de votre page d'accueil vers la page A démontre plus d'importance qu'un lien d'un article de blog. Plus il y a de liens vers la page A, plus cette page devient "significative" pour les moteurs de recherche.

Conceptuellement, une architecture de site pourrait ressembler à ceci, où les pagesÀ propos, Produit, Actualités,etc. sont positionnées au sommet de la hiérarchie de l'importance des pages.

Source

Assurez-vous que les pages les plus importantes pour votre entreprise se trouvent en haut de la hiérarchie avec le plus grand nombre de liens internes (pertinents !).

4. Définissez une structure d'URL.

La structure d'URL fait référence à la manière dont vous structurez vos URL, quipeut êtredéterminée par l'architecture de votre site. J'expliquerai la connexion dans un instant. Tout d'abord, clarifions que les URL peuvent avoir des sous-répertoires, commeblog.hubspot.com, et/ou des sous-dossiers, commehubspot.com/blog, qui indiquent où mène l'URL.

Par exemple, un article de blog intituléComment toiletter votre chienrelèverait d'un sous-domaine ou d'un sous-répertoire de blog. L'URL peut être www.bestdogcare.com/blog/how-to-groom-your-dog . Alors qu'une page de produit sur ce même site seraitwww.bestdogcare.com/products/grooming-brush.

Que vous utilisiez des sous-domaines ou des sous-répertoires ou des "produits" par rapport à "magasin" dans votre URL dépend entièrement de vous. La beauté de créer votre propre site Web est que vous pouvez créer les règles. Ce qui est important, c'est que ces règles suivent une structure unifiée, ce qui signifie que vous ne devez pas basculer entre blog.votresiteweb.com et votresiteweb.com/blogs sur des pages différentes. Créez une feuille de route, appliquez-la à votre structure de nommage d'URL et respectez-la.

Voici quelques conseils supplémentaires sur la façon d'écrire vos URL :

- Utilisez des caractères minuscules.

- Utilisez des tirets pour séparer les mots.

- Faites-les courts et descriptifs.

- Évitez d'utiliser des caractères ou des mots inutiles (y compris des prépositions).

- Incluez vos mots clés cibles.

Une fois que vous avez mis en place votre structure d'URL, vous soumettez une liste d'URL de vos pages importantes aux moteurs de recherche sous la forme d'un sitemap XML . Cela donne aux robots de recherche un contexte supplémentaire sur votre site afin qu'ils n'aient pas à le comprendre pendant qu'ils explorent.

5. Utilisez robots.txt.

Lorsqu'un robot Web parcourt votre site, il vérifie d'abord le fichier /robot.txt, autrement connu sous le nom de protocole d'exclusion de robot. Ce protocole peut autoriser ou interdire à des robots Web spécifiques d'explorer votre site, y compris des sections spécifiques ou même des pages de votre site. Si vous souhaitez empêcher les bots d'indexer votre site, vous utiliserez une balise meta noindex robots. Discutons de ces deux scénarios.

Vous voudrez peut-être empêcher certains bots d'explorer complètement votre site. Malheureusement, il existe des bots avec des intentions malveillantes - des bots qui gratteront votre contenu ou spammeront vos forums communautaires. Si vous remarquez ce mauvais comportement, vous utiliserez votre robot.txt pour les empêcher d'accéder à votre site Web. Dans ce scénario, vous pouvez considérer robot.txt comme votre champ de force contre les mauvais bots sur Internet.

En ce qui concerne l'indexation, les robots de recherche explorent votre site pour recueillir des indices et trouver des mots-clés afin qu'ils puissent faire correspondre vos pages Web avec des requêtes de recherche pertinentes. Mais, comme nous le verrons plus tard, vous avez un budget de crawl que vous ne voulez pas dépenser pour des données inutiles. Ainsi, vous souhaiterez peut-être exclure les pages qui n'aident pas les robots de recherche à comprendre de quoi parle votre site Web, par exemple, une pagede remerciementd'une offre ou une page de connexion.

Quoi qu'il en soit, votre protocole robot.txt sera unique en fonction de ce que vous souhaitez accomplir.

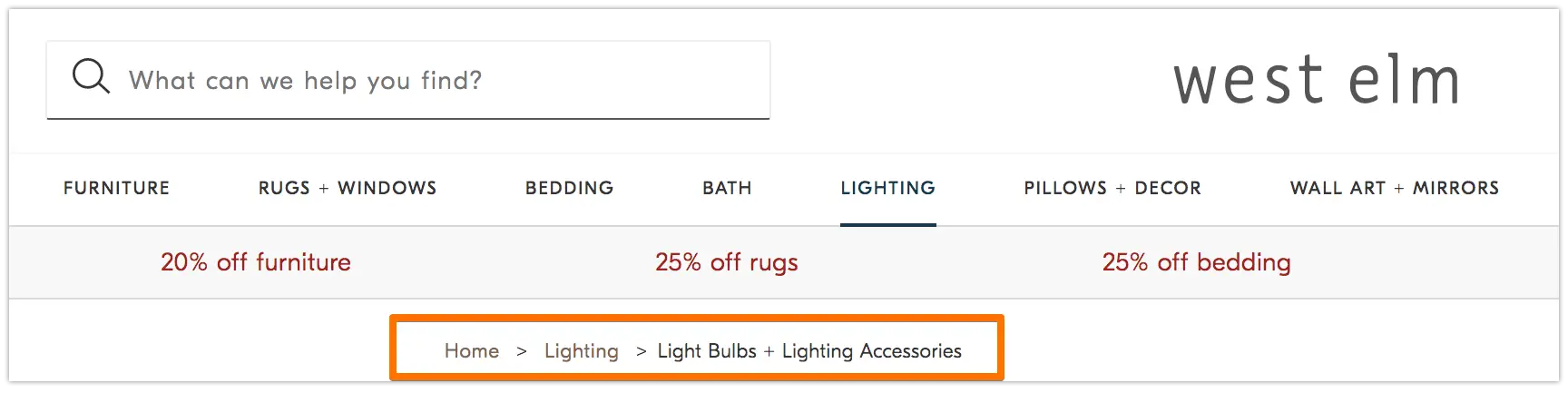

6. Ajouter des menus fil d'Ariane.

Vous souvenez-vous de la vieille fableHansel et Greteloù deux enfants laissaient tomber des miettes de pain par terre pour retrouver le chemin du retour ? Eh bien, ils étaient sur quelque chose.

Les fils d'Ariane sont exactement ce à quoi ils ressemblent - une piste qui guide les utilisateurs vers le début de leur voyage sur votre site Web. Il s'agit d'un menu de pages qui indique aux utilisateurs comment leur page actuelle se rapporte au reste du site.

Et ils ne sont pas réservés aux visiteurs du site Web ; les robots de recherche les utilisent également.

Source

Les fils d'Ariane doivent être deux choses : 1) visibles pour les utilisateurs afin qu'ils puissent facilement naviguer sur vos pages Web sans utiliser le bouton Retour , et 2) avoir un langage de balisage structuré pour donner un contexte précis aux robots de recherche qui explorent votre site.

Vous ne savez pas comment ajouter des données structurées à votre fil d'Ariane ? Utilisez ce guide pour BreadcrumbList .

7. Utilisez la pagination.

Vous souvenez-vous de l'époque où les enseignants vous demandaient de numéroter les pages de votre document de recherche ? C'est ce qu'on appelle la pagination. Dans le monde du référencement technique, la pagination a un rôle légèrement différent, mais vous pouvez toujours la considérer comme une forme d'organisation.

La pagination utilise du code pour indiquer aux moteurs de recherche lorsque des pages avec des URL distinctes sont liées les unes aux autres. Par exemple, vous pouvez avoir une série de contenus que vous divisez en chapitres ou en plusieurs pages Web. Si vous souhaitez faciliter la découverte et l'exploration de ces pages par les robots de recherche, vous utiliserez la pagination.

La façon dont cela fonctionne est assez simple. Vous irez au<head>de la première page de la série et utiliserez

rel="next"pour indiquer au robot de recherche quelle page explorer en second. Ensuite, à la page deux, vous utiliserezrel=”prev”pour indiquer la page précédente etrel=”next”pour indiquer la page suivante, et ainsi de suite.

Ça ressemble à ça…

À la première page :

<link rel="next" href="https://www.website.com/page-two" />

À la page deux :

<link rel="prev" href="https://www.website.com/page-one" />

<link rel="next" href="https://www.website.com/page-three" />

Notez que la pagination est utile pour la découverte de crawl, mais n'est plus prise en charge par Google pour les pages d'indexation par lots comme elle l'était autrefois.

8. Vérifiez vos fichiers journaux SEO.

Vous pouvez considérer les fichiers journaux comme une entrée de journal. Les serveurs Web (le journal) enregistrent et stockent les données du journal sur chaque action qu'ils effectuent sur votre site dans des fichiers journaux (le journal). Les données enregistrées comprennent l'heure et la date de la demande, le contenu demandé et l'adresse IP de la demande. Vous pouvez également identifier l'agent utilisateur, qui est un logiciel identifiable de manière unique (comme un robot de recherche, par exemple) qui répond à la demande d'un utilisateur.

Mais qu'est-ce que cela a à voir avec le référencement?

Eh bien, les robots de recherche laissent une trace sous la forme de fichiers journaux lorsqu'ils explorent votre site. Vous pouvez déterminer si, quand et quoi a été exploré en consultant les fichiers journaux et en filtrant par l' agent utilisateur et le moteur de recherche .

Ces informations vous sont utiles car vous pouvez déterminer comment votre budget de crawl est dépensé et quels obstacles à l'indexation ou à l'accès un bot rencontre. Pour accéder à vos fichiers journaux, vous pouvez soit demander à un développeur, soit utiliser un analyseur de fichiers journaux, comme Screaming Frog .

Ce n'est pas parce qu'un robot de recherche peut explorer votre site qu'il peut indexer toutes vos pages. Jetons un coup d'œil à la couche suivante de votre audit SEO technique : l'indexabilité .

Liste de contrôle d'indexabilité

Lorsque les robots de recherche parcourent votre site Web, ils commencent à indexer les pages en fonction de leur sujet et de leur pertinence par rapport à ce sujet. Une fois indexée, votre page est éligible pour se classer sur les SERPs. Voici quelques facteurs qui peuvent aider vos pages à être indexées.

Liste de contrôle d'indexabilité

- Débloquez les robots de recherche pour accéder aux pages.

- Supprimez le contenu en double.

- Auditez vos redirections.

- Vérifiez la réactivité mobile de votre site.

- Corrigez les erreurs HTTP.

1. Débloquez les robots de recherche pour accéder aux pages.

Vous vous occuperez probablement de cette étape lorsque vous aborderez l'exploration, mais cela vaut la peine d'être mentionné ici. Vous voulez vous assurer que les robots sont envoyés sur vos pages préférées et qu'ils peuvent y accéder librement. Vous avez quelques outils à votre disposition pour ce faire. Le testeur robots.txt de Google vous donnera une liste des pages qui ne sont pas autorisées et vous pouvez utiliser l'outil d'inspection de la console de recherche Google pour déterminer la cause des pages bloquées.

2. Supprimez le contenu en double.

Le contenu dupliqué confond les robots de recherche et a un impact négatif sur votre indexabilité. N'oubliez pas d'utiliser des URL canoniques pour établir vos pages préférées.

3. Auditez vos redirections.

Vérifiez que toutes vos redirections sont configurées correctement. Les boucles de redirection, les URL cassées ou, pire, les redirections incorrectes peuvent causer des problèmes lors de l'indexation de votre site. Pour éviter cela, auditez régulièrement toutes vos redirections.

4. Vérifiez la réactivité mobile de votre site.

Si votre site Web n'est pas encore adapté aux mobiles, vous êtes loin derrière là où vous devez être. Dès 2016, Google a commencé à indexer d'abord les sites mobiles , en donnant la priorité à l'expérience mobile par rapport au bureau. Aujourd'hui, cette indexation est activée par défaut. Pour suivre cette tendance importante, vous pouvez utiliser le test adapté aux mobiles de Google pour vérifier où votre site Web doit être amélioré.

5. Corrigez les erreurs HTTP.

HTTP signifie HyperText Transfer Protocol, mais vous ne vous en souciez probablement pas. Ce qui vous intéresse, c'est quand HTTP renvoie des erreurs à vos utilisateurs ou aux moteurs de recherche, et comment les corriger.

Les erreurs HTTP peuvent entraver le travail des robots de recherche en les bloquant d'un contenu important sur votre site. Il est donc extrêmement important de corriger ces erreurs rapidement et de manière approfondie.

Étant donné que chaque erreur HTTP est unique et nécessite une résolution spécifique, la section ci-dessous contient une brève explication de chacune, et vous utiliserez les liens fournis pour en savoir plus ou comment les résoudre.

- Les redirections permanentes 301 sont utilisées pour envoyer en permanence du trafic d'une URL à une autre. Votre CMS vous permettra de configurer ces redirections, mais un trop grand nombre d'entre elles peuvent ralentir votre site et dégrader votre expérience utilisateur car chaque redirection supplémentaire augmente le temps de chargement de la page. Visez des chaînes de redirection zéro, si possible, car un trop grand nombre entraînera les moteurs de recherche à abandonner l'exploration de cette page.

- 302 La redirection temporaire est un moyen de rediriger temporairement le trafic d'une URL vers une autre page Web. Bien que ce code d'état enverra automatiquement les utilisateurs vers la nouvelle page Web, la balise de titre, l'URL et la description mises en cache resteront cohérentes avec l'URL d'origine. Si la redirection temporaire reste en place suffisamment longtemps, elle sera éventuellement traitée comme une redirection permanente et ces éléments seront transmis à l'URL de destination.

- 403 Messages interdits signifient que le contenu qu'un utilisateur a demandé est restreint en fonction des autorisations d'accès ou en raison d'une mauvaise configuration du serveur.

- Les pages d'erreur 404 indiquent aux utilisateurs que la page qu'ils ont demandée n'existe pas, soit parce qu'elle a été supprimée, soit parce qu'ils ont tapé la mauvaise URL. C'est toujours une bonne idée de créer des pages 404 qui sont sur la marque et engageantes pour garder les visiteurs sur votre site (cliquez sur le lien ci-dessus pour voir quelques bons exemples).

- 405 Méthode non autorisée signifie que le serveur de votre site Web a reconnu et a toujours bloqué la méthode d'accès, ce qui a entraîné un message d'erreur.

- 500 Internal Server Error est un message d'erreur général qui signifie que votre serveur Web rencontre des problèmes pour fournir votre site au demandeur.

- L'erreur 502 Bad Gateway est liée à une mauvaise communication ou à une réponse invalide entre les serveurs du site Web.

- 503 Service Unavailable vous indique que pendant que votre serveur fonctionne correctement, il est incapable de répondre à la demande.

- 504 Gateway Timeout signifie qu'un serveur n'a pas reçu de réponse rapide de votre serveur Web pour accéder aux informations demandées.

Quelle que soit la raison de ces erreurs, il est important de les corriger pour satisfaire à la fois les utilisateurs et les moteurs de recherche, et les inciter à revenir sur votre site.

Même si votre site a été exploré et indexé, les problèmes d'accessibilité qui bloquent les utilisateurs et les bots auront un impact sur votre référencement. Cela dit, nous devons passer à la prochaine étape de votre audit SEO technique : la capacité de rendu.

Liste de contrôle de rendu

Avant de plonger dans ce sujet, il est important de noter la différence entre l'accessibilité SEO et l'accessibilité Web . Ce dernier consiste à rendre vos pages Web faciles à naviguer pour les utilisateurs souffrant de handicaps ou de déficiences, comme la cécité ou la dyslexie, par exemple. De nombreux éléments de l'accessibilité en ligne se chevauchent avec les meilleures pratiques SEO. Cependant, un audit d'accessibilité SEO ne tient pas compte de tout ce que vous devez faire pour rendre votre site plus accessible aux visiteurs handicapés.

Nous allons nous concentrer sur l'accessibilité SEO, ou le rendu, dans cette section, mais gardez à l'esprit l'accessibilité Web lorsque vous développez et maintenez votre site.

Liste de contrôle de rendu

Un site accessible est basé sur la facilité de rendu. Vous trouverez ci-dessous les éléments du site Web à examiner pour votre audit de rendu.

Performances du serveur

Comme vous l'avez appris ci-dessus, les délais d'attente et les erreurs de serveur entraîneront des erreurs HTTP qui empêcheront les utilisateurs et les robots d'accéder à votre site. Si vous remarquez que votre serveur rencontre des problèmes, utilisez les ressources fournies ci-dessus pour les dépanner et les résoudre. Si vous ne le faites pas en temps opportun, les moteurs de recherche peuvent supprimer votre page Web de leur index, car montrer une page cassée à un utilisateur est une mauvaise expérience.

Statut HTTP

Comme pour les performances du serveur, les erreurs HTTP empêcheront l'accès à vos pages Web. Vous pouvez utiliser un robot d'exploration Web, comme Screaming Frog , Botify ou DeepCrawl pour effectuer un audit complet des erreurs de votre site.

Temps de chargement et taille de page

Si votre page prend trop de temps à se charger, le taux de rebond n'est pas le seul problème dont vous devez vous préoccuper. Un retard dans le temps de chargement des pages peut entraîner une erreur de serveur qui bloquera les robots de vos pages Web ou les fera explorer des versions partiellement chargées auxquelles il manque des sections importantes de contenu. En fonction de la demande d'exploration pour une ressource donnée, les bots dépenseront une quantité équivalente de ressources pour tenter de charger, de rendre et d'indexer les pages. Cependant, vous devez faire tout ce qui est en votre pouvoir pour réduire le temps de chargement de votre page.

Rendu JavaScript

Google a certes du mal à traiter JavaScript (JS) et recommande donc d'utiliser du contenu pré-rendu pour améliorer l'accessibilité. Google propose également une multitude de ressources pour vous aider à comprendre comment les robots de recherche accèdent à JS sur votre site et comment améliorer les problèmes liés à la recherche.

Pages orphelines

Chaque page de votre site doit être liée àau moinsune autre page - de préférence plus, selon l'importance de la page. Lorsqu'une page n'a pas de liens internes, on parle de page orpheline. Comme un article sans introduction, ces pages manquent du contexte dont les bots ont besoin pour comprendre comment elles doivent être indexées.

Profondeur de page

La profondeur de page fait référence au nombre de couches vers le bas d'une page dans la structure de votre site, c'est-à-dire au nombre de clics qui vous séparent de votre page d'accueil. Il est préférable de garder l'architecture de votre site aussi superficielle que possible tout en conservant une hiérarchie intuitive. Parfois, un site multicouche est inévitable ; dans ce cas, vous voudrez donner la priorité à un site bien organisé plutôt qu'à un site superficiel.

Quel que soit le nombre de couches dans la structure de votre site, conservez les pages importantes, comme vos pages de produits et de contact, pas plus de trois clics de profondeur. Une structure qui enterre votre page produit si profondément dans votre site que les utilisateurs et les bots doivent jouer au détective pour les trouver sont moins accessibles et offrent une mauvaise expérience

Par exemple, une URL de site Web comme celle-ci qui guide votre public cible vers votre page produit est un exemple de structure de site mal planifiée : www.yourwebsite.com/products-features/features-by-industry/airlines-case-studies/airlines -des produits.

Chaînes de redirection

Lorsque vous décidez de rediriger le trafic d'une page à une autre, vous en payez le prix. Ce prix est l'efficacité du crawl. Les redirections peuvent ralentir l'exploration, réduire le temps de chargement des pages et rendre votre site inaccessible si ces redirections ne sont pas configurées correctement. Pour toutes ces raisons, essayez de réduire au minimum les redirections.

Une fois que vous avez résolu les problèmes d'accessibilité, vous pouvez passer au classement de vos pages dans les SERP.

Liste de contrôle de classement

Passons maintenant aux éléments plus d'actualité que vous connaissez probablement déjà - comment améliorer le classement d'un point de vue SEO technique. Le classement de vos pages implique certains des éléments sur la page et hors page que nous avons mentionnés précédemment, mais d'un point de vue technique.

N'oubliez pas que tous ces éléments fonctionnent ensemble pour créer un site optimisé pour le référencement. Donc, nous serions négligents de laisser de côté tous les facteurs contributifs. Plongeons-y.

Liens internes et externes

Les liens aident les robots de recherche à comprendre où une page s'intègre dans le grand schéma d'une requête et donnent un contexte pour classer cette page. Les liens guident les robots de recherche (et les utilisateurs) vers le contenu connexe et transfèrent l'importance de la page. Dans l'ensemble, la liaison améliore l'exploration, l'indexation et votre capacité à vous classer.

Qualité des backlinks

Les backlinks - des liens d'autres sites vers le vôtre - constituent un vote de confiance pour votre site. Ils indiquent aux robots de recherche que le site Web externe A estime que votre page est de haute qualité et mérite d'être explorée. Au fur et à mesure que ces votes s'additionnent, les robots de recherche remarquent et traitent votre site comme plus crédible. Cela semble beaucoup, n'est-ce pas ? Cependant, comme pour la plupart des grandes choses, il y a une mise en garde. La qualité de ces backlinks compte beaucoup.

Les liens provenant de sites de mauvaise qualité peuvent en fait nuire à votre classement. Il existe de nombreuses façons d'obtenir des backlinks de qualité vers votre site, comme la sensibilisation aux publications pertinentes, la revendication de mentions non liées, la fourniture de publications pertinentes, la revendication de mentions non liées et la fourniture de contenu utile vers lequel d'autres sites souhaitent créer un lien.

Grappes de contenu

Chez HubSpot, nous n'avons pas hésité à parler de notre amour pour les clusters de contenu ou de la manière dont ils contribuent à la croissance organique . Les clusters de contenu relient le contenu connexe afin que les robots de recherche puissent facilement trouver, explorer et indexer toutes les pages que vous possédez sur un sujet particulier. Ils agissent comme un outil d'auto-promotion pour montrer aux moteurs de recherche ce que vous savez sur un sujet, de sorte qu'ils sont plus susceptibles de classer votre site comme une autorité pour toute requête de recherche connexe.

Votre classement est le principal déterminant de la croissance du trafic organique, car des études montrent que les internautes sont plus susceptibles de cliquer sur les trois premiers résultats de recherche sur les SERP. Mais comment vous assurez-vousque le résultat est le vôtre ?

Terminons par le dernier élément de la pyramide du trafic organique : la cliquabilité.

Liste de vérification de la cliquabilité

Bien que le taux de clics (CTR) ait tout à voir avec le comportement du chercheur,vouspouvez faire certaines choses pour améliorer votre cliquabilité sur les SERP. Bien que les méta-descriptions et les titres de page avec des mots-clés aient un impact sur le CTR, nous allons nous concentrer sur les éléments techniques car c'est pourquoi vous êtes ici.

Liste de vérification de la cliquabilité

- Utilisez des données structurées.

- Gagnez des fonctionnalités SERP.

- Optimiser pour les extraits en vedette.

- Considérez Google Discover.

Le classement et le taux de clics vont de pair car, soyons honnêtes, les internautes veulent des réponses immédiates. Plus votre résultat se démarque sur le SERP, plus vous aurez de chances d'obtenir le clic. Passons en revue quelques façons d'améliorer votre cliquabilité.

1. Utilisez des données structurées.

Les données structurées utilisent un vocabulaire spécifique appelé schéma pour catégoriser et étiqueter les éléments de votre page Web pour les robots de recherche. Le schéma indique clairement ce qu'est chaque élément, comment il se rapporte à votre site et comment l'interpréter. Fondamentalement, les données structurées disent aux bots : "Ceci est une vidéo", "Ceci est un produit" ou "Ceci est une recette", ne laissant aucune place à l'interprétation .

To be clear, using structured data is not a “clickability factor” (if there even is such a thing), but it does help organize your content in a way that makes it easy for search bots to understand, index, and potentially rank your pages.

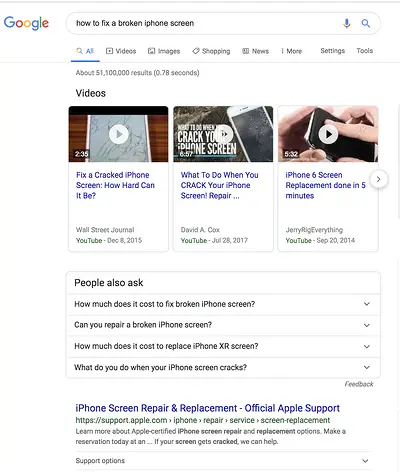

2. Win SERP features.

SERP features , otherwise known as rich results, are a double-edged sword. If you win themandget the click-through, you're golden. If not, your organic results are pushed down the page beneath sponsored ads, text answer boxes, video carousels, and the like.

Rich results are those elements that don't follow the page title, URL, meta description format of other search results. For example, the image below shows two SERP features — a video carousel and “People Also Ask” box — above the first organic result.

While you can still get clicks from appearing in the top organic results, your chances are greatly improved with rich results.

How do you increase your chances of earning rich results? Write useful content and use structured data. The easier it is for search bots to understand the elements of your site, the better your chances of getting a rich result.

Structured data is useful for getting these ( and other search gallery elements ) from your site to the top of the SERPs, thereby, increasing the probability of a click-through:

- Articles

- Videos

- Commentaires

- Events

- How-Tos

- FAQs (“People Also Ask” boxes)

- Images

- Local Business Listings

- Products

- Sitelinks

3. Optimize for Featured Snippets.

One unicorn SERP feature that has nothing to do with schema markup is Featured Snippets, those boxes above the search results that provide concise answers to search queries.

Featured Snippets are intended to get searchers the answers to their queries as quickly as possible. According to Google , providing the best answer to the searcher's query is the only way to win a snippet. However, HubSpot's research revealed a few additional ways to optimize your content for featured snippets .

4. Consider Google Discover.

Google Discover is a relatively new algorithmic listing of content by category specifically for mobile users. It's no secret that Google has been doubling down on the mobile experience; with over 50% of searches coming from mobile , it's no surprise either. The tool allows users to build a library of content by selecting categories of interest (think: gardening, music, or politics).

At HubSpot, we believe topic clustering can increase the likelihood of Google Discover inclusion and are actively monitoring our Google Discover traffic in Google Search Console to determine the validity of that hypothesis. We recommend that you also invest some time in researching this new feature. The payoff is a highly engaged user base that has basically hand-selected the content you've worked hard to create.

The Perfect Trio

Technical SEO, on-page SEO, and off-page SEO work together to unlock the door to organic traffic. While on-page and off-page techniques are often the first to be deployed, technical SEO plays a critical role in getting your site to the top of the search results and your content in front of your ideal audience. Use these technical tactics to round out your SEO strategy and watch the results unfold.