Kafka: Pilihan Bagus Untuk Pialang Pesan Di Layanan Mikro

Diterbitkan: 2022-11-19Kafka adalah platform streaming terdistribusi. Ini sering digunakan untuk agregasi log, pemrosesan aliran waktu nyata, dan sumber acara. Baru-baru ini, Kafka semakin populer sebagai perantara pesan untuk layanan mikro. Kafka bukanlah antrian pesan tradisional seperti ActiveMQ atau RabbitMQ. Itu tidak memiliki server pusat yang menyimpan semua pesan. Sebagai gantinya, ia menggunakan model terbitkan-berlangganan. Pesan disimpan dalam topik, dan setiap topik dapat memiliki banyak partisi. Kafka sangat tersedia dan terukur. Itu dapat menangani miliaran pesan per hari. Kafka juga sangat cepat. Itu dapat memproses pesan secara real-time. Kafka adalah pilihan tepat untuk membuat broker pesan untuk layanan mikro. Ini sangat tersedia, terukur, dan cepat.

Kafka, yang merupakan sistem perpesanan waktu nyata, memungkinkan hal ini. Aliran data dilindungi dari interferensi dan dapat didistribusikan atau toleran terhadap kesalahan. Bus Integrasi Data Kafka adalah protokol pertukaran data yang memungkinkan berbagai produsen dan konsumen untuk berbagi data. Kemampuan Kafka mirip dengan MongoDB dan RDS, yang berfungsi sebagai buffer data di akhir aplikasi Anda.

KSQL, bahasa skrip berbasis SQL, digunakan untuk menganalisis dan memproses data streaming waktu nyata di Apache Kafka . KSQL menyertakan Framework Interaktif untuk Stream Processing, yang dimaksudkan untuk memungkinkan Anda melakukan aktivitas Stream Processing seperti agregasi data, pemfilteran, penggabungan, sessionisasi, windowing, dan sebagainya.

Ini lebih dari sekadar perantara pesan yang luar biasa, seperti yang ditunjukkan oleh Apache Kafka. Implementasi kerangka kerja memiliki sejumlah fitur seperti basis data yang membuatnya cocok untuk digunakan dalam basis data. Akibatnya, sekarang berfungsi sebagai catatan acara bisnis daripada mengandalkan database relasional.

Aplikasi Kafka menghemat waktu dan energi dengan mengalirkan data dari MongoDB dengan cara yang sederhana dan efisien. MongoDB diperlukan bagi perusahaan untuk mempublikasikan data dalam jumlah besar ke pelanggan lain serta mengelola beberapa aliran data. Layanan Koneksi Kafka MongoDB memungkinkan pengembang untuk membuat beberapa aliran asinkron dengan MongoDB, yang merupakan alat industri yang populer.

Dalam database, Apache Kafka berfungsi sebagai model. Ratusan perusahaan menggunakannya untuk memberikan jaminan ACID dan melakukan tugas-tugas penting. Namun, dalam kebanyakan kasus, Kafka tidak sekompetitif database lainnya.

Apa Jenis Basis Data Kafka?

Kafka adalah jenis database yang digunakan untuk menyimpan dan mengambil pesan. Ini adalah sistem terdistribusi yang dirancang untuk dapat diskalakan dan toleran terhadap kesalahan.

Ini adalah platform pemrosesan aliran sumber terbuka yang ditulis dalam Scala dan Java yang merupakan bagian dari proyek Kafka dari Apache Software Foundation. Aliran dalam ilmu komputer adalah kumpulan elemen informasi yang tersedia dari waktu ke waktu. Aliran dapat didefinisikan sebagai item dalam sabuk konveyor yang sedang diproses satu per satu. Aliran, dalam bentuknya yang paling dasar, bisa menjadi rangkaian peristiwa yang tampaknya tidak berhubungan. Konsep sumber acara berbeda dari konsep pergudangan data dan analisis data yang biasa digunakan pengembang. Bagaimana cara menggunakan Kafka sebagai database? Biru adalah perusahaan yang mengatakan ya untuk kesepakatan itu.

Menurut Tim Merah, pemrogram membuat kesalahan besar saat beralih dari basis data konvensional ke Kafka. Menurut Martin Kleppmann, pesan Tim Merah bahwa Kafka adalah untuk semua orang adalah menggurui. Masalah yang dimiliki Tim Merah dengan Kafka dan stream adalah bahwa mereka memiliki masalah dengan pengembang yang membuang RDMS. Ketika log peristiwa permanen disajikan, itu akan selalu memiliki konteks historisnya, membuatnya mudah untuk diaudit. Administrasi basis data memiliki banyak keuntungan, tetapi juga merupakan salah satu aspek yang paling sulit. Basis data tradisional beroperasi dalam dua cara yang sangat berbeda: ini menggabungkan membaca dan menulis. Sangat penting bagi pemrogram untuk memelihara dan menyinkronkan data duplikat di beberapa tabel.

Skala mengubah pola saat Anda pergi. Aliran dibedakan dengan perbedaan yang jelas antara perhatian pembaca dan penulis. Tidak ada hubungan antara seberapa cepat Kafka menulis ke file dan seberapa cepat Elastic Search dapat mendorong pembaruan ke file tersebut. Akibatnya, pengguna Kafka memproses log untuk menghasilkan berbagai tampilan terwujud. Membuat tampilan terwujud berfungsi sebagai mekanisme caching yang nyaman memerlukan beberapa biaya di muka. Tampilan terwujud, selain menyimpan data dan penskalaan mereka sendiri, merupakan komponen infrastruktur yang penting. Untuk 99% bisnis, DBMS adalah fondasi terbaik.

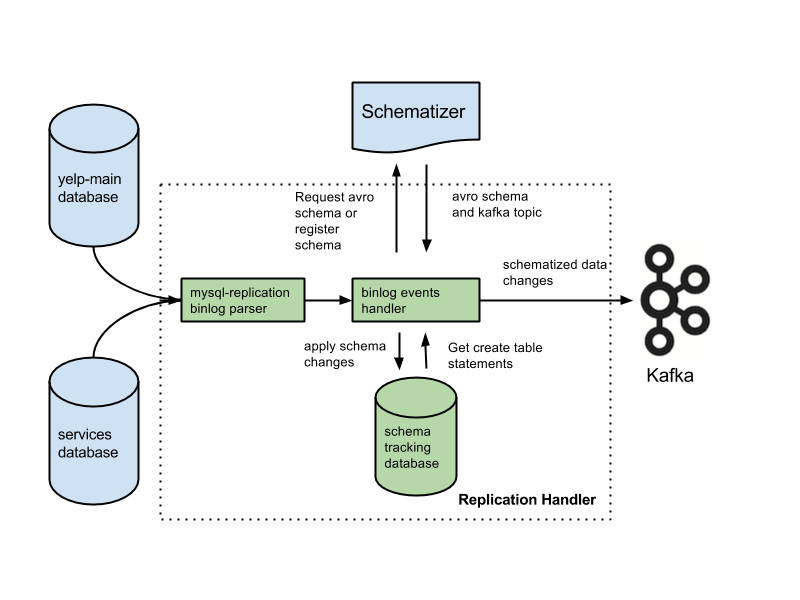

Aplikasi Anda mungkin termasuk dalam kategori ini, dan Anda mungkin berhak atas arsitektur baru berdasarkan latar belakang Anda. Banyak fitur penting akan hilang jika Anda mengganti database dengan log. Fitur-fiturnya termasuk batasan kunci asing, transaksi atomik (semua atau tidak sama sekali), dan teknik isolasi prosedural yang membantu masalah konkurensi. Arjun berasumsi bahwa integritas aplikasi Anda dipertahankan setiap saat. Fitur dasar yang dianggap remeh oleh kebanyakan orang menjadi tanggung jawab ekstra saat Anda mengerjakan streaming. Sangat penting untuk memisahkan maksud dari pernyataan tertulis. Konfigurasi umum adalah menggunakan Kafka bersama dengan sistem Ubah Pengambilan Data.

Menurut Team Red, fitur integritas data database sangat penting untuk mencapai kontrol data. Transaksi harus diisolasi dari database konvensional agar dapat dipertimbangkan. Akibatnya, satu tulisan bisa menjadi mahal. Jika aplikasi Anda kesulitan mengatasi volume penulisan yang mahal, Anda mungkin terpaksa bermigrasi ke database yang lebih konvensional. Team Red gagal menyebutkan bahwa menggunakan database di depan Kafka mengurangi fitur terbaiknya.

Keuntungan dari desain ini sangat signifikan dibandingkan sistem perpesanan tradisional. Keuntungan pertama dari Kafka adalah dapat menangani banyak permintaan. Selain itu, karena data hanya ditulis ke disk saat dibutuhkan, Kafka dapat menangani data dalam jumlah besar.

SQL Server adalah alat Database yang termasuk dalam kategori alat. Perangkat genggam ini serbaguna dan dapat diandalkan, tetapi terkadang sulit digunakan. Kafka dan Azure adalah platform yang sangat mumpuni, tetapi Kafka ditingkatkan sementara Azure diperkecil.

SQL Server adalah alat yang sangat baik untuk bisnis yang membutuhkan penyimpanan data dalam jumlah besar, tetapi ini mungkin bukan pilihan terbaik bagi mereka yang membutuhkan penskalaan cepat atau throughput tinggi. Untuk bisnis yang perlu memproses data dalam jumlah besar tanpa mengorbankan kinerja, Kafka adalah pilihan yang lebih baik daripada SQL Server.

Kafka: Sistem Penyimpanan Terdistribusi Untuk Telemetri Deret Waktu

Sistem Penyimpanan Terdistribusi Kafka, yang menggunakan model berbasis Topik, menyimpan data. Data dapat disimpan dalam model basis data Kafka berbasis Topik daripada dalam basis data relasional. Ini berperilaku mirip dengan antrean di Kafka Topic , meskipun tidak dengan cara yang sama seperti antrean. Itu dapat menyimpan sejumlah besar rangkaian waktu dalam kerangka kerja Kafka daripada Database Rangkaian Waktu.

Apa Perbedaan Antara Kafka Dan Mongodb?

Ini adalah layanan log komit yang didistribusikan, dipartisi, dan direplikasi yang didasarkan pada sistem terdistribusi. Terlepas dari desainnya yang unik, ini merupakan komponen penting dari sistem pesan. MongoDB, di sisi lain, digambarkan sebagai "Basis data untuk ide-ide raksasa."

Karena Kafka tidak mendukung antrean di luar kotak, Anda harus meretasnya ke sistem versi konsumen. Jika database relasional diperlukan, alat lain mungkin lebih bermanfaat. MongoDB adalah pilihan yang sangat baik karena berbagai alasan, termasuk kemudahan penggunaan dan fleksibilitasnya. Dukungan pengguna Apache tersedia. Confluent memiliki Kafka (jika bersedia membayar) yang dibuat di Linkedin bersamaan dengan proyek Kafka. Memiliki vendor yang melakukan pencadangan otomatis dan menskalakan klaster secara otomatis sangatlah nyaman. Jika Anda tidak memiliki administrator sistem atau DBA yang mengetahui MongoDB, sebaiknya gunakan pihak ketiga yang berspesialisasi dalam hosting MongoDB.

Kafka, dalam bentuknya yang paling dasar, dimaksudkan untuk memungkinkan kita mengantri pesan. Mesin penyimpanan Cassandra memastikan penulisan waktu yang konstan ke data Anda tidak peduli seberapa besar ukurannya. MongoDB menyediakan implementasi peta/pengurangan khusus serta dukungan Hadoop asli untuk analitik, sedangkan Cassandra tidak. Tidak ada bedanya apakah itu dihosting oleh Anda atau penyedia lain karena biayanya biasanya masuk akal.

Kafka Vs. Sistem Database Tradisional

Penting untuk dicatat bahwa ada beberapa perbedaan antara Kafka dan sistem database tradisional.

Karena Kafka adalah platform streaming, Kafka dapat menangani tingkat penyerapan data yang tinggi tanpa memerlukan pemrosesan sebelumnya yang signifikan.

Data dikonsumsi oleh pembacaan ekor daripada pembacaan disk saat menjalankan Kafka.

Penggunaan caching halaman mengurangi kebutuhan kunjungan database bolak-balik untuk Kafka.

Untuk mengirim data hilir ke pelanggan hilir, Kafka menggunakan perpesanan pub/sub.

Apa itu Basis Data Kafka

Kafka adalah database yang sering digunakan untuk menyimpan data streaming. Ini adalah sistem terdistribusi yang dirancang untuk dapat diskalakan dan toleran terhadap kesalahan. Kafka sering digunakan untuk membangun saluran data real-time dan aplikasi streaming. Itu dapat menangani throughput tinggi dan latensi rendah.

Pialang pesan seperti Kafka semakin populer dalam beberapa tahun terakhir. Menurut pendukungnya, Kafka adalah perubahan paradigma dalam pengelolaan data. Sangat penting untuk diingat bahwa menggunakan Kafka sebagai penyimpanan data utama Anda tidak memberi Anda isolasi. Setiap masalah yang dihadapi oleh sistem basis data akan diselesaikan di masa mendatang. Peretas dapat mencuri data dengan mengeksploitasi kelemahan dalam arsitektur otonom. Jika dua pengguna mencoba membeli item yang sama pada waktu yang sama, keduanya akan berhasil, dan kami akan kehabisan inventaris untuk keduanya. Arsitektur ini, yang menggunakan fitur perjalanan waktu saat menjalankan peralatan gaslight, bergantung pada arsitektur berbasis peristiwa.

Mengelola volume data yang besar adalah penggunaan Kafka yang sangat baik. Transaksi masih harus diisolasi menggunakan DBMS tradisional. Gunakan database OLTP untuk kontrol penerimaan, CDC untuk pembuatan acara, dan modelkan salinan hilir saat tampilan muncul untuk membalikkan database Anda.

Kafka juga dapat digunakan untuk menyimpan data dalam jumlah besar dan memprosesnya setiap hari. Kemampuan memproses data besar dalam mode batch atau streaming merupakan keunggulan dibandingkan metode lainnya. Proses Kafka dapat digunakan untuk mengambil file log dari beberapa server dan menyimpannya dalam database atau indeks pencarian, misalnya. Tersedia pula streaming API yang dapat digunakan untuk mengolah data secara real time.

Kafka Vs Sql

Secara umum, Kafka dan MySQL diklasifikasikan menjadi dua jenis: Message Queues dan Database Applications. Sebagian besar pengembang menganggap Kafka sebagai solusi dengan throughput tinggi, terdistribusi, dan skalabilitas, sedangkan MySQL dipandang sebagai yang paling populer karena kesederhanaan, kinerja, dan kemudahan penggunaannya.

Perpesanan pub-sub di Kafka adalah sistem throughput terdistribusi, toleran kesalahan, dan tinggi yang dapat menangani volume data yang besar. MySQL adalah database sumber terbuka paling populer di dunia, yang dimaksudkan untuk digunakan dalam sistem produksi yang sangat penting dan beban berat. Perkembangan menganggap Kafka lebih kuat daripada MySQL karena throughputnya yang tinggi, arsitektur terdistribusi, dan skalabilitas; sedangkan SQL, Gratis, dan Mudah adalah alasan utama mengapa pengguna MySQL lebih menyukainya. Saya merekomendasikan PostgreSQL jika Anda ingin mendapatkan pengalaman langsung dengan sistem manajemen basis data (DBMS). Di Vital Beats, kami terutama menggunakan Postgres karena Postgres memungkinkan kami mencapai keseimbangan yang diinginkan antara manajemen data yang efektif dan pencadangan sambil tetap mendukung baris perintah. Jika Anda berencana untuk menghosting database Anda di tempat atau di cloud, titik kontak pertama adalah database PaaS (Platform as a Service). Karena MongoDB menulis data pada level yang sama dengan satu dokumen, konsistensi sulit dilakukan tanpa transaksi.

Penyimpanan dokumen, seperti yang ditemukan di Amazon DynamoDB dan AWS RedShift, sangat berbeda dengan key-value pair (atau penyimpanan kolom) yang ditemukan di MongoDB. Lebih cepat dan lebih mudah untuk membuat kueri menggunakan database #Nosql karena waktu pengembangan berkurang. Sebagai karyawan pemula di industri real estate, saya ingin memilih database yang akan sangat produktif dari waktu ke waktu. Jika Anda menjalankan Aurora Postgres di AWS dengan penerapan satu wilayah, ini adalah salah satu platform terbaik yang saya rekomendasikan. Jika Anda menggunakan PostgreSQL di tiga lingkungan cloud, Anda akan mengalami replikasi mutli-region yang lebih baik. Jika Anda mengonfigurasinya dengan benar, salah satu dari ketiga database ini akan bekerja secara efisien, dapat diskalakan, dan dapat diandalkan dalam jangka panjang. Uber beralih dari Postgres ke MySql karena berbagai alasan, termasuk kebutuhan akan sistem transmisi data yang lebih gesit dan dapat diandalkan.

Chief technology officer di OPS Platform menyatakan bahwa Postgres adalah pilihan jangka panjang yang paling efektif untuk produk mereka karena kecepatan dan kemudahan penggunaannya. Jika dibandingkan dengan MySQL 7.x, transaksi ditangani lebih cepat di MySQL 8.0. Apakah database lebih aman? Apakah mungkin mengubah kunci enkripsi secara acak? MySQL dan MongoDB adalah dua database open source yang paling populer. Selain kemudahan penyimpanan data, MongoDB dapat digunakan untuk menyimpan data masuk dalam jumlah besar melalui Content Distribution Network (CDN). Keunggulan utama Postgres dibandingkan database objek-relasional lainnya adalah penekanannya pada ekstensibilitas dan kepatuhan standar.

Indeks B-tree dan hash reguler, serta Indeks Ekspresi dan Partial (yang hanya memengaruhi sebagian tabel), dapat dibuat. Perbedaan paling mendasar antara Redis dan Kafka adalah penggunaan framework perpesanan perusahaan. Saya mencari teknologi cloud-native saat saya memilihnya. Selain penemuan layanan, NATS dapat digunakan untuk menggantikan load balancing, multicluster global, dan operasi lainnya. Satu-satunya hal yang tidak dilakukan Redis adalah berfungsi sebagai perantara pesan murni (pada saat penulisan). Akibatnya, ini lebih merupakan penyimpanan nilai kunci dalam memori umum. Meskipun memiliki perpustakaan musik yang luas, lagu-lagu saya seringkali berdurasi lebih dari dua jam.

Masalah dengan menyimpan file audio dalam baris database selama beberapa jam adalah tidak mudah dicari. Jika mau, pertimbangkan untuk menyimpan file audio di layanan penyimpanan cloud seperti Backblaze b2 atau AWS S3. Apakah ada solusi yang menggunakan MQTT Broker di IoT World? Itu ditempatkan di salah satu pusat data. Kami sedang memprosesnya untuk tujuan terkait Siaga dan Alarm. Tujuan utama kami adalah menggunakan produk yang lebih ringan yang mengurangi kompleksitas operasional dan biaya pemeliharaan. Akan ideal jika kita dapat mengintegrasikan Apache Kafka dengan panggilan API pihak ketiga tambahan ini.

Aplikasi RabbitMQ adalah pilihan yang sangat baik untuk mencoba ulang dan mengantri. Jika Anda tidak membutuhkan setiap pesan untuk diproses oleh lebih dari satu pengguna, Anda dapat menggunakan RabbitMQ. Tidak masuk akal menggunakan Kafka untuk mengirimkan sistem dengan konfirmasi. Pengelola keadaan kejadian Kafka, seperti pengelola keadaan kejadian yang bertahan, memungkinkan Anda mengubah dan mengkueri berbagai sumber data menggunakan API aliran. Kerangka kerja RabbitMQ sangat ideal untuk penerbit atau pelanggan satu-ke-satu (atau konsumen), dan saya percaya pertukaran fanout dapat dikonfigurasi untuk mengaktifkan banyak konsumen. Proyek Pushnami mendemonstrasikan cara memigrasikan data langsung dari satu database ke database lainnya. Karena setiap frontend (Angular), backend (Node.js), dan frontend (MongoDB) asli, pertukaran data jauh lebih mudah.

Untuk menghindari lapisan terjemahan, saya melewatkan bagian relasional ke hierarkis. Sangat penting untuk menjaga ukuran terbatas pada objek MongoDB dan menggunakan indeks yang benar. Pada awal 1960-an, beberapa rekam medis elektronik (EMR) paling awal menggunakan MUMPS, database berorientasi dokumen. MongoDB, yang menyimpan hingga 40% dari semua catatan rumah sakit, dianggap sebagai database medis yang kuat. Namun, ada beberapa metode yang sangat pintar untuk melakukan kueri geo yang tidak didukung secara asli, yang sangat lambat dalam jangka panjang. Amazon Kinesis memproses ratusan ribu file data per detik dari ratusan ribu sumber. RabbitMQ memudahkan Anda mengirim dan menerima pesan dari aplikasi apa pun. Apache ActiveMQ cepat, mendukung berbagai klien lintas bahasa, dan merupakan bahasa skrip yang kuat. Data Hadoop diproses menggunakan mesin pemrosesan yang cepat dan serba guna bernama Spark.

Kafka Vs Mongodb

Mongodb adalah basis data berorientasi dokumen yang kuat yang memiliki banyak fitur yang menjadikannya pilihan yang baik untuk berbagai aplikasi. Kafka adalah platform streaming berkinerja tinggi yang dapat digunakan untuk membangun saluran data real-time dan aplikasi streaming.

Transfer dari MongoDB sebagai Sumber ke sumber MongoDB lain atau sumber MongoDB lainnya dapat berjalan mulus dengan aplikasi Kafka ke MongoDB. Dengan bantuan MongoDB Kafka Connector, Anda akan mempelajari cara mentransfer data secara efisien. Dengan fitur ini, Anda dapat membuat saluran ETL yang sama sekali baru untuk organisasi Anda. Confluent menawarkan berbagai konektor yang bertindak sebagai sumber dan penerima, memungkinkan pengguna untuk mentransfer data di antara keduanya. Konektor Debezium MongoDB adalah salah satu mekanisme konektivitas yang memungkinkan pengguna Kafka MongoDB untuk terhubung ke database MongoDB. Sebelum Anda dapat memulai Confluent Kafka, Anda harus terlebih dahulu memastikan bahwa itu berjalan di sistem Anda. Dengan menggunakan fungsionalitas seperti KStream, KSQL, atau alat lain seperti Spark Streaming, Anda dapat menganalisis data di Kafka.

Entri data ke gudang memerlukan skrip manual serta kode kustom. Platform pipeline data tanpa kode Hevo memungkinkan Anda membuat sistem pipeline data sederhana tanpa coding. Platform harga transparan Hevo memungkinkan Anda untuk melihat setiap detail pengeluaran ELT Anda secara real time. Masa percobaan berlangsung selama 14 hari dan mencakup dukungan 24×7. Enkripsi end-to-end dilakukan dengan menggunakan sertifikasi keamanan yang paling ketat. Hevo dapat digunakan untuk mentransfer data Kafka dan MongoDB Anda dengan aman ke 150 sumber data yang berbeda (termasuk 40 sumber gratis).

Apa itu Kafka dan Mongodb?

Konektor MongoDB Kafka adalah konektor terverifikasi Confluent yang menyimpan data dari topik Kafka sebagai data yang masuk ke MongoDB dan menerbitkan perubahan pada topik tersebut sebagai sumber data.

Pro Dan Kontra Menggunakan Kafka Sebagai Database

Database mana yang bagus untuk Kafka? Pada prinsipnya Kafka dapat digunakan untuk membuat database. Hasilnya akan menjadi pemeriksaan dari setiap masalah utama yang mengganggu sistem manajemen database selama beberapa dekade. Sistem manajemen basis data (DBMS) adalah jenis perangkat lunak yang mengatur dan menanyakan data. Mereka diperlukan untuk aplikasi berskala besar dan untuk menyimpan data yang harus diakses oleh banyak pengguna. DBMS diklasifikasikan menjadi dua jenis: relasional dan non-relasional. Model relasional adalah metode standar untuk merepresentasikan informasi dalam DBMS relasional. Mereka populer karena mudah digunakan, dan dapat digunakan untuk menyimpan data yang diatur dalam tabel. DBMS yang tidak menggunakan model relasional tidak sekuat yang menggunakan model lain. Data juga disimpan dalam format selain tabel untuk mengaturnya dengan lebih efisien, seperti aliran data. Model Kafka digunakan untuk membuat database, yang dapat digunakan untuk berbagai keperluan. Pemrosesan aliran adalah jantung dari Kafka, model representasi data baru. Sistem manajemen data (DMS) adalah komponen penting dari manajemen data. Namun, menggunakan Kafka sebagai database terkadang sulit. Beberapa masalah paling umum yang ditemui DBMS adalah kinerja, skalabilitas, dan keandalan. George Fraser, CEO Fivetran, dan Arjun Narayan, CEO Materialize, ikut menulis postingan tersebut.

Basis Data Kegigihan Kafka

Database persistensi Kafka menyediakan cara untuk menyimpan data dalam kluster kafka dengan cara yang sangat tersedia dan dapat diskalakan. Secara default, kafka akan menggunakan database dalam memori untuk menyimpan data, tetapi ini tidak cocok untuk penerapan produksi. Database persistensi kafka dapat digunakan untuk menyediakan opsi penyimpanan yang lebih andal untuk data kafka.

LinkedIn membuat Apache kaffef open-source pada tahun 2011. Platform ini memungkinkan data real-time diumpankan pada latensi dan throughput yang sangat rendah. Dalam kebanyakan kasus, data dapat diimpor dan diekspor melalui Kafka Connect dari sistem eksternal. Solusi baru dapat membantu mengatasi masalah seperti kinerja penyimpanan yang tidak efisien dan drive yang kurang dimanfaatkan. Terlepas dari tantangan arsitekturnya, flash lokal merupakan pilihan yang sangat baik untuk sistem Kafka. Karena setiap topik di Kakfa hanya bisa diakses di satu drive, akan ada peningkatan underutilization. Sinkronisasi juga bisa sulit, mengakibatkan masalah biaya dan efisiensi.

Ketika SSD gagal, data darinya harus dibangun kembali sepenuhnya. Prosedur yang memakan waktu ini mengurangi kinerja cluster. Kafka paling cocok untuk penyimpanan berbasis NVMe/TCP karena ini meratakan pertukaran antara keandalan dan kinerja.

Kafka Adalah Sistem Perpesanan Yang Fantastis, Tapi Bukan Solusi Sempurna Untuk Menyimpan Data

Kafka adalah sistem perpesanan luar biasa yang dapat digunakan untuk menyimpan data. Salah satu opsi retensi Kafka adalah waktu retensi -1, yang mengacu pada retensi seumur hidup. Namun, keandalan Kafka jauh dari basis data tradisional. Penting untuk dicatat bahwa Kafka menyimpan data dalam disk, checksum, dan direplikasi untuk toleransi kesalahan, sehingga mengumpulkan lebih banyak data yang disimpan tidak memperlambatnya. Kafka dapat digunakan untuk mengirim dan menerima pesan, tetapi ini bukan pilihan terbaik untuk menyimpan data.

Apa itu Kafka

Kafka adalah sistem pesan publish-subscribe yang cepat, terukur, tahan lama, dan toleran terhadap kesalahan. Kafka digunakan dalam produksi oleh perusahaan seperti LinkedIn, Twitter, Netflix, dan Airbnb.

Kafka memiliki desain yang simpel dan lugas. Ini adalah sistem terdistribusi yang berjalan pada sekelompok mesin dan dapat diskalakan secara horizontal. Kafka dirancang untuk menangani throughput tinggi dan latensi rendah.

Kafka digunakan untuk membangun pipa dan aplikasi data streaming waktu nyata. Ini dapat digunakan untuk memproses dan mengumpulkan data secara real time. Kafka juga dapat digunakan untuk pemrosesan acara, logging, dan audit.

LinkedIn meluncurkan Kafka pada tahun 2011 untuk menangani umpan data waktu nyata. Kafka digunakan oleh lebih dari 80% dari Fortune 100 hari ini. Kafka Streams API adalah pustaka yang kuat dan ringan yang dirancang untuk memungkinkan pemrosesan saat itu juga. Selain database terdistribusi yang populer, Kafka menyertakan abstraksi log komit terdistribusi. Tidak seperti antrian perpesanan, Kafka adalah sistem terdistribusi yang sangat mudah beradaptasi dan toleran dengan skalabilitas tinggi. Sebagai contoh, ini dapat digunakan untuk mengelola pencocokan penumpang dan pengemudi di Uber atau menyediakan analitik waktu nyata di British Gas. Banyak layanan mikro mengandalkan Kafka. Layanan cloud-native, lengkap, dan terkelola penuh Confluent lebih unggul dari Kafka. Confluent membuatnya mudah untuk membangun kategori yang sama sekali baru dari aplikasi modern yang digerakkan oleh peristiwa dengan menggabungkan data historis dan real-time menjadi satu sumber kebenaran terpadu.

Dengan bantuan Kinesis, Anda dapat menangani berbagai aliran data, menjadikannya platform pemrosesan aliran yang andal dan serbaguna. Ini adalah platform yang populer karena kecepatan, kesederhanaan, dan kompatibilitasnya dengan berbagai perangkat. Karena keandalannya, ini adalah salah satu platform streaming paling populer. Itu dapat menangani volume data yang tinggi tanpa mengalami masalah apa pun karena daya tahannya. Selain itu, karena ini adalah platform terkenal yang digunakan dan didukung secara luas, mudah untuk menemukan mitra atau integrator untuk membantu Anda memulainya. Jika Anda mencari platform streaming yang kuat dan dapat diandalkan, Kinesis adalah pilihan yang tepat.

Kafka: Sistem Perpesanan Yang Mengganti Basis Data

Aliran data real-time dapat dibuat untuk beradaptasi dengan lingkungan data yang berubah dengan menggunakan Kafka, sistem pesan untuk membangun pipa dan aplikasi data streaming real-time. Data besar diproses melalui aliran peristiwa waktu nyata melalui penggunaan Kafka, yang ditulis dalam Scala dan Java. Koneksi Kafka dapat diperpanjang dari satu titik ke titik lainnya, dan juga dapat digunakan untuk mengirim data antar sumber. Platform streaming acara dimaksudkan untuk menyediakan streaming langsung acara. Tidak adil membandingkan database dengan solusi perpesanan seperti Kafka. Karena fitur-fitur di Kafka, database tidak lagi diperlukan.

Kafka Bukan Database

Kafka bukan database, tetapi sering digunakan bersamaan dengan database. Ini adalah perantara pesan yang dapat digunakan untuk mengirim pesan antara berbagai komponen sistem. Ini sering digunakan untuk memisahkan berbagai bagian sistem sehingga mereka dapat menskalakan secara mandiri.

Dimungkinkan untuk mengganti Apache Kafka dengan database, tetapi jangan melakukannya demi kenyamanan. Episode Top Gear di mana protagonis mendapatkan $10.000 masing-masing untuk membeli supercar Italia bermesin tengah bekas mengingatkan saya pada episode Top Gear lama di mana protagonis diberi $10.000 masing-masing. Pada tahun 2011, LinkedIn merilis Kafka, dan episode ini ditayangkan pada tahun yang sama. Ini memungkinkan Anda untuk melakukan perpesanan persisten seminimal mungkin tanpa berinvestasi dalam platform perpesanan berfitur lengkap. Premis mendasar adalah bahwa ada aturan dasar. Buat tabel (atau keranjang, kumpulan, indeks, apa pun) untuk setiap peristiwa yang direkam selama proses produser. Polling database secara teratur dari instance konsumen, perbarui status konsumen saat diproses.

Agar model berfungsi dengan baik, produsen dan konsumen harus dapat bekerja secara bersamaan. Pertimbangkan untuk menggunakan buku Kafka sebagai panduan dan menyimpan catatan tanpa batas waktu daripada hanya membacanya. Disjoint kelompok konsumen, di sisi lain, dapat diimplementasikan dengan menggandakan record pada penyisipan, kemudian menghapus record setelah dikonsumsi. Kafka menggunakan offset terus-menerus untuk mengaktifkan pengipasan data yang ditentukan pengguna dan mendukung banyak konsumen yang terpisah. Untuk menghentikan fungsi ini, Anda harus mengembangkan layanan dari bawah ke atas. Tidaklah sulit untuk mengimplementasikan konsep pembersihan berbasis waktu, tetapi perlu untuk menampung logika para pemulung. Di Kafka, ada kontrol halus atas semua aktor (konsumen, produsen, dan administrator).

Itu dapat memproses jutaan catatan per detik pada komoditas dan server cloud tanpa masalah apa pun. Kafka dioptimalkan untuk throughput tingkat tinggi baik di sisi produsen maupun konsumen, dalam arti non-fungsional. Menggunakan Kafka, ini adalah log terdistribusi, hanya tambahan yang tidak ada bandingannya di bidang ini. Tidak seperti broker pesan tradisional yang menghapus pesan pada tahap konsumsi, Kafka tidak menghapus pesan setelah dikonsumsi. Throughput dan latensi database hampir pasti perlu ditingkatkan secara signifikan melalui penggunaan perangkat keras khusus dan penyetelan kinerja yang sangat terfokus. Pembagian dengan broker mungkin menarik pada pandangan pertama. Saat Anda menggunakan platform acara streaming seperti Kafka, Anda memanfaatkan upaya rekayasa luar biasa yang telah dilakukan untuk pembuatannya.

Untuk memastikan bahwa solusi apa pun yang Anda pilih untuk diterapkan hari ini dapat dipertahankan, Anda harus yakin bahwa solusi tersebut dapat dipertahankan dengan standar yang tinggi. Sebagian besar fungsi dalam event store hanya dapat diimplementasikan melalui penggunaan database. Tidak ada toko acara satu ukuran untuk semua; penyimpanan acara nontrivial apa pun, dalam banyak kasus, hampir pasti merupakan implementasi yang dipesan lebih dahulu yang didukung oleh satu atau lebih database siap pakai. Anda dapat menggunakan database di bidang pengorganisasian data untuk pengambilan yang efisien, tetapi Anda harus menghindari penggunaannya untuk mendistribusikan data (hampir) real-time.