Guida passo passo per installare LLM open source nel tuo ambiente locale, senza Internet

Pubblicato: 2023-12-20Riepilogo

Nel mondo in rapida evoluzione dell’intelligenza artificiale, l’installazione di un Large Language Model (LLM) come FALCON all’interno di un sistema locale presenta una serie unica di sfide e opportunità. Questa guida è progettata per guidarti attraverso i passaggi critici della configurazione di FALCON Open-Source LLM, concentrandosi sul raggiungimento di prestazioni ottimali mantenendo allo stesso tempo una rigorosa privacy e sicurezza dei dati.

Intraprendi il viaggio di implementazione di FALCON, un importante modello LLM (Large Language Model) open source, a livello locale, garantendo prestazioni di punta e una solida sicurezza. Questa guida completa copre i prerequisiti hardware, l'installazione del software e la formazione sui dati, sottolineando al contempo l'importanza di test regolari, manutenzione, considerazioni sulla scalabilità e analisi dei costi. Per una prospettiva più ampia, tieniti informato sui 5 principali LLM open source e valuta la possibilità di sfruttare l'esperienza di Creole Studios per un'implementazione sicura, consentendoti di sfruttare la potenza dell'intelligenza artificiale mantenendo rigorosi standard sulla privacy dei dati.

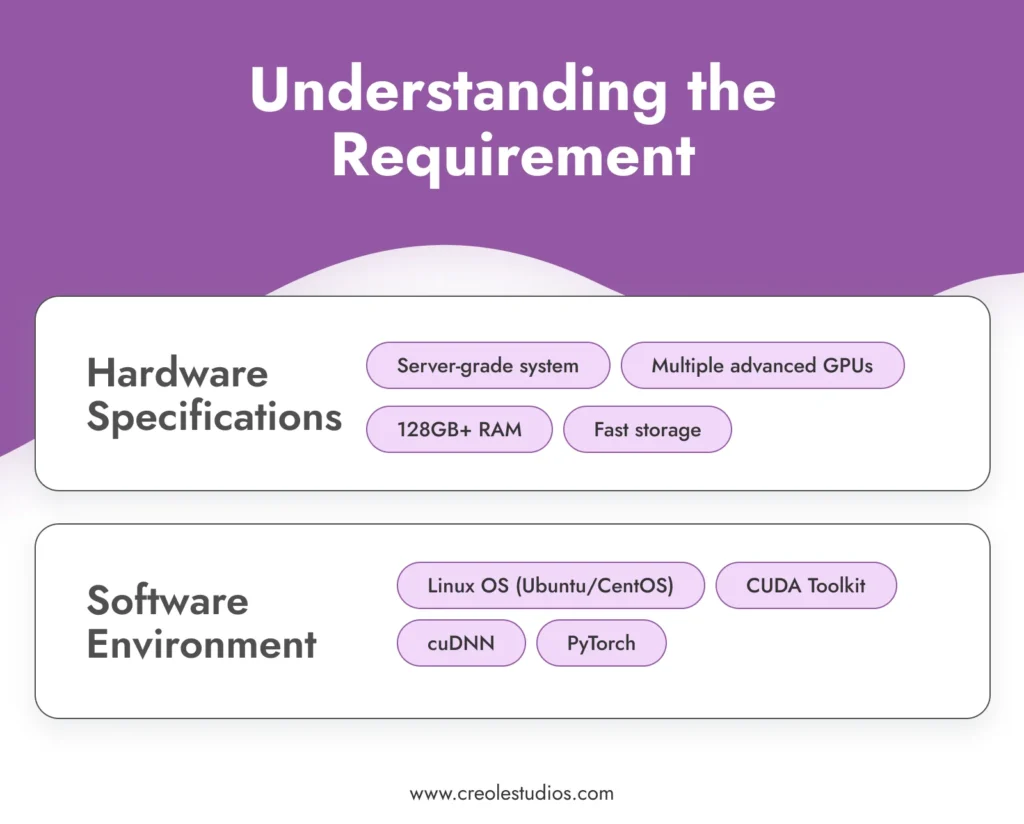

Comprendere il requisito

Prima di immergersi nel processo di installazione, è fondamentale comprendere i requisiti per l'esecuzione di un modello sofisticato come FALCON .

- Specifiche hardware : FALCON, con i suoi enormi 180 miliardi di parametri, richiede notevoli risorse computazionali. Ciò richiede un ambiente informatico ad alte prestazioni, che in genere coinvolge sistemi di livello server dotati di più GPU avanzate (ad esempio, NVIDIA A100), RAM sostanziale (128 GB o più) e soluzioni di archiviazione ad alta velocità (SSD o NVMe) per gestire il modello e dati in modo efficiente. Puoi fare riferimento alle linee guida di NVIDIA per la configurazione di ambienti AI e ML.

- Ambiente software : l'esecuzione di FALCON richiede in modo efficace un ambiente software stabile e compatibile. Un sistema operativo basato su Linux come Ubuntu o CentOS è consigliato per il suo eccellente supporto GPU e la compatibilità con strumenti e librerie essenziali. Lo stack software include CUDA Toolkit per l'accelerazione GPU, cuDNN per reti neurali profonde e framework di apprendimento automatico come PyTorch.

Acquisisci il modello

Il prossimo passo sarà l'acquisizione del modello FALCON. Ciò può comportare :

- Licenza del modello : controlla la disponibilità più recente e le opzioni di licenza per FALCON. La concessione in licenza di un modello come FALCON comporta in genere trattative e accordi, garantendo di avere il diritto legale di utilizzare il modello. Tieni d'occhio il repository ufficiale FALCON o i relativi marketplace di modelli AI per aggiornamenti e dettagli sulla licenza.

- Trasferimento del modello : data la natura con gap d'aria della configurazione, il trasferimento del modello nell'ambiente locale è un passaggio fondamentale. Ciò potrebbe comportare il trasferimento fisico del modello utilizzando dispositivi di archiviazione sicuri e crittografati. L'integrità e la sicurezza del modello durante questo trasferimento sono fondamentali.

Configurare l'infrastruttura

La creazione di un'infrastruttura solida è fondamentale per il funzionamento efficiente di FALCON LLM :

- Configurazione server : ottimizza i tuoi server per carichi di lavoro AI ad alta intensità. Ciò include la configurazione di più GPU per l'elaborazione parallela, la garanzia di reti a larghezza di banda elevata all'interno del sistema e l'implementazione di soluzioni di raffreddamento efficaci per gestire la produzione di calore.

- Gestione dello storage : date le dimensioni di FALCON e i set di dati potenzialmente grandi con cui lavorerai, pianifica attentamente la tua architettura di storage. Per la loro velocità si consigliano SSD ad alta capacità o unità NVMe. Assicurati di disporre di sistemi di ridondanza e backup.

- Alimentazione e raffreddamento : questi potenti server richiederanno adeguati sistemi di alimentazione e raffreddamento. Assicurati che la tua infrastruttura sia in grado di gestire questi requisiti. È consigliabile consultare specialisti hardware per progettare un data center in grado di sostenere questa configurazione

Installa il software richiesto

L'installazione del software è un passaggio fondamentale nella configurazione del tuo LLM open source :

- Configurazione del sistema operativo : installa la distribuzione Linux scelta. Ubuntu e CentOS sono scelte popolari per la loro stabilità e supporto. Assicurarsi che il sistema operativo sia configurato per utilizzare in modo ottimale le risorse hardware.

- Installazione delle dipendenze : installa CUDA Toolkit per il supporto GPU, cuDNN per funzionalità di deep learning e PyTorch come framework di machine learning. Assicurati di utilizzare versioni compatibili con il modello FALCON.

- Software di sicurezza : in un ambiente isolato, la sicurezza interna è fondamentale. Installa robusti firewall e sistemi di rilevamento delle intrusioni. Anche se il sistema è isolato, possono verificarsi minacce interne o violazioni accidentali.

Installazione del modello

L'installazione del modello FALCON prevede diversi passaggi :

- Trasferimento del modello : trasferisci in modo sicuro i file del modello sul tuo sistema locale utilizzando dispositivi di archiviazione crittografati.

- Processo di installazione : seguire la guida di installazione fornita da FALCON. Ciò di solito comporta l'impostazione delle variabili di ambiente, il caricamento dei file del modello e la configurazione dei parametri del modello.

- Verifica : dopo l'installazione, verificare l'integrità dell'installazione. Assicurarsi che i file del modello siano intatti e che il modello esegua correttamente la diagnostica iniziale.

Sicurezza e conformità dei dati

Garantire la sicurezza dei dati in un ambiente air gap implica diversi livelli di protezione :

- Crittografia : tutti i dati, sia inattivi che in transito all'interno della rete, dovrebbero essere crittografati. Implementa protocolli di crittografia avanzati per proteggere i tuoi dati.

- Conformità : rispettare le normative pertinenti sulla protezione dei dati e gli standard di settore. Controlla regolarmente la conformità dei tuoi sistemi.

- Controllo degli accessi : implementare rigide politiche di controllo degli accessi. Solo il personale autorizzato dovrebbe avere accesso al modello e ai dati.

Addestrare il modello con dati curati

Per adattare FALCON alle tue esigenze specifiche, è essenziale addestrarlo con dati selezionati .

- Raccolta e preparazione dei dati : raccogli i dati rilevanti per il tuo caso d'uso. Questi dati dovrebbero essere rappresentativi, diversificati e di alta qualità. Preelaborare e pulire i dati per garantire che siano adatti per l'addestramento.

- Processo di formazione : configura i parametri di formazione di FALCON per allinearli ai tuoi obiettivi. L'addestramento di un modello come FALCON richiede una profonda conoscenza dei principi dell'apprendimento automatico e delle specifiche dell'architettura del modello.

- Monitoraggio e aggiustamento : monitorare continuamente il processo di allenamento per prestazioni e precisione. Prepararsi a modificare i dati o i parametri di allenamento secondo necessità per ottenere i risultati desiderati.

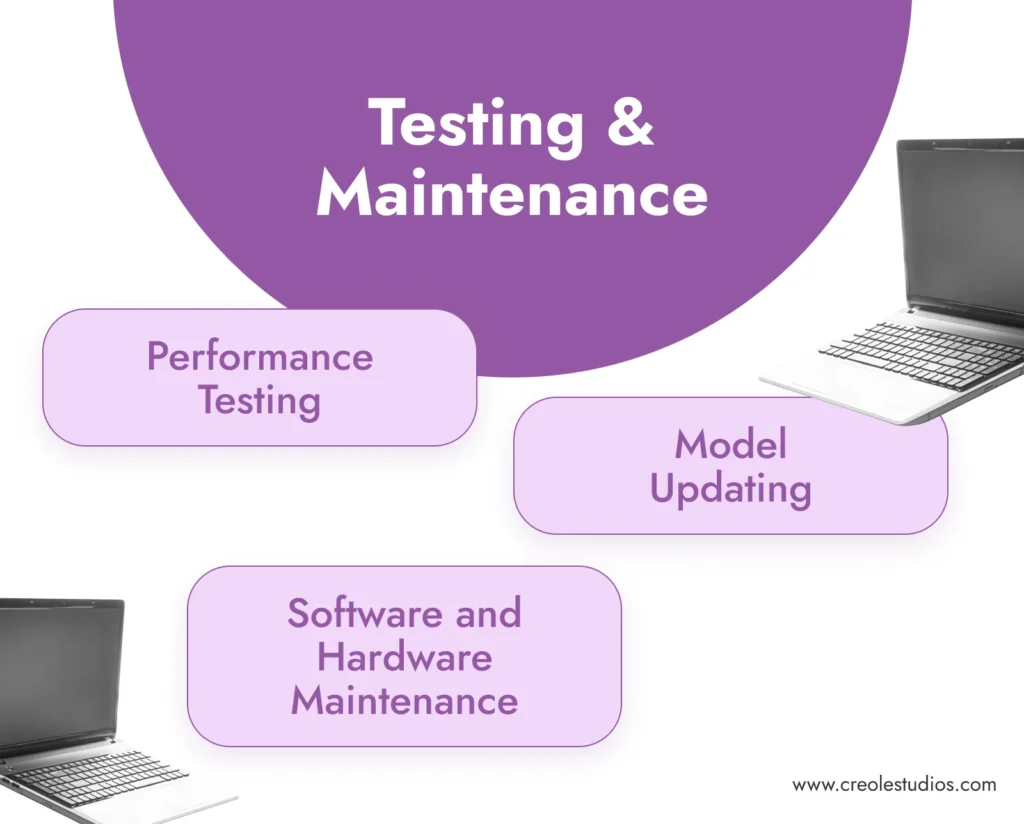

Test e manutenzione

Test e manutenzione regolari sono fondamentali per il successo a lungo termine del modello .

- Test delle prestazioni : testare regolarmente l'accuratezza e l'efficienza del modello. Ciò comporta l'esecuzione di set di dati di convalida e il controllo della coerenza e della qualità degli output del modello.

- Manutenzione software e hardware : aggiornare e applicare patch regolarmente all'ambiente software. Mantenere l'hardware per garantire che funzioni in modo efficiente, compresa la gestione dei sistemi di raffreddamento, il controllo degli alimentatori e la sostituzione di eventuali componenti guasti.

- Aggiornamento del modello : tieniti aggiornato sugli aggiornamenti del modello FALCON. In un ambiente air-gapped, l'aggiornamento del modello potrebbe richiedere il trasferimento manuale dei file del modello aggiornato.

Scalabilità e costi

Considera la crescita futura e le implicazioni in termini di costi della tua configurazione .

- Pianificazione della scalabilità : pianifica il potenziale ridimensionamento della tua infrastruttura. Ciò potrebbe includere l’aggiunta di più GPU, l’espansione dello spazio di archiviazione o il miglioramento delle capacità di rete all’interno dell’ambiente con gap d’aria.

- Analisi dei costi : rivedere regolarmente i costi legati al mantenimento e all'esecuzione di FALCON. Ciò include i costi dell'hardware, il consumo di energia e i costi di licenza.

Note finali: l'importanza dei LLM Open-Source e la competenza di Creole Studios

L'installazione locale di LLM open source come FALCON offre vantaggi significativi, tra cui privacy dei dati, personalizzazione e controllo senza precedenti sulle capacità di intelligenza artificiale. Consente alle aziende di sfruttare la potenza dell'intelligenza artificiale garantendo al tempo stesso che i dati sensibili rimangano entro i confini della loro rete privata e sicura.

Creole Studios eccelle nell'assistere i clienti nel complesso processo di creazione e mantenimento di LLM open source in ambienti locali con gap d'aria. La nostra esperienza garantisce un'implementazione fluida, sicura ed efficace, consentendo alle aziende di sfruttare tutto il potenziale dell'intelligenza artificiale mantenendo i più elevati standard di privacy e sicurezza dei dati. Con il nostro supporto, le aziende possono affrontare con sicurezza le sfide dell’implementazione dell’intelligenza artificiale e rimanere all’avanguardia nel panorama tecnologico in rapida evoluzione.