La guida definitiva alla SEO tecnica

Pubblicato: 2023-02-24Elenca tre cose che hai fatto quest'anno che riguardano l'ottimizzazione per i motori di ricerca (SEO).

Queste tattiche ruotano attorno alla ricerca di parole chiave, meta descrizioni e backlink?

Se è così, non sei solo. Quando si tratta di SEO, queste tecniche sono solitamente le prime che i marketer aggiungono al loro arsenale.

Sebbene queste strategie migliorino la visibilità del tuo sito nella ricerca organica, non sono le uniche che dovresti utilizzare. C'è un'altra serie di tattiche che rientrano nell'ombrello SEO.

La SEO tecnica si riferisce agli elementi dietro le quinte che alimentano il tuo motore di crescita organica, come l'architettura del sito, l'ottimizzazione mobile e la velocità della pagina. Questi aspetti della SEO potrebbero non essere i più sexy, ma sono incredibilmente importanti.

Il primo passo per migliorare il tuo SEO tecnico è sapere dove ti trovi eseguendo un audit del sito. Il secondo passo è creare un piano per affrontare le aree in cui non sei all'altezza. Tratteremo questi passaggi in modo approfondito di seguito.

Suggerimento professionale: crea un sito Web progettato per la conversione utilizzando gli strumenti CMS gratuiti di HubSpot.

Cos'è la SEO tecnica?

La SEO tecnica si riferisce a tutto ciò che fai per rendere più facile la scansione e l'indicizzazione del tuo sito per i motori di ricerca. La SEO tecnica, la strategia dei contenuti e le strategie di creazione di link funzionano tutte in tandem per aiutare le tue pagine a posizionarsi in alto nella ricerca.

SEO tecnico vs. SEO on-page vs. SEO off-page

Molte persone suddividono l'ottimizzazione per i motori di ricerca (SEO) in tre diversi segmenti: SEO on-page, SEO off-page e SEO tecnico. Copriamo rapidamente cosa significa ciascuno.

SEO sulla pagina

La SEO on-page si riferisce al contenuto che dice ai motori di ricerca (e ai lettori!) di cosa tratta la tua pagina, inclusi testo alternativo dell'immagine, utilizzo delle parole chiave, meta descrizioni, tag H1, denominazione degli URL e collegamenti interni. Hai il massimo controllo sulla SEO on-page perché, beh, tutto èsultuo sito.

SEO fuori pagina

La SEO off-page indica ai motori di ricerca quanto sia popolare e utile la tua pagina attraverso voti di fiducia, in particolare backlink o collegamenti da altri siti al tuo. La quantità e la qualità dei backlink aumentano il PageRank di una pagina. A parità di condizioni, una pagina con 100 link rilevanti da siti credibili supererà una pagina con 50 link rilevanti da siti credibili (o 100 link irrilevanti da siti credibili).

SEO tecnico

Anche la SEO tecnica è sotto il tuo controllo, ma è un po' più complicata da padroneggiare poiché è meno intuitiva.

Perché la SEO tecnica è importante?

Potresti essere tentato di ignorare completamente questo componente del SEO; tuttavia, svolge un ruolo importante nel tuo traffico organico. Il tuo contenuto potrebbe essere il più completo, utile e ben scritto, ma a meno che un motore di ricerca non possa scansionarlo, pochissime persone lo vedranno mai.

È come un albero che cade nella foresta quando nessuno è in giro a sentirlo... fa rumore? Senza una solida base tecnica SEO, i tuoi contenuti non faranno rumore per i motori di ricerca.

Fonte

Fonte

Parliamo di come puoi far risuonare i tuoi contenuti attraverso Internet.

Comprendere la SEO tecnica

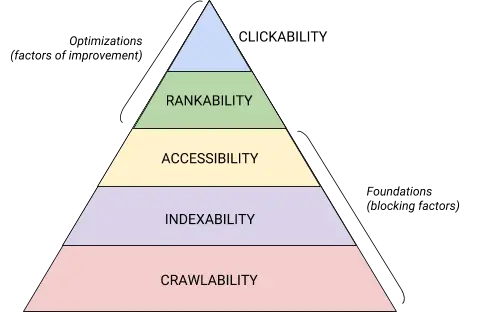

Il SEO tecnico è una bestia che è meglio scomporre in pezzi digeribili. Se sei come me, ti piace affrontare grandi cose in pezzi e con liste di controllo. Che ci crediate o no, tutto ciò che abbiamo trattato fino a questo punto può essere inserito in una delle cinque categorie, ognuna delle quali merita il proprio elenco di elementi utilizzabili.

Queste cinque categorie e il loro posto nella gerarchia tecnica SEO sono illustrate al meglio da questo bellissimo grafico che ricorda la Gerarchia dei bisogni di Maslov ma remixato per l'ottimizzazione dei motori di ricerca. (Nota che useremo il termine comunemente usato "Rendering" al posto di Accessibilità.)

Fonte

Fonte

Fondamenti tecnici dell'audit SEO

Prima di iniziare con il tuo audit SEO tecnico, ci sono alcuni fondamenti che devi mettere in atto.

Copriamo questi fondamenti tecnici SEO prima di passare al resto dell'audit del tuo sito web.

Controlla il tuo dominio preferito

Il tuo dominio è l'URL che le persone digitano per arrivare sul tuo sito, come hubspot.com . Il dominio del tuo sito web influisce sul fatto che le persone possano trovarti tramite la ricerca e fornisce un modo coerente per identificare il tuo sito.

Quando selezioni un dominio preferito, indichi ai motori di ricerca se preferisci che la versione www o non www del tuo sito venga visualizzata nei risultati di ricerca. Ad esempio, potresti selezionarewww.yourwebsite.cominvece diyourwebsite.com. Questo dice ai motori di ricerca di dare la priorità alla versione www del tuo sito e reindirizza tutti gli utenti a quell'URL. In caso contrario, i motori di ricerca tratteranno queste due versioni come siti separati, con conseguente dispersione del valore SEO.

In precedenza, Google ti chiedeva di identificare la versione del tuo URL che preferisci. Ora Google identificherà e selezionerà una versione da mostrare agli utenti che cercano per te. Tuttavia, se preferisci impostare la versione preferita del tuo dominio, puoi farlo tramite i tag canonici (di cui parleremo a breve). In ogni caso, una volta impostato il tuo dominio preferito, assicurati che tutte le varianti, ovverowww, non-www, http e index.html, reindirizzino tutte in modo permanente a quella versione.

Implementa SSL

Potresti aver già sentito questo termine, perché è piuttosto importante. SSL, o Secure Sockets Layer , crea uno strato di protezione tra il server web (il software responsabile di soddisfare una richiesta online) e un browser, rendendo così sicuro il tuo sito. Quando un utente invia informazioni al tuo sito Web, come informazioni di pagamento o di contatto, è meno probabile che tali informazioni vengano compromesse perché hai SSL per proteggerle.

Un certificato SSL è indicato da un dominio che inizia con "https://" anziché "http://" e un simbolo di blocco nella barra degli URL.

I motori di ricerca danno la priorità ai siti sicuri: infatti, Google ha annunciato già nel 2014 che SSL sarebbe stato considerato un fattore di ranking . Per questo motivo, assicurati di impostare la variante SSL della tua home page come dominio preferito.

Dopo aver configurato SSL, dovrai eseguire la migrazione di tutte le pagine non SSL da http a https. È un compito arduo, ma ne vale la pena in nome di un posizionamento migliore. Ecco i passaggi che devi compiere:

- Reindirizza tutte le pagine http://yourwebsite.com a https://yourwebsite.com .

- Aggiorna tutti i tag canonical e hreflang di conseguenza.

- Aggiorna gli URL sulla tua mappa del sito (che si trova in yourwebsite.com/sitemap.xml ) e il tuo robot.txt (che si trova in yourwebsite.com/robots.txt ).

- Imposta una nuova istanza di Google Search Console e Bing Webmaster Tools per il tuo sito Web https e monitoralo per assicurarti che il 100% del traffico venga migrato.

Ottimizza la velocità della pagina

Sai per quanto tempo un visitatore del sito web aspetterà il caricamento del tuo sito web? Sei secondi ... e questo è essere generosi. Alcuni dati mostrano che la frequenza di rimbalzo aumenta del 90% con un aumento del tempo di caricamento della pagina da uno a cinque secondi. Non hai un secondo da perdere, quindi migliorare il tempo di caricamento del tuo sito dovrebbe essere una priorità.

La velocità del sito non è solo importante per l'esperienza utente e la conversione, ma è anche un fattore di ranking .

Utilizza questi suggerimenti per migliorare il tempo medio di caricamento della pagina:

- Comprimi tutti i tuoi file. La compressione riduce le dimensioni delle tue immagini , così come dei file CSS, HTML e JavaScript, in modo che occupino meno spazio e si carichino più velocemente.

- Controlla i reindirizzamenti regolarmente. L'elaborazione di un reindirizzamento 301 richiede alcuni secondi. Moltiplicalo su più pagine o livelli di reindirizzamenti e avrai un serio impatto sulla velocità del tuo sito.

- Riduci il codice. Il codice disordinato può influire negativamente sulla velocità del tuo sito. Codice disordinato significa codice pigro. È come scrivere: forse nella prima bozza esprimi il tuo punto di vista in 6 frasi. Nella seconda bozza, lo fai in 3. Più il codice è efficiente, più velocemente verrà caricata la pagina (in generale). Dopo aver ripulito le cose, minimizzerai e comprimerai il tuo codice .

- Considera una rete di distribuzione dei contenuti (CDN). I CDN sono server Web distribuiti che memorizzano copie del tuo sito Web in varie posizioni geografiche e forniscono il tuo sito in base alla posizione del ricercatore. Poiché le informazioni tra i server hanno una distanza più breve da percorrere, il tuo sito si carica più velocemente per la parte richiedente.

- Cerca di non essere felice con il plug-in. I plug-in obsoleti presentano spesso vulnerabilità di sicurezza che rendono il tuo sito Web vulnerabile agli hacker malintenzionati che possono danneggiare le classifiche del tuo sito Web. Assicurati di utilizzare sempre le versioni più recenti dei plug-in e riduci al minimo il tuo utilizzo. Allo stesso modo, prendi in considerazione l'utilizzo di temi personalizzati, poiché i temi di siti Web predefiniti spesso contengono molto codice non necessario.

- Sfrutta i plugin della cache. I plug-in di cache memorizzano una versione statica del tuo sito da inviare agli utenti di ritorno, riducendo così il tempo di caricamento del sito durante le visite ripetute.

- Utilizzare il caricamento asincrono (asincrono). Gli script sono istruzioni che i server devono leggere prima di poter elaborare l'HTML, o il corpo, della tua pagina web, cioè le cose che i visitatori vogliono vedere sul tuo sito. In genere, gli script vengono inseriti nella <head> di un sito web (pensa: il tuo script di Google Tag Manager), dove hanno la priorità rispetto al contenuto nel resto della pagina. L'uso del codice asincrono significa che il server può elaborare simultaneamente l'HTML e lo script, riducendo così il ritardo e aumentando il tempo di caricamento della pagina.

Ecco come appare uno script asincrono: < script async src =” script.js “></ script >

Se vuoi vedere dove il tuo sito web non è all'altezza nel reparto velocità, puoi utilizzare questa risorsa di Google .

Una volta che hai messo a punto i fondamenti tecnici della SEO, sei pronto per passare alla fase successiva: la crawlability.

Lista di controllo per la scansione

La crawlability è il fondamento della tua strategia SEO tecnica. I robot di ricerca eseguiranno la scansione delle tue pagine per raccogliere informazioni sul tuo sito.

Se questi robot sono in qualche modo bloccati dalla scansione, non possono indicizzare o classificare le tue pagine. Il primo passo per implementare la SEO tecnica è garantire che tutte le tue pagine importanti siano accessibili e facili da navigare.

Di seguito tratteremo alcuni elementi da aggiungere alla tua lista di controllo, nonché alcuni elementi del sito Web da controllare per garantire che le tue pagine siano perfette per la scansione.

Lista di controllo per la scansione

- Crea una mappa del sito XML.

- Massimizza il tuo crawl budget.

- Ottimizza l'architettura del tuo sito.

- Imposta una struttura dell'URL.

- Utilizza robots.txt.

- Aggiungi menu breadcrumb.

- Usa l'impaginazione.

- Controlla i tuoi file di registro SEO.

1. Crea una mappa del sito XML.

Ricordi quella struttura del sito che abbiamo esaminato? Questo appartiene a qualcosa chiamato Sitemap XML che aiuta i robot di ricerca a comprendere e scansionare le tue pagine web. Puoi pensarla come una mappa per il tuo sito web. Una volta completata , invierai la tua mappa del sito a Google Search Console e Bing Webmaster Tools. Ricordati di mantenere aggiornata la tua mappa del sito mentre aggiungi e rimuovi pagine web.

2. Massimizza il tuo crawl budget.

Il tuo crawl budget si riferisce alle pagine e alle risorse del tuo sito che i bot di ricerca eseguiranno la scansione .

Poiché il crawl budget non è infinito, assicurati di dare la priorità alle tue pagine più importanti per la scansione.

Ecco alcuni suggerimenti per assicurarti di massimizzare il tuo crawl budget:

- Rimuovi o canonizza le pagine duplicate.

- Correggi o reindirizza eventuali collegamenti interrotti.

- Assicurati che i tuoi file CSS e Javascript siano scansionabili.

- Controlla regolarmente le tue statistiche di scansione e osserva eventuali cali o aumenti improvvisi.

- Assicurati che qualsiasi bot o pagina di cui hai impedito la scansione sia destinato a essere bloccato.

- Mantieni aggiornata la tua mappa del sito e inviala agli strumenti per i webmaster appropriati.

- Elimina il tuo sito da contenuti non necessari o obsoleti.

- Fai attenzione agli URL generati dinamicamente, che possono far salire alle stelle il numero di pagine del tuo sito.

3. Ottimizza l'architettura del tuo sito.

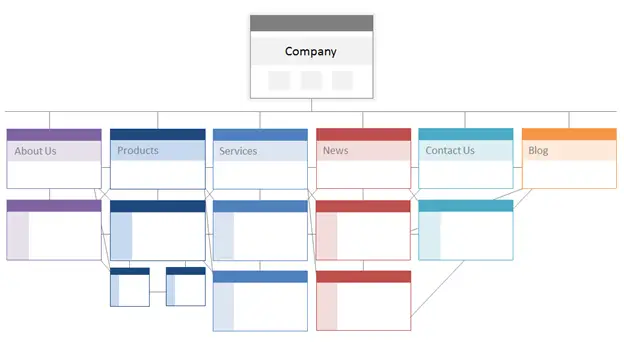

Il tuo sito web ha più pagine. Queste pagine devono essere organizzate in modo da consentire ai motori di ricerca di trovarle e scansionarle facilmente. È qui che entra in gioco la struttura del tuo sito, spesso indicata come l'architettura delle informazioni del tuo sito web.

Allo stesso modo in cui un edificio si basa sulla progettazione architettonica, l'architettura del tuo sito è il modo in cui organizzi le pagine del tuo sito.

Le pagine correlate sono raggruppate insieme; ad esempio, la home page del tuo blog si collega a singoli post del blog, ognuno dei quali si collega alle rispettive pagine dell'autore. Questa struttura aiuta i robot di ricerca a comprendere la relazione tra le tue pagine.

L'architettura del tuo sito dovrebbe anche modellare ed essere modellata dall'importanza delle singole pagine. Più la Pagina A è vicina alla tua home page, più pagine si collegano alla Pagina A e più link equity hannoquellepagine, maggiore sarà l'importanza che i motori di ricerca daranno alla Pagina A.

Ad esempio, un collegamento dalla tua home page alla Pagina A dimostra più significato di un collegamento da un post di un blog. Più collegamenti alla pagina A, più "significativa" diventa quella pagina per i motori di ricerca.

Concettualmente, l'architettura di un sito potrebbe assomigliare a questa, in cui le pagineInformazioni, Prodotto, Notizie,ecc. sono posizionate in cima alla gerarchia dell'importanza della pagina.

Fonte

Assicurati che le pagine più importanti per la tua attività siano in cima alla gerarchia con il maggior numero di link interni (rilevanti!).

4. Impostare una struttura URL.

La struttura dell'URL si riferisce a come strutturi i tuoi URL, chepotrebbero esseredeterminati dall'architettura del tuo sito. Spiegherò la connessione tra un momento. Innanzitutto, chiariamo che gli URL possono avere sottodirectory, comeblog.hubspot.com, e/o sottocartelle, comehubspot.com/blog, che indicano dove conduce l'URL.

Ad esempio, un post sul blog intitolatoHow to Groom Your Dogrientrerebbe in un sottodominio o sottodirectory del blog. L'URL potrebbe essere www.bestdogcare.com/blog/how-to-groom-your-dog . Considerando che una pagina di prodotto su quello stesso sito sarebbewww.bestdogcare.com/products/grooming-brush.

Se utilizzi sottodomini o sottodirectory o "prodotti" rispetto a "negozio" nel tuo URL dipende interamente da te. Il bello di creare il tuo sito web è che puoi creare le regole. L'importante è che queste regole seguano una struttura unificata, il che significa che non dovresti passare da blog.yourwebsite.com a yourwebsite.com/blogs su pagine diverse. Crea una tabella di marcia, applicala alla struttura dei nomi degli URL e rispettala.

Ecco alcuni altri suggerimenti su come scrivere i tuoi URL:

- Usa caratteri minuscoli.

- Usa i trattini per separare le parole.

- Rendili brevi e descrittivi.

- Evita di usare caratteri o parole non necessari (comprese le preposizioni).

- Includi le tue parole chiave target.

Dopo aver abbottonato la struttura dell'URL, invierai un elenco di URL delle tue pagine importanti ai motori di ricerca sotto forma di una mappa del sito XML . Ciò fornisce ai robot di ricerca un contesto aggiuntivo sul tuo sito in modo che non debbano capirlo mentre eseguono la scansione.

5. Utilizza robots.txt.

Quando un robot web esegue la scansione del tuo sito, controlla prima il /robot.txt, altrimenti noto come Robot Exclusion Protocol. Questo protocollo può consentire o impedire a robot Web specifici di eseguire la scansione del tuo sito, comprese sezioni specifiche o persino pagine del tuo sito. Se desideri impedire ai bot di indicizzare il tuo sito, utilizzerai un meta tag noindex robots. Discutiamo entrambi questi scenari.

Potresti voler impedire a determinati bot di eseguire la scansione del tuo sito. Sfortunatamente, ci sono alcuni bot là fuori con intenti dannosi: bot che esploreranno i tuoi contenuti o invieranno spam ai forum della tua community. Se noti questo cattivo comportamento, utilizzerai il file robot.txt per impedire loro di accedere al tuo sito web. In questo scenario, puoi pensare a robot.txt come al tuo campo di forza da bot dannosi su Internet.

Per quanto riguarda l'indicizzazione, i robot di ricerca eseguono la scansione del tuo sito per raccogliere indizi e trovare parole chiave in modo che possano abbinare le tue pagine web a query di ricerca pertinenti. Ma, come discuteremo più avanti, hai un crawl budget che non vuoi spendere in dati non necessari. Pertanto, potresti voler escludere le pagine che non aiutano i robot di ricerca a capire di cosa tratta il tuo sito Web, ad esempio una paginadi ringraziamentoda un'offerta o una pagina di accesso.

In ogni caso, il tuo protocollo robot.txt sarà unico a seconda di ciò che desideri realizzare.

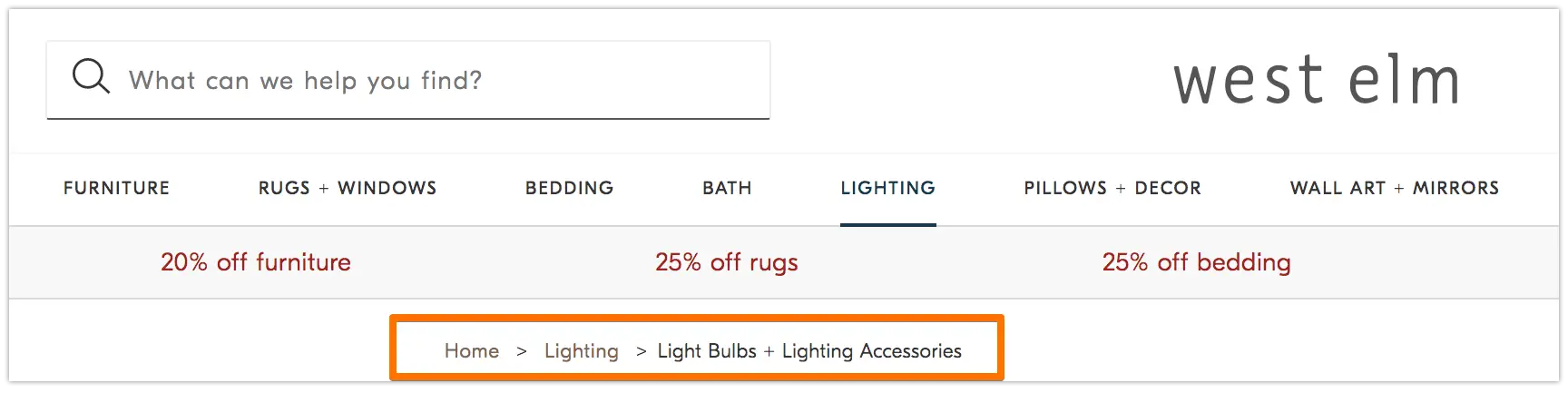

6. Aggiungi menu breadcrumb.

Ricordi la vecchia favolaHansel e Gretelin cui due bambini lasciavano cadere le briciole di pane per terra per ritrovare la strada di casa? Beh, stavano facendo qualcosa.

I breadcrumb sono esattamente ciò che sembrano: un percorso che guida gli utenti all'inizio del loro viaggio sul tuo sito web. È un menu di pagine che indica agli utenti in che modo la loro pagina corrente è correlata al resto del sito.

E non sono solo per i visitatori del sito web; anche i robot di ricerca li usano.

Fonte

I breadcrumb dovrebbero essere due cose: 1) visibili agli utenti in modo che possano navigare facilmente nelle tue pagine web senza utilizzare il pulsanteIndietroe 2) avere un linguaggio di markup strutturato per fornire un contesto accurato ai robot di ricerca che eseguono la scansione del tuo sito.

Non sei sicuro di come aggiungere dati strutturati ai tuoi breadcrumb? Usa questa guida per BreadcrumbList .

7. Usa l'impaginazione.

Ricordi quando gli insegnanti ti chiedevano di numerare le pagine del tuo documento di ricerca? Si chiama impaginazione. Nel mondo della SEO tecnica, l'impaginazione ha un ruolo leggermente diverso, ma puoi comunque pensarla come una forma di organizzazione.

L'impaginazione utilizza il codice per comunicare ai motori di ricerca quando le pagine con URL distinti sono correlate tra loro. Ad esempio, potresti avere una serie di contenuti suddivisa in capitoli o più pagine web. Se vuoi rendere più facile per i robot di ricerca scoprire e scansionare queste pagine, allora utilizzerai l'impaginazione.

Il modo in cui funziona è piuttosto semplice. Andrai all'<head>della prima pagina della serie e userai

rel="next"per indicare al bot di ricerca quale pagina scansionare per seconda. Quindi, a pagina due, utilizzerairel=”prev”per indicare la pagina precedente erel=”next”per indicare la pagina successiva, e così via.

Sembra così...

A pagina uno:

<link rel=“next” href=“https://www.website.com/page-two” />

A pagina due:

<link rel=“prev” href=“https://www.website.com/page-one” />

<link rel=“next” href=“https://www.website.com/page-three” />

Tieni presente che l'impaginazione è utile per il crawl discovery, ma non è più supportata da Google per l'indicizzazione in batch delle pagine come una volta.

8. Controlla i tuoi file di registro SEO.

Puoi pensare ai file di registro come a una voce di diario. I server Web (il journaler) registrano e archiviano i dati di registro su ogni azione che intraprendono sul tuo sito nei file di registro (il journal). I dati registrati includono l'ora e la data della richiesta, il contenuto richiesto e l'indirizzo IP richiedente. Puoi anche identificare l'agente utente, che è un software identificabile in modo univoco (come un bot di ricerca, ad esempio) che soddisfa la richiesta di un utente.

Ma cosa c'entra questo con la SEO?

Bene, i robot di ricerca lasciano una traccia sotto forma di file di registro quando eseguono la scansione del tuo sito. Puoi determinare se, quando e cosa è stato sottoposto a scansione controllando i file di registro e filtrando in base all'agente utente e al motore di ricerca .

Queste informazioni ti sono utili perché puoi determinare come viene speso il tuo crawl budget e quali ostacoli all'indicizzazione o all'accesso a un bot sta incontrando. Per accedere ai tuoi file di registro, puoi chiedere a uno sviluppatore o utilizzare un analizzatore di file di registro, come Screaming Frog .

Solo perché un bot di ricerca può eseguire la scansione del tuo sito non significa necessariamente che possa indicizzare tutte le tue pagine. Diamo un'occhiata al livello successivo del tuo audit SEO tecnico: l'indicizzabilità .

Lista di controllo dell'indicizzabilità

Quando i robot di ricerca eseguono la scansione del tuo sito Web, iniziano a indicizzare le pagine in base al loro argomento e alla rilevanza rispetto a tale argomento. Una volta indicizzata, la tua pagina è idonea a posizionarsi nelle SERP. Ecco alcuni fattori che possono aiutare le tue pagine a essere indicizzate.

Lista di controllo dell'indicizzabilità

- Sblocca i robot di ricerca dall'accesso alle pagine.

- Rimuovi i contenuti duplicati.

- Controlla i tuoi reindirizzamenti.

- Controlla la reattività mobile del tuo sito.

- Correggi gli errori HTTP.

1. Sblocca i robot di ricerca dall'accesso alle pagine.

Probabilmente ti occuperai di questo passaggio quando affronti la scansione, ma vale la pena menzionarlo qui. Vuoi assicurarti che i bot vengano inviati alle tue pagine preferite e che possano accedervi liberamente. Hai alcuni strumenti a tua disposizione per farlo. Il tester robots.txt di Google ti fornirà un elenco di pagine non consentite e puoi utilizzare lo strumento Inspect di Google Search Console per determinare la causa delle pagine bloccate.

2. Rimuovi i contenuti duplicati.

I contenuti duplicati confondono i robot di ricerca e influiscono negativamente sull'indicizzabilità. Ricorda di utilizzare gli URL canonici per stabilire le tue pagine preferite.

3. Controlla i tuoi reindirizzamenti.

Verifica che tutti i tuoi reindirizzamenti siano impostati correttamente. Loop di reindirizzamento, URL interrotti o, peggio, reindirizzamenti impropri possono causare problemi durante l'indicizzazione del tuo sito. Per evitare ciò, controlla regolarmente tutti i tuoi reindirizzamenti.

4. Controlla la reattività mobile del tuo sito.

Se il tuo sito web non è ancora ottimizzato per i dispositivi mobili, allora sei molto indietro rispetto a dove devi essere. Già nel 2016, Google ha iniziato a indicizzare prima i siti per dispositivi mobili , dando priorità all'esperienza mobile rispetto a quella desktop. Oggi l'indicizzazione è abilitata per impostazione predefinita. Per stare al passo con questa importante tendenza, puoi utilizzare il test di ottimizzazione mobile di Google per verificare dove il tuo sito web deve migliorare.

5. Correggi gli errori HTTP.

HTTP è l'acronimo di HyperText Transfer Protocol, ma probabilmente non ti interessa. Ciò che ti interessa è quando HTTP restituisce errori ai tuoi utenti o ai motori di ricerca e come risolverli.

Gli errori HTTP possono ostacolare il lavoro dei robot di ricerca bloccandoli da contenuti importanti sul tuo sito. È quindi estremamente importante affrontare questi errori in modo rapido e completo.

Poiché ogni errore HTTP è unico e richiede una risoluzione specifica, la sezione seguente contiene una breve spiegazione di ciascuno e utilizzerai i collegamenti forniti per saperne di più o come risolverli.

- I reindirizzamenti permanenti 301 vengono utilizzati per inviare in modo permanente il traffico da un URL a un altro. Il tuo CMS ti consentirà di impostare questi reindirizzamenti, ma troppi di questi possono rallentare il tuo sito e peggiorare la tua esperienza utente poiché ogni reindirizzamento aggiuntivo aumenta il tempo di caricamento della pagina. Mira a zero catene di reindirizzamento, se possibile, poiché troppe causeranno la rinuncia ai motori di ricerca a eseguire la scansione di quella pagina.

- 302 Temporary Redirect è un modo per reindirizzare temporaneamente il traffico da un URL a una pagina web diversa. Anche se questo codice di stato invierà automaticamente gli utenti alla nuova pagina web, il tag del titolo, l'URL e la descrizione memorizzati nella cache rimarranno coerenti con l'URL di origine. Se il reindirizzamento temporaneo rimane attivo abbastanza a lungo, tuttavia, alla fine verrà trattato come un reindirizzamento permanente e tali elementi passeranno all'URL di destinazione.

- I messaggi proibiti 403 indicano che il contenuto richiesto da un utente è limitato in base alle autorizzazioni di accesso oa causa di un'errata configurazione del server.

- Le pagine di errore 404 informano gli utenti che la pagina che hanno richiesto non esiste, perché è stata rimossa o perché hanno digitato l'URL sbagliato. È sempre una buona idea creare pagine 404 on-brand e coinvolgenti per mantenere i visitatori sul tuo sito (fai clic sul link qui sopra per vedere alcuni buoni esempi).

- 405 Metodo non consentito significa che il server del tuo sito web ha riconosciuto e comunque bloccato il metodo di accesso, generando un messaggio di errore.

- 500 Internal Server Error è un messaggio di errore generale che indica che il tuo server web sta riscontrando problemi nel consegnare il tuo sito alla parte richiedente.

- L'errore 502 Bad Gateway è correlato a problemi di comunicazione o risposta non valida tra i server del sito Web.

- 503 Service Unavailable ti dice che mentre il tuo server funziona correttamente, non è in grado di soddisfare la richiesta.

- 504 Gateway Timeout significa che un server non ha ricevuto una risposta tempestiva dal tuo server web per accedere alle informazioni richieste.

Qualunque sia la ragione di questi errori, è importante risolverli per mantenere felici sia gli utenti che i motori di ricerca e per far sì che entrambi tornino sul tuo sito.

Anche se il tuo sito è stato scansionato e indicizzato, i problemi di accessibilità che bloccano utenti e bot avranno un impatto sulla tua SEO. Detto questo, dobbiamo passare alla fase successiva del tuo audit SEO tecnico: la renderabilità.

Lista di controllo della resa

Prima di addentrarci in questo argomento, è importante notare la differenza tra accessibilità SEO e accessibilità web . Quest'ultimo ruota intorno a rendere le tue pagine web facili da navigare per gli utenti con disabilità o menomazioni, come la cecità o la dislessia, per esempio. Molti elementi dell'accessibilità online si sovrappongono alle migliori pratiche SEO. Tuttavia, un audit di accessibilità SEO non tiene conto di tutto ciò che dovresti fare per rendere il tuo sito più accessibile ai visitatori disabili.

Ci concentreremo sull'accessibilità SEO, o rendering, in questa sezione, ma tieni l'accessibilità web al primo posto mentre sviluppi e mantieni il tuo sito.

Lista di controllo della resa

Un sito accessibile si basa sulla facilità di rendering. Di seguito sono riportati gli elementi del sito Web da esaminare per il controllo della renderabilità.

Prestazioni del server

Come hai appreso in precedenza, i timeout e gli errori del server causeranno errori HTTP che impediscono a utenti e bot di accedere al tuo sito. Se noti che il tuo server sta riscontrando problemi, utilizza le risorse fornite sopra per risolverli. Se non lo fai in modo tempestivo, i motori di ricerca possono rimuovere la tua pagina web dal loro indice poiché è una brutta esperienza mostrare una pagina rotta a un utente.

Stato HTTP

Analogamente alle prestazioni del server, gli errori HTTP impediranno l'accesso alle tue pagine web. Puoi utilizzare un web crawler, come Screaming Frog , Botify o DeepCrawl per eseguire un controllo completo degli errori del tuo sito.

Tempo di caricamento e dimensione della pagina

Se la tua pagina impiega troppo tempo a caricarsi, la frequenza di rimbalzo non è l'unico problema di cui devi preoccuparti. Un ritardo nel tempo di caricamento della pagina può causare un errore del server che bloccherà i bot dalle tue pagine web o li costringerà a eseguire la scansione di versioni parzialmente caricate che mancano di importanti sezioni di contenuto. A seconda della quantità di richiesta di scansione per una determinata risorsa, i bot spenderanno una quantità equivalente di risorse per tentare di caricare, eseguire il rendering e indicizzare le pagine. Tuttavia, dovresti fare tutto ciò che è sotto il tuo controllo per ridurre il tempo di caricamento della pagina.

Rendering JavaScript

Google ha certamente difficoltà a elaborare JavaScript (JS) e, pertanto, consiglia di utilizzare contenuti pre-renderizzati per migliorare l'accessibilità. Google ha anche una serie di risorse per aiutarti a capire come i robot di ricerca accedono a JS sul tuo sito e come migliorare i problemi relativi alla ricerca.

Pagine orfane

Ogni pagina del tuo sito dovrebbe essere collegata adalmenoun'altra pagina, preferibilmente di più, a seconda dell'importanza della pagina. Quando una pagina non ha link interni, si chiama pagina orfana. Come un articolo senza introduzione, queste pagine mancano del contesto di cui i bot hanno bisogno per capire come dovrebbero essere indicizzate.

Profondità pagina

La profondità della pagina si riferisce a quanti livelli di una pagina esiste nella struttura del tuo sito, ovvero a quanti clic è lontana dalla tua home page. È meglio mantenere l'architettura del tuo sito il più superficiale possibile pur mantenendo una gerarchia intuitiva. A volte un sito a più livelli è inevitabile; in tal caso, ti consigliamo di dare la priorità a un sito ben organizzato rispetto alla superficialità.

Indipendentemente dal numero di livelli nella struttura del tuo sito, mantieni le pagine importanti, come le pagine dei prodotti e dei contatti, non più profonde di tre clic. Una struttura che seppellisce la pagina del tuo prodotto così in profondità nel tuo sito che gli utenti e i bot devono fare il detective per trovarla, sono meno accessibili e forniscono un'esperienza scadente

Ad esempio, l'URL di un sito Web come questo che guida il tuo pubblico di destinazione alla pagina del tuo prodotto è un esempio di una struttura del sito mal pianificata: www.yourwebsite.com/products-features/features-by-industry/airlines-case-studies/airlines -prodotti.

Catene di reindirizzamento

Quando decidi di reindirizzare il traffico da una pagina all'altra, stai pagando un prezzo. Quel prezzo è l'efficienza della scansione. I reindirizzamenti possono rallentare la scansione, ridurre il tempo di caricamento della pagina e rendere inaccessibile il tuo sito se tali reindirizzamenti non sono impostati correttamente. Per tutti questi motivi, cerca di ridurre al minimo i reindirizzamenti.

Una volta affrontati i problemi di accessibilità, puoi passare al posizionamento delle tue pagine nelle SERP.

Lista di controllo della classifica

Ora passiamo agli elementi più attuali di cui probabilmente sei già a conoscenza: come migliorare il posizionamento dal punto di vista tecnico SEO. Far classificare le tue pagine implica alcuni degli elementi on-page e off-page che abbiamo menzionato prima, ma da un punto di vista tecnico.

Ricorda che tutti questi elementi lavorano insieme per creare un sito SEO-friendly. Quindi, saremmo negligenti a tralasciare tutti i fattori che contribuiscono. Immergiamoci dentro.

Collegamento interno ed esterno

I collegamenti aiutano i robot di ricerca a capire dove si inserisce una pagina nel grande schema di una query e forniscono un contesto su come classificare quella pagina. I collegamenti guidano i robot di ricerca (e gli utenti) al contenuto correlato e trasferiscono l'importanza della pagina. Nel complesso, il collegamento migliora la scansione, l'indicizzazione e la tua capacità di classificare.

Qualità del collegamento a ritroso

I backlink - collegamenti da altri siti al tuo - forniscono un voto di fiducia per il tuo sito. Dicono ai robot di ricerca che il sito Web esterno A ritiene che la tua pagina sia di alta qualità e che valga la pena eseguire la scansione. Man mano che questi voti si sommano, i robot di ricerca notano e trattano il tuo sito come più credibile. Sembra un ottimo affare, vero? Tuttavia, come con la maggior parte delle grandi cose, c'è un avvertimento. La qualità di quei backlink è molto importante.

I collegamenti da siti di bassa qualità possono effettivamente danneggiare il tuo posizionamento. Ci sono molti modi per ottenere backlink di qualità al tuo sito, come raggiungere pubblicazioni pertinenti, rivendicare menzioni non collegate, fornire pubblicazioni pertinenti, rivendicare menzioni non collegate e fornire contenuti utili a cui altri siti desiderano collegarsi.

Cluster di contenuti

Noi di HubSpot non siamo stati timidi riguardo al nostro amore per i cluster di contenuti o al modo in cui contribuiscono alla crescita organica . I cluster di contenuti collegano i contenuti correlati in modo che i robot di ricerca possano facilmente trovare, eseguire la scansione e indicizzare tutte le pagine che possiedi su un determinato argomento. Agiscono come uno strumento di autopromozione per mostrare ai motori di ricerca quanto sai su un argomento, quindi è più probabile che classifichino il tuo sito come un'autorità per qualsiasi query di ricerca correlata.

La tua classifica è il principale fattore determinante nella crescita del traffico organico perché gli studi dimostrano che gli utenti hanno maggiori probabilità di fare clic sui primi tre risultati di ricerca nelle SERP. Ma come ti assicuri cheil tuosia il risultato che viene cliccato?

Concludiamo con l'ultimo tassello della piramide del traffico organico: la cliccabilità.

Lista di controllo della cliccabilità

Mentre la percentuale di clic (CTR) ha tutto a che fare con il comportamento del ricercatore, ci sono coseche puoifare per migliorare la tua cliccabilità sulle SERP. Mentre le meta descrizioni e i titoli delle pagine con parole chiave influiscono sul CTR, ci concentreremo sugli elementi tecnici perché è per questo che sei qui.

Lista di controllo della cliccabilità

- Usa i dati strutturati.

- Ottieni funzionalità SERP.

- Ottimizza per gli snippet in primo piano.

- Considera Google Discover.

Il ranking e la percentuale di clic vanno di pari passo perché, siamo onesti, gli utenti vogliono risposte immediate. Più il tuo risultato risalta sulla SERP, più è probabile che tu ottenga il clic. Esaminiamo alcuni modi per migliorare la tua cliccabilità.

1. Usa dati strutturati.

I dati strutturati utilizzano un vocabolario specifico chiamato schema per classificare ed etichettare gli elementi sulla tua pagina web per i robot di ricerca. Lo schema chiarisce cos'è ogni elemento, come si relaziona al tuo sito e come interpretarlo. Fondamentalmente, i dati strutturati dicono ai bot: "Questo è un video", "Questo è un prodotto" o "Questa è una ricetta", senza lasciare spazio all'interpretazione .

To be clear, using structured data is not a “clickability factor” (if there even is such a thing), but it does help organize your content in a way that makes it easy for search bots to understand, index, and potentially rank your pages.

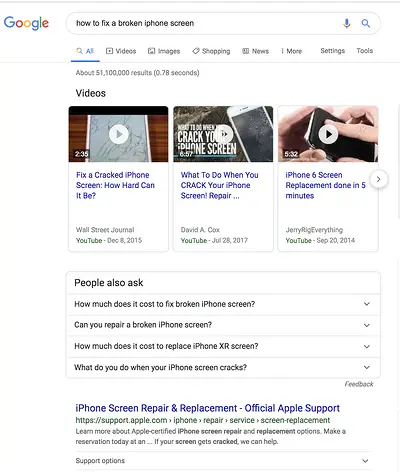

2. Win SERP features.

SERP features , otherwise known as rich results, are a double-edged sword. If you win themandget the click-through, you're golden. If not, your organic results are pushed down the page beneath sponsored ads, text answer boxes, video carousels, and the like.

Rich results are those elements that don't follow the page title, URL, meta description format of other search results. For example, the image below shows two SERP features — a video carousel and “People Also Ask” box — above the first organic result.

While you can still get clicks from appearing in the top organic results, your chances are greatly improved with rich results.

How do you increase your chances of earning rich results? Write useful content and use structured data. The easier it is for search bots to understand the elements of your site, the better your chances of getting a rich result.

Structured data is useful for getting these ( and other search gallery elements ) from your site to the top of the SERPs, thereby, increasing the probability of a click-through:

- Articles

- Videos

- Recensioni

- Events

- How-Tos

- FAQs (“People Also Ask” boxes)

- Images

- Local Business Listings

- Products

- Sitelinks

3. Optimize for Featured Snippets.

One unicorn SERP feature that has nothing to do with schema markup is Featured Snippets, those boxes above the search results that provide concise answers to search queries.

Featured Snippets are intended to get searchers the answers to their queries as quickly as possible. According to Google , providing the best answer to the searcher's query is the only way to win a snippet. However, HubSpot's research revealed a few additional ways to optimize your content for featured snippets .

4. Consider Google Discover.

Google Discover is a relatively new algorithmic listing of content by category specifically for mobile users. It's no secret that Google has been doubling down on the mobile experience; with over 50% of searches coming from mobile , it's no surprise either. The tool allows users to build a library of content by selecting categories of interest (think: gardening, music, or politics).

At HubSpot, we believe topic clustering can increase the likelihood of Google Discover inclusion and are actively monitoring our Google Discover traffic in Google Search Console to determine the validity of that hypothesis. We recommend that you also invest some time in researching this new feature. The payoff is a highly engaged user base that has basically hand-selected the content you've worked hard to create.

The Perfect Trio

Technical SEO, on-page SEO, and off-page SEO work together to unlock the door to organic traffic. While on-page and off-page techniques are often the first to be deployed, technical SEO plays a critical role in getting your site to the top of the search results and your content in front of your ideal audience. Use these technical tactics to round out your SEO strategy and watch the results unfold.