WordPress robots.txt

Pubblicato: 2019-02-26WordPress robots.txt è molto importante per la SEO. Per essere sicuro che il tuo sito sia ben posizionato nei risultati dei motori di ricerca, devi rendere le sue pagine più importanti convenienti per la ricerca e l'indicizzazione dei "robot" ("bot") dei motori di ricerca. Un file robots.txt ben strutturato aiuterà a indirizzare questi robot alle pagine che desideri indicizzare.

In questo articolo riveleremo tali domande:

- Che cos'è un file robots.txt e perché è importante

- Posizione del file txt dei robot di WordPress

- I migliori robot txt per WordPress

- Come creare un file robots.txt

- Come controllare il file robots.txt e inviarlo alla console di ricerca di Google.

Che cos'è un file robots.txt per WordPress e perché è importante?

Quando crei un nuovo sito Web, i motori di ricerca invieranno i loro robot per eseguire la scansione e creare una mappa di tutte le sue pagine. In questo modo, sapranno quali pagine mostrare come risultato quando qualcuno cerca parole chiave pertinenti. A livello di base, questo è abbastanza semplice (controlla anche questo utile post – File .htaccess predefinito di WordPress).

Il problema è che i siti Web moderni contengono molti altri elementi oltre alle pagine. WordPress ti consente di installare, ad esempio, plugin che spesso hanno le proprie directory. Non è necessario mostrarlo nei risultati di ricerca, poiché non corrispondono al contenuto.

Quello che fa il file robots.txt è fornire una serie di linee guida per i robot di ricerca. Dice loro: “Guardate qui e indicizzate queste pagine, ma non entrate in altre aree!”. Questo file può essere dettagliato quanto vuoi ed è molto facile da creare, anche se sei un principiante.

In pratica, i motori di ricerca eseguiranno comunque la scansione del tuo sito, anche se non crei un file robots.txt. Tuttavia, non crearlo è un passaggio molto irrazionale. Senza questo file, lasci ai robot l'indicizzazione di tutto il contenuto del tuo sito e decidono che devi mostrare tutte le parti del tuo sito, anche quelle che vorresti nascondere all'accesso pubblico (inoltre, controlla i migliori plugin per eCommerce di WordPress ).

Un punto più importante, senza un file robots.txt, il tuo sito web riceverà molti accessi dai robot del tuo sito. Ciò influenzerà negativamente le sue prestazioni. Anche se la presenza del tuo sito è ancora ridotta, la velocità di caricamento della pagina è qualcosa che dovrebbe essere sempre prioritario e al massimo livello. Alla fine, ci sono solo alcune cose che alle persone non piacciono più del caricamento lento dei siti web.

Posizione del file txt dei robot di WordPress

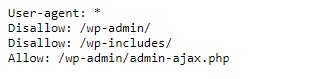

Quando crei un sito Web WordPress, un file robots.txt viene creato automaticamente e posizionato nella tua directory principale sul server. Ad esempio, se il tuo sito si trova qui – wpdevart.com, puoi trovarlo su wpdevart.com/robots.txt e vedere qualcosa del genere:

Questo è un esempio del file robots.txt più semplice. Traducendo in un linguaggio leggibile dall'uomo, il lato destro dopo lo User-agent: dichiara

per quali robot ci sono le regole. Un asterisco significa che la regola è universale e si applica a tutti i robot. In questo caso, il file dice ai robot che non possono eseguire la scansione delle directory wp-admin e wp-includes. Il significato di queste regole è che queste directory contengono molti file che richiedono protezione dall'accesso pubblico (controlla anche il nostro plugin WordPress Countdown).

Naturalmente, puoi aggiungere più regole al tuo file. Prima di farlo, devi capire che questo è un file virtuale. Di solito, WordPress robots.txt si trova nella directory principale, che viene spesso chiamata public_html o www (o con il nome del tuo sito web):

Va notato che il file robots.txt per WordPress, creato per impostazione predefinita, non è accessibile da nessuna directory. Funziona, ma se vuoi apportare modifiche, devi creare il tuo file e caricarlo nella directory principale.

Vedremo diversi modi per creare un file robots.txt per WordPress. Ora discutiamo come determinare quali regole includere nel file.

I migliori robot txt per WordPress

Non è così difficile creare i migliori robot txt per il tuo sito Web WordPress. Quindi quali regole devono essere incluse nel file robots.txt. Nella sezione precedente, abbiamo visto un esempio di un file robots.txt generato da WordPress. Include solo due brevi regole, ma per la maggior parte dei siti sono sufficienti. Diamo un'occhiata a due diversi file robots.txt e vediamo cosa fa ciascuno.

Ecco il nostro primo esempio di file robots.txt di WordPress:

User-agent: * Allow: / # Disallowed Sub-Directories Disallow: / payout / Disallow: / photos / Disallow: / forums /Questo file robots.txt è stato creato per il forum. I motori di ricerca di solito indicizzano ogni thread del forum. A seconda dell'argomento del tuo forum, potresti voler disattivare l'indicizzazione. Ad esempio, Google non indicizzerà centinaia di brevi discussioni degli utenti. Puoi anche impostare regole che puntano a uno specifico thread del forum per escluderlo e consentire ai motori di ricerca di indicizzare il resto.

Si nota anche una riga che inizia con Consenti: / nella parte superiore del file. Questa riga indica ai robot che possono eseguire la scansione di tutte le pagine del tuo sito, ad eccezione delle restrizioni stabilite di seguito. Hai anche notato che abbiamo impostato queste regole in modo che siano universali (con un asterisco), come nel file robots.txt di WordPress virtuale (inoltre, puoi controllare il nostro plug-in per la tabella dei prezzi di WordPress).

Diamo un'occhiata a un altro esempio di file robots.txt di WordPress:

User-agent: * Disallow: / wp-admin / Disallow: / wp-includes / User-agent: Bingbot Disallow: /In questo file impostiamo le stesse regole che vanno a WordPress per impostazione predefinita. Anche se stiamo aggiungendo anche una nuova serie di regole che impediscono ai robot di ricerca di Bing di eseguire la scansione del nostro sito. Bingbot, come puoi vedere, è il nome del robot.

Puoi anche digitare i nomi di altri motori di ricerca per limitare/consentire l'accesso. In pratica, ovviamente, Bingbot è molto buono (anche se non buono come Googlebot). Tuttavia, ci sono molti robot dannosi.

La cattiva notizia è che non sempre seguono le istruzioni nel file robots.txt (funzionano ancora come terroristi). Va tenuto presente che, sebbene la maggior parte dei robot utilizzerà le istruzioni fornite in questo file, non è possibile forzarli a farlo.

Se approfondisci l'argomento, troverai molti suggerimenti su cosa consentire e cosa bloccare sul tuo sito WordPress. Anche se, dalla nostra esperienza, spesso meno regole sono meglio. Ecco un esempio di

i migliori robot txt per il sito Web WordPress, ma per siti Web diversi può essere diverso:

User-agent: * Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Disallow: *utm*= Disallow: *openstat= Allow: */uploads Sitemap: https://wpdevart.com/sitemap.xmlTradizionalmente a WordPress piace chiudere le directory wp-admin e wp-includes. Tuttavia, questa non è più la soluzione migliore. Inoltre, se aggiungi meta tag per le tue immagini a scopo di promozione (SEO), non ha senso dire ai robot di non indicizzare i contenuti di queste directory.

Cosa dovrebbe contenere il tuo file robots.txt dipenderà dalle esigenze del tuo sito. Quindi sentiti libero di fare più ricerche!

Come creare un file robots.txt

Cosa potrebbe essere più semplice della creazione di un file di testo (txt). Tutto quello che devi fare è aprire il tuo editor preferito (come Blocco note o TextEdit) e inserire alcune righe. Quindi salvi il file utilizzando robots e l'estensione txt (robots.txt). Ci vorranno alcuni secondi, quindi potresti voler creare un robots.txt per WordPress senza utilizzare un plug-in.

Abbiamo salvato questo file localmente sul computer. Una volta creato il tuo file devi connetterti al tuo sito tramite FTP (magari con FileZilla).

Dopo esserti connesso al tuo sito, vai alla directory public_html. Ora, tutto ciò che devi fare è caricare il file robots.txt dal tuo computer al server. Puoi farlo sia facendo clic con il tasto destro del mouse sul file nel navigatore FTP locale o semplicemente trascinandolo con il mouse.

Ci vogliono solo pochi secondi. Come puoi vedere, questo metodo è più semplice rispetto all'utilizzo del plug-in.

Come controllare WordPress robots.txt e inviarlo alla Google Search Console

Dopo che il file robots.txt di WordPress è stato creato e caricato, puoi verificare la presenza di errori in Google Search Console. Search Console è un insieme di strumenti Google progettati per aiutarti a tenere traccia di come vengono visualizzati i tuoi contenuti nei risultati di ricerca. Uno di questi strumenti controlla robots.txt, lo troverai facilmente nella pagina di amministrazione degli strumenti per i webmaster di Google (controlla anche i 50 migliori plugin per WordPress 2020).

Lì troverai il campo dell'editor in cui puoi aggiungere il codice per il tuo file robots.txt di WordPress e fare clic su Invia nell'angolo in basso a destra. La console di ricerca di Google ti chiederà se desideri utilizzare il nuovo codice o scaricare un file dal tuo sito web.

Ora la piattaforma verificherà la presenza di errori nel tuo file. Se viene rilevato un errore, ti verranno mostrate informazioni al riguardo. Hai visto alcuni esempi del file robots.txt di WordPress e ora hai ancora più possibilità di creare il tuo file robots.txt perfetto!