インターネットを使用せずにオープンソース LLM をローカル環境にインストールするためのステップバイステップ ガイド

公開: 2023-12-20まとめ

急速に進歩する AI の世界では、FALCON のような大規模言語モデル(LLM) をローカル システム内にインストールすると、独特の課題と機会が生じます。 このガイドは、厳格なデータ プライバシーとセキュリティを維持しながら最適なパフォーマンスを達成することに重点を置き、FALCON オープンソース LLM をセットアップする重要な手順を説明するように設計されています。

著名なオープンソースの大規模言語モデル (LLM) である FALCON のローカル展開に着手し、最高のパフォーマンスと堅牢なセキュリティを確保します。 この包括的なガイドでは、ハードウェアの前提条件、ソフトウェアのインストール、データ トレーニングについて説明するとともに、定期的なテスト、メンテナンス、スケーラビリティの考慮事項、コスト分析の重要性を強調しています。 より広い視野で、トップ 5 のオープンソース LLMに関する情報を常に入手し、厳格なデータ プライバシー基準を維持しながら AI の力を活用できる安全な実装のための Creole Studiosの専門知識の活用を検討してください。

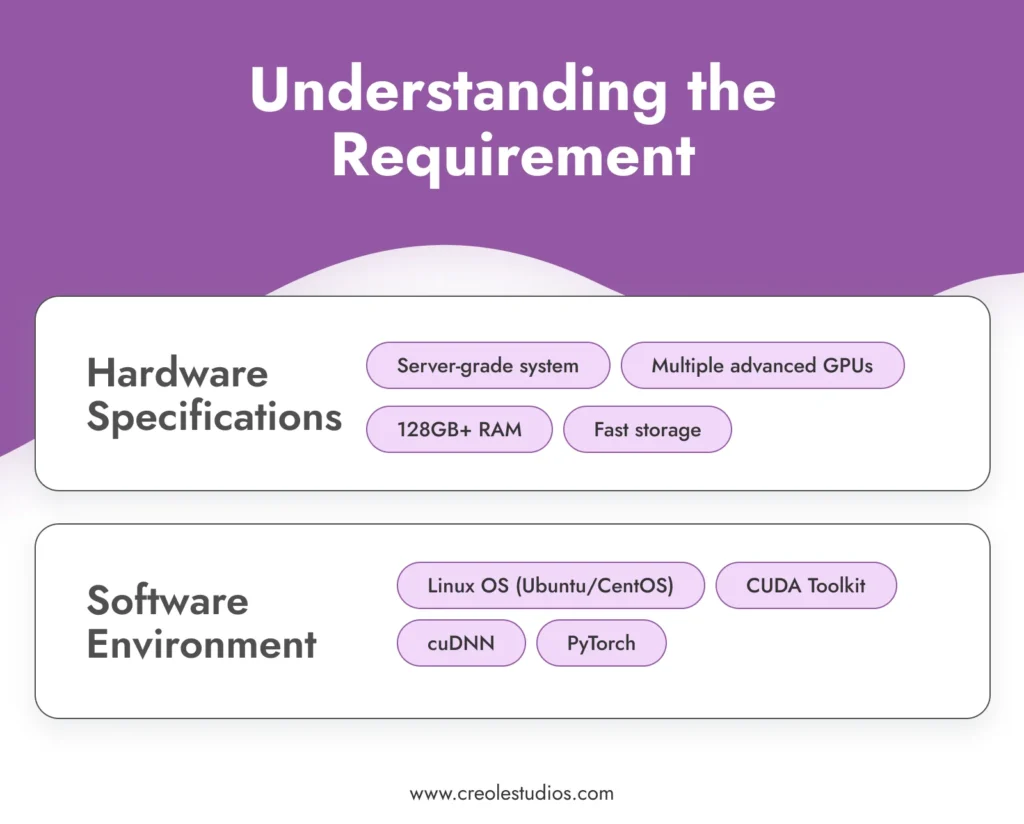

要件を理解する

インストールプロセスに入る前に、FALCON のような洗練されたモデルを実行するための要件を理解することが重要です。

- ハードウェア仕様: FALCON は 1,800 億もの膨大なパラメータを備えており、大量の計算リソースを必要とします。 これには、通常、モデルを管理するための複数の高度な GPU (NVIDIA A100 など)、大量の RAM (128GB 以上)、および高速ストレージ ソリューション (SSD または NVMe) を備えたサーバー グレードのシステムが必要となる、高性能コンピューティング環境が必要になります。効率的にデータを取得します。 AI および ML 環境のセットアップについては、NVIDIA のガイドラインを参照してください。

- ソフトウェア環境: FALCON を効果的に実行するには、安定した互換性のあるソフトウェア環境が必要です。 Ubuntu や CentOS などの Linux ベースのオペレーティング システムは、優れた GPU サポートと必須ツールやライブラリとの互換性を備えているため推奨されます。 ソフトウェア スタックには、GPU アクセラレーション用の CUDA ツールキット、ディープ ニューラル ネットワーク用の cuDNN、PyTorch などの機械学習フレームワークが含まれています。

モデルを取得する

次のステップは、FALCON モデルを取得することです。 これには次のことが関係する可能性があります。

- モデルのライセンス: FALCON の最新の可用性とライセンス オプションを確認します。 FALCON のようなモデルのライセンスには、通常、モデルを使用する法的権利があることを保証するための交渉と合意が必要です。 アップデートやライセンスの詳細については、公式 FALCON リポジトリまたは関連する AI モデル マーケットプレイスに注目してください。

- モデルの転送: セットアップのエアギャップの性質を考慮すると、モデルをローカル環境に転送することは重要な手順です。 これには、安全な暗号化されたストレージ デバイスを使用してモデルを物理的に転送することが含まれる場合があります。 この転送中のモデルの整合性とセキュリティが最も重要です。

インフラストラクチャのセットアップ

FALCON LLM を効率的に運用するには、堅牢なインフラストラクチャを確立することが極めて重要です。

- サーバー構成: 高強度の AI ワークロードに合わせてサーバーを最適化します。 これには、並列処理用に複数の GPU を構成すること、システム内で高帯域幅のネットワークを確保すること、熱出力を管理するための効果的な冷却ソリューションを実装することが含まれます。

- ストレージ管理: FALCON のサイズと、扱うことになる潜在的に大規模なデータセットを考慮して、ストレージ アーキテクチャを慎重に計画してください。 速度の観点から、大容量 SSD または NVMe ドライブをお勧めします。 冗長性とバックアップ システムが導入されていることを確認してください。

- 電源と冷却: これらの強力なサーバーには、適切な電源と冷却システムが必要です。 インフラストラクチャがこれらの要件に対応できることを確認してください。 このセットアップを維持できるデータセンターを設計するには、ハードウェアの専門家に相談することをお勧めします。

必要なソフトウェアをインストールする

ソフトウェアのインストールは、オープンソース LLM を設定する際の重要な手順です。

- オペレーティング システムのセットアップ: 選択した Linux ディストリビューションをインストールします。 Ubuntu と CentOS は、安定性とサポートの点で人気のある選択肢です。 ハードウェア リソースを最適に使用するように OS が構成されていることを確認します。

- 依存関係のインストール: GPU サポート用の CUDA Toolkit、深層学習機能用の cuDNN、および機械学習フレームワークとしての PyTorch をインストールします。 FALCON モデルと互換性のあるバージョンを使用していることを確認してください。

- セキュリティ ソフトウェア: エアギャップ環境では、内部セキュリティが鍵となります。 堅牢なファイアウォールと侵入検知システムをインストールします。 システムが分離されていても、内部の脅威や偶発的な侵害が発生する可能性があります。

モデルのインストール

FALCON モデルのインストールには、いくつかの手順が必要です。

- モデル転送: 暗号化されたストレージ デバイスを使用して、モデル ファイルをローカル システムに安全に転送します。

- インストール手順: FALCON が提供するインストールガイドに従ってください。 これには通常、環境変数の設定、モデル ファイルのロード、およびモデル パラメーターの構成が含まれます。

- 検証: インストール後に、インストールの整合性を検証します。 モデル ファイルが損なわれていないこと、およびモデルが初期診断を正しく実行していることを確認してください。

データセキュリティとコンプライアンス

エアギャップ環境でデータのセキュリティを確保するには、いくつかの保護層が必要です。

- 暗号化: すべてのデータは、保存中およびネットワーク内での転送中の両方で暗号化される必要があります。 強力な暗号化プロトコルを実装してデータを保護します。

- コンプライアンス: 関連するデータ保護規制および業界標準を遵守します。 システムのコンプライアンスを定期的に監査します。

- アクセス制御: 厳格なアクセス制御ポリシーを実装します。 許可された担当者のみがモデルとデータにアクセスできるようにする必要があります。

厳選されたデータを使用してモデルをトレーニングする

FALCON を特定のニーズに合わせて調整するには、厳選されたデータを使用して FALCON をトレーニングすることが不可欠です。

- データの収集と準備: ユースケースに関連するデータを収集します。 このデータは、代表的で、多様性があり、高品質である必要があります。 データがトレーニングに適していることを確認するために、データを前処理してクリーンアップします。

- トレーニング プロセス: 目的に合わせて FALCON のトレーニング パラメーターを設定します。 FALCON のようなモデルをトレーニングするには、機械学習の原理とモデル アーキテクチャの詳細を深く理解する必要があります。

- 監視と調整: トレーニング プロセスのパフォーマンスと精度を継続的に監視します。 望ましい結果を達成するために、必要に応じてトレーニング データやパラメーターを調整できるように準備してください。

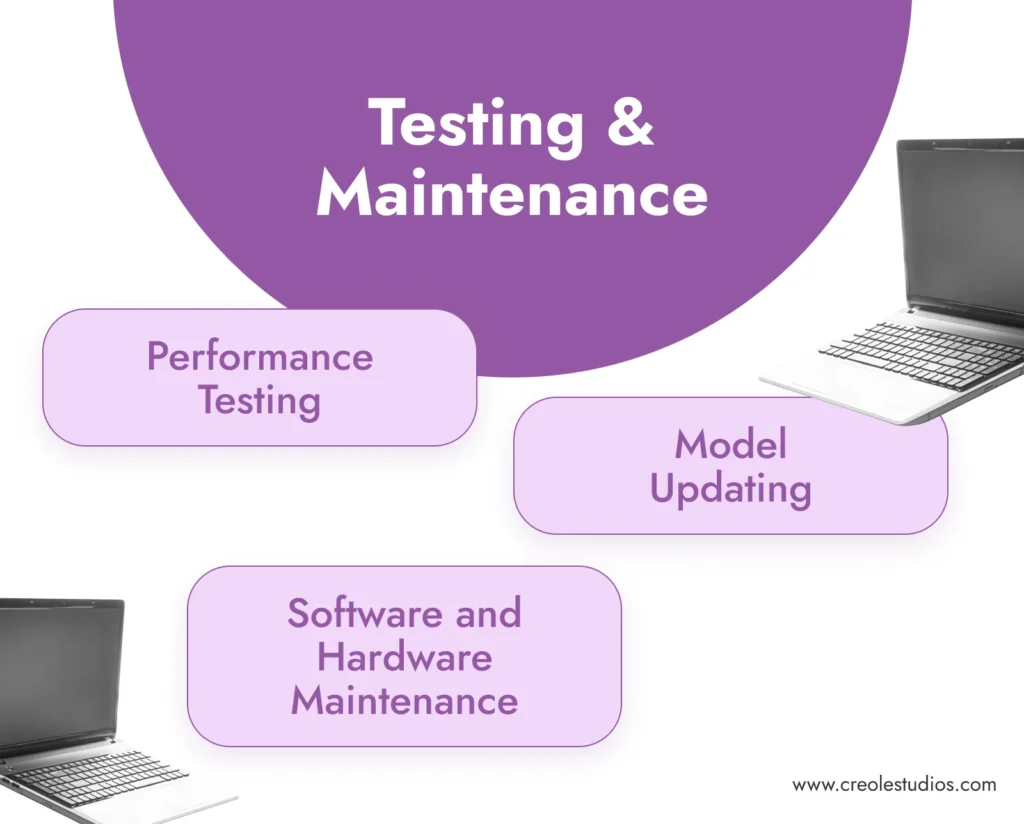

テストとメンテナンス

モデルの長期的な成功には、定期的なテストとメンテナンスが重要です。

- パフォーマンス テスト: モデルの精度と効率を定期的にテストします。 これには、検証データセットを実行し、モデルの出力の一貫性と品質をチェックすることが含まれます。

- ソフトウェアとハードウェアのメンテナンス: ソフトウェア環境を定期的に更新し、パッチを適用します。 冷却システムの管理、電源のチェック、故障したコンポーネントの交換など、ハードウェアが効率的に動作するようにメンテナンスを行います。

- モデルの更新: FALCON モデルの最新情報を入手します。 エアギャップ環境では、モデルを更新するには、更新されたモデル ファイルを手動で転送する必要がある場合があります。

スケーラビリティとコスト

将来の成長とセットアップのコストへの影響を考慮してください。

- スケーラビリティ計画: インフラストラクチャの潜在的なスケーリングを計画します。 これには、GPU の追加、ストレージの拡張、エアギャップ環境内のネットワーク容量の強化などが含まれる場合があります。

- コスト分析: FALCON の保守と運用にかかるコストを定期的に確認します。 これには、ハードウェアのコスト、エネルギー消費、ライセンス料が含まれます。

最終メモ: オープンソース LLM と Creole Studios の専門知識の重要性

FALCON のようなオープンソース LLM をローカルにインストールすると、比類のないデータ プライバシー、カスタマイズ、AI 機能の制御など、大きなメリットが得られます。 これにより、企業は AI の力を活用しながら、機密データを安全なプライベート ネットワークの範囲内に確実に保持できるようになります。

Creole Studios は、ローカルのエアギャップ環境でオープンソース LLM をセットアップおよび保守する複雑なプロセスでクライアントを支援することに優れています。 当社の専門知識により、スムーズで安全かつ効果的な導入が保証され、最高水準のデータ プライバシーとセキュリティを維持しながら、企業が AI の可能性を最大限に活用できるようになります。 私たちのサポートにより、企業は自信を持って AI 導入の課題に対処し、急速に進化する技術情勢の中で優位に立つことができます。