WordPress robots.txt

公開: 2019-02-26WordPressrobots.txtはSEOにとって非常に重要です。 あなたのサイトが検索エンジンの結果でうまくランク付けされることを確実にするために、あなたはその最も重要なページを検索エンジンの「ロボット」(「ボット」)の検索と索引付けに便利にする必要があります。 適切に構造化されたrobots.txtファイルは、これらのボットをインデックスに登録するページに誘導するのに役立ちます。

この記事では、そのような質問を明らかにします。

- robots.txtファイルとは何ですか?なぜそれが重要なのですか

- WordPressロボットのtxtの場所

- WordPressに最適なロボットtxt

- robots.txtファイルを作成する方法

- robots.txtファイルを確認してGoogle検索コンソールに送信する方法。

WordPressのrobots.txtファイルとは何ですか?なぜそれが重要なのですか?

新しいWebサイトを作成すると、検索エンジンはロボットを送信して、すべてのページのマップをスキャンして作成します。 このようにして、誰かが関連するキーワードを検索したときに結果として表示するページを知ることができます。 基本的なレベルでは、これは非常に簡単です(また、この便利な投稿– WordPressのデフォルトの.htaccessファイルを確認してください)。

問題は、最近のWebサイトには、ページ以外にも多くの要素が含まれていることです。 WordPressを使用すると、たとえば、独自のディレクトリを持つことが多いプラグインをインストールできます。 コンテンツと一致しないため、検索結果に表示する必要はありません。

robots.txtファイルが行うことは、検索ロボットの一連のガイドラインを提供することです。 彼は彼らにこう言います:「ここを見て、このページに索引を付けてください、しかし他の領域には入らないでください!」。 このファイルは必要に応じて詳細にすることができ、初心者でも非常に簡単に作成できます。

実際には、robots.txtファイルを作成しなくても、検索エンジンはサイトをスキャンします。 ただし、それを作成しないことは非常に不合理なステップです。 このファイルがないと、ロボットにサイトのすべてのコンテンツのインデックスを作成させ、公開アクセスから隠したいものも含めて、サイトのすべての部分を表示する必要があると判断します(また、–最高のWordPresseコマースプラグインを確認してください) )。

さらに重要な点は、robots.txtファイルがないと、Webサイトはサイトのロボットから多くのヒットを得ることになります。 これは、そのパフォーマンスに悪影響を及ぼします。 サイトの出席者がまだ少ない場合でも、ページの読み込み速度は常に優先され、最高レベルである必要があります。 結局、人々がゆっくりとウェブサイトをロードすること以上に嫌いなことはほんのわずかです。

WordPressロボットのtxtの場所

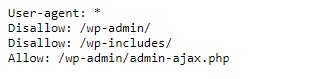

WordPress Webサイトを作成すると、robots.txtファイルが自動的に作成され、サーバーのメインディレクトリに配置されます。 たとえば、サイトがここ(wpdevart.com)にある場合は、wpdevart.com / robots.txtにあり、次のように表示されます。

これは、最も単純なrobots.txtファイルの例です。 人間が読める言語に翻訳すると、User-agent:が宣言した後の右側

どのロボットのルールがありますか。 アスタリスクは、ルールが普遍的であり、すべてのロボットに適用されることを意味します。 この場合、ファイルはロボットにwp-adminおよびwp-includesディレクトリをスキャンできないことを通知します。 これらのルールの意味は、これらのディレクトリには、パブリックアクセスからの保護を必要とする多くのファイルが含まれていることです(また、WordPressカウントダウンプラグインを確認してください)。

もちろん、ファイルにルールを追加することもできます。 これを行う前に、これが仮想ファイルであることを理解する必要があります。 通常、WordPress robots.txtはルートディレクトリにあります。ルートディレクトリは、public_htmlまたはwww(またはWebisteの名前)と呼ばれることがよくあります。

デフォルトで作成されたWordPressのrobots.txtファイルには、どのディレクトリからもアクセスできないことに注意してください。 動作しますが、変更を加える場合は、独自のファイルを作成してルートディレクトリにアップロードする必要があります。

WordPress用のrobots.txtファイルを作成するいくつかの方法を見ていきます。 次に、ファイルに含めるルールを決定する方法について説明します。

WordPressに最適なロボットtxt

WordPressWebサイトに最適なロボットtxtを作成することはそれほど難しくありません。 したがって、robots.txtファイルに含める必要のあるルールは何ですか。 前のセクションでは、WordPressによって生成されたrobots.txtファイルの例を見ました。 短いルールは2つしか含まれていませんが、ほとんどのサイトでは十分です。 2つの異なるrobots.txtファイルを見て、それぞれが何をするかを見てみましょう。

WordPressrobots.txtファイルの最初の例を次に示します。

User-agent: * Allow: / # Disallowed Sub-Directories Disallow: / payout / Disallow: / photos / Disallow: / forums /このrobots.txtファイルはフォーラム用に作成されています。 検索エンジンは通常、すべてのフォーラムスレッドにインデックスを付けます。 フォーラムのトピックによっては、インデックス作成を禁止することをお勧めします。 たとえば、Googleは何百もの短いユーザーディスカッションをインデックスに登録しません。 また、特定のフォーラムスレッドを指すルールを設定して除外し、検索エンジンが残りのスレッドにインデックスを付けることができるようにすることもできます。

また、ファイルの先頭にAllow:/で始まる行があります。 この行は、以下に設定されている制限を除いて、サイトのすべてのページをスキャンできることをロボットに通知します。 また、仮想WordPress robots.txtファイルにあるように(アスタリスクを付けて)これらのルールをユニバーサルに設定していることにも気づきました(また、WordPress Pricingテーブルプラグインを確認できます)。

別のサンプルWordPressrobots.txtファイルをチェックしてみましょう:

User-agent: * Disallow: / wp-admin / Disallow: / wp-includes / User-agent: Bingbot Disallow: /このファイルでは、デフォルトでWordPressに適用されるのと同じルールを設定します。 ただし、Bing検索ロボットがサイトをクロールするのをブロックする新しいルールセットも追加しています。 ご覧のとおり、Bingbotはロボットの名前です。

他の検索エンジン名を入力して、それらのアクセスを制限/許可することもできます。 もちろん、実際には、Bingbotは非常に優れています(Googlebotほど優れていなくても)。 しかし、悪意のあるロボットはたくさんいます。

悪いニュースは、robots.txtファイルの指示に常に従うとは限らないことです(彼らは依然としてテロリストのように機能します)。 ほとんどのロボットはこのファイルで提供されている指示を使用しますが、強制することはできないことに注意してください。

トピックをさらに深く掘り下げると、WordPressサイトで何を許可し何をブロックするかについて多くの提案が見つかります。 ただし、私たちの経験から、多くの場合、ルールは少ない方が良いです。 これがその例です

WordPress Webサイトに最適なrobotstxtですが、Webサイトが異なれば異なる場合があります。

User-agent: * Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Disallow: *utm*= Disallow: *openstat= Allow: */uploads Sitemap: https://wpdevart.com/sitemap.xml従来、WordPressはwp-adminおよびwp-includesディレクトリを閉じるのが好きです。 ただし、これはもはや最善の解決策ではありません。 さらに、プロモーション(SEO)の目的で画像にメタタグを追加する場合、これらのディレクトリのコンテンツにインデックスを付けないようにロボットに指示しても意味がありません。

robots.txtファイルを含める必要があるのは、サイトのニーズによって異なります。 だから、もっと研究をしてください!

robots.txtを作成する方法

テキストファイル(txt)を作成するよりも簡単なことは何でしょうか。 お気に入りのエディター(メモ帳やテキストエディットなど)を開いて、数行入力するだけです。 次に、robotsとtxt拡張子(robots.txt)を使用してファイルを保存します。 数秒かかるため、プラグインを使用せずにWordPress用のrobots.txtを作成することをお勧めします。

このファイルをコンピューターにローカルに保存しました。 独自のファイルを作成したら、FTP経由で(おそらくFileZillaを使用して)サイトに接続する必要があります。

サイトに接続したら、public_htmlディレクトリに移動します。 これで、robots.txtファイルをコンピューターからサーバーにアップロードするだけです。 これを行うには、ローカルFTPナビゲーターでファイル上でマウスの右ボタンをクリックするか、マウスを使用してファイルをドラッグします。

ほんの数秒で完了します。 ご覧のとおり、この方法はプラグインを使用するよりも簡単です。

WordPressrobots.txtを確認してGoogle検索コンソールに送信する方法

WordPress robots.txtファイルを作成してアップロードした後、Google検索コンソールでエラーを確認できます。 検索コンソールは、コンテンツが検索結果にどのように表示されるかを追跡するのに役立つように設計されたGoogleツールのセットです。 これらのツールの1つはrobots.txtをチェックし、Googleウェブマスターツールの管理ページで簡単に見つけることができます(また、50のベストWordPressプラグイン2020もチェックしてください)。

そこに、WordPress robots.txtファイルのコードを追加できるエディターフィールドがあり、右下隅にある[送信]をクリックします。 Google検索コンソールは、新しいコードを使用するか、Webサイトからファイルをダウンロードするかを尋ねてきます。

これで、プラットフォームはファイルのエラーをチェックします。 エラーが見つかった場合は、これに関する情報が表示されます。 WordPressのrobots.txtファイルの例をいくつか見てきましたが、今では完璧なrobots.txtファイルを作成するチャンスがさらに増えています。