Pig: Apache Hadoop을 위한 고급 플랫폼

게시 됨: 2023-02-22Pig는 Apache Hadoop에서 실행되는 프로그램을 만들기 위한 고급 플랫폼입니다. "Pig"라는 용어는 플랫폼의 인프라 계층을 의미하며 컴파일러 및 실행 환경과 일련의 고급 연산자로 구성됩니다. Pig의 인프라 계층은 개발자가 Pig 프로그램을 생성, 유지 및 실행할 수 있는 일련의 도구를 제공합니다. Pig는 Apache Hadoop 생태계 의 일부인 오픈 소스 프로젝트입니다. Pig의 프로그래밍 모델은 데이터 흐름을 기반으로 하므로 많은 양의 데이터를 처리하는 프로그램을 쉽게 작성할 수 있습니다. Pig 프로그램은 유향 비순환 그래프에서 실행되는 일련의 연산자로 구성됩니다. Pig는 확장 가능하고 효율적이며 사용하기 쉽기 때문에 대량의 데이터를 처리하는 데 적합합니다.

NoSQL 솔루션으로서 데이터를 분석하고 액세스하려면 미리 정의된 특정 방법이 필요합니다. SQL(UNION, INTERSECT 등)은 빅데이터 세계에서 자주 사용되지 않는 일반적인 쿼리 표현식입니다. Hive는 배치 및 빅 데이터 처리에 최적화되어 있으므로 모든 행을 터치하는 것이 가장 좋습니다. Hive는 규모의 이점이 있는 Hadoop보다 운영에 훨씬 적은 시간과 비용을 사용합니다. 개발 시스템의 작은 쿼리도 RDBMS의 유사한 쿼리보다 ORDERS가 훨씬 느릴 수 있습니다. Hive는 쿼리 결과를 캐시하지 않습니다. 반복 쿼리를 다시 제출하는 것은 MapReduce에서 일반적인 관행입니다.

Hive에는 두 가지 유형이 있습니다. 1) Hive는 데이터베이스가 아닙니다. 오히려 쿼리 데이터에 특정한 SQL 부분을 지원하는 쿼리 엔진입니다. b) Hive는 SQL을 지원하는 데이터베이스입니다. c) Hive는 SQL 관련 데이터베이스입니다. Hive는 무엇보다도 Pig와 Python을 포함하는 Hadoop용 SQL 기반 데이터 웨어하우스 시스템입니다. Hive는 Hadoop 데이터를 저장하는 데 사용됩니다.

돼지는 Sql입니까?

이 질문에 대한 답은 개인의 의견에 따라 다르기 때문에 옳고 그른 답은 없습니다. 어떤 사람들은 pig가 sql이라고 믿을 수 있지만 다른 사람들은 그렇지 않을 수 있습니다. 궁극적으로 pig가 sql인지 여부를 결정하는 것은 개인의 몫입니다.

오늘날 Apache Hive 와 Pig는 빠르게 빅 데이터와 동의어가 되고 있는 두 가지 용어입니다. 이러한 도구를 통해 데이터 개발자와 분석가는 이를 사용하여 높은 수준의 데이터 무결성을 유지하면서 MapReduce의 복잡성을 줄일 수 있습니다. Hive는 ETL(추출, 로드 및 변환) 도구라고도 하는 데이터 웨어하우스 인프라입니다. Apache Hive, Pig 및 SQL은 데이터 분석 및 관리에 널리 사용되는 세 가지 도구입니다. 귀하의 필요에 가장 적합한 플랫폼이 무엇인지, 얼마나 자주 사용해야 하는지 알고 있어야 합니다. 이 세 가지 기술의 맥락에서 Hive, Pig 및 SQL을 사용하는 세 가지 방법을 살펴보겠습니다. SQL은 Apache Hive 및 Apache Pig의 우세에도 불구하고 여전히 빅 데이터 관리 및 분석 분야에서 왕입니다. 각각은 특정 기능을 수행하기 때문에 해당 요구 사항은 비즈니스에 맞게 조정됩니다. Apache Pig는 스크립트를 기반으로 하며 특별한 지식이 필요한 반면 Apache Hive는 개발자 고유의 유일한 데이터베이스 솔루션입니다.

돼지는 유연성이 뛰어난 다재다능한 동물입니다. 예를 들어 Pig는 JSON 또는 XML 데이터가 포함된 로그 파일을 처리하여 데이터를 읽을 수 있습니다. 웹 서비스의 데이터를 Pig에 저장하는 것도 가능합니다.

지도 데이터 유형, 튜플 및 백 데이터 유형은 상호 교환하여 사용할 수 있습니다. 모든 소스의 데이터를 처리할 수 있습니다.

Pig는 ETL 도구입니까?

ETL 도구를 정의하는 방법에 따라 달라지므로 이 질문에 대한 확실한 대답은 없습니다. 일반적으로 ETL 도구는 하나 이상의 소스에서 데이터를 추출하여 대상 시스템과 호환되는 형식으로 변환하고 해당 시스템에 로드하는 데 도움이 되는 소프트웨어 애플리케이션입니다. 어떤 사람들은 pig가 이러한 모든 기능을 수행할 수 있기 때문에 ETL 도구라고 말할 것입니다. 다른 사람들은 pig가 데이터 변환을 위해 특별히 설계되지 않았기 때문에 ETL 도구가 아니라고 주장할 수 있습니다. 궁극적으로 이 질문에 대한 대답은 ETL 도구에 대한 자체 정의에 따라 다릅니다.

ETL 처리에 돼지를 어떻게 사용할 수 있습니까?

Pig 애플리케이션은 프로세스가 개체에서 데이터를 추출하고 규칙 집합에 따라 데이터 저장소로 변환하는 방법을 설명하는 ETL 트랜잭션 모델로 설명할 수 있습니다. 사용자는 파일, 스트림 및 기타 소스에서 데이터를 수집하기 위해 Pig의 사용자 정의 함수(UDF)를 정의합니다.

돼지 도구는 무엇입니까?

Pig로 알려진 플랫폼 또는 도구는 대규모 데이터 세트를 처리합니다. 이 라이브러리에는 MapReduce 프로세스에서 데이터를 처리하기 위한 높은 수준의 추상화가 포함되어 있습니다. Pig Latin은 데이터 분석 코드를 개발하기 위해 코딩 프로세스에 사용되는 고급 스크립팅 언어입니다.

돼지와 Sql의 차이점은 무엇입니까?

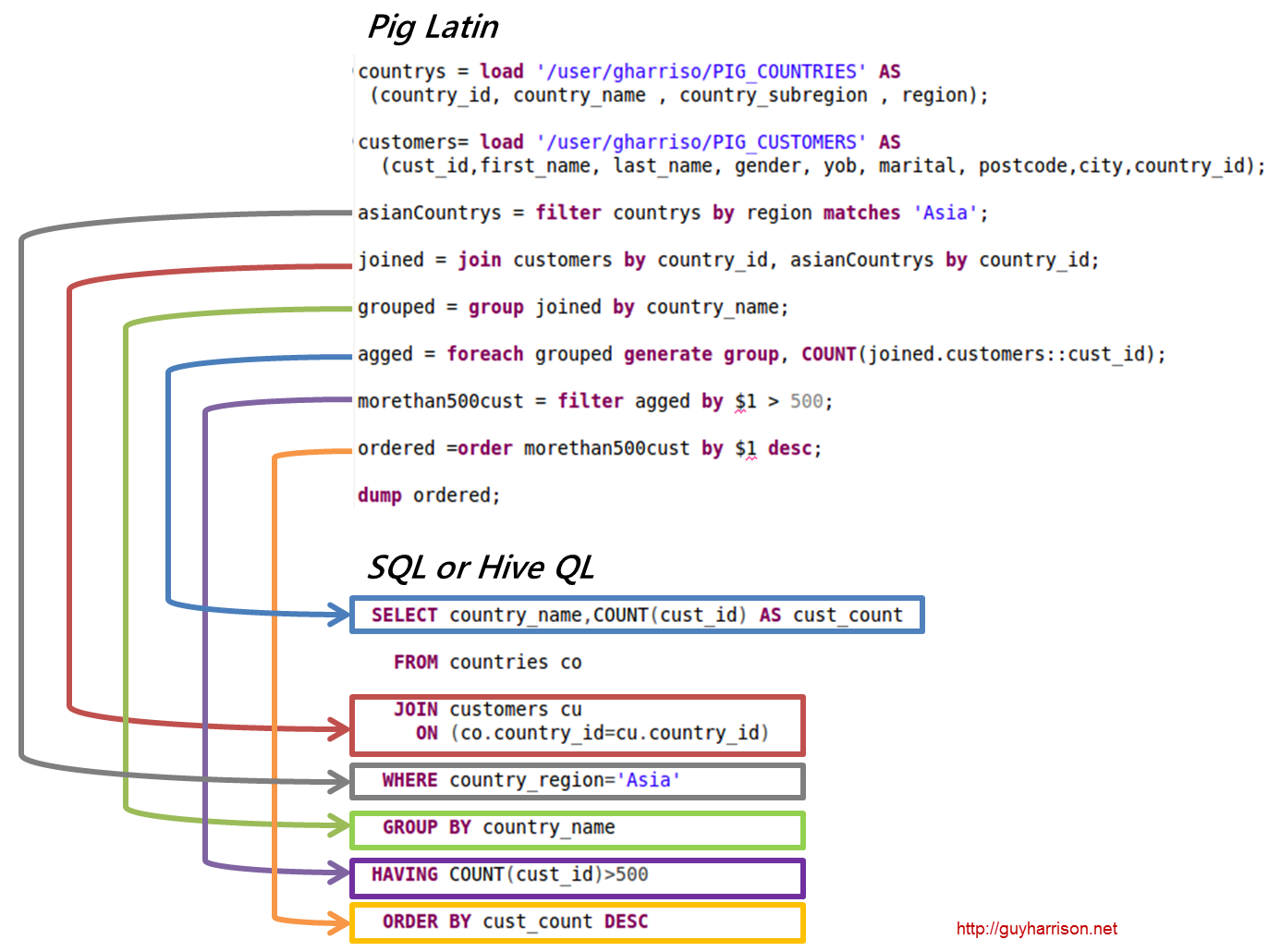

SQL Pig Latin 및 Apache Pig는 절차적 언어입니다. SQL은 본질적으로 선언적인 스크립팅 언어입니다. 스키마 사용 여부는 전적으로 Apache Pig에 달려 있습니다. 데이터는 스키마 없이도 저장할 수 있습니다(값 유형은 $, $ 등에 저장됨).

Pig는 Hadoop의 일부입니까?

Pig Hadoop 애플리케이션은 대규모 데이터 세트를 분석하는 데 사용할 수 있는 고급 프로그래밍 언어입니다. Yahoo!의 Pig Hadoop 프로젝트는 최초의 Hadoop 프로젝트 중 하나였습니다. 일반적으로 Hadoop을 실행할 때 상당한 양의 데이터 관리 작업을 수행합니다.

대용량 데이터 분석 분야에서 Pig Hadoop은 고급 프로그래밍 언어입니다. Apache Pig를 사용하여 데이터를 분석하려면 먼저 Pig Latin을 사용하여 스크립트를 작성해야 합니다. MapReduce 작업 으로 변환될 스크립트. 이는 Apache Pig 확장인 Pig Engine을 활용하여 달성됩니다. 아래 단계에 따라 Linux/CentOS/Windows(VM 또는 Cloudera를 통해)에 Apache Pig를 설치할 수 있습니다. 첫 번째 단계는 Apache Pig를 다운로드하고 설치하는 것입니다. 두 번째 단계는 bashrc 파일을 사용하여 Apache Pig 환경 변수를 변경하는 것입니다.

3단계에서 Pig 버전을 확인합니다. 이 파일은 이동 후 다른 디렉토리에 저장할 수 있습니다. 다섯 번째 단계는 Pig 명령을 클릭하여 Grunt Shell(Pig Latin을 실행하는 데 사용되는 스크립트)을 실행하는 것입니다.

Pig Latin이 데이터 분석을 위한 최고의 고급 스크립팅 언어인 이유

Pig Latin 데이터 분석 코드는 고급 스크립팅 언어로 작성되었습니다. 데이터 흐름을 병렬로 처리하기 위한 SQL과 유사한 언어입니다.

아파치 피그 예

Pig는 Apache Hadoop에서 실행되는 프로그램을 만들기 위한 고급 플랫폼입니다. 이 플랫폼의 언어는 Pig Latin이라고 합니다. Pig는 MapReduce, Tez 또는 Spark에서 Hadoop 작업을 실행할 수 있습니다. Pig Latin은 Java MapReduce 관용구의 프로그래밍을 MapReduce 프로그래밍을 더 쉽게 만드는 표기법으로 추상화합니다. 예를 들어 다음 Pig Latin 문은 위의 Java MapReduce 코드와 동일합니다. A = LOAD 'mydata' USING PigStorage(',') AS (id:int, name:chararray, age:int, gpa:float); 덤프 A;