기술 SEO에 대한 궁극의 가이드

게시 됨: 2023-02-24검색 엔진 최적화(SEO)와 관련하여 올해 수행한 세 가지 일을 나열하십시오.

이러한 전술은 키워드 연구, 메타 설명 및 백링크를 중심으로 이루어집니까?

그렇다면 당신은 혼자가 아닙니다. SEO와 관련하여 이러한 기술은 일반적으로 마케터가 무기고에 추가하는 첫 번째 기술입니다.

이러한 전략은 자연 검색에서 사이트의 가시성을 향상시키지만 반드시 사용해야 하는 것은 아닙니다. SEO 우산 아래에 속하는 또 다른 전술 세트가 있습니다.

기술 SEO는 사이트 아키텍처, 모바일 최적화 및 페이지 속도와 같이 유기적인 성장 엔진을 강화하는 비하인드 스토리 요소를 나타냅니다. SEO의 이러한 측면은 가장 섹시하지는 않지만 매우 중요합니다.

기술 SEO를 개선하는 첫 번째 단계는 사이트 감사를 수행하여 현재 위치를 파악하는 것입니다. 두 번째 단계는 부족한 부분을 해결하기 위한 계획을 세우는 것입니다. 아래에서 이러한 단계를 자세히 다룹니다.

프로 팁: HubSpot의 무료 CMS 도구를 사용하여 변환하도록 설계된 웹사이트를 만드십시오.

기술적 SEO란 무엇입니까?

기술 SEO는 검색 엔진이 사이트를 더 쉽게 크롤링하고 색인을 생성할 수 있도록 하는 모든 작업을 의미합니다. 기술적 SEO, 콘텐츠 전략 및 링크 구축 전략은 모두 함께 작동하여 페이지가 검색에서 높은 순위에 오르도록 도와줍니다.

기술적 SEO vs. 온페이지 SEO vs. 오프페이지 SEO

많은 사람들이 검색 엔진 최적화(SEO)를 온페이지 SEO, 오프페이지 SEO 및 기술 SEO의 세 가지 버킷으로 분류합니다. 각각의 의미를 빠르게 살펴보겠습니다.

온페이지 SEO

온페이지 SEO는 이미지 대체 텍스트, 키워드 사용, 메타 설명, H1 태그, URL 이름 지정 및 내부 링크를 포함하여 검색 엔진(및 독자!)에게 페이지가 무엇인지 알려주는 콘텐츠를 말합니다. 모든 것이 사이트에있기 때문에 온페이지 SEO를 가장 잘 제어할 수 있습니다 .

오프 페이지 SEO

오프 페이지 SEO는 신뢰 투표를 통해 검색 엔진에 귀하의 페이지가 얼마나 인기 있고 유용한지 알려줍니다. 특히 백링크 또는 다른 사이트에서 귀하의 사이트로 연결되는 링크입니다. 백링크 수량 및 품질은 페이지의 PageRank를 높입니다. 모든 조건이 같다면 신뢰할 수 있는 사이트의 관련 링크가 100개 있는 페이지는 신뢰할 수 있는 사이트의 관련 링크가 50개(또는 신뢰할 수 있는 사이트의 관련 없는 링크가 100개) 있는 페이지보다 순위가 높습니다.

기술 SEO

기술적 SEO도 제어할 수 있지만 덜 직관적이기 때문에 마스터하기가 약간 까다롭습니다.

기술적 SEO가 중요한 이유는 무엇입니까?

SEO의 이 구성 요소를 완전히 무시하고 싶을 수도 있습니다. 그러나 유기적 트래픽에서 중요한 역할을 합니다. 귀하의 콘텐츠는 가장 철저하고 유용하며 잘 작성되었을 수 있지만 검색 엔진이 콘텐츠를 크롤링할 수 없다면 콘텐츠를 볼 수 있는 사람은 거의 없습니다.

주위에 아무도 들을 사람이 없을 때 숲 속으로 쓰러지는 나무와 같으니... 소리를 내나요? 강력한 기술 SEO 기반이 없으면 콘텐츠가 검색 엔진에 아무런 영향을 미치지 않습니다.

원천

원천

인터넷을 통해 콘텐츠를 울리게 만드는 방법에 대해 논의해 봅시다.

기술적 SEO 이해

기술적 SEO는 소화 가능한 조각으로 가장 잘 분해되는 야수입니다. 당신이 나와 같다면, 당신은 체크리스트와 덩어리로 큰 일을 처리하는 것을 좋아합니다. 믿거나 말거나 지금까지 다룬 모든 내용은 다섯 가지 범주 중 하나에 속할 수 있으며 각 범주에는 실행 가능한 항목 목록이 있습니다.

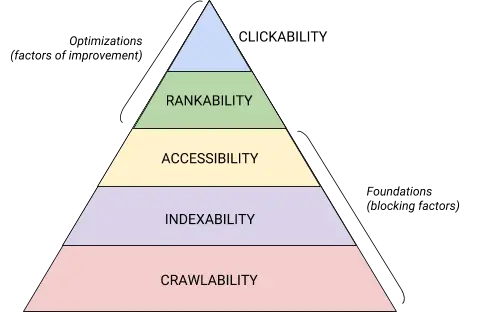

기술적 SEO 계층 구조에서 이 다섯 가지 범주와 해당 위치는 Maslov의 요구 계층 구조를 연상시키지만 검색 엔진 최적화를 위해 리믹스한 이 아름다운 그래픽으로 가장 잘 설명됩니다. (접근성 대신 일반적으로 사용되는 "렌더링"이라는 용어를 사용합니다.)

원천

원천

기술 SEO 감사 기초

기술 SEO 감사를 시작하기 전에 준비해야 할 몇 가지 기본 사항이 있습니다.

나머지 웹사이트 감사로 이동하기 전에 이러한 기술적인 SEO 기본 사항을 다루겠습니다 .

선호하는 도메인 감사

귀하의 도메인은 사람들이 귀하의 사이트에 도착하기 위해 입력하는 URL입니다(예: hubspot.com ) . 웹사이트 도메인은 사람들이 검색을 통해 귀하를 찾을 수 있는지 여부에 영향을 미치고 귀하의 사이트를 식별하는 일관된 방법을 제공합니다.

선호하는 도메인을 선택하면 검색 결과에 사이트의 www 또는 www가 없는 버전을 선호하는지 여부를 검색 엔진에 알리는 것입니다. 예를 들어yourwebsite.com대신www.yourwebsite.com을선택할 수 있습니다 . 이렇게 하면 검색 엔진에 사이트의 www 버전에 우선 순위를 지정하고 모든 사용자를 해당 URL로 리디렉션합니다. 그렇지 않으면 검색 엔진이 이 두 버전을 별도의 사이트로 취급하여 SEO 가치가 분산됩니다.

이전에는 Google에서 선호하는 URL 버전을 식별하도록 요청했습니다. 이제 Google에서 검색자를 표시할 버전을 식별하고 선택합니다 . 그러나 선호하는 도메인 버전을 설정하려는 경우 표준 태그(곧 다룰 예정)를 통해 설정할 수 있습니다. 어느 쪽이든 기본 도메인을 설정한 후에는www, non-www, http 및 index.html을의미하는 모든 변형이 해당 버전으로 영구적으로 리디렉션되는지 확인하세요.

SSL 구현

이전에 이 용어를 들어본 적이 있을 것입니다. 이는 매우 중요하기 때문입니다. SSL(Secure Sockets Layer)은 웹 서버(온라인 요청 이행을 담당하는 소프트웨어)와 브라우저 사이에 보호 계층을 생성하여 사이트를 안전하게 만듭니다. 사용자가 지불 또는 연락처 정보와 같은 정보를 귀하의 웹사이트로 보낼 때 해당 정보를 보호하기 위해 SSL이 있기 때문에 해당 정보가 해킹될 가능성이 적습니다.

SSL 인증서는 "http://"가 아닌 "https://"로 시작하는 도메인과 URL 표시줄의 잠금 기호로 표시됩니다.

검색 엔진은 보안 사이트를 우선시합니다. 사실 Google은 이미 2014년 에 SSL이 순위 요소로 간주될 것이라고 발표했습니다 . 따라서 홈페이지의 SSL 변형을 선호 도메인으로 설정해야 합니다.

SSL을 설정한 후 SSL이 아닌 페이지를 http에서 https로 마이그레이션해야 합니다. 어려운 주문이지만 순위 향상이라는 이름으로 노력할 가치가 있습니다. 취해야 할 단계는 다음과 같습니다.

- 모든 http://yourwebsite.com 페이지를 https://yourwebsite.com 으로 리디렉션합니다 .

- 이에 따라 모든 표준 및 hreflang 태그를 업데이트합니다.

- 사이트맵( yourwebsite.com/sitemap.xml 에 있음 ) 및 robot.txt( yourwebsite.com/robots.txt 에 있음 ) 의 URL을 업데이트합니다 .

- https 웹사이트에 대한 Google Search Console 및 Bing 웹마스터 도구의 새 인스턴스를 설정하고 트래픽의 100%가 마이그레이션되도록 추적합니다.

페이지 속도 최적화

웹사이트 방문자가 귀하의 웹사이트가 로드될 때까지 얼마나 오래 기다려야 하는지 아십니까? 6초 ... 관대합니다. 일부 데이터에 따르면 페이지 로드 시간이 1초에서 5초로 증가하면 이탈률이 90% 증가합니다. 1초도 낭비할 시간이 없으므로 사이트 로드 시간을 개선하는 것이 우선되어야 합니다.

사이트 속도는 사용자 경험과 전환에 중요할 뿐만 아니라 순위 요소 이기도 합니다 .

다음 팁을 사용하여 평균 페이지 로드 시간을 개선하십시오.

- 모든 파일을 압축합니다. 압축은 이미지 와 CSS, HTML, 자바스크립트 파일 의 크기를 줄여 공간을 덜 차지하고 더 빠르게 로드합니다.

- 리디렉션을 정기적으로 감사합니다. 301 리디렉션을 처리하는 데 몇 초가 걸립니다. 여러 페이지 또는 리디렉션 계층에 곱하면 사이트 속도에 심각한 영향을 미칩니다.

- 코드를 다듬습니다. 지저분한 코드는 사이트 속도에 부정적인 영향을 미칠 수 있습니다. 지저분한 코드는 게으른 코드를 의미합니다. 글을 쓰는 것과 비슷합니다. 아마도 첫 번째 초안에서 6개의 문장으로 요점을 설명할 것입니다. 두 번째 초안에서는 3으로 만듭니다. 코드가 효율적일수록 페이지가 더 빨리 로드됩니다(일반적으로). 일단 정리하면 코드가 축소되고 압축 됩니다 .

- 콘텐츠 배포 네트워크(CDN)를 고려하십시오. CDN은 다양한 지리적 위치에 웹사이트 사본을 저장하고 검색자의 위치에 따라 사이트를 제공하는 분산 웹 서버입니다. 서버 간의 정보 이동 거리가 더 짧기 때문에 요청 당사자에게 사이트가 더 빨리 로드됩니다.

- 플러그인을 행복하게 만들지 마십시오. 오래된 플러그인에는 웹사이트 순위에 해를 끼칠 수 있는 악의적인 해커에게 웹사이트를 취약하게 만드는 보안 취약점이 있는 경우가 많습니다. 항상 최신 버전의 플러그인을 사용하고 가장 필수적인 것으로 사용을 최소화하십시오. 같은 맥락에서 사전 제작된 웹 사이트 테마에는 종종 불필요한 코드가 많이 포함되어 있으므로 맞춤형 테마를 사용하는 것이 좋습니다.

- 캐시 플러그인을 활용하십시오. 캐시 플러그인은 사이트의 정적 버전을 저장하여 재방문 사용자에게 보내므로 재방문하는 동안 사이트를 로드하는 시간이 줄어듭니다.

- 비동기식(async) 로딩을 사용합니다. 스크립트는 방문자가 사이트에서 보고 싶어하는 웹 페이지의 HTML 또는 본문을 처리하기 전에 서버가 읽어야 하는 지침입니다. 일반적으로 스크립트는 웹사이트의 <head>(예: Google 태그 관리자 스크립트)에 배치되며 페이지의 나머지 콘텐츠보다 우선순위가 높습니다. 비동기 코드를 사용하면 서버가 HTML과 스크립트를 동시에 처리할 수 있으므로 지연이 줄어들고 페이지 로드 시간이 늘어납니다.

다음은 비동기 스크립트의 모습입니다. < script async src =" script.js "></ script >

속도 부서에서 웹사이트가 부족한 부분을 확인하려면 Google의 이 리소스를 사용할 수 있습니다 .

기술적인 SEO 기초가 마련되면 다음 단계인 크롤링 가능성으로 이동할 준비가 된 것입니다.

크롤링 가능성 체크리스트

크롤링 가능성은 기술적인 SEO 전략의 기초입니다. 검색 봇은 페이지를 크롤링하여 사이트에 대한 정보를 수집합니다.

이러한 봇의 크롤링이 차단되면 페이지를 색인화하거나 순위를 매길 수 없습니다. 기술적 SEO 구현의 첫 번째 단계는 모든 중요한 페이지에 액세스하고 쉽게 탐색할 수 있도록 하는 것입니다.

아래에서는 체크리스트에 추가할 몇 가지 항목과 페이지가 크롤링하기에 적합한지 확인하기 위해 감사할 웹사이트 요소를 다룹니다.

크롤링 가능성 체크리스트

- XML 사이트맵을 만듭니다.

- 크롤링 예산을 최대화하십시오.

- 사이트 아키텍처를 최적화하십시오.

- URL 구조를 설정합니다.

- robots.txt를 활용하세요.

- 이동 경로 메뉴를 추가합니다.

- 페이지 매김을 사용하십시오.

- SEO 로그 파일을 확인하십시오.

1. XML 사이트맵을 만듭니다.

우리가 살펴본 사이트 구조를 기억하십니까? 그것은 검색 봇이 웹 페이지를 이해하고 크롤링하는 데 도움이 되는 XML Sitemap 이라는 것에 속합니다 . 웹사이트의 지도라고 생각하시면 됩니다. 완료 되면 사이트맵을 Google Search Console 및 Bing 웹마스터 도구에 제출합니다. 웹 페이지를 추가하고 제거할 때 사이트맵을 최신 상태로 유지해야 합니다.

2. 크롤링 예산을 최대화하십시오.

크롤링 예산은 검색 봇이 크롤링할 사이트의 페이지와 리소스를 나타냅니다 .

크롤링 예산은 무한하지 않으므로 크롤링을 위해 가장 중요한 페이지의 우선순위를 지정해야 합니다.

다음은 크롤링 예산을 최대화하기 위한 몇 가지 팁입니다.

- 중복 페이지를 제거하거나 정규화합니다.

- 끊어진 링크를 수정하거나 리디렉션합니다.

- CSS 및 자바스크립트 파일을 크롤링할 수 있는지 확인하세요.

- 크롤링 통계를 정기적으로 확인하고 급격한 감소 또는 증가를 관찰하십시오.

- 크롤링을 허용하지 않은 봇이나 페이지가 차단되었는지 확인하세요.

- 사이트맵을 최신 상태로 유지하고 적절한 웹마스터 도구에 제출하십시오.

- 사이트에서 불필요하거나 오래된 콘텐츠를 정리합니다.

- 동적으로 생성된 URL에 주의하십시오. 그러면 사이트의 페이지 수가 급증할 수 있습니다.

3. 사이트 아키텍처를 최적화합니다.

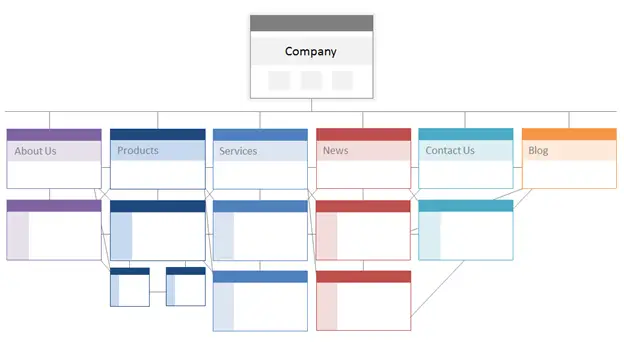

귀하의 웹사이트에는 여러 페이지가 있습니다. 이러한 페이지는 검색 엔진이 쉽게 찾고 크롤링할 수 있는 방식으로 구성되어야 합니다. 웹 사이트의 정보 아키텍처라고도 하는 사이트 구조가 필요한 곳입니다.

건물이 건축 디자인을 기반으로 하는 것과 같은 방식으로 사이트 아키텍처는 사이트에서 페이지를 구성하는 방법입니다.

관련 페이지는 함께 그룹화됩니다. 예를 들어 블로그 홈페이지는 각각의 작성자 페이지로 연결되는 개별 블로그 게시물로 연결됩니다. 이 구조는 검색 봇이 페이지 간의 관계를 이해하는 데 도움이 됩니다.

사이트 아키텍처도 개별 페이지의 중요성을 형성해야 합니다. 페이지 A가 홈페이지에 가까울수록 페이지 A에 더 많은 페이지가 연결되고해당페이지의 링크 자산이 많을수록 검색 엔진이 페이지 A에 더 많은 중요성을 부여합니다.

예를 들어 홈페이지에서 페이지 A로 연결되는 링크는 블로그 게시물의 링크보다 더 중요합니다. 페이지 A에 대한 링크가 많을수록 해당 페이지가 검색 엔진에 더 "중요"해집니다.

개념적으로 사이트 아키텍처는정보, 제품, 뉴스등의 페이지가 페이지 중요도 계층 구조의 맨 위에 위치하는 이와 같이 보일 수 있습니다.

원천

비즈니스에 가장 중요한 페이지가 가장 많은 수의 (관련!) 내부 링크가 있는 계층 구조의 맨 위에 있는지 확인하십시오.

4. URL 구조를 설정합니다.

URL 구조는 사이트 아키텍처에 따라 결정될수 있는URL 구조를 나타냅니다. 잠시 후에 연결을 설명하겠습니다. 먼저, URL에는 URL이 연결되는 위치를 나타내는blog.hubspot.com과 같은 하위 디렉터리 및/또는hubspot.com/blog와 같은 하위 폴더가 있을 수 있음을 명확히 합시다 .

예를 들어How to Groom Your Dog라는 제목의 블로그 게시물은 블로그 하위 도메인 또는 하위 디렉토리에 속합니다. URL은 www.bestdogcare.com/blog/how-to-groom-your-dog 일 수 있습니다 . 반면 동일한 사이트의 제품 페이지는www.bestdogcare.com/products/grooming-brush입니다 .

URL에서 하위 도메인이나 하위 디렉토리 또는 "제품"과 "상점"을 사용할지는 전적으로 귀하에게 달려 있습니다. 나만의 웹사이트를 만드는 것의 아름다움은 규칙을 만들 수 있다는 것입니다. 중요한 것은 이러한 규칙이 통합 구조를 따른다는 것입니다. 즉, 다른 페이지에서 blog.yourwebsite.com과 yourwebsite.com/blogs 사이를 전환하면 안 됩니다. 로드맵을 만들고 URL 명명 구조에 적용하고 이를 고수하십시오.

다음은 URL 작성 방법에 대한 몇 가지 추가 도움말입니다.

- 소문자를 사용하십시오.

- 대시를 사용하여 단어를 구분하십시오.

- 짧고 설명적입니다.

- 불필요한 문자나 단어(전치사 포함)를 사용하지 마십시오.

- 목표 키워드를 포함하십시오.

URL 구조가 완성되면 중요한 페이지의 URL 목록을 XML 사이트맵 형식으로 검색 엔진에 제출하게 됩니다 . 이렇게 하면 검색 봇이 사이트에 대한 추가 컨텍스트를 제공하므로 크롤링할 때 알아낼 필요가 없습니다.

5. robots.txt를 활용합니다.

웹 로봇이 사이트를 크롤링할 때 로봇 제외 프로토콜이라고도 하는 /robot.txt를 먼저 확인합니다. 이 프로토콜은 사이트의 특정 섹션이나 페이지를 포함하여 특정 웹 로봇이 사이트를 크롤링하도록 허용하거나 허용하지 않을 수 있습니다. 봇이 사이트의 색인을 생성하지 못하도록 하려면 NOINDEX 로봇 메타 태그를 사용합니다. 이 두 가지 시나리오에 대해 논의해 보겠습니다.

특정 봇이 사이트를 완전히 크롤링하지 못하도록 차단할 수 있습니다. 불행하게도 악의적인 의도를 가진 봇이 있습니다. 콘텐츠를 스크랩하거나 커뮤니티 포럼에 스팸을 보내는 봇입니다. 이 나쁜 행동을 발견하면 robots.txt를 사용하여 웹사이트에 들어오는 것을 방지합니다. 이 시나리오에서는 robot.txt를 인터넷에 있는 나쁜 봇의 역장으로 생각할 수 있습니다.

인덱싱과 관련하여 검색 봇은 사이트를 크롤링하여 단서를 수집하고 키워드를 찾아 웹 페이지를 관련 검색어와 일치시킬 수 있습니다. 그러나 나중에 설명하겠지만 불필요한 데이터에 지출하고 싶지 않은 크롤링 예산이 있습니다. 따라서 검색 봇이 귀하의 웹사이트가 무엇인지 이해하는 데 도움이 되지 않는 페이지(예: 제안의감사페이지 또는 로그인 페이지)를 제외할 수 있습니다.

무엇이든 달성하고자 하는 것에 따라 귀하의 robot.txt 프로토콜은 고유할 것입니다 .

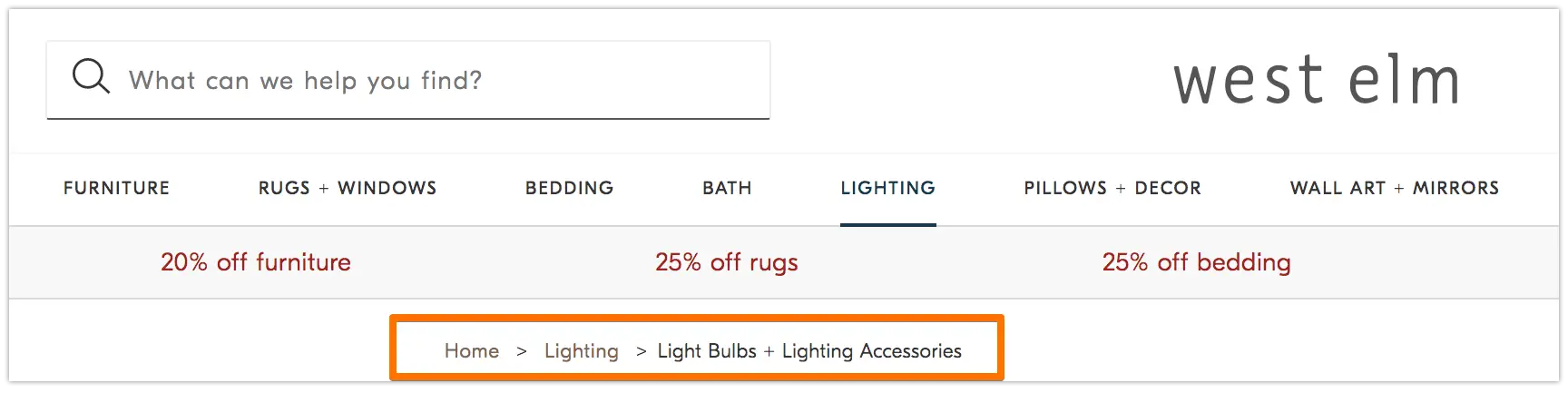

6. 이동 경로 메뉴를 추가합니다.

두 아이가 집으로 돌아가는 길을 찾기 위해 땅에 빵 부스러기를 떨어뜨린 오래된 우화헨젤과 그레텔을기억하십니까? 글쎄, 그들은 뭔가에 있었다.

이동 경로는 말 그대로 사용자가 웹사이트에서 여정의 시작점으로 돌아가도록 안내하는 트레일입니다. 사용자에게 현재 페이지가 사이트의 나머지 부분과 어떻게 관련되어 있는지 알려주는 페이지 메뉴입니다.

웹사이트 방문자만을 위한 것이 아닙니다. 검색 봇도 사용합니다.

원천

이동 경로는 1)뒤로버튼을 사용하지 않고도 웹 페이지를 쉽게 탐색할 수 있도록 사용자에게 표시되어야 하며, 2) 사이트를 크롤링하는 검색 봇에 정확한 컨텍스트를 제공하는 구조화된 마크업 언어를 포함해야 합니다.

탐색 경로에 구조화된 데이터를 추가하는 방법을 모르십니까? BreadcrumbList에 대해 이 가이드를 사용하십시오 .

7. 페이지 매김을 사용하십시오.

선생님이 연구 논문의 페이지에 번호를 매기라고 요구했던 때를 기억하십니까? 이것을 페이지네이션이라고 합니다. 기술적인 SEO의 세계에서 페이지네이션은 약간 다른 역할을 하지만 여전히 구성의 한 형태로 생각할 수 있습니다.

페이지 매김은 코드를 사용하여 고유한 URL이 있는 페이지가 서로 관련될 때 검색 엔진에 알립니다. 예를 들어 장이나 여러 웹 페이지로 나누는 콘텐츠 시리즈가 있을 수 있습니다. 검색 봇이 이러한 페이지를 쉽게 검색하고 크롤링하도록 하려면 페이지 매김을 사용합니다.

작동 방식은 매우 간단합니다. 시리즈 중 1페이지의<head>로 이동하여

rel=”next”는두 번째로 크롤링할 페이지를 검색 봇에게 알려줍니다. 그런 다음 두 번째 페이지에서 이전 페이지를 나타 내기위해 rel=”prev”를사용하고 후속 페이지를 나타내기 위해 rel=”next”를 사용합니다.

다음과 같이 보입니다…

1페이지:

<link rel=“다음” href=“https://www.website.com/page-two” />

2페이지:

<link rel=“prev” href=“https://www.website.com/page-one” />

<link rel=“다음” href=“https://www.website.com/page-three” />

페이지 매김은 크롤링 검색에 유용하지만 예전처럼 페이지 색인을 일괄 처리하기 위해 Google에서 더 이상 지원하지 않습니다.

8. SEO 로그 파일을 확인하십시오.

로그 파일을 저널 항목으로 생각할 수 있습니다. 웹 서버(저널러)는 사이트에서 수행하는 모든 작업에 대한 로그 데이터를 로그 파일(저널)에 기록하고 저장합니다. 기록되는 데이터에는 요청 시간과 날짜, 요청한 콘텐츠 및 요청 IP 주소가 포함됩니다. 사용자에 대한 요청을 이행하는 고유하게 식별 가능한 소프트웨어(예: 검색 봇)인 사용자 에이전트를 식별할 수도 있습니다.

그러나 이것이 SEO와 무슨 관련이 있습니까?

검색 봇은 사이트를 크롤링할 때 로그 파일 형태로 흔적을 남깁니다. 로그 파일을 확인하고 사용자 에이전트 및 검색 엔진 으로 필터링하여 크롤링 여부, 시기 및 내용을 확인할 수 있습니다 .

이 정보는 크롤링 예산이 사용되는 방식과 봇이 경험하는 인덱싱 또는 액세스에 대한 장벽을 결정할 수 있기 때문에 유용합니다. 로그 파일에 액세스하려면 개발자에게 문의하거나 Screaming Frog와 같은 로그 파일 분석기를 사용할 수 있습니다 .

검색 봇이 사이트를 크롤링할 수 있다고 해서 반드시 모든 페이지의 색인을 생성할 수 있다는 의미는 아닙니다. 기술적 SEO 감사의 다음 단계인 인덱싱 기능을 살펴보겠습니다 .

인덱싱 가능성체크리스트

검색 봇은 웹 사이트를 크롤링하면서 주제 및 해당 주제와의 관련성을 기반으로 페이지 색인을 생성하기 시작합니다. 색인이 생성되면 귀하의 페이지는 SERP에서 순위를 매길 수 있습니다. 페이지의 색인을 생성하는 데 도움이 되는 몇 가지 요소는 다음과 같습니다.

인덱싱 가능성 체크리스트

- 검색 봇이 페이지에 액세스하지 못하도록 차단 해제합니다.

- 중복 콘텐츠를 제거합니다.

- 리디렉션을 감사합니다.

- 사이트의 모바일 반응성을 확인하십시오.

- HTTP 오류를 수정합니다.

1. 검색 봇이 페이지에 액세스하지 못하도록 차단 해제합니다.

크롤링 가능성을 해결할 때 이 단계를 처리할 가능성이 높지만 여기에서 언급할 가치가 있습니다. 봇이 원하는 페이지로 전송되고 자유롭게 액세스할 수 있는지 확인하려고 합니다. 이를 위해 사용할 수 있는 몇 가지 도구가 있습니다. Google의 robots.txt 테스터는 허용되지 않는 페이지 목록을 제공하며 Google Search Console의 검사 도구를 사용하여 차단된 페이지의 원인을 확인할 수 있습니다.

2. 중복 콘텐츠를 제거합니다.

중복 콘텐츠는 검색 봇을 혼란스럽게 하고 인덱싱 기능에 부정적인 영향을 미칩니다. 표준 URL을 사용하여 선호하는 페이지를 설정해야 합니다.

3. 리디렉션을 감사합니다.

모든 리디렉션이 올바르게 설정되었는지 확인하십시오. 리디렉션 루프, 깨진 URL 또는 더 나쁜 경우 부적절한 리디렉션으로 인해 사이트가 인덱싱될 때 문제가 발생할 수 있습니다. 이를 방지하려면 모든 리디렉션을 정기적으로 감사하십시오.

4. 사이트의 모바일 반응성을 확인하십시오.

귀하의 웹사이트가 지금까지 모바일 친화적이지 않다면, 귀하는 귀하가 있어야 할 곳에 훨씬 뒤쳐져 있는 것입니다. 빠르면 2016년부터 Google은 모바일 사이트를 먼저 인덱싱하기 시작하여 데스크톱보다 모바일 경험을 우선시했습니다. 현재 해당 인덱싱은 기본적으로 활성화되어 있습니다. 이 중요한 추세를 따라잡기 위해 Google의 모바일 친화성 테스트를 사용하여 웹사이트에서 개선해야 할 부분을 확인할 수 있습니다.

5. HTTP 오류를 수정합니다.

HTTP는 HyperText Transfer Protocol의 약자이지만 아마 신경 쓰지 않을 것입니다. 관심 있는 것은 HTTP가 사용자 또는 검색 엔진에 오류를 반환하는 시점과 이를 수정하는 방법입니다.

HTTP 오류는 사이트의 중요한 콘텐츠에서 검색 봇을 차단하여 검색 봇의 작업을 방해할 수 있습니다. 따라서 이러한 오류를 빠르고 철저하게 해결하는 것이 매우 중요합니다.

모든 HTTP 오류는 고유하며 특정 해결 방법이 필요하므로 아래 섹션에는 각각에 대한 간략한 설명이 있으며 제공되는 링크를 사용하여 자세한 내용 또는 해결 방법을 알아볼 수 있습니다.

- 301 영구 리디렉션은 한 URL에서 다른 URL로 트래픽을 영구적으로 보내는 데 사용됩니다. CMS에서 이러한 리디렉션을 설정할 수 있지만 이러한 리디렉션이 너무 많으면 각 추가 리디렉션이 페이지 로드 시간에 추가되므로 사이트 속도가 느려지고 사용자 환경이 저하될 수 있습니다. 리디렉션 체인이 너무 많으면 검색 엔진이 해당 페이지 크롤링을 포기하게 되므로 가능하면 제로 리디렉션 체인을 목표로 합니다.

- 302 임시 리디렉션은 URL에서 다른 웹 페이지로 트래픽을 일시적으로 리디렉션하는 방법입니다. 이 상태 코드는 자동으로 사용자를 새 웹 페이지로 보내지만 캐시된 제목 태그, URL 및 설명은 원래 URL과 일치하게 유지됩니다. 그러나 임시 리디렉션이 충분히 오래 유지되면 결국 영구 리디렉션으로 처리되고 해당 요소가 대상 URL로 전달됩니다.

- 403 금지 메시지는 사용자가 요청한 콘텐츠가 액세스 권한에 따라 또는 서버 구성 오류로 인해 제한됨을 의미합니다.

- 404 오류 페이지는 사용자에게 요청한 페이지가 제거되었거나 잘못된 URL을 입력했기 때문에 존재하지 않는다고 알려줍니다. 방문자를 사이트에 계속 머물게 하려면 브랜드에 맞고 참여를 유도하는 404 페이지를 만드는 것이 좋습니다(좋은 예를 보려면 위의 링크를 클릭하세요).

- 405 방법이 허용되지 않음은 웹사이트 서버가 액세스 방법을 인식했지만 여전히 차단하여 오류 메시지가 발생했음을 의미합니다.

- 500 내부 서버 오류는 웹 서버에서 사이트를 요청 당사자에게 전달하는 데 문제가 있음을 의미하는 일반적인 오류 메시지입니다.

- 502 잘못된 게이트웨이 오류는 웹 사이트 서버 간의 잘못된 통신 또는 잘못된 응답과 관련이 있습니다.

- 503 서비스를 사용할 수 없음은 서버가 제대로 작동하는 동안 요청을 이행할 수 없음을 나타냅니다.

- 504 게이트웨이 시간 초과는 서버가 요청한 정보에 액세스하기 위해 웹 서버로부터 적시에 응답을 받지 못했음을 의미합니다.

이러한 오류의 원인이 무엇이든 사용자와 검색 엔진 모두 만족하고 사이트를 다시 방문하도록 문제를 해결하는 것이 중요합니다.

사이트가 크롤링되고 인덱싱된 경우에도 사용자와 봇을 차단하는 접근성 문제는 SEO에 영향을 미칩니다. 즉, 기술적 SEO 감사의 다음 단계인 렌더링 가능성으로 이동해야 합니다.

렌더링 가능성 체크리스트

이 주제에 대해 알아보기 전에 SEO 접근성과 웹 접근성의 차이점에 주목하는 것이 중요합니다 . 후자는 예를 들어 실명이나 난독증과 같은 장애가 있는 사용자가 웹 페이지를 쉽게 탐색할 수 있도록 만드는 데 중점을 둡니다. 온라인 접근성의 많은 요소가 SEO 모범 사례와 겹칩니다. 그러나 SEO 접근성 감사는 장애가 있는 방문자가 사이트에 더 쉽게 액세스할 수 있도록 하기 위해 수행해야 하는 모든 사항을 설명하지 않습니다.

이 섹션에서는 SEO 접근성 또는 렌더링에 중점을 두지만 사이트를 개발하고 유지 관리할 때 웹 접근성을 가장 먼저 염두에 두십시오.

렌더링 가능성 체크리스트

액세스 가능한 사이트는 렌더링의 용이성을 기반으로 합니다. 렌더링 가능성 감사를 위해 검토할 웹사이트 요소는 다음과 같습니다.

서버 성능

위에서 배운 것처럼 서버 시간 초과 및 오류로 인해 사용자와 봇이 사이트에 액세스하는 것을 방해하는 HTTP 오류가 발생합니다. 서버에 문제가 발생하는 경우 위에 제공된 리소스를 사용하여 문제를 해결하십시오. 적시에 그렇게 하지 않으면 사용자에게 깨진 페이지를 표시하는 것이 좋지 않은 경험이므로 검색 엔진이 색인에서 웹 페이지를 제거할 수 있습니다.

HTTP 상태

서버 성능과 마찬가지로 HTTP 오류는 웹 페이지에 대한 액세스를 차단합니다. Screaming Frog , Botify 또는 DeepCrawl 과 같은 웹 크롤러를 사용하여 사이트의 포괄적인 오류 감사를 수행할 수 있습니다.

로드 시간 및 페이지 크기

페이지를 로드하는 데 너무 오래 걸리면 이탈률만 걱정할 필요는 없습니다. 페이지 로드 시간이 지연되면 웹 페이지에서 봇을 차단하거나 콘텐츠의 중요한 섹션이 누락된 부분적으로 로드된 버전을 크롤링하는 서버 오류가 발생할 수 있습니다. 주어진 리소스에 대한 크롤링 요구량에 따라 봇은 페이지를 로드, 렌더링 및 인덱싱하는 데 동일한 양의 리소스를 사용합니다. 그러나 페이지 로드 시간을 줄이려면 제어할 수 있는 모든 작업을 수행해야 합니다.

자바스크립트 렌더링

Google은 JavaScript(JS)를 처리하는 데 어려움을 겪고 있으므로 접근성을 개선하기 위해 미리 렌더링된 콘텐츠를 사용할 것을 권장합니다 . 또한 Google 에는 검색 봇이 사이트에서 JS에 액세스하는 방법과 검색 관련 문제를 개선하는 방법을 이해하는 데 도움이 되는 다양한 리소스가 있습니다.

고아 페이지

사이트의 모든 페이지는 적어도하나의 다른 페이지에 연결되어야 합니다. 페이지의 중요도에 따라 더 많은 것이 좋습니다. 페이지에 내부 링크가 없으면 고아 페이지라고 합니다. 소개가 없는 기사처럼 이러한 페이지에는 봇이 인덱싱 방법을 이해하는 데 필요한 컨텍스트가 부족합니다.

페이지 깊이

페이지 심도는 사이트 구조에서 페이지 아래에 있는 레이어 수, 즉 홈페이지에서 얼마나 많은 클릭이 떨어져 있는지를 나타냅니다. 직관적인 계층 구조를 유지하면서 사이트 아키텍처를 가능한 한 얕게 유지하는 것이 가장 좋습니다. 때로는 다층 사이트가 불가피합니다. 이 경우 얕음보다 잘 구성된 사이트를 우선시해야 합니다.

사이트 구조의 레이어 수에 관계없이 제품 및 연락처 페이지와 같은 중요한 페이지를 세 번 이상 클릭하지 마십시오. 제품 페이지를 사이트 깊숙이 파묻어 사용자와 봇이 찾기 위해 탐정 역할을 해야 하는 구조는 접근성이 떨어지고 열악한 경험을 제공합니다.

예를 들어 대상 고객을 제품 페이지로 안내하는 웹사이트 URL은 잘못 계획된 사이트 구조의 예입니다. -제품.

리디렉션 체인

한 페이지에서 다른 페이지로 트래픽을 리디렉션하기로 결정하면 비용을 지불하게 됩니다. 그 가격은 크롤링 효율성입니다. 리디렉션을 사용하면 크롤링 속도가 느려지고 페이지 로드 시간이 단축되며 리디렉션이 제대로 설정되지 않은 경우 사이트에 액세스할 수 없게 됩니다. 이러한 모든 이유로 리디렉션을 최소한으로 유지하십시오.

접근성 문제를 해결한 후에는 SERP에서 페이지 순위를 매기는 방식으로 이동할 수 있습니다.

순위 확인 목록

이제 기술적인 SEO 관점에서 순위를 개선하는 방법에 대해 이미 알고 있을 수 있는 더 많은 주제 요소로 이동합니다. 페이지 순위를 매기는 데는 앞서 언급했지만 기술적인 관점에서 언급한 일부 온페이지 및 오프페이지 요소가 포함됩니다.

이러한 모든 요소가 함께 작동하여 SEO 친화적인 사이트를 생성한다는 점을 기억하십시오. 따라서 우리는 모든 기여 요인을 배제하지 않을 것입니다. 그것에 뛰어 들자.

내부 및 외부 연결

링크는 검색 봇이 검색어의 대대적인 계획에서 페이지가 적합한 위치를 이해하고 해당 페이지의 순위를 매기는 방법에 대한 컨텍스트를 제공하는 데 도움이 됩니다. 링크는 검색 봇(및 사용자)을 관련 콘텐츠로 안내하고 페이지 중요도를 이전합니다. 전반적으로 연결하면 크롤링, 인덱싱 및 순위 지정 기능이 향상됩니다.

백링크 품질

백링크 ( 다른 사이트에서 자신의 사이트로 돌아가는 링크)는 사이트에 대한 신뢰 투표를 제공합니다. 그들은 검색 봇에게 외부 웹사이트 A가 귀하의 페이지가 고품질이고 크롤링할 가치가 있다고 믿는다고 말합니다. 이러한 투표가 합산되면 검색 봇은 귀하의 사이트를 더 신뢰할 수 있는 사이트로 인식하고 취급합니다. 대단한 것 같죠? 그러나 대부분의 훌륭한 일과 마찬가지로 주의 사항이 있습니다. 이러한 백링크의 품질은 매우 중요합니다.

품질이 낮은 사이트의 링크는 실제로 순위를 손상시킬 수 있습니다. 관련 간행물에 대한 홍보, 연결되지 않은 멘션 요청, 관련 간행물 제공, 연결되지 않은 멘션 요청, 다른 사이트에서 연결하고 싶은 유용한 콘텐츠 제공과 같이 사이트에 대한 양질의 백링크를 얻는 방법에는 여러 가지가 있습니다.

콘텐츠 클러스터

HubSpot은 콘텐츠 클러스터에 대한 애정 이나 콘텐츠 클러스터가 유기적 성장에 어떻게 기여하는지 에 대해 부끄러워하지 않았습니다 . 콘텐츠 클러스터는 관련 콘텐츠를 연결하므로 검색 봇이 특정 주제에 대해 소유한 모든 페이지를 쉽게 찾고, 크롤링하고, 색인을 생성할 수 있습니다. 그들은 당신이 주제에 대해 얼마나 알고 있는지를 검색 엔진에 보여주는 자체 홍보 도구 역할을 하므로 관련 검색어에 대한 기관으로 귀하의 사이트 순위를 매길 가능성이 더 큽니다.

연구에 따르면 검색자가 SERP에서 상위 3개 검색 결과를 클릭할 가능성이 더 높기 때문에 귀하의 순위는 유기적 트래픽 성장의 주요 결정 요인입니다. 그러나당신의것이 클릭되는 결과인지 어떻게 확신할 수 있습니까?

유기적 트래픽 피라미드의 마지막 요소인 클릭 가능성으로 마무리하겠습니다.

클릭 가능성 체크리스트

클릭률(CTR)은 검색자의 행동과 모든 관련이 있지만 SERP에서 클릭 가능성을 개선하기 위해 할 수 있는일이 있습니다. 메타 설명과 키워드가 포함된 페이지 제목은 CTR에 영향을 미치지만 기술적인 요소에 집중할 것입니다.

클릭 가능성 체크리스트

- 구조화된 데이터를 사용합니다.

- 승리 SERP 기능.

- 추천 스니펫을 위해 최적화합니다.

- Google 검색을 고려하십시오.

솔직히 말해서 검색자는 즉각적인 답변을 원하기 때문에 순위와 클릭률은 밀접한 관련이 있습니다. 검색 결과가 SERP에서 더 눈에 띄게 될수록 클릭을 더 많이 받을 가능성이 높아집니다. 클릭 가능성을 개선하는 몇 가지 방법을 살펴보겠습니다.

1. 구조화된 데이터를 사용합니다.

구조화된 데이터는 스키마라는 특정 어휘를 사용하여 검색 봇을 위해 웹 페이지의 요소를 분류하고 레이블을 지정합니다. 스키마는 각 요소가 무엇인지, 사이트와 어떤 관련이 있는지, 어떻게 해석해야 하는지를 명확하게 보여줍니다. 기본적으로 구조화된 데이터는 봇에게 "이것은 비디오입니다", "이것은 제품입니다" 또는 "이것은 레시피입니다" 라고 말하며 해석할 여지가 없습니다 .

To be clear, using structured data is not a “clickability factor” (if there even is such a thing), but it does help organize your content in a way that makes it easy for search bots to understand, index, and potentially rank your pages.

2. Win SERP features.

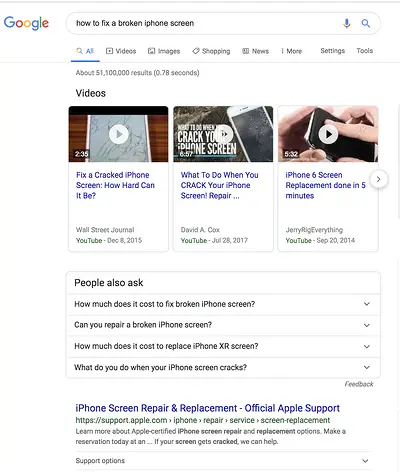

SERP features , otherwise known as rich results, are a double-edged sword. If you win themandget the click-through, you're golden. If not, your organic results are pushed down the page beneath sponsored ads, text answer boxes, video carousels, and the like.

Rich results are those elements that don't follow the page title, URL, meta description format of other search results. For example, the image below shows two SERP features — a video carousel and “People Also Ask” box — above the first organic result.

While you can still get clicks from appearing in the top organic results, your chances are greatly improved with rich results.

How do you increase your chances of earning rich results? Write useful content and use structured data. The easier it is for search bots to understand the elements of your site, the better your chances of getting a rich result.

Structured data is useful for getting these ( and other search gallery elements ) from your site to the top of the SERPs, thereby, increasing the probability of a click-through:

- Articles

- Videos

- 리뷰

- Events

- How-Tos

- FAQs (“People Also Ask” boxes)

- Images

- Local Business Listings

- 제품

- Sitelinks

3. Optimize for Featured Snippets.

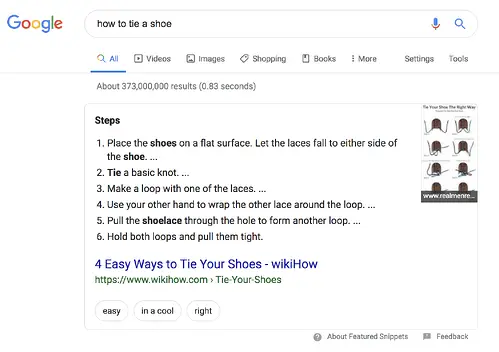

One unicorn SERP feature that has nothing to do with schema markup is Featured Snippets, those boxes above the search results that provide concise answers to search queries.

Featured Snippets are intended to get searchers the answers to their queries as quickly as possible. According to Google , providing the best answer to the searcher's query is the only way to win a snippet. However, HubSpot's research revealed a few additional ways to optimize your content for featured snippets .

4. Consider Google Discover.

Google Discover is a relatively new algorithmic listing of content by category specifically for mobile users. It's no secret that Google has been doubling down on the mobile experience; with over 50% of searches coming from mobile , it's no surprise either. The tool allows users to build a library of content by selecting categories of interest (think: gardening, music, or politics).

At HubSpot, we believe topic clustering can increase the likelihood of Google Discover inclusion and are actively monitoring our Google Discover traffic in Google Search Console to determine the validity of that hypothesis. We recommend that you also invest some time in researching this new feature. The payoff is a highly engaged user base that has basically hand-selected the content you've worked hard to create.

The Perfect Trio

Technical SEO, on-page SEO, and off-page SEO work together to unlock the door to organic traffic. While on-page and off-page techniques are often the first to be deployed, technical SEO plays a critical role in getting your site to the top of the search results and your content in front of your ideal audience. Use these technical tactics to round out your SEO strategy and watch the results unfold.