워드프레스 robots.txt

게시 됨: 2019-02-26WordPress robots.txt는 SEO에 매우 중요합니다. 귀하의 사이트가 검색 엔진 결과에서 좋은 순위를 차지하도록 하려면 검색 엔진의 "로봇"("봇")을 검색하고 인덱싱하는 데 가장 중요한 페이지를 편리하게 만들어야 합니다. 잘 구성된 robots.txt 파일은 이러한 봇을 색인을 생성하려는 페이지로 안내하는 데 도움이 됩니다.

이 기사에서 우리는 다음과 같은 질문을 밝힐 것입니다.

- robots.txt 파일이란 무엇이며 중요한 이유

- WordPress 로봇 txt 위치

- WordPress를 위한 최고의 로봇 txt

- robots.txt 파일을 만드는 방법

- robots.txt 파일을 확인하고 Google 검색 콘솔로 보내는 방법.

WordPress용 robots.txt 파일이란 무엇이며 왜 중요한가요?

새 웹사이트를 만들 때 검색 엔진은 로봇을 보내 모든 페이지의 지도를 스캔하고 만듭니다. 이렇게 하면 사용자가 관련 키워드를 검색할 때 어떤 페이지가 결과로 표시되는지 알 수 있습니다. 기본 수준에서 이것은 매우 간단합니다(또한 이 유용한 게시물을 확인하십시오 – WordPress 기본 .htaccess 파일).

문제는 최신 웹 사이트에는 페이지 외에도 많은 다른 요소가 포함되어 있다는 것입니다. WordPress를 사용하면 예를 들어 종종 자체 디렉토리가 있는 플러그인을 설치할 수 있습니다. 콘텐츠와 일치하지 않으므로 검색 결과에 표시할 필요가 없습니다.

robots.txt 파일이 하는 일은 검색 로봇에 대한 일련의 지침을 제공하는 것입니다. 그는 그들에게 "여기를 보고 이 페이지의 색인을 생성하되 다른 영역에 들어가지 마십시오!"라고 말합니다. 이 파일은 원하는 만큼 자세하게 만들 수 있으며 초보자도 매우 쉽게 만들 수 있습니다.

실제로 robots.txt 파일을 생성하지 않더라도 검색 엔진은 여전히 귀하의 사이트를 검색합니다. 그러나 생성하지 않는 것은 매우 비합리적인 단계입니다. 이 파일이 없으면 로봇이 사이트의 모든 콘텐츠를 인덱싱하도록 남겨두고 공개 액세스에서 숨기려는 부분을 포함하여 사이트의 모든 부분을 표시해야 한다고 결정합니다(또한 – 최고의 WordPress 전자 상거래 플러그인 확인 ).

더 중요한 점은 robots.txt 파일이 없으면 웹사이트에 로봇이 많이 방문한다는 것입니다. 이는 성능에 부정적인 영향을 미칩니다. 사이트의 방문자 수가 아직 적더라도 페이지 로딩 속도는 항상 최우선 순위이며 최고 수준이어야합니다. 결국 사람들이 웹 사이트를 느리게 로드하는 것보다 더 좋아하지 않는 것이 몇 가지 있습니다.

WordPress 로봇 txt 위치

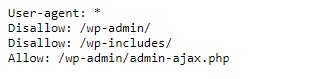

WordPress 웹 사이트를 만들 때 robots.txt 파일이 자동으로 만들어지고 서버의 기본 디렉터리에 있습니다. 예를 들어, 귀하의 사이트가 wpdevart.com에 있는 경우 wpdevart.com/robots.txt에서 찾을 수 있으며 다음과 같이 표시됩니다.

이것은 가장 단순한 robots.txt 파일의 예입니다. 사람이 읽을 수 있는 언어로 번역하면 User-agent: 다음 오른쪽에 다음이 선언됩니다.

로봇에 대한 규칙입니다. 별표는 규칙이 보편적이며 모든 로봇에 적용됨을 의미합니다. 이 경우 파일은 로봇에게 wp-admin 및 wp-includes 디렉토리를 스캔할 수 없다고 알려줍니다. 이 규칙의 의미는 이러한 디렉토리에 공개 액세스로부터 보호해야 하는 많은 파일이 포함되어 있다는 것입니다(또한 WordPress Countdown 플러그인 확인).

물론 파일에 더 많은 규칙을 추가할 수 있습니다. 이 작업을 수행하기 전에 이것이 가상 파일이라는 것을 이해해야 합니다. 일반적으로 WordPress robots.txt는 종종 public_html 또는 www(또는 웹 사이트 이름)라고 하는 루트 디렉토리에 있습니다.

기본적으로 생성되는 WordPress용 robots.txt 파일은 어떤 디렉토리에서도 액세스할 수 없습니다. 작동하지만 변경하려면 고유한 파일을 만들고 루트 디렉터리에 업로드해야 합니다.

WordPress용 robots.txt 파일을 만드는 몇 가지 방법을 살펴보겠습니다. 이제 파일에 포함할 규칙을 결정하는 방법에 대해 논의해 보겠습니다.

WordPress를 위한 최고의 로봇 txt

WordPress 웹 사이트에 가장 적합한 로봇 txt를 만드는 것은 그리 어렵지 않습니다. 따라서 robots.txt 파일에 포함되어야 하는 규칙은 무엇입니까? 이전 섹션에서 WordPress에서 생성된 robots.txt 파일의 예를 보았습니다. 여기에는 두 개의 짧은 규칙만 포함되어 있지만 대부분의 사이트에서는 충분합니다. 두 개의 서로 다른 robots.txt 파일을 살펴보고 각각이 수행하는 작업을 살펴보겠습니다.

다음은 WordPress robots.txt 파일의 첫 번째 예입니다.

User-agent: * Allow: / # Disallowed Sub-Directories Disallow: / payout / Disallow: / photos / Disallow: / forums /이 robots.txt 파일은 포럼용으로 생성됩니다. 검색 엔진은 일반적으로 모든 포럼 스레드를 색인화합니다. 포럼 주제에 따라 인덱싱을 허용하지 않을 수 있습니다. 예를 들어 Google은 수백 개의 짧은 사용자 토론을 색인화하지 않습니다. 특정 포럼 스레드를 지정하는 규칙을 설정하여 해당 스레드를 제외하고 검색 엔진이 나머지 스레드를 인덱싱하도록 할 수도 있습니다.

또한 파일 맨 위에 Allow: /로 시작하는 줄이 있습니다. 이 줄은 로봇이 아래에 설정된 제한 사항을 제외하고 사이트의 모든 페이지를 스캔할 수 있음을 알려줍니다. 또한 가상 WordPress robots.txt 파일에서와 같이 이러한 규칙을 범용(별표 포함)으로 설정했음을 알았습니다(또한 WordPress 가격 테이블 플러그인을 확인할 수 있음).

다른 샘플 WordPress robots.txt 파일을 확인해 보겠습니다.

User-agent: * Disallow: / wp-admin / Disallow: / wp-includes / User-agent: Bingbot Disallow: /이 파일에서는 기본적으로 WordPress에 적용되는 것과 동일한 규칙을 설정합니다. Bing 검색 로봇이 사이트를 크롤링하지 못하도록 차단하는 새로운 규칙 세트도 추가하고 있습니다. 빙봇은 보시다시피 로봇의 이름입니다.

다른 검색 엔진 이름을 입력하여 액세스를 제한/허용할 수도 있습니다. 물론 실제로 Bingbot은 매우 좋습니다(Googlebot만큼 좋지는 않더라도). 그러나 많은 악성 로봇이 있습니다.

나쁜 소식은 그들이 항상 robots.txt 파일의 지침을 따르지 않는다는 것입니다(그들은 여전히 테러리스트처럼 작동합니다). 대부분의 로봇이 이 파일에 제공된 지침을 사용하지만 강제할 수는 없다는 점을 염두에 두어야 합니다.

주제에 대해 더 깊이 들어가면 WordPress 사이트에서 허용할 항목과 차단할 항목에 대한 많은 제안을 찾을 수 있습니다. 우리의 경험에 따르면 규칙이 적을수록 더 좋은 경우가 많습니다. 다음은 의 예입니다

WordPress 웹 사이트에 대한 최고의 로봇 txt이지만 웹 사이트에 따라 다를 수 있습니다.

User-agent: * Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Disallow: *utm*= Disallow: *openstat= Allow: */uploads Sitemap: https://wpdevart.com/sitemap.xml전통적으로 WordPress는 wp-admin 및 wp-includes 디렉토리를 닫는 것을 좋아합니다. 그러나 이것은 더 이상 최상의 솔루션이 아닙니다. 또한 홍보(SEO) 목적으로 이미지에 메타 태그를 추가하는 경우 로봇에게 이러한 디렉토리의 내용을 색인화하지 말라고 지시하는 것은 의미가 없습니다.

robots.txt 파일을 포함해야 하는 항목은 사이트의 요구 사항에 따라 다릅니다. 그러니 부담 없이 더 많은 연구를 하십시오!

robots.txt를 만드는 방법

텍스트 파일(txt)을 만드는 것보다 더 간단할 수 있는 것이 무엇입니까? 메모장이나 TextEdit와 같은 좋아하는 편집기를 열고 몇 줄만 입력하면 됩니다. 그런 다음 robots 및 txt 확장자(robots.txt)를 사용하여 파일을 저장합니다. 몇 초가 걸리므로 플러그인을 사용하지 않고 WordPress용 robots.txt를 생성할 수 있습니다.

이 파일을 컴퓨터에 로컬로 저장했습니다. 자신의 파일을 만든 후에는 FTP(FileZilla를 사용할 수도 있음)를 통해 사이트에 연결해야 합니다.

사이트에 접속한 후 public_html 디렉토리로 이동합니다. 이제 컴퓨터에서 서버로 robots.txt 파일을 업로드하기만 하면 됩니다. 로컬 FTP 내비게이터에서 파일을 마우스 오른쪽 버튼으로 클릭하거나 단순히 마우스를 사용하여 끌어서 이 작업을 수행할 수 있습니다.

몇 초 밖에 걸리지 않습니다. 보시다시피 이 방법은 플러그인을 사용하는 것보다 쉽습니다.

WordPress robots.txt를 확인하고 Google Search Console로 보내는 방법

WordPress robots.txt 파일을 만들고 업로드한 후 Google Search Console에서 오류를 확인할 수 있습니다. Search Console은 콘텐츠가 검색결과에 표시되는 방식을 추적하는 데 도움이 되도록 설계된 일련의 Google 도구입니다. 이 도구 중 하나는 robots.txt를 확인하며 Google 웹마스터 도구 관리 페이지에서 쉽게 찾을 수 있습니다(또한 2020년 최고의 WordPress 플러그인 50개 확인).

거기에서 WordPress robots.txt 파일에 대한 코드를 추가할 수 있는 편집기 필드를 찾을 수 있고 오른쪽 하단 모서리에 있는 제출을 클릭합니다. Google 검색 콘솔에서 새 코드를 사용할 것인지 웹사이트에서 파일을 다운로드할 것인지 묻습니다.

이제 플랫폼에서 파일에 오류가 있는지 확인합니다. 오류가 발견되면 이에 대한 정보가 표시됩니다. WordPress robots.txt 파일의 몇 가지 예를 보았고 이제 완벽한 robots.txt 파일을 만들 수 있는 더 많은 기회가 있습니다!