Właśnie zakończono aktualizację spamu Google: oto, co się stało

Opublikowany: 2022-10-24

Czasami Google wprowadza aktualizację spamu, która po prostu zapewnia, że wyniki w Google nie są wypełnione spamem.

Ponieważ jeśli użytkownik kliknie wynik będący spamem, a sytuacja taka będzie się powtarzać, spowoduje to okropne wrażenia i ludzie przestaną korzystać z Google.

Nie podają zbyt wielu szczegółów na temat aktualizacji spamu na swojej stronie internetowej, ale na szczęście mamy dwie rzeczy, które pomagają nam określić, jakie były zmiany.

Po pierwsze, śledzimy ponad 900 milionów domen w sieci, co pozwala nam dostrzec wzorce.

Drugi, który jest bardziej odpowiedni dla tej aktualizacji, znajduje się w naszej agencji, NP Digital, mamy 100 witryn eksperymentalnych, które wykorzystują treści napisane przez sztuczną inteligencję. Celem tych witryn nie jest „granie” w Google, ale raczej ustalenie, w jaki sposób Google postrzega treści napisane przez sztuczną inteligencję. W dalszej części tego postu omówię bardziej szczegółowo, co stało się z tymi witrynami, ponieważ wyniki były interesujące.

Cel aktualizacji

Jak sama nazwa wskazuje, głównym celem Google jest ograniczenie spamu. Teraz mają wiele rodzajów aktualizacji spamu, na przykład w lipcu 2021 r. Mieli aktualizację spamu z linkami.

Ta aktualizacja nie określała, czy była związana ze spamem związanym z linkami, czy tylko ogólnym spamem.

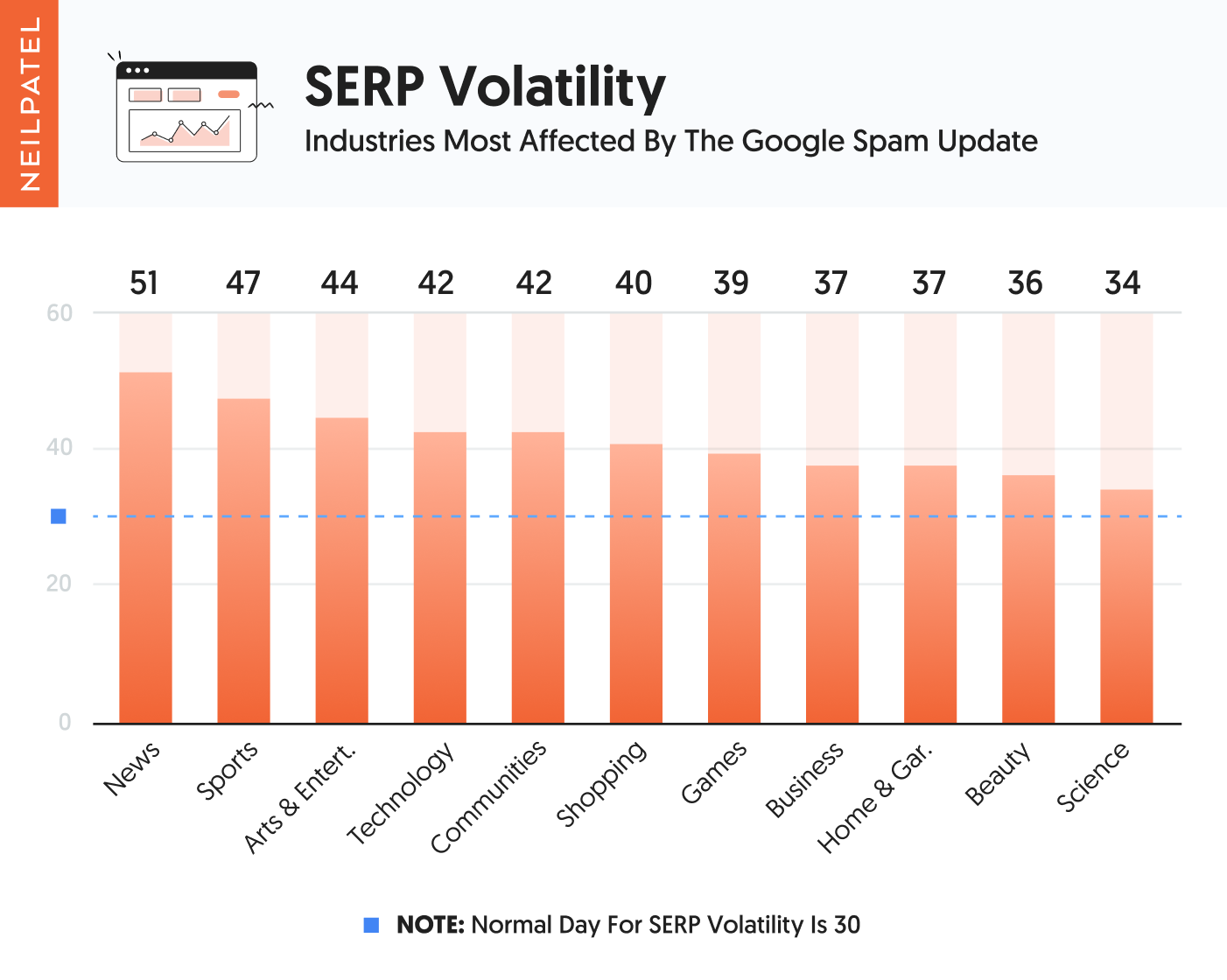

Ale kiedy spojrzymy na ponad 900 milionów domen, które śledzimy, oto kategorie, które zostały dotknięte najbardziej negatywnie na całym świecie.

Jak widać na powyższym wykresie, najbardziej ucierpiały strony z wiadomościami i sportem. Tuż za nimi uplasowały się miejsca poświęcone sztuce, rozrywce, technologii i społeczności.

Większość z tych witryn jest oparta na dużej zawartości i nie jest zorientowana na produkt.

Gdy przyjrzeliśmy się witrynom, których to dotyczy, oto, co znaleźliśmy:

- Cienka zawartość – większość z nich nie miała niesamowitej zawartości… wiele z nich miało rzadką zawartość. I żeby wyjaśnić, że przez cienką treść nie mam na myśli małej liczby słów, mam na myśli treść, która tak naprawdę nie zapewniała dużej wartości. Zasadniczo treść była na poziomie powierzchownym, a kiedy skończyłeś ją czytać, nie uzyskałeś wielu spostrzeżeń ani żadnych praktycznych punktów lub wartości.

- Źle utworzone metatagi – wiele witryn, których dotyczy problem, miało strony ze zduplikowanymi metatagami lub takimi, które zostały wyraźnie napisane dla wyszukiwarek, a nie dla ludzi.

- Upychanie słów kluczowych – szokujące osoby nadal są upychane słowami kluczowymi. Spośród dotkniętych witryn większość z nich nie zawierała słów kluczowych, ale około 3,89% z nich tak. Niezależnie od tego, czy było to w treści w metatagach, używali słów kluczowych w nadmierny sposób, co sprawiało, że czytanie nie było idealne.

Jak wiesz, na SEO składa się wiele innych czynników. Po prostu nie mogliśmy znaleźć żadnych innych głównych wzorców. Z pozoru niektóre rzeczy, na które patrzyli, wydają się podobne do przydatnej aktualizacji treści.

Przyjrzeliśmy się również linkom zwrotnym witryn, które straciły najwięcej ruchu, i nie znaleźliśmy żadnych wzorców. Nie oznacza to, że Google patrzył na linki jako czynnik spamujący w tej aktualizacji, co więcej, po prostu nie widzieliśmy żadnych wzorców .

Teraz tutaj robi się ciekawie…

Treść generowana przez sztuczną inteligencję

Pamiętasz, jak wspomniałem, że mamy 100 stron internetowych generowanych przez sztuczną inteligencję? Działają w różnych branżach i wszystkie mają ponad 60 stron treści, jeśli nie więcej, które są generowane przez sztuczną inteligencję, i oczywiście ręcznie utworzyliśmy linki (nie kupiliśmy ich i nigdy nie powinieneś kupować linków ), aby pomogło to uszeregować witryny.

W rzeczywistości mamy ponad 681 witryn generowanych przez sztuczną inteligencję, ale większość z nich nie generuje wystarczającego ruchu SEO. Na przykład, gdy witryna jest odwiedzana przez Google tylko 1000 miesięcznie, trudno jest dostrzec wzorce, ponieważ liczba odwiedzających drastycznie zmienia się z dnia na dzień.

Ale 100 witryn opartych na sztucznej inteligencji generuje co najmniej 3000 odwiedzających miesięcznie z Google.

Żadna z witryn niczego nie sprzedaje ani nie zbiera leadów, są to tylko strony informacyjne z różnych branż.

Obecnie ze 100 witryn generowanych przez sztuczną inteligencję 53 ma treści tworzone wyłącznie za pomocą sztucznej inteligencji. Mają też swoje metatagi, a nawet nagłówki w artykule, wszystkie stworzone przez sztuczną inteligencję.

Te strony nie prowadzą do innych witryn ani nawet stron wewnętrznych, ponieważ narzędzia do generowania treści AI tak naprawdę nie dodają linków.

Należy zauważyć, że większość narzędzi AI tak naprawdę nie tworzy treści powyżej 500 słów, chyba że zaczniesz dostosowywać treść lub poprosisz autora AI o tworzenie treści akapit po akapicie.

Ale w przypadku pierwszej partii witryn AI (53 z nich) nie wymagaliśmy od ludzi modyfikowania ani zmieniania jakiejkolwiek zawartości. Wykorzystaliśmy wyłącznie treść stworzoną przez sztuczną inteligencję w formie, w jakiej została utworzona, w tym metatagi utworzone przez twórcę AI.

Teraz w drugiej partii mieliśmy 47 witryn, w tych witrynach użyliśmy sztucznej inteligencji do stworzenia treści, ale potem poprosiliśmy człowieka o modyfikację treści, aby była lepsza i zapewniała większą wartość. Ludzie dodawali również linki wewnętrzne i zewnętrzne, modyfikowali metatagi, aby były bardziej przyjazne dla użytkownika, a także dodawali obrazy i osadzali filmy w artykule, gdy miało to sens.

Jedyną rzeczą, której nie zrobiliśmy, było znaczne zwiększenie długości. Ponieważ z tego, co widzimy w naszym Ubersuggest AI Writer, większość ludzi po prostu korzysta z treści napisanych przez AI i nie modyfikuje ich zbytnio. Kiedy go modyfikują, zwykle jest to nieznaczne, a ludzie naprawdę nie dodają zbyt wiele w liczbie słów.

W naszych witrynach chcieliśmy powielić to, co większość marketerów robi ze sztuczną inteligencją, aby zorientować się, co Google próbuje rozwiązać.

Czy możesz zgadnąć, co stało się z tymi witrynami?

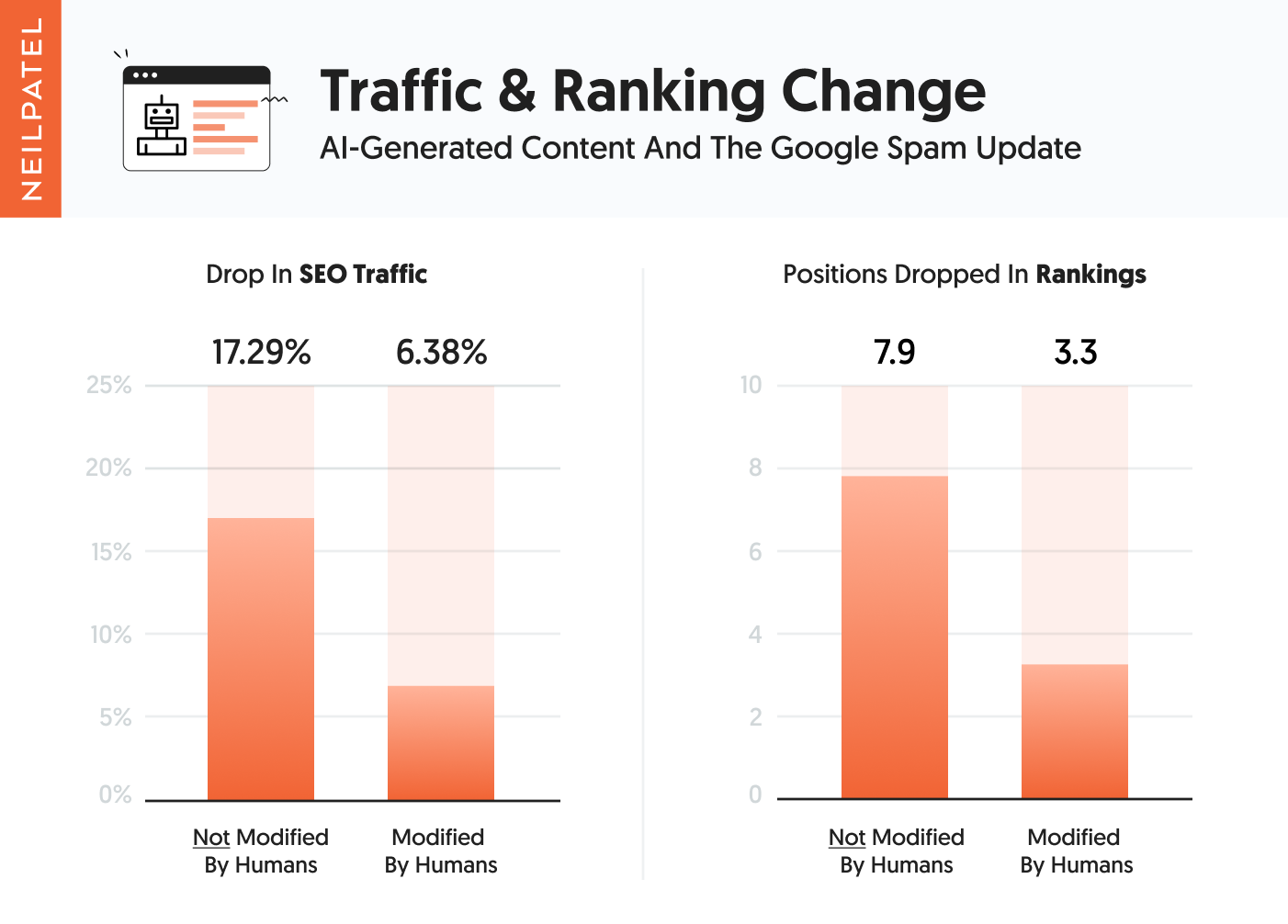

Pierwsza grupa treści napisanych przez sztuczną inteligencję, które nie miały interwencji człowieka, jeśli chodzi o modyfikację treści, nie działała tak dobrze, jak te, które miały interwencję człowieka.

Zasadniczo odnotowali spadek ruchu o średnio 17,29%, a rankingi ich słów kluczowych spadły średnio o 7,9 pozycji. Pamiętaj, że może się wydawać, że to dużo, ale żaden z nich nie miał tak naprawdę pierwszego miejsca w rankingach popularnych terminów.

W drugiej grupie odnotowano spadek ruchu o 6,38% i spadek pozycji w rankingu średnio o 3,3 pozycji.

Ale kiedy kopaliśmy głębiej, ponieważ byłem ciekawy wyników dla każdej witryny, zauważyliśmy, że nie wszystkie witryny zostały dotknięte aktualizacją.

Z pierwszej grupy 53 witryn, w których treść NIE została dostosowana przez ludzi, 14 z nich zostało dotkniętych aktualizacją i odnotowało spadki ruchu między 31,44% a 73,18%. Średnio 14 witryn straciło 51,65% ruchu.

Z drugiej grupy, w której ludzie nieznacznie modyfikowali treść, trafiło 8 witryn. Stracili od 29,52% do 81,43% swojego ruchu. Średnio te 8 witryn odnotowało spadek ruchu o 42,17%.

Zabawne jest to, że niektóre inne witryny w obu segmentach odnotowały mniejsze spadki ruchu, takie jak kilka punktów procentowych, a kilka z nich odnotowało nawet niewielki wzrost ruchu z ruchu SEO nawet o 4%, porównując ruch przed aktualizacją i po aktualizacji jako wdrożenie aktualizacji zajęło 48 godzin.

Ale tutaj robi się interesująco, w pierwszej grupie 14 witryn, które zostały dotknięte, 13 z nich również odnotowało spadki ruchu z powodu aktualizacji przydatnych treści. Z drugiej grupy wszystkie 8 witryn zostało dotkniętych przydatną aktualizacją treści.

Należy zauważyć, że nie było wielu dni aktualizacji postów danych od momentu, gdy Google zakończył wdrażanie, do momentu opublikowania tego posta na blogu. A nie chciałem porównywać ruchu niedzielnego z ruchem środowym. Ponieważ musisz spojrzeć na niedzielę w porównaniu z ostatnią niedzielą, aby usunąć stronniczość. Niemniej jednak powyższe statystyki są tym, co widzieliśmy, a spadki w rankingu również potwierdzają, że te witryny zostały dotknięte aktualizacją.

Wniosek

Z tego, co widzimy, większość tej aktualizacji koncentrowała się na treści, metatagach i upychaniu słów kluczowych. Nie oznacza to, że Google nie przyjrzał się innym czynnikom, takim jak linki czy duplikaty treści, ale zauważyliśmy największe wzorce związane z czynnikami, o których wspomniałem powyżej, oraz treściami generowanymi przez sztuczną inteligencję.

Jeśli chcesz dobrze sobie radzić na dłuższą metę, skup się na użytkowniku, to naprawdę sposób na wygraną. Na krótką metę możesz nie wyjść na prowadzenie, ale na dłuższą metę tak.

Po prostu zadaj sobie pytania, na przykład, czy ten fragment treści będzie pomocny dla użytkowników? Czy używanie tych samych metatagów na wszystkich stronach jest pomocne? Czy moja witryna zapewnia wystarczającą wartość, aby ludzie chcieli do mnie linkować?

Zasadniczo po prostu sprawdzasz siebie i robisz to, co najlepsze dla użytkowników.

Co zobaczyłeś w aktualizacji spamu Google?

Zobacz, jak moja agencja może zwiększyć ruch w Twojej witrynie

- SEO – odblokuj ogromne ilości ruchu SEO. Zobacz prawdziwe wyniki.

- Marketing treści – nasz zespół tworzy epickie treści, które będą udostępniane, uzyskiwać linki i przyciągać ruch.

- Płatne media – skuteczne płatne strategie z wyraźnym zwrotem z inwestycji.

Zarezerwuj połączenie