Przewodnik krok po kroku dotyczący instalacji Open-Source LLM w środowisku lokalnym – bez Internetu

Opublikowany: 2023-12-20Streszczenie

W szybko rozwijającym się świecie sztucznej inteligencji zainstalowanie modelu wielkojęzykowego (LLM), takiego jak FALCON, w systemie lokalnym stwarza unikalny zestaw wyzwań i możliwości. Celem tego przewodnika jest przeprowadzenie Cię przez najważniejsze etapy konfiguracji FALCON Open-Source LLM, koncentrując się na osiągnięciu optymalnej wydajności przy jednoczesnym zachowaniu ścisłej prywatności i bezpieczeństwa danych.

Rozpocznij wdrażanie FALCON, czołowego modelu wielkojęzykowego typu open source (LLM), lokalnie, zapewniając najwyższą wydajność i solidne bezpieczeństwo. Ten kompleksowy przewodnik obejmuje wymagania wstępne dotyczące sprzętu, instalację oprogramowania i szkolenia dotyczące danych, podkreślając jednocześnie znaczenie regularnych testowania, konserwacji, rozważań dotyczących skalowalności i analizy kosztów. Aby uzyskać szerszą perspektywę, bądź na bieżąco z 5 najlepszymi rozwiązaniami LLM typu open source i rozważ wykorzystanie wiedzy Creole Studios do bezpiecznego wdrożenia, umożliwiającego wykorzystanie mocy sztucznej inteligencji przy jednoczesnym zachowaniu rygorystycznych standardów ochrony danych.

Zrozumienie wymagania

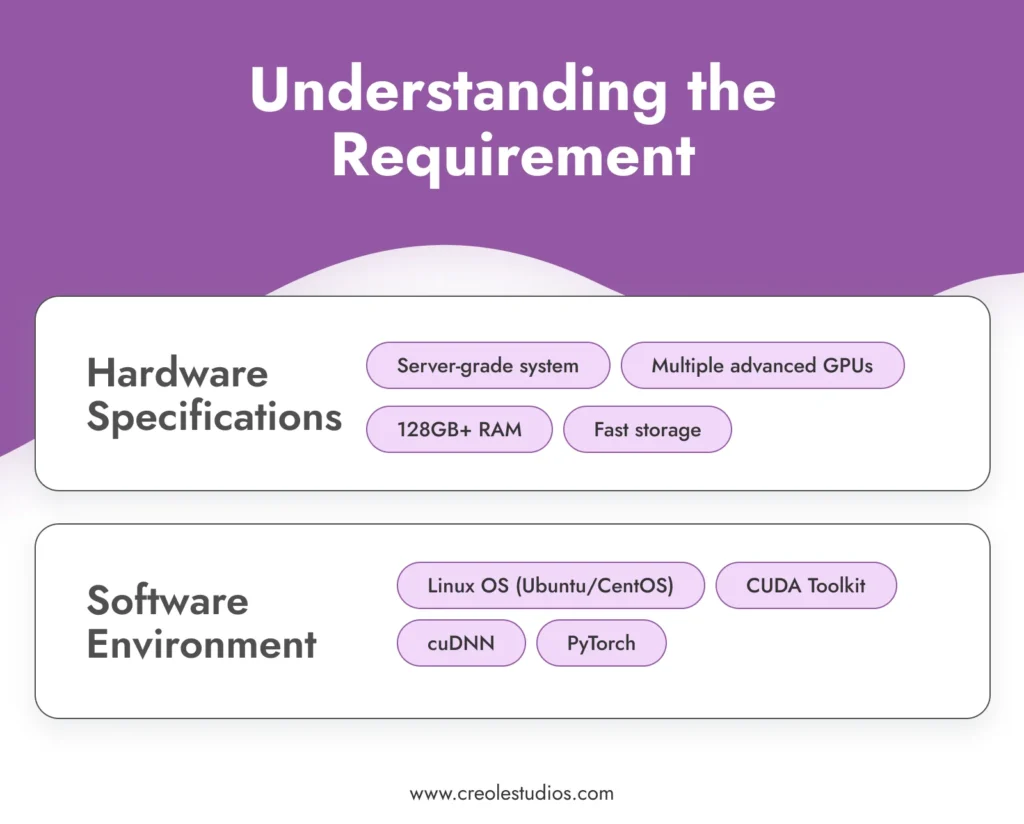

Przed przystąpieniem do procesu instalacji niezwykle ważne jest zrozumienie wymagań dotyczących obsługi tak zaawansowanego modelu, jak FALCON .

- Specyfikacja sprzętu : FALCON, ze swoimi ogromnymi 180 miliardami parametrów, wymaga znacznych zasobów obliczeniowych. Wymaga to środowiska obliczeniowego o wysokiej wydajności, zazwyczaj obejmującego systemy klasy serwerowej wyposażone w wiele zaawansowanych procesorów graficznych (np. NVIDIA A100), znaczną pamięć RAM (128 GB lub więcej) i szybkie rozwiązania pamięci masowej (SSD lub NVMe) do zarządzania modelem i efektywnie przesyłać dane. Możesz zapoznać się z wytycznymi firmy NVIDIA dotyczącymi konfigurowania środowisk AI i ML.

- Środowisko oprogramowania : Efektywne działanie FALCON wymaga stabilnego i kompatybilnego środowiska oprogramowania. Zalecany jest system operacyjny oparty na systemie Linux, taki jak Ubuntu lub CentOS, ze względu na doskonałą obsługę procesora graficznego i kompatybilność z niezbędnymi narzędziami i bibliotekami. Stos oprogramowania obejmuje zestaw narzędzi CUDA do przyspieszania GPU, cuDNN dla głębokich sieci neuronowych i platformy uczenia maszynowego, takie jak PyTorch.

Zdobądź model

Kolejnym krokiem jest pozyskanie modelu FALCON. Może to obejmować :

- Licencjonowanie modelu : sprawdź najnowszą dostępność i opcje licencjonowania FALCON. Licencjonowanie modelu takiego jak FALCON zazwyczaj wiąże się z negocjacjami i umowami, zapewniającymi, że masz prawo do korzystania z modelu. Śledź oficjalne repozytorium FALCON lub powiązane rynki modeli AI, aby uzyskać aktualizacje i szczegóły licencji.

- Transfer modelu : Biorąc pod uwagę szczelny charakter konfiguracji, przeniesienie modelu do środowiska lokalnego jest krokiem krytycznym. Może to obejmować fizyczne przeniesienie modelu przy użyciu bezpiecznych, zaszyfrowanych urządzeń pamięci masowej. Integralność i bezpieczeństwo modelu podczas transferu są najważniejsze.

Skonfiguruj infrastrukturę

Utworzenie solidnej infrastruktury ma kluczowe znaczenie dla wydajnego działania FALCON LLM :

- Konfiguracja serwera : zoptymalizuj swoje serwery pod kątem obciążeń AI o dużej intensywności. Obejmuje to skonfigurowanie wielu procesorów graficznych do przetwarzania równoległego, zapewnienie sieci o dużej przepustowości w systemie i wdrożenie skutecznych rozwiązań chłodzących w celu zarządzania mocą cieplną.

- Zarządzanie pamięcią masową : Biorąc pod uwagę rozmiar FALCON i potencjalnie duże zbiory danych, z którymi będziesz pracować, starannie zaplanuj architekturę pamięci masowej. Ze względu na ich prędkość zalecane są dyski SSD o dużej pojemności lub dyski NVMe. Upewnij się, że masz systemy nadmiarowości i kopii zapasowych.

- Zasilanie i chłodzenie : Te potężne serwery będą wymagały odpowiedniego zasilania i systemów chłodzenia. Upewnij się, że Twoja infrastruktura jest w stanie sprostać tym wymaganiom. Zaleca się skonsultowanie się ze specjalistami ds. sprzętu w celu zaprojektowania centrum danych, które wytrzyma tę konfigurację

Zainstaluj wymagane oprogramowanie

Instalacja oprogramowania jest kluczowym krokiem w konfiguracji LLM typu open source :

- Konfiguracja systemu operacyjnego : Zainstaluj wybraną dystrybucję Linuksa. Ubuntu i CentOS są popularnymi wyborami ze względu na ich stabilność i wsparcie. Upewnij się, że system operacyjny jest skonfigurowany tak, aby optymalnie wykorzystywać zasoby sprzętowe.

- Instalacja zależności : zainstaluj zestaw narzędzi CUDA do obsługi procesora graficznego, cuDNN do obsługi głębokiego uczenia się i PyTorch jako platformę uczenia maszynowego. Upewnij się, że używasz wersji kompatybilnych z modelem FALCON.

- Oprogramowanie zabezpieczające : w zamkniętym środowisku bezpieczeństwo wewnętrzne ma kluczowe znaczenie. Zainstaluj solidną zaporę sieciową i systemy wykrywania włamań. Nawet jeśli system jest odizolowany, mogą wystąpić zagrożenia wewnętrzne lub przypadkowe naruszenia.

Instalacja modelu

Instalacja modelu FALCON składa się z kilku kroków :

- Transfer modelu : Bezpiecznie przenieś pliki modelu do systemu lokalnego za pomocą szyfrowanych urządzeń pamięci masowej.

- Proces instalacji : Postępuj zgodnie z instrukcją instalacji dostarczoną przez FALCON. Zwykle wiąże się to z ustawieniem zmiennych środowiskowych, załadowaniem plików modelu i skonfigurowaniem parametrów modelu.

- Weryfikacja : Po instalacji należy sprawdzić integralność instalacji. Upewnij się, że pliki modelu są nienaruszone i że model poprawnie przeprowadza wstępną diagnostykę.

Bezpieczeństwo danych i zgodność

Zapewnienie bezpieczeństwa danych w szczelnym środowisku obejmuje kilka warstw ochrony :

- Szyfrowanie : wszystkie dane, zarówno przechowywane, jak i przesyłane w sieci, powinny być szyfrowane. Wdrażaj silne protokoły szyfrowania, aby chronić swoje dane.

- Zgodność : przestrzegaj odpowiednich przepisów o ochronie danych i standardów branżowych. Regularnie audytuj swoje systemy pod kątem zgodności.

- Kontrola dostępu : wdrażaj rygorystyczne zasady kontroli dostępu. Dostęp do modelu i danych powinien mieć wyłącznie upoważniony personel.

Trenowanie modelu przy użyciu wyselekcjonowanych danych

Aby dostosować FALCON do konkretnych potrzeb, niezbędne jest przeszkolenie go na podstawie wyselekcjonowanych danych .

- Gromadzenie i przygotowanie danych : Zbierz dane istotne dla Twojego przypadku użycia. Dane te powinny być reprezentatywne, zróżnicowane i wysokiej jakości. Przetwórz wstępnie i wyczyść dane, aby upewnić się, że nadają się do szkolenia.

- Proces szkoleniowy : Skonfiguruj parametry szkoleniowe FALCON tak, aby odpowiadały Twoim celom. Szkolenie modelu takiego jak FALCON wymaga głębokiego zrozumienia zasad uczenia maszynowego i specyfiki architektury modelu.

- Monitorowanie i regulacja : Stale monitoruj proces szkoleniowy pod kątem wydajności i dokładności. Bądź przygotowany na dostosowanie danych lub parametrów treningowych, jeśli jest to konieczne, aby osiągnąć pożądane rezultaty.

Testowanie i konserwacja

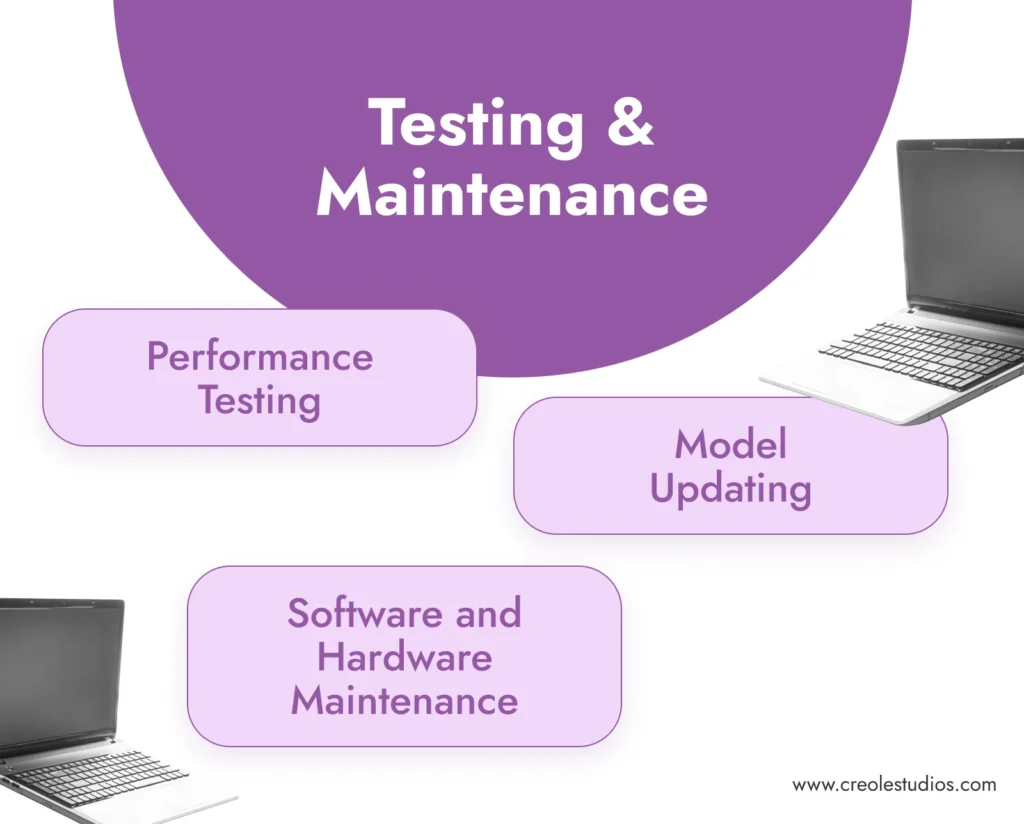

Regularne testowanie i konserwacja mają kluczowe znaczenie dla długoterminowego sukcesu modelu .

- Testowanie wydajności : Regularnie testuj model pod kątem dokładności i wydajności. Obejmuje to uruchamianie zestawów danych walidacyjnych i sprawdzanie wyników modelu pod kątem spójności i jakości.

- Konserwacja oprogramowania i sprzętu : Regularnie aktualizuj i łataj środowisko oprogramowania. Konserwacja sprzętu, aby zapewnić jego efektywne działanie, obejmuje zarządzanie systemami chłodzenia, sprawdzanie zasilaczy i wymianę wszelkich uszkodzonych komponentów.

- Aktualizacja modelu : Bądź na bieżąco z aktualizacjami modelu FALCON. W środowisku pozbawionym przestrzeni powietrznej aktualizacja modelu może wymagać ręcznego przesłania zaktualizowanych plików modelu.

Skalowalność i koszt

Weź pod uwagę przyszły rozwój i konsekwencje kosztowe swojej konfiguracji .

- Planowanie skalowalności : Zaplanuj potencjalne skalowanie swojej infrastruktury. Może to obejmować dodanie większej liczby procesorów graficznych, rozszerzenie pamięci masowej lub zwiększenie wydajności sieci w środowisku bezprzewodowym.

- Analiza kosztów : Regularnie przeglądaj koszty związane z utrzymaniem i funkcjonowaniem FALCON. Obejmuje to koszty sprzętu, zużycie energii i opłaty licencyjne.

Uwagi końcowe: znaczenie programów LLM typu open source i wiedzy specjalistycznej Creole Studios

Lokalna instalacja rozwiązań LLM typu open source, takich jak FALCON, oferuje znaczące korzyści, w tym niezrównaną prywatność danych, dostosowywanie i kontrolę nad możliwościami sztucznej inteligencji. Umożliwia firmom wykorzystanie mocy sztucznej inteligencji, zapewniając jednocześnie, że wrażliwe dane pozostaną w bezpiecznej, prywatnej sieci.

Creole Studios specjalizuje się w pomaganiu klientom w złożonym procesie konfigurowania i utrzymywania rozwiązań LLM typu open source w lokalnych, pozbawionych powietrza środowiskach. Nasza wiedza specjalistyczna zapewnia sprawne, bezpieczne i skuteczne wdrożenie, umożliwiając firmom wykorzystanie pełnego potencjału sztucznej inteligencji przy zachowaniu najwyższych standardów prywatności i bezpieczeństwa danych. Dzięki naszemu wsparciu firmy mogą śmiało stawić czoła wyzwaniom związanym z wdrażaniem sztucznej inteligencji i utrzymać przewagę w szybko rozwijającym się krajobrazie technologicznym.