Kompletny przewodnik po technicznym SEO

Opublikowany: 2023-02-24Wymień trzy rzeczy, które zrobiłeś w tym roku, a które dotyczą optymalizacji pod kątem wyszukiwarek (SEO).

Czy te taktyki koncentrują się wokół badania słów kluczowych, metaopisów i linków zwrotnych?

Jeśli tak, nie jesteś sam. Jeśli chodzi o SEO, techniki te są zwykle pierwszymi, które marketerzy dodają do swojego arsenału.

Strategie te poprawiają wprawdzie widoczność Twojej witryny w bezpłatnych wynikach wyszukiwania, ale nie są jedynymi, które powinieneś stosować. Istnieje jeszcze jeden zestaw taktyk, które mieszczą się pod parasolem SEO.

Techniczne SEO odnosi się do zakulisowych elementów, które napędzają Twój organiczny silnik wzrostu, takich jak architektura witryny, optymalizacja mobilna i szybkość strony. Te aspekty SEO mogą nie być najseksowniejsze, ale są niezwykle ważne.

Pierwszym krokiem do poprawy technicznego SEO jest ustalenie, gdzie się znajdujesz, przeprowadzając audyt witryny. Drugim krokiem jest stworzenie planu odnoszącego się do obszarów, w których ci się nie udaje. Poniżej szczegółowo omówimy te kroki.

Porada dla profesjonalistów: Stwórz stronę internetową przeznaczoną do konwersji za pomocą bezpłatnych narzędzi CMS HubSpot.

Co to jest techniczne SEO?

Techniczne SEO odnosi się do wszystkiego, co robisz, co ułatwia wyszukiwarkom przeszukiwanie i indeksowanie Twojej witryny. Techniczne SEO, strategia treści i strategie budowania linków działają razem, aby Twoje strony zajmowały wysokie pozycje w wyszukiwaniu.

SEO techniczne a SEO na stronie a SEO poza stroną

Wiele osób dzieli optymalizację pod kątem wyszukiwarek (SEO) na trzy różne segmenty: SEO na stronie, SEO poza stroną i SEO techniczne. Omówmy szybko, co każdy z nich oznacza.

SEO na stronie

SEO na stronie odnosi się do treści, która mówi wyszukiwarkom (i czytelnikom!), o czym jest Twoja strona, w tym tekst alternatywny obrazu, użycie słów kluczowych, metaopisy, tagi H1, nazewnictwo adresów URL i wewnętrzne linkowanie. Masz największą kontrolę nad SEO na stronie, ponieważ wszystko jestwTwojej witrynie.

SEO poza stroną

SEO poza stroną mówi wyszukiwarkom, jak popularna i użyteczna jest Twoja strona, poprzez wotum zaufania — w szczególności linki zwrotne lub linki z innych witryn do Twojej własnej. Ilość i jakość linków zwrotnych zwiększa PageRank strony. Zakładając, że wszystko jest równe, strona ze 100 odpowiednimi linkami z wiarygodnych witryn przewyższy ranking strony z 50 odpowiednimi linkami z wiarygodnych witryn (lub 100 nieistotnymi linkami z wiarygodnych witryn).

SEO techniczne

Techniczne SEO jest również pod twoją kontrolą, ale jest nieco trudniejsze do opanowania, ponieważ jest mniej intuicyjne.

Dlaczego techniczne SEO jest ważne?

Możesz ulec pokusie całkowitego zignorowania tego elementu SEO; odgrywa jednak ważną rolę w Twoim ruchu organicznym. Twoje treści mogą być najbardziej dokładne, przydatne i dobrze napisane, ale jeśli wyszukiwarka nie może ich zaindeksować, bardzo niewiele osób kiedykolwiek je zobaczy.

To jest jak drzewo, które upada w lesie, kiedy nie ma nikogo, kto mógłby to usłyszeć… czy wydaje dźwięk? Bez mocnych podstaw technicznych SEO, Twoje treści nie będą miały żadnego dźwięku dla wyszukiwarek.

Źródło

Źródło

Porozmawiajmy o tym, jak sprawić, by Twoje treści odbiły się szerokim echem w internecie.

Zrozumienie technicznego SEO

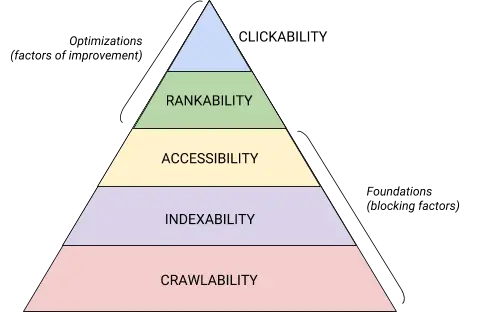

Techniczne SEO to bestia, którą najlepiej podzielić na strawne kawałki. Jeśli jesteś podobny do mnie, lubisz zajmować się dużymi sprawami w kawałkach i za pomocą list kontrolnych. Wierzcie lub nie, ale wszystko, co omówiliśmy do tej pory, można umieścić w jednej z pięciu kategorii, z których każda zasługuje na własną listę elementów, które można zastosować.

Te pięć kategorii i ich miejsce w technicznej hierarchii SEO najlepiej ilustruje ta piękna grafika, która przypomina Hierarchię potrzeb Maslova, ale została zremiksowana w celu optymalizacji pod kątem wyszukiwarek. (Zauważ, że zamiast dostępności użyjemy powszechnie używanego terminu „Renderowanie”.)

Źródło

Źródło

Podstawy audytu technicznego SEO

Zanim zaczniesz od technicznego audytu SEO, musisz wprowadzić kilka podstawowych zasad.

Omówmy te techniczne podstawy SEO, zanim przejdziemy do reszty audytu Twojej witryny.

Przeprowadź audyt swojej preferowanej domeny

Twoja domena to adres URL, który użytkownicy wpisują, aby przejść do Twojej witryny, np. hubspot.com . Twoja domena witryny wpływa na to, czy użytkownicy mogą Cię znaleźć za pomocą wyszukiwania, i zapewnia spójny sposób identyfikowania Twojej witryny.

Wybierając preferowaną domenę, informujesz wyszukiwarki, czy wolisz wyświetlać w wynikach wyszukiwania wersję swojej witryny z przedrostkiem www czy bez. Na przykład możesz wybraćwww.twojawitryna.comzamiasttwojawitryna.com. To mówi wyszukiwarkom, aby nadały priorytet wersji www Twojej witryny i przekierowują wszystkich użytkowników do tego adresu URL. W przeciwnym razie wyszukiwarki potraktują te dwie wersje jako osobne witryny, co spowoduje rozproszenie wartości SEO.

Wcześniej Google prosiło Cię o określenie preferowanej wersji adresu URL. Teraz Google zidentyfikuje i wybierze wersję, aby pokazać ją wyszukiwarkom . Jeśli jednak wolisz ustawić preferowaną wersję swojej domeny, możesz to zrobić za pomocą tagów kanonicznych (które omówimy wkrótce). Tak czy inaczej, po ustawieniu preferowanej domeny upewnij się, że wszystkie warianty, czyliwww, bez www, http i index.html, przekierowują na stałe do tej wersji.

Zaimplementuj SSL

Być może słyszałeś już ten termin — to dlatego, że jest dość ważny. SSL lub Secure Sockets Layer tworzy warstwę ochronną między serwerem sieciowym (oprogramowaniem odpowiedzialnym za realizację żądania online) a przeglądarką, dzięki czemu witryna jest bezpieczna. Kiedy użytkownik wysyła informacje do Twojej witryny, takie jak informacje o płatności lub dane kontaktowe, istnieje mniejsze prawdopodobieństwo, że zostaną one zhakowane, ponieważ chroni je SSL.

Certyfikat SSL jest oznaczony przez domenę zaczynającą się od „https://” zamiast „http://” oraz symbol kłódki na pasku adresu URL.

Wyszukiwarki traktują priorytetowo bezpieczne witryny — w rzeczywistości Google ogłosił już w 2014 r., że protokół SSL będzie brany pod uwagę jako czynnik rankingowy . Z tego powodu pamiętaj, aby ustawić wariant SSL swojej strony głównej jako preferowaną domenę.

Po skonfigurowaniu protokołu SSL musisz przeprowadzić migrację wszystkich stron, które nie korzystają z protokołu SSL, z protokołu http na https. To trudne zadanie, ale warte wysiłku w imię lepszego rankingu. Oto kroki, które musisz wykonać:

- Przekieruj wszystkie strony http://twojawitryna.com na https://twojawitryna.com .

- Zaktualizuj odpowiednio wszystkie tagi canonical i hreflang.

- Zaktualizuj adresy URL w mapie witryny (znajdującej się pod adresem yourwebsite.com/sitemap.xml ) i pliku robot.txt (znajdującym się pod adresem yourwebsite.com/robots.txt ).

- Skonfiguruj nową instancję Google Search Console i Bing Webmaster Tools dla swojej witryny https i śledź ją, aby mieć pewność, że 100% ruchu zostanie przeniesione.

Zoptymalizuj szybkość strony

Czy wiesz, jak długo odwiedzający witrynę będzie czekał na załadowanie Twojej witryny? Sześć sekund … i to jest hojne. Niektóre dane pokazują , że współczynnik odrzuceń wzrasta o 90% wraz ze wzrostem czasu ładowania strony z jednej do pięciu sekund. Nie masz ani sekundy do stracenia, więc poprawa czasu ładowania witryny powinna być priorytetem.

Szybkość witryny jest ważna nie tylko ze względu na wygodę użytkownika i konwersję — to także czynnik rankingowy .

Skorzystaj z tych wskazówek, aby skrócić średni czas ładowania strony:

- Skompresuj wszystkie swoje pliki. Kompresja zmniejsza rozmiar obrazów , a także plików CSS, HTML i JavaScript, dzięki czemu zajmują mniej miejsca i ładują się szybciej.

- Regularnie kontroluj przekierowania. Przetwarzanie przekierowania 301 zajmuje kilka sekund. Pomnóż to przez kilka stron lub warstw przekierowań, a poważnie wpłyniesz na szybkość swojej witryny.

- Skróć swój kod. Niechlujny kod może negatywnie wpłynąć na szybkość Twojej witryny. Niechlujny kod oznacza kod, który jest leniwy. To jak pisanie — być może w pierwszym szkicu wyrażasz swoje zdanie w 6 zdaniach. W drugim szkicu zrobisz to w 3. Im wydajniejszy kod, tym szybciej strona się załaduje (ogólnie). Po wyczyszczeniu wszystkiego zmniejszysz i skompresujesz swój kod .

- Rozważ sieć dystrybucji treści (CDN). Sieci CDN to rozproszone serwery internetowe, które przechowują kopie Twojej witryny w różnych lokalizacjach geograficznych i dostarczają ją na podstawie lokalizacji osoby wyszukującej. Ponieważ informacje między serwerami mają do przebycia krótszą odległość, Twoja witryna ładuje się szybciej dla strony żądającej.

- Staraj się nie być zadowolonym z wtyczki. Przestarzałe wtyczki często mają luki w zabezpieczeniach, które sprawiają, że Twoja witryna jest podatna na ataki złośliwych hakerów, którzy mogą zaszkodzić rankingom Twojej witryny. Upewnij się, że zawsze korzystasz z najnowszych wersji wtyczek i ogranicz użycie do najbardziej niezbędnych. W tym samym duchu rozważ użycie niestandardowych motywów, ponieważ gotowe motywy stron internetowych często zawierają dużo niepotrzebnego kodu.

- Skorzystaj z wtyczek pamięci podręcznej. Wtyczki pamięci podręcznej przechowują statyczną wersję witryny, którą można wysłać do powracających użytkowników, skracając w ten sposób czas ładowania witryny podczas kolejnych wizyt.

- Użyj ładowania asynchronicznego (asynchronicznego). Skrypty to instrukcje, które serwery muszą przeczytać, zanim będą mogły przetworzyć kod HTML, czyli treść Twojej strony internetowej, czyli rzeczy, które odwiedzający chcą zobaczyć w Twojej witrynie. Zazwyczaj skrypty są umieszczane w <head> witryny (pomyśl o skrypcie Menedżera tagów Google), gdzie mają wyższy priorytet niż treść na pozostałej części strony. Korzystanie z kodu asynchronicznego oznacza, że serwer może jednocześnie przetwarzać kod HTML i skrypt, zmniejszając w ten sposób opóźnienie i wydłużając czas ładowania strony.

Oto jak wygląda skrypt asynchroniczny: < script async src =” script.js “></ script >

Jeśli chcesz zobaczyć, gdzie Twoja witryna nie działa pod względem szybkości, możesz skorzystać z tego zasobu Google .

Gdy masz już podstawy techniczne SEO, możesz przejść do następnego etapu — indeksowania.

Lista kontrolna indeksowania

Crawlability jest podstawą Twojej technicznej strategii SEO. Roboty wyszukujące będą indeksować Twoje strony, aby zebrać informacje o Twojej witrynie.

Jeśli te roboty zostaną w jakiś sposób zablokowane przed indeksowaniem, nie będą mogły indeksować ani klasyfikować Twoich stron. Pierwszym krokiem do wdrożenia technicznego SEO jest upewnienie się, że wszystkie ważne strony są dostępne i łatwe w nawigacji.

Poniżej omówimy niektóre elementy, które należy dodać do listy kontrolnej, a także niektóre elementy witryny, które należy skontrolować, aby mieć pewność, że Twoje strony są gotowe do indeksowania.

Lista kontrolna indeksowania

- Utwórz mapę witryny XML.

- Zmaksymalizuj swój budżet indeksowania.

- Zoptymalizuj architekturę witryny.

- Ustaw strukturę adresu URL.

- Użyj pliku robots.txt.

- Dodaj menu nawigacyjne.

- Użyj paginacji.

- Sprawdź pliki dziennika SEO.

1. Utwórz mapę witryny XML.

Pamiętasz tę strukturę witryny, którą omówiliśmy? To należy do czegoś, co nazywa się mapą witryny XML , która pomaga robotom wyszukującym zrozumieć i indeksować twoje strony internetowe. Możesz myśleć o tym jak o mapie swojej witryny. Po ukończeniu prześlesz mapę witryny do Google Search Console i Narzędzi dla webmasterów Bing. Pamiętaj o aktualizowaniu mapy witryny podczas dodawania i usuwania stron internetowych.

2. Zmaksymalizuj swój budżet na indeksowanie.

Budżet na indeksowanie odnosi się do stron i zasobów w Twojej witrynie, które będą indeksowane przez roboty wyszukujące .

Ponieważ budżet na indeksowanie nie jest nieskończony, upewnij się, że priorytetowo traktujesz najważniejsze strony do indeksowania.

Oto kilka wskazówek, dzięki którym zmaksymalizujesz budżet na indeksowanie:

- Usuń lub kanonizuj zduplikowane strony.

- Napraw lub przekieruj wszelkie uszkodzone linki.

- Upewnij się, że Twoje pliki CSS i JavaScript są dostępne do indeksowania.

- Regularnie sprawdzaj statystyki indeksowania i uważaj na nagłe spadki lub wzrosty.

- Upewnij się, że każdy bot lub strona, której indeksowanie jest zabronione, ma zostać zablokowana.

- Aktualizuj mapę witryny i przesyłaj ją do odpowiednich narzędzi dla webmasterów.

- Usuń z witryny niepotrzebne lub nieaktualne treści.

- Uważaj na dynamicznie generowane adresy URL, które mogą sprawić, że liczba stron w Twojej witrynie gwałtownie wzrośnie.

3. Zoptymalizuj architekturę witryny.

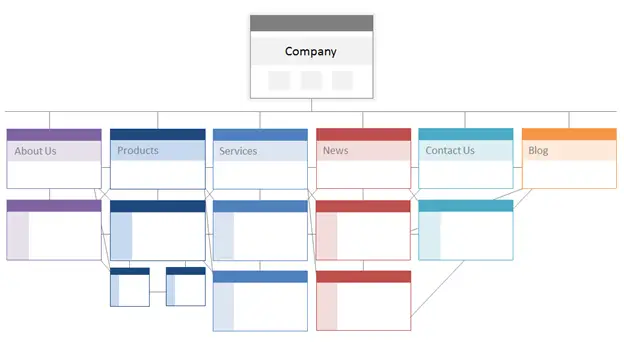

Twoja witryna ma wiele stron. Strony te muszą być zorganizowane w taki sposób, aby wyszukiwarki mogły je łatwo znaleźć i zaindeksować. Tutaj pojawia się struktura Twojej witryny — często nazywana architekturą informacji witryny.

Podobnie jak budynek jest oparty na projekcie architektonicznym, architektura witryny określa sposób organizacji stron w witrynie.

Powiązane strony są pogrupowane; na przykład strona główna twojego bloga zawiera linki do poszczególnych postów na blogu, z których każdy łączy się z odpowiednimi stronami autorów. Ta struktura pomaga robotom wyszukującym zrozumieć relacje między Twoimi stronami.

Architektura Twojej witryny powinna również kształtować i być kształtowana przez znaczenie poszczególnych stron. Im strona A jest bliżej Twojej strony głównej, tym więcej linków prowadzi do strony A i im większy jest udziałtychstron w linkach, tym większe znaczenie wyszukiwarki będą przywiązywać do strony A.

Na przykład link ze strony głównej do strony A ma większe znaczenie niż link z posta na blogu. Im więcej linków do strony A, tym bardziej „znacząca” staje się ta strona dla wyszukiwarek.

Koncepcyjnie architektura witryny mogłaby wyglądać mniej więcej tak, gdzie stronyInformacje, Produkt, Wiadomościitp. są umieszczone na szczycie hierarchii ważności strony.

Źródło

Upewnij się, że najważniejsze strony dla Twojej firmy znajdują się na szczycie hierarchii z największą liczbą (istotnych!) linków wewnętrznych.

4. Ustaw strukturę adresu URL.

Struktura adresów URL odnosi się do struktury adresów URL, któramoże byćokreślona przez architekturę witryny. Za chwilę wyjaśnię związek. Najpierw wyjaśnijmy, że adresy URL mogą mieć podkatalogi, takie jakblog.hubspot.comi/lub podfoldery, takie jakhubspot.com/blog, które wskazują, dokąd prowadzi adres URL.

Na przykład post na blogu zatytułowanyJak czesać psaznalazłby się w subdomenie lub podkatalogu bloga. Adres URL może wyglądać tak : www.bestdogcare.com/blog/how-to-groom-your-dog . Natomiast strona produktu w tej samej witrynie towww.bestdogcare.com/products/grooming-brush.

To, czy użyjesz subdomen, podkatalogów, „produktów” czy „sklepu” w swoim adresie URL, zależy wyłącznie od Ciebie. Piękno tworzenia własnej strony internetowej polega na tym, że możesz stworzyć zasady. Co ważne, reguły te mają ujednoliconą strukturę, co oznacza, że nie należy przełączać się między blog.twojawitryna.com a twojawitryna.com/blogs na różnych stronach. Utwórz plan działania, zastosuj go do struktury nazewnictwa adresów URL i trzymaj się go.

Oto kilka dodatkowych wskazówek dotyczących pisania adresów URL:

- Używaj małych liter.

- Użyj myślników do oddzielenia wyrazów.

- Niech będą krótkie i opisowe.

- Unikaj używania zbędnych znaków lub słów (w tym przyimków).

- Uwzględnij docelowe słowa kluczowe.

Po dopracowaniu struktury adresów URL prześlesz do wyszukiwarek listę adresów URL ważnych stron w formie mapy witryny XML . Dzięki temu roboty wyszukujące zyskają dodatkowy kontekst dotyczący Twojej witryny, dzięki czemu nie będą musiały go odkrywać podczas indeksowania.

5. Wykorzystaj plik robots.txt.

Gdy robot internetowy indeksuje Twoją witrynę, najpierw sprawdza plik /robot.txt, znany również jako protokół wykluczania robotów. Protokół ten może zezwalać lub uniemożliwiać określonym robotom internetowym indeksowanie Twojej witryny, w tym określonych sekcji, a nawet stron Twojej witryny. Jeśli chcesz uniemożliwić robotom indeksowanie Twojej witryny, użyj metatagu robots noindex. Omówmy oba te scenariusze.

Możesz całkowicie zablokować niektórym botom możliwość indeksowania Twojej witryny. Niestety, istnieje kilka botów o złośliwych zamiarach — botów, które zeskrobują Twoje treści lub spamują fora społeczności. Jeśli zauważysz to złe zachowanie, użyjesz pliku robot.txt, aby uniemożliwić im wejście do Twojej witryny. W tym scenariuszu możesz myśleć o pliku robot.txt jako o polu siłowym ze strony złych botów w Internecie.

Jeśli chodzi o indeksowanie, roboty wyszukujące indeksują Twoją witrynę, aby zebrać wskazówki i znaleźć słowa kluczowe, aby dopasować Twoje strony internetowe do odpowiednich zapytań. Ale, jak omówimy później, masz budżet indeksowania, którego nie chcesz wydawać na niepotrzebne dane. Możesz więc wykluczyć strony, które nie pomagają wyszukiwarkom zrozumieć, o czym jest Twoja witryna, na przykład stronaz podziękowaniamiz oferty lub strona logowania.

Bez względu na wszystko, Twój protokół robot.txt będzie unikalny w zależności od tego, co chcesz osiągnąć.

6. Dodaj menu nawigacyjne.

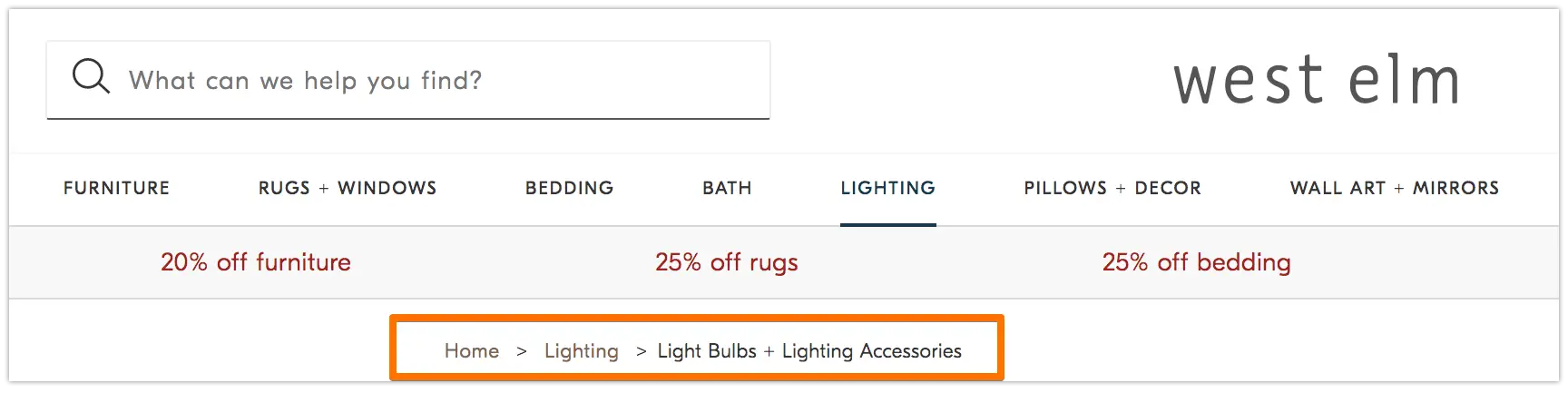

Pamiętasz starą bajkęJaś i Małgosia, w której dwoje dzieci upuściło bułkę tartą na ziemię, aby znaleźć drogę powrotną do domu? Cóż, coś im się pomieszało.

Breadcrumbs są dokładnie tym, jak brzmią — śladem, który prowadzi użytkowników z powrotem do początku ich podróży w Twojej witrynie. Jest to menu stron, które informuje użytkowników, w jaki sposób ich bieżąca strona odnosi się do reszty witryny.

I nie są one przeznaczone tylko dla osób odwiedzających witrynę; boty wyszukiwania również ich używają.

Źródło

Breadcrumbs powinny mieć dwie cechy: 1) być widoczne dla użytkowników, aby mogli łatwo poruszać się po stronach internetowych bez używania przyciskuWstecz, oraz 2) mieć uporządkowany język znaczników, aby zapewnić dokładny kontekst robotom wyszukującym indeksującym Twoją witrynę.

Nie wiesz, jak dodać uporządkowane dane do bułki tartej? Skorzystaj z tego przewodnika dla BreadcrumbList .

7. Użyj paginacji.

Pamiętasz, kiedy nauczyciele wymagali od ciebie ponumerowania stron w pracy naukowej? To się nazywa paginacja. W świecie technicznego SEO paginacja pełni nieco inną rolę, ale nadal można o niej myśleć jako o formie organizacji.

Paginacja używa kodu do informowania wyszukiwarek, kiedy strony z odrębnymi adresami URL są ze sobą powiązane. Na przykład możesz mieć serię treści podzieloną na rozdziały lub wiele stron internetowych. Jeśli chcesz ułatwić robotom wyszukującym wyszukiwanie i indeksowanie tych stron, użyj podziału na strony.

Sposób działania jest dość prosty. Przejdziesz do<head>pierwszej strony serii i użyjesz

rel=”next”, aby powiedzieć robotowi wyszukującemu, którą stronę zaindeksować jako drugą. Następnie na stronie drugiej użyjeszrel=”prev”, aby wskazać poprzednią stronę, irel=”next”, aby wskazać następną stronę i tak dalej.

To wygląda tak…

Na pierwszej stronie:

<link rel=“next” href=“https://www.website.com/page-two” />

Na stronie drugiej:

<link rel=“prev” href=“https://www.website.com/page-one” />

<link rel=“next” href=“https://www.website.com/page-three” />

Pamiętaj, że podział na strony jest przydatny do wykrywania indeksowania, ale nie jest już obsługiwany przez Google do grupowania stron indeksu, jak to było kiedyś.

8. Sprawdź pliki dziennika SEO.

Możesz myśleć o plikach dziennika jak o wpisie do dziennika. Serwery internetowe (dziennikarz) rejestrują i przechowują dane dziennika dotyczące każdego działania podejmowanego w Twojej witrynie w plikach dziennika (dzienniku). Zarejestrowane dane obejmują godzinę i datę żądania, żądaną treść oraz żądany adres IP. Możesz także zidentyfikować agenta użytkownika, który jest oprogramowaniem, które można jednoznacznie zidentyfikować (jak na przykład bot wyszukiwania), które spełnia żądanie użytkownika.

Ale co to ma wspólnego z SEO?

Cóż, roboty wyszukujące pozostawiają ślad w postaci plików dziennika podczas indeksowania Twojej witryny. Możesz określić, czy, kiedy i co zostało przeszukane, sprawdzając pliki dziennika i filtrując według klienta użytkownika i wyszukiwarki .

Te informacje są przydatne, ponieważ możesz określić, w jaki sposób wydawany jest budżet na indeksowanie i jakie bariery w indeksowaniu lub dostępie napotyka bot. Aby uzyskać dostęp do plików dziennika, możesz poprosić programistę lub użyć analizatora plików dziennika, takiego jak Screaming Frog .

To, że robot wyszukujący może zaindeksować Twoją witrynę, nie musi oznaczać, że może zaindeksować wszystkie Twoje strony. Przyjrzyjmy się kolejnej warstwie technicznego audytu SEO — indeksowalności .

Lista kontrolna indeksowalności

Gdy roboty wyszukujące indeksują Twoją witrynę, zaczynają indeksować strony na podstawie ich tematu i związku z tym tematem. Po zindeksowaniu Twoja strona kwalifikuje się do rankingu w SERP. Oto kilka czynników, które mogą pomóc w indeksowaniu Twoich stron.

Lista kontrolna indeksowalności

- Odblokuj botom wyszukiwania dostęp do stron.

- Usuń zduplikowaną treść.

- Audytuj swoje przekierowania.

- Sprawdź responsywność swojej strony na urządzenia mobilne.

- Napraw błędy HTTP.

1. Odblokuj botom wyszukiwania dostęp do stron.

Prawdopodobnie zajmiesz się tym krokiem, gdy zajmiesz się indeksowaniem, ale warto o tym wspomnieć w tym miejscu. Chcesz mieć pewność, że boty będą wysyłane na preferowane przez Ciebie strony i że będą miały do nich swobodny dostęp. Masz do dyspozycji kilka narzędzi, aby to zrobić. Tester pliku robots.txt firmy Google wyświetli listę stron, które są niedozwolone, i możesz użyć narzędzia Inspect w Google Search Console, aby określić przyczynę zablokowania stron.

2. Usuń powielone treści.

Zduplikowana treść dezorientuje roboty wyszukujące i negatywnie wpływa na indeksowalność. Pamiętaj, aby używać kanonicznych adresów URL w celu ustalenia preferowanych stron.

3. Audytuj swoje przekierowania.

Sprawdź, czy wszystkie przekierowania są poprawnie skonfigurowane. Pętle przekierowań, uszkodzone adresy URL lub — co gorsza — niewłaściwe przekierowania mogą powodować problemy podczas indeksowania Twojej witryny. Aby tego uniknąć, regularnie kontroluj wszystkie swoje przekierowania.

4. Sprawdź responsywność swojej strony na urządzenia mobilne.

Jeśli Twoja witryna nie jest do tej pory dostosowana do urządzeń mobilnych, oznacza to, że jesteś daleko w tyle, gdzie powinieneś. Już w 2016 r. Google zaczął najpierw indeksować witryny mobilne , kładąc pierwszeństwo na urządzeniach mobilnych, a nie na komputerach. Obecnie to indeksowanie jest domyślnie włączone. Aby nadążyć za tym ważnym trendem, możesz skorzystać z testu dostosowania mobilnego Google , aby sprawdzić, gdzie Twoja witryna wymaga poprawy.

5. Napraw błędy HTTP.

HTTP to skrót od HyperText Transfer Protocol, ale prawdopodobnie nie przejmujesz się tym. Zależy Ci na tym, kiedy HTTP zwraca błędy Twoim użytkownikom lub wyszukiwarkom i jak je naprawić.

Błędy HTTP mogą utrudniać pracę robotom wyszukującym, blokując im dostęp do ważnych treści w Twojej witrynie. Dlatego niezwykle ważne jest, aby szybko i dokładnie usunąć te błędy.

Ponieważ każdy błąd HTTP jest unikalny i wymaga określonego rozwiązania, w poniższej sekcji znajduje się krótkie wyjaśnienie każdego z nich, a podane linki pozwolą uzyskać więcej informacji na temat tych błędów lub sposobów ich rozwiązania.

- Stałe przekierowania 301 służą do stałego kierowania ruchu z jednego adresu URL na inny. Twój CMS pozwoli Ci skonfigurować te przekierowania, ale zbyt wiele z nich może spowolnić Twoją witrynę i pogorszyć wrażenia użytkownika, ponieważ każde dodatkowe przekierowanie wydłuża czas ładowania strony. Jeśli to możliwe, dąż do zerowych łańcuchów przekierowań, ponieważ zbyt wiele spowoduje, że wyszukiwarki zrezygnują z indeksowania tej strony.

- Tymczasowe przekierowanie 302 to sposób na tymczasowe przekierowanie ruchu z adresu URL na inną stronę internetową. Chociaż ten kod stanu automatycznie przekieruje użytkowników do nowej strony internetowej, zapisany w pamięci podręcznej tag tytułu, adres URL i opis pozostaną zgodne z początkowym adresem URL. Jeśli jednak tymczasowe przekierowanie pozostanie na miejscu wystarczająco długo, ostatecznie zostanie potraktowane jako przekierowanie stałe, a te elementy zostaną przekazane do docelowego adresu URL.

- 403 Forbidden Messages oznacza, że treść żądana przez użytkownika jest ograniczona na podstawie uprawnień dostępu lub z powodu błędnej konfiguracji serwera.

- Strony błędów 404 informują użytkowników, że żądana strona nie istnieje, ponieważ została usunięta lub wpisali zły adres URL. Zawsze dobrze jest tworzyć strony 404, które są zgodne z marką i angażują użytkowników, aby zatrzymać użytkowników w witrynie (kliknij powyższy link, aby zobaczyć kilka dobrych przykładów).

- Metoda 405 niedozwolona oznacza, że serwer Twojej witryny rozpoznał metodę dostępu i nadal ją blokuje, co powoduje wyświetlenie komunikatu o błędzie.

- Wewnętrzny błąd serwera 500 to ogólny komunikat o błędzie, który oznacza, że na serwerze internetowym występują problemy z dostarczaniem witryny do strony żądającej.

- Błąd 502 Bad Gateway jest związany z błędną komunikacją lub nieprawidłową odpowiedzią między serwerami witryny.

- 503 Usługa niedostępna mówi ci, że chociaż twój serwer działa poprawnie, nie jest w stanie spełnić żądania.

- 504 Gateway Timeout oznacza, że serwer nie otrzymał w odpowiednim czasie odpowiedzi z Twojego serwera internetowego, aby uzyskać dostęp do żądanych informacji.

Bez względu na przyczynę tych błędów ważne jest, aby je rozwiązać, aby zadowolić zarówno użytkowników, jak i wyszukiwarki oraz aby obie strony wracały do Twojej witryny.

Nawet jeśli Twoja witryna została przeszukana i zindeksowana, problemy z dostępnością, które blokują użytkowników i boty, będą miały wpływ na Twoje SEO. To powiedziawszy, musimy przejść do następnego etapu technicznego audytu SEO — renderowania.

Lista kontrolna renderowalności

Zanim zagłębimy się w ten temat, ważne jest, aby zwrócić uwagę na różnicę między dostępnością SEO a dostępnością sieci . Ta ostatnia polega na ułatwieniu nawigacji po stronach internetowych użytkownikom niepełnosprawnym lub upośledzonym, takim jak na przykład ślepota lub dysleksja. Wiele elementów dostępności online pokrywa się z najlepszymi praktykami SEO. Jednak audyt dostępności SEO nie uwzględnia wszystkiego, co musisz zrobić, aby Twoja witryna była bardziej dostępna dla osób niepełnosprawnych.

W tej sekcji skupimy się na dostępności SEO lub renderowaniu, ale podczas opracowywania i utrzymywania witryny pamiętaj o dostępności sieci.

Lista kontrolna renderowalności

Dostępna witryna opiera się na łatwości renderowania. Poniżej znajdują się elementy witryny, które należy przejrzeć na potrzeby audytu renderowania.

Wydajność serwera

Jak dowiedziałeś się powyżej, przekroczenie limitu czasu serwera i błędy powodują błędy HTTP, które utrudniają użytkownikom i botom dostęp do Twojej witryny. Jeśli zauważysz problemy z serwerem, skorzystaj z zasobów podanych powyżej, aby je rozwiązać. Niezrobienie tego w odpowiednim czasie może spowodować usunięcie Twojej strony przez wyszukiwarki z ich indeksu, ponieważ pokazywanie użytkownikowi uszkodzonej strony jest złym doświadczeniem.

Stan HTTP

Podobnie jak w przypadku wydajności serwera, błędy HTTP uniemożliwią dostęp do Twoich stron internetowych. Możesz użyć robota indeksującego, takiego jak Screaming Frog , Botify lub DeepCrawl , aby przeprowadzić kompleksowy audyt błędów w swojej witrynie.

Czas ładowania i rozmiar strony

Jeśli Twoja strona ładuje się zbyt długo, współczynnik odrzuceń nie jest jedynym problemem, o który musisz się martwić. Opóźnienie w ładowaniu strony może spowodować błąd serwera, który zablokuje dostęp botów do Twoich stron internetowych lub zmusi je do indeksowania częściowo załadowanych wersji, w których brakuje ważnych sekcji treści. W zależności od tego, jak duże jest zapotrzebowanie na indeksowanie dla danego zasobu, boty będą wydawać równoważną ilość zasobów na próby załadowania, renderowania i indeksowania stron. Powinieneś jednak zrobić wszystko, co w twojej mocy, aby skrócić czas ładowania strony.

Renderowanie JavaScript

Google ma wprawdzie trudności z przetwarzaniem JavaScript (JS), dlatego zaleca stosowanie wstępnie renderowanych treści w celu poprawy dostępności. Google udostępnia również wiele zasobów , które pomogą Ci zrozumieć, w jaki sposób roboty wyszukujące uzyskują dostęp do JS w Twojej witrynie i jak poprawić problemy związane z wyszukiwaniem.

Strony sieroce

Każda strona w Twojej witrynie powinna być połączona zco najmniejjedną inną stroną — najlepiej z większą liczbą, w zależności od tego, jak ważna jest dana strona. Gdy strona nie ma wewnętrznych linków, nazywa się ją stroną osieroconą. Podobnie jak artykuł bez wstępu, strony te nie mają kontekstu, którego boty potrzebują, aby zrozumieć, w jaki sposób powinny być indeksowane.

Głębokość strony

Głębokość strony odnosi się do tego, ile warstw w dół strony znajduje się w strukturze witryny, tj. o ile kliknięć dzieli ją od strony głównej. Najlepiej jest zachować architekturę witryny tak płytką, jak to tylko możliwe, przy jednoczesnym zachowaniu intuicyjnej hierarchii. Czasami wielowarstwowa witryna jest nieunikniona; w takim przypadku będziesz chciał nadać priorytet dobrze zorganizowanej witrynie nad płytkością.

Niezależnie od tego, ile warstw ma Twoja witryna, ważne strony — takie jak strony produktu i dane kontaktowe — powinny znajdować się na głębokości nie większej niż trzy kliknięcia. Struktura, która zakopuje stronę produktu tak głęboko w witrynie, że użytkownicy i boty muszą bawić się w detektywa, aby je znaleźć, jest mniej dostępna i zapewnia słabe wrażenia

Na przykład taki adres URL witryny, który kieruje docelowych odbiorców na stronę produktu, jest przykładem źle zaplanowanej struktury witryny: www.yourwebsite.com/products-features/features-by-industry/linie lotnicze-studia przypadków/linie lotnicze -produkty.

Łańcuchy przekierowań

Decydując się na przekierowanie ruchu z jednej strony na drugą, płacisz pewną cenę. Ta cena to wydajność indeksowania. Przekierowania mogą spowolnić indeksowanie, skrócić czas wczytywania strony i uniemożliwić dostęp do witryny, jeśli te przekierowania nie są prawidłowo skonfigurowane. Z tych wszystkich powodów staraj się ograniczyć przekierowania do minimum.

Po rozwiązaniu problemów z dostępnością możesz przejść do rankingu stron w SERP.

Lista kontrolna rankingu

Teraz przechodzimy do bardziej aktualnych elementów, o których prawdopodobnie już wiesz — jak poprawić ranking z technicznego punktu widzenia SEO. Pozycjonowanie stron obejmuje niektóre elementy na stronie i poza nią, o których wspominaliśmy wcześniej, ale z technicznego punktu widzenia.

Pamiętaj, że wszystkie te elementy współpracują ze sobą, tworząc stronę przyjazną dla SEO. Bylibyśmy więc niedbali, gdybyśmy pominęli wszystkie czynniki, które się do tego przyczyniły. Zagłębmy się w to.

Łączenie wewnętrzne i zewnętrzne

Linki pomagają robotom wyszukującym zrozumieć, gdzie strona pasuje do wielkiego schematu zapytania i dają kontekst do rankingu tej strony. Linki kierują roboty wyszukujące (i użytkowników) do powiązanych treści i przenoszą znaczenie strony. Ogólnie rzecz biorąc, łączenie poprawia indeksowanie, indeksowanie i zdolność do pozycjonowania.

Jakość linków zwrotnych

Linki zwrotne — linki z innych witryn prowadzące do Twojej — stanowią wotum zaufania dla Twojej witryny. Mówią robotom wyszukiwania, że zewnętrzna witryna A uważa, że Twoja strona jest wysokiej jakości i warta indeksowania. Gdy te głosy się sumują, roboty wyszukujące zauważają i traktują Twoją witrynę jako bardziej wiarygodną. Brzmi jak świetna okazja, prawda? Jednak, jak w przypadku większości wspaniałych rzeczy, jest jedno zastrzeżenie. Jakość tych linków zwrotnych ma duże znaczenie.

Linki z witryn o niskiej jakości mogą w rzeczywistości zaszkodzić twoim rankingom. Istnieje wiele sposobów na uzyskanie wysokiej jakości linków zwrotnych do Twojej witryny, takich jak docieranie do odpowiednich publikacji, zgłaszanie roszczeń do niepowiązanych wzmianek, udostępnianie odpowiednich publikacji, zgłaszanie roszczeń do niepowiązanych wzmianek i udostępnianie przydatnych treści, do których inne witryny chcą się odwoływać.

Klastry treści

My w HubSpot nie wstydzimy się naszej miłości do klastrów treści ani tego, jak przyczyniają się one do wzrostu organicznego . Klastry treści łączą pokrewne treści, dzięki czemu roboty wyszukujące mogą łatwo znajdować, przeszukiwać i indeksować wszystkie posiadane przez Ciebie strony na określony temat. Działają jako narzędzie autopromocji, aby pokazać wyszukiwarkom, ile wiesz na dany temat, więc jest bardziej prawdopodobne, że uznają Twoją witrynę za autorytet dla dowolnego powiązanego zapytania.

Twoja pozycja w rankingu jest głównym wyznacznikiem wzrostu ruchu organicznego, ponieważ badania pokazują, że osoby wyszukujące częściej klikają trzy najlepsze wyniki wyszukiwania w SERP. Ale jak upewnić się, żeTwójwynik zostanie kliknięty?

Zakończmy to ostatnim elementem piramidy ruchu organicznego: klikalnością.

Lista kontrolna klikalności

Współczynnik klikalności (CTR) ma wiele wspólnego z zachowaniem wyszukiwarki, ale są rzeczy,które możeszzrobić, aby poprawić klikalność w SERP. Chociaż metaopisy i tytuły stron ze słowami kluczowymi mają wpływ na CTR, skupimy się na elementach technicznych, ponieważ właśnie dlatego tu jesteś.

Lista kontrolna klikalności

- Korzystaj z danych strukturalnych.

- Wygraj funkcje SERP.

- Optymalizuj pod kątem polecanych fragmentów.

- Rozważ Google Discover.

Ranking i współczynnik klikalności idą w parze, ponieważ, bądźmy szczerzy, wyszukujący oczekują natychmiastowych odpowiedzi. Im bardziej Twój wynik wyróżnia się w SERP, tym większe prawdopodobieństwo kliknięcia. Omówmy kilka sposobów na poprawę klikalności.

1. Korzystaj z danych strukturalnych.

Dane strukturalne wykorzystują określone słownictwo zwane schematem do kategoryzowania i etykietowania elementów na Twojej stronie internetowej dla robotów wyszukujących. Schemat wyjaśnia, czym jest każdy element, w jaki sposób odnosi się do Twojej witryny i jak go interpretować. Zasadniczo dane strukturalne mówią botom „To jest wideo”, „To jest produkt” lub „To jest przepis”, nie pozostawiając miejsca na interpretację .

To be clear, using structured data is not a “clickability factor” (if there even is such a thing), but it does help organize your content in a way that makes it easy for search bots to understand, index, and potentially rank your pages.

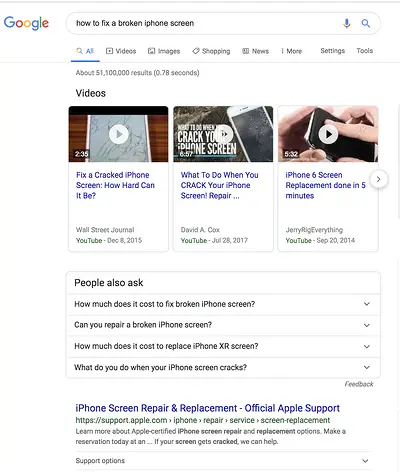

2. Win SERP features.

SERP features , otherwise known as rich results, are a double-edged sword. If you win themandget the click-through, you're golden. If not, your organic results are pushed down the page beneath sponsored ads, text answer boxes, video carousels, and the like.

Rich results are those elements that don't follow the page title, URL, meta description format of other search results. For example, the image below shows two SERP features — a video carousel and “People Also Ask” box — above the first organic result.

While you can still get clicks from appearing in the top organic results, your chances are greatly improved with rich results.

How do you increase your chances of earning rich results? Write useful content and use structured data. The easier it is for search bots to understand the elements of your site, the better your chances of getting a rich result.

Structured data is useful for getting these ( and other search gallery elements ) from your site to the top of the SERPs, thereby, increasing the probability of a click-through:

- Articles

- Videos

- Opinie

- Events

- How-Tos

- FAQs (“People Also Ask” boxes)

- Images

- Local Business Listings

- Products

- Sitelinks

3. Optimize for Featured Snippets.

One unicorn SERP feature that has nothing to do with schema markup is Featured Snippets, those boxes above the search results that provide concise answers to search queries.

Featured Snippets are intended to get searchers the answers to their queries as quickly as possible. According to Google , providing the best answer to the searcher's query is the only way to win a snippet. However, HubSpot's research revealed a few additional ways to optimize your content for featured snippets .

4. Consider Google Discover.

Google Discover is a relatively new algorithmic listing of content by category specifically for mobile users. It's no secret that Google has been doubling down on the mobile experience; with over 50% of searches coming from mobile , it's no surprise either. The tool allows users to build a library of content by selecting categories of interest (think: gardening, music, or politics).

At HubSpot, we believe topic clustering can increase the likelihood of Google Discover inclusion and are actively monitoring our Google Discover traffic in Google Search Console to determine the validity of that hypothesis. We recommend that you also invest some time in researching this new feature. The payoff is a highly engaged user base that has basically hand-selected the content you've worked hard to create.

The Perfect Trio

Technical SEO, on-page SEO, and off-page SEO work together to unlock the door to organic traffic. While on-page and off-page techniques are often the first to be deployed, technical SEO plays a critical role in getting your site to the top of the search results and your content in front of your ideal audience. Use these technical tactics to round out your SEO strategy and watch the results unfold.