WordPress robots.txt

Opublikowany: 2019-02-26WordPress robots.txt jest bardzo ważny dla SEO. Aby mieć pewność, że Twoja witryna jest dobrze pozycjonowana w wynikach wyszukiwania, musisz sprawić, by jej najważniejsze strony były wygodne do wyszukiwania i indeksowania „robotów” („botów”) wyszukiwarek. Dobrze skonstruowany plik robots.txt pomoże skierować te boty na strony, które chcesz zindeksować.

W tym artykule ujawnimy takie pytania:

- Co to jest plik robots.txt i dlaczego jest ważny

- Lokalizacja txt robotów WordPress

- Najlepszy tekst robota dla WordPress

- Jak utworzyć plik robots.txt

- Jak sprawdzić plik robots.txt i wysłać go do konsoli wyszukiwania Google.

Co to jest plik robots.txt dla WordPressa i dlaczego jest ważny?

Kiedy tworzysz nową witrynę, wyszukiwarki wyślą swoje roboty, aby przeskanowały i utworzyły mapę wszystkich jej stron. W ten sposób będą wiedzieć, które strony wyświetlić w wynikach wyszukiwania odpowiednich słów kluczowych. Na podstawowym poziomie jest to dość proste (sprawdź też ten przydatny post – domyślny plik .htaccess WordPressa).

Problem polega na tym, że współczesne strony internetowe zawierają wiele innych elementów poza stronami. WordPress umożliwia instalowanie np. wtyczek, które często posiadają własne katalogi. Nie ma potrzeby pokazywania tego w wynikach wyszukiwania, ponieważ nie pasują one do treści.

To, co robi plik robots.txt, to zestaw wskazówek dla robotów wyszukujących. Mówi im: „Spójrz tutaj i zindeksuj te strony, ale nie wchodź w inne obszary!”. Ten plik może być tak szczegółowy, jak chcesz i jest bardzo łatwy do utworzenia, nawet jeśli jesteś początkującym.

W praktyce wyszukiwarki nadal będą skanować Twoją witrynę, nawet jeśli nie utworzysz pliku robots.txt. Jednak nieutworzenie go jest bardzo irracjonalnym krokiem. Bez tego pliku pozostawiasz robotom indeksowanie całej zawartości Twojej witryny, a one decydują, że musisz pokazać wszystkie części witryny, nawet te, które chciałbyś ukryć przed publicznym dostępem (sprawdź także – Najlepsze wtyczki eCommerce WordPress ).

Co ważniejsze, bez pliku robots.txt Twoja witryna będzie miała dużo trafień od robotów z Twojej witryny. Wpłynie to niekorzystnie na jego wydajność. Nawet jeśli frekwencja Twojej witryny jest nadal niewielka, szybkość ładowania strony jest czymś, co zawsze powinno być priorytetem i na najwyższym poziomie. W końcu jest tylko kilka rzeczy, których ludzie nie lubią bardziej niż powolne ładowanie stron internetowych.

Lokalizacja txt robotów WordPress

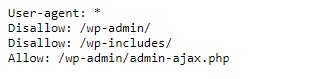

Kiedy tworzysz witrynę WordPress, plik robots.txt jest automatycznie tworzony i umieszczany w głównym katalogu na serwerze. Na przykład, jeśli Twoja witryna znajduje się tutaj – wpdevart.com, możesz ją znaleźć pod adresem wpdevart.com/robots.txt i zobaczyć coś takiego:

To jest przykład najprostszego pliku robots.txt. Tłumacząc na język czytelny dla człowieka, prawa strona po User-agent: deklaruje

dla jakich robotów obowiązują zasady. Gwiazdka oznacza, że reguła jest uniwersalna i dotyczy wszystkich robotów. W tym przypadku plik informuje roboty, że nie mogą skanować katalogów wp-admin i wp-includes. Znaczenie tych reguł jest takie, że katalogi te zawierają wiele plików, które wymagają ochrony przed publicznym dostępem (sprawdź też naszą wtyczkę WordPress Countdown).

Oczywiście możesz dodać więcej reguł do swojego pliku. Zanim to zrobisz, musisz zrozumieć, że jest to plik wirtualny. Zwykle plik robots.txt WordPressa znajduje się w katalogu głównym, który często nazywa się public_html lub www (lub nazwą Twojej strony internetowej):

Należy zauważyć, że tworzony domyślnie plik robots.txt dla WordPressa nie jest dostępny z żadnego katalogu. Działa, ale jeśli chcesz dokonać zmian, musisz stworzyć własny plik i przesłać go do katalogu głównego.

Przyjrzymy się kilku sposobom tworzenia pliku robots.txt dla WordPressa. Porozmawiajmy teraz, jak określić, które reguły należy uwzględnić w pliku.

Najlepszy tekst robota dla WordPress

Stworzenie najlepszego pliku txt robots dla Twojej witryny WordPress nie jest trudne. Więc jakie reguły muszą być zawarte w pliku robots.txt. W poprzedniej sekcji widzieliśmy przykład pliku robots.txt wygenerowanego przez WordPress. Zawiera tylko dwie krótkie zasady, ale dla większości witryn są one wystarczające. Przyjrzyjmy się dwóm różnym plikom robots.txt i zobaczmy, co robi każdy z nich.

Oto nasz pierwszy przykład pliku robots.txt WordPress:

User-agent: * Allow: / # Disallowed Sub-Directories Disallow: / payout / Disallow: / photos / Disallow: / forums /Ten plik robots.txt został utworzony na potrzeby forum. Wyszukiwarki zazwyczaj indeksują każdy wątek na forum. W zależności od tematu forum możesz chcieć zabronić indeksowania. Na przykład Google nie zindeksuje setek krótkich dyskusji użytkowników. Możesz także ustawić reguły wskazujące na określony wątek na forum, aby go wykluczyć i zezwolić wyszukiwarkom na indeksowanie pozostałych.

Zauważysz również linię zaczynającą się od Zezwól: / na górze pliku. Ten wiersz informuje roboty, że mogą skanować wszystkie strony Twojej witryny, z wyjątkiem ograniczeń określonych poniżej. Zauważyłeś również, że ustawiliśmy te reguły jako uniwersalne (z gwiazdką), tak jak to było w wirtualnym pliku robots.txt WordPress (możesz też sprawdzić naszą wtyczkę tabeli cen WordPress).

Sprawdźmy inny przykładowy plik robots.txt WordPress:

User-agent: * Disallow: / wp-admin / Disallow: / wp-includes / User-agent: Bingbot Disallow: /W tym pliku ustawiamy te same reguły, które domyślnie trafiają do WordPressa. Chociaż dodajemy również nowy zestaw reguł, które blokują roboty wyszukiwania Bing przed indeksowaniem naszej witryny. Bingbot, jak widać, to nazwa robota.

Możesz również wpisać nazwy innych wyszukiwarek, aby ograniczyć / zezwolić na ich dostęp. W praktyce oczywiście Bingbot jest bardzo dobry (nawet jeśli nie tak dobry jak Googlebot). Istnieje jednak wiele złośliwych robotów.

Zła wiadomość jest taka, że nie zawsze postępują zgodnie z instrukcjami zawartymi w pliku robots.txt (nadal działają jak terroryści). Należy pamiętać, że chociaż większość robotów skorzysta z instrukcji zawartych w tym pliku, nie można ich do tego zmusić.

Jeśli zagłębisz się w temat, znajdziesz wiele sugestii dotyczących tego, na co zezwalać, a co blokować na swojej witrynie WordPress. Chociaż z naszego doświadczenia wynika, że często mniej reguł jest lepszych. Oto przykład

najlepszy plik robots txt dla witryny WordPress, ale dla innej witryny może być inny:

User-agent: * Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Disallow: *utm*= Disallow: *openstat= Allow: */uploads Sitemap: https://wpdevart.com/sitemap.xmlTradycyjnie WordPress lubi zamykać katalogi wp-admin i wp-includes. Jednak nie jest to już najlepsze rozwiązanie. Dodatkowo, jeśli dodasz metatagi do swoich obrazów w celu promocji (SEO), nie ma sensu mówić robotom, aby nie indeksowały zawartości tych katalogów.

To, co powinno zawierać plik robots.txt, będzie zależeć od potrzeb Twojej witryny. Dlatego zachęcamy do dalszych badań!

Jak stworzyć robots.txt

Co może być prostsze niż tworzenie pliku tekstowego (txt). Wszystko, co musisz zrobić, to otworzyć swój ulubiony edytor (np. Notatnik lub TextEdit) i wprowadzić kilka linijek. Następnie zapisujesz plik za pomocą robotów i rozszerzenia txt (robots.txt). Zajmie to kilka sekund, więc możesz utworzyć robots.txt dla WordPressa bez używania wtyczki.

Zapisaliśmy ten plik lokalnie na komputerze. Po utworzeniu własnego pliku musisz połączyć się ze swoją witryną przez FTP (może z FileZilla).

Po połączeniu się ze swoją witryną przejdź do katalogu public_html. Teraz wystarczy tylko przesłać plik robots.txt z komputera na serwer. Możesz to zrobić, klikając plik prawym przyciskiem myszy w lokalnym nawigatorze FTP lub po prostu przeciągając go myszą.

To zajmuje tylko kilka sekund. Jak widać, ta metoda jest łatwiejsza niż korzystanie z wtyczki.

Jak sprawdzić plik robots.txt WordPress i wysłać go do Google Search Console

Po utworzeniu i przesłaniu pliku robots.txt WordPress, możesz sprawdzić błędy w Google Search Console. Search Console to zestaw narzędzi Google zaprojektowanych, aby pomóc Ci śledzić, jak Twoje treści pojawiają się w wynikach wyszukiwania. Jedno z tych narzędzi sprawdza plik robots.txt, łatwo znajdziesz go na stronie administratora narzędzi Google dla webmasterów (sprawdź także The 50 Best WordPress Plugins 2020).

Znajdziesz tam pole edytora, w którym możesz dodać kod do pliku robots.txt WordPress i kliknij Prześlij w prawym dolnym rogu. Konsola wyszukiwarki Google zapyta Cię, czy chcesz użyć nowego kodu, czy pobrać plik ze swojej witryny.

Teraz platforma sprawdzi Twój plik pod kątem błędów. Jeśli zostanie znaleziony błąd, zostanie wyświetlona informacja o tym. Widziałeś kilka przykładów pliku robots.txt WordPress, a teraz masz jeszcze większe szanse na stworzenie idealnego pliku robots.txt!