Atualização de spam do Google acaba de ser concluída: veja o que aconteceu

Publicados: 2022-10-24

Ocasionalmente, o Google lança sua atualização de spam, que apenas garante que os resultados no Google não sejam preenchidos com spam.

Porque se um usuário clicar em um resultado com spam, e se isso acontecer continuamente, isso cria uma experiência terrível e as pessoas param de usar o Google.

Eles não fornecem muitos detalhes sobre a atualização de spam em seu site, mas, felizmente para você, temos duas coisas que nos ajudam a determinar quais foram as alterações.

A primeira coisa que temos é rastrear mais de 900 milhões de domínios na web, então isso nos permite ver padrões.

A segunda, mais relevante para esta atualização, está em nossa agência, NP Digital, temos 100 sites experimentais que usam conteúdo escrito por IA. O objetivo desses sites não é “jogar” com o Google, eles são mais para descobrir como o Google percebe o conteúdo escrito por IA. E entrarei em mais detalhes sobre o que aconteceu com esses sites mais adiante neste post, pois os resultados foram interessantes.

Finalidade da atualização

Como no nome, o principal objetivo do Google é reduzir o spam. Agora eles têm vários tipos de atualizações de spam, como em julho de 2021, eles tiveram uma atualização de spam de link.

Esta atualização não especificou se era spam relacionado a links ou apenas spam geral.

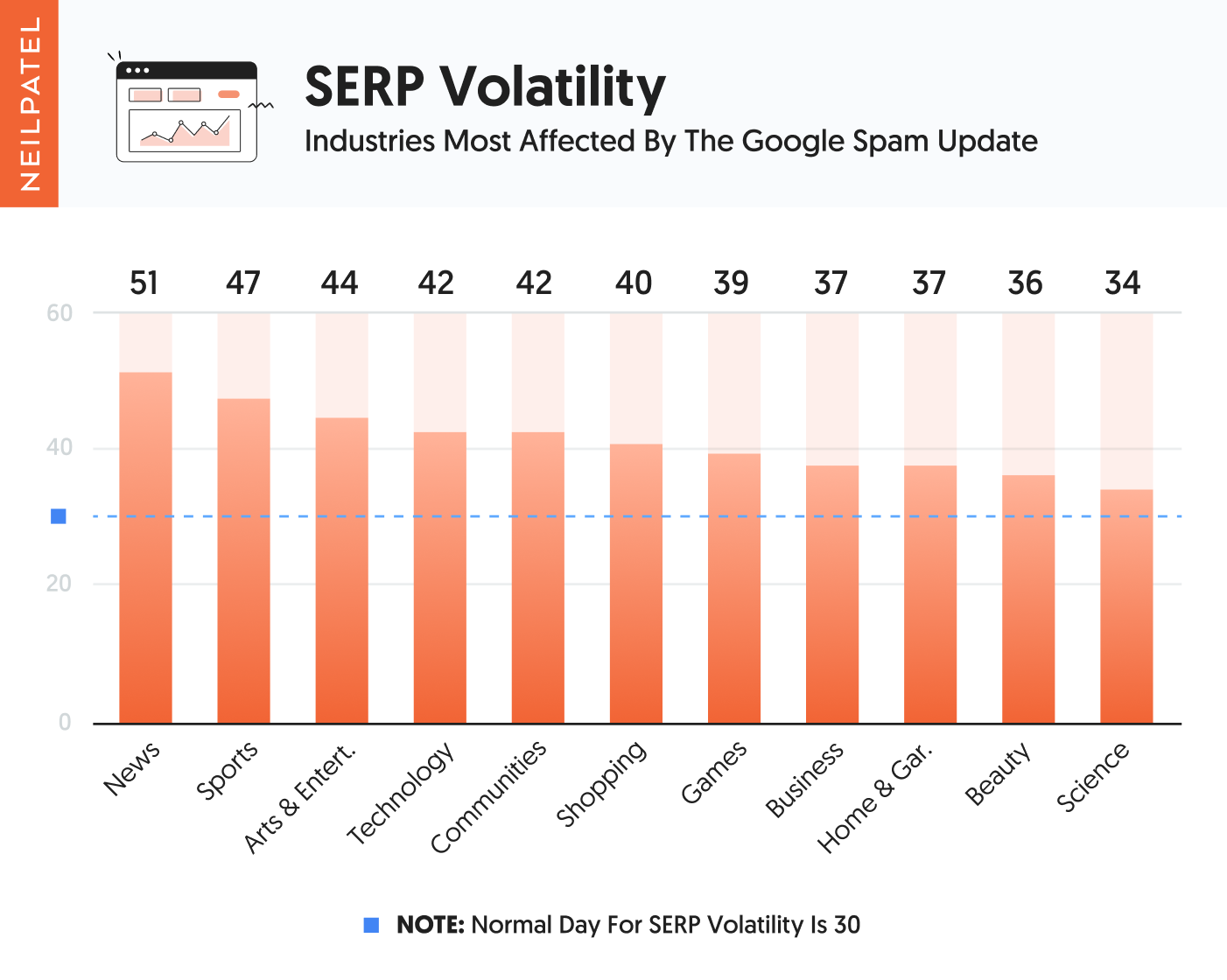

Mas quando olhamos para os mais de 900 milhões de domínios que rastreamos, aqui estão as categorias que foram mais afetadas de forma negativa globalmente.

Como você pode ver no gráfico acima, os sites de notícias e esportes foram os mais afetados. Seguido de perto por artes e entretenimento e tecnologia e sites comunitários.

A maioria desses sites é baseada em conteúdo pesado e não é orientada para o produto.

Quando analisamos os sites afetados, eis o que descobrimos:

- Conteúdo superficial – a maioria deles não tinha conteúdo incrível… muitos deles tinham conteúdo superficial. E para esclarecer que, por conteúdo fino, não quero dizer baixa contagem de palavras, quero dizer conteúdo que realmente não forneceu muito valor. Em essência, o conteúdo era superficial e, uma vez que você terminasse de lê-lo, não obteria muitos insights ou pontos ou valores acionáveis.

- Meta tags mal criadas – muitos dos sites afetados tinham páginas com meta tags duplicadas ou obviamente escritas para mecanismos de pesquisa e não para humanos.

- Preenchimento de palavras- chave – pessoas chocantes ainda são preenchimento de palavras-chave. Dos sites afetados, a maioria deles não continha palavras-chave, mas cerca de 3,89% deles o faziam. Seja em seu conteúdo em meta tags, eles estavam usando palavras-chave de maneira excessiva que tornava a experiência de leitura não ideal.

Como você sabe, existem muitos outros fatores em SEO. Simplesmente não conseguimos encontrar nenhum outro padrão importante. De um nível superficial, algumas das coisas que eles observaram parecem semelhantes à atualização de conteúdo útil.

Também analisamos os backlinks dos sites que perderam mais tráfego e não encontramos nenhum padrão. Agora, isso não significa que o Google considerou ou não os links como um fator de spam nesta atualização, mais do que isso, simplesmente não vimos nenhum padrão .

Agora é aqui que fica interessante…

conteúdo gerado por IA

Lembra como mencionei que temos 100 sites gerados por IA? Eles estão em uma variedade de setores e todos têm mais de 60 páginas de conteúdo, se não mais, todas geradas por IA e, é claro, criamos links manualmente (não os compramos e você nunca deve comprar links ) para ajudar na classificação dos sites.

E, na verdade, temos mais de 681 sites gerados por IA, mas a maioria deles não recebe tráfego de SEO suficiente. Por exemplo, quando um site recebe apenas 1.000 visitantes por mês do Google, é muito difícil ver padrões, pois a contagem de visitantes muda drasticamente de um dia para o outro.

Mas 100 dos sites orientados por IA geram pelo menos 3.000 visitantes por mês do Google.

Nenhum dos sites vende nada ou coleta leads, são apenas sites informativos em diferentes setores.

Agora, dos 100 sites gerados por conteúdo de IA, 53 têm seu conteúdo criado exclusivamente por meio de IA. E eles também têm suas metatags e até mesmo os títulos do artigo, todos criados pela IA.

Essas páginas não têm links para outros sites ou mesmo páginas internas, pois as ferramentas de geração de conteúdo de IA realmente não adicionam links.

Uma coisa a observar é que a maioria das ferramentas de IA realmente não cria conteúdo com mais de 500 palavras, a menos que você comece a ajustar o conteúdo ou faça com que o redator de IA crie conteúdo um parágrafo por vez.

Mas para o primeiro lote de sites de IA (53 deles), não tivemos humanos modificando ou alterando nenhum conteúdo. Usamos puramente o conteúdo que foi criado pela IA na forma em que foi criado, incluindo as meta tags que o escritor da IA criou.

Agora, no segundo lote, tínhamos 47 sites, nesses sites usamos IA para criar o conteúdo, mas depois tivemos um humano modificando o conteúdo para garantir que fosse melhor e fornecesse mais valor. Os humanos também adicionaram links internos e externos, modificaram as metatags para torná-las mais fáceis de usar e adicionaram imagens e incorporaram vídeos ao artigo quando fazia sentido.

A única coisa que não fizemos foi aumentar muito o comprimento. Porque, pelo que vemos em nosso Ubersuggest AI Writer, a maioria das pessoas apenas usa conteúdo escrito por IA e não o modifica muito. Quando eles o modificam, tende a ser um pouco, e as pessoas realmente não estão adicionando muito na contagem de palavras.

Com nossos sites, queríamos replicar o que a maioria dos profissionais de marketing está fazendo com IA para ter uma ideia do que o Google está tentando resolver.

Você consegue adivinhar o que aconteceu com esses sites?

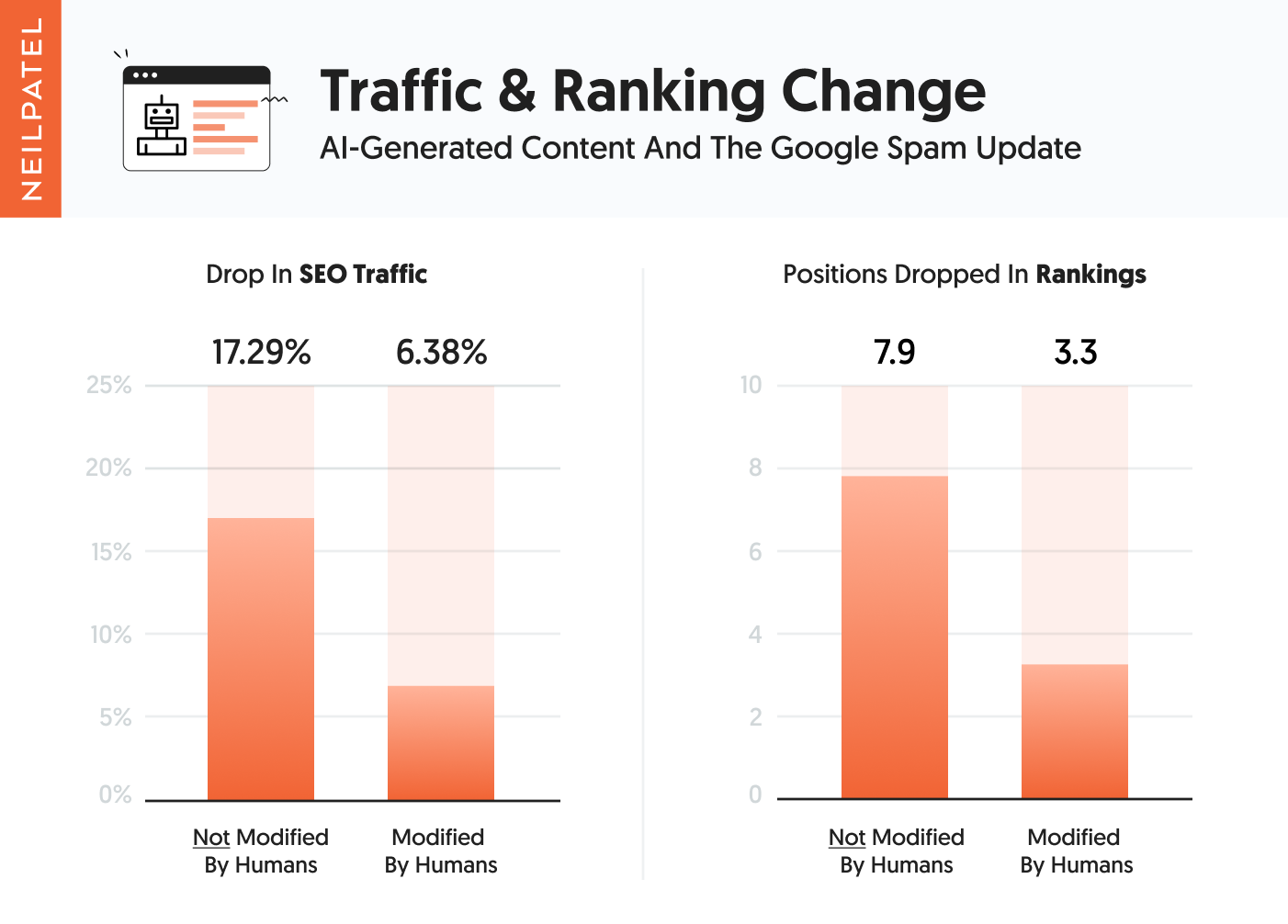

O primeiro grupo de conteúdo escrito por IA, que não teve intervenção humana quando se trata de modificar o conteúdo, não teve um desempenho tão bom quanto os que tiveram intervenção humana.

Em essência, eles observaram uma queda média de 17,29% no tráfego e suas classificações de palavras-chave caíram em média 7,9 posições. Lembre-se de que pode parecer muito, mas nenhum deles realmente tinha classificações número 1 para qualquer termo popular.

O segundo grupo teve uma queda de tráfego de 6,38% e, em média, uma queda de 3,3 posições no ranking.

Mas então, quando nos aprofundamos porque eu estava curioso para ver os resultados de cada site, percebemos que nem todos os sites foram atingidos pela atualização.

Do primeiro grupo de 53 sites, em que o conteúdo NÃO foi ajustado por humanos, 14 deles foram atingidos pela atualização e tiveram quedas de tráfego entre 31,44% e 73,18%. Em média, os 14 sites perderam 51,65% do tráfego.

Do segundo grupo, que teve humanos modificando ligeiramente o conteúdo, 8 sites foram atingidos. Eles perderam entre 29,52% e 81,43% de seu tráfego. Em média, esses 8 sites tiveram uma queda de tráfego de 42,17%.

Agora, o que é engraçado é que alguns dos outros sites em ambos os baldes tiveram quedas menores de tráfego, como alguns pontos percentuais, e alguns até viram um leve aumento de tráfego de SEO em até 4% quando você compara o tráfego pré-atualização e pós-atualização como demorou 48 horas para a atualização ser lançada.

Mas aqui é onde fica interessante, no primeiro grupo dos 14 sites que foram afetados, 13 deles também viram quedas de tráfego da atualização de conteúdo útil. E do segundo grupo, todos os 8 sites foram atingidos pela atualização de conteúdo útil.

Uma coisa a notar é que não houve muitos dias de atualização de postagem de dados desde quando o Google terminou de lançar as coisas até quando lancei esta postagem no blog. E eu não queria comparar o tráfego de domingo com o tráfego de quarta-feira. Como você precisa olhar para o domingo versus o último domingo para remover o preconceito. No entanto, as estatísticas acima são o que vimos e as quedas de classificação também confirmam que esses sites foram atingidos pela atualização.

Conclusão

Pelo que estamos vendo, a maior parte dessa atualização se concentrou em conteúdo, meta tags e preenchimento de palavras-chave. Isso não significa que o Google não olhou para outros fatores, como links ou conteúdo duplicado, mas vimos os maiores padrões relacionados aos fatores que mencionei acima e ao conteúdo gerado por IA.

Se você quer se dar bem no longo prazo, foque no usuário, realmente é o caminho para vencer. No curto prazo, você pode não ganhar, mas no longo prazo, você vai.

Apenas pergunte a si mesmo: esse conteúdo será útil para os usuários? Usar as mesmas meta tags em todas as páginas é útil? Meu site está fornecendo valor suficiente para que as pessoas queiram criar links para mim?

Em essência, você está apenas verificando a si mesmo e fazendo o que é melhor para os usuários.

O que você viu na atualização de spam do Google?

Veja como minha agência pode direcionar grandes quantidades de tráfego para seu site

- SEO – desbloqueie enormes quantidades de tráfego de SEO. Veja resultados reais.

- Marketing de conteúdo – nossa equipe cria conteúdo épico que será compartilhado, obterá links e atrairá tráfego.

- Mídia paga – estratégias pagas eficazes com ROI claro.

Marcar uma chamada