Guia passo a passo para instalar o LLM de código aberto em seu ambiente local – sem Internet

Publicados: 2023-12-20Resumo

No mundo em rápido avanço da IA, a instalação de um Large Language Model (LLM) como o FALCON dentro de um sistema local apresenta um conjunto único de desafios e oportunidades. Este guia foi projetado para orientá-lo nas etapas críticas de configuração do FALCON Open-Source LLM, com foco em alcançar o desempenho ideal e, ao mesmo tempo, manter a privacidade e a segurança dos dados rigorosas.

Embarque na jornada de implantação do FALCON, um proeminente modelo de linguagem grande e de código aberto (LLM), localmente, garantindo desempenho máximo e segurança robusta. Este guia abrangente abrange pré-requisitos de hardware, instalação de software e treinamento de dados, ao mesmo tempo em que ressalta a importância de testes regulares, manutenção, considerações de escalabilidade e análise de custos. Para uma perspectiva mais ampla, mantenha-se informado sobre os 5 principais LLMs de código aberto e considere aproveitar a experiência da Creole Studios para uma implementação segura, permitindo que você aproveite o poder da IA enquanto mantém padrões rígidos de privacidade de dados.

Compreendendo o requisito

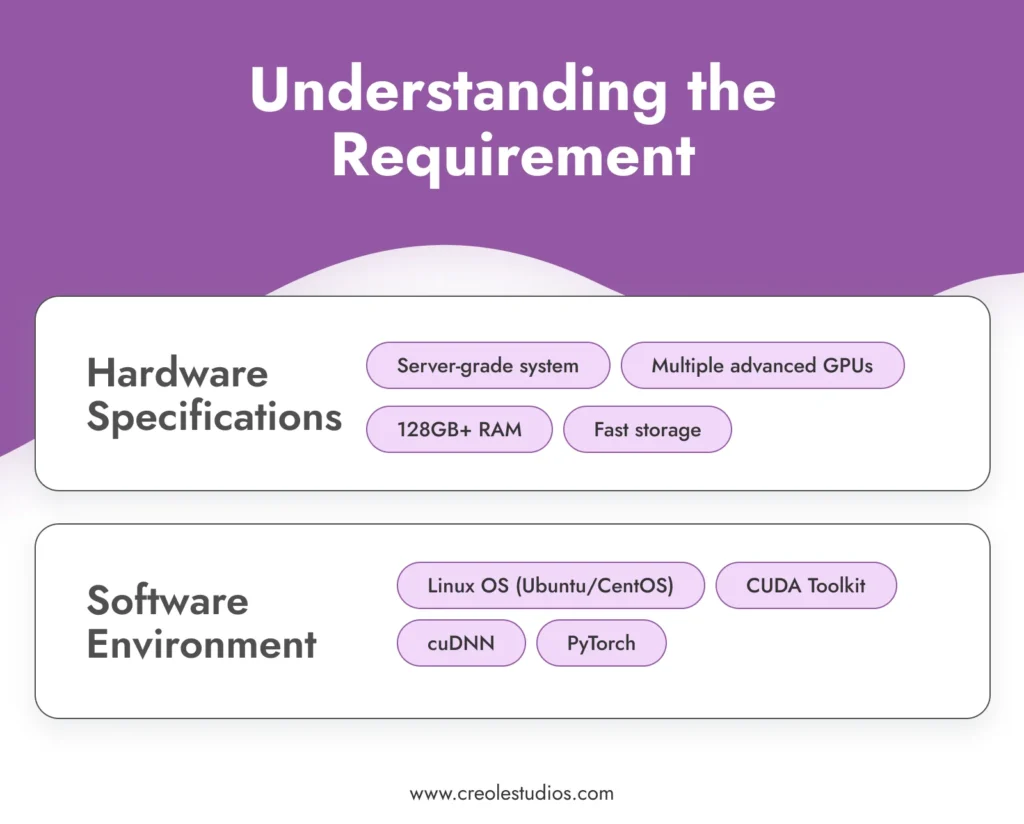

Antes de mergulhar no processo de instalação, é crucial compreender os requisitos para operar um modelo sofisticado como o FALCON .

- Especificações de hardware : O FALCON, com seus enormes 180 bilhões de parâmetros, exige recursos computacionais significativos. Isso requer um ambiente de computação de alto desempenho, normalmente envolvendo sistemas de nível de servidor equipados com várias GPUs avançadas (por exemplo, NVIDIA A100s), RAM substancial (128 GB ou mais) e soluções de armazenamento de alta velocidade (SSDs ou NVMe) para gerenciar o modelo e dados de forma eficiente. Você pode consultar as diretrizes da NVIDIA para configurar ambientes de IA e ML.

- Ambiente de software : A execução eficaz do FALCON requer um ambiente de software estável e compatível. Um sistema operacional baseado em Linux como Ubuntu ou CentOS é recomendado por seu excelente suporte de GPU e compatibilidade com ferramentas e bibliotecas essenciais. A pilha de software inclui o CUDA Toolkit para aceleração de GPU, cuDNN para redes neurais profundas e estruturas de aprendizado de máquina como PyTorch.

Adquira o modelo

O próximo passo é adquirir o modelo FALCON. Isto pode envolver :

- Licenciamento de modelo : verifique as opções mais recentes de disponibilidade e licenciamento do FALCON. O licenciamento de um modelo como o FALCON normalmente envolve negociações e acordos, garantindo que você tenha o direito legal de usar o modelo. Fique de olho no repositório oficial do FALCON ou nos mercados de modelos de IA relacionados para atualizações e detalhes de licenciamento.

- Transferência de modelo : Dada a natureza isolada da configuração, transferir o modelo para o seu ambiente local é uma etapa crítica. Isso pode envolver a transferência física do modelo usando dispositivos de armazenamento criptografados e seguros. A integridade e segurança do modelo durante esta transferência são fundamentais.

Configure a infraestrutura

Estabelecer uma infraestrutura robusta é fundamental para a operação eficiente do FALCON LLM :

- Configuração do servidor : otimize seus servidores para cargas de trabalho de IA de alta intensidade. Isso inclui configurar várias GPUs para processamento paralelo, garantir redes de alta largura de banda dentro do sistema e implementar soluções de resfriamento eficazes para gerenciar a produção de calor.

- Gerenciamento de armazenamento : Dado o tamanho do FALCON e os conjuntos de dados potencialmente grandes com os quais você trabalhará, planeje cuidadosamente sua arquitetura de armazenamento. SSDs ou unidades NVMe de alta capacidade são recomendados por sua velocidade. Certifique-se de ter sistemas de redundância e backup em funcionamento.

- Energia e resfriamento : Esses servidores poderosos exigirão sistemas adequados de fornecimento de energia e resfriamento. Certifique-se de que sua infraestrutura possa atender a esses requisitos. É aconselhável consultar especialistas em hardware para projetar um data center que possa sustentar esta configuração

Instale o software necessário

A instalação do software é uma etapa crítica na configuração do seu LLM de código aberto :

- Configuração do sistema operacional : Instale a distribuição Linux escolhida. Ubuntu e CentOS são escolhas populares por sua estabilidade e suporte. Certifique-se de que o sistema operacional esteja configurado para usar os recursos de hardware de maneira ideal.

- Instalação de dependência : instale o CUDA Toolkit para suporte de GPU, cuDNN para recursos de aprendizado profundo e PyTorch como estrutura de aprendizado de máquina. Certifique-se de usar versões compatíveis com o modelo FALCON.

- Software de segurança : Em um ambiente isolado, a segurança interna é fundamental. Instale sistemas robustos de firewall e detecção de intrusões. Mesmo que o sistema esteja isolado, podem ocorrer ameaças internas ou violações acidentais.

Instalação do modelo

A instalação do modelo FALCON envolve vários passos :

- Transferência de modelo : transfira com segurança os arquivos do modelo para o seu sistema local usando dispositivos de armazenamento criptografados.

- Processo de instalação : Siga o guia de instalação fornecido pela FALCON. Isso geralmente envolve a configuração das variáveis de ambiente, o carregamento dos arquivos do modelo e a configuração dos parâmetros do modelo.

- Verificação : Pós-instalação, verifique a integridade da instalação. Certifique-se de que os arquivos do modelo estejam intactos e que o modelo execute o diagnóstico inicial corretamente.

Segurança e conformidade de dados

Garantir a segurança dos dados em um ambiente isolado envolve várias camadas de proteção :

- Criptografia : Todos os dados, tanto em repouso quanto em trânsito na rede, devem ser criptografados. Implemente protocolos de criptografia fortes para proteger seus dados.

- Conformidade : cumpra os regulamentos relevantes de proteção de dados e os padrões do setor. Audite regularmente seus sistemas quanto à conformidade.

- Controle de acesso : Implemente políticas rígidas de controle de acesso. Somente pessoal autorizado deve ter acesso ao modelo e aos dados.

Treinando o modelo com dados selecionados

Para adaptar o FALCON às suas necessidades específicas, é essencial treiná-lo com dados selecionados .

- Coleta e preparação de dados : reúna dados relevantes para seu caso de uso. Esses dados devem ser representativos, diversificados e de alta qualidade. Pré-processe e limpe os dados para garantir que sejam adequados para treinamento.

- Processo de treinamento : Configure os parâmetros de treinamento do FALCON para alinhar com seus objetivos. Treinar um modelo como o FALCON requer um conhecimento profundo dos princípios de aprendizado de máquina e das especificidades da arquitetura do modelo.

- Monitoramento e ajuste : Monitore continuamente o processo de treinamento quanto ao desempenho e precisão. Esteja preparado para ajustar os dados ou parâmetros de treinamento conforme necessário para alcançar os resultados desejados.

Teste e Manutenção

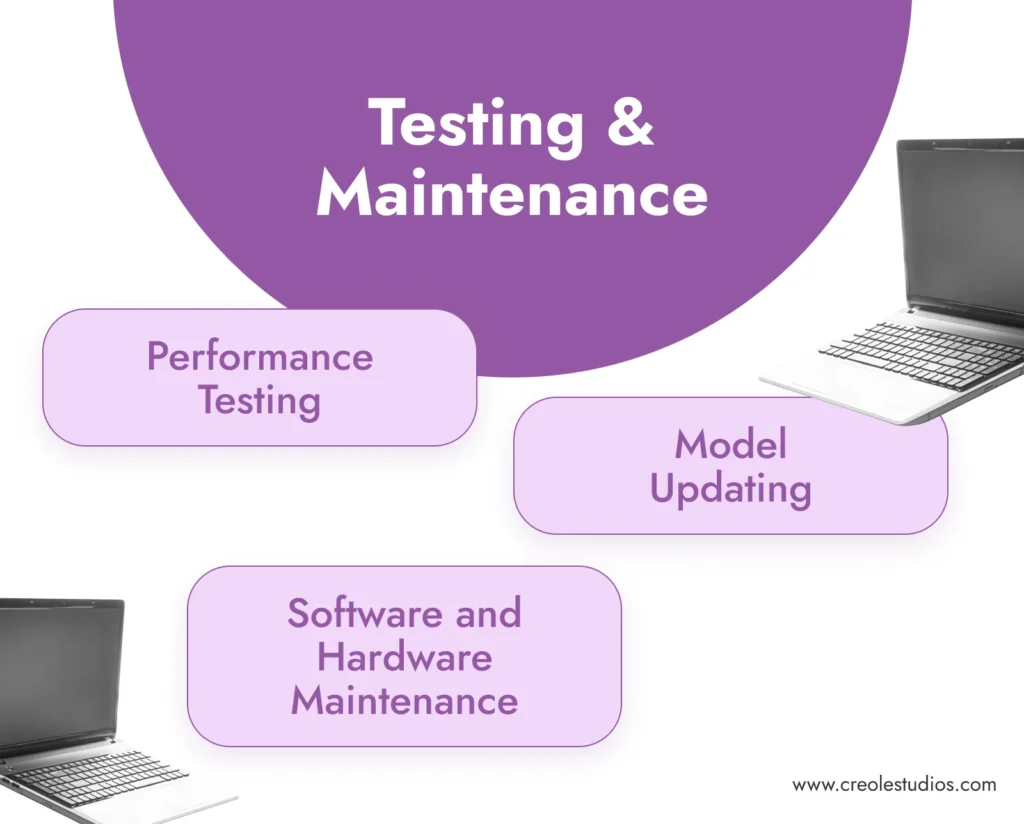

Testes e manutenção regulares são essenciais para o sucesso do modelo a longo prazo .

- Teste de desempenho : teste regularmente o modelo quanto à precisão e eficiência. Isso envolve a execução de conjuntos de dados de validação e a verificação da consistência e qualidade dos resultados do modelo.

- Manutenção de software e hardware : atualize e corrija regularmente o ambiente de software. Faça a manutenção do hardware para garantir que ele opere com eficiência, incluindo o gerenciamento dos sistemas de resfriamento, a verificação das fontes de alimentação e a substituição de quaisquer componentes com falha.

- Atualização do modelo : Mantenha-se atualizado sobre as atualizações do modelo FALCON. Em um ambiente isolado, a atualização do modelo pode exigir a transferência manual de arquivos de modelo atualizados.

Escalabilidade e Custo

Considere o crescimento futuro e as implicações de custo da sua configuração .

- Planejamento de escalabilidade : planeje o dimensionamento potencial de sua infraestrutura. Isso pode incluir a adição de mais GPUs, a expansão do armazenamento ou o aprimoramento das capacidades da rede no ambiente isolado.

- Análise de custos : Revise regularmente os custos envolvidos na manutenção e operação do FALCON. Isso inclui custos de hardware, consumo de energia e taxas de licenciamento.

Notas finais: A importância dos LLMs de código aberto e da experiência dos Creole Studios

A instalação local de LLMs de código aberto como o FALCON oferece benefícios significativos, incluindo privacidade de dados, personalização e controle incomparáveis sobre seus recursos de IA. Ele permite que as empresas aproveitem o poder da IA, garantindo ao mesmo tempo que os dados confidenciais permaneçam dentro dos limites de sua rede privada e segura.

A Creole Studios se destaca em ajudar os clientes no complexo processo de configuração e manutenção de LLMs de código aberto em ambientes locais isolados. Nossa experiência garante uma implementação tranquila, segura e eficaz, permitindo que as empresas aproveitem todo o potencial da IA, mantendo os mais altos padrões de privacidade e segurança de dados. Com o nosso apoio, as empresas podem enfrentar com confiança os desafios da implementação da IA e permanecer à frente no cenário tecnológico em rápida evolução.