Difusão estável: tutoriais, recursos e ferramentas

Publicados: 2022-09-08- Recursos e informações

- Quais imagens foram usadas para treinar o modelo de difusão estável?

- Onde encontrar exemplos e prompts de difusão estável?

- Existe um servidor oficial do Discord?

- Ferramentas e software

- Como executar a difusão estável no Windows/Linux?

- Como executar a difusão estável em um Mac?

- Qual o tamanho do modelo de difusão estável?

- Tutoriais e guias

- Construtor de prompt de difusão estável

- Guia definitivo para iniciantes

- Registros Akáshicos

- Ficha de Alerta

- Estilos de arte e mídias

- Estilos visuais e artísticos

No dia 22 de agosto, o fundador da Stability.ai, Emad Mostaque, anunciou o lançamento do Stable Diffusion. Este modelo de arte generativa de IA tem recursos superiores aos do DALL·E 2 e também está disponível como um projeto de código aberto. Naquelas semanas desde seu lançamento, as pessoas abandonaram seus empreendimentos e projetos para dar toda a atenção ao Stable Diffusion.

Eu já estava bastante empolgado quando a OpenAI anunciou o DALL·E 2, e também tive a sorte de obter acesso antecipado. Mas tendo brincado com Stable Diffusion nos últimos dias, posso dizer que DALL·E 2 não chega nem perto do que Stable Diffusion traz para a mesa.

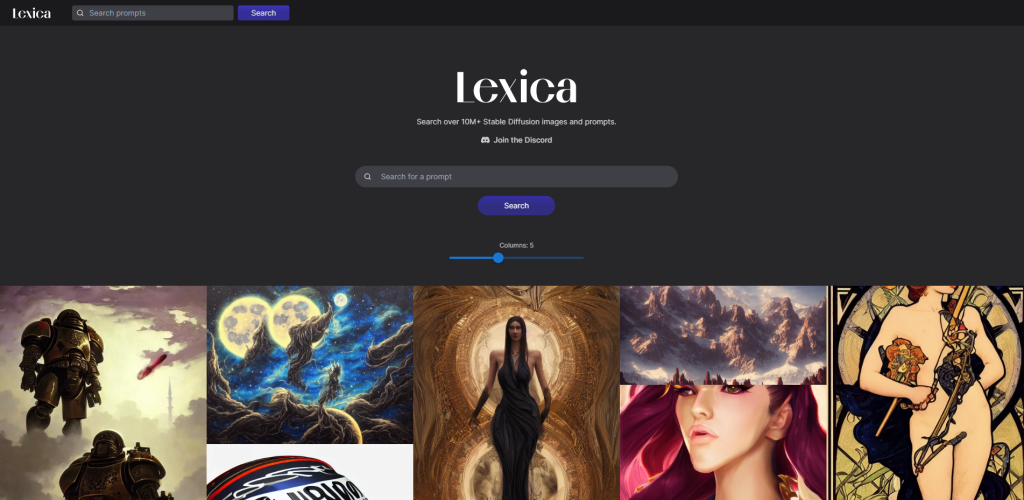

E o fato de ser de código aberto também o torna muito mais acessível. Em apenas duas semanas, sites como o Lexica arquivaram mais de 10 milhões de imagens geradas por IA. Também espero que os desenvolvedores façam progressos firmes para integrar o Stable Diffusion com as ferramentas de design gráfico mais populares, como Figma, Sketch e outras. A capacidade de gerar arte de alta qualidade em movimento é sem precedentes.

O objetivo deste artigo é listar todos os tutoriais, recursos e ferramentas interessantes e relevantes para ajudá-lo a se familiarizar rapidamente com a difusão estável. Acredito que nos próximos meses veremos um fluxo maciço de projetos especializados em extrair o máximo do potencial da difusão estável. Farei o meu melhor para manter este artigo atualizado em conformidade.

- Tutoriais – esta seção é fortemente focada em tópicos como “Como usar a difusão estável?” .

- Recursos – esta seção é focada em consultas como “O que é difusão estável?”.

- Ferramentas – esta seção é baseada em ferramentas que permitem usar difusão estável.

Então, sem mais delongas – vamos começar com o básico.

Recursos e informações

Uma das primeiras perguntas que muitas pessoas têm sobre o Stable Diffusion é a licença sob a qual este modelo é publicado e se a arte gerada é livre para uso em projetos pessoais e comerciais.

A licença que a Stable Diffusion está usando é CreativeML Open RAIL-M e pode ser lida na íntegra em Hugging Face. Resumindo, “Licenças Open Responsible AI (Open RAIL) são licenças projetadas para permitir acesso livre e aberto, reutilização e distribuição downstream de derivados de artefatos de IA, desde que as restrições de uso comportamental sempre se apliquem (incluindo a trabalhos derivados)”. .

Uma explicação mais detalhada para esta licença está disponível nesta página da BigScience.

Quais imagens foram usadas para treinar o modelo de difusão estável?

A modelagem de IA é o meio de criar e treinar algoritmos de Machine Learning para uma finalidade específica. Neste caso, o objetivo de gerar imagens a partir de prompts do usuário.

Se você está curioso sobre quais imagens Stable Diffusion usou, Andy Baio e Simon Willison fizeram uma análise completa de mais de 12 milhões de imagens (de um total de 2,3 bilhões) que foram usadas para treinar o modelo Stable Diffusion.

Aqui estão algumas das principais conclusões:

- Os conjuntos de dados que foram usados para treinar a difusão estável foram os reunidos pelo LAION.

- Dos 12 milhões de imagens amostradas, 47% do tamanho total da amostra veio de 100 domínios, com o Pinterest gerando 8,5% de todo o conjunto de dados. Outras fontes importantes incluem WordPress.com, Blogspot, Flickr, DeviantArt e Wikimedia.

- Stable Diffusion não restringe o uso de gerar arte a partir de nomes de pessoas (sejam celebridades ou não).

Será interessante ver como o modelo evolui e se as empresas estarão dispostas a contribuir com sua mídia para ajudar a Stable Diffusion crescer.

Onde encontrar exemplos e prompts de difusão estável?

Uma das maneiras pelas quais o Stable Diffusion difere de DALL·E é tirar o máximo proveito do Stable Diffusion; você tem que aprender sobre seus modificadores . Um modificador, em particular, é chamado de semente . Sempre que você gerar uma imagem com Difusão Estável, essa imagem receberá uma semente, que também pode ser entendida como a composição geral dessa imagem. Portanto, se você gostou de uma imagem em particular e deseja replicar seu estilo (ou pelo menos o mais próximo possível), pode usar sementes.

A melhor plataforma para encontrar exemplos e os prompts usados para gerar essas imagens é o Lexica, que arquiva mais de 10 milhões de obras de arte de amostra. Cada obra de arte inclui seu prompt completo e o número da semente, que você pode reutilizar.

Existe um servidor oficial do Discord?

Sim!

Você pode acessá-lo visitando [https://discord.gg/stablediffusion]; importante observar que o servidor não suporta mais a geração de imagens do próprio servidor. Esse recurso estava disponível como parte do programa beta. Se você quiser usar o Stable Diffusion de um servidor Discord - você pode procurar projetos como Yet Another SD Discord Bot ou visitar o servidor Discord para experimentá-lo.

Ferramentas e software

Se você viu ou foi cativado pela arte criada com Stable Diffusion, pode estar se perguntando se pode experimentá-la por si mesmo. E a resposta é sim, e existem várias maneiras de experimentar o Stable Diffusion gratuitamente, incluindo fazê-lo no navegador ou na sua máquina.

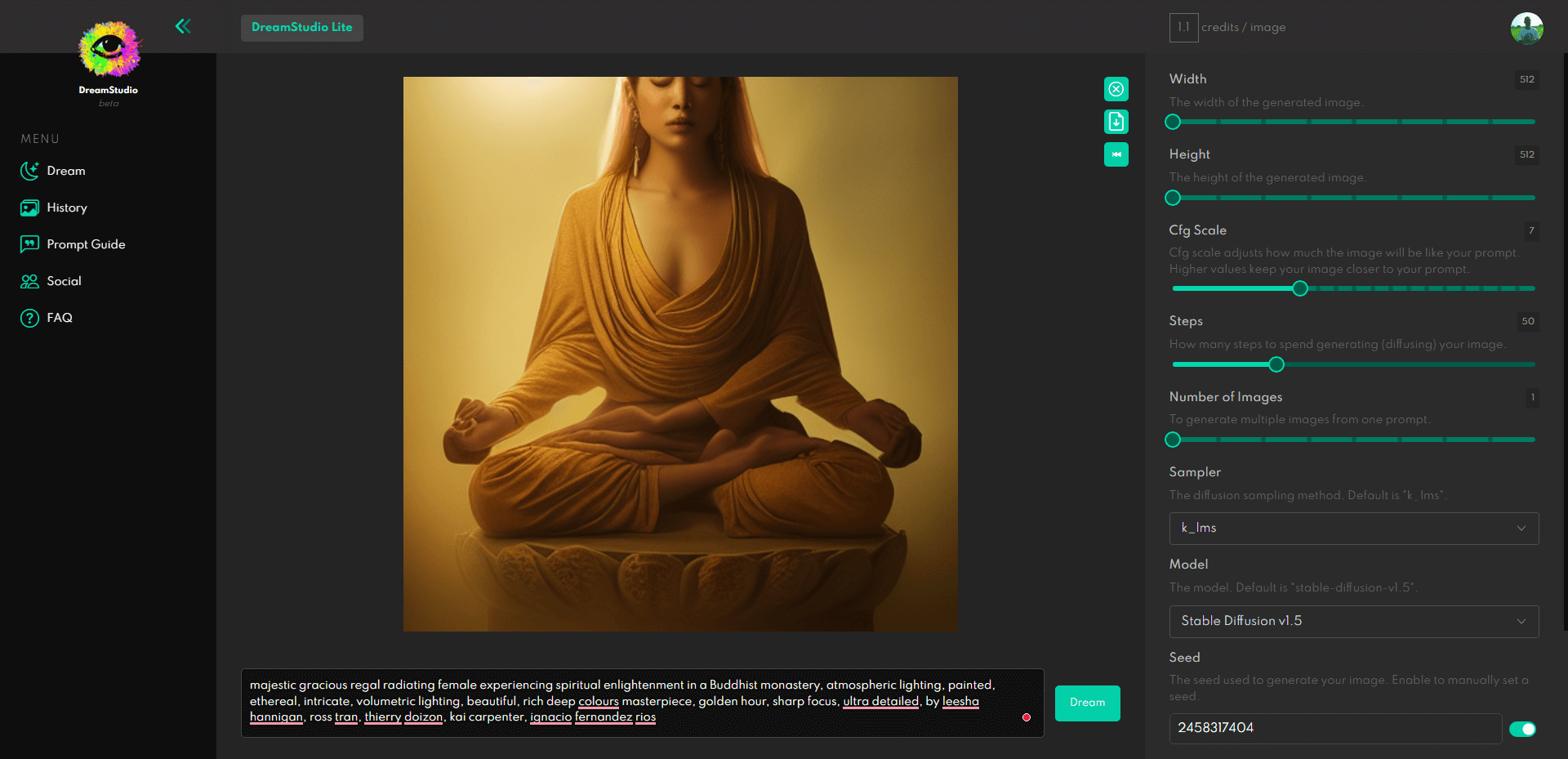

A maneira oficial de fazer isso é usar a plataforma DreamStudio.

Qualquer pessoa pode se registrar gratuitamente e novas contas recebem 200 tokens gratuitos de cortesia. Esses tokens são suficientes para 200 gerações, desde que você não aumente a complexidade e não altere a altura e a largura além da configuração padrão de 512 × 512. Mas se você aumentar a complexidade, provavelmente ficará sem seus tokens rapidamente.

Como executar a difusão estável no Windows/Linux?

Atualmente, a solução mais popular para executar o Stable Diffusion localmente é o repositório Stable Diffusion Web UI disponível no GitHub. Com base na GUI do Gradio, isso é o mais próximo possível da interface do DreamStudio, e você pode dar adeus a quaisquer limitações.

Quais são os requisitos do PC para difusão estável?

– 4 GB (mais é preferível) GPU VRAM (suporte oficial apenas para Nvidia!)

– Usuários AMD verifiquem aqui

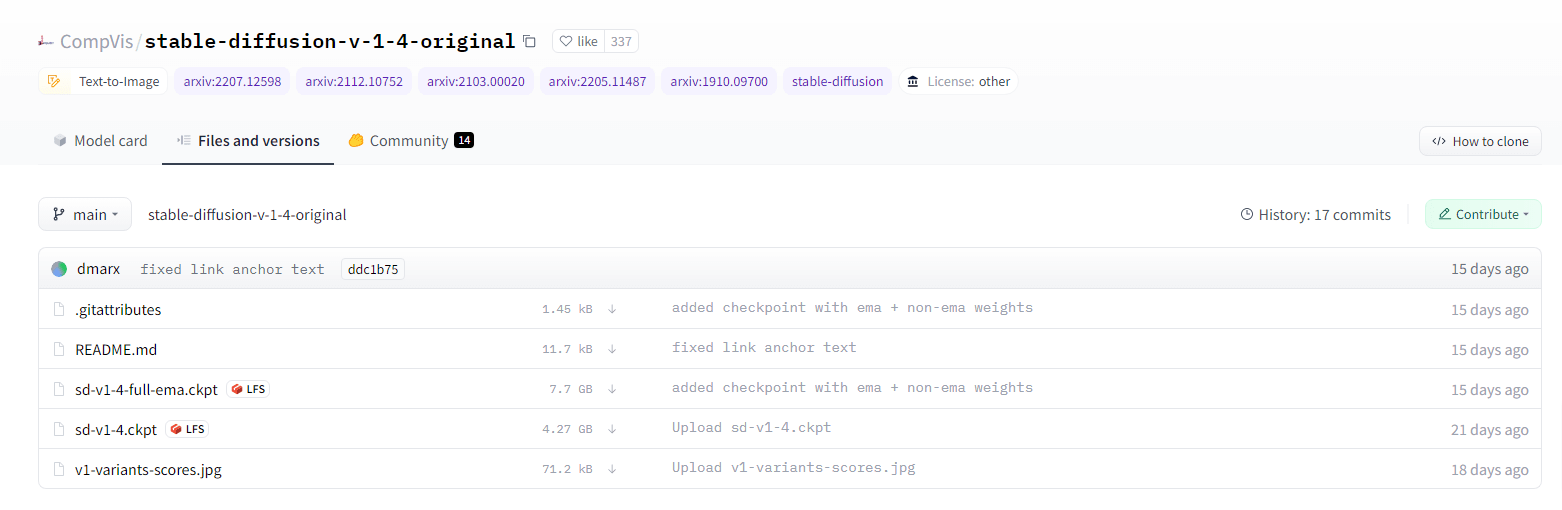

Lembre-se de usar o repositório de IU da Web; você precisará baixar o modelo você mesmo do Hugging Face. Certifique-se de ler completamente o guia de instalação (Windows) para configurá-lo corretamente. Para Linux, consulte este guia. E você também pode colocá-lo em funcionamento no Google Colab – guia aqui.

Existem alternativas para executar o SD no Windows ou Linux?

A interface de usuário de difusão estável está ganhando popularidade (instalação com 1 clique para Windows e Linux).

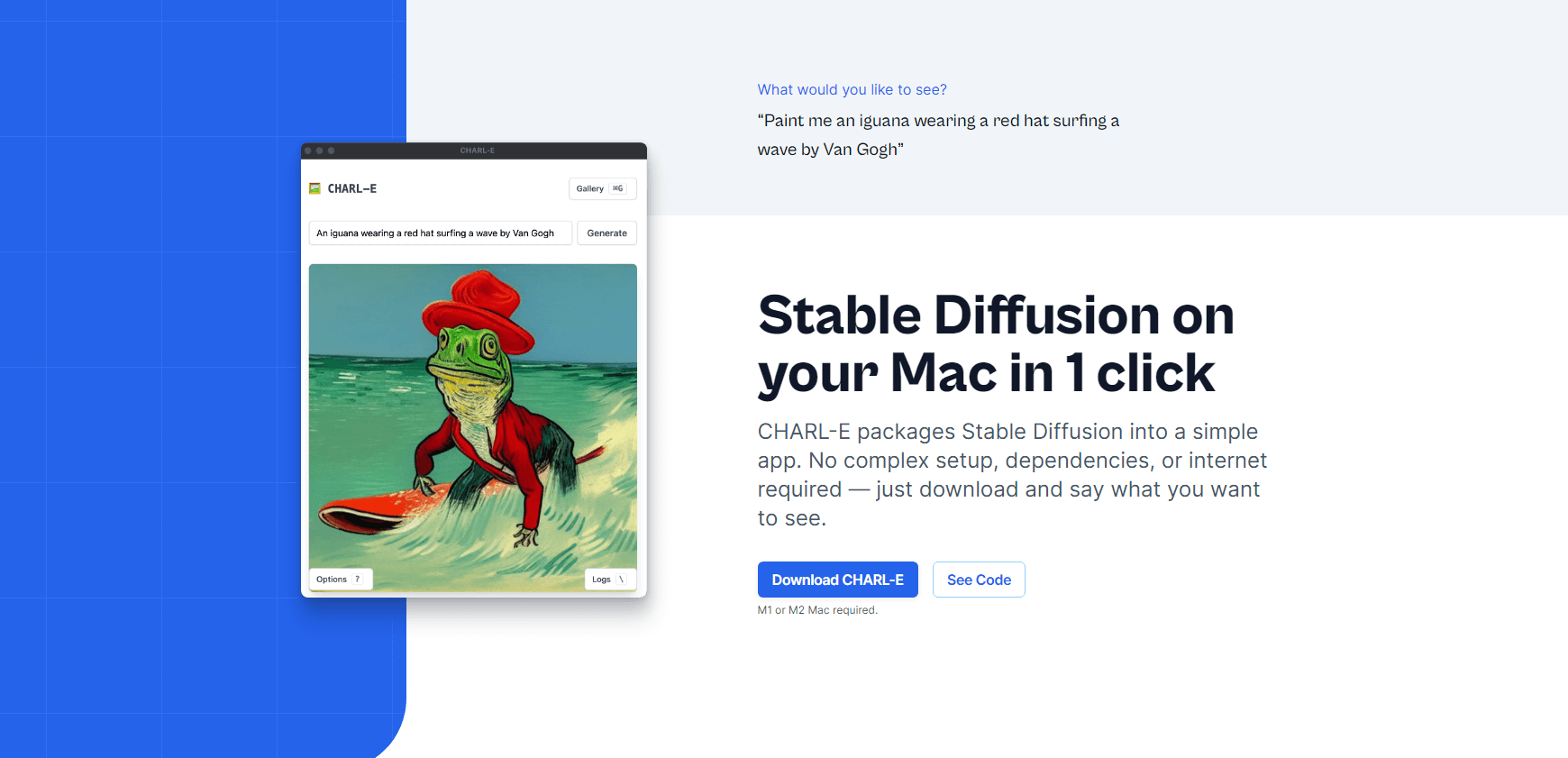

Como executar a difusão estável em um Mac?

Charlie Holtz lançou o CHARL-E, um instalador de 1 clique para usuários de Mac (M1 e M2).

As características:

- Baixe automaticamente todos os pesos necessários.

- Você pode definir um número de semente e amostragem DDIM.

- As imagens geradas são salvas em uma galeria.

Há também o Diffusion Bee a considerar como alternativa.

Qual o tamanho do modelo de difusão estável?

Como mencionei acima, você precisa baixar o modelo Stable Diffusion, e o link pode ser encontrado aqui. Você precisará criar uma conta no Hugging Face e, posteriormente, aceitar os termos de licença do modelo antes de poder visualizar e baixar seus arquivos.

Uma das perguntas que as pessoas têm é: “Como é que o modelo tem apenas 4 GB de tamanho, mesmo tendo sido feito de mais de 2 bilhões de imagens?” .

E a melhor resposta para essa pergunta vem de uma usuária do Hacker News juliendorra ⟶

Essa é a parte interessante: todas as imagens geradas são derivadas de um modelo menor que 4GB (os pesos treinados da rede neural).

Então, de certa forma, centenas de bilhões de imagens possíveis são todas armazenadas no modelo (cada um vetor em um espaço latente multidimensional) e transformadas em pixels sob demanda (conduzidas pelo modelo de linguagem que sabe como transformar palavras em um vetor neste espaço )

Como é determinístico (dados exatamente os mesmos parâmetros de solicitação, incluindo semente aleatória, você obtém exatamente a mesma imagem), é uma forma de compactação (ou pelo menos decodificação de codificação) também: eu poderia enviar os parâmetros para 1 milhão de imagens que você seria capaz de recriar do seu lado, apenas como um arquivo de texto relativamente pequeno.

Tutoriais e guias

A seção a seguir é dedicada inteiramente a tutoriais e guias para ajudá-lo a extrair o máximo de seus prompts de difusão estável. Como eu disse, farei o meu melhor para manter isso atualizado à medida que mais guias estiverem disponíveis e uma melhor compreensão do modelo for obtida.

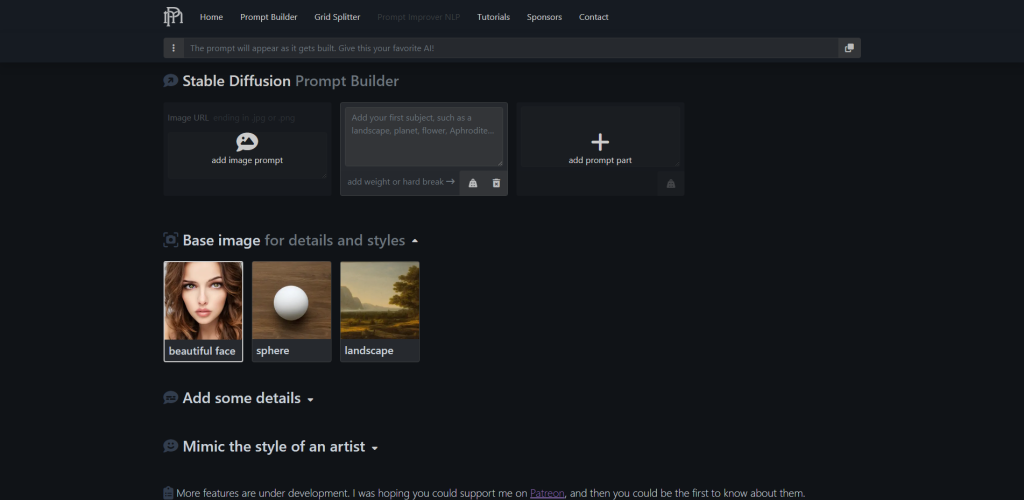

Construtor de prompt de difusão estável

Existem guias de estilo adicionais abaixo, mas no que diz respeito à criação visual de prompts – a ferramenta promptoMANIA é provavelmente a melhor que existe.

Você pode começar adicionando a descrição da imagem que está tentando criar e, em seguida, rolar para baixo para começar a adicionar detalhes e imitar os estilos de vários artistas. Existem centenas de opções para escolher, cada uma com uma visualização visual.

Quando terminar de construir sua string, você pode copiá-la e colá-la em qualquer ferramenta que esteja usando para gerar imagens de difusão estável.

Guia definitivo para iniciantes

Arman Chaudhry publicou uma apresentação compacta do Google Docs sobre os fundamentos do SD.

Este guia abrange todos os modificadores suportados pelo SD, mas também recomenda as práticas recomendadas para configurações de largura/altura e erros comuns a serem evitados.

Registros Akáshicos

Se você deseja fazer um mergulho profundo (ou precisa de referências para pesquisa) – o repositório SD Akashic Records tem uma quantidade impressionante de recursos para você estudar.

Você encontrará tudo, desde o uso de palavras-chave, otimização imediata e guias de estilo. Há também menções a várias ferramentas, além das já mencionadas neste artigo.

Ficha de Alerta

Se você está procurando inspiração para aplicar estilos e efeitos personalizados aos seus prompts, confira esta postagem no blog de Moritz. Abrange adições imediatas para conceitos como arte 2D e 3D, detalhes, iluminação, cores e ambientes.

Estilos de arte e mídias

Confira este arquivo do Google Docs para mais de 100 estilos e mídias diferentes para usar na geração de imagens SD. O documento é baseado em um único prompt, e o referido prompt foi gerado em centenas de estilos diferentes para que você possa replicar o mesmo estilo em seus prompts.

Estilos visuais e artísticos

Confira este arquivo modifiers.json no GitHub para estilos adicionais e recomendações de artistas. São mais de 200 modificadores diferentes que você pode aplicar aos seus prompts.