O Guia Definitivo para SEO Técnico

Publicados: 2023-02-24Liste três coisas que você fez este ano relacionadas à otimização de mecanismo de busca (SEO).

Essas táticas giram em torno de pesquisa de palavras-chave, meta descrições e backlinks?

Se assim for, você não está sozinho. Quando se trata de SEO, essas técnicas geralmente são as primeiras que os profissionais de marketing adicionam ao seu arsenal.

Embora essas estratégias melhorem a visibilidade do seu site na pesquisa orgânica, elas não são as únicas que você deve empregar. Há outro conjunto de táticas que se enquadram no guarda-chuva do SEO.

O SEO técnico refere-se aos elementos dos bastidores que alimentam seu mecanismo de crescimento orgânico, como arquitetura do site, otimização móvel e velocidade da página. Esses aspectos do SEO podem não ser os mais atraentes, mas são incrivelmente importantes.

O primeiro passo para melhorar seu SEO técnico é saber onde você está realizando uma auditoria do site. A segunda etapa é criar um plano para abordar as áreas em que você falha. Abordaremos essas etapas em profundidade abaixo.

Dica profissional: crie um site projetado para converter usando as ferramentas CMS gratuitas da HubSpot.

O que é SEO técnico?

SEO técnico refere-se a qualquer coisa que você faça para tornar seu site mais fácil para os mecanismos de pesquisa rastrearem e indexarem. SEO técnico, estratégia de conteúdo e estratégias de criação de links funcionam em conjunto para ajudar suas páginas a terem uma classificação alta na pesquisa.

SEO Técnico x SEO On-Page x SEO Fora da Página

Muitas pessoas dividem a otimização de mecanismo de pesquisa (SEO) em três categorias diferentes: SEO na página, SEO fora da página e SEO técnico. Vamos cobrir rapidamente o que cada um significa.

SEO na página

O SEO na página refere-se ao conteúdo que informa aos mecanismos de pesquisa (e aos leitores!) Sobre o que é sua página, incluindo texto alternativo da imagem, uso de palavras-chave, meta descrições, tags H1, nomenclatura de URL e links internos. Você tem mais controle sobre o SEO na página porque, bem, tudo estánoseu site.

SEO fora da página

O SEO fora da página informa aos mecanismos de pesquisa o quão popular e útil é sua página por meio de votos de confiança – principalmente backlinks ou links de outros sites para o seu. A quantidade e a qualidade dos backlinks aumentam o PageRank de uma página. Todas as coisas sendo iguais, uma página com 100 links relevantes de sites confiáveis superará uma página com 50 links relevantes de sites confiáveis (ou 100 links irrelevantes de sites confiáveis).

SEO técnico

O SEO técnico também está sob seu controle, mas é um pouco mais complicado de dominar, pois é menos intuitivo.

Por que o SEO técnico é importante?

Você pode ficar tentado a ignorar completamente esse componente do SEO; no entanto, desempenha um papel importante no seu tráfego orgânico. Seu conteúdo pode ser o mais completo, útil e bem escrito, mas, a menos que um mecanismo de pesquisa possa rastreá-lo, poucas pessoas o verão.

É como uma árvore que cai na floresta quando ninguém está por perto para ouvi-la... ela faz barulho? Sem uma forte base técnica de SEO, seu conteúdo não fará barulho para os mecanismos de pesquisa.

Fonte

Fonte

Vamos discutir como você pode fazer seu conteúdo repercutir na internet.

Entendendo o SEO Técnico

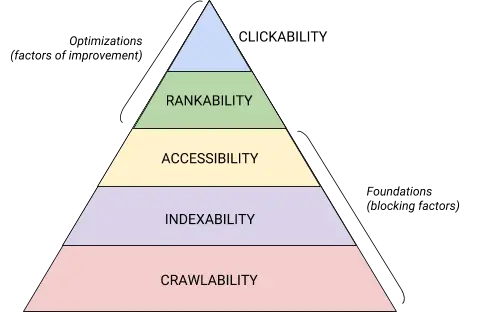

O SEO técnico é uma besta que é melhor dividida em partes digeríveis. Se você é como eu, gosta de lidar com grandes coisas em partes e com listas de verificação. Acredite ou não, tudo o que abordamos até aqui pode ser colocado em uma das cinco categorias, cada uma merecendo sua própria lista de itens acionáveis.

Essas cinco categorias e seu lugar na hierarquia técnica de SEO são melhor ilustradas por este belo gráfico que lembra a Hierarquia de necessidades de Maslov, mas remixado para otimização de mecanismos de pesquisa. (Observe que usaremos o termo comumente usado “Renderização” no lugar de Acessibilidade.)

Fonte

Fonte

Fundamentos técnicos de auditoria de SEO

Antes de começar com sua auditoria técnica de SEO, existem alguns fundamentos que você precisa colocar em prática.

Audite seu domínio preferido

Seu domínio é o URL que as pessoas digitam para acessar seu site, como hubspot.com . O domínio do seu site afeta se as pessoas podem encontrá-lo por meio da pesquisa e fornece uma maneira consistente de identificar seu site.

Ao selecionar um domínio preferido, você está informando aos mecanismos de pesquisa se prefere que a versão www ou não www do seu site seja exibida nos resultados da pesquisa. Por exemplo, você pode selecionarwww.yourwebsite.comem vez deyourwebsite.com. Isso informa aos mecanismos de pesquisa para priorizar a versão www do seu site e redirecionar todos os usuários para esse URL. Caso contrário, os mecanismos de pesquisa tratarão essas duas versões como sites separados, resultando em valor de SEO disperso.

Anteriormente, o Google pedia que você identificasse a versão de sua URL de sua preferência. Agora, o Google identificará e selecionará uma versão para mostrar aos pesquisadores para você. No entanto, se você preferir definir a versão preferencial do seu domínio, poderá fazê-lo por meio de tags canônicas (que abordaremos em breve). De qualquer forma, depois de definir seu domínio preferido, verifique se todas as variantes, ou seja,www, não-www, http e index.html, redirecionam permanentemente para essa versão.

Implementar SSL

Você já deve ter ouvido esse termo antes - porque é muito importante. O SSL, ou Secure Sockets Layer , cria uma camada de proteção entre o servidor web (o software responsável por atender a uma solicitação online) e um navegador, tornando seu site seguro. Quando um usuário envia informações para seu site, como pagamento ou informações de contato, essas informações têm menos probabilidade de serem invadidas porque você tem SSL para protegê-las.

Um certificado SSL é indicado por um domínio que começa com “https://” em oposição a “http://” e um símbolo de cadeado na barra de URL.

Os mecanismos de busca priorizam sites seguros — na verdade, o Google anunciou já em 2014 que o SSL seria considerado um fator de classificação . Por isso, certifique-se de definir a variante SSL da sua página inicial como seu domínio preferido.

Depois de configurar o SSL, você precisará migrar todas as páginas não SSL de http para https. É uma tarefa difícil, mas vale o esforço em nome de uma classificação melhorada. Aqui estão os passos que você precisa tomar:

- Redirecione todas as páginas http://seusite.com para https://seusite.com .

- Atualize todas as tags canônicas e hreflang de acordo.

- Atualize os URLs em seu sitemap (localizado em yourwebsite.com/sitemap.xml ) e seu robot.txt (localizado em yourwebsite.com/robots.txt ).

- Configure uma nova instância do Google Search Console e do Bing Webmaster Tools para o seu site https e rastreie-o para garantir que 100% do tráfego seja migrado.

Otimize a velocidade da página

Você sabe quanto tempo um visitante do site esperará o carregamento do seu site? Seis segundos ... e isso é ser generoso. Alguns dados mostram que a taxa de rejeição aumenta em 90% com um aumento no tempo de carregamento da página de um para cinco segundos. Você não tem um segundo a perder, então melhorar o tempo de carregamento do seu site deve ser uma prioridade.

A velocidade do site não é importante apenas para a experiência do usuário e para a conversão — também é um fator de classificação .

Use estas dicas para melhorar o tempo médio de carregamento da página:

- Comprima todos os seus arquivos. A compactação reduz o tamanho das imagens , bem como dos arquivos CSS, HTML e JavaScript, para que ocupem menos espaço e carreguem mais rapidamente.

- Auditoria redireciona regularmente. Um redirecionamento 301 leva alguns segundos para ser processado. Multiplique isso por várias páginas ou camadas de redirecionamentos e você afetará seriamente a velocidade do seu site.

- Reduza seu código. Código confuso pode afetar negativamente a velocidade do seu site. Código bagunçado significa código preguiçoso. É como escrever - talvez no primeiro rascunho, você apresente seu ponto de vista em 6 frases. No segundo rascunho, você faz em 3. Quanto mais eficiente for o código, mais rápido a página carregará (em geral). Depois de limpar as coisas, você reduzirá e compactará seu código .

- Considere uma rede de distribuição de conteúdo (CDN). CDNs são servidores web distribuídos que armazenam cópias de seu site em várias localizações geográficas e entregam seu site com base na localização do pesquisador. Como as informações entre os servidores têm uma distância menor para percorrer, seu site carrega mais rápido para o solicitante.

- Tente não ficar feliz com o plug-in. Os plug-ins desatualizados geralmente têm vulnerabilidades de segurança que tornam seu site suscetível a hackers mal-intencionados que podem prejudicar as classificações do seu site. Certifique-se de estar sempre usando as versões mais recentes dos plug-ins e minimize seu uso ao mais essencial. Da mesma forma, considere o uso de temas personalizados, pois os temas de sites pré-fabricados geralmente vêm com muitos códigos desnecessários.

- Aproveite os plug-ins de cache. Os plug-ins de cache armazenam uma versão estática do seu site para enviar aos usuários recorrentes, diminuindo assim o tempo de carregamento do site durante as visitas repetidas.

- Use carregamento assíncrono (assíncrono). Scripts são instruções que os servidores precisam ler antes de poderem processar o HTML, ou corpo, de sua página da Web, ou seja, as coisas que os visitantes desejam ver em seu site. Normalmente, os scripts são colocados no <head> de um site (pense: o script do Gerenciador de tags do Google), onde são priorizados sobre o conteúdo do restante da página. Usar código assíncrono significa que o servidor pode processar o HTML e o script simultaneamente, diminuindo assim o atraso e aumentando o tempo de carregamento da página.

Veja a aparência de um script assíncrono: < script async src =” script.js “></ script >

Se você quiser ver onde seu site falha no departamento de velocidade, você pode usar este recurso do Google .

Depois de definir os fundamentos técnicos de SEO, você está pronto para passar para o próximo estágio - rastreabilidade.

Lista de verificação de rastreabilidade

A rastreabilidade é a base da sua estratégia técnica de SEO. Os bots de pesquisa rastrearão suas páginas para coletar informações sobre seu site.

Se esses bots forem de alguma forma impedidos de rastrear, eles não poderão indexar ou classificar suas páginas. O primeiro passo para implementar o SEO técnico é garantir que todas as suas páginas importantes sejam acessíveis e fáceis de navegar.

A seguir, abordaremos alguns itens a serem adicionados à sua lista de verificação, bem como alguns elementos do site a serem auditados para garantir que suas páginas estejam prontas para rastreamento.

Lista de verificação de rastreabilidade

- Crie um mapa do site XML.

- Maximize seu orçamento de rastreamento.

- Otimize a arquitetura do seu site.

- Defina uma estrutura de URL.

- Utilize robots.txt.

- Adicione menus de trilha de navegação.

- Usar paginação.

- Verifique seus arquivos de log de SEO.

1. Crie um mapa do site XML.

Lembra da estrutura do site que examinamos? Isso pertence a algo chamado XML Sitemap , que ajuda os bots de pesquisa a entender e rastrear suas páginas da web. Você pode pensar nisso como um mapa para o seu site. Você enviará seu mapa do site para o Google Search Console e Bing Webmaster Tools assim que estiver concluído. Lembre-se de manter o mapa do site atualizado ao adicionar e remover páginas da web.

2. Maximize seu orçamento de rastreamento.

Seu orçamento de rastreamento refere-se às páginas e recursos que os bots de pesquisa do seu site rastrearão .

Como o orçamento de rastreamento não é infinito, certifique-se de priorizar suas páginas mais importantes para rastreamento.

Aqui estão algumas dicas para garantir que você esteja maximizando seu orçamento de rastreamento:

- Remova ou canonize páginas duplicadas.

- Corrija ou redirecione quaisquer links quebrados.

- Certifique-se de que seus arquivos CSS e Javascript sejam rastreáveis.

- Verifique suas estatísticas de rastreamento regularmente e observe quedas ou aumentos repentinos.

- Certifique-se de que qualquer bot ou página que você proibiu de rastrear seja bloqueado.

- Mantenha seu sitemap atualizado e envie-o para as ferramentas apropriadas para webmasters.

- Elimine seu site de conteúdo desnecessário ou desatualizado.

- Fique atento aos URLs gerados dinamicamente, que podem aumentar o número de páginas do seu site.

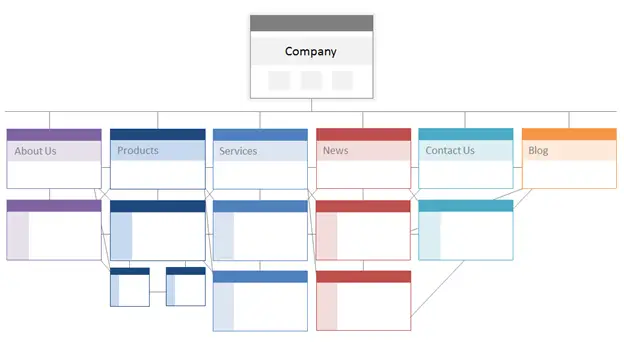

3. Otimize a arquitetura do seu site.

Seu site tem várias páginas. Essas páginas precisam ser organizadas de forma a permitir que os mecanismos de pesquisa as localizem e rastreiem facilmente. É aí que entra a estrutura do seu site – geralmente chamada de arquitetura de informações do seu site.

Da mesma forma que um edifício é baseado no projeto arquitetônico, a arquitetura do seu site é como você organiza as páginas do seu site.

As páginas relacionadas são agrupadas; por exemplo, a página inicial do seu blog tem links para postagens de blog individuais, cada uma com um link para suas respectivas páginas de autor. Essa estrutura ajuda os bots de pesquisa a entender o relacionamento entre suas páginas.

A arquitetura do seu site também deve moldar e ser moldada pela importância de páginas individuais. Quanto mais próxima a página A estiver da sua página inicial, mais páginas vincularão à página A e quanto mais equidade de linkessaspáginas tiverem, mais importância os mecanismos de pesquisa darão à página A.

Por exemplo, um link da sua página inicial para a página A demonstra mais importância do que um link de uma postagem no blog. Quanto mais links para a página A, mais “significativa” essa página se torna para os mecanismos de pesquisa.

Conceitualmente, a arquitetura de um site poderia ser algo assim, onde as páginasSobre, Produto, Notícias,etc. são posicionadas no topo da hierarquia de importância da página.

Fonte

Certifique-se de que as páginas mais importantes para o seu negócio estejam no topo da hierarquia com o maior número de links internos (relevantes!)

4. Defina uma estrutura de URL.

A estrutura do URL refere-se a como você estrutura seus URLs, o quepode serdeterminado pela arquitetura do seu site. Vou explicar a conexão em um momento. Primeiro, vamos esclarecer que os URLs podem ter subdiretórios, comoblog.hubspot.com, e/ou subpastas, comohubspot.com/blog, que indicam aonde o URL leva.

Por exemplo, uma postagem de blog intituladaHow to Groom Your Dogcairia em um subdomínio ou subdiretório de blog. O URL pode ser www.bestdogcare.com/blog/how-to-groom-your-dog . Considerando que uma página de produto no mesmo site seriawww.bestdogcare.com/products/grooming-brush.

Se você usa subdomínios ou subdiretórios ou “produtos” versus “loja” em seu URL, depende inteiramente de você. A beleza de criar seu próprio site é que você pode criar as regras. O importante é que essas regras sigam uma estrutura unificada, o que significa que você não deve alternar entre blog.seusite.com e seusite.com/blogs em páginas diferentes. Crie um roteiro, aplique-o à sua estrutura de nomenclatura de URL e cumpra-o.

Aqui estão mais algumas dicas sobre como escrever seus URLs:

- Use caracteres minúsculos.

- Use travessões para separar as palavras.

- Faça-os curtos e descritivos.

- Evite usar caracteres ou palavras desnecessárias (incluindo preposições).

- Inclua suas palavras-chave alvo.

Depois de ter sua estrutura de URL definida, você enviará uma lista de URLs de suas páginas importantes para os mecanismos de pesquisa na forma de um mapa do site XML . Isso fornece aos bots de pesquisa um contexto adicional sobre o seu site, para que eles não precisem descobrir enquanto rastreiam.

5. Utilize robots.txt.

Quando um robô da web rastreia seu site, ele verifica primeiro o /robot.txt, também conhecido como Protocolo de Exclusão de Robô. Esse protocolo pode permitir ou impedir que robôs da Web específicos rastreiem seu site, incluindo seções específicas ou até mesmo páginas de seu site. Se você quiser impedir que bots indexem seu site, use uma meta tag noindex robots. Vamos discutir esses dois cenários.

Você pode querer impedir que certos bots rastreiem seu site. Infelizmente, existem alguns bots com intenções maliciosas - bots que irão raspar seu conteúdo ou enviar spam aos fóruns da sua comunidade. Se você perceber esse mau comportamento, usará seu robot.txt para impedir que eles entrem em seu site. Neste cenário, você pode pensar em robot.txt como seu campo de força de bots ruins na internet.

Em relação à indexação, os bots de pesquisa rastreiam seu site para coletar pistas e encontrar palavras-chave para que possam corresponder às suas páginas da Web com consultas de pesquisa relevantes. Mas, como discutiremos mais tarde, você tem um orçamento de rastreamento que não deseja gastar com dados desnecessários. Portanto, você pode excluir páginas que não ajudam os bots de pesquisa a entender sobre o que é o seu site, por exemplo, uma páginade agradecimentode uma oferta ou uma página de login.

Não importa o que aconteça, seu protocolo robot.txt será único, dependendo do que você gostaria de realizar.

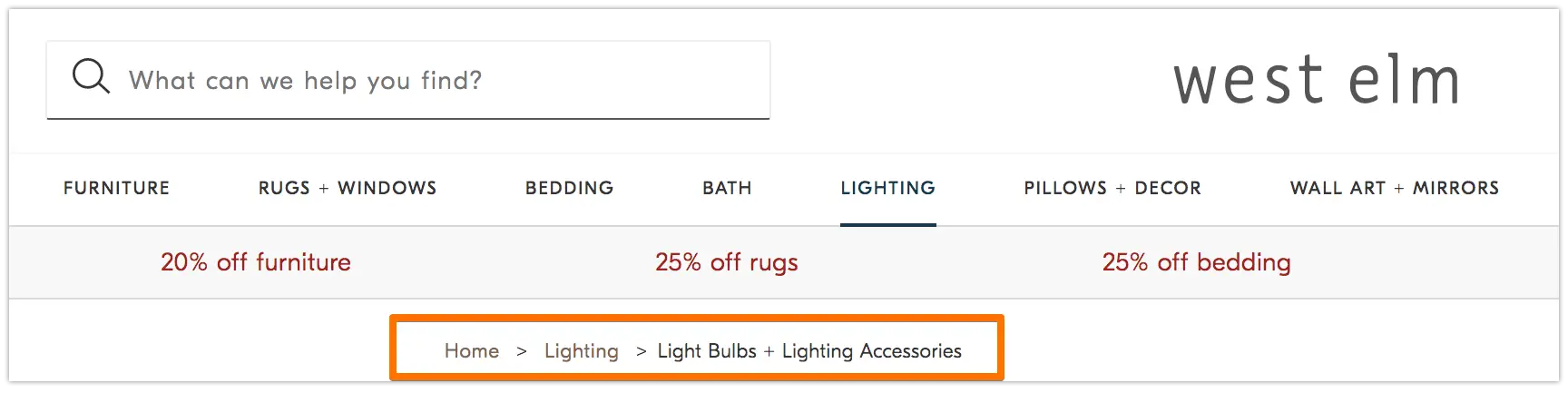

6. Adicione menus de trilha de navegação.

Lembre-se da velha fábulaJoão e Maria, onde duas crianças jogavam migalhas de pão no chão para encontrar o caminho de volta para casa? Bem, eles estavam tramando algo.

Breadcrumbs são exatamente o que parecem - uma trilha que guia os usuários de volta ao início de sua jornada em seu site. É um menu de páginas que informa aos usuários como sua página atual se relaciona com o restante do site.

E eles não são apenas para visitantes do site; os bots de pesquisa também os usam.

Fonte

Breadcrumbs devem ser duas coisas: 1) visíveis para os usuários para que eles possam navegar facilmente em suas páginas da Web sem usar o botãoVoltare 2) ter uma linguagem de marcação estruturada para fornecer um contexto preciso aos bots de pesquisa que estão rastreando seu site.

Não sabe como adicionar dados estruturados às suas trilhas de navegação? Use este guia para BreadcrumbList .

7. Use paginação.

Lembra quando os professores exigiam que você numerasse as páginas do seu trabalho de pesquisa? Isso se chama paginação. No mundo do SEO técnico, a paginação tem um papel um pouco diferente, mas você ainda pode pensar nela como uma forma de organização.

A paginação usa código para informar aos mecanismos de pesquisa quando as páginas com URLs distintos estão relacionadas entre si. Por exemplo, você pode ter uma série de conteúdo dividida em capítulos ou várias páginas da web. Se você deseja facilitar a descoberta e o rastreamento dessas páginas pelos bots de pesquisa, use a paginação.

A forma como funciona é bem simples. Você irá para o<head>da página um da série e usará

rel=”next”para informar ao bot de pesquisa qual página rastrear em segundo lugar. Então, na página dois, você usarárel=”prev”para indicar a página anterior erel=”next”para indicar a página seguinte, e assim por diante.

Se parece com isso…

Na página um:

<link rel=“next” href=“https://www.website.com/page-two” />

Na página dois:

<link rel=“prev” href=“https://www.website.com/page-one” />

<link rel=“next” href=“https://www.website.com/page-three” />

Observe que a paginação é útil para a descoberta de rastreamento, mas não é mais suportada pelo Google para páginas de índice em lote como antes.

8. Verifique seus arquivos de log de SEO.

Você pode pensar em arquivos de log como uma entrada de diário. Os servidores da Web (o journaler) registram e armazenam dados de log sobre todas as ações que realizam em seu site em arquivos de log (o diário). Os dados registrados incluem a hora e a data da solicitação, o conteúdo solicitado e o endereço IP solicitante. Você também pode identificar o agente do usuário, que é um software de identificação exclusiva (como um bot de pesquisa, por exemplo) que atende à solicitação de um usuário.

Mas o que isso tem a ver com SEO?

Bem, os bots de pesquisa deixam um rastro na forma de arquivos de log quando rastreiam seu site. Você pode determinar se, quando e o que foi rastreado verificando os arquivos de log e filtrando pelo agente do usuário e mecanismo de pesquisa .

Essas informações são úteis porque você pode determinar como seu orçamento de rastreamento é gasto e quais barreiras para indexação ou acesso um bot está enfrentando. Para acessar seus arquivos de log, você pode perguntar a um desenvolvedor ou usar um analisador de arquivo de log, como o Screaming Frog .

Só porque um bot de pesquisa pode rastrear seu site não significa necessariamente que ele pode indexar todas as suas páginas. Vamos dar uma olhada na próxima camada de sua auditoria técnica de SEO — indexabilidade .

Lista de verificação de indexabilidade

À medida que os bots de pesquisa rastreiam seu site, eles começam a indexar páginas com base em seu tópico e relevância para esse tópico. Uma vez indexada, sua página é elegível para classificação nas SERPs. Aqui estão alguns fatores que podem ajudar suas páginas a serem indexadas.

Lista de verificação de indexabilidade

- Desbloqueie o acesso de bots de pesquisa às páginas.

- Remova o conteúdo duplicado.

- Audite seus redirecionamentos.

- Verifique a capacidade de resposta móvel do seu site.

- Corrija erros de HTTP.

1. Desbloqueie o acesso de bots de pesquisa às páginas.

Você provavelmente cuidará dessa etapa ao abordar a capacidade de rastreamento, mas vale a pena mencioná-la aqui. Você deseja garantir que os bots sejam enviados para suas páginas preferidas e que possam acessá-las livremente. Você tem algumas ferramentas à sua disposição para fazer isso. O testador de robots.txt do Google fornecerá uma lista de páginas que não são permitidas e você poderá usar a ferramenta Inspecionar do Google Search Console para determinar a causa das páginas bloqueadas.

2. Remova o conteúdo duplicado.

O conteúdo duplicado confunde os bots de pesquisa e afeta negativamente sua indexabilidade. Lembre-se de usar URLs canônicos para estabelecer suas páginas preferidas.

3. Audite seus redirecionamentos.

Verifique se todos os seus redirecionamentos estão configurados corretamente. Loops de redirecionamento, URLs quebrados ou — pior — redirecionamentos impróprios podem causar problemas quando seu site está sendo indexado. Para evitar isso, audite todos os seus redirecionamentos regularmente.

4. Verifique a capacidade de resposta móvel do seu site.

Se o seu site ainda não é compatível com dispositivos móveis, você está muito atrás de onde deveria estar. Já em 2016, o Google começou a indexar sites móveis primeiro , priorizando a experiência móvel em relação ao computador. Hoje, essa indexação é habilitada por padrão. Para acompanhar essa importante tendência, você pode usar o teste de compatibilidade com dispositivos móveis do Google para verificar onde seu site precisa melhorar.

5. Corrija os erros de HTTP.

HTTP significa HyperText Transfer Protocol, mas você provavelmente não se importa com isso. O que importa é quando o HTTP retorna erros para seus usuários ou para os mecanismos de pesquisa e como corrigi-los.

Os erros de HTTP podem impedir o trabalho dos bots de pesquisa, bloqueando-os de conteúdo importante em seu site. Portanto, é extremamente importante corrigir esses erros de forma rápida e completa.

Como cada erro de HTTP é único e requer uma resolução específica, a seção abaixo apresenta uma breve explicação de cada um, e você usará os links fornecidos para saber mais sobre eles ou como resolvê-los.

- Redirecionamentos permanentes 301 são usados para enviar permanentemente o tráfego de um URL para outro. Seu CMS permitirá que você configure esses redirecionamentos, mas muitos deles podem tornar seu site lento e degradar a experiência do usuário, pois cada redirecionamento adicional aumenta o tempo de carregamento da página. Procure cadeias de redirecionamento zero, se possível, pois muitas farão com que os mecanismos de pesquisa desistam de rastrear essa página.

- 302 Temporary Redirect é uma forma de redirecionar temporariamente o tráfego de um URL para uma página diferente. Embora esse código de status envie automaticamente os usuários para a nova página da Web, a tag de título, o URL e a descrição armazenados em cache permanecerão consistentes com o URL de origem. Se o redirecionamento temporário permanecer no local por tempo suficiente, ele será eventualmente tratado como um redirecionamento permanente e esses elementos passarão para o URL de destino.

- Mensagens 403 proibidas significam que o conteúdo que um usuário solicitou é restrito com base em permissões de acesso ou devido a uma configuração incorreta do servidor.

- As páginas de erro 404 informam aos usuários que a página que eles solicitaram não existe, porque foi removida ou porque digitaram o URL errado. É sempre uma boa ideia criar páginas 404 com marca própria e atraentes para manter os visitantes em seu site (clique no link acima para ver alguns bons exemplos).

- 405 Method Not Allowed significa que o servidor do seu site reconheceu e ainda bloqueou o método de acesso, resultando em uma mensagem de erro.

- 500 Internal Server Error é uma mensagem de erro geral que significa que seu servidor da Web está com problemas para entregar seu site ao solicitante.

- 502 Bad Gateway Error está relacionado à falta de comunicação ou resposta inválida entre os servidores do site.

- 503 Serviço indisponível informa que, embora seu servidor esteja funcionando corretamente, ele não pode atender à solicitação.

- 504 Gateway Timeout significa que um servidor não recebeu uma resposta em tempo hábil de seu servidor web para acessar as informações solicitadas.

Seja qual for o motivo desses erros, é importante resolvê-los para manter os usuários e os mecanismos de pesquisa satisfeitos e para que ambos retornem ao seu site.

Mesmo que seu site tenha sido rastreado e indexado, problemas de acessibilidade que bloqueiam usuários e bots afetarão seu SEO. Dito isso, precisamos passar para o próximo estágio de sua auditoria técnica de SEO – renderização.

Lista de verificação de renderização

Antes de mergulharmos neste tópico, é importante observar a diferença entre acessibilidade de SEO e acessibilidade na web . O último gira em torno de tornar suas páginas da web fáceis de navegar para usuários com deficiências ou deficiências, como cegueira ou dislexia, por exemplo. Muitos elementos de acessibilidade online se sobrepõem às melhores práticas de SEO. No entanto, uma auditoria de acessibilidade de SEO não leva em conta tudo o que você precisa fazer para tornar seu site mais acessível a visitantes com deficiência.

Vamos nos concentrar na acessibilidade de SEO, ou renderização, nesta seção, mas lembre-se da acessibilidade da Web ao desenvolver e manter seu site.

Lista de verificação de renderização

Um site acessível é baseado na facilidade de renderização. Abaixo estão os elementos do site para revisar para sua auditoria de renderização.

Desempenho do servidor

Como você aprendeu acima, tempos limite e erros do servidor causarão erros de HTTP que impedem que usuários e bots acessem seu site. Se você perceber que seu servidor está com problemas, use os recursos fornecidos acima para solucionar problemas e resolvê-los. Deixar de fazer isso em tempo hábil pode resultar na remoção de sua página da Web do índice pelos mecanismos de pesquisa, pois é uma experiência ruim mostrar uma página quebrada a um usuário.

Status HTTP

Semelhante ao desempenho do servidor, os erros de HTTP impedirão o acesso às suas páginas da web. Você pode usar um rastreador da Web, como Screaming Frog , Botify ou DeepCrawl para realizar uma auditoria abrangente de erros em seu site.

Tempo de carregamento e tamanho da página

Se sua página demorar muito para carregar, a taxa de rejeição não é o único problema com o qual você deve se preocupar. Um atraso no tempo de carregamento da página pode resultar em um erro de servidor que bloqueará bots de suas páginas da Web ou fará com que eles rastreiem versões parcialmente carregadas que não tenham seções importantes de conteúdo. Dependendo de quanta demanda de rastreamento existe para um determinado recurso, os bots gastarão uma quantidade equivalente de recursos para tentar carregar, renderizar e indexar páginas. No entanto, você deve fazer tudo ao seu alcance para diminuir o tempo de carregamento da página.

Renderização JavaScript

O Google reconhecidamente tem dificuldade em processar JavaScript (JS) e, portanto, recomenda o emprego de conteúdo pré-renderizado para melhorar a acessibilidade. O Google também tem uma série de recursos para ajudar você a entender como os bots de pesquisa acessam o JS em seu site e como melhorar os problemas relacionados à pesquisa.

Páginas órfãs

Cada página do seu site deve estar vinculada apelo menosuma outra página – de preferência mais, dependendo da importância da página. Quando uma página não possui links internos, ela é chamada de página órfã. Como um artigo sem introdução, essas páginas carecem do contexto que os bots precisam para entender como devem ser indexados.

Profundidade da página

A profundidade da página refere-se a quantas camadas uma página existe na estrutura do seu site, ou seja, a quantos cliques da sua página inicial ela está. É melhor manter a arquitetura do site o mais superficial possível, mantendo uma hierarquia intuitiva. Às vezes, um site com várias camadas é inevitável; nesse caso, você deve priorizar um site bem organizado em detrimento da superficialidade.

Independentemente de quantas camadas na estrutura do seu site, mantenha páginas importantes – como seu produto e páginas de contato – não mais do que três cliques. Uma estrutura que enterra sua página de produto tão profundamente em seu site que os usuários e bots precisam bancar o detetive para encontrá-los são menos acessíveis e fornecem uma experiência ruim

Por exemplo, um URL de site como este que orienta seu público-alvo para a página do produto é um exemplo de estrutura de site mal planejada: www.yourwebsite.com/products-features/features-by-industry/airlines-case-studies/airlines -produtos.

cadeias de redirecionamento

Quando você decide redirecionar o tráfego de uma página para outra, está pagando um preço. Esse preço é a eficiência do rastreamento. Os redirecionamentos podem retardar o rastreamento, reduzir o tempo de carregamento da página e tornar seu site inacessível se esses redirecionamentos não forem configurados corretamente. Por todos esses motivos, tente reduzir ao mínimo os redirecionamentos.

Depois de resolver os problemas de acessibilidade, você pode passar para a classificação de suas páginas nas SERPs.

Lista de verificação de classificação

Agora passamos para os elementos mais tópicos que você provavelmente já conhece - como melhorar a classificação do ponto de vista técnico de SEO. Colocar suas páginas no ranking envolve alguns dos elementos on-page e off-page que mencionamos antes, mas de uma perspectiva técnica.

Lembre-se de que todos esses elementos trabalham juntos para criar um site otimizado para SEO. Portanto, seríamos negligentes em deixar de fora todos os fatores contribuintes. Vamos mergulhar nisso.

Links Internos e Externos

Os links ajudam os bots de pesquisa a entender onde uma página se encaixa no grande esquema de uma consulta e fornece contexto sobre como classificar essa página. Os links orientam os bots de pesquisa (e usuários) para o conteúdo relacionado e a importância da página de transferência. No geral, a vinculação melhora o rastreamento, a indexação e sua capacidade de classificação.

Qualidade de backlink

Backlinks – links de outros sites para o seu – fornecem um voto de confiança para o seu site. Eles dizem aos bots de pesquisa que o site externo A acredita que sua página é de alta qualidade e que vale a pena rastreá-la. À medida que esses votos se somam, os bots de pesquisa percebem e tratam seu site como mais confiável. Parece um ótimo negócio, certo? No entanto, como acontece com a maioria das grandes coisas, há uma ressalva. A qualidade desses backlinks é muito importante.

Links de sites de baixa qualidade podem realmente prejudicar seus rankings. Há muitas maneiras de obter backlinks de qualidade para o seu site, como divulgação de publicações relevantes, alegando menções não vinculadas, fornecendo publicações relevantes, reivindicando menções não vinculadas e fornecendo conteúdo útil ao qual outros sites desejam vincular.

Clusters de conteúdo

Nós da HubSpot não temos vergonha de nosso amor por clusters de conteúdo ou como eles contribuem para o crescimento orgânico . Os clusters de conteúdo vinculam o conteúdo relacionado para que os bots de pesquisa possam encontrar, rastrear e indexar facilmente todas as páginas que você possui em um tópico específico. Eles agem como uma ferramenta de autopromoção para mostrar aos mecanismos de pesquisa o quanto você sabe sobre um tópico, portanto, é mais provável que classifiquem seu site como uma autoridade para qualquer consulta de pesquisa relacionada.

Sua classificação é o principal determinante no crescimento do tráfego orgânico porque os estudos mostram que os pesquisadores têm maior probabilidade de clicar nos três principais resultados de pesquisa nas SERPs. Mas como você garante que oseuresultado seja clicado?

Vamos completar isso com a peça final da pirâmide de tráfego orgânico: a capacidade de clique.

Lista de verificação de cliques

Embora a taxa de cliques (CTR) tenha tudo a ver com o comportamento do pesquisador, há coisasque vocêpode fazer para melhorar sua capacidade de clique nos SERPs. Embora meta descrições e títulos de página com palavras-chave tenham impacto na CTR, vamos nos concentrar nos elementos técnicos porque é por isso que você está aqui.

Lista de verificação de cliques

- Use dados estruturados.

- Ganhe recursos de SERP.

- Otimize para trechos em destaque.

- Considere o Google Discover.

A classificação e a taxa de cliques andam de mãos dadas porque, sejamos honestos, os pesquisadores querem respostas imediatas. Quanto mais seu resultado se destacar na SERP, maior a probabilidade de você obter o clique. Vamos ver algumas maneiras de melhorar sua capacidade de clique.

1. Use dados estruturados.

Os dados estruturados empregam um vocabulário específico chamado esquema para categorizar e rotular elementos em sua página da Web para bots de pesquisa. O esquema deixa bem claro o que é cada elemento, como ele se relaciona com o seu site e como interpretá-lo. Basicamente, os dados estruturados dizem aos bots: “Isto é um vídeo”, “Isto é um produto” ou “Isto é uma receita”, não deixando espaço para interpretação .

To be clear, using structured data is not a “clickability factor” (if there even is such a thing), but it does help organize your content in a way that makes it easy for search bots to understand, index, and potentially rank your pages.

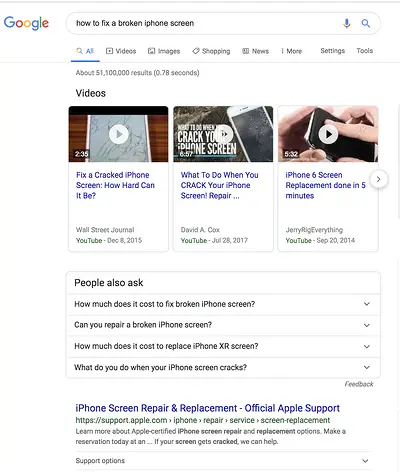

2. Win SERP features.

SERP features , otherwise known as rich results, are a double-edged sword. If you win themandget the click-through, you're golden. If not, your organic results are pushed down the page beneath sponsored ads, text answer boxes, video carousels, and the like.

Rich results are those elements that don't follow the page title, URL, meta description format of other search results. For example, the image below shows two SERP features — a video carousel and “People Also Ask” box — above the first organic result.

While you can still get clicks from appearing in the top organic results, your chances are greatly improved with rich results.

How do you increase your chances of earning rich results? Write useful content and use structured data. The easier it is for search bots to understand the elements of your site, the better your chances of getting a rich result.

Structured data is useful for getting these ( and other search gallery elements ) from your site to the top of the SERPs, thereby, increasing the probability of a click-through:

- Articles

- Videos

- Avaliações

- Events

- How-Tos

- FAQs (“People Also Ask” boxes)

- Images

- Local Business Listings

- Products

- Sitelinks

3. Optimize for Featured Snippets.

One unicorn SERP feature that has nothing to do with schema markup is Featured Snippets, those boxes above the search results that provide concise answers to search queries.

Featured Snippets are intended to get searchers the answers to their queries as quickly as possible. According to Google , providing the best answer to the searcher's query is the only way to win a snippet. However, HubSpot's research revealed a few additional ways to optimize your content for featured snippets .

4. Consider Google Discover.

Google Discover is a relatively new algorithmic listing of content by category specifically for mobile users. It's no secret that Google has been doubling down on the mobile experience; with over 50% of searches coming from mobile , it's no surprise either. The tool allows users to build a library of content by selecting categories of interest (think: gardening, music, or politics).

At HubSpot, we believe topic clustering can increase the likelihood of Google Discover inclusion and are actively monitoring our Google Discover traffic in Google Search Console to determine the validity of that hypothesis. We recommend that you also invest some time in researching this new feature. The payoff is a highly engaged user base that has basically hand-selected the content you've worked hard to create.

The Perfect Trio

Technical SEO, on-page SEO, and off-page SEO work together to unlock the door to organic traffic. While on-page and off-page techniques are often the first to be deployed, technical SEO plays a critical role in getting your site to the top of the search results and your content in front of your ideal audience. Use these technical tactics to round out your SEO strategy and watch the results unfold.