WordPress robots.txt

Publicados: 2019-02-26WordPress robots.txt é muito importante para SEO. Para ter certeza de que seu site está bem classificado nos resultados dos mecanismos de pesquisa, você precisa tornar suas páginas mais importantes convenientes para pesquisar e indexar “robôs” (“bots”) dos mecanismos de pesquisa. Um arquivo robots.txt bem estruturado ajudará a direcionar esses bots para as páginas que você deseja indexar.

Neste artigo vamos revelar tais questões:

- O que é um arquivo robots.txt e por que é importante

- Localização do txt dos robôs do WordPress

- Melhor txt de robôs para WordPress

- Como criar um arquivo robots.txt

- Como verificar o arquivo robots.txt e enviá-lo para o console da Pesquisa Google.

O que é um arquivo robots.txt para WordPress e por que é importante?

Quando você cria um novo site, os mecanismos de busca enviam seus robôs para escanear e criar um mapa de todas as suas páginas. Dessa forma, eles saberão quais páginas mostrar como resultado quando alguém pesquisar palavras-chave relevantes. Em um nível básico, isso é bastante simples (veja também este post útil – arquivo .htaccess padrão do WordPress).

O problema é que os sites modernos contêm muitos outros elementos além das páginas. O WordPress permite que você instale, por exemplo, plugins que geralmente possuem seus próprios diretórios. Não há necessidade de mostrar isso nos resultados da pesquisa, pois eles não correspondem ao conteúdo.

O que o arquivo robots.txt faz é fornecer um conjunto de diretrizes para robôs de pesquisa. Ele lhes diz: “Olhem aqui e indexem essas páginas, mas não entrem em outras áreas!”. Este arquivo pode ser tão detalhado quanto você quiser e é muito fácil de criar, mesmo se você for iniciante.

Na prática, os motores de busca ainda irão varrer o seu site, mesmo que você não crie um arquivo robots.txt. No entanto, não criá-lo é um passo muito irracional. Sem esse arquivo, você deixa os robôs indexarem todo o conteúdo do seu site e eles decidem que você precisa mostrar todas as partes do seu site, mesmo aquelas que você gostaria de ocultar do acesso público (veja também – Melhores plugins de comércio eletrônico do WordPress ).

Um ponto mais importante, sem um arquivo robots.txt, seu site terá muitos acessos de robôs do seu site. Isso afetará negativamente seu desempenho. Mesmo que a audiência do seu site ainda seja pequena, a velocidade de carregamento da página é algo que deve estar sempre em prioridade e no mais alto nível. No final, existem apenas algumas coisas que as pessoas não gostam mais do que carregar sites lentamente.

Localização do txt dos robôs do WordPress

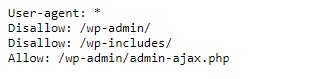

Quando você cria um site WordPress, um arquivo robots.txt é criado automaticamente e localizado em seu diretório principal no servidor. Por exemplo, se o seu site está localizado aqui – wpdevart.com, você pode encontrá-lo em wpdevart.com/robots.txt e ver algo assim:

Este é um exemplo do arquivo robots.txt mais simples. Traduzindo em linguagem legível, o lado direito após o User-agent: declara

para quais robôs são as regras. Um asterisco significa que a regra é universal e se aplica a todos os robôs. Nesse caso, o arquivo informa aos robôs que eles não podem verificar os diretórios wp-admin e wp-includes. O significado dessas regras é que esses diretórios contêm muitos arquivos que exigem proteção contra acesso público (também, verifique nosso plugin WordPress Countdown).

Claro, você pode adicionar mais regras ao seu arquivo. Antes de fazer isso, você precisa entender que este é um arquivo virtual. Normalmente, o WordPress robots.txt está localizado no diretório raiz, que geralmente é chamado de public_html ou www (ou pelo nome do seu site):

Deve-se notar que o arquivo robots.txt para WordPress, criado por padrão, não pode ser acessado a partir de nenhum diretório. Funciona, mas se você quiser fazer alterações, precisará criar seu próprio arquivo e enviá-lo para o diretório raiz.

Veremos várias maneiras de criar um arquivo robots.txt para WordPress. Agora vamos discutir como determinar quais regras incluir no arquivo.

Melhor txt de robôs para WordPress

Não é tão difícil criar o melhor txt de robôs para o seu site WordPress. Então, quais regras precisam ser incluídas no arquivo robots.txt. Na seção anterior, vimos um exemplo de arquivo robots.txt gerado pelo WordPress. Inclui apenas duas regras curtas, mas para a maioria dos sites elas são suficientes. Vamos dar uma olhada em dois arquivos robots.txt diferentes e ver o que cada um faz.

Aqui está nosso primeiro exemplo de um arquivo robots.txt do WordPress:

User-agent: * Allow: / # Disallowed Sub-Directories Disallow: / payout / Disallow: / photos / Disallow: / forums /Este arquivo robots.txt foi criado para o fórum. Os mecanismos de pesquisa geralmente indexam todos os tópicos do fórum. Dependendo do tópico do seu fórum, você pode querer desabilitar a indexação. Por exemplo, o Google não indexará centenas de discussões curtas de usuários. Você também pode definir regras que apontam para um tópico específico do fórum para excluí-lo e permitir que os mecanismos de pesquisa indexem o restante.

Você também percebe uma linha que começa com Permitir: / na parte superior do arquivo. Essa linha informa aos robôs que eles podem verificar todas as páginas do seu site, exceto as restrições definidas abaixo. Você também notou que definimos essas regras como universais (com um asterisco), como estava no arquivo virtual do WordPress robots.txt (também, você pode verificar nosso plugin da tabela de preços do WordPress).

Vamos conferir outro exemplo de arquivo robots.txt do WordPress:

User-agent: * Disallow: / wp-admin / Disallow: / wp-includes / User-agent: Bingbot Disallow: /Neste arquivo definimos as mesmas regras que vão para o WordPress por padrão. Embora também estejamos adicionando um novo conjunto de regras que impedem que os robôs de pesquisa do Bing rastreiem nosso site. Bingbot, como você pode ver, é o nome do robô.

Você pode digitar outros nomes de mecanismos de pesquisa para restringir/permitir seu acesso também. Na prática, é claro, o Bingbot é muito bom (mesmo que não seja tão bom quanto o Googlebot). No entanto, existem muitos robôs maliciosos.

A má notícia é que eles nem sempre seguem as instruções do arquivo robots.txt (eles ainda funcionam como terroristas). Deve-se ter em mente que, embora a maioria dos robôs use as instruções fornecidas neste arquivo, você não pode forçá-los a fazê-lo.

Se você se aprofundar no assunto, encontrará muitas sugestões sobre o que permitir e o que bloquear em seu site WordPress. Embora, pela nossa experiência, menos regras sejam muitas vezes melhores. Aqui está um exemplo de

melhor robots txt para site WordPress, mas para site diferente pode ser diferente:

User-agent: * Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Disallow: *utm*= Disallow: *openstat= Allow: */uploads Sitemap: https://wpdevart.com/sitemap.xmlTradicionalmente, o WordPress gosta de fechar os diretórios wp-admin e wp-includes. No entanto, esta já não é a melhor solução. Além disso, se você adicionar meta tags para suas imagens para fins de promoção (SEO), não faz sentido dizer aos robôs para não indexar o conteúdo desses diretórios.

O que deve conter seu arquivo robots.txt dependerá das necessidades do seu site. Portanto, sinta-se à vontade para pesquisar mais!

Como criar um robots.txt

O que poderia ser mais simples do que criar um arquivo de texto (txt). Tudo o que você precisa fazer é abrir seu editor favorito (como o Bloco de Notas ou o TextEdit) e inserir algumas linhas. Então você salva o arquivo usando robots e extensão txt(robots.txt). Levará alguns segundos, então você pode querer criar um robots.txt para WordPress sem usar um plugin.

Salvamos este arquivo localmente no computador. Depois de criar seu próprio arquivo, você precisa se conectar ao seu site via FTP (talvez com o FileZilla).

Depois de se conectar ao seu site, vá para o diretório public_html. Agora, tudo que você precisa fazer é carregar o arquivo robots.txt do seu computador para o servidor. Você pode fazer isso clicando com o botão direito do mouse no arquivo no navegador FTP local ou simplesmente arrastando-o com o mouse.

Leva apenas alguns segundos. Como você pode ver, esse método é mais fácil do que usar o plugin.

Como verificar o robots.txt do WordPress e enviá-lo para o Google Search Console

Depois que o arquivo robots.txt do WordPress for criado e carregado, você poderá verificar se há erros no Google Search Console. O Search Console é um conjunto de ferramentas do Google projetadas para ajudar você a acompanhar como seu conteúdo aparece nos resultados de pesquisa. Uma dessas ferramentas verifica o robots.txt, você o encontrará facilmente na página de administração das ferramentas do webmaster do Google (veja também Os 50 Melhores Plugins WordPress 2020).

Lá você encontrará o campo do editor onde você pode adicionar o código para o seu arquivo WordPress robots.txt e clique em Enviar no canto inferior direito. O console de pesquisa do Google perguntará se você deseja usar o novo código ou fazer o download de um arquivo do seu site.

Agora, a plataforma verificará se há erros no arquivo. Se um erro for encontrado, informações sobre isso serão mostradas a você. Você viu alguns exemplos do arquivo robots.txt do WordPress e agora tem ainda mais chances de criar seu arquivo robots.txt perfeito!