Actualizarea Google Spam tocmai a fost finalizată: iată ce s-a întâmplat

Publicat: 2022-10-24

Ocazional, Google lansează actualizarea de spam, care se asigură doar că rezultatele de pe Google nu sunt umplute cu spam.

Pentru că dacă un utilizator dă clic pe un rezultat spam și dacă acest lucru se întâmplă continuu, se creează o experiență groaznică și oamenii ar înceta să mai folosească Google.

Nu oferă prea multe detalii despre actualizarea spam-ului de pe site-ul lor, dar, din fericire pentru tine, avem două lucruri care ne ajută să stabilim care au fost modificările.

Primul lucru pe care îl avem este că urmărim peste 900 de milioane de domenii pe web, astfel încât acest lucru ne permite să vedem tipare.

Al doilea, care este mai relevant pentru această actualizare este la agenția noastră, NP Digital, avem 100 de site-uri experimentale care folosesc conținut scris prin AI. Scopul acelor site-uri nu este de a „juca” Google, ci mai degrabă de a-și da seama cum percepe Google conținutul scris prin inteligență artificială. Și voi intra în mai multe detalii despre ceea ce sa întâmplat cu acele site-uri mai târziu în această postare, deoarece rezultatele au fost interesante.

Scopul actualizării

Ca și în nume, scopul principal al Google este reducerea spamului. Acum au mai multe tipuri de actualizări de spam, cum ar fi în iulie 2021, au avut o actualizare de spam a linkurilor.

Această actualizare nu a specificat dacă a fost legat de spam-ul de link-uri sau doar de spam general.

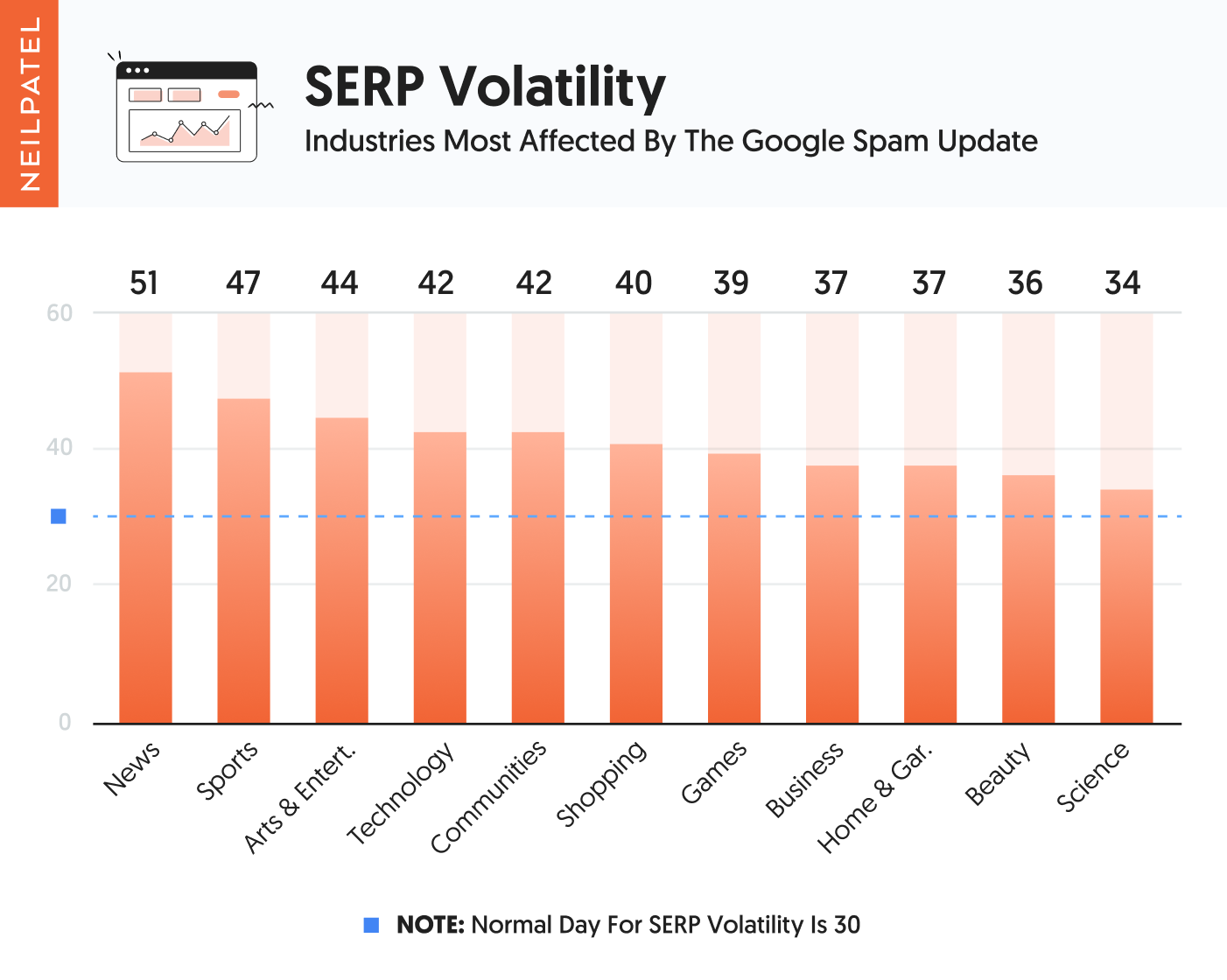

Dar când ne uităm la cele peste 900 de milioane de domenii pe care le urmărim, iată categoriile care au fost afectate cel mai mult în mod negativ la nivel global.

După cum puteți vedea din graficul de mai sus, site-urile de știri și sport au fost cele mai afectate. Urmat îndeaproape de arte și divertisment și tehnologie și site-uri comunitare.

Majoritatea acestor site-uri sunt bazate pe conținut intens și nu sunt orientate spre produs.

Când ne-am uitat la site-urile afectate, iată ce am găsit:

- Conținut subțire – majoritatea nu aveau conținut uimitor... mulți dintre ei aveau conținut subțire. Și pentru a clarifica faptul că, prin conținut subțire, nu mă refer la un număr scăzut de cuvinte, mă refer la conținut care într-adevăr nu a oferit prea multă valoare. În esență, conținutul a fost la nivel de suprafață și, odată ce ai terminat de citit, nu ai obținut multe perspective sau alte puncte de acționare sau valoare.

- Meta-etichete prost create – multe dintre site-urile web afectate aveau pagini cu meta-etichete duplicate sau care au fost scrise evident pentru motoarele de căutare și nu pentru oameni.

- Umplutura de cuvinte cheie – oamenii șocante sunt încă umplutură de cuvinte cheie. Dintre site-urile afectate, majoritatea nu au avut cuvinte cheie, dar aproximativ 3,89% dintre ele au făcut-o. Fie că era în conținutul lor pe metaetichete, ei foloseau cuvinte cheie într-un mod excesiv, ceea ce făcea ca experiența de lectură să nu fie ideală.

După cum știți, există mulți alți factori în SEO. Pur și simplu nu am putut găsi alte modele majore. La nivel de suprafață, unele dintre lucrurile la care s-au uitat par asemănătoare cu actualizarea utilă a conținutului.

Ne-am uitat și la backlink-urile site-urilor care au pierdut cel mai mult trafic, nu am putut găsi niciun model. Acum, acest lucru nu înseamnă că Google a privit sau nu link-urile ca un factor de spam în această actualizare, cu atât mai mult cu cât pur și simplu nu am văzut niciun model .

Acum, aici devine interesant...

Conținut generat de AI

Îți amintești cum am menționat că avem 100 de site-uri web generate de AI? Sunt într-o varietate de industrii și toate au peste 60 de pagini de conținut, dacă nu mai mult, care sunt toate generate de AI și, desigur, am construit manual link-uri (nu le-am cumpărat și nu ar trebui să cumpărați niciodată link-uri ) astfel încât să ajute site-urile să se claseze.

Și, în realitate, avem de fapt peste 681 de site-uri generate de AI, dar cele mai multe dintre ele nu primesc suficient trafic SEO. De exemplu, atunci când un site primește doar 1.000 de vizitatori pe lună de la Google, este prea greu să vezi modele, deoarece numărul de vizitatori se schimbă drastic de la o zi la alta.

Dar 100 dintre site-urile bazate pe inteligență artificială generează cel puțin 3.000 de vizitatori pe lună de la Google.

Niciunul dintre site-uri nu vinde nimic sau nu colectează clienți potențiali, sunt doar site-uri informaționale din diferite industrii.

Acum, dintre cele 100 de site-uri generate de conținut AI, 53 au conținutul creat exclusiv prin AI. Și au, de asemenea, metaetichetele lor și chiar și titlurile din articol, toate create de AI.

Aceste pagini nu fac linkuri către alte site-uri sau chiar pagini interne, deoarece instrumentele de generare de conținut AI nu adaugă cu adevărat linkuri.

Un lucru de remarcat este că majoritatea instrumentelor AI nu creează într-adevăr conținut de peste 500 de cuvinte decât dacă începeți să ajustați conținutul sau dacă îl puneți pe scriitorul AI să creeze conținut câte un paragraf.

Dar pentru primul lot de site-uri AI (53 dintre ele), nu am avut oameni să modifice sau să schimbe niciun conținut. Am folosit exclusiv conținutul creat de AI în forma în care a fost creat, inclusiv metaetichetele create de scriitorul AI.

Acum, în al doilea lot, aveam 47 de site-uri, pe aceste site-uri am folosit AI pentru a crea conținutul, dar apoi am pus un om să modifice conținutul pentru a ne asigura că este mai bun și oferă mai multă valoare. Oamenii au adăugat, de asemenea, link-uri interne și externe, au modificat metaetichetele pentru a fi mai ușor de utilizat și au adăugat imagini și încorpora videoclipuri în articol atunci când avea sens.

Singurul lucru pe care nu l-am făcut a fost să mărim mult lungimea. Pentru că, din ceea ce vedem de la Ubersuggest AI Writer, majoritatea oamenilor folosesc doar conținut scris prin inteligență artificială și nu îl modifică prea mult. Când o modifică, tinde să fie ușor, iar oamenii chiar nu adaugă prea multe în numărul de cuvinte.

Cu site-urile noastre, am vrut să replicăm ceea ce fac majoritatea marketerilor cu inteligența artificială pentru a obține o idee despre ceea ce încearcă Google să rezolve.

Poți ghici ce s-a întâmplat cu acele site-uri?

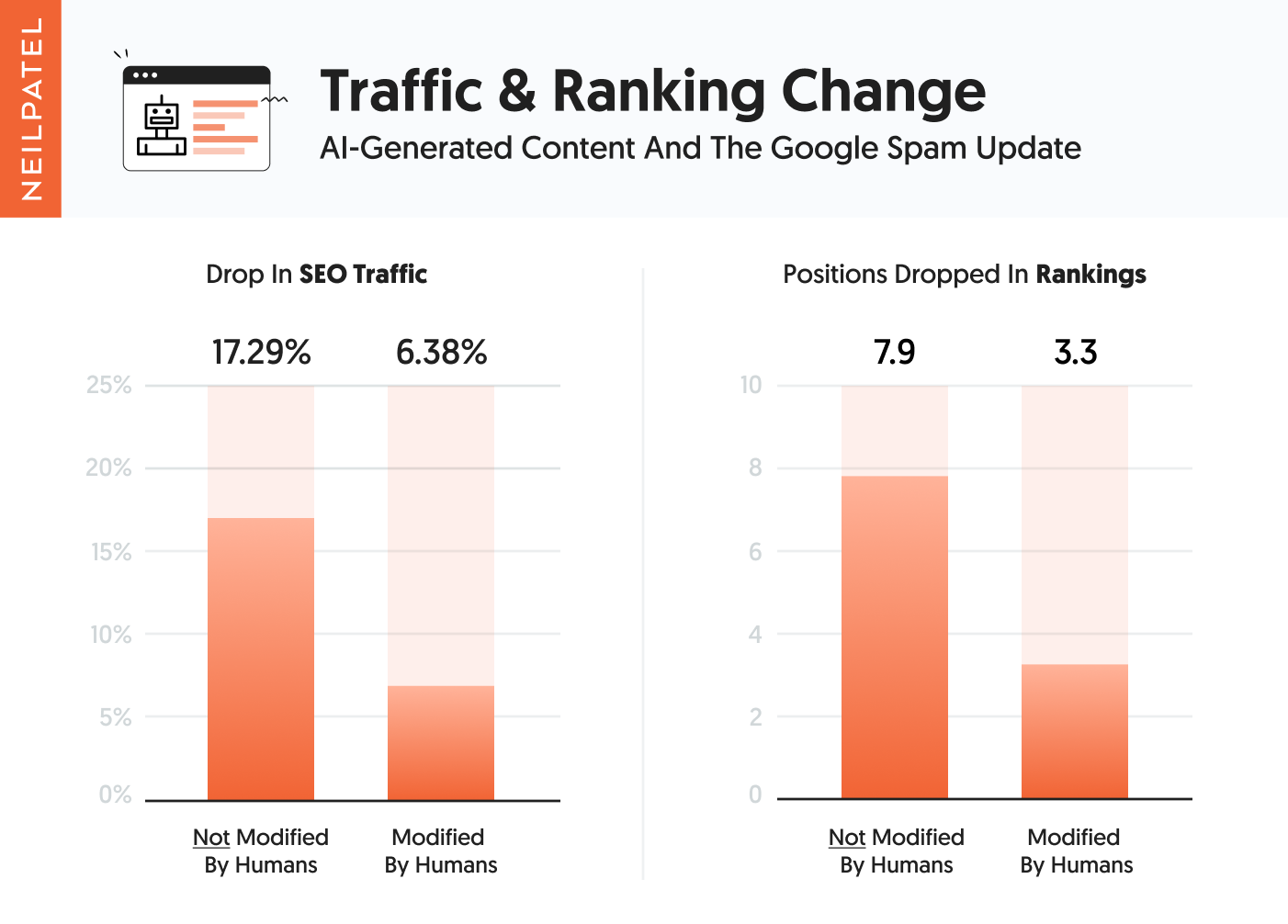

Primul grup de conținut scris prin inteligență artificială, care nu a avut nicio intervenție umană când vine vorba de modificarea conținutului, nu a funcționat la fel de bine ca cei care au avut intervenție umană.

În esență, ei au văzut în medie o scădere de 17,29% a traficului, iar clasamentul cuvintelor lor a scăzut în medie cu 7,9 poziții. Rețineți că poate părea mult, dar niciunul dintre ei nu a avut cu adevărat clasamentul numărul 1 pentru niciun termen popular.

Al doilea grup a înregistrat o scădere a traficului cu 6,38% și, în medie, o scădere a poziției în clasament cu 3,3 poziții.

Dar atunci când am săpat mai adânc pentru că eram curios să văd rezultatele pentru fiecare site, am observat că nu toate site-urile au fost lovite de actualizare.

Din primul grup de 53 de site-uri, în care conținutul NU a fost ajustat de oameni, 14 dintre ele au fost lovite de actualizare și au înregistrat scăderi de trafic între 31,44% și 73,18%. În medie, cele 14 site-uri au pierdut 51,65% din trafic.

Din cel de-al doilea grup, în care oamenii modifică ușor conținutul, au fost lovite 8 site-uri. Au pierdut între 29,52% și 81,43% din trafic. În medie, cele 8 site-uri au înregistrat o scădere a traficului cu 42,17%.

Acum, ceea ce este amuzant este că unele dintre celelalte site-uri din ambele categorii au înregistrat scăderi mai mici de trafic, cum ar fi câteva puncte procentuale, iar câteva chiar au văzut o ușoară creștere a traficului din traficul SEO cu până la 4% atunci când compari traficul pre-actualizare și cel post-actualizare ca a durat 48 de ore pentru ca actualizarea să fie lansată.

Dar aici devine interesant, în primul grup din cele 14 site-uri care au fost afectate, 13 dintre ele au văzut și scăderi de trafic din actualizarea de conținut utilă. Și din al doilea grup, toate cele 8 site-uri au fost lovite de actualizarea utilă a conținutului.

Un lucru de remarcat este că nu au existat tone de zile de actualizare a postării datelor de la momentul în care Google a terminat de implementat lucrurile până la momentul în care am lansat această postare pe blog. Și nu am vrut să compar traficul de duminică cu cel de miercuri. După cum trebuie să priviți duminica față de duminica trecută pentru a elimina părtinirea. Cu toate acestea, statisticile de mai sus sunt ceea ce am văzut, iar scăderile din clasament confirmă, de asemenea, că aceste site-uri au fost afectate de actualizare.

Concluzie

Din ceea ce vedem, cea mai mare parte a acestei actualizări s-a concentrat pe conținut, metaetichete și umplutură de cuvinte cheie. Nu înseamnă că Google nu s-a uitat la alți factori, cum ar fi link-urile sau conținutul duplicat, dar am văzut cele mai mari modele legate de factorii pe care i-am menționat mai sus și de conținutul generat de AI.

Dacă doriți să faceți bine pe termen lung, concentrați-vă pe utilizator, acesta este într-adevăr modalitatea de a câștiga. Pe termen scurt, s-ar putea să nu ajungi înainte, dar pe termen lung, vei ajunge.

Pune-ți doar întrebări cum ar fi acest conținut va fi util pentru utilizatori? Este utilă folosirea acelorași metaetichete pe toate paginile? Site-ul meu oferă suficientă valoare încât oamenii vor dori să trimită linkuri către mine?

În esență, vă verificați pe loc și faceți ceea ce este mai bine pentru utilizatori.

Ce ați văzut din actualizarea Google spam?

Vedeți cum agenția mea poate genera cantități masive de trafic către site-ul dvs. web

- SEO – deblocați cantități masive de trafic SEO. Vezi rezultate reale.

- Marketing de conținut – echipa noastră creează conținut epic care va fi distribuit, va primi link-uri și va atrage trafic.

- Media plătită – strategii plătite eficiente cu rentabilitate a investiției clară.

Rezervați un apel