Ghidul suprem pentru SEO tehnic

Publicat: 2023-02-24Enumerați trei lucruri pe care le-ați făcut anul acesta care se referă la optimizarea pentru motoarele de căutare (SEO).

Aceste tactici se învârt în jurul cercetării cuvintelor cheie, meta descrierilor și backlink-urilor?

Dacă da, nu ești singur. Când vine vorba de SEO, aceste tehnici sunt de obicei primele pe care marketerii le adaugă la arsenalul lor.

Deși aceste strategii îmbunătățesc vizibilitatea site-ului dvs. în căutarea organică, ele nu sunt singurele pe care ar trebui să le utilizați. Există un alt set de tactici care se încadrează sub umbrela SEO.

SEO tehnic se referă la elementele din culise care alimentează motorul de creștere organică, cum ar fi arhitectura site-ului, optimizarea pentru dispozitive mobile și viteza paginii. Aceste aspecte ale SEO s-ar putea să nu fie cele mai sexy, dar sunt incredibil de importante.

Primul pas în îmbunătățirea SEO tehnică este să știi unde te afli prin efectuarea unui audit al site-ului. Al doilea pas este să creezi un plan care să abordeze zonele în care nu îți lipsești. Vom acoperi mai jos acești pași în profunzime.

Sfat profesionist: creați un site web conceput pentru a face conversii folosind instrumentele CMS gratuite ale HubSpot.

Ce este SEO tehnic?

SEO tehnic se referă la orice faci care face site-ul tău mai ușor de accesat cu crawlere și de indexat pentru motoarele de căutare. SEO tehnic, strategia de conținut și strategiile de creare a linkurilor funcționează în tandem pentru a ajuta paginile dvs. să se claseze foarte bine în căutare.

SEO tehnic vs. SEO on-page vs. SEO off-page

Mulți oameni descompun optimizarea pentru motoarele de căutare (SEO) în trei compartimente diferite: SEO on-page, SEO off-page și SEO tehnic. Să acoperim rapid ce înseamnă fiecare.

SEO pe pagină

SEO on-page se referă la conținutul care spune motoarelor de căutare (și cititorilor!) despre ce este vorba în pagina dvs., inclusiv textul alternativ al imaginii, utilizarea cuvintelor cheie, meta descrierile, etichetele H1, denumirea adreselor URL și linkurile interne. Ai cel mai mare control asupra SEO pe pagină pentru că, ei bine, totul estepesite-ul tău.

SEO off-page

SEO off-page le spune motoarelor de căutare cât de populară și utilă este pagina dvs. prin voturi de încredere - în special backlink-uri sau link-uri de pe alte site-uri către propriul dvs. Cantitatea și calitatea backlink-ului sporesc PageRank-ul unei pagini. Toate lucrurile fiind egale, o pagină cu 100 de link-uri relevante de pe site-uri credibile va depăși o pagină cu 50 de link-uri relevante de pe site-uri credibile (sau 100 de link-uri irelevante de pe site-uri credibile).

SEO tehnic

SEO tehnic este și în controlul tău, dar este puțin mai dificil de stăpânit, deoarece este mai puțin intuitiv.

De ce este important SEO tehnic?

Ați putea fi tentat să ignorați complet această componentă a SEO; cu toate acestea, joacă un rol important în traficul dvs. organic. Conținutul dvs. poate fi cel mai complet, util și bine scris, dar dacă un motor de căutare nu îl poate accesa cu crawlere, foarte puțini oameni îl vor vedea vreodată.

Este ca un copac care cade în pădure când nimeni nu este prin preajmă să-l audă... scoate un sunet? Fără o bază tehnică SEO puternică, conținutul tău nu va emite niciun sunet pentru motoarele de căutare.

Sursă

Sursă

Să discutăm cum vă puteți face conținutul să răsune prin internet.

Înțelegerea SEO tehnic

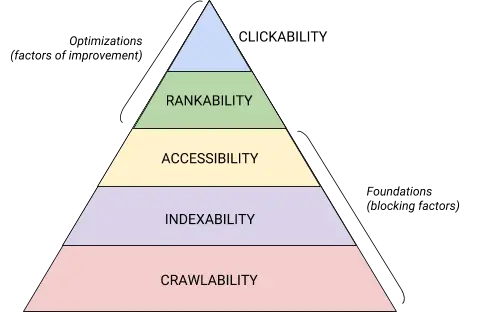

SEO tehnic este o bestie care este cel mai bine descompusă în bucăți digerabile. Dacă ești ca mine, îți place să abordezi lucrurile mari în bucăți și cu liste de verificare. Credeți sau nu, tot ceea ce am acoperit până în acest moment poate fi plasat într-una dintre cele cinci categorii, fiecare dintre acestea meritând propria listă de elemente acționabile.

Aceste cinci categorii și locul lor în ierarhia tehnică SEO este cel mai bine ilustrat de această grafică frumoasă, care amintește de Ierarhia nevoilor lui Maslov, dar remixată pentru optimizarea motoarelor de căutare. (Rețineți că vom folosi termenul folosit în mod obișnuit „Redare” în locul Accesibilității.)

Sursă

Sursă

Fundamentele tehnice ale auditului SEO

Înainte de a începe cu auditul tehnic SEO, există câteva elemente fundamentale pe care trebuie să le puneți în aplicare.

Auditați domeniul dvs. preferat

Domeniul dvs. este adresa URL pe care oamenii o introduc pentru a ajunge pe site-ul dvs., cum ar fi hubspot.com . Domeniul site-ului dvs. web influențează dacă oamenii vă pot găsi prin căutare și oferă o modalitate consecventă de a vă identifica site-ul.

Când selectați un domeniu preferat, le spuneți motoarelor de căutare dacă preferați ca versiunea www sau non-www a site-ului dvs. să fie afișată în rezultatele căutării. De exemplu, puteți selectawww.site-ul dvs. webîn loculsite-ului dumneavoastră.com. Acest lucru le spune motoarele de căutare să prioritizeze versiunea www a site-ului dvs. și redirecționează toți utilizatorii către acea adresă URL. În caz contrar, motoarele de căutare vor trata aceste două versiuni ca site-uri separate, rezultând o valoare SEO dispersată.

Anterior, Google v-a cerut să identificați versiunea adresei URL pe care o preferați. Acum, Google va identifica și va selecta o versiune pentru a vă afișa celor care caută. Cu toate acestea, dacă preferați să setați versiunea preferată a domeniului dvs., atunci puteți face acest lucru prin intermediul etichetelor canonice (pe care le vom acoperi în scurt timp). Oricum, odată ce ați setat domeniul preferat, asigurați-vă că toate variantele, adicăwww, non-www, http și index.html, toate redirecționează permanent către versiunea respectivă.

Implementați SSL

Poate că ați mai auzit acest termen - asta pentru că este destul de important. SSL, sau Secure Sockets Layer , creează un strat de protecție între serverul web (software-ul responsabil pentru îndeplinirea unei cereri online) și un browser, făcând astfel site-ul dvs. sigur. Când un utilizator trimite informații către site-ul dvs. web, cum ar fi informații de plată sau de contact, este mai puțin probabil ca aceste informații să fie piratate, deoarece aveți SSL pentru a le proteja.

Un certificat SSL este notat cu un domeniu care începe cu „https://” spre deosebire de „http://” și un simbol de lacăt în bara de adrese URL.

Motoarele de căutare acordă prioritate site-urilor securizate – de fapt, Google a anunțat încă din 2014 că SSL va fi considerat un factor de clasare . Din acest motiv, asigurați-vă că setați varianta SSL a paginii dvs. de pornire ca domeniu preferat.

După ce configurați SSL, va trebui să migrați orice pagini non-SSL de la http la https. Este o comandă grea, dar merită efortul în numele unui clasament îmbunătățit. Iată pașii pe care trebuie să îi urmați:

- Redirecționează toate paginile http://yourwebsite.com către https://yourwebsite.com .

- Actualizați toate etichetele canonice și hreflang în consecință.

- Actualizați adresele URL de pe sitemap-ul dvs. (situat la yourwebsite.com/sitemap.xml ) și robot.txt (situat la yourwebsite.com/robots.txt ).

- Configurați o nouă instanță a Google Search Console și Bing Webmaster Tools pentru site-ul dvs. https și urmăriți-o pentru a vă asigura că 100% din trafic migrează.

Optimizați viteza paginii

Știți cât timp va aștepta un vizitator al site-ului web să se încarce site-ul dvs.? Șase secunde ... și asta înseamnă să fii generos. Unele date arată că rata de respingere crește cu 90% cu o creștere a timpului de încărcare a paginii de la una la cinci secunde. Nu aveți o secundă de pierdut, așa că îmbunătățirea timpului de încărcare a site-ului ar trebui să fie o prioritate.

Viteza site-ului nu este importantă doar pentru experiența utilizatorului și pentru conversie, ci este și un factor de clasare .

Utilizați aceste sfaturi pentru a îmbunătăți timpul mediu de încărcare a paginii:

- Comprimați toate fișierele dvs. Comprimarea reduce dimensiunea imaginilor dvs. , precum și a fișierelor CSS, HTML și JavaScript, astfel încât acestea ocupă mai puțin spațiu și se încarcă mai rapid.

- Redirecționări de audit în mod regulat. Procesarea unei redirecționări 301 durează câteva secunde. Înmulțiți-l pe mai multe pagini sau straturi de redirecționări și veți avea un impact serios asupra vitezei site-ului dvs.

- Decupați codul. Codul dezordonat poate afecta negativ viteza site-ului dvs. Cod dezordonat înseamnă cod care este leneș. Este ca și cum ai scris — poate că în prima schiță, îți exprimi punctul de vedere în 6 propoziții. În a doua schiță, îl faci în 3. Cu cât codul este mai eficient, cu atât pagina se va încărca mai repede (în general). Odată ce ați curățat lucrurile, vă veți reduce și comprima codul .

- Luați în considerare o rețea de distribuție de conținut (CDN). CDN-urile sunt servere web distribuite care stochează copii ale site-ului dvs. în diferite locații geografice și vă livrează site-ul în funcție de locația celui care caută. Deoarece informațiile dintre servere au o distanță mai mică de parcurs, site-ul dvs. se încarcă mai repede pentru partea solicitantă.

- Încercați să nu mergeți fericit cu pluginul. Pluginurile învechite au adesea vulnerabilități de securitate care fac site-ul dvs. susceptibil la hackeri rău intenționați care pot afecta clasamentul site-ului dvs. Asigurați-vă că utilizați întotdeauna cele mai recente versiuni de pluginuri și minimizați utilizarea la cele mai esențiale. În același sens, luați în considerare utilizarea temelor personalizate, deoarece temele de site-uri prefabricate vin adesea cu o mulțime de coduri inutile.

- Profitați de pluginurile cache. Pluginurile cache stochează o versiune statică a site-ului dvs. pentru a o trimite utilizatorilor care revin, reducând astfel timpul de încărcare a site-ului în timpul vizitelor repetate.

- Utilizați încărcarea asincronă (async). Scripturile sunt instrucțiuni pe care serverele trebuie să le citească înainte de a putea procesa HTML, sau corpul paginii dvs. web, adică lucrurile pe care vizitatorii doresc să le vadă pe site-ul dvs. De obicei, scripturile sunt plasate în <head> al unui site web (gândiți-vă: scriptul dvs. Google Tag Manager), unde sunt prioritizate față de conținutul de pe restul paginii. Folosind codul asincron înseamnă că serverul poate procesa HTML și scriptul simultan, reducând astfel întârzierea și mărind timpul de încărcare a paginii.

Iată cum arată un script asincron: < script async src =” script.js „></ script >

Dacă doriți să vedeți unde site-ul dvs. este insuficient în departamentul de viteză, puteți utiliza această resursă de la Google .

Odată ce ați pus bazele tehnice SEO la locul lor, sunteți gata să treceți la următoarea etapă - crawbilitatea.

Lista de verificare a accesului la crawlere

Crawlability este baza strategiei tale tehnice SEO. Boții de căutare vă vor accesa cu crawlere paginile pentru a aduna informații despre site-ul dvs.

Dacă acești roboți sunt blocați cumva de accesare cu crawlere, nu vă pot indexa sau clasa paginile. Primul pas pentru implementarea SEO tehnic este să vă asigurați că toate paginile dvs. importante sunt accesibile și ușor de navigat.

Mai jos vom acoperi câteva elemente de adăugat la lista dvs. de verificare, precum și câteva elemente ale site-ului web de auditat pentru a ne asigura că paginile dvs. sunt optime pentru accesare cu crawlere.

Lista de verificare a accesului la crawlere

- Creați o hartă de site XML.

- Maximizați-vă bugetul de accesare cu crawlere.

- Optimizați-vă arhitectura site-ului.

- Setați o structură URL.

- Utilizați robots.txt.

- Adăugați meniuri pesmet.

- Utilizați paginarea.

- Verificați fișierele jurnal SEO.

1. Creați un sitemap XML.

Îți amintești structura site-ului pe care am trecut? Acest lucru aparține ceva numit un Sitemap XML care îi ajută pe roboții de căutare să înțeleagă și să acceseze cu crawlere paginile dvs. web. Vă puteți gândi la ea ca la o hartă pentru site-ul dvs. Veți trimite harta site-ului dvs. la Google Search Console și Bing Webmaster Tools după ce este finalizată. Nu uitați să vă mențineți harta site-ului la zi pe măsură ce adăugați și eliminați pagini web.

2. Maximizați-vă bugetul de accesare cu crawlere.

Bugetul dvs. de accesare cu crawlere se referă la paginile și resursele pe care le vor accesa roboții de căutare pe site .

Deoarece bugetul de accesare cu crawlere nu este infinit, asigurați-vă că acordați prioritate celor mai importante pagini pentru accesare cu crawlere.

Iată câteva sfaturi pentru a vă asigura că vă maximizați bugetul de accesare cu crawlere:

- Eliminați sau canonizați paginile duplicate.

- Remediați sau redirecționați orice linkuri rupte.

- Asigurați-vă că fișierele dvs. CSS și Javascript pot fi accesate cu crawlere.

- Verificați-vă statisticile de accesare cu crawlere în mod regulat și urmăriți dacă există scăderi sau creșteri bruște.

- Asigurați-vă că orice bot sau pagină pe care le-ați interzis accesarea cu crawlere este menită să fie blocată.

- Țineți-vă sitemap-ul actualizat și trimiteți-l la instrumentele adecvate pentru webmasteri.

- Eliminați site-ul de conținut inutil sau învechit.

- Atenție la adresele URL generate dinamic, care pot face ca numărul de pagini de pe site să crească vertiginos.

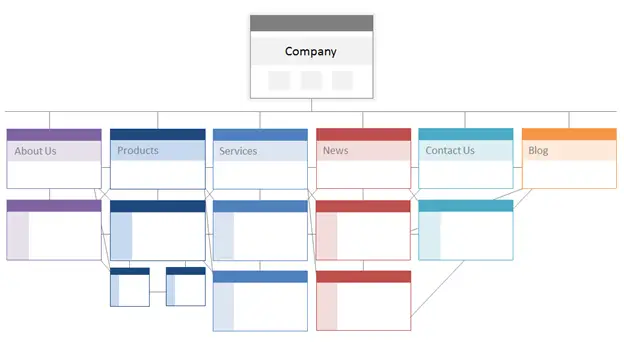

3. Optimizați-vă arhitectura site-ului.

Site-ul dvs. are mai multe pagini. Aceste pagini trebuie să fie organizate într-un mod care să permită motoarelor de căutare să le găsească și să le acceseze cu crawlere. Aici intervine structura site-ului dvs. - denumită adesea arhitectura informațională a site-ului dvs. -.

În același mod în care o clădire se bazează pe design arhitectural, arhitectura site-ului tău este modul în care organizezi paginile de pe site.

Paginile înrudite sunt grupate; de exemplu, pagina de pornire a blogului dvs. trimite către postări individuale de blog, fiecare link către paginile respective ale autorului. Această structură îi ajută pe roboții de căutare să înțeleagă relația dintre paginile tale.

Arhitectura site-ului dvs. ar trebui, de asemenea, să modeleze și să fie modelată de importanța paginilor individuale. Cu cât Pagina A este mai aproape de pagina ta de pornire, cu cât mai multe pagini se leagă către Pagina A și cu câtacelepagini au mai multă echitate de link-uri, cu atât motoarele de căutare vor acorda mai multă importanță paginii A.

De exemplu, un link de la pagina ta de pornire către Pagina A demonstrează mai multă importanță decât un link de la o postare pe blog. Cu cât sunt mai multe link-uri către Pagina A, cu atât pagina devine mai „semnificativă” pentru motoarele de căutare.

Conceptual, arhitectura unui site ar putea arăta cam așa, unde paginileDespre, Produs, Știrietc. sunt poziționate în vârful ierarhiei de importanță a paginii.

Sursă

Asigurați-vă că cele mai importante pagini pentru afacerea dvs. se află în vârful ierarhiei cu cel mai mare număr de link-uri interne (relevante!).

4. Setați o structură URL.

Structura URL se referă la modul în care vă structurați adresele URL, carear putea fideterminată de arhitectura site-ului dvs. Îți voi explica legătura într-o clipă. În primul rând, să clarificăm că adresele URL pot avea subdirectoare, cum ar fiblog.hubspot.comși/sau subdosare, cum ar fihubspot.com/blog, care indică unde duce adresa URL.

De exemplu, o postare de blog intitulatăCum să-ți îngrijești câineles-ar încadra într-un subdomeniu sau subdirector de blog. Adresa URL poate fi www.bestdogcare.com/blog/how-to-groom-your-dog . În timp ce o pagină de produs de pe același site ar fiwww.bestdogcare.com/products/grooming-brush.

Indiferent dacă utilizați subdomenii sau subdirectoare sau „produse” versus „magazin” în adresa URL depinde în întregime de dvs. Frumusețea creării propriului site web este că poți crea regulile. Ceea ce este important este ca acele reguli să urmeze o structură unificată, ceea ce înseamnă că nu ar trebui să comutați între blog.yourwebsite.com și yourwebsite.com/blogs pe pagini diferite. Creați o foaie de parcurs, aplicați-o structurii dvs. de denumire URL și rămâneți la ea.

Iată câteva sfaturi suplimentare despre cum să scrieți adresele URL:

- Folosiți caractere mici.

- Folosiți liniuțe pentru a separa cuvintele.

- Fă-le scurte și descriptive.

- Evitați să folosiți caractere sau cuvinte inutile (inclusiv prepoziții).

- Includeți cuvintele cheie țintă.

După ce ați activat structura URL, veți trimite motoarele de căutare o listă de adrese URL ale paginilor dvs. importante sub forma unui sitemap XML . Acest lucru oferă roboților de căutare un context suplimentar despre site-ul dvs., astfel încât aceștia să nu fie nevoiți să-și dea seama în timp ce accesează cu crawlere.

5. Utilizați robots.txt.

Când un robot web accesează cu crawlere site-ul dvs., va verifica mai întâi /robot.txt, altfel cunoscut sub numele de Robot Exclusion Protocol. Acest protocol poate permite sau interzice anumiți roboți web să acceseze cu crawlere site-ul dvs., inclusiv anumite secțiuni sau chiar pagini ale site-ului dvs. Dacă doriți să împiedicați roboții să vă indexeze site-ul, veți folosi o metaetichetă noindex robots. Să discutăm ambele scenarii.

Poate doriți să blocați anumiți roboți să vă acceseze cu crawlere site-ul. Din păcate, există niște roboți cu intenții rău intenționate - roboți care vă vor răzui conținutul sau vor spama forumurile comunității. Dacă observați acest comportament rău, veți folosi robot.txt pentru a le împiedica să intre pe site-ul dvs. web. În acest scenariu, vă puteți gândi la robot.txt ca fiind câmpul dvs. de forță de la roboții răi de pe internet.

În ceea ce privește indexarea, roboții de căutare accesează cu crawlere site-ul dvs. pentru a aduna indicii și a găsi cuvinte cheie, astfel încât să poată potrivi paginile dvs. web cu interogări de căutare relevante. Dar, după cum vom discuta mai târziu, aveți un buget de accesare cu crawlere pe care nu doriți să-l cheltuiți pentru date inutile. Prin urmare, este posibil să doriți să excludeți paginile care nu îi ajută pe roboții de căutare să înțeleagă despre ce este vorba site-ul dvs., de exemplu, o paginăde mulțumiredintr-o ofertă sau o pagină de conectare.

Indiferent de ce, protocolul robot.txt va fi unic, în funcție de ceea ce doriți să realizați.

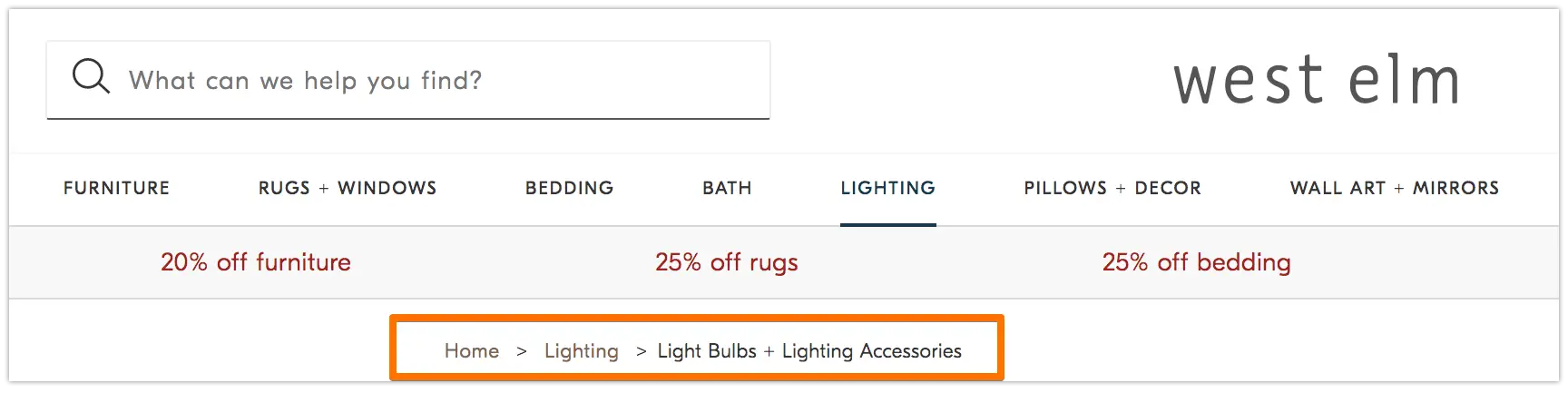

6. Adăugați meniuri pesmet.

Îți amintești de vechea fabulăHansel și Gretelîn care doi copii au aruncat pesmet pe pământ pentru a-și găsi drumul înapoi acasă? Ei bine, erau la ceva.

Pesmeturile sunt exact așa cum sună – un traseu care ghidează utilizatorii să se întoarcă la începutul călătoriei lor pe site-ul dvs. Este un meniu de pagini care le spune utilizatorilor cum se leagă pagina lor curentă cu restul site-ului.

Și nu sunt doar pentru vizitatorii site-ului web; roboții de căutare îi folosesc și ei.

Sursă

Breadcrumb-urile ar trebui să fie două lucruri: 1) vizibile pentru utilizatori, astfel încât aceștia să poată naviga cu ușurință în paginile dvs. web fără a utiliza butonulÎnapoiși 2) să aibă un limbaj de marcare structurat pentru a oferi un context precis robotilor de căutare care accesează cu crawlere site-ul dvs.

Nu sunteți sigur cum să adăugați date structurate la breadcrumbs? Utilizați acest ghid pentru BreadcrumbList .

7. Folosiți paginarea.

Îți amintești când profesorii ți-ar cere să numerotezi paginile lucrării tale de cercetare? Asta se numește paginație. În lumea SEO tehnică, paginarea are un rol ușor diferit, dar poți totuși să te gândești la ea ca la o formă de organizare.

Paginarea folosește codul pentru a spune motoarele de căutare când paginile cu adrese URL distincte sunt legate între ele. De exemplu, este posibil să aveți o serie de conținut pe care o împărțiți în capitole sau mai multe pagini web. Dacă doriți să faceți ușor ca robotii de căutare să descopere și să acceseze cu crawlere aceste pagini, atunci veți folosi paginarea.

Modul în care funcționează este destul de simplu. Veți merge la<head>prima pagină a seriei și veți folosi

rel="next"pentru a spune robotului de căutare ce pagină să acceseze cu crawlere a doua. Apoi, pe pagina a doua, veți folosirel=”prev”pentru a indica pagina anterioară șirel=”next”pentru a indica pagina ulterioară și așa mai departe.

Arată așa…

Pe pagina unu:

<link rel="next" href="https://www.website.com/page-two” />

Pe pagina a doua:

<link rel=“prev” href="https://www.website.com/page-one” />

<link rel="next" href="https://www.website.com/page-three" />

Rețineți că paginarea este utilă pentru descoperirea cu crawlere, dar nu mai este acceptată de Google pentru a indexa paginile în loturi așa cum a fost cândva.

8. Verificați fișierele de jurnal SEO.

Vă puteți gândi la fișierele jurnal ca la o intrare de jurnal. Serverele web (jurnalul) înregistrează și stochează date de jurnal despre fiecare acțiune pe care o întreprind pe site-ul dvs. în fișiere de jurnal (jurnal). Datele înregistrate includ ora și data solicitării, conținutul solicitat și adresa IP solicitantă. De asemenea, puteți identifica agentul utilizator, care este un software unic identificabil (cum ar fi un bot de căutare, de exemplu) care îndeplinește cererea pentru un utilizator.

Dar ce legătură are asta cu SEO?

Ei bine, roboții de căutare lasă o urmă sub formă de fișiere jurnal atunci când accesează cu crawlere site-ul tău. Puteți determina dacă, când și ce a fost accesat cu crawlere verificând fișierele jurnal și filtrarea de către agentul utilizator și motorul de căutare .

Aceste informații vă sunt utile, deoarece puteți determina modul în care este cheltuit bugetul de accesare cu crawlere și ce bariere se confruntă în calea indexării sau accesului unui bot. Pentru a vă accesa fișierele jurnal, puteți fie să întrebați un dezvoltator, fie să utilizați un analizor de fișiere jurnal, cum ar fi Screaming Frog .

Doar pentru că un robot de căutare poate accesa cu crawlere site-ul dvs. nu înseamnă neapărat că vă poate indexa toate paginile. Să aruncăm o privire la următorul strat al auditului tău tehnic SEO - indexabilitatea .

Lista de verificare pentru indexabilitate

Pe măsură ce roboții de căutare accesează cu crawlere site-ul dvs., ei încep să indexeze paginile în funcție de subiectul lor și de relevanța pentru acel subiect. Odată indexată, pagina ta este eligibilă pentru a se clasa pe SERP-uri. Iată câțiva factori care vă pot ajuta paginile să fie indexate.

Lista de verificare pentru indexabilitate

- Deblocați roboții de căutare de la accesarea paginilor.

- Eliminați conținutul duplicat.

- Auditează-ți redirecționările.

- Verificați capacitatea de răspuns mobil a site-ului dvs.

- Remediați erorile HTTP.

1. Deblocați roboții de căutare de la accesarea paginilor.

Probabil că veți avea grijă de acest pas atunci când abordați posibilitatea de accesare cu crawlere, dar merită menționat aici. Doriți să vă asigurați că roboții sunt trimiși către paginile dvs. preferate și că le pot accesa liber. Aveți la dispoziție câteva instrumente pentru a face acest lucru. Testerul robots.txt de la Google vă va oferi o listă de pagini care sunt interzise și puteți utiliza instrumentul Inspect din Google Search Console pentru a determina cauza paginilor blocate.

2. Eliminați conținutul duplicat.

Conținutul duplicat încurcă roboții de căutare și vă afectează negativ indexabilitatea. Nu uitați să utilizați adrese URL canonice pentru a vă stabili paginile preferate.

3. Auditează-ți redirecționările.

Verificați dacă toate redirecționările sunt configurate corect. Buclele de redirecționare, adresele URL rupte sau, mai rău, redirecționările necorespunzătoare pot cauza probleme atunci când site-ul dvs. este indexat. Pentru a evita acest lucru, auditați în mod regulat toate redirecționările.

4. Verificați capacitatea de răspuns mobil a site-ului dvs.

Dacă site-ul dvs. nu este compatibil cu dispozitivele mobile până acum, atunci sunteți cu mult în urmă de locul unde trebuie să fiți. Încă din 2016, Google a început să indexeze mai întâi site-urile mobile , acordând prioritate experienței mobile în detrimentul desktopului. Astăzi, această indexare este activată în mod implicit. Pentru a ține pasul cu această tendință importantă, puteți utiliza testul Google pentru mobil pentru a verifica unde trebuie să se îmbunătățească site-ul dvs.

5. Remediați erorile HTTP.

HTTP înseamnă HyperText Transfer Protocol, dar probabil că nu vă pasă de asta. Ceea ce vă interesează este când HTTP returnează erori utilizatorilor dvs. sau motoarelor de căutare și cum să le remediați.

Erorile HTTP pot împiedica activitatea roboților de căutare prin blocarea acestora de la conținutul important de pe site-ul dvs. Prin urmare, este incredibil de important să abordați aceste erori rapid și temeinic.

Deoarece fiecare eroare HTTP este unică și necesită o rezoluție specifică, secțiunea de mai jos conține o scurtă explicație a fiecăreia și veți folosi linkurile furnizate pentru a afla mai multe despre sau cum să le rezolvați.

- Redirecționările permanente 301 sunt folosite pentru a trimite permanent trafic de la o adresă URL la alta. CMS-ul dvs. vă va permite să configurați aceste redirecționări, dar prea multe dintre acestea vă pot încetini site-ul și vă pot degrada experiența utilizatorului, deoarece fiecare redirecționare suplimentară crește timpul de încărcare a paginii. Urmăriți lanțurile de redirecționare zero, dacă este posibil, deoarece prea multe vor determina motoarele de căutare să renunțe la accesarea cu crawlere a paginii respective.

- 302 Redirecționarea temporară este o modalitate de a redirecționa temporar traficul de la o adresă URL către o altă pagină web. Deși acest cod de stare va trimite automat utilizatorii către noua pagină web, eticheta de titlu, adresa URL și descrierea din cache vor rămâne în concordanță cu adresa URL de origine. Dacă redirecționarea temporară rămâne suficient de mult timp, totuși, va fi tratată în cele din urmă ca o redirecționare permanentă și acele elemente vor trece la adresa URL de destinație.

- 403 Mesaje interzise înseamnă că conținutul solicitat de un utilizator este restricționat pe baza permisiunilor de acces sau din cauza unei configurări greșite a serverului.

- Paginile de eroare 404 le spun utilizatorilor că pagina pe care au solicitat-o nu există, fie pentru că a fost eliminată, fie pentru că au introdus adresa URL greșită. Este întotdeauna o idee bună să creați 404 pagini care să fie personalizate și captivante pentru a menține vizitatorii pe site-ul dvs. (faceți clic pe linkul de mai sus pentru a vedea câteva exemple bune).

- 405 Metoda nepermisă înseamnă că serverul site-ului dvs. a recunoscut și a blocat în continuare metoda de acces, rezultând un mesaj de eroare.

- 500 Internal Server Error este un mesaj de eroare general care înseamnă că serverul dvs. web întâmpină probleme la livrarea site-ului dvs. către partea solicitantă.

- 502 Eroare de gateway greșită este legată de comunicarea greșită sau răspunsul invalid între serverele site-ului web.

- 503 Service Unavailable vă spune că, în timp ce serverul dumneavoastră funcționează corect, acesta nu poate îndeplini cererea.

- 504 Gateway Timeout înseamnă că un server nu a primit un răspuns în timp util de la serverul dvs. web pentru a accesa informațiile solicitate.

Indiferent de motivul acestor erori, este important să le soluționați pentru a-i mulțumi atât pe utilizatori, cât și pe motoarele de căutare și pentru ca ambii să revină pe site-ul dvs.

Chiar dacă site-ul dvs. a fost accesat cu crawlere și indexat, problemele de accesibilitate care blochează utilizatorii și roboții vă vor afecta SEO. Acestea fiind spuse, trebuie să trecem la următoarea etapă a auditului tău tehnic SEO - randamentul.

Lista de verificare a redabilității

Înainte de a aborda acest subiect, este important să remarcăm diferența dintre accesibilitatea SEO și accesibilitatea web . Acesta din urmă se învârte în a face paginile dvs. web ușor de navigat pentru utilizatorii cu dizabilități sau deficiențe, cum ar fi orbirea sau dislexia, de exemplu. Multe elemente ale accesibilității online se suprapun cu cele mai bune practici SEO. Cu toate acestea, un audit de accesibilitate SEO nu ține cont de tot ceea ce trebuie să faceți pentru a face site-ul dvs. mai accesibil pentru vizitatorii care sunt cu dizabilități.

Ne vom concentra pe accesibilitatea SEO, sau pe randare, în această secțiune, dar păstrați în minte accesibilitatea web pe măsură ce vă dezvoltați și mențineți site-ul.

Lista de verificare a redabilității

Un site accesibil se bazează pe ușurința de redare. Mai jos sunt elementele site-ului de examinat pentru auditul dvs. de redare.

Performanța serverului

După cum ați învățat mai sus, timeout-urile și erorile serverului vor cauza erori HTTP care împiedică utilizatorii și roboții să acceseze site-ul dvs. Dacă observați că serverul dvs. întâmpină probleme, utilizați resursele furnizate mai sus pentru a le depana și a le rezolva. Dacă nu faceți acest lucru în timp util, motoarele de căutare vă vor elimina pagina web din index, deoarece este o experiență slabă să afișați o pagină ruptă unui utilizator.

Stare HTTP

Similar cu performanța serverului, erorile HTTP vor împiedica accesul la paginile dvs. web. Puteți utiliza un crawler web, cum ar fi Screaming Frog , Botify sau DeepCrawl pentru a efectua un audit complet al erorilor site-ului dvs.

Timpul de încărcare și dimensiunea paginii

Dacă pagina dvs. durează prea mult să se încarce, rata de respingere nu este singura problemă de care trebuie să vă faceți griji. O întârziere a timpului de încărcare a paginii poate duce la o eroare de server care îi va bloca pe roboții din paginile dvs. web sau îi va determina să acceseze cu crawlere versiunile încărcate parțial cărora le lipsesc secțiuni importante de conținut. În funcție de cât de multă cerere de accesare cu crawlere există pentru o anumită resursă, roboții vor cheltui o cantitate echivalentă de resurse pentru a încerca să încarce, să randeze și să indexeze pagini. Cu toate acestea, ar trebui să faceți tot ce vă stă în control pentru a reduce timpul de încărcare a paginii.

Redare JavaScript

Desigur, Google are o dificultate în procesarea JavaScript (JS) și, prin urmare, recomandă utilizarea conținutului pre-rendat pentru a îmbunătăți accesibilitatea. Google are, de asemenea, o serie de resurse pentru a vă ajuta să înțelegeți cum accesează roboții de căutare JS pe site-ul dvs. și cum să îmbunătățiți problemele legate de căutare.

Pagini Orfane

Fiecare pagină de pe site-ul dvs. ar trebui să fie legată decel puțino altă pagină - de preferință mai multe, în funcție de cât de importantă este pagina. Când o pagină nu are legături interne, se numește pagină orfană. La fel ca un articol fără introducere, acestor pagini le lipsește contextul de care au nevoie roboții pentru a înțelege cum ar trebui să fie indexați.

Adâncimea paginii

Adâncimea paginii se referă la câte straturi în jos pe o pagină există în structura site-ului dvs., adică la câte clicuri distanță de pagina dvs. de pornire. Cel mai bine este să vă păstrați arhitectura site-ului cât mai superficială posibil, menținând în același timp o ierarhie intuitivă. Uneori, un site cu mai multe straturi este inevitabil; în acest caz, veți dori să acordați prioritate unui site bine organizat în detrimentul superficialității.

Indiferent de câte straturi din structura site-ului dvs., păstrați paginile importante - cum ar fi produsele și paginile de contact - nu mai mult de trei clicuri adâncime. O structură care îngroapă pagina de produs atât de adânc în site-ul dvs. încât utilizatorii și roboții trebuie să se joace detectivi pentru a le găsi sunt mai puțin accesibile și oferă o experiență slabă

De exemplu, o adresă URL a site-ului web ca aceasta care vă ghidează publicul țintă către pagina produsului dvs. este un exemplu de structură a site-ului prost planificată: www.yourwebsite.com/products-features/features-by-industry/airlines-case-studies/airlines -produse.

Lanțuri de redirecționare

Când decideți să redirecționați traficul de la o pagină la alta, plătiți un preț. Acel preț este eficiența crawl-ului. Redirecționările pot încetini accesul cu crawlere, pot reduce timpul de încărcare a paginii și pot face site-ul dvs. inaccesibil dacă acele redirecționări nu sunt configurate corect. Din toate aceste motive, încercați să mențineți redirecționările la minimum.

Odată ce ați abordat problemele de accesibilitate, puteți trece la modul în care paginile dvs. se clasează în SERP-uri.

Lista de verificare a gradului de clasificare

Acum trecem la elementele mai de actualitate de care probabil le cunoașteți deja - cum să îmbunătățiți clasarea din punct de vedere tehnic SEO. Clasarea paginilor dvs. implică unele dintre elementele din pagină și din afara paginii pe care le-am menționat anterior, dar dintr-o lentilă tehnică.

Amintiți-vă că toate aceste elemente lucrează împreună pentru a crea un site prietenos cu SEO. Deci, am fi neglijent să omitem toți factorii care contribuie. Să ne aruncăm în ea.

Legături interne și externe

Linkurile îi ajută pe roboții de căutare să înțeleagă unde se încadrează o pagină în schema mare a unei interogări și oferă context pentru cum să clasifice pagina respectivă. Legăturile ghidează roboții de căutare (și utilizatorii) către conținutul asociat și importanța paginii de transfer. În general, conectarea îmbunătățește accesarea cu crawlere, indexarea și capacitatea dvs. de a vă clasa.

Calitate backlink

Backlink -urile - link-uri de pe alte site-uri înapoi către propriul dvs. - oferă un vot de încredere pentru site-ul dvs. Ei spun robotilor de căutare că site-ul extern A consideră că pagina dvs. este de înaltă calitate și merită accesată cu crawlere. Pe măsură ce aceste voturi se adună, roboții de căutare observă și tratează site-ul dvs. ca fiind mai credibil. Sună ca o afacere grozavă, nu? Cu toate acestea, ca și în cazul majorității lucrurilor grozave, există o avertizare. Calitatea acelor backlink-uri contează foarte mult.

Link-urile de pe site-uri de calitate scăzută vă pot afecta de fapt clasamentele. Există multe modalități de a obține backlink-uri de calitate către site-ul dvs., cum ar fi comunicarea către publicații relevante, revendicarea mențiunilor nelegate, furnizarea de publicații relevante, revendicarea mențiunilor nelegate și furnizarea de conținut util la care alte site-uri doresc să facă linkuri.

Clustere de conținut

Noi, cei de la HubSpot, nu ne-am sfiit dragostea noastră pentru clusterele de conținut sau modul în care acestea contribuie la creșterea organică . Clusterele de conținut leagă conținutul asociat, astfel încât roboții de căutare să poată găsi, accesa cu crawlere și indexează cu ușurință toate paginile pe care le dețineți pe un anumit subiect. Acţionează ca un instrument de auto-promovare pentru a le arăta motoarelor de căutare cât de mult ştiţi despre un subiect, astfel încât sunt mai probabil să-ţi claseze site-ul ca autoritate pentru orice interogare de căutare asociată.

Clasificarea dvs. este principalul factor determinant în creșterea organică a traficului, deoarece studiile arată că cei care caută au mai multe șanse să facă clic pe primele trei rezultate ale căutării din SERP-uri. Dar cum te asiguri că rezultatultăueste pe care se face clic?

Să completăm acest lucru cu ultima parte a piramidei organice a traficului: clickability.

Lista de verificare a clicului

În timp ce rata de clic (CTR) are totul de-a face cu comportamentul căutării, există lucruri pecare le putețiface pentru a vă îmbunătăți capacitatea de clic pe SERP-uri. În timp ce metadescrierile și titlurile paginilor cu cuvinte cheie au un impact asupra CTR, ne vom concentra pe elementele tehnice, deoarece de aceea sunteți aici.

Lista de verificare a clicului

- Utilizați date structurate.

- Câștigați caracteristicile SERP.

- Optimizați pentru fragmente recomandate.

- Luați în considerare Google Discover.

Clasarea și rata de clic merg mână în mână pentru că, să fim sinceri, cei care caută vor răspunsuri imediate. Cu cât rezultatul tău iese mai mult în evidență pe SERP, cu atât mai probabil vei obține clicul. Să trecem peste câteva moduri de a vă îmbunătăți posibilitatea de a face clic.

1. Folosiți date structurate.

Datele structurate folosesc un vocabular specific numit schema pentru a clasifica și eticheta elementele de pe pagina dvs. web pentru roboții de căutare. Schema face clar ce este fiecare element, cum se leagă de site-ul dvs. și cum să îl interpretați. Practic, datele structurate le spun roboților: „Acesta este un videoclip”, „Acesta este un produs” sau „Aceasta este o rețetă”, fără a lăsa loc de interpretare .

To be clear, using structured data is not a “clickability factor” (if there even is such a thing), but it does help organize your content in a way that makes it easy for search bots to understand, index, and potentially rank your pages.

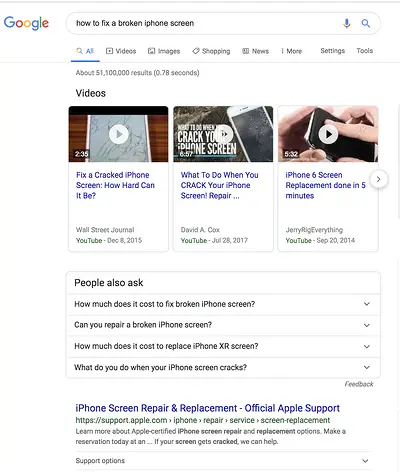

2. Win SERP features.

SERP features , otherwise known as rich results, are a double-edged sword. If you win themandget the click-through, you're golden. If not, your organic results are pushed down the page beneath sponsored ads, text answer boxes, video carousels, and the like.

Rich results are those elements that don't follow the page title, URL, meta description format of other search results. For example, the image below shows two SERP features — a video carousel and “People Also Ask” box — above the first organic result.

While you can still get clicks from appearing in the top organic results, your chances are greatly improved with rich results.

How do you increase your chances of earning rich results? Write useful content and use structured data. The easier it is for search bots to understand the elements of your site, the better your chances of getting a rich result.

Structured data is useful for getting these ( and other search gallery elements ) from your site to the top of the SERPs, thereby, increasing the probability of a click-through:

- Articles

- Videos

- Recenzii

- Events

- How-Tos

- FAQs (“People Also Ask” boxes)

- Images

- Local Business Listings

- Products

- Sitelinks

3. Optimize for Featured Snippets.

One unicorn SERP feature that has nothing to do with schema markup is Featured Snippets, those boxes above the search results that provide concise answers to search queries.

Featured Snippets are intended to get searchers the answers to their queries as quickly as possible. According to Google , providing the best answer to the searcher's query is the only way to win a snippet. However, HubSpot's research revealed a few additional ways to optimize your content for featured snippets .

4. Consider Google Discover.

Google Discover is a relatively new algorithmic listing of content by category specifically for mobile users. It's no secret that Google has been doubling down on the mobile experience; with over 50% of searches coming from mobile , it's no surprise either. The tool allows users to build a library of content by selecting categories of interest (think: gardening, music, or politics).

At HubSpot, we believe topic clustering can increase the likelihood of Google Discover inclusion and are actively monitoring our Google Discover traffic in Google Search Console to determine the validity of that hypothesis. We recommend that you also invest some time in researching this new feature. The payoff is a highly engaged user base that has basically hand-selected the content you've worked hard to create.

The Perfect Trio

Technical SEO, on-page SEO, and off-page SEO work together to unlock the door to organic traffic. While on-page and off-page techniques are often the first to be deployed, technical SEO plays a critical role in getting your site to the top of the search results and your content in front of your ideal audience. Use these technical tactics to round out your SEO strategy and watch the results unfold.