WordPress robots.txt

Publicat: 2019-02-26WordPress robots.txt este foarte important pentru SEO. Pentru a vă asigura că site-ul dvs. este bine clasat în rezultatele motoarelor de căutare, trebuie să faceți cele mai importante pagini convenabile pentru căutarea și indexarea „roboților” („roboților”) din motoarele de căutare. Un fișier robots.txt bine structurat vă va ajuta să direcționați acești roboți către paginile pe care doriți să le indexați.

În acest articol vom dezvălui astfel de întrebări:

- Ce este un fișier robots.txt și de ce este important

- Locație text pentru roboți WordPress

- Cel mai bun text de roboți pentru WordPress

- Cum se creează un fișier robots.txt

- Cum să verificați fișierul robots.txt și să-l trimiteți la consola Căutare Google.

Ce este un fișier robots.txt pentru WordPress și de ce este important?

Când creați un site web nou, motoarele de căutare își vor trimite roboții să scaneze și să creeze o hartă a tuturor paginilor sale. În acest fel, ei vor ști ce pagini să afișeze ca rezultat atunci când cineva caută cuvinte cheie relevante. La un nivel de bază, acest lucru este destul de simplu (de asemenea, verificați această postare utilă – fișierul WordPress implicit .htaccess).

Problema este că site-urile web moderne conțin multe alte elemente în afară de pagini. WordPress vă permite să instalați, de exemplu, pluginuri care au adesea propriile directoare. Nu este nevoie să afișați acest lucru în rezultatele căutării, deoarece nu se potrivesc cu conținutul.

Ceea ce face fișierul robots.txt este să ofere un set de linii directoare pentru roboții de căutare. El le spune: „Uitați-vă aici și indexați aceste pagini, dar nu intrați în alte zone!”. Acest fișier poate fi cât de detaliat doriți și este foarte ușor de creat, chiar dacă sunteți începător.

În practică, motoarele de căutare vă vor scana în continuare site-ul, chiar dacă nu creați un fișier robots.txt. Cu toate acestea, a nu-l crea este un pas foarte irațional. Fără acest fișier, lăsați roboții să indexeze tot conținutul site-ului dvs. și ei decid că trebuie să afișați toate părțile site-ului dvs., chiar și pe acelea pe care doriți să le ascundeți de la accesul public (de asemenea, verificați – Cele mai bune pluginuri WordPress eCommerce ).

Un punct mai important, fără un fișier robots.txt, site-ul dvs. va avea o mulțime de accesări de la roboții site-ului dvs. Acest lucru îi va afecta negativ performanța. Chiar dacă frecvența site-ului dvs. este încă mică, viteza de încărcare a paginii este ceva care ar trebui să fie întotdeauna prioritar și la cel mai înalt nivel. În cele din urmă, există doar câteva lucruri pe care oamenilor nu le plac mai mult decât încărcarea lent a site-urilor web.

Locație text pentru roboți WordPress

Când creați un site web WordPress, un fișier robots.txt este creat automat și localizat în directorul dvs. principal de pe server. De exemplu, dacă site-ul dvs. se află aici – wpdevart.com, îl puteți găsi la wpdevart.com/robots.txt și puteți vedea ceva de genul acesta:

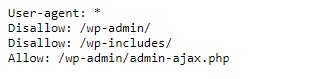

Acesta este un exemplu de cel mai simplu fișier robots.txt. Traducerea într-un limbaj care poate fi citit de om, partea dreaptă după User-agent: declară

pentru care roboți sunt regulile. Un asterisc înseamnă că regula este universală și se aplică tuturor roboților. În acest caz, fișierul le spune roboților că nu pot scana directoarele wp-admin și wp-includes. Sensul acestor reguli este că aceste directoare conțin o mulțime de fișiere care necesită protecție împotriva accesului public (de asemenea, verificați pluginul nostru WordPress Countdown).

Desigur, puteți adăuga mai multe reguli la fișierul dvs. Înainte de a face acest lucru, trebuie să înțelegeți că acesta este un fișier virtual. De obicei, WordPress robots.txt se află în directorul rădăcină, care este adesea numit public_html sau www (sau după numele site-ului dvs.):

De menționat că fișierul robots.txt pentru WordPress, creat implicit, nu vă este accesibil din niciun director. Funcționează, dar dacă doriți să faceți modificări, trebuie să vă creați propriul fișier și să-l încărcați în directorul rădăcină.

Vom analiza mai multe moduri de a crea un fișier robots.txt pentru WordPress. Acum să discutăm cum să stabilim ce reguli să includem în fișier.

Cel mai bun text de roboți pentru WordPress

Nu este atât de dificil să creezi cei mai buni roboți txt pentru site-ul tău WordPress. Deci, ce reguli trebuie incluse în fișierul robots.txt. În secțiunea anterioară, am văzut un exemplu de fișier robots.txt generat de WordPress. Include doar două reguli scurte, dar pentru majoritatea site-urilor sunt suficiente. Să aruncăm o privire la două fișiere robots.txt diferite și să vedem ce face fiecare.

Iată primul nostru exemplu de fișier WordPress robots.txt:

User-agent: * Allow: / # Disallowed Sub-Directories Disallow: / payout / Disallow: / photos / Disallow: / forums /Acest fișier robots.txt este creat pentru forum. Motoarele de căutare indexează de obicei fiecare fir de discuție pe forum. În funcție de subiectul forumului dvs., este posibil să doriți să interziceți indexarea. De exemplu, Google nu va indexa sute de discuții scurte cu utilizatorii. Puteți, de asemenea, să setați reguli care să trimită către un anumit thread de forum pentru a-l exclude și să permiteți motoarele de căutare să indexeze restul.

De asemenea, observați o linie care începe cu Allow: / în partea de sus a fișierului. Această linie le spune roboților că pot scana toate paginile site-ului dvs., cu excepția restricțiilor stabilite mai jos. De asemenea, ați observat că am setat aceste reguli să fie universale (cu un asterisc), așa cum a fost în fișierul virtual WordPress robots.txt (de asemenea, puteți verifica pluginul nostru pentru Tabelul de prețuri WordPress).

Să verificăm un alt exemplu de fișier WordPress robots.txt:

User-agent: * Disallow: / wp-admin / Disallow: / wp-includes / User-agent: Bingbot Disallow: /În acest fișier setăm aceleași reguli care merg implicit la WordPress. Deși adăugăm și un nou set de reguli care împiedică roboții de căutare Bing să acceseze cu crawlere site-ul nostru. Bingbot, după cum puteți vedea, este numele robotului.

Puteți introduce numele altor motoare de căutare pentru a restricționa/permite accesul acestora. În practică, desigur, Bingbot este foarte bun (chiar dacă nu la fel de bun ca Googlebot). Cu toate acestea, există mulți roboți rău intenționați.

Vestea proastă este că nu respectă întotdeauna instrucțiunile din fișierul robots.txt (încă funcționează ca teroriștii). Trebuie avut în vedere faptul că, deși majoritatea roboților vor folosi instrucțiunile furnizate în acest fișier, nu îi puteți forța să facă acest lucru.

Dacă intrați mai adânc în subiect, veți găsi multe sugestii despre ce să permiteți și ce să blocați pe site-ul dvs. WordPress. Deși, din experiența noastră, mai puține reguli sunt adesea mai bune. Iată un exemplu de

best robots txt pentru site-ul WordPress, dar pentru site-uri diferite poate fi diferit:

User-agent: * Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Disallow: *utm*= Disallow: *openstat= Allow: */uploads Sitemap: https://wpdevart.com/sitemap.xmlÎn mod tradițional, WordPress îi place să închidă directoarele wp-admin și wp-includes. Totuși, aceasta nu mai este cea mai bună soluție. În plus, dacă adăugați metaetichete pentru imaginile dvs. în scopul promovării (SEO), nu are rost să le spuneți roboților să nu indexeze conținutul acestor directoare.

Ceea ce ar trebui să conțină fișierul robots.txt va depinde de nevoile site-ului dvs. Așa că nu ezitați să faceți mai multe cercetări!

Cum se creează un fișier robots.txt

Ce ar putea fi mai simplu decât crearea unui fișier text (txt). Tot ce trebuie să faci este să deschizi editorul tău preferat (cum ar fi Notepad sau TextEdit) și să introduci câteva rânduri. Apoi salvați fișierul folosind roboți și extensia txt (robots.txt). Va dura câteva secunde, așa că poate doriți să creați un robots.txt pentru WordPress fără a utiliza un plugin.

Am salvat acest fișier local pe computer. Odată ce ați creat propriul fișier, trebuie să vă conectați la site-ul dvs. prin FTP (poate cu FileZilla).

După conectarea la site-ul dvs., accesați directorul public_html. Acum, tot ce trebuie să faceți este să încărcați fișierul robots.txt de pe computer pe server. Puteți face acest lucru fie făcând clic pe butonul drept al mouse-ului pe fișier în navigatorul local FTP, fie pur și simplu trăgându-l folosind mouse-ul.

Durează doar câteva secunde. După cum puteți vedea, această metodă este mai ușoară decât utilizarea pluginului.

Cum să verificați WordPress robots.txt și să îl trimiteți la Google Search Console

După ce fișierul dvs. WordPress robots.txt a fost creat și încărcat, puteți verifica dacă există erori în Google Search Console. Search Console este un set de instrumente Google concepute pentru a vă ajuta să urmăriți cum apare conținutul dvs. în rezultatele căutării. Unul dintre aceste instrumente verifică robots.txt, îl veți găsi cu ușurință pe pagina de administrare a instrumentelor pentru webmasteri Google (de asemenea, verificați Cele mai bune 50 de pluginuri WordPress 2020).

Acolo veți găsi câmpul editor unde puteți adăuga codul pentru fișierul dvs. WordPress robots.txt și faceți clic pe Trimiteți în colțul din dreapta jos. Consola Căutare Google vă va întreba dacă doriți să utilizați noul cod sau să descărcați un fișier de pe site-ul dvs. web.

Acum platforma vă va verifica fișierul pentru erori. Dacă se găsește o eroare, vi se vor afișa informații despre aceasta. Ați văzut câteva exemple ale fișierului robots.txt WordPress și acum aveți și mai multe șanse să vă creați fișierul robots.txt perfect!