Полное руководство по техническому SEO

Опубликовано: 2023-02-24Перечислите три вещи, которые вы сделали в этом году, относящиеся к поисковой оптимизации (SEO).

Вращается ли эта тактика вокруг исследования ключевых слов, метаописаний и обратных ссылок?

Если да, то вы не одиноки. Когда дело доходит до SEO, маркетологи обычно первыми добавляют в свой арсенал эти методы.

Хотя эти стратегии действительно улучшают видимость вашего сайта в органическом поиске, они не единственные, которые вы должны использовать. Есть еще один набор тактик, которые входят в понятие SEO.

Техническое SEO относится к закулисным элементам, которые обеспечивают двигатель вашего органического роста, таким как архитектура сайта, мобильная оптимизация и скорость страницы. Эти аспекты SEO могут быть не самыми привлекательными, но они невероятно важны.

Первый шаг в улучшении вашего технического SEO — это узнать, где вы находитесь, выполнив аудит сайта. Второй шаг — создать план для устранения областей, в которых вы не дотягиваете. Ниже мы подробно рассмотрим эти шаги.

Совет для профессионалов: создайте веб-сайт, предназначенный для конвертации, используя бесплатные инструменты CMS HubSpot.

Что такое техническое SEO?

Техническое SEO относится ко всему, что вы делаете, чтобы упростить сканирование и индексацию вашего сайта поисковыми системами. Техническое SEO, стратегия контента и стратегии построения ссылок работают в тандеме, чтобы помочь вашим страницам занять высокие позиции в поиске.

Техническое SEO против SEO на странице против SEO вне страницы

Многие люди разбивают поисковую оптимизацию (SEO) на три разных блока: внутреннее SEO, внешнее SEO и техническое SEO. Давайте быстро рассмотрим, что каждый из них означает.

SEO на странице

SEO на странице относится к контенту, который сообщает поисковым системам (и читателям!), О чем ваша страница, включая замещающий текст изображения, использование ключевых слов, метаописания, теги H1, имена URL и внутренние ссылки. У вас есть максимальный контроль над SEO на странице, потому что все находитсянавашем сайте.

Внешнее SEO

Внешняя SEO-оптимизация сообщает поисковым системам, насколько популярна и полезна ваша страница, посредством вотума доверия — в первую очередь обратных ссылок или ссылок с других сайтов на ваш собственный. Количество и качество обратных ссылок повышают PageRank страницы. При прочих равных условиях страница со 100 релевантными ссылками с надежных сайтов будет иметь более высокий рейтинг, чем страница с 50 релевантными ссылками с надежных сайтов (или со 100 нерелевантными ссылками с надежных сайтов).

Техническое SEO

Техническое SEO также находится под вашим контролем, но его немного сложнее освоить, поскольку он менее интуитивно понятен.

Почему важно техническое SEO?

У вас может возникнуть соблазн полностью игнорировать этот компонент SEO; однако он играет важную роль в вашем органическом трафике. Ваш контент может быть самым тщательным, полезным и хорошо написанным, но если поисковая система не сможет его просканировать, очень немногие люди когда-либо его увидят.

Это как дерево, которое падает в лесу, когда его никто не слышит… оно издает звук? Без сильной технической основы SEO ваш контент не будет восприниматься поисковыми системами.

Источник

Источник

Давайте обсудим, как сделать так, чтобы ваш контент звучал в Интернете.

Понимание технического SEO

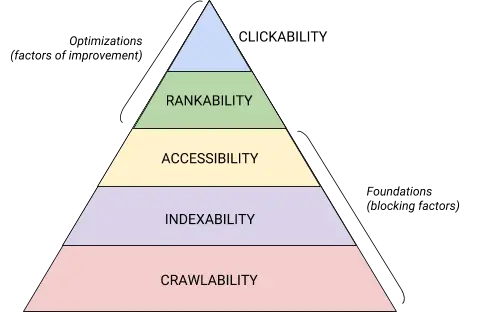

Техническое SEO — это зверь, которого лучше всего разбить на удобоваримые части. Если вы похожи на меня, вам нравится решать большие задачи по частям и с помощью контрольных списков. Хотите верьте, хотите нет, но все, что мы рассмотрели до этого момента, можно отнести к одной из пяти категорий, каждая из которых заслуживает отдельного списка действий.

Эти пять категорий и их место в технической иерархии SEO лучше всего иллюстрирует эта красивая графика, напоминающая иерархию потребностей Маслова, но переработанная для поисковой оптимизации. (Обратите внимание, что мы будем использовать общеупотребительный термин «Визуализация» вместо «Доступность».)

Источник

Источник

Основы технического SEO-аудита

Прежде чем приступить к техническому SEO-аудиту, необходимо уяснить несколько основных моментов.

Аудит предпочтительного домена

Ваш домен — это URL-адрес, который люди вводят для перехода на ваш сайт, например hubspot.com . Домен вашего веб-сайта влияет на то, смогут ли люди найти вас через поиск, и обеспечивает согласованный способ идентификации вашего сайта.

Когда вы выбираете предпочитаемый домен, вы сообщаете поисковым системам, предпочитаете ли вы версию вашего сайта с www или без www для отображения в результатах поиска. Например, вы можете выбратьwww.yourwebsite.comвместоyourwebsite.com. Это сообщает поисковым системам о приоритете версии вашего сайта с www и перенаправляет всех пользователей на этот URL-адрес. В противном случае поисковые системы будут рассматривать эти две версии как отдельные сайты, что приведет к рассредоточению ценности SEO.

Ранее Google просил вас указать предпочитаемую вами версию URL-адреса. Теперь Google определит и выберет версию для вас. Однако, если вы предпочитаете установить предпочтительную версию своего домена, вы можете сделать это с помощью канонических тегов (которые мы вскоре рассмотрим). В любом случае, как только вы установите свой предпочтительный домен, убедитесь, что все варианты, то естьwww, не-www, http и index.html, постоянно перенаправляют на эту версию.

Внедрить SSL

Возможно, вы слышали этот термин раньше — потому что он очень важен. SSL или Secure Sockets Layer создает уровень защиты между веб-сервером (программным обеспечением, ответственным за выполнение онлайн-запроса) и браузером, тем самым делая ваш сайт безопасным. Когда пользователь отправляет информацию на ваш веб-сайт, например платежную или контактную информацию, эта информация с меньшей вероятностью будет взломана, поскольку у вас есть SSL для ее защиты.

SSL-сертификат обозначается доменом, начинающимся с «https://», а не с «http://», и символом замка в строке URL.

Поисковые системы отдают предпочтение безопасным сайтам — фактически, Google объявил еще в 2014 году, что SSL будет считаться фактором ранжирования . По этой причине обязательно установите вариант SSL вашей домашней страницы в качестве предпочтительного домена.

После настройки SSL вам потребуется перенести все страницы, не поддерживающие SSL, с http на https. Это трудная задача, но стоит усилий во имя улучшения рейтинга. Вот шаги, которые вам необходимо предпринять:

- Перенаправьте все страницы http://yourwebsite.com на https://yourwebsite.com .

- Обновите все теги canonical и hreflang соответствующим образом.

- Обновите URL-адреса на карте сайта (находится по адресу yourwebsite.com/sitemap.xml ) и в файле robot.txt (находится по адресу yourwebsite.com/robots.txt ).

- Настройте новый экземпляр Google Search Console и Bing Webmaster Tools для своего https-сайта и отслеживайте его, чтобы убедиться, что 100% трафика переносится.

Оптимизировать скорость страницы

Знаете ли вы, как долго посетитель сайта будет ждать загрузки вашего сайта? Шесть секунд … и это великодушие. Некоторые данные показывают , что показатель отказов увеличивается на 90% при увеличении времени загрузки страницы с одной до пяти секунд. Вы не можете терять ни секунды, поэтому улучшение времени загрузки вашего сайта должно быть приоритетом.

Скорость сайта важна не только для взаимодействия с пользователем и конверсии — она также является фактором ранжирования .

Используйте эти советы, чтобы улучшить среднее время загрузки страницы:

- Сжать все ваши файлы. Сжатие уменьшает размер ваших изображений , а также файлов CSS, HTML и JavaScript, поэтому они занимают меньше места и загружаются быстрее.

- Аудит перенаправляет регулярно. Обработка перенаправления 301 занимает несколько секунд. Умножьте это на несколько страниц или уровней переадресации, и вы серьезно повлияете на скорость вашего сайта.

- Сократите свой код. Грязный код может негативно сказаться на скорости вашего сайта. Грязный код означает ленивый код. Это как писать — может быть, в первом черновике вы изложите свою точку зрения в 6 предложениях. Во втором черновике вы делаете это за 3. Чем эффективнее код, тем быстрее будет загружаться страница (в целом). После того, как вы наведете порядок, вы уменьшите и сожмете свой код .

- Рассмотрим сеть распространения контента (CDN). CDN — это распределенные веб-серверы, которые хранят копии вашего веб-сайта в различных географических точках и доставляют ваш сайт в зависимости от местоположения искателя. Поскольку информация между серверами проходит меньшее расстояние, ваш сайт загружается быстрее для запрашивающей стороны.

- Старайтесь не идти плагин счастливым. Устаревшие плагины часто имеют уязвимости в системе безопасности, которые делают ваш сайт уязвимым для злоумышленников, которые могут повредить рейтингу вашего сайта. Убедитесь, что вы всегда используете последние версии плагинов, и минимизируйте использование до самого необходимого. В том же духе рассмотрите возможность использования пользовательских тем, поскольку готовые темы веб-сайтов часто содержат много ненужного кода.

- Воспользуйтесь преимуществами плагинов кеша. Плагины кэширования сохраняют статическую версию вашего сайта для отправки вернувшимся пользователям, тем самым сокращая время загрузки сайта во время повторных посещений.

- Используйте асинхронную (асинхронную) загрузку. Скрипты — это инструкции, которые серверы должны прочесть, прежде чем они смогут обработать HTML или тело вашей веб-страницы, то есть то, что посетители хотят видеть на вашем сайте. Как правило, скрипты размещаются в <head> веб-сайта (например, ваш скрипт Диспетчера тегов Google), где они имеют приоритет над содержимым остальной части страницы. Использование асинхронного кода означает, что сервер может одновременно обрабатывать HTML и скрипт, тем самым уменьшая задержку и увеличивая время загрузки страницы.

Вот как выглядит асинхронный скрипт: < script async src = " script.js "> </script>

Если вы хотите увидеть, где ваш сайт отстает по скорости, вы можете использовать этот ресурс от Google .

Когда у вас есть технические основы SEO, вы готовы перейти к следующему этапу — сканируемости.

Контрольный список обходимости

Сканируемость — это основа вашей технической SEO-стратегии. Поисковые роботы будут сканировать ваши страницы, чтобы собрать информацию о вашем сайте.

Если этим ботам каким-то образом запретить сканирование, они не смогут индексировать или ранжировать ваши страницы. Первый шаг к внедрению технического SEO — убедиться, что все ваши важные страницы доступны и просты в навигации.

Ниже мы рассмотрим некоторые элементы, которые следует добавить в контрольный список, а также некоторые элементы веб-сайта, которые необходимо проверить, чтобы убедиться, что ваши страницы подходят для сканирования.

Контрольный список обходимости

- Создайте XML-карту сайта.

- Максимизируйте краулинговый бюджет.

- Оптимизируйте архитектуру вашего сайта.

- Установите структуру URL.

- Используйте файл robots.txt.

- Добавьте меню хлебных крошек.

- Используйте пагинацию.

- Проверьте файлы журнала SEO.

1. Создайте XML-карту сайта.

Помните ту структуру сайта, которую мы рассмотрели? Это относится к так называемой XML-карте сайта , которая помогает поисковым роботам понимать и сканировать ваши веб-страницы. Вы можете думать об этом как о карте для вашего сайта. Вы отправите свою карту сайта в консоль поиска Google и инструменты Bing для веб-мастеров , как только она будет завершена. Не забывайте обновлять карту сайта при добавлении и удалении веб-страниц.

2. Максимизируйте краулинговый бюджет.

Ваш краулинговый бюджет относится к страницам и ресурсам на вашем сайте, которые поисковые роботы будут сканировать .

Поскольку краулинговый бюджет не бесконечен, убедитесь, что вы отдаете приоритет сканированию самых важных страниц.

Вот несколько советов, которые помогут максимально эффективно использовать краулинговый бюджет:

- Удалите или канонизируйте дубликаты страниц.

- Исправьте или перенаправьте неработающие ссылки.

- Убедитесь, что ваши файлы CSS и Javascript доступны для сканирования.

- Регулярно проверяйте статистику сканирования и следите за внезапными падениями или увеличениями.

- Убедитесь, что любой бот или страница, сканирование которых вы запретили, должны быть заблокированы.

- Обновляйте карту сайта и отправляйте ее в соответствующие инструменты для веб-мастеров.

- Очистите свой сайт от ненужного или устаревшего контента.

- Остерегайтесь динамически генерируемых URL-адресов, которые могут резко увеличить количество страниц на вашем сайте.

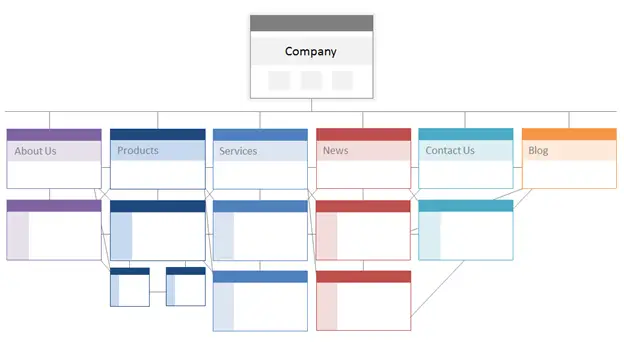

3. Оптимизируйте архитектуру вашего сайта.

Ваш сайт имеет несколько страниц. Эти страницы должны быть организованы таким образом, чтобы поисковые системы могли легко их находить и сканировать. Вот тут-то и появляется структура вашего сайта, которую часто называют информационной архитектурой вашего сайта.

Точно так же, как здание основано на архитектурном дизайне, архитектура вашего сайта — это то, как вы организуете страницы на своем сайте.

Связанные страницы сгруппированы вместе; например, главная страница вашего блога ссылается на отдельные записи в блоге, каждая из которых ссылается на страницы соответствующих авторов. Эта структура помогает поисковым роботам понять взаимосвязь между вашими страницами.

Архитектура вашего сайта также должна определяться важностью отдельных страниц. Чем ближе Страница А к вашей домашней странице, чем больше страниц ссылается на Страницу А, и чем больше ссылочный вес уэтихстраниц, тем большее значение поисковые системы будут придавать Странице А.

Например, ссылка с вашей домашней страницы на страницу А демонстрирует большую значимость, чем ссылка из сообщения в блоге. Чем больше ссылок на страницу А, тем более «значимой» становится эта страница для поисковых систем.

Концептуально архитектура сайта может выглядеть примерно так, где страницы«О сайте», «Продукт», «Новости»и т. д. расположены в верхней части иерархии важности страниц.

Источник

Убедитесь, что наиболее важные для вашего бизнеса страницы находятся на вершине иерархии с наибольшим количеством (релевантных!) внутренних ссылок.

4. Установите структуру URL.

Структура URL-адресов относится к тому, как вы структурируете свои URL-адреса, чтоможетопределяться архитектурой вашего сайта. Я объясню связь через мгновение. Во-первых, давайте уточним, что URL-адреса могут иметь подкаталоги, такие какblog.hubspot.com, и/или подпапки, такие какhubspot.com/blog, которые указывают, куда ведет URL-адрес.

Например, сообщение в блоге под названием«Как ухаживать за собакой»будет находиться в поддомене или подкаталоге блога. URL-адрес может быть www.bestdogcare.com/blog/how-to-groom-your-dog . В то время как страница продукта на том же сайте будетwww.bestdogcare.com/products/grooming-brush.

Используете ли вы поддомены или подкаталоги или «продукты» или «магазин» в своем URL-адресе, полностью зависит от вас. Прелесть создания собственного веб-сайта в том, что вы можете создавать правила. Важно то, что эти правила имеют единую структуру, а это означает, что вы не должны переключаться между blog.yourwebsite.com и yourwebsite.com/blogs на разных страницах. Создайте дорожную карту, примените ее к структуре именования URL-адресов и придерживайтесь ее.

Вот еще несколько советов о том, как писать URL-адреса:

- Используйте символы нижнего регистра.

- Используйте тире для разделения слов.

- Сделайте их краткими и описательными.

- Избегайте использования ненужных символов или слов (включая предлоги).

- Включите целевые ключевые слова.

После того, как вы настроите структуру URL-адресов, вы отправите поисковым системам список URL-адресов важных страниц в виде карты сайта в формате XML . Это дает поисковым роботам дополнительный контекст о вашем сайте, поэтому им не нужно выяснять его во время сканирования.

5. Используйте robots.txt.

Когда веб-робот сканирует ваш сайт, он сначала проверяет файл /robot.txt, также известный как протокол исключения роботов. Этот протокол может разрешать или запрещать определенным веб-роботам сканировать ваш сайт, включая определенные разделы или даже страницы вашего сайта. Если вы хотите запретить ботам индексировать ваш сайт, используйте метатег noindex robots. Давайте обсудим оба этих сценария.

Вы можете полностью запретить некоторым ботам сканировать ваш сайт. К сожалению, есть боты со злым умыслом — боты, которые будут очищать ваш контент или спамить на форумах вашего сообщества. Если вы заметите такое плохое поведение, вы воспользуетесь файлом robot.txt, чтобы предотвратить их вход на ваш сайт. В этом сценарии вы можете думать о robot.txt как о своем силовом поле от плохих ботов в Интернете.

Что касается индексации, поисковые роботы сканируют ваш сайт, чтобы собрать подсказки и найти ключевые слова, чтобы они могли сопоставить ваши веб-страницы с соответствующими поисковыми запросами. Но, как мы обсудим позже, у вас есть краулинговый бюджет, который вы не хотите тратить на ненужные данные. Таким образом, вы можете исключить страницы, которые не помогают поисковым роботам понять, о чем ваш сайт, например, страницублагодарностииз предложения или страницу входа.

В любом случае, ваш протокол robot.txt будет уникальным в зависимости от того, чего вы хотите достичь.

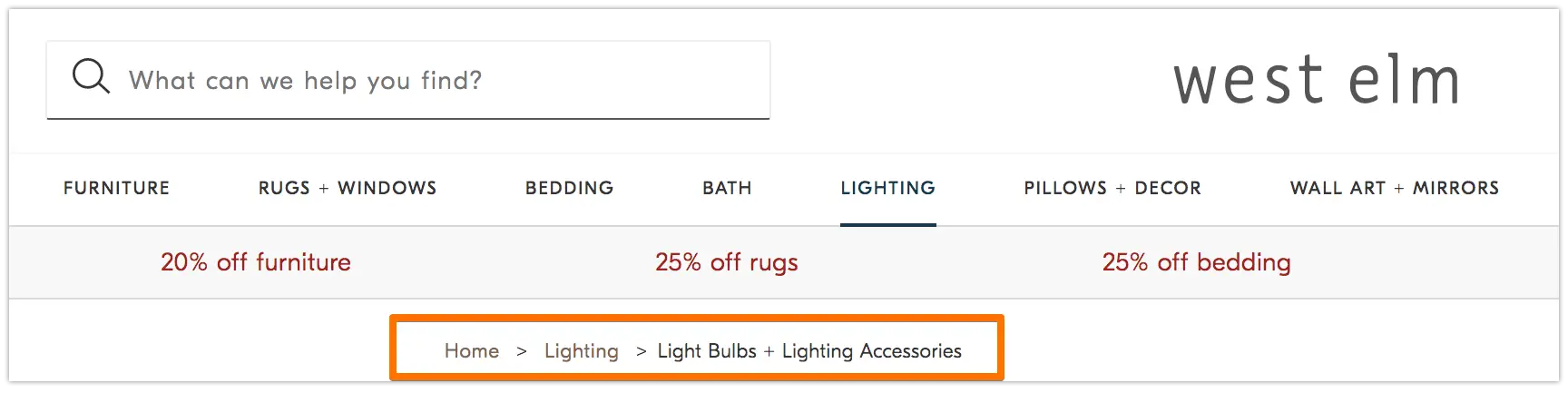

6. Добавьте навигационные меню.

Помните старую басню«Гензель и Гретель», где двое детей бросали хлебные крошки на землю, чтобы найти дорогу домой? Что ж, они что-то задумали.

Хлебные крошки — это именно то, на что они похожи — это путь, который возвращает пользователей к началу их путешествия по вашему сайту. Это меню страниц, которое сообщает пользователям, как их текущая страница связана с остальной частью сайта.

И они предназначены не только для посетителей сайта; поисковые роботы тоже их используют.

Источник

Хлебные крошки должны быть двумя вещами: 1) видимыми для пользователей, чтобы они могли легко перемещаться по вашим веб-страницам, не используя кнопку«Назад», и 2) иметь структурированный язык разметки, чтобы предоставлять точный контекст поисковым роботам, сканирующим ваш сайт.

Не знаете, как добавить структурированные данные в хлебные крошки? Используйте это руководство для BreadcrumbList .

7. Используйте пагинацию.

Помните, когда учителя требовали от вас нумеровать страницы в исследовательской работе? Это называется пагинация. В мире технического SEO нумерация страниц играет немного другую роль, но вы все равно можете думать о ней как о форме организации.

Разбивка на страницы использует код, чтобы сообщить поисковым системам, когда страницы с разными URL-адресами связаны друг с другом. Например, у вас может быть серия контента, которую вы разбиваете на главы или несколько веб-страниц. Если вы хотите, чтобы поисковые роботы могли легко обнаруживать и сканировать эти страницы, используйте нумерацию страниц.

Принцип работы довольно прост. Вы перейдете к<head>первой страницы серии и используете

rel="next", чтобы сообщить поисковому роботу, какую страницу сканировать второй. Затем на второй странице вы будете использоватьrel="prev"для указания предыдущей страницы иrel="next"для указания следующей страницы и так далее.

Похоже на это…

На первой странице:

<link rel="следующий" href="https://www.website.com/page-two" />

На второй странице:

<link rel="prev" href="https://www.website.com/page-one" />

<link rel="следующий" href="https://www.website.com/page-three" />

Обратите внимание, что разбиение на страницы полезно для обнаружения сканирования, но Google больше не поддерживает пакетное индексирование страниц, как это было раньше.

8. Проверьте файлы журнала SEO.

Вы можете думать о файлах журнала как о записи в журнале. Веб-серверы (журнализатор) записывают и хранят данные журнала о каждом действии, которое они предпринимают на вашем сайте, в файлах журнала (журнал). Записанные данные включают время и дату запроса, запрошенный контент и запрашиваемый IP-адрес. Вы также можете идентифицировать пользовательский агент, который представляет собой уникально идентифицируемое программное обеспечение (например, поисковый бот), которое выполняет запрос пользователя.

Но какое это имеет отношение к SEO?

Что ж, поисковые боты оставляют след в виде лог-файлов, когда сканируют ваш сайт. Вы можете определить, сканировалось ли, когда и что именно, проверив файлы журналов и отфильтровав их с помощью пользовательского агента и поисковой системы .

Эта информация полезна для вас, потому что вы можете определить, как расходуется ваш краулинговый бюджет и какие барьеры для индексации или доступа возникают у бота. Чтобы получить доступ к вашим лог-файлам, вы можете обратиться к разработчику или использовать анализатор лог-файлов, например Screaming Frog .

Тот факт, что поисковый бот может сканировать ваш сайт, не обязательно означает, что он может проиндексировать все ваши страницы. Давайте взглянем на следующий уровень вашего технического SEO-аудита — индексируемость .

Контрольныйсписокиндексируемости

Когда поисковые роботы сканируют ваш веб-сайт, они начинают индексировать страницы в зависимости от их темы и релевантности этой теме. После индексации ваша страница имеет право на ранжирование в поисковой выдаче. Вот несколько факторов, которые могут помочь проиндексировать ваши страницы.

Контрольный список индексируемости

- Разблокируйте поисковым ботам доступ к страницам.

- Удалите дублированный контент.

- Аудит ваших редиректов.

- Проверьте адаптацию вашего сайта к мобильным устройствам.

- Исправьте ошибки HTTP.

1. Разблокировать поисковым ботам доступ к страницам.

Вы, вероятно, позаботитесь об этом шаге при решении проблемы сканирования, но здесь стоит упомянуть об этом. Вы хотите убедиться, что боты отправляются на предпочитаемые вами страницы и имеют свободный доступ к ним. У вас есть несколько инструментов для этого. Тестер Google robots.txt предоставит вам список запрещенных страниц, и вы сможете использовать инструмент проверки Google Search Console, чтобы определить причину блокировки страниц.

2. Удалите повторяющийся контент.

Дублированный контент сбивает с толку поисковых роботов и негативно влияет на вашу индексируемость. Не забудьте использовать канонические URL-адреса, чтобы установить предпочтительные страницы.

3. Аудит ваших перенаправлений.

Убедитесь, что все ваши перенаправления настроены правильно. Циклы перенаправления, неработающие URL-адреса или, что еще хуже, неправильные перенаправления могут вызвать проблемы при индексации вашего сайта. Чтобы избежать этого, регулярно проверяйте все ваши редиректы.

4. Проверьте адаптацию вашего сайта к мобильным устройствам.

Если ваш веб-сайт еще не оптимизирован для мобильных устройств, значит, вы далеко отстаете от того, что вам нужно. Еще в 2016 году Google начал индексировать в первую очередь мобильные сайты , отдавая предпочтение мобильному интерфейсу, а не десктопу. Сегодня эта индексация включена по умолчанию. Чтобы не отставать от этой важной тенденции, вы можете использовать тест Google для мобильных устройств , чтобы проверить, что нужно улучшить на вашем веб-сайте.

5. Исправьте ошибки HTTP.

HTTP означает протокол передачи гипертекста, но вам, вероятно, все равно. Что вас действительно волнует, так это то, когда HTTP возвращает ошибки вашим пользователям или поисковым системам, и как их исправить.

Ошибки HTTP могут препятствовать работе поисковых ботов, блокируя им доступ к важному контенту на вашем сайте. Поэтому очень важно быстро и тщательно устранять эти ошибки.

Поскольку каждая ошибка HTTP уникальна и требует определенного решения, в разделе ниже есть краткое объяснение каждой из них, и вы будете использовать предоставленные ссылки, чтобы узнать больше о них или о том, как их устранить.

- 301 Постоянная переадресация используется для постоянной пересылки трафика с одного URL на другой. Ваша CMS позволит вам настроить эти перенаправления, но слишком большое их количество может замедлить работу вашего сайта и ухудшить взаимодействие с пользователем, поскольку каждое дополнительное перенаправление увеличивает время загрузки страницы. Стремитесь к нулевым цепочкам перенаправления, если это возможно, так как слишком большое количество приведет к тому, что поисковые системы перестанут сканировать эту страницу.

- 302 Temporary Redirect — это способ временно перенаправить трафик с URL-адреса на другую веб-страницу. Хотя этот код состояния будет автоматически отправлять пользователей на новую веб-страницу, кэшированный тег заголовка, URL-адрес и описание останутся в соответствии с исходным URL-адресом. Однако, если временное перенаправление остается на месте достаточно долго, оно в конечном итоге будет рассматриваться как постоянное перенаправление, и эти элементы перейдут на целевой URL-адрес.

- 403 Запрещенные сообщения означают, что запрошенный пользователем контент ограничен на основании разрешений на доступ или из-за неправильной настройки сервера.

- Страницы ошибок 404 сообщают пользователям, что запрошенная ими страница не существует либо потому, что она была удалена, либо потому, что они ввели неверный URL-адрес. Всегда полезно создавать страницы 404, которые являются фирменными и привлекательными, чтобы удерживать посетителей на вашем сайте (нажмите на ссылку выше, чтобы увидеть несколько хороших примеров).

- 405 Method Not Allowed означает, что сервер вашего веб-сайта распознал и по-прежнему заблокировал метод доступа, что привело к появлению сообщения об ошибке.

- 500 Internal Server Error — это общее сообщение об ошибке, которое означает, что ваш веб-сервер испытывает проблемы с доставкой вашего сайта запрашивающей стороне.

- Ошибка 502 Bad Gateway связана с недопониманием или неверным ответом между серверами веб-сайта.

- 503 Сервис недоступен сообщает вам, что, хотя ваш сервер работает нормально, он не может выполнить запрос.

- 504 Gateway Timeout означает, что сервер не получил своевременный ответ от вашего веб-сервера для доступа к запрошенной информации.

Какой бы ни была причина этих ошибок, важно устранить их, чтобы и пользователи, и поисковые системы были довольны, и чтобы и те, и другие возвращались на ваш сайт.

Даже если ваш сайт был просканирован и проиндексирован, проблемы с доступностью, которые блокируют пользователей и ботов, повлияют на вашу поисковую оптимизацию. Тем не менее, нам нужно перейти к следующему этапу вашего технического SEO-аудита — рендерингу.

Контрольный список визуализации

Прежде чем мы углубимся в эту тему, важно отметить разницу между доступностью для SEO и веб-доступностью . Последнее вращается вокруг того, чтобы упростить навигацию по вашим веб-страницам для пользователей с ограниченными возможностями или нарушениями, такими как, например, слепота или дислексия. Многие элементы онлайн-доступности совпадают с лучшими практиками SEO. Однако SEO-аудит доступности не учитывает всего, что вам нужно сделать, чтобы сделать ваш сайт более доступным для посетителей с ограниченными возможностями.

В этом разделе мы сосредоточимся на доступности SEO или рендеринге, но не забывайте о веб-доступности, когда вы разрабатываете и поддерживаете свой сайт.

Контрольный список визуализации

Доступный сайт основан на простоте рендеринга. Ниже приведены элементы веб-сайта, которые необходимо проверить для аудита возможности рендеринга.

Производительность сервера

Как вы узнали выше, тайм-ауты и ошибки сервера вызывают ошибки HTTP, которые мешают пользователям и ботам получить доступ к вашему сайту. Если вы заметили, что на вашем сервере возникают проблемы, используйте ресурсы, указанные выше, для устранения неполадок и их устранения. Невыполнение этого требования своевременно может привести к тому, что поисковые системы удалят вашу веб-страницу из своего индекса, поскольку показывать пользователю неработающую страницу — плохой опыт.

HTTP-статус

Как и в случае с производительностью сервера, ошибки HTTP препятствуют доступу к вашим веб-страницам. Вы можете использовать веб-краулер, такой как Screaming Frog , Botify или DeepCrawl , чтобы выполнить всесторонний аудит вашего сайта на наличие ошибок.

Время загрузки и размер страницы

Если ваша страница загружается слишком долго, показатель отказов — не единственная проблема, о которой вам следует беспокоиться. Задержка загрузки страницы может привести к ошибке сервера, которая заблокирует доступ ботов к вашим веб-страницам или заставит их сканировать частично загруженные версии, в которых отсутствуют важные разделы контента. В зависимости от того, насколько велик спрос на сканирование для данного ресурса, боты будут тратить эквивалентное количество ресурсов, чтобы попытаться загрузить, отобразить и проиндексировать страницы. Однако вы должны сделать все, что в ваших силах, чтобы сократить время загрузки страницы.

Рендеринг JavaScript

Google, по общему признанию, испытывает трудности с обработкой JavaScript (JS) и поэтому рекомендует использовать предварительно обработанный контент для улучшения доступности. У Google также есть множество ресурсов , которые помогут вам понять, как поисковые боты получают доступ к JS на вашем сайте, и как решить проблемы, связанные с поиском.

Страницы-сироты

Каждая страница вашего сайта должна быть связанакак минимумс одной другой страницей, а лучше с несколькими, в зависимости от того, насколько важна эта страница. Когда на странице нет внутренних ссылок, она называется страницей-сиротой. Как и в статье без введения, на этих страницах отсутствует контекст, необходимый ботам для понимания того, как их следует индексировать.

Глубина страницы

Глубина страницы относится к тому, на сколько слоев ниже находится страница в структуре вашего сайта, т. е. на сколько кликов она удалена от вашей домашней страницы. Лучше всего, чтобы архитектура вашего сайта была как можно более мелкой, сохраняя при этом интуитивно понятную иерархию. Иногда многоуровневый сайт неизбежен; в этом случае вы захотите отдать предпочтение хорошо организованному сайту, а не поверхностности.

Независимо от того, сколько слоев в структуре вашего сайта, держите важные страницы — например, страницы вашего продукта и контактов — не более чем в три клика. Структура, которая прячет страницу вашего продукта так глубоко на вашем сайте, что пользователям и ботам приходится играть в детективов, чтобы обнаружить, что они менее доступны и обеспечивают плохой опыт.

Например, такой URL-адрес веб-сайта, который направляет вашу целевую аудиторию на страницу вашего продукта, является примером плохо спланированной структуры сайта: www.yourwebsite.com/products-features/features-by-industry/airlines-case-studies/airlines. -продукты.

Цепочки перенаправления

Когда вы решаете перенаправить трафик с одной страницы на другую, вы платите цену. Эта цена — эффективность сканирования. Перенаправления могут замедлить сканирование, сократить время загрузки страницы и сделать ваш сайт недоступным, если эти перенаправления не настроены должным образом. По всем этим причинам постарайтесь свести редиректы к минимуму.

После того, как вы решили проблемы доступности, вы можете перейти к тому, как ваши страницы ранжируются в поисковой выдаче.

Контрольный список ранжирования

Теперь мы переходим к более актуальным элементам, о которых вы, вероятно, уже знаете — как улучшить ранжирование с технической точки зрения SEO. Чтобы ранжировать ваши страницы, нужно использовать некоторые элементы на странице и за ее пределами, о которых мы упоминали ранее, но с технической точки зрения.

Помните, что все эти элементы работают вместе, чтобы создать SEO-дружественный сайт. Таким образом, было бы упущением не учитывать все сопутствующие факторы. Давайте углубимся в это.

Внутренние и внешние ссылки

Ссылки помогают поисковым роботам понять, какое место страница занимает в общей схеме запроса, и дают контекст для ранжирования этой страницы. Ссылки направляют поисковых роботов (и пользователей) к соответствующему контенту и передают важность страницы. В целом, связывание улучшает сканирование, индексацию и вашу способность ранжироваться.

Качество обратной ссылки

Обратные ссылки — ссылки с других сайтов на ваш собственный — обеспечивают доверие к вашему сайту. Они сообщают поисковым роботам, что внешний веб-сайт А считает вашу страницу качественной и заслуживающей сканирования. По мере того, как эти голоса складываются, поисковые роботы замечают ваш сайт и считают его более надежным. Звучит как отличная сделка, верно? Однако, как и в большинстве замечательных вещей, здесь есть одна оговорка. Качество этих обратных ссылок имеет большое значение.

Ссылки с некачественных сайтов могут навредить вашему рейтингу. Есть много способов получить качественные обратные ссылки на ваш сайт, например, обратиться к соответствующим публикациям, запросить упоминания без ссылок, предоставить релевантные публикации, запросить упоминания без ссылок и предоставить полезный контент, на который другие сайты хотят ссылаться.

Кластеры контента

Мы в HubSpot не стесняемся своей любви к кластерам контента и тому, как они способствуют органическому росту . Кластеры контента связывают связанный контент, поэтому поисковые роботы могут легко находить, сканировать и индексировать все принадлежащие вам страницы по определенной теме. Они действуют как инструмент саморекламы, чтобы показать поисковым системам, как много вы знаете о теме, поэтому они с большей вероятностью оценят ваш сайт как авторитетный для любого связанного поискового запроса.

Ваша ранжируемость является основным фактором, определяющим рост органического трафика, поскольку исследования показывают, что пользователи с большей вероятностью нажимают на три верхних результата поиска в поисковой выдаче. Но как вы гарантируете, что именновашрезультат будет кликнут?

Давайте завершим это последней частью пирамиды органического трафика: кликабельностью.

Контрольный список кликабельности

Хотя показатель кликабельности (CTR) во многом связан с поведением поисковика, есть вещи, которыевыможете сделать, чтобы улучшить кликабельность в поисковой выдаче. Хотя метаописания и заголовки страниц с ключевыми словами влияют на CTR, мы сосредоточимся на технических элементах, потому что именно поэтому вы здесь.

Контрольный список кликабельности

- Используйте структурированные данные.

- Выиграйте функции SERP.

- Оптимизация для избранных фрагментов.

- Рассмотрим Google Дискавери.

Ранжирование и рейтинг кликов идут рука об руку, потому что, будем честными, поисковики хотят немедленных ответов. Чем больше ваш результат выделяется в поисковой выдаче, тем больше вероятность того, что вы получите клик. Давайте рассмотрим несколько способов улучшить вашу кликабельность.

1. Используйте структурированные данные.

Структурированные данные используют специальный словарь, называемый схемой, для классификации и маркировки элементов на вашей веб-странице для поисковых роботов. Схема делает кристально ясным, что представляет собой каждый элемент, как он относится к вашему сайту и как его интерпретировать. По сути, структурированные данные говорят ботам: «Это видео», «Это продукт» или «Это рецепт», не оставляя места для интерпретации .

To be clear, using structured data is not a “clickability factor” (if there even is such a thing), but it does help organize your content in a way that makes it easy for search bots to understand, index, and potentially rank your pages.

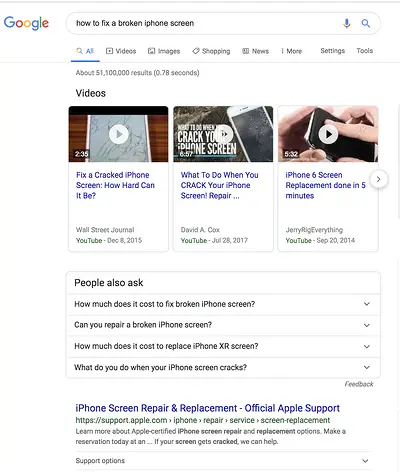

2. Win SERP features.

SERP features , otherwise known as rich results, are a double-edged sword. If you win themandget the click-through, you're golden. If not, your organic results are pushed down the page beneath sponsored ads, text answer boxes, video carousels, and the like.

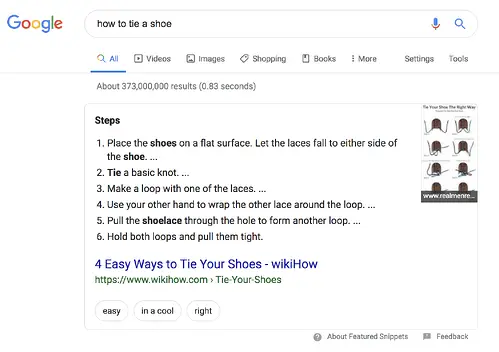

Rich results are those elements that don't follow the page title, URL, meta description format of other search results. For example, the image below shows two SERP features — a video carousel and “People Also Ask” box — above the first organic result.

While you can still get clicks from appearing in the top organic results, your chances are greatly improved with rich results.

How do you increase your chances of earning rich results? Write useful content and use structured data. The easier it is for search bots to understand the elements of your site, the better your chances of getting a rich result.

Structured data is useful for getting these ( and other search gallery elements ) from your site to the top of the SERPs, thereby, increasing the probability of a click-through:

- Articles

- Videos

- Отзывы

- Events

- How-Tos

- FAQs (“People Also Ask” boxes)

- Images

- Local Business Listings

- Products

- Sitelinks

3. Optimize for Featured Snippets.

One unicorn SERP feature that has nothing to do with schema markup is Featured Snippets, those boxes above the search results that provide concise answers to search queries.

Featured Snippets are intended to get searchers the answers to their queries as quickly as possible. According to Google , providing the best answer to the searcher's query is the only way to win a snippet. However, HubSpot's research revealed a few additional ways to optimize your content for featured snippets .

4. Consider Google Discover.

Google Discover is a relatively new algorithmic listing of content by category specifically for mobile users. It's no secret that Google has been doubling down on the mobile experience; with over 50% of searches coming from mobile , it's no surprise either. The tool allows users to build a library of content by selecting categories of interest (think: gardening, music, or politics).

At HubSpot, we believe topic clustering can increase the likelihood of Google Discover inclusion and are actively monitoring our Google Discover traffic in Google Search Console to determine the validity of that hypothesis. We recommend that you also invest some time in researching this new feature. The payoff is a highly engaged user base that has basically hand-selected the content you've worked hard to create.

The Perfect Trio

Technical SEO, on-page SEO, and off-page SEO work together to unlock the door to organic traffic. While on-page and off-page techniques are often the first to be deployed, technical SEO plays a critical role in getting your site to the top of the search results and your content in front of your ideal audience. Use these technical tactics to round out your SEO strategy and watch the results unfold.