WordPress robots.txt

Опубликовано: 2019-02-26WordPress robots.txt очень важен для SEO. Чтобы быть уверенным, что ваш сайт хорошо ранжируется в результатах поисковых систем, вам необходимо сделать наиболее важные его страницы удобными для поиска и индексации «роботами» («ботами») поисковых систем. Хорошо структурированный файл robots.txt поможет направить этих ботов на страницы, которые вы хотите проиндексировать.

В этой статье мы раскроем такие вопросы:

- Что такое файл robots.txt и почему он важен

- Местоположение txt роботов WordPress

- Лучшие роботы txt для WordPress

- Как создать файл robots.txt

- Как проверить файл robots.txt и отправить его в консоль поиска Google.

Что такое файл robots.txt для WordPress и почему он важен?

Когда вы создаете новый веб-сайт, поисковые системы отправляют своих роботов для сканирования и создания карты всех его страниц. Таким образом, они будут знать, какие страницы показывать в результате поиска по релевантным ключевым словам. На базовом уровне это довольно просто (также посмотрите этот полезный пост — файл WordPress по умолчанию .htaccess).

Проблема в том, что современные веб-сайты помимо страниц содержат множество других элементов. WordPress позволяет вам устанавливать, например, плагины, которые часто имеют свои собственные каталоги. Нет необходимости показывать это в результатах поиска, так как они не соответствуют содержанию.

Файл robots.txt предоставляет набор рекомендаций для поисковых роботов. Он им говорит: «Смотрите сюда и проиндексируйте эти страницы, но не заходите в другие разделы!». Этот файл может быть настолько подробным, насколько вы хотите, и его очень легко создать, даже если вы новичок.

На практике поисковые системы все равно будут сканировать ваш сайт, даже если вы не создадите файл robots.txt. Однако не создавать его — очень нерациональный шаг. Без этого файла вы оставляете роботам индексировать все содержимое вашего сайта, и они решают, что вам нужно показать все части вашего сайта, даже те, которые вы хотели бы скрыть от общего доступа (также проверьте — Лучшие плагины для электронной коммерции WordPress ).

Более важный момент, без файла robots.txt ваш сайт будет иметь много обращений от роботов вашего сайта. Это негативно скажется на его работе. Даже если посещаемость вашего сайта пока невелика, скорость загрузки страниц — это то, что всегда должно быть в приоритете и на самом высоком уровне. В конце концов, есть всего несколько вещей, которые людям не нравятся больше, чем медленная загрузка веб-сайтов.

Местоположение txt роботов WordPress

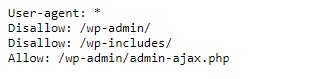

Когда вы создаете веб-сайт WordPress, автоматически создается файл robots.txt, который размещается в вашем основном каталоге на сервере. Например, если ваш сайт находится здесь — wpdevart.com, вы можете найти его по адресу wpdevart.com/robots.txt и увидеть что-то вроде этого:

Это пример простейшего файла robots.txt. Переводя на понятный человеку язык, правая часть после User-agent: объявляет

для каких роботов правила. Звездочка означает, что правило универсально и распространяется на всех роботов. В этом случае файл сообщает роботам, что они не могут сканировать каталоги wp-admin и wp-includes. Смысл этих правил в том, что эти каталоги содержат множество файлов, требующих защиты от публичного доступа (также проверьте наш плагин WordPress Countdown).

Конечно, вы можете добавить в свой файл больше правил. Прежде чем это сделать, нужно понимать, что это виртуальный файл. Обычно WordPress robots.txt находится в корневом каталоге, который часто называется public_html или www (или по имени вашего веб-сайта):

Следует отметить, что файл robots.txt для WordPress, созданный по умолчанию, недоступен вам ни из какой директории. Это работает, но если вы хотите внести изменения, вам нужно создать свой собственный файл и загрузить его в корневой каталог.

Мы рассмотрим несколько способов создания файла robots.txt для WordPress. Теперь давайте обсудим, как определить, какие правила включить в файл.

Лучшие роботы txt для WordPress

Создать лучший файл robots txt для вашего сайта WordPress не так сложно. Итак, какие правила нужно включить в файл robots.txt. В предыдущем разделе мы видели пример файла robots.txt, сгенерированного WordPress. Он включает всего два коротких правила, но для большинства сайтов их достаточно. Давайте взглянем на два разных файла robots.txt и посмотрим, что делает каждый из них.

Вот наш первый пример файла robots.txt WordPress:

User-agent: * Allow: / # Disallowed Sub-Directories Disallow: / payout / Disallow: / photos / Disallow: / forums /Этот файл robots.txt создан для форума. Поисковики обычно индексируют каждую ветку форума. В зависимости от темы вашего форума вы можете запретить индексирование. Например, Google не будет индексировать сотни коротких обсуждений пользователей. Вы также можете установить правила, указывающие на конкретную ветку форума, чтобы исключить ее и разрешить поисковым системам индексировать остальные.

Вы также заметили строку, начинающуюся с Allow: / в верхней части файла. Эта строка сообщает роботам, что они могут сканировать все страницы вашего сайта, за исключением ограничений, установленных ниже. Вы также заметили, что мы установили эти правила как универсальные (со звездочкой), как это было в виртуальном файле WordPress robots.txt (также вы можете проверить наш плагин таблицы цен WordPress).

Давайте проверим еще один образец файла robots.txt WordPress:

User-agent: * Disallow: / wp-admin / Disallow: / wp-includes / User-agent: Bingbot Disallow: /В этом файле мы устанавливаем те же правила, что и в WordPress по умолчанию. Хотя мы также добавляем новый набор правил, которые запрещают поисковым роботам Bing сканировать наш сайт. Bingbot, как видите, это имя робота.

Вы также можете ввести имена других поисковых систем, чтобы ограничить или разрешить их доступ. На практике, конечно, Bingbot очень хорош (пусть и не так хорош, как Googlebot). Однако существует множество вредоносных роботов.

Плохая новость в том, что они не всегда следуют инструкциям в файле robots.txt (все равно работают как террористы). Следует иметь в виду, что, хотя большинство роботов будут использовать инструкции, представленные в этом файле, вы не можете заставить их это делать.

Если вы углубитесь в тему, вы найдете много предложений о том, что разрешить и что заблокировать на вашем сайте WordPress. Хотя, по нашему опыту, чем меньше правил, тем лучше. Вот пример

лучший robots txt для сайта WordPress, но для разных сайтов он может отличаться:

User-agent: * Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Disallow: *utm*= Disallow: *openstat= Allow: */uploads Sitemap: https://wpdevart.com/sitemap.xmlТрадиционно WordPress любит закрывать каталоги wp-admin и wp-includes. Однако это уже не лучшее решение. Кроме того, если вы добавляете метатеги для своих изображений в целях продвижения (SEO), нет смысла говорить роботам не индексировать содержимое этих каталогов.

Что должен содержать ваш файл robots.txt, будет зависеть от потребностей вашего сайта. Так что не стесняйтесь делать больше исследований!

Как создать robots.txt

Что может быть проще, чем создать текстовый файл (txt). Все, что вам нужно сделать, это открыть ваш любимый редактор (например, Блокнот или TextEdit) и ввести несколько строк. Затем вы сохраняете файл, используя robots и расширение txt (robots.txt). Это займет несколько секунд, поэтому вы можете создать файл robots.txt для WordPress без использования плагина.

Мы сохранили этот файл локально на компьютере. После того, как вы создали свой собственный файл, вам необходимо подключиться к вашему сайту через FTP (возможно, с помощью FileZilla).

После подключения к вашему сайту перейдите в каталог public_html. Теперь все, что вам нужно сделать, это загрузить файл robots.txt со своего компьютера на сервер. Вы можете сделать это либо щелкнув правой кнопкой мыши файл в локальном FTP-навигаторе, либо просто перетащив его с помощью мыши.

Это займет всего несколько секунд. Как видите, этот способ проще, чем использование плагина.

Как проверить WordPress robots.txt и отправить его в Google Search Console

После создания и загрузки файла WordPress robots.txt вы можете проверить наличие ошибок в Google Search Console. Search Console — это набор инструментов Google, предназначенных для того, чтобы помочь вам отслеживать, как ваш контент отображается в результатах поиска. Один из этих инструментов проверяет robots.txt, вы легко найдете его на странице администратора инструментов Google для веб-мастеров (также проверьте 50 лучших плагинов WordPress 2020).

Там вы найдете поле редактора, в которое вы можете добавить код для вашего файла robots.txt WordPress, и нажмите «Отправить» в правом нижнем углу. Консоль поиска Google спросит вас, хотите ли вы использовать новый код или загрузить файл с вашего веб-сайта.

Теперь платформа проверит ваш файл на наличие ошибок. При обнаружении ошибки вам будет показана информация об этом. Вы видели несколько примеров файла robots.txt для WordPress, и теперь у вас есть еще больше шансов создать свой идеальный файл robots.txt!