LLM โอเพ่นซอร์ส 5 อันดับแรกที่คุณต้องรู้ [ธันวาคม 2023]

เผยแพร่แล้ว: 2023-12-19สรุป:

สำรวจแนวหน้าของนวัตกรรม AI ด้วยโมเดลภาษาขนาดใหญ่แบบโอเพ่นซอร์ส (LLM) 5 อันดับแรกของปี 2023 ตั้งแต่พารามิเตอร์ 180B ที่ก้าวล้ำของ Falcon ไปจนถึงความสามารถหลายภาษาของ BLOOM เจาะลึกคุณสมบัติล้ำสมัยที่กำหนดอนาคต ค้นพบจุดแข็งและการใช้งานที่เป็นไปได้ของ Llama 2, GPT-NeoX-20B และ MPT-7B ซึ่งช่วยให้ธุรกิจต่างๆ สามารถขยายขนาดได้อย่างปลอดภัยในภูมิทัศน์ AI ที่กำลังพัฒนา

การแนะนำ

โลกแห่งปัญญาประดิษฐ์ (AI) กำลังเปลี่ยนแปลงอย่างรวดเร็ว และการเปลี่ยนแปลงส่วนใหญ่มาจากสิ่งที่เรียกว่า Large Language Models (LLM) สิ่งเหล่านี้ไม่ได้เป็นเพียงเครื่องมือทั่วไปเท่านั้น พวกเขาเป็นเหมือนผู้นำของเทคโนโลยียุคใหม่ คิดว่าสิ่งเหล่านี้เป็นระบบที่ชาญฉลาดจริงๆ ที่กำลังเปลี่ยนแปลงวิธีการใช้โทรศัพท์ คอมพิวเตอร์ และอุปกรณ์อื่นๆ ของเรา

องค์กรต่างๆ อาจเลือกใช้ซอฟต์แวร์ opensource LLM (Large Language Model) แทนที่จะใช้บริการแชทบอทภายนอก เช่น ChatGPT, Claude.ai หรือ Phind เพื่อจัดการข้อกังวลด้านความเป็นส่วนตัวและความปลอดภัย การเรียกใช้ LLM แบบโอเพ่นซอร์สบนเครื่องของคุณช่วยให้แน่ใจว่าข้อมูลที่ละเอียดอ่อนและข้อมูลที่เป็นความลับยังคงอยู่ในการควบคุมขององค์กร ซึ่งช่วยลดความเสี่ยงในการเปิดเผยต่อหน่วยงานภายนอก แนวทางนี้มีความสำคัญอย่างยิ่งบนแพลตฟอร์มที่การโต้ตอบอาจได้รับการตรวจสอบโดยมนุษย์หรือใช้สำหรับการฝึกอบรมโมเดลในอนาคต ด้วยการใช้ประโยชน์จากซอฟต์แวร์โอเพ่นซอร์ส LLM ภายในองค์กร องค์กรสามารถรักษาระดับความปลอดภัยของข้อมูลและการรักษาความลับในระดับที่สูงขึ้น โดยจัดการกับปัญหาความเป็นส่วนตัวที่อาจเกิดขึ้นที่เกี่ยวข้องกับแอปพลิเคชันภายนอก

สิ่งที่น่าตื่นเต้นคือ LLM จำนวนมากเหล่านี้เป็นโอเพ่นซอร์ส ซึ่งหมายความว่าใครก็ตามที่มีความสนใจและมีทักษะด้านเทคโนโลยีสามารถใช้ เปลี่ยนแปลง และปรับปรุงได้ มันเหมือนกับการมีเพื่อน AI ที่ฉลาดสุดๆ ที่คุณสามารถเรียนรู้และสอนลูกเล่นใหม่ๆ ได้

Opensource LLM 5 อันดับแรกของปี 2023

ในบล็อกนี้ เราจะดู LLM โอเพ่นซอร์สที่น่าทึ่งห้ารายการเหล่านี้ แต่ละคนมีความพิเศษในแบบของตัวเอง โดยนำแนวคิดและความสามารถใหม่ๆ มาสู่โลกแห่ง AI

ฟอลคอน แอลแอลเอ็ม

Falcon LLM ย่อมาจาก Large Language Model (LLM) ที่ก้าวล้ำซึ่งพัฒนาโดย Technology Innovation Institute (TII) ในอาบูดาบี ได้รับการออกแบบมาเพื่อขับเคลื่อนแอปพลิเคชันและกรณีการใช้งาน เพื่อให้มั่นใจถึงความยืดหยุ่นในอนาคตของโลกของเรา ปัจจุบันชุดนี้ครอบคลุมโมเดล AI พารามิเตอร์ Falcon 180B, 40B, 7.5B และ 1.3B พร้อมด้วยชุดข้อมูล REFINEDWEB ที่ได้รับการดูแลอย่างพิถีพิถัน พวกเขาร่วมกันนำเสนอโซลูชั่นที่หลากหลายและครอบคลุม

ต่อไปนี้เป็นรายละเอียดที่ครอบคลุมเกี่ยวกับคุณลักษณะหลัก จุดแข็ง และการใช้งานที่เป็นไปได้ พร้อมด้วยแหล่งข้อมูลที่เกี่ยวข้องสำหรับการสำรวจเพิ่มเติม:

คุณสมบัติที่สำคัญ:

- ขนาดมหึมา : ด้วยพารามิเตอร์ 180,000 ล้านพารามิเตอร์ Falcon 180B จึงมีขีดความสามารถที่น่าประทับใจสำหรับการเรียนรู้และประสิทธิภาพ ซึ่งเหนือกว่า LLM โอเพ่นซอร์สอื่นๆ อีกหลายตัว

- การฝึกอบรมที่มีประสิทธิภาพ : ฝึกอบรมบนชุดข้อมูลที่ได้รับการปรับปรุงแล้วจำนวน 3.5 ล้านล้านโทเค็น รับประกันความถูกต้องและคุณภาพพร้อมทั้งเพิ่มประสิทธิภาพการใช้ทรัพยากร

- ความพร้อมใช้งานของโอเพ่นซอร์ส : รหัสและข้อมูลการฝึกอบรมเปิดเผยต่อสาธารณะบน Hugging Face ซึ่งส่งเสริมความโปร่งใสและการมีส่วนร่วมของชุมชน

- ประสิทธิภาพที่เหนือกว่า : Falcon มีประสิทธิภาพเหนือกว่า GPT-3 ในเกณฑ์มาตรฐานต่างๆ ในขณะที่ใช้ทรัพยากรการฝึกอบรมและการอนุมานน้อยกว่า ทำให้เป็นตัวเลือกที่มีประสิทธิภาพมากขึ้น

- โมเดลที่หลากหลาย : TII มีเวอร์ชัน Falcon หลากหลาย รวมถึงโมเดล AI พารามิเตอร์ 180B, 40B, 7.5B, 1.3B ซึ่งเป็นโมเดลเฉพาะสำหรับงานเฉพาะ เช่น การเขียนเรื่องราวแบบยาว

จุดแข็ง:

- ไปป์ไลน์ข้อมูลคุณภาพสูง : กระบวนการกรองและขจัดข้อมูลซ้ำซ้อนที่เข้มงวดของ TII ช่วยให้มั่นใจได้ถึงข้อมูลการฝึกอบรมที่แม่นยำและเชื่อถือได้สำหรับ Falcon

- ความสามารถหลายภาษา : Falcon สามารถจัดการหลายภาษาได้อย่างมีประสิทธิภาพ แม้ว่าจะเน้นที่ภาษาอังกฤษเป็นหลักก็ตาม

- ศักยภาพในการปรับแต่งอย่างละเอียด : Falcon สามารถปรับแต่งได้อย่างละเอียดสำหรับงานเฉพาะ ซึ่งจะช่วยเพิ่มประสิทธิภาพและความสามารถในการปรับตัวให้ดียิ่งขึ้นไปอีก

- การพัฒนาที่ขับเคลื่อนโดยชุมชน : ลักษณะโอเพ่นซอร์สช่วยให้สามารถปรับปรุงและวิจัยร่วมกันได้ ซึ่งจะช่วยเร่งการพัฒนาของ Falcon

การใช้งานที่เป็นไปได้:

- การประมวลผลภาษาธรรมชาติ (NLP): Falcon สามารถเป็นเลิศในงาน NLP ต่างๆ เช่น การสรุปข้อความ การวิเคราะห์ความรู้สึก และการสร้างบทสนทนา

- การสร้างเนื้อหาเชิงสร้างสรรค์ : โมเดลนี้สามารถช่วยเหลือนักเขียนและศิลปินในการสร้างรูปแบบความคิดสร้างสรรค์ที่แตกต่างกัน เช่น บทกวี บทละคร และบทเพลง

- การศึกษาและการวิจัย : ประสบการณ์การเรียนรู้เฉพาะบุคคล การสร้างเนื้อหาทางการศึกษา และการสนับสนุนการวิจัย ล้วนแล้วแต่มีประโยชน์

- ธุรกิจและการตลาด : Falcon สามารถขับเคลื่อนแชทบอทอัจฉริยะ ปรับแต่งแคมเปญการตลาด และวิเคราะห์ข้อมูลลูกค้าได้อย่างมีประสิทธิภาพ

แหล่งข้อมูลเพิ่มเติม :

- เว็บไซต์ Falcon LLM: https://www.tii.ae/news/abu-dhabi-based-technology-innovation-institute-introduces-falcon-llm-foundational-large

- การ์ดโมเดลกอดใบหน้าเหยี่ยว: https://huggingface.co/spaces/tiiuae/falcon-180b-demo

- โพสต์บนบล็อก TII Falcon: https://huggingface.co/tiiuae/falcon-180B

- วิดีโอ YouTube บน Falcon-180B: https://www.youtube.com/watch?v=9MArp9H2YCM

ลามะ 2

Llama 2 ซึ่งเป็นโมเดลภาษาโอเพ่นซอร์สขนาดใหญ่ที่พัฒนาโดย Meta AI และ Microsoft นำเสนอความสามารถพิเศษในการสร้างเนื้อหาที่หลากหลาย ตั้งแต่บทกวีไปจนถึงการเขียนโค้ด การตอบคำถาม และการแปลภาษา มันมีประสิทธิภาพเหนือกว่า LLM อื่นๆ ในด้านเกณฑ์มาตรฐานการให้เหตุผลและการเข้ารหัส โดยเน้นความปลอดภัยผ่านการเรียนรู้แบบเสริมกำลัง และจัดทำ “คู่มือการใช้งานอย่างมีความรับผิดชอบ” ในขณะที่ยังอยู่ระหว่างการพัฒนา ผู้ใช้ควรตระหนักถึงความไม่ถูกต้องที่อาจเกิดขึ้น ผลลัพธ์ที่มีอคติ และความต้องการความเชี่ยวชาญด้านเทคนิคเพื่อการใช้งานที่เหมาะสมที่สุด การใช้งานอย่างมีความรับผิดชอบเป็นสิ่งสำคัญยิ่งในการปลดล็อกศักยภาพสูงสุดของ Llama 2 ในการปฏิวัติสาขาต่างๆ

สร้างขึ้นบนรากฐานของ Llama ดั้งเดิม Llama 2 เหนือกว่ารุ่นก่อนในหลายประการ:

- การฝึกอบรมที่หลากหลาย : ฝึกอบรมบนชุดข้อมูลที่มีขนาดใหญ่และหลากหลาย ทำให้มั่นใจได้ถึงความเข้าใจและประสิทธิภาพที่ดีขึ้นในงานต่างๆ

- ความพร้อมใช้งานแบบเปิด : Llama 2 แตกต่างจากการเข้าถึงแบบจำกัดของรุ่นก่อนตรงที่พร้อมสำหรับการวิจัย การพัฒนา และแม้แต่แอปพลิเคชันเชิงพาณิชย์บนแพลตฟอร์ม เช่น AWS, Azure และ Hugging Face

- การมุ่งเน้นด้านความปลอดภัย : Meta ให้ความสำคัญกับความปลอดภัยโดยการใช้มาตรการเพื่อลดข้อมูลที่ไม่ถูกต้อง อคติ และผลลัพธ์ที่เป็นอันตราย

- การฝึกอบรมที่ได้รับการปรับปรุง : นำเสนอในเวอร์ชันต่างๆ โดยมีการนับพารามิเตอร์ตั้งแต่ 7 พันล้านถึง 70 พันล้าน เพื่อรองรับความต้องการและทรัพยากรที่หลากหลาย

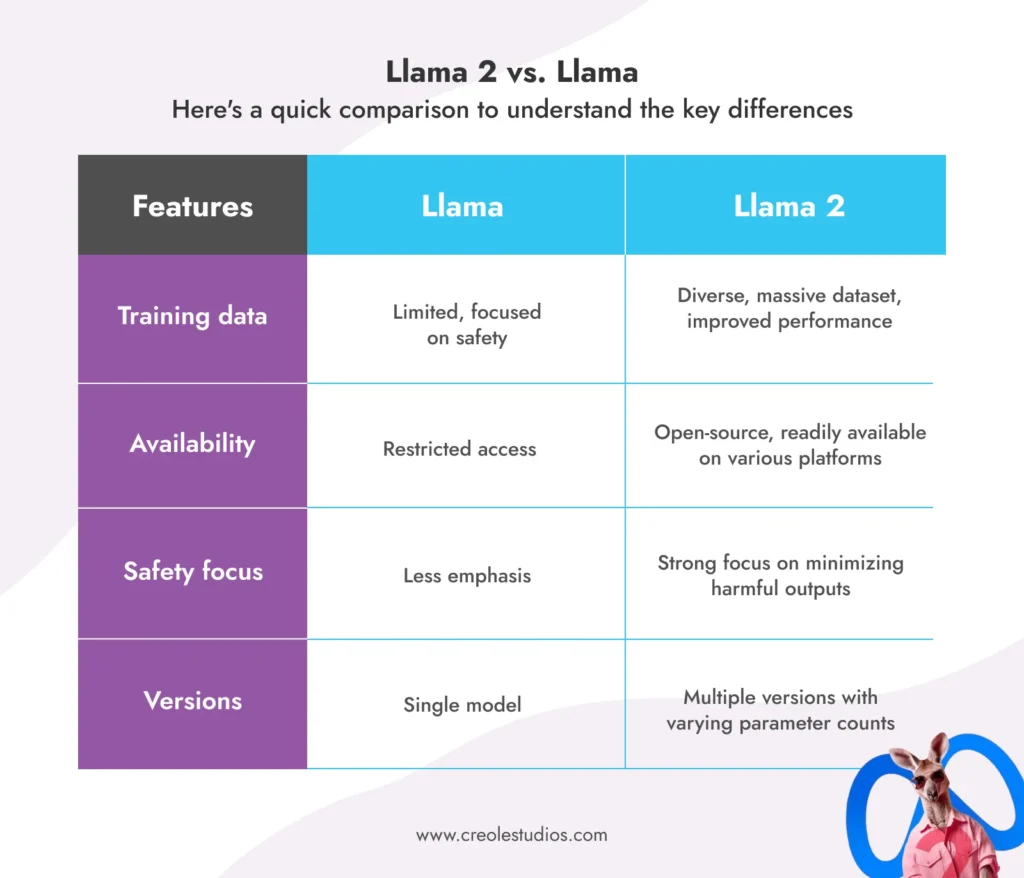

ลามะ 2 กับ ลามะ:

ต่อไปนี้เป็นการเปรียบเทียบสั้นๆ เพื่อทำความเข้าใจความแตกต่างที่สำคัญ:

การใช้งานที่เป็นไปได้ของ Llama 2:

- แชทบอทและผู้ช่วยเสมือน : ความสามารถในการสนทนาที่ได้รับการปรับปรุงสามารถขับเคลื่อนการโต้ตอบที่เป็นธรรมชาติและน่าดึงดูดยิ่งขึ้น

- การสร้างข้อความและเนื้อหาสร้างสรรค์ : สร้างรูปแบบสร้างสรรค์ที่แตกต่างกัน เช่น บทกวี สคริปต์ หรือโค้ด เพื่อช่วยเหลือนักเขียนและศิลปิน

- การสร้างโค้ดและการเขียนโปรแกรม : ช่วยนักพัฒนาในงานต่างๆ เช่น การเติมโค้ดให้สมบูรณ์และการตรวจจับจุดบกพร่อง

- การศึกษาและการวิจัย : ปรับแต่งประสบการณ์การเรียนรู้ สร้างเนื้อหาทางการศึกษา และช่วยเหลือนักวิจัยในงานต่างๆ

- ธุรกิจและการตลาด : ปรับปรุงการบริการลูกค้าผ่านแชทบอท ปรับแต่งแคมเปญการตลาด และวิเคราะห์ข้อมูลลูกค้า

ข้อจำกัดและข้อควรพิจารณา:

- เช่นเดียวกับ LLM ทั้งหมด Llama 2 ยังอยู่ระหว่างการพัฒนาและสามารถสร้างเอาต์พุตที่ไม่ถูกต้องหรือเอนเอียงได้

- การใช้อย่างมีความรับผิดชอบและมีจริยธรรมถือเป็นสิ่งสำคัญเพื่อหลีกเลี่ยงการใช้ในทางที่ผิดและความลำเอียงที่อาจเกิดขึ้น

- เวอร์ชันต่างๆ ต้องใช้ทรัพยากรในการคำนวณที่แตกต่างกัน ดังนั้นการเลือกเวอร์ชันที่เหมาะสมจึงเป็นสิ่งสำคัญ

ทรัพยากร:

- เว็บไซต์ Meta AI LLAMA: https://ai.meta.com/blog/large-language-model-llama-meta-ai/

- โพสต์ในบล็อก Meta AI บน LLAMA2: https://ai.meta.com/blog/large-language-model-llama-meta-ai/

- การ์ดโมเดล Hugging Face LLAMA2: https://huggingface.co/models?search=llama

บลูม แอลแอลเอ็ม

Bloom LLM เกิดจากความพยายามร่วมกันของชุมชนระดับโลก และได้กลายเป็นกำลังสำคัญในภูมิทัศน์ AI แบบโอเพ่นซอร์ส ต่อไปนี้เป็นรายละเอียดที่ครอบคลุมเกี่ยวกับคุณสมบัติหลัก แอปพลิเคชันที่เป็นไปได้ และสิ่งที่ทำให้เป็นเอกลักษณ์:

BLOOM LLM คืออะไร?

BLOOM เป็น LLM ขนาดใหญ่ที่พูดได้หลายภาษา มีพารามิเตอร์ถึง 176 พันล้านพารามิเตอร์ และได้รับการฝึกอบรมเกี่ยวกับภาษา 46 ภาษาและภาษาการเขียนโปรแกรม 13 ภาษา BLOOM ได้รับการพัฒนาผ่านโครงการความร่วมมือตลอดทั้งปีที่เกี่ยวข้องกับ Hugging Face และนักวิจัยจากกว่า 70 ประเทศ โดยรวบรวมจิตวิญญาณของ AI แบบโอเพ่นซอร์ส

คุณสมบัติที่สำคัญของบลูม:

- ความสามารถในการพูดได้หลายภาษา : สร้างข้อความที่สอดคล้องกันและแม่นยำใน 46 ภาษาที่มากกว่ารูปแบบทั่วไปที่เน้นภาษาอังกฤษเป็นศูนย์กลาง

- การเข้าถึงแบบโอเพ่นซอร์ส : ทั้งซอร์สโค้ดและข้อมูลการฝึกอบรมนั้นเปิดเผยต่อสาธารณะ ซึ่งส่งเสริมความโปร่งใสและการปรับปรุงที่ขับเคลื่อนโดยชุมชน

- การสร้างข้อความแบบถดถอยอัตโนมัติ : ขยายและเติมลำดับข้อความให้สมบูรณ์อย่างราบรื่น ทำให้เหมาะสำหรับงานสร้างสรรค์และข้อมูลต่างๆ

- จำนวนพารามิเตอร์จำนวนมาก : ด้วยพารามิเตอร์ 176 พันล้านพารามิเตอร์ BLOOM ติดอันดับหนึ่งใน LLM โอเพ่นซอร์สที่ทรงพลังที่สุด โดยให้ประสิทธิภาพที่เหนือกว่า

- ความร่วมมือระดับโลก : การพัฒนาแบบจำลองนี้เป็นตัวอย่างถึงพลังของความร่วมมือระหว่างประเทศในการพัฒนาเทคโนโลยี AI

- การเข้าถึงฟรี : ใครๆ ก็สามารถเข้าถึงและใช้งาน BLOOM ผ่านทางแพลตฟอร์ม Hugging Face ทำให้เข้าถึงเครื่องมือ AI ล้ำสมัยได้อย่างเป็นประชาธิปไตย

- การฝึกอบรมระดับอุตสาหกรรม : ฝึกอบรมเกี่ยวกับข้อมูลข้อความจำนวนมหาศาลโดยใช้ทรัพยากรการคำนวณที่สำคัญ เพื่อให้มั่นใจถึงประสิทธิภาพที่แข็งแกร่ง

การใช้งานที่เป็นไปได้ของ BLOOM:

- การสื่อสารหลายภาษา : อำนวยความสะดวกในการสื่อสารข้ามวัฒนธรรมโดยการแปลข้อความและสร้างเนื้อหาเฉพาะภาษา

- การเขียนเชิงสร้างสรรค์และการสร้างเนื้อหา : ช่วยเหลือนักเขียนและศิลปินในรูปแบบต่างๆ เช่น บทกวี สคริปต์ โค้ด บทเพลง ฯลฯ

- การศึกษาและการวิจัย : ปรับแต่งประสบการณ์การเรียนรู้ สร้างสื่อการเรียนรู้ และสนับสนุนการวิจัยในสาขาต่างๆ

- ธุรกิจและการตลาด : ปรับปรุงการบริการลูกค้าด้วยแชทบอทหลายภาษา ปรับแต่งแคมเปญการตลาดในแบบของคุณ และวิเคราะห์ข้อมูลอย่างมีประสิทธิภาพ

- การพัฒนา AI แบบโอเพ่นซอร์ส : ทำหน้าที่เป็นรากฐานสำหรับการวิจัยและพัฒนาเพิ่มเติมใน AI แบบโอเพ่นซอร์ส เพื่อส่งเสริมนวัตกรรมของชุมชน

อะไรที่ทำให้ BLOOM มีเอกลักษณ์เฉพาะตัว?

- การมุ่งเน้นหลายภาษา : แตกต่างจาก LLM หลายแห่งที่เน้นภาษาอังกฤษเป็นหลัก ความสามารถหลายภาษาของ BLOOM เปิดโอกาสใหม่สำหรับการสื่อสารและความเข้าใจในระดับโลก

- ความเปิดกว้างและความโปร่งใส : การเข้าถึงโค้ดและข้อมูลการฝึกอบรมโดยสาธารณะช่วยให้มีส่วนร่วมในการปรับปรุงและใช้งานโมเดลได้กว้างขึ้น

- การพัฒนาความร่วมมือ : การสร้างแบบจำลองผ่านการทำงานร่วมกันระดับโลกแสดงให้เห็นถึงศักยภาพของ AI แบบโอเพ่นซอร์สในการเชื่อมอุปสรรคทางภูมิศาสตร์และวัฒนธรรม

ข้อจำกัดและข้อควรพิจารณา:

- เช่นเดียวกับ LLM ทั้งหมด BLOOM ยังอยู่ระหว่างการพัฒนาและสามารถสร้างผลลัพธ์ที่ไม่ถูกต้องหรือเอนเอียงได้ การใช้อย่างมีความรับผิดชอบและมีจริยธรรมเป็นสิ่งสำคัญ

- การใช้ BLOOM อย่างมีประสิทธิภาพต้องอาศัยความรู้ทางเทคนิคและความเข้าใจในความสามารถของตน

- ขนาดใหญ่ของโมเดลอาจต้องใช้ทรัพยากรการคำนวณจำนวนมากสำหรับงานบางอย่าง

ทรัพยากร:

- เว็บไซต์ BigScience BLOOM: https://huggingface.co/bigscience/bloom-intermediate

- การ์ดโมเดล Hugging Face BLOOM: https://bigscience.huggingface.co/blog/bloom

- โพสต์บนบล็อก BigScience บน BLOOM: https://huggingface.co/bigscience/bloom

- พื้นที่เก็บข้อมูลการ์ดโมเดล BLOOM บน GitHub: https://github.com/bigscience-workshop/model_card

GPT-NeoX-20B

เป็น LLM โอเพ่นซอร์สอีกแห่งหนึ่งที่มีความโดดเด่น นำเสนอความสามารถและศักยภาพที่โดดเด่น ต่อไปนี้เป็นรายละเอียดคุณลักษณะหลัก จุดแข็ง และการใช้งานที่เป็นไปได้:

GPT-NeoX-20B คืออะไร?

- GPT-NeoX-20B พัฒนาโดย EleutherAI เป็นโมเดลภาษาถอยหลังอัตโนมัติพารามิเตอร์ 2 หมื่นล้านพารามิเตอร์ ซึ่งได้รับการฝึกฝนบน Pile ซึ่งเป็นชุดข้อมูลข้อความและโค้ดขนาดใหญ่

- สถาปัตยกรรมของมันยืมมาจาก GPT-3 แต่มีการเพิ่มประสิทธิภาพที่สำคัญเพื่อประสิทธิภาพและประสิทธิผลที่ดีขึ้น

- GPT-NeoX-20B มีความเป็นเลิศในหลายด้าน:

- การใช้เหตุผลเพียงเล็กน้อย : ทำงานได้ดีเป็นพิเศษในงานที่ต้องการความเข้าใจและการประยุกต์ใช้ข้อมูลจากตัวอย่างที่มีจำกัด

- การสร้างข้อความแบบยาว : สร้างข้อความที่สอดคล้องกันและถูกต้องตามหลักไวยากรณ์แม้จะเป็นลำดับที่ยาวก็ตาม

- การสร้างและวิเคราะห์โค้ด : สามารถเข้าใจและสร้างโค้ดได้ ช่วยเหลือ Developer ในงานต่างๆ

จุดแข็งของ GPT-NeoX-20B:

- โอเพ่นซอร์ส : รหัสและน้ำหนักของแบบจำลองเปิดเผยต่อสาธารณะ เพื่อสนับสนุนการมีส่วนร่วมของชุมชนและการวิจัย

- การฝึกอบรมที่มีประสิทธิภาพ : ใช้ไลบรารี DeepSpeed เพื่อการฝึกอบรมที่มีประสิทธิภาพ โดยใช้ทรัพยากรในการคำนวณน้อยกว่าเมื่อเทียบกับ LLM อื่นๆ

- การเรียนรู้แบบไม่กี่ช็อตที่แข็งแกร่ง : ทำงานได้ดีเป็นพิเศษกับงานที่มีข้อมูลจำกัด ทำให้สามารถปรับให้เข้ากับสถานการณ์ที่หลากหลายได้

- การสร้างข้อความแบบยาว : สร้างข้อความที่สอดคล้องกันและถูกต้องตามหลักไวยากรณ์แม้เป็นลำดับที่ยาว เหมาะสำหรับการเขียนเชิงสร้างสรรค์และการสร้างเนื้อหา

- การสร้างและการวิเคราะห์โค้ด : ทำความเข้าใจและสร้างโค้ด ซึ่งอาจช่วยเหลือนักพัฒนาในการตรวจจับจุดบกพร่อง การเติมโค้ดให้สมบูรณ์ และงานอื่น ๆ

การใช้งานที่เป็นไปได้ของ GPT-NeoX-20B:

- ผู้ช่วยส่วนตัวและแชทบอท : เพิ่มความสามารถในการทำความเข้าใจและตอบคำถามและคำขอที่ซับซ้อน

- การเขียนเชิงสร้างสรรค์และการสร้างเนื้อหา : ช่วยนักเขียนและศิลปินในการสร้างรูปแบบสร้างสรรค์ที่แตกต่างกัน เช่น บทกวี บทละคร ผลงานเพลง ฯลฯ

- การศึกษาและการวิจัย : ปรับแต่งประสบการณ์การเรียนรู้ สร้างเนื้อหาทางการศึกษา และสนับสนุนการวิจัยในสาขาต่างๆ

- การพัฒนาซอฟต์แวร์ : ช่วยเหลือนักพัฒนาในงานต่างๆ เช่น การเติมโค้ดให้สมบูรณ์ การตรวจจับจุดบกพร่อง และการวิเคราะห์โค้ด

- การวิจัย AI แบบโอเพ่นซอร์ส : ทำหน้าที่เป็นรากฐานสำหรับการวิจัยและพัฒนาเพิ่มเติมใน AI แบบโอเพ่นซอร์ส เพื่อส่งเสริมนวัตกรรม

ข้อจำกัดและข้อควรพิจารณา:

- เช่นเดียวกับ LLM ทั้งหมด GPT-NeoX-20B ยังอยู่ระหว่างการพัฒนา และบางครั้งสามารถสร้างเอาต์พุตที่ไม่ถูกต้องหรือเอนเอียงได้ การใช้อย่างมีความรับผิดชอบและมีจริยธรรมเป็นสิ่งสำคัญ

- การใช้ศักยภาพอย่างเต็มที่อาจต้องใช้ความรู้ด้านเทคนิคและความเข้าใจในความสามารถของตน

- ขนาดของแบบจำลองอาจต้องใช้ทรัพยากรการคำนวณจำนวนมากสำหรับงานบางอย่าง

ทรัพยากร:

- พื้นที่เก็บข้อมูล EleutherAI GitHub: นี่คือพื้นที่เก็บข้อมูลอย่างเป็นทางการสำหรับ GPT-NeoX-20B ซึ่งคุณสามารถค้นหาซอร์สโค้ด สคริปต์การฝึกอบรม และโมเดลที่ได้รับการฝึกอบรมล่วงหน้าได้ (ที่มา: https://github.com/EleutherAI/gpt-neox)

- การ์ดโมเดล Hugging Face: การ์ดโมเดล Hugging Face ให้ภาพรวมที่ครอบคลุมของ GPT-NeoX-20B รวมถึงความสามารถ ข้อจำกัด และผลลัพธ์การวัดประสิทธิภาพ (ที่มา: https://huggingface.co/EleutherAI/gpt-neox-20b)

- โพสต์ในบล็อก EleutherAI: บล็อกโพสต์โดย EleutherAI นี้แนะนำ GPT-NeoX-20B อภิปรายเกี่ยวกับสถาปัตยกรรมและกระบวนการฝึกอบรม และเน้นย้ำถึงแอปพลิเคชันที่มีศักยภาพบางส่วน (ที่มา: https://www.opensourceforu.com/2022/04/eleutherai-releases-gpt-neox-20b-a-20-billion-parameter-ai-language-model/)

MPT-7B

MPT-7B ย่อมาจาก MosaicML Pretrained Transformer เป็น LLM โอเพ่นซอร์สที่ทรงพลังซึ่งพัฒนาโดยมูลนิธิ MosaicML มีพารามิเตอร์ถึง 7 พันล้านพารามิเตอร์และได้รับการฝึกอบรมบนชุดข้อมูลขนาดใหญ่ 1 ล้านล้านโทเค็น ทำให้เป็นคู่แข่งที่มีความสามารถในภูมิทัศน์ LLM ต่อไปนี้เป็นรายละเอียดคุณสมบัติหลักและแอปพลิเคชันที่เป็นไปได้ พร้อมด้วยแหล่งข้อมูลที่เกี่ยวข้องสำหรับการสำรวจเพิ่มเติม:

คุณสมบัติที่สำคัญ:

- ใบอนุญาตเชิงพาณิชย์ : MPT-7B ต่างจากรุ่นโอเพ่นซอร์สอื่นๆ ตรงที่ได้รับอนุญาตให้ใช้ในเชิงพาณิชย์ โดยเป็นการเปิดประตูให้ธุรกิจต่างๆ ใช้ประโยชน์จากขีดความสามารถของตน

- ข้อมูลการฝึกอบรมที่กว้างขวาง : การฝึกอบรมของ MPT-7B บนชุดข้อมูลที่หลากหลายจำนวน 1 ล้านล้านโทเค็น ช่วยให้มั่นใจถึงประสิทธิภาพที่แข็งแกร่งและความสามารถในการปรับตัวในงานต่างๆ

- การจัดการอินพุตที่ยาวนาน : โมเดลนี้สามารถจัดการอินพุตที่ยาวเป็นพิเศษได้โดยไม่ลดทอนความแม่นยำ ทำให้เหมาะสำหรับงานต่างๆ เช่น การสรุปเอกสารที่มีความยาว

- ความเร็วและประสิทธิภาพ : ปรับให้เหมาะสมเพื่อการฝึกอบรมและการอนุมานที่รวดเร็ว MPT-7B ให้ผลลัพธ์ที่ทันท่วงที ซึ่งสำคัญมากสำหรับการใช้งานในโลกแห่งความเป็นจริง

- โค้ดโอเพ่นซอร์ส : โค้ดการฝึกอบรมโอเพ่นซอร์สที่มีประสิทธิภาพของโมเดลส่งเสริมความโปร่งใสและอำนวยความสะดวกในการมีส่วนร่วมของชุมชนในการพัฒนา

- ความเป็นเลิศเชิงเปรียบเทียบ : MPT-7B แสดงให้เห็นถึงประสิทธิภาพที่เหนือกว่าเมื่อเปรียบเทียบกับรุ่นโอเพ่นซอร์สอื่นๆ ในช่วงพารามิเตอร์ 7B-20B แม้จะตรงกับคุณภาพของ LLaMA-7B ก็ตาม

การใช้งานที่เป็นไปได้:

- การวิเคราะห์เชิงคาดการณ์ : MPT-7B สามารถวิเคราะห์ชุดข้อมูลขนาดใหญ่เพื่อระบุรูปแบบและแนวโน้ม แจ้งการตัดสินใจทางธุรกิจ และเพิ่มประสิทธิภาพการดำเนินงาน

- การสนับสนุนการตัดสินใจ : โมเดลสามารถช่วยในกระบวนการตัดสินใจที่ซับซ้อนโดยการให้ข้อมูลเชิงลึกและคำแนะนำตามข้อมูลที่วิเคราะห์

- การสร้างและการสรุปเนื้อหา : MPT-7B สามารถสร้างรูปแบบข้อความสร้างสรรค์ที่แตกต่างกัน เช่น บทกวี สคริปต์ หรือรหัส หรือสรุปเอกสารขนาดยาวได้อย่างมีประสิทธิภาพ

- แชทบอทบริการลูกค้า : ด้วยการทำความเข้าใจภาษาและบริบทที่เป็นธรรมชาติ MPT-7B สามารถขับเคลื่อนแชทบอทอัจฉริยะเพื่อประสบการณ์การบริการลูกค้าที่ดียิ่งขึ้น

- การวิจัยและพัฒนา : แบบจำลองนี้สามารถสนับสนุนความพยายามในการวิจัยในด้านต่างๆ โดยการวิเคราะห์ข้อมูล สร้างสมมติฐาน และช่วยเหลือในการสำรวจอย่างสร้างสรรค์

แหล่งข้อมูลเพิ่มเติม:

- เว็บไซต์ MosaicML MPT-7B: https://www.mosaicml.com/blog/mpt-7b

- การ์ดโมเดลกอดใบหน้า MPT-7B: https://huggingface.co/mosaicml/mpt-7b

- โพสต์ในบล็อกของ MosaicML บน MPT-7B: https://www.mosaicml.com/blog/mpt-7b

ใช้ประโยชน์จาก OpenSource LLM กับ Creole Studios

Opensource Large Language Models (LLM) กำลังปรับโฉม AI โดยนำเสนอความยืดหยุ่นและนวัตกรรมสำหรับธุรกิจ เหมาะอย่างยิ่งสำหรับการสร้างโซลูชันเทคโนโลยีใหม่ๆ และลดต้นทุนการพัฒนา อย่างไรก็ตาม ความท้าทายเช่นความเป็นส่วนตัวของข้อมูลและการปรับแต่งตามความต้องการทางธุรกิจที่เฉพาะเจาะจงอาจมีความซับซ้อน

Creole Studios เป็นพันธมิตรในอุดมคติของคุณในการฝ่าฟันความท้าทายเหล่านี้ ความเชี่ยวชาญของเราในด้าน AI และการเรียนรู้ของเครื่องหมายความว่าเราสามารถช่วยให้ธุรกิจของคุณควบคุมศักยภาพสูงสุดของ LLM แบบโอเพ่นซอร์สได้อย่างมีประสิทธิภาพและปลอดภัย เรามุ่งเน้นที่การสร้างโซลูชันที่ออกแบบตามความต้องการของคุณซึ่งสอดคล้องกับเป้าหมายเฉพาะของคุณ เพื่อให้มั่นใจว่าคุณจะเป็นผู้นำในภูมิทัศน์ AI ที่พัฒนาอย่างรวดเร็ว

ร่วมมือกับ Creole Studios เพื่อเปลี่ยนแปลงการเดินทาง AI ของคุณด้วยพลังของ LLM แบบโอเพ่นซอร์ส