WordPress robots.txt

เผยแพร่แล้ว: 2019-02-26WordPress robots.txt มีความสำคัญมากสำหรับ SEO เพื่อให้แน่ใจว่าเว็บไซต์ของคุณอยู่ในอันดับที่ดีในผลลัพธ์ของเครื่องมือค้นหา คุณต้องทำให้หน้าที่สำคัญที่สุดของเว็บไซต์สะดวกสำหรับการค้นหาและจัดทำดัชนี “หุ่นยนต์” (“บอท”) ของเครื่องมือค้นหา ไฟล์ robots.txt ที่มีโครงสร้างดีจะช่วยนำบอทเหล่านี้ไปยังหน้าที่คุณต้องการสร้างดัชนี

ในบทความนี้เราจะเปิดเผยคำถามดังกล่าว:

- ไฟล์ robots.txt คืออะไรและเหตุใดจึงสำคัญ

- ตำแหน่ง txt ของหุ่นยนต์ WordPress

- สุดยอดหุ่นยนต์ txt สำหรับ WordPress

- วิธีสร้างไฟล์ robots.txt

- วิธีตรวจสอบไฟล์ robots.txt และส่งไปยัง Google Search Console

ไฟล์ robots.txt สำหรับ WordPress คืออะไร และเหตุใดจึงสำคัญ

เมื่อคุณสร้างเว็บไซต์ใหม่ เสิร์ชเอ็นจิ้นจะส่งหุ่นยนต์ของพวกเขาไปสแกนและสร้างแผนที่ของหน้าทั้งหมด ด้วยวิธีนี้ พวกเขาจะรู้ว่าหน้าใดที่จะแสดงเมื่อมีผู้ค้นหาคำสำคัญที่เกี่ยวข้อง ในระดับพื้นฐาน มันค่อนข้างง่าย (ตรวจสอบโพสต์ที่มีประโยชน์นี้ – ไฟล์ .htaccess เริ่มต้นของ WordPress)

ปัญหาคือเว็บไซต์สมัยใหม่มีองค์ประกอบอื่นๆ มากมายนอกเหนือจากหน้า WordPress ให้คุณติดตั้งได้ ตัวอย่างเช่น ปลั๊กอินที่มักจะมีไดเร็กทอรีของตัวเอง ไม่จำเป็นต้องแสดงในผลการค้นหา เนื่องจากไม่ตรงกับเนื้อหา

สิ่งที่ไฟล์ robots.txt ทำคือจัดเตรียมชุดแนวทางปฏิบัติสำหรับโรบ็อตการค้นหา เขาบอกพวกเขาว่า: “ดูที่นี่และจัดทำดัชนีหน้านี้ แต่อย่าเข้าไปในส่วนอื่น!” ไฟล์นี้สามารถมีรายละเอียดได้ตามที่คุณต้องการ และสร้างได้ง่ายมาก แม้ว่าคุณจะเป็นมือใหม่ก็ตาม

ในทางปฏิบัติ เครื่องมือค้นหาจะยังคงสแกนไซต์ของคุณ แม้ว่าคุณจะไม่ได้สร้างไฟล์ robots.txt ก็ตาม อย่างไรก็ตาม การไม่สร้างมันเป็นขั้นตอนที่ไร้เหตุผลมาก หากไม่มีไฟล์นี้ คุณจะปล่อยให้โรบอตจัดทำดัชนีเนื้อหาทั้งหมดของไซต์ของคุณ และพวกเขาตัดสินใจว่าคุณจำเป็นต้องแสดงทุกส่วนของไซต์ของคุณ แม้กระทั่งส่วนที่คุณต้องการซ่อนจากการเข้าถึงแบบสาธารณะ (ตรวจสอบด้วย – ปลั๊กอินอีคอมเมิร์ซ WordPress ที่ดีที่สุด ).

จุดที่สำคัญกว่านั้น หากไม่มีไฟล์ robots.txt เว็บไซต์ของคุณจะมีเพลงฮิตมากมายจากโรบ็อตในไซต์ของคุณ ซึ่งจะส่งผลเสียต่อประสิทธิภาพการทำงาน แม้ว่าการเข้าใช้ไซต์ของคุณจะยังน้อย แต่ความเร็วในการโหลดหน้าเว็บก็เป็นสิ่งที่ควรให้ความสำคัญและอยู่ในระดับสูงสุดเสมอ ในท้ายที่สุดมีเพียงไม่กี่สิ่งที่ผู้คนไม่ชอบมากกว่าการโหลดเว็บไซต์ช้า

ตำแหน่ง txt ของหุ่นยนต์ WordPress

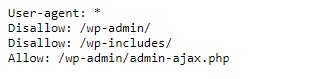

เมื่อคุณสร้างเว็บไซต์ WordPress ไฟล์ robots.txt จะถูกสร้างขึ้นโดยอัตโนมัติและอยู่ในไดเร็กทอรีหลักของคุณบนเซิร์ฟเวอร์ ตัวอย่างเช่น หากเว็บไซต์ของคุณอยู่ที่นี่ – wpdevart.com คุณสามารถค้นหาได้ที่ wpdevart.com/robots.txt และดูสิ่งต่อไปนี้:

นี่คือตัวอย่างไฟล์ robots.txt ที่ง่ายที่สุด แปลเป็นภาษาที่มนุษย์อ่านได้ทางด้านขวามือหลังจาก User-agent: ประกาศ

กฎของหุ่นยนต์คือ เครื่องหมายดอกจันหมายความว่ากฎนั้นเป็นสากลและใช้กับโรบ็อตทั้งหมด ในกรณีนี้ ไฟล์จะบอกหุ่นยนต์ว่าพวกเขาไม่สามารถสแกนไดเร็กทอรี wp-admin และ wp-includes ความหมายของกฎเหล่านี้คือไดเร็กทอรีเหล่านี้มีไฟล์จำนวนมากที่ต้องการการป้องกันจากการเข้าถึงแบบสาธารณะ (ตรวจสอบปลั๊กอิน WordPress Countdown ของเราด้วย)

แน่นอน คุณสามารถเพิ่มกฎเพิ่มเติมในไฟล์ของคุณได้ ก่อนที่คุณจะทำเช่นนี้ คุณต้องเข้าใจว่านี่เป็นไฟล์เสมือน โดยปกติ WordPress robots.txt จะอยู่ในไดเร็กทอรีราก ซึ่งมักเรียกว่า public_html หรือ www (หรือตามชื่อเว็บของคุณ):

โปรดทราบว่าคุณไม่สามารถเข้าถึงไฟล์ robots.txt สำหรับ WordPress ซึ่งสร้างโดยค่าเริ่มต้นได้จากไดเรกทอรีใดๆ ใช้งานได้ แต่ถ้าคุณต้องการเปลี่ยนแปลง คุณต้องสร้างไฟล์ของคุณเองและอัปโหลดไปยังไดเร็กทอรีราก

เราจะพิจารณาหลายวิธีในการสร้างไฟล์ robots.txt สำหรับ WordPress ตอนนี้ เรามาพูดถึงวิธีการกำหนดกฎที่จะรวมไว้ในไฟล์กัน

สุดยอดหุ่นยนต์ txt สำหรับ WordPress

ไม่ยากเลยที่จะสร้างหุ่นยนต์ txt ที่ดีที่สุดสำหรับเว็บไซต์ WordPress ของคุณ ดังนั้นกฎใดบ้างที่จำเป็นต้องรวมอยู่ในไฟล์ robots.txt ในส่วนที่แล้ว เราเห็นตัวอย่างไฟล์ robots.txt ที่สร้างโดย WordPress ประกอบด้วยกฎสั้น ๆ เพียงสองข้อ แต่สำหรับไซต์ส่วนใหญ่ก็เพียงพอแล้ว มาดูไฟล์ robots.txt ที่แตกต่างกันสองไฟล์และดูว่าแต่ละไฟล์ทำอะไรได้บ้าง

นี่คือตัวอย่างแรกของเราสำหรับไฟล์ WordPress robots.txt:

User-agent: * Allow: / # Disallowed Sub-Directories Disallow: / payout / Disallow: / photos / Disallow: / forums /ไฟล์ robots.txt นี้สร้างขึ้นสำหรับฟอรัม เครื่องมือค้นหามักจะจัดทำดัชนีทุกกระทู้ในฟอรั่ม คุณอาจต้องการไม่อนุญาตให้สร้างดัชนี ทั้งนี้ขึ้นอยู่กับหัวข้อของฟอรัมของคุณ ตัวอย่างเช่น Google จะไม่จัดทำดัชนีการสนทนาสั้น ๆ ของผู้ใช้หลายร้อยรายการ คุณยังสามารถตั้งกฎที่ชี้ไปที่ชุดข้อความในฟอรัมที่ต้องการเพื่อแยกออก และอนุญาตให้เครื่องมือค้นหาจัดทำดัชนีส่วนที่เหลือ

คุณยังสังเกตเห็นบรรทัดที่ขึ้นต้นด้วย Allow: / ที่ด้านบนของไฟล์ บรรทัดนี้บอกให้โรบ็อตสแกนทุกหน้าในไซต์ของคุณ ยกเว้นข้อจำกัดที่กำหนดไว้ด้านล่าง คุณยังสังเกตเห็นว่าเราตั้งกฎเหล่านี้เป็นสากล (พร้อมเครื่องหมายดอกจัน) เช่นเดียวกับที่อยู่ในไฟล์ WordPress robots.txt เสมือน (นอกจากนี้ คุณสามารถตรวจสอบปลั๊กอินตารางราคา WordPress ของเราได้)

ลองดูไฟล์ WordPress robots.txt ตัวอย่างอื่น:

User-agent: * Disallow: / wp-admin / Disallow: / wp-includes / User-agent: Bingbot Disallow: /ในไฟล์นี้ เราตั้งกฎเดียวกันกับที่ใช้กับ WordPress เป็นค่าเริ่มต้น แม้ว่าเราจะเพิ่มกฎชุดใหม่ซึ่งบล็อกโรบ็อตการค้นหาของ Bing จากการรวบรวมข้อมูลเว็บไซต์ของเรา อย่างที่คุณเห็น Bingbot คือชื่อของหุ่นยนต์

คุณสามารถพิมพ์ชื่อเครื่องมือค้นหาอื่นๆ เพื่อจำกัด / อนุญาตการเข้าถึงได้เช่นกัน แน่นอนว่าในทางปฏิบัติ Bingbot นั้นดีมาก (แม้ว่าจะไม่ดีเท่า Googlebot ก็ตาม) อย่างไรก็ตาม มีหุ่นยนต์ที่เป็นอันตรายจำนวนมาก

ข่าวร้ายคือพวกเขาไม่ปฏิบัติตามคำแนะนำในไฟล์ robots.txt เสมอไป (ยังคงทำงานเหมือนผู้ก่อการร้าย) โปรดทราบว่าแม้ว่าโรบ็อตส่วนใหญ่จะใช้คำแนะนำที่ให้ไว้ในไฟล์นี้ แต่คุณไม่สามารถบังคับให้หุ่นยนต์ทำเช่นนั้นได้

หากคุณเจาะลึกลงไปในหัวข้อนี้ คุณจะพบคำแนะนำมากมายเกี่ยวกับสิ่งที่ควรอนุญาตและสิ่งที่ควรบล็อกในไซต์ WordPress ของคุณ แม้ว่าจากประสบการณ์ของเรา กฎที่น้อยลงมักจะดีกว่า นี่คือตัวอย่างของ

หุ่นยนต์ txt ที่ดีที่สุดสำหรับเว็บไซต์ WordPress แต่สำหรับเว็บไซต์อื่นอาจแตกต่างกัน:

User-agent: * Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Disallow: *utm*= Disallow: *openstat= Allow: */uploads Sitemap: https://wpdevart.com/sitemap.xmlตามเนื้อผ้า WordPress ชอบปิดไดเรกทอรี wp-admin และ wp-includes อย่างไรก็ตาม นี่ไม่ใช่ทางออกที่ดีที่สุดอีกต่อไป นอกจากนี้ หากคุณเพิ่มเมตาแท็กสำหรับรูปภาพของคุณเพื่อจุดประสงค์ในการโปรโมต (SEO) ก็ไม่มีประโยชน์ที่จะบอกโรบ็อตไม่ให้สร้างดัชนีเนื้อหาของไดเร็กทอรีเหล่านี้

สิ่งที่ควรมีไฟล์ robots.txt จะขึ้นอยู่กับความต้องการของไซต์ของคุณ ดังนั้นอย่าลังเลที่จะทำวิจัยเพิ่มเติม!

วิธีสร้าง robots.txt

อะไรจะง่ายกว่าการสร้างไฟล์ข้อความ (txt) สิ่งที่คุณต้องทำคือเปิดตัวแก้ไขที่คุณชื่นชอบ (เช่น Notepad หรือ TextEdit) แล้วป้อนสองสามบรรทัด จากนั้นคุณบันทึกไฟล์โดยใช้โรบ็อตและส่วนขยาย txt (robots.txt) จะใช้เวลาสองสามวินาที ดังนั้นคุณอาจต้องการสร้าง robots.txt สำหรับ WordPress โดยไม่ต้องใช้ปลั๊กอิน

เราบันทึกไฟล์นี้ไว้ในเครื่องคอมพิวเตอร์ เมื่อคุณสร้างไฟล์ของคุณเองแล้ว คุณต้องเชื่อมต่อกับไซต์ของคุณผ่าน FTP (อาจด้วย FileZilla)

หลังจากเชื่อมต่อกับไซต์ของคุณแล้ว ให้ไปที่ไดเร็กทอรี public_html ตอนนี้ สิ่งที่คุณต้องทำคืออัปโหลดไฟล์ robots.txt จากคอมพิวเตอร์ของคุณไปยังเซิร์ฟเวอร์ คุณสามารถทำได้โดยคลิกปุ่มขวาของเมาส์บนไฟล์ในตัวนำทาง FTP ในเครื่อง หรือเพียงแค่ลากโดยใช้เมาส์ของคุณ

ใช้เวลาเพียงไม่กี่วินาที อย่างที่คุณเห็น วิธีนี้ง่ายกว่าการใช้ปลั๊กอิน

วิธีตรวจสอบ WordPress robots.txt และส่งไปที่ Google Search Console

หลังจากที่สร้างและอัปโหลดไฟล์ WordPress robots.txt แล้ว คุณสามารถตรวจสอบข้อผิดพลาดใน Google Search Console Search Console คือชุดเครื่องมือของ Google ที่ออกแบบมาเพื่อช่วยให้คุณติดตามว่าเนื้อหาของคุณปรากฏในผลการค้นหาอย่างไร หนึ่งในเครื่องมือเหล่านี้ตรวจสอบ robots.txt คุณจะพบมันได้อย่างง่ายดายบนหน้าผู้ดูแลระบบเครื่องมือเว็บมาสเตอร์ของ Google (ตรวจสอบ 50 ปลั๊กอิน WordPress ที่ดีที่สุดในปี 2020)

คุณจะพบช่องแก้ไขซึ่งคุณสามารถเพิ่มโค้ดสำหรับไฟล์ WordPress robots.txt ของคุณ แล้วคลิกส่งที่มุมล่างขวา Google Search Console จะถามคุณว่าคุณต้องการใช้รหัสใหม่หรือดาวน์โหลดไฟล์จากเว็บไซต์ของคุณ

ตอนนี้แพลตฟอร์มจะตรวจสอบไฟล์ของคุณเพื่อหาข้อผิดพลาด หากพบข้อผิดพลาด ข้อมูลเกี่ยวกับสิ่งนี้จะแสดงให้คุณเห็น คุณเห็นตัวอย่างบางส่วนของไฟล์ WordPress robots.txt และตอนนี้คุณมีโอกาสมากขึ้นที่จะสร้างไฟล์ robots.txt ที่สมบูรณ์แบบของคุณ !