在本地环境中安装开源 LLM 的分步指南 - 无需互联网

已发表: 2023-12-20概括

在快速发展的人工智能世界中,在本地系统中安装像 FALCON 这样的大型语言模型(LLM) 带来了一系列独特的挑战和机遇。 本指南旨在引导您完成设置 FALCON 开源 LLM 的关键步骤,重点是实现最佳性能,同时保持严格的数据隐私和安全性。

在本地开始 FALCON(一种著名的开源大型语言模型 (LLM))的部署之旅,确保峰值性能和强大的安全性。 该综合指南涵盖了硬件先决条件、软件安装和数据培训,同时强调了定期测试、维护、可扩展性考虑因素和成本分析的重要性。 为了获得更广泛的视角,请随时了解排名前 5 的开源法学硕士,并考虑利用 Creole Studios的专业知识进行安全实施,使您能够利用人工智能的力量,同时保持严格的数据隐私标准。

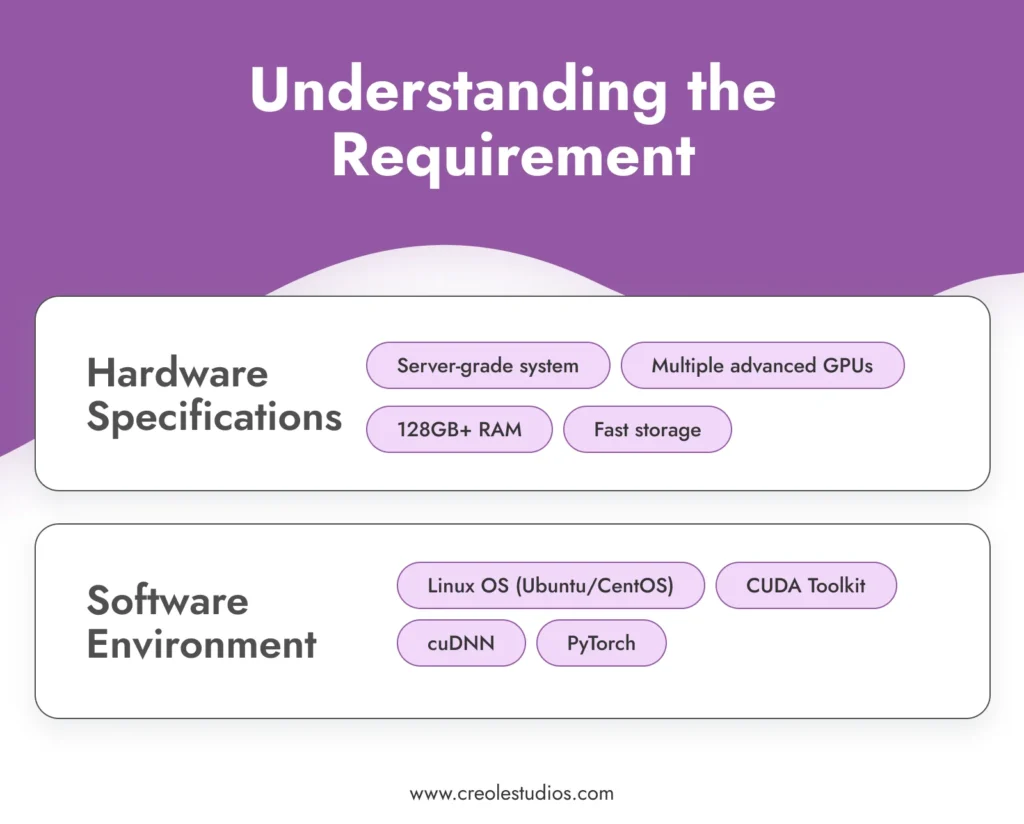

了解需求

在深入安装过程之前,了解运行 FALCON 等复杂模型的要求至关重要。

- 硬件规格:FALCON 拥有 1800 亿个海量参数,需要大量的计算资源。 这需要高性能计算环境,通常涉及配备多个高级 GPU(例如 NVIDIA A100)、大量 RAM(128GB 或更多)和高速存储解决方案(SSD 或 NVMe)的服务器级系统来管理模型和数据有效。 您可以参考 NVIDIA 设置 AI 和 ML 环境的指南。

- 软件环境:有效运行FALCON需要稳定且兼容的软件环境。 建议使用基于 Linux 的操作系统,如 Ubuntu 或 CentOS,因为它具有出色的 GPU 支持以及与基本工具和库的兼容性。 该软件堆栈包括用于 GPU 加速的 CUDA 工具包、用于深度神经网络的 cuDNN 以及 PyTorch 等机器学习框架。

获取模型

下一步是获取 FALCON 模型。 这可能涉及:

- 型号许可:检查 FALCON 的最新可用性和许可选项。 像 FALCON 这样的模型的许可通常需要谈判和协议,以确保您拥有使用该模型的合法权利。 请关注官方 FALCON 存储库或相关 AI 模型市场以获取更新和许可详细信息。

- 模型传输:考虑到设置的气隙性质,将模型传输到本地环境是关键的一步。 这可能涉及使用安全、加密的存储设备物理传输模型。 在此传输过程中模型的完整性和安全性至关重要。

设置基础设施

建立强大的基础设施对于 FALCON LLM 的高效运营至关重要:

- 服务器配置:针对高强度 AI 工作负载优化服务器。 这包括配置多个 GPU 进行并行处理、确保系统内的高带宽网络以及实施有效的冷却解决方案来管理热量输出。

- 存储管理:考虑到 FALCON 的大小以及您将使用的潜在大型数据集,请仔细规划您的存储架构。 由于速度快,建议使用高容量 SSD 或 NVMe 驱动器。 确保您拥有适当的冗余和备份系统。

- 电源和冷却:这些功能强大的服务器将需要足够的电源和冷却系统。 确保您的基础设施能够满足这些要求。 建议咨询硬件专家来设计一个可以维持此设置的数据中心

安装所需的软件

软件安装是设置开源 LLM 的关键步骤:

- 操作系统设置:安装您选择的 Linux 发行版。 Ubuntu 和 CentOS 因其稳定性和支持而成为受欢迎的选择。 确保操作系统配置为以最佳方式使用硬件资源。

- 依赖安装:安装 CUDA Toolkit 以获得 GPU 支持,安装 cuDNN 以获得深度学习功能,安装 PyTorch 作为机器学习框架。 确保您使用与 FALCON 模型兼容的版本。

- 安全软件:在气隙环境中,内部安全是关键。 安装强大的防火墙和入侵检测系统。 即使系统是隔离的,内部威胁或意外破坏也可能发生。

模型安装

安装 FALCON 模型涉及几个步骤:

- 模型传输:使用加密存储设备将模型文件安全地传输到本地系统。

- 安装过程:遵循FALCON提供的安装指南。 这通常涉及设置环境变量、加载模型文件和配置模型参数。

- 验证:安装后,验证安装的完整性。 确保模型文件完好无损并且模型正确运行初始诊断。

数据安全与合规性

确保气隙环境中的数据安全涉及多层保护:

- 加密:所有静态数据和网络内传输的数据都应加密。 实施强大的加密协议来保护您的数据。

- 合规性:遵守相关数据保护法规和行业标准。 定期审核您的系统是否合规。

- 访问控制:实施严格的访问控制策略。 只有授权人员才能访问模型和数据。

使用精选数据训练模型

为了根据您的特定需求定制 FALCON,使用精选数据对其进行训练至关重要。

- 数据收集和准备:收集与您的用例相关的数据。 这些数据应该具有代表性、多样化且高质量。 预处理和清理数据以确保其适合训练。

- 训练过程:配置 FALCON 的训练参数以符合您的目标。 训练像 FALCON 这样的模型需要深入了解机器学习原理和模型架构的细节。

- 监控和调整:持续监控培训过程的绩效和准确性。 准备好根据需要调整训练数据或参数以达到预期结果。

测试与维护

定期测试和维护对于模型的长期成功至关重要。

- 性能测试:定期测试模型的准确性和效率。 这涉及运行验证数据集并检查模型输出的一致性和质量。

- 软硬件维护:定期更新、修补软件环境。 维护硬件以确保其高效运行,包括管理冷却系统、检查电源以及更换任何故障组件。

- 模型更新:及时了解 FALCON 模型的更新。 在气隙环境中,更新模型可能需要手动传输更新的模型文件。

可扩展性和成本

考虑您的设置的未来增长和成本影响。

- 可扩展性规划:规划基础设施的潜在扩展。 这可能包括添加更多 GPU、扩展存储或增强气隙环境中的网络容量。

- 成本分析:定期审查维护和运行 FALCON 所涉及的成本。 这包括硬件成本、能源消耗和许可费用。

最后注意事项:开源法学硕士和 Creole Studios 专业知识的重要性

本地安装 FALCON 等开源 LLM 可提供显着的优势,包括无与伦比的数据隐私、定制和对 AI 功能的控制。 它允许企业利用人工智能的力量,同时确保敏感数据保留在其安全的专用网络范围内。

Creole Studios 擅长协助客户完成在本地隔离环境中设置和维护开源法学硕士的复杂流程。 我们的专业知识可确保顺利、安全和有效的实施,使企业能够充分利用人工智能的潜力,同时保持最高的数据隐私和安全标准。 在我们的支持下,企业可以自信地应对人工智能实施的挑战,并在快速发展的技术领域保持领先地位。