WordPress 机器人.txt

已发表: 2019-02-26WordPress robots.txt 对 SEO 非常重要。 为确保您的网站在搜索引擎结果中排名良好,您需要使其最重要的页面便于搜索和索引搜索引擎的“机器人”(“bots”)。 结构良好的 robots.txt 文件将有助于将这些机器人引导到您要索引的页面。

在本文中,我们将揭示这些问题:

- 什么是 robots.txt 文件以及为什么它很重要

- WordPress 机器人 txt 位置

- 适用于 WordPress 的最佳机器人 txt

- 如何创建 robots.txt 文件

- 如何检查 robots.txt 文件并将其发送到 Google 搜索控制台。

什么是 WordPress 的 robots.txt 文件,为什么它很重要?

当您创建一个新网站时,搜索引擎将发送他们的机器人扫描并创建其所有页面的地图。 这样,当有人搜索相关关键字时,他们就会知道要显示哪些页面。 在基本层面上,这非常简单(另外,请查看这篇有用的帖子——WordPress 默认的 .htaccess 文件)。

问题是现代网站除了页面之外还包含许多其他元素。 例如,WordPress 允许您安装通常具有自己目录的插件。 无需在搜索结果中显示此内容,因为它们与内容不匹配。

robots.txt 文件的作用是为搜索机器人提供一组指南。 他告诉他们:“看这里并索引这些页面,但不要进入其他区域!”。 该文件可以根据需要尽可能详细,并且即使您是初学者也很容易创建。

实际上,即使您没有创建 robots.txt 文件,搜索引擎仍会扫描您的网站。 但是,不创建它是一个非常不合理的步骤。 如果没有此文件,您会让机器人为您网站的所有内容编制索引,并且他们决定您需要显示网站的所有部分,即使是您希望隐藏以防止公共访问的那些部分(另外,请查看 – 最佳 WordPress 电子商务插件)。

更重要的一点是,如果没有 robots.txt 文件,您的网站将会有很多来自您网站的 robots.txt 的点击。 这将对其性能产生不利影响。 即使您的网站的访问量仍然很小,页面加载速度也应该始终处于优先级和最高级别。 最后,除了缓慢加载网站之外,人们不喜欢的只有几件事。

WordPress 机器人 txt 位置

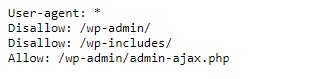

创建 WordPress 网站时,会自动创建一个 robots.txt 文件,该文件位于服务器的主目录中。 例如,如果您的站点位于此处 - wpdevart.com,您可以在 wpdevart.com/robots.txt 找到它并看到如下内容:

这是最简单的 robots.txt 文件的示例。 翻译成人类可读的语言,右边的 User-agent: 声明

规则适用于哪些机器人。 星号表示该规则是通用的并且适用于所有机器人。 在这种情况下,该文件告诉机器人它们无法扫描 wp-admin 和 wp-includes 目录。 这些规则的含义是这些目录包含许多需要保护以防止公共访问的文件(另外,请查看我们的 WordPress Countdown 插件)。

当然,您可以在文件中添加更多规则。 在执行此操作之前,您需要了解这是一个虚拟文件。 通常,WordPress robots.txt 位于根目录中,通常称为 public_html 或 www(或您的网站名称):

应该注意的是,您无法从任何目录访问默认创建的 WordPress 的 robots.txt 文件。 它可以工作,但是如果您想进行更改,则需要创建自己的文件并将其上传到根目录。

我们将研究几种为 WordPress 创建 robots.txt 文件的方法。 现在让我们讨论如何确定要在文件中包含哪些规则。

适用于 WordPress 的最佳机器人 txt

为您的 WordPress 网站创建最好的 robots txt 并不难。 那么 robots.txt 文件中需要包含哪些规则。 在上一节中,我们看到了 WordPress 生成的 robots.txt 文件的示例。 它只包括两个简短的规则,但对于大多数网站来说,它们就足够了。 让我们看一下两个不同的 robots.txt 文件,看看每个文件的作用。

这是我们的第一个 WordPress robots.txt 文件示例:

User-agent: * Allow: / # Disallowed Sub-Directories Disallow: / payout / Disallow: / photos / Disallow: / forums /这个 robots.txt 文件是为论坛创建的。 搜索引擎通常会索引每个论坛主题。 根据您论坛的主题,您可能希望禁止索引。 例如,谷歌不会索引数百个简短的用户讨论。 您还可以设置指向特定论坛主题的规则以排除它,并允许搜索引擎索引其余部分。

您还会注意到文件顶部以 Allow: / 开头的一行。 此行告诉机器人它们可以扫描您网站的所有页面,但下面设置的限制除外。 您还注意到我们将这些规则设置为通用的(带有星号),就像在虚拟 WordPress robots.txt 文件中一样(另外,您可以查看我们的 WordPress 定价表插件)。

让我们看看另一个示例 WordPress robots.txt 文件:

User-agent: * Disallow: / wp-admin / Disallow: / wp-includes / User-agent: Bingbot Disallow: /在这个文件中,我们设置了与 WordPress 默认相同的规则。 尽管我们还添加了一组新规则来阻止 Bing 搜索机器人抓取我们的网站。 如您所见,Bingbot 是机器人的名称。

您也可以键入其他搜索引擎名称来限制/允许其访问。 当然,在实践中,Bingbot 非常好(即使不如 Googlebot)。 但是,有很多恶意机器人。

坏消息是他们并不总是遵循 robots.txt 文件中的说明(他们仍然像恐怖分子一样工作)。 需要注意的是,虽然大多数机器人会使用本文件中提供的说明,但您不能强迫它们这样做。

如果您深入了解该主题,您会发现许多关于在您的 WordPress 网站上允许和阻止什么的建议。 尽管根据我们的经验,规则越少越好。 这是一个例子

WordPress 网站的最佳 robots txt,但对于不同的网站,它可能会有所不同:

User-agent: * Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Disallow: *utm*= Disallow: *openstat= Allow: */uploads Sitemap: https://wpdevart.com/sitemap.xml传统上 WordPress 喜欢关闭 wp-admin 和 wp-includes 目录。 但是,这不再是最佳解决方案。 另外,如果您出于促销 (SEO) 的目的为图像添加元标记,那么告诉机器人不要索引这些目录的内容是没有意义的。

您的 robots.txt 文件应包含的内容取决于您网站的需求。 因此,请随时进行更多研究!

如何创建 robots.txt

有什么比创建文本文件 (txt) 更简单的了。 您所要做的就是打开您最喜欢的编辑器(如记事本或 TextEdit)并输入几行。 然后使用 robots 和 txt 扩展名 (robots.txt) 保存文件。 这将需要几秒钟,因此您可能希望在不使用插件的情况下为 WordPress 创建 robots.txt。

我们将此文件本地保存在计算机上。 制作自己的文件后,您需要通过 FTP(可能使用 FileZilla)连接到您的站点。

连接到您的站点后,转到 public_html 目录。 现在,您需要做的就是将 robots.txt 文件从您的计算机上传到服务器。 您可以通过在本地 FTP 导航器中的文件上单击鼠标右键或简单地使用鼠标拖动它来执行此操作。

只需要几秒钟。 如您所见,这种方法比使用插件更容易。

如何检查 WordPress robots.txt 并将其发送到 Google Search Console

创建并上传 WordPress robots.txt 文件后,您可以在 Google Search Console 中检查错误。 Search Console 是一组 Google 工具,旨在帮助您跟踪内容在搜索结果中的显示方式。 其中一个工具会检查 robots.txt,您可以在 Google 网站管理员工具管理页面上轻松找到它(另外,请查看 2020 年 50 个最佳 WordPress 插件)。

在那里您将找到编辑器字段,您可以在其中添加 WordPress robots.txt 文件的代码,然后单击右下角的提交。 Google 搜索控制台会询问您是要使用新代码还是从您的网站下载文件。

现在平台将检查您的文件是否有错误。 如果发现错误,将向您显示相关信息。 您看到了一些 WordPress robots.txt 文件的示例,现在您有更多机会创建完美的 robots.txt 文件!