WordPress 機器人.txt

已發表: 2019-02-26WordPress robots.txt 對 SEO 非常重要。 為確保您的網站在搜索引擎結果中排名良好,您需要使其最重要的頁面便於搜索和索引搜索引擎的“機器人”(“bots”)。 結構良好的 robots.txt 文件將有助於將這些機器人引導到您要索引的頁面。

在本文中,我們將揭示這些問題:

- 什麼是 robots.txt 文件以及為什麼它很重要

- WordPress 機器人 txt 位置

- 適用於 WordPress 的最佳機器人 txt

- 如何創建 robots.txt 文件

- 如何檢查 robots.txt 文件並將其發送到 Google 搜索控制台。

什麼是 WordPress 的 robots.txt 文件,為什麼它很重要?

當您創建一個新網站時,搜索引擎將發送他們的機器人掃描並創建其所有頁面的地圖。 這樣,當有人搜索相關關鍵字時,他們就會知道要顯示哪些頁面。 在基本層面上,這非常簡單(另外,請查看這篇有用的帖子——WordPress 默認的 .htaccess 文件)。

問題是現代網站除了頁面之外還包含許多其他元素。 例如,WordPress 允許您安裝通常具有自己目錄的插件。 無需在搜索結果中顯示此內容,因為它們與內容不匹配。

robots.txt 文件的作用是為搜索機器人提供一組指南。 他告訴他們:“看這裡並索引這些頁面,但不要進入其他區域!”。 該文件可以根據需要盡可能詳細,並且即使您是初學者也很容易創建。

實際上,即使您沒有創建 robots.txt 文件,搜索引擎仍會掃描您的網站。 但是,不創建它是一個非常不合理的步驟。 如果沒有此文件,您會讓機器人為您網站的所有內容編制索引,並且他們決定您需要顯示網站的所有部分,即使是您希望隱藏以防止公共訪問的那些部分(另外,請查看 – 最佳 WordPress 電子商務插件)。

更重要的一點是,如果沒有 robots.txt 文件,您的網站將會有很多來自您網站的 robots.txt 的點擊。 這將對其性能產生不利影響。 即使您的網站的訪問量仍然很小,頁面加載速度也應該始終處於優先級和最高級別。 最後,除了緩慢加載網站之外,人們不喜歡的只有幾件事。

WordPress 機器人 txt 位置

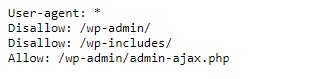

創建 WordPress 網站時,會自動創建一個 robots.txt 文件,該文件位於服務器的主目錄中。 例如,如果您的站點位於此處 - wpdevart.com,您可以在 wpdevart.com/robots.txt 找到它並看到如下內容:

這是最簡單的 robots.txt 文件的示例。 翻譯成人類可讀的語言,右邊的 User-agent: 聲明

規則適用於哪些機器人。 星號表示該規則是通用的並且適用於所有機器人。 在這種情況下,該文件告訴機器人它們無法掃描 wp-admin 和 wp-includes 目錄。 這些規則的含義是這些目錄包含許多需要保護以防止公共訪問的文件(另外,請查看我們的 WordPress Countdown 插件)。

當然,您可以在文件中添加更多規則。 在執行此操作之前,您需要了解這是一個虛擬文件。 通常,WordPress robots.txt 位於根目錄中,通常稱為 public_html 或 www(或您的網站名稱):

應該注意的是,您無法從任何目錄訪問默認創建的 WordPress 的 robots.txt 文件。 它可以工作,但是如果您想進行更改,則需要創建自己的文件並將其上傳到根目錄。

我們將研究幾種為 WordPress 創建 robots.txt 文件的方法。 現在讓我們討論如何確定要在文件中包含哪些規則。

適用於 WordPress 的最佳機器人 txt

為您的 WordPress 網站創建最好的 robots txt 並不難。 那麼 robots.txt 文件中需要包含哪些規則。 在上一節中,我們看到了 WordPress 生成的 robots.txt 文件的示例。 它只包括兩個簡短的規則,但對於大多數網站來說,它們就足夠了。 讓我們看一下兩個不同的 robots.txt 文件,看看每個文件的作用。

這是我們的第一個 WordPress robots.txt 文件示例:

User-agent: * Allow: / # Disallowed Sub-Directories Disallow: / payout / Disallow: / photos / Disallow: / forums /這個 robots.txt 文件是為論壇創建的。 搜索引擎通常會索引每個論壇主題。 根據您論壇的主題,您可能希望禁止索引。 例如,谷歌不會索引數百個簡短的用戶討論。 您還可以設置指向特定論壇主題的規則以排除它,並允許搜索引擎索引其餘部分。

您還會注意到文件頂部以 Allow: / 開頭的一行。 此行告訴機器人它們可以掃描您網站的所有頁面,但下面設置的限制除外。 您還注意到我們將這些規則設置為通用的(帶有星號),就像在虛擬 WordPress robots.txt 文件中一樣(另外,您可以查看我們的 WordPress 定價表插件)。

讓我們看看另一個示例 WordPress robots.txt 文件:

User-agent: * Disallow: / wp-admin / Disallow: / wp-includes / User-agent: Bingbot Disallow: /在這個文件中,我們設置了與 WordPress 默認相同的規則。 儘管我們還添加了一組新規則來阻止 Bing 搜索機器人抓取我們的網站。 如您所見,Bingbot 是機器人的名稱。

您也可以鍵入其他搜索引擎名稱來限制/允許其訪問。 當然,在實踐中,Bingbot 非常好(即使不如 Googlebot)。 但是,有很多惡意機器人。

壞消息是他們並不總是遵循 robots.txt 文件中的說明(他們仍然像恐怖分子一樣工作)。 需要注意的是,雖然大多數機器人會使用本文件中提供的說明,但您不能強迫它們這樣做。

如果您深入了解該主題,您會發現許多關於在您的 WordPress 網站上允許和阻止什麼的建議。 儘管根據我們的經驗,規則越少越好。 這是一個例子

WordPress 網站的最佳 robots txt,但對於不同的網站,它可能會有所不同:

User-agent: * Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Disallow: *utm*= Disallow: *openstat= Allow: */uploads Sitemap: https://wpdevart.com/sitemap.xml傳統上 WordPress 喜歡關閉 wp-admin 和 wp-includes 目錄。 但是,這不再是最佳解決方案。 另外,如果您出於促銷 (SEO) 的目的為圖像添加元標記,那麼告訴機器人不要索引這些目錄的內容是沒有意義的。

您的 robots.txt 文件應包含的內容取決於您網站的需求。 因此,請隨時進行更多研究!

如何創建 robots.txt

有什麼比創建文本文件 (txt) 更簡單的了。 您所要做的就是打開您最喜歡的編輯器(如記事本或 TextEdit)並輸入幾行。 然後使用 robots 和 txt 擴展名 (robots.txt) 保存文件。 這將需要幾秒鐘,因此您可能希望在不使用插件的情況下為 WordPress 創建 robots.txt。

我們將此文件本地保存在計算機上。 製作自己的文件後,您需要通過 FTP(可能使用 FileZilla)連接到您的站點。

連接到您的站點後,轉到 public_html 目錄。 現在,您需要做的就是將 robots.txt 文件從您的計算機上傳到服務器。 您可以通過在本地 FTP 導航器中的文件上單擊鼠標右鍵或簡單地使用鼠標拖動它來執行此操作。

只需要幾秒鐘。 如您所見,這種方法比使用插件更容易。

如何檢查 WordPress robots.txt 並將其發送到 Google Search Console

創建並上傳 WordPress robots.txt 文件後,您可以在 Google Search Console 中檢查錯誤。 Search Console 是一組 Google 工具,旨在幫助您跟踪內容在搜索結果中的顯示方式。 其中一個工具會檢查 robots.txt,您可以在 Google 網站管理員工具管理頁面上輕鬆找到它(另外,請查看 2020 年 50 個最佳 WordPress 插件)。

在那裡您將找到編輯器字段,您可以在其中添加 WordPress robots.txt 文件的代碼,然後單擊右下角的提交。 Google 搜索控制台會詢問您是要使用新代碼還是從您的網站下載文件。

現在平台將檢查您的文件是否有錯誤。 如果發現錯誤,將向您顯示相關信息。 您看到了一些 WordPress robots.txt 文件的示例,現在您有更多機會創建完美的 robots.txt 文件!